WO2018124280A1 - Simulation system, image processing method, and information storage medium - Google Patents

Simulation system, image processing method, and information storage medium Download PDFInfo

- Publication number

- WO2018124280A1 WO2018124280A1 PCT/JP2017/047250 JP2017047250W WO2018124280A1 WO 2018124280 A1 WO2018124280 A1 WO 2018124280A1 JP 2017047250 W JP2017047250 W JP 2017047250W WO 2018124280 A1 WO2018124280 A1 WO 2018124280A1

- Authority

- WO

- WIPO (PCT)

- Prior art keywords

- virtual space

- user

- image

- virtual

- position information

- Prior art date

Links

Images

Classifications

-

- A—HUMAN NECESSITIES

- A63—SPORTS; GAMES; AMUSEMENTS

- A63F—CARD, BOARD, OR ROULETTE GAMES; INDOOR GAMES USING SMALL MOVING PLAYING BODIES; VIDEO GAMES; GAMES NOT OTHERWISE PROVIDED FOR

- A63F13/00—Video games, i.e. games using an electronically generated display having two or more dimensions

- A63F13/50—Controlling the output signals based on the game progress

- A63F13/52—Controlling the output signals based on the game progress involving aspects of the displayed game scene

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/048—Interaction techniques based on graphical user interfaces [GUI]

- G06F3/0481—Interaction techniques based on graphical user interfaces [GUI] based on specific properties of the displayed interaction object or a metaphor-based environment, e.g. interaction with desktop elements like windows or icons, or assisted by a cursor's changing behaviour or appearance

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T19/00—Manipulating 3D models or images for computer graphics

-

- G—PHYSICS

- G09—EDUCATION; CRYPTOGRAPHY; DISPLAY; ADVERTISING; SEALS

- G09G—ARRANGEMENTS OR CIRCUITS FOR CONTROL OF INDICATING DEVICES USING STATIC MEANS TO PRESENT VARIABLE INFORMATION

- G09G5/00—Control arrangements or circuits for visual indicators common to cathode-ray tube indicators and other visual indicators

Abstract

This simulation system includes a virtual space setting unit, a moving body processing unit, and a display processing unit. The virtual space setting unit sets a first virtual space and a second virtual space as virtual spaces. Until a switching condition is established, the display processing unit sets positional information about a user's moving body or a virtual camera as positional information in the first virtual space, performs a process for rendering an image of the second virtual space such that the image of the second virtual space is added to an image of the first virtual space, and generates an image in which the image of the second virtual space is displayed in an area corresponding to a singular point. When the switching condition has been established, the display processing unit sets the positional information about the user's moving body or the virtual camera as positional information in the second virtual space, performs a process for rendering an image of the first virtual space such that the image of the first virtual space is added to an image of the second virtual space, and generates an image in which the image of the first virtual space is displayed in an area corresponding to a singular point.

Description

本発明は、シミュレーションシステム、画像処理方法及び情報記憶媒体等に関する。

The present invention relates to a simulation system, an image processing method, an information storage medium, and the like.

従来より、仮想空間において仮想カメラから見える画像を生成するシミュレーションシステムが知られている。例えば仮想カメラから見える画像をHMD(頭部装着型表示装置)に表示して、バーチャルリアリティ(VR)を実現するシミュレーションシステムの従来技術としては、特許文献1等に開示される技術がある。

Conventionally, a simulation system that generates an image that can be seen from a virtual camera in a virtual space is known. For example, as a conventional technique of a simulation system that realizes virtual reality (VR) by displaying an image viewed from a virtual camera on an HMD (head-mounted display device), there is a technique disclosed in Patent Document 1 or the like.

このようなシミュレーションシステムでは、複数のオブジェクトが配置設定される仮想空間として、1つの仮想空間だけが設定される。そしてユーザは、自身に対応するユーザキャラクタが、当該1つの仮想空間で移動することで、バーチャルリアリティの世界を楽しむことになる。しかしながら、従来は、例えば複数の仮想空間を移動可能な仮想現実を実現するシミュレーションシステムについては提案されていなかった。

In such a simulation system, only one virtual space is set as a virtual space in which a plurality of objects are arranged and set. And a user will enjoy the world of virtual reality because the user character corresponding to himself moves in the one virtual space. However, conventionally, for example, a simulation system that realizes a virtual reality capable of moving in a plurality of virtual spaces has not been proposed.

本発明の幾つかの態様によれば、複数の仮想空間を移動可能な仮想現実を実現できるシミュレーションシステム、画像処理方法及び情報記憶媒体等を提供できる。

According to some aspects of the present invention, it is possible to provide a simulation system, an image processing method, an information storage medium, and the like that can realize a virtual reality that can move in a plurality of virtual spaces.

本発明の一態様は、オブジェクトが配置される仮想空間の設定処理を行う仮想空間設定部と、前記仮想空間において、ユーザに対応するユーザ移動体を移動させる処理を行う移動体処理部と、前記仮想空間において仮想カメラから見える画像の描画処理を行う表示処理部と、を含み、前記仮想空間設定部は、前記仮想空間として、第1の仮想空間と、前記第1の仮想空間に対して特異点を介して結びつけられる第2の仮想空間とを設定し、前記表示処理部は、所与の切替条件が成立する前においては、前記ユーザ移動体又は前記仮想カメラの位置情報を、前記第1の仮想空間の位置情報として設定し、第1の描画処理として、前記第1の仮想空間の画像に加えて前記第2の仮想空間の画像を描画する処理を行って、前記特異点に対応する領域に前記第2の仮想空間の画像が表示される画像を生成し、前記ユーザ移動体又は前記仮想カメラが前記特異点に対応する場所を第1の進行方向で通過することで前記切替条件が成立した場合には、前記ユーザ移動体又は前記仮想カメラの前記位置情報を、前記第2の仮想空間の位置情報として設定し、第2の描画処理として、前記第2の仮想空間の画像に加えて前記第1の仮想空間の画像を描画する処理を行って、前記特異点に対応する領域に前記第1の仮想空間の画像が表示される画像を生成し、前記表示処理部は、前記仮想カメラの視線方向が、前記第1の進行方向の反対方向側を向いた場合に、前記特異点に対応する領域に前記第1の仮想空間の画像が表示される画像を生成するシミュレーションシステムに関係する。また本発明は、上記各部としてコンピュータを機能させるプログラム、又は該プログラムを記憶したコンピュータ読み取り可能な情報記憶媒体に関係する。

One aspect of the present invention includes a virtual space setting unit that performs a setting process of a virtual space in which an object is arranged, a moving object processing unit that performs a process of moving a user moving object corresponding to a user in the virtual space, A display processing unit that performs drawing processing of an image viewed from a virtual camera in the virtual space, wherein the virtual space setting unit is specific to the first virtual space and the first virtual space as the virtual space A second virtual space that is connected via a point, and the display processing unit displays the position information of the user moving object or the virtual camera before the given switching condition is established. Corresponding to the singular point by performing a process of drawing the image of the second virtual space in addition to the image of the first virtual space as the first drawing process. Territory Generating the image in which the image of the second virtual space is displayed, and the switching condition is satisfied when the user moving body or the virtual camera passes through the place corresponding to the singular point in the first traveling direction. In this case, the position information of the user moving body or the virtual camera is set as the position information of the second virtual space, and is added to the image of the second virtual space as a second drawing process. The first virtual space image is rendered to generate an image in which the first virtual space image is displayed in a region corresponding to the singular point, and the display processing unit includes the virtual camera The present invention relates to a simulation system that generates an image in which an image of the first virtual space is displayed in a region corresponding to the singular point when the line-of-sight direction is directed in the direction opposite to the first traveling direction. . The present invention also relates to a program that causes a computer to function as each of the above-described units, or a computer-readable information storage medium that stores the program.

本発明の一態様によれば、ユーザ移動体が移動する仮想空間において、仮想カメラから見える画像が生成される。また仮想空間として第1の仮想空間と第2の仮想空間が設定される。そして切替条件が成立する前においては、ユーザ移動体又は仮想カメラの位置情報が第1の仮想空間の位置情報として設定され、第1の仮想空間の画像に加えて第2の仮想空間の画像が描画されて、特異点に対応する領域に第2の仮想空間の画像が表示される画像が生成される。一方、切替条件が成立すると、ユーザ移動体又は仮想カメラの位置情報が第2の仮想空間の位置情報として設定され、第2の仮想空間の画像に加えて第1の仮想空間の画像が描画されて、特異点に対応する領域に第1の仮想空間の画像が表示される画像が生成される。そして本発明の一態様では、仮想カメラの視線方向が、第1の進行方向の反対方向側を向いた場合に、特異点に対応する領域に第1の仮想空間の画像が表示される画像が生成されるようになる。このようにすれば、ユーザ移動体又は仮想カメラが特異点に対応する領域を通過することで、ユーザ移動体又は仮想カメラの位置が第1の仮想空間の位置から第2の仮想空間の位置に切り替わるようになる。そしてユーザ移動体又は仮想カメラが第1の仮想空間に位置する場合には、第1の仮想空間の画像に加えて第2の仮想空間の画像が描画されて、特異点に対応する領域に第2の仮想空間の画像が表示されるようになる。一方、ユーザ移動体又は仮想カメラが第2の仮想空間に位置する場合には、第2の仮想空間の画像に加えて第1の仮想空間の画像が描画されて、特異点に対応する領域に第1の仮想空間の画像が表示されるようになる。これにより、複数の仮想空間を移動可能な仮想現実を実現できるシミュレーションシステム等の提供が可能になる。

According to one aspect of the present invention, an image that can be seen from a virtual camera is generated in a virtual space in which a user moving object moves. A first virtual space and a second virtual space are set as the virtual space. Before the switching condition is satisfied, the position information of the user moving body or the virtual camera is set as the position information of the first virtual space, and the image of the second virtual space is added to the image of the first virtual space. An image is generated in which the image of the second virtual space is displayed in the region corresponding to the singular point. On the other hand, when the switching condition is satisfied, the position information of the user moving body or the virtual camera is set as the position information of the second virtual space, and the image of the first virtual space is drawn in addition to the image of the second virtual space. Thus, an image in which the image of the first virtual space is displayed in the region corresponding to the singular point is generated. In one aspect of the present invention, an image in which an image of the first virtual space is displayed in a region corresponding to a singular point when the line-of-sight direction of the virtual camera faces the opposite direction side of the first traveling direction. Will be generated. In this way, the user moving body or the virtual camera passes through the region corresponding to the singular point, so that the position of the user moving body or the virtual camera is changed from the position of the first virtual space to the position of the second virtual space. It will be switched. When the user moving body or the virtual camera is located in the first virtual space, the image of the second virtual space is drawn in addition to the image of the first virtual space, and the second virtual space is drawn in the region corresponding to the singular point. The image of the virtual space 2 is displayed. On the other hand, when the user moving body or the virtual camera is located in the second virtual space, the image of the first virtual space is drawn in addition to the image of the second virtual space, and the region corresponding to the singular point is drawn. An image of the first virtual space is displayed. This makes it possible to provide a simulation system or the like that can realize a virtual reality that can move in a plurality of virtual spaces.

また本発明の一態様では、前記表示処理部は、前記ユーザ移動体又は前記仮想カメラが、前記第1の進行方向とは異なる第2の進行方向で前記特異点を通過した場合には、前記ユーザ移動体又は前記仮想カメラの前記位置情報を、前記第1の仮想空間の位置情報として設定し、前記第1の描画処理として、少なくとも前記第1の仮想空間の画像を描画する処理を行ってもよい。

In the aspect of the invention, the display processing unit may be configured such that when the user moving body or the virtual camera passes through the singular point in a second traveling direction different from the first traveling direction, The position information of the user moving body or the virtual camera is set as the position information of the first virtual space, and as the first drawing process, a process of drawing at least an image of the first virtual space is performed. Also good.

このようにすれば、ユーザ移動体又は仮想カメラが、第1の進行方向とは異なる第2の進行方向で、特異点に対応する領域を通過することで、ユーザ移動体又は仮想カメラの位置が第2の仮想空間の位置から第1の仮想空間の位置に切り替わるようになる。

In this way, the user moving body or the virtual camera passes through the region corresponding to the singular point in the second traveling direction different from the first traveling direction, so that the position of the user moving body or the virtual camera is changed. The position of the second virtual space is switched to the position of the first virtual space.

また本発明の一態様では、前記表示処理部は、前記ユーザ移動体又は前記仮想カメラが前記特異点に対応する場所を通過することで前記切替条件が成立した場合に、前記ユーザ移動体又は前記仮想カメラの前記位置情報を、第3の仮想空間の位置情報として設定し、第3の描画処理として、少なくとも前記第3の仮想空間の画像を描画する処理を行ってもよい。

Moreover, in one aspect of the present invention, the display processing unit, when the switching condition is satisfied by the user moving body or the virtual camera passing through a location corresponding to the singular point, the user moving body or the The position information of the virtual camera may be set as the position information of the third virtual space, and a process of drawing at least an image of the third virtual space may be performed as the third drawing process.

このようにすれば、第1、第2の仮想空間に加えて、第3の仮想空間を移動する仮想現実を実現できるシミュレーションシステム等の提供が可能になる。

This makes it possible to provide a simulation system or the like that can realize a virtual reality that moves in the third virtual space in addition to the first and second virtual spaces.

また本発明の一態様では、前記表示処理部は、複数の前記ユーザがプレイする場合に、複数の前記ユーザに対応する複数の前記ユーザ移動体又は複数の前記仮想カメラが前記特異点に対応する場所を通過して前記第1の仮想空間に戻ったことを条件に、前記第3の描画処理を許可してもよい。

In the aspect of the invention, the display processing unit may correspond to the singular points, when the plurality of users play, the plurality of user moving bodies corresponding to the plurality of users or the plurality of virtual cameras. The third drawing process may be permitted on condition that the vehicle passes through a place and returns to the first virtual space.

このようにすれば、複数のユーザがプレイする場合に、一部のユーザが第2の仮想空間に取り残されてしまうような事態の発生を防止できる。

In this way, when a plurality of users play, some users can be prevented from being left in the second virtual space.

また本発明の一態様では、前記表示処理部は、前記ユーザの入力情報又はセンサの検出情報に基づいて、前記切替条件が成立したか否かを判断してもよい。

In one aspect of the present invention, the display processing unit may determine whether or not the switching condition is satisfied based on the input information of the user or the detection information of the sensor.

このようにすれば、ユーザの入力情報やセンサの検出情報に基づいて仮想空間を切り替える処理などを実現できるようになる。

In this way, it is possible to realize a process of switching the virtual space based on user input information or sensor detection information.

また本発明の一態様では、前記ユーザが移動する実空間のプレイフィールドには、前記特異点に対応する物体が配置されており、前記表示処理部は、前記ユーザが前記実空間において前記物体の場所を通過した場合に、前記ユーザ移動体又は前記仮想カメラが、前記特異点に対応する場所を通過したと判断してもよい。

In one aspect of the present invention, an object corresponding to the singular point is arranged in a play field in the real space in which the user moves, and the display processing unit is configured to allow the user to move the object in the real space. When passing through a place, it may be determined that the user moving body or the virtual camera has passed through a place corresponding to the singular point.

このようにすれば、実空間において、特異点に対応する物体の場所を実際に通過することで、対応するユーザ移動体又は仮想カメラが、特異点の場所を通過したと判断されるようになるため、ユーザの仮想現実感を向上できる。

In this way, by actually passing the location of the object corresponding to the singular point in the real space, it is determined that the corresponding user moving body or virtual camera has passed the location of the singular point. Therefore, the virtual reality of the user can be improved.

また本発明の一態様では、前記表示処理部は、前記特異点を設定又は非設定にする処理を行ってもよい。

In one aspect of the present invention, the display processing unit may perform processing for setting or not setting the singular point.

このようにすれば、特異点の設定、非設定を切り替えることが可能になり、より多様なゲーム処理やゲーム演出などを実現できるようになる。

This makes it possible to switch between setting and non-setting of singular points, and to realize more various game processing and game effects.

また本発明の一態様では、前記ユーザに仮想現実を体験させるための体感装置を制御する体感装置制御部を含み(体感装置制御部としてコンピュータを機能させ)、前記体感装置制御部は、前記切替条件が成立していない場合の前記体感装置の制御と、前記切替条件が成立した場合の前記体感装置の制御を異ならせてもよい。

Moreover, in one aspect of the present invention, it includes a sensation device control unit that controls a sensation device for allowing the user to experience virtual reality (a computer functions as the sensation device control unit), and the sensation device control unit includes the switching The control of the sensation apparatus when the condition is not satisfied may be different from the control of the sensation apparatus when the switching condition is satisfied.

このようにすれば、仮想空間が切り替わったことを、体感装置を用いてユーザに効果的に体感させることが可能になる。

This makes it possible for the user to effectively experience the fact that the virtual space has been switched using the sensation apparatus.

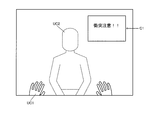

また本発明の一態様では、複数の前記ユーザがプレイする場合に、実空間でのユーザ間の衝突の報知情報の出力処理を行う報知処理部を含んでもよい(報知処理部としてコンピュータを機能させてもよい)。

Moreover, in one aspect of the present invention, when a plurality of users play, a notification processing unit that performs a process of outputting notification information of collision between users in real space may be included (a computer is caused to function as the notification processing unit). May be)

このようにすれば、例えば、仮想空間では衝突が発生していないのに、実空間においてユーザ間の衝突が発生するような状況において、ユーザ間の衝突の発生の可能性をユーザに対して効果的に報知できるようになる。

In this way, for example, in a situation where a collision between users occurs in the real space even though no collision occurs in the virtual space, the possibility of the occurrence of the collision between the users is effective for the user. Can be informed.

また本発明の一態様では、実空間での前記ユーザの位置情報を取得する情報取得部を含み(情報取得部としてコンピュータを機能させ)、前記移動体処理部は、取得された前記位置情報に基づいて、前記ユーザ移動体を移動させる処理を行い、前記表示処理部は、前記ユーザが装着する頭部装着型表示装置の表示画像を生成し、前記表示処理部は、前記切替条件が成立する前においては、前記実空間での前記ユーザの前記位置情報により特定される前記ユーザ移動体又は前記仮想カメラの前記位置情報を、前記第1の仮想空間の位置情報として設定し、前記切替条件が成立した場合には、前記実空間での前記ユーザの前記位置情報により特定される前記ユーザ移動体又は前記仮想カメラの前記位置情報を、前記第2の仮想空間の位置情報として設定してもよい。

Moreover, in one mode of the present invention, an information acquisition unit that acquires position information of the user in real space is included (a computer is caused to function as the information acquisition unit), and the moving body processing unit includes the acquired position information. The display processing unit generates a display image of a head-mounted display device worn by the user, and the display processing unit satisfies the switching condition. Before, the position information of the user moving body or the virtual camera specified by the position information of the user in the real space is set as the position information of the first virtual space, and the switching condition is If established, the position information of the user moving object or the virtual camera specified by the position information of the user in the real space is used as the position information of the second virtual space. It may be set Te.

このようにすれば、実空間でのユーザの位置情報が取得され、取得された位置情報に基づいて、仮想空間においてユーザ移動体等を移動するようになる。そして切替条件が成立すると、ユーザ移動体又は仮想カメラの位置が第1の仮想空間の位置から第2の仮想空間の位置に切り替わるようになり、複数の仮想空間を移動する仮想現実感を更に向上することが可能になる。

In this way, the position information of the user in the real space is acquired, and the user moving body or the like is moved in the virtual space based on the acquired position information. When the switching condition is satisfied, the position of the user moving body or the virtual camera is switched from the position of the first virtual space to the position of the second virtual space, further improving the virtual reality that moves in a plurality of virtual spaces. It becomes possible to do.

また本発明の一態様は、実空間でのユーザの位置情報を取得する情報取得部と、オブジェクトが配置される仮想空間の設定処理を行う仮想空間設定部と、取得された前記位置情報に基づいて、前記仮想空間において、ユーザに対応するユーザ移動体を移動させる処理を行う移動体処理部と、前記仮想空間において仮想カメラから見える画像の描画処理を行い、前記ユーザが装着する頭部装着型表示装置に表示する画像を生成する表示処理部と、を含み、前記仮想空間設定部は、前記仮想空間として、第1の仮想空間と、前記第1の仮想空間に対して特異点を介して結びつけられる第2の仮想空間とを設定し、前記表示処理部は、所与の切替条件が成立する前においては、前記実空間での前記ユーザの前記位置情報により特定される前記ユーザ移動体又は前記仮想カメラの前記位置情報を、前記第1の仮想空間の位置情報として設定し、第1の描画処理として、少なくとも前記第1の仮想空間の画像を描画する処理を行い、前記ユーザ移動体又は前記仮想カメラが前記特異点に対応する場所を第1の進行方向で通過することで前記切替条件が成立した場合には、前記実空間での前記ユーザの前記位置情報により特定される前記ユーザ移動体又は前記仮想カメラの前記位置情報を、前記第2の仮想空間の位置情報として設定し、第2の描画処理として、少なくとも前記第2の仮想空間の画像を描画する処理を行うシミュレーションシステムに関係する。また本発明は、上記各部としてコンピュータを機能させるプログラム、又は該プログラムを記憶したコンピュータ読み取り可能な情報記憶媒体に関係する。

One embodiment of the present invention is based on an information acquisition unit that acquires position information of a user in real space, a virtual space setting unit that performs setting processing of a virtual space in which an object is arranged, and the acquired position information. A moving body processing unit that performs a process of moving a user moving body corresponding to the user in the virtual space, and a head-mounted type that performs a drawing process of an image viewed from a virtual camera in the virtual space and is worn by the user A display processing unit configured to generate an image to be displayed on a display device, wherein the virtual space setting unit includes, as the virtual space, a first virtual space and a singular point with respect to the first virtual space. A second virtual space to be associated with each other, and the display processing unit sets the user specified by the position information of the user in the real space before a given switching condition is satisfied. The position information of the moving body or the virtual camera is set as the position information of the first virtual space, and as the first drawing process, at least an image of the first virtual space is drawn, and the user When the moving condition or the virtual camera passes through the place corresponding to the singular point in the first traveling direction and the switching condition is satisfied, it is specified by the position information of the user in the real space. Simulation that sets the position information of the user moving body or the virtual camera as position information of the second virtual space and performs a process of drawing at least an image of the second virtual space as a second drawing process. Related to the system. The present invention also relates to a program that causes a computer to function as each of the above-described units, or a computer-readable information storage medium that stores the program.

本発明の一態様によれば、実空間でのユーザの位置情報が取得され、取得された位置情報に基づいて、仮想空間においてユーザ移動体等を移動するようになる。そして切替条件が成立すると、ユーザ移動体又は仮想カメラの位置が、第1の仮想空間の位置から第2の仮想空間の位置に切り替わるようになる。これにより、複数の仮想空間を移動可能な仮想現実を実現できるシミュレーションシステム等の提供が可能になる。

According to one aspect of the present invention, user position information in real space is acquired, and a user moving body or the like is moved in the virtual space based on the acquired position information. When the switching condition is satisfied, the position of the user moving body or the virtual camera is switched from the position of the first virtual space to the position of the second virtual space. This makes it possible to provide a simulation system or the like that can realize a virtual reality that can move in a plurality of virtual spaces.

また本発明の他の態様は、オブジェクトが配置される仮想空間を設定する仮想空間設定処理と、前記仮想空間において、ユーザに対応するユーザ移動体を移動させる移動体処理と、前記仮想空間において仮想カメラから見える画像の描画処理を行う表示処理と、を行い、前記仮想空間設定処理において、前記仮想空間として、第1の仮想空間と、前記第1の仮想空間に対して特異点を介して結びつけられる第2の仮想空間とを設定し、前記表示処理において、所与の切替条件が成立する前は、前記ユーザ移動体又は前記仮想カメラの位置情報を、前記第1の仮想空間の位置情報として設定し、第1の描画処理として、前記第1の仮想空間の画像に加えて前記第2の仮想空間の画像を描画する処理を行って、前記特異点に対応する領域に前記第2の仮想空間の画像が表示される画像を生成し、前記ユーザ移動体又は前記仮想カメラが前記特異点に対応する場所を第1の進行方向で通過することで前記切替条件が成立した場合には、前記ユーザ移動体又は前記仮想カメラの前記位置情報を、前記第2の仮想空間の位置情報として設定し、第2の描画処理として、前記第2の仮想空間の画像に加えて前記第1の仮想空間の画像を描画する処理を行って、前記特異点に対応する領域に前記第1の仮想空間の画像が表示される画像を生成し、前記表示処理において、前記仮想カメラの視線方向が、前記第1の進行方向の反対方向側を向いた場合に、前記特異点に対応する領域に前記第1の仮想空間の画像が表示される画像を生成する画像処理方法に関係する。

According to another aspect of the present invention, there is provided a virtual space setting process for setting a virtual space in which an object is arranged, a moving body process for moving a user moving body corresponding to a user in the virtual space, and a virtual space in the virtual space. Display processing for rendering an image visible from the camera, and in the virtual space setting processing, the virtual space is connected to the first virtual space and the first virtual space via a singular point The position information of the user moving body or the virtual camera is used as the position information of the first virtual space before a given switching condition is satisfied in the display process. Set and perform a process of drawing the image of the second virtual space in addition to the image of the first virtual space as the first drawing process, and the region corresponding to the singular point When an image in which an image of the virtual space of 2 is displayed is generated and the user moving body or the virtual camera passes through the place corresponding to the singular point in the first traveling direction, the switching condition is satisfied. Sets the position information of the user moving body or the virtual camera as the position information of the second virtual space, and in addition to the image of the second virtual space as the second drawing process, the first information To generate an image in which the image of the first virtual space is displayed in an area corresponding to the singular point. In the display process, the line-of-sight direction of the virtual camera is The present invention relates to an image processing method for generating an image in which an image of the first virtual space is displayed in a region corresponding to the singular point when facing in the direction opposite to the first traveling direction.

また本発明の他の態様は、実空間でのユーザの位置情報を取得する情報取得処理と、オブジェクトが配置される仮想空間を設定する仮想空間設定処理と、取得された前記位置情報に基づいて、前記仮想空間において、ユーザに対応するユーザ移動体を移動させる移動体処理と、前記仮想空間において仮想カメラから見える画像の描画処理を行い、前記ユーザが装着する頭部装着型表示装置に表示する画像を生成する表示処理と、を行い、前記仮想空間設定処理において、前記仮想空間として、第1の仮想空間と、前記第1の仮想空間に対して特異点を介して結びつけられる第2の仮想空間とを設定し、前記表示処理において、所与の切替条件が成立する前は、前記実空間での前記ユーザの前記位置情報により特定される前記ユーザ移動体又は前記仮想カメラの前記位置情報を、前記第1の仮想空間の位置情報として設定し、第1の描画処理として、少なくとも前記第1の仮想空間の画像を描画する処理を行い、前記ユーザ移動体又は前記仮想カメラが前記特異点に対応する場所を第1の進行方向で通過することで前記切替条件が成立した場合には、前記実空間での前記ユーザの前記位置情報により特定される前記ユーザ移動体又は前記仮想カメラの前記位置情報を、前記第2の仮想空間の位置情報として設定し、第2の描画処理として、少なくとも前記第2の仮想空間の画像を描画する処理を行う画像処理方法に関係する。

Another aspect of the present invention is based on information acquisition processing for acquiring user location information in real space, virtual space setting processing for setting a virtual space in which an object is placed, and the acquired location information. In the virtual space, a moving body process for moving a user moving body corresponding to the user and a drawing process for an image visible from the virtual camera in the virtual space are performed and displayed on the head-mounted display device worn by the user. Display processing for generating an image, and in the virtual space setting processing, as the virtual space, a first virtual space and a second virtual linked to the first virtual space via a singular point In the display process, before the given switching condition is satisfied, the user moving body or the user specified by the position information of the user in the real space is set. The position information of the virtual camera is set as the position information of the first virtual space, and as a first drawing process, a process of drawing at least an image of the first virtual space is performed, and the user moving object or The user movement specified by the position information of the user in the real space when the switching condition is satisfied when the virtual camera passes through a place corresponding to the singular point in a first traveling direction. An image processing method for setting the position information of a body or the virtual camera as position information of the second virtual space and performing at least a process of drawing an image of the second virtual space as a second drawing process Involved.

以下、本実施形態について説明する。なお、以下に説明する本実施形態は、請求の範囲に記載された本発明の内容を不当に限定するものではない。また本実施形態で説明される構成の全てが、本発明の必須構成要件であるとは限らない。

Hereinafter, this embodiment will be described. In addition, this embodiment demonstrated below does not unduly limit the content of this invention described in the claim. In addition, all the configurations described in the present embodiment are not necessarily essential configuration requirements of the present invention.

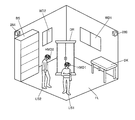

1.シミュレーションシステム

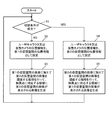

図1は、本実施形態のシミュレーションシステム(シミュレータ、ゲームシステム、画像生成システム)の構成例を示すブロック図である。本実施形態のシミュレーションシステムは例えばバーチャルリアリティ(VR)をシミュレートするシステムであり、ゲームコンテンツを提供するゲームシステム、スポーツ競技シミュレータや運転シミュレータなどのリアルタイムシミュレーションシステム、SNSのサービスを提供するシステム、映像等のコンテンツを提供するコンテンツ提供システム、或いは遠隔作業を実現するオペレーティングシステムなどの種々のシステムに適用可能である。なお、本実施形態のシミュレーションシステムは図1の構成に限定されず、その構成要素(各部)の一部を省略したり、他の構成要素を追加するなどの種々の変形実施が可能である。 1. Simulation System FIG. 1 is a block diagram illustrating a configuration example of a simulation system (a simulator, a game system, and an image generation system) according to the present embodiment. The simulation system of this embodiment is a system that simulates virtual reality (VR), for example, a game system that provides game content, a real-time simulation system such as a sports competition simulator and a driving simulator, a system that provides SNS services, and video The present invention can be applied to various systems such as a content providing system that provides content such as an operating system that implements remote work. Note that the simulation system of the present embodiment is not limited to the configuration shown in FIG. 1, and various modifications such as omitting some of the components (each unit) or adding other components are possible.

図1は、本実施形態のシミュレーションシステム(シミュレータ、ゲームシステム、画像生成システム)の構成例を示すブロック図である。本実施形態のシミュレーションシステムは例えばバーチャルリアリティ(VR)をシミュレートするシステムであり、ゲームコンテンツを提供するゲームシステム、スポーツ競技シミュレータや運転シミュレータなどのリアルタイムシミュレーションシステム、SNSのサービスを提供するシステム、映像等のコンテンツを提供するコンテンツ提供システム、或いは遠隔作業を実現するオペレーティングシステムなどの種々のシステムに適用可能である。なお、本実施形態のシミュレーションシステムは図1の構成に限定されず、その構成要素(各部)の一部を省略したり、他の構成要素を追加するなどの種々の変形実施が可能である。 1. Simulation System FIG. 1 is a block diagram illustrating a configuration example of a simulation system (a simulator, a game system, and an image generation system) according to the present embodiment. The simulation system of this embodiment is a system that simulates virtual reality (VR), for example, a game system that provides game content, a real-time simulation system such as a sports competition simulator and a driving simulator, a system that provides SNS services, and video The present invention can be applied to various systems such as a content providing system that provides content such as an operating system that implements remote work. Note that the simulation system of the present embodiment is not limited to the configuration shown in FIG. 1, and various modifications such as omitting some of the components (each unit) or adding other components are possible.

操作部160は、ユーザ(プレーヤ)が種々の操作情報(入力情報)を入力するためのものである。操作部160は、例えば操作ボタン、方向指示キー、ジョイスティック、ハンドル、ペダル、レバー又は音声入力装置等の種々の操作デバイスにより実現できる。

The operation unit 160 is for a user (player) to input various operation information (input information). The operation unit 160 can be realized by various operation devices such as an operation button, a direction instruction key, a joystick, a handle, a pedal, a lever, or a voice input device.

記憶部170は各種の情報を記憶する。記憶部170は、処理部100や通信部196などのワーク領域として機能する。ゲームプログラムや、ゲームプログラムの実行に必要なゲームデータは、この記憶部170に保持される。記憶部170の機能は、半導体メモリ(DRAM、VRAM)、HDD(ハードディスクドライブ)、SSD、光ディスク装置などにより実現できる。記憶部170は、オブジェクト情報記憶部172、描画バッファ178を含む。

The storage unit 170 stores various types of information. The storage unit 170 functions as a work area such as the processing unit 100 or the communication unit 196. The game program and game data necessary for executing the game program are held in the storage unit 170. The function of the storage unit 170 can be realized by a semiconductor memory (DRAM, VRAM), HDD (Hard Disk Drive), SSD, optical disk device, or the like. The storage unit 170 includes an object information storage unit 172 and a drawing buffer 178.

情報記憶媒体180(コンピュータにより読み取り可能な媒体)は、プログラムやデータなどを格納するものであり、その機能は、光ディスク(DVD、BD、CD)、HDD、或いは半導体メモリ(ROM)などにより実現できる。処理部100は、情報記憶媒体180に格納されるプログラム(データ)に基づいて本実施形態の種々の処理を行う。即ち情報記憶媒体180には、本実施形態の各部としてコンピュータ(入力装置、処理部、記憶部、出力部を備える装置)を機能させるためのプログラム(各部の処理をコンピュータに実行させるためのプログラム)が記憶される。

The information storage medium 180 (a computer-readable medium) stores programs, data, and the like, and its function can be realized by an optical disk (DVD, BD, CD), HDD, semiconductor memory (ROM), or the like. . The processing unit 100 performs various processes of the present embodiment based on a program (data) stored in the information storage medium 180. That is, in the information storage medium 180, a program for causing a computer (an apparatus including an input device, a processing unit, a storage unit, and an output unit) to function as each unit of the present embodiment (a program for causing the computer to execute processing of each unit). Is memorized.

HMD200(頭部装着型表示装置)は、ユーザの頭部に装着されて、ユーザの眼前に画像を表示する装置である。HMD200は非透過型であることが望ましいが、透過型であってもよい。またHMD200は、いわゆるメガネタイプのHMDであってもよい。

The HMD 200 (head-mounted display device) is a device that is mounted on the user's head and displays an image in front of the user's eyes. The HMD 200 is preferably a non-transmissive type, but may be a transmissive type. The HMD 200 may be a so-called glasses-type HMD.

HMD200は、センサ部210、表示部220、処理部240を含む。なおHMD200に発光素子を設ける変形実施も可能である。センサ部210は、例えばヘッドトラッキングなどのトラッキング処理を実現するためものである。例えばセンサ部210を用いたトラッキング処理により、HMD200の位置、方向を特定する。HMD200の位置、方向が特定されることで、ユーザの視点位置、視線方向を特定できる。

The HMD 200 includes a sensor unit 210, a display unit 220, and a processing unit 240. A modification in which a light emitting element is provided in the HMD 200 is also possible. The sensor unit 210 is for realizing tracking processing such as head tracking, for example. For example, the position and direction of the HMD 200 are specified by tracking processing using the sensor unit 210. By specifying the position and direction of the HMD 200, the user's viewpoint position and line-of-sight direction can be specified.

トラッキング方式としては種々の方式を採用できる。トラッキング方式の一例である第1のトラッキング方式では、後述の図2(A)、図2(B)で詳細に説明するように、センサ部210として複数の受光素子(フォトダイオード等)を設ける。そして外部に設けられた発光素子(LED等)からの光(レーザー等)をこれらの複数の受光素子により受光することで、現実世界の3次元空間でのHMD200(ユーザの頭部)の位置、方向を特定する。第2のトラッキング方式では、後述の図3(A)、図3(B)で詳細に説明するように、複数の発光素子(LED)をHMD200に設ける。そして、これらの複数の発光素子からの光を、外部に設けられた撮像部で撮像することで、HMD200の位置、方向を特定する。第3のトラッキング方式では、センサ部210としてモーションセンサを設け、このモーションセンサを用いてHMD200の位置、方向を特定する。モーションセンサは例えば加速度センサやジャイロセンサなどにより実現できる。例えば3軸の加速度センサと3軸のジャイロセンサを用いた6軸のモーションセンサを用いることで、現実世界の3次元空間でのHMD200の位置、方向を特定できる。なお、第1のトラッキング方式と第2のトラッキング方式の組合わせ、或いは第1のトラッキング方式と第3のトラッキング方式の組合わせなどにより、HMD200の位置、方向を特定してもよい。またHMD200の位置、方向を特定することでユーザの視点位置、視線方向を特定するのではなく、ユーザの視点位置、視線方向を直接に特定するトラッキング処理を採用してもよい。

A variety of tracking methods can be used. In the first tracking method, which is an example of the tracking method, a plurality of light receiving elements (photodiodes and the like) are provided as the sensor unit 210, as will be described in detail with reference to FIGS. 2A and 2B described later. Then, by receiving light (laser or the like) from a light emitting element (LED or the like) provided outside by the plurality of light receiving elements, the position of the HMD 200 (user's head) in the real world three-dimensional space, Identify the direction. In the second tracking method, a plurality of light emitting elements (LEDs) are provided in the HMD 200 as will be described in detail with reference to FIGS. 3A and 3B described later. And the position and direction of HMD200 are pinpointed by imaging the light from these light emitting elements with the imaging part provided outside. In the third tracking method, a motion sensor is provided as the sensor unit 210, and the position and direction of the HMD 200 are specified using this motion sensor. The motion sensor can be realized by, for example, an acceleration sensor or a gyro sensor. For example, by using a 6-axis motion sensor using a 3-axis acceleration sensor and a 3-axis gyro sensor, the position and direction of the HMD 200 in a three-dimensional space in the real world can be specified. Note that the position and direction of the HMD 200 may be specified by a combination of the first tracking method and the second tracking method, or a combination of the first tracking method and the third tracking method. Further, instead of specifying the user's viewpoint position and line-of-sight direction by specifying the position and direction of the HMD 200, tracking processing that directly specifies the user's viewpoint position and line-of-sight direction may be employed.

HMD200の表示部220は例えば有機ELディスプレイ(OEL)や液晶ディスプレイ(LCD)などにより実現できる。例えばHMD200の表示部220には、ユーザの左眼の前に設定される第1のディスプレイ又は第1の表示領域と、右眼の前に設定される第2のディスプレイ又は第2の表示領域が設けられており、立体視表示が可能になっている。立体視表示を行う場合には、例えば視差が異なる左眼用画像と右眼用画像を生成し、第1のディスプレイに左眼用画像を表示し、第2のディスプレイに右眼用画像を表示する。或いは1つのディスプレイの第1の表示領域に左眼用画像を表示し、第2の表示領域に右眼用画像を表示する。またHMD200には左眼用、右眼用の2つの接眼レンズ(魚眼レンズ)が設けられており、これによりユーザの視界の全周囲に亘って広がるVR空間が表現される。そして接眼レンズ等の光学系で生じる歪みを補正するための補正処理が、左眼用画像、右眼用画像に対して行われる。この補正処理は表示処理部120が行う。

The display unit 220 of the HMD 200 can be realized by, for example, an organic EL display (OEL) or a liquid crystal display (LCD). For example, the display unit 220 of the HMD 200 includes a first display or first display area set in front of the user's left eye and a second display or second display area set in front of the right eye. It is provided and stereoscopic display is possible. When performing stereoscopic display, for example, a left-eye image and a right-eye image with different parallax are generated, a left-eye image is displayed on the first display, and a right-eye image is displayed on the second display. To do. Alternatively, the left-eye image is displayed in the first display area of one display, and the right-eye image is displayed in the second display area. The HMD 200 is provided with two eyepiece lenses (fisheye lenses) for the left eye and the right eye, thereby expressing a VR space that extends over the entire perimeter of the user's field of view. Then, correction processing for correcting distortion generated in an optical system such as an eyepiece is performed on the left-eye image and the right-eye image. This correction process is performed by the display processing unit 120.

HMD200の処理部240は、HMD200において必要な各種の処理を行う。例えば処理部240は、センサ部210の制御処理や表示部220の表示制御処理などを行う。また処理部240が、3次元音響(立体音響)処理を行って、3次元的な音の方向や距離や広がりの再現を実現してもよい。

The processing unit 240 of the HMD 200 performs various processes necessary for the HMD 200. For example, the processing unit 240 performs control processing of the sensor unit 210, display control processing of the display unit 220, and the like. Further, the processing unit 240 may perform a three-dimensional sound (stereoscopic sound) process to realize reproduction of a three-dimensional sound direction, distance, and spread.

なお、図1ではシミュレーションシステムの表示部がHMD200である場合の例を示しているが、シミュレーションシステムの表示部はHMD以外のタイプの表示部であってもよい。例えばシミュレーションシステムの表示部は、例えば業務用ゲーム装置におけるディスプレイ(通常の2Dモニターやドームスクリーン)や、家庭用ゲーム装置におけるテレビや、パーソナルコンピュータ(PC)におけるディスプレイなどであってもよい。

In addition, although the example in case the display part of a simulation system is HMD200 is shown in FIG. 1, the display part of a simulation system may be a display part of types other than HMD. For example, the display unit of the simulation system may be, for example, a display (ordinary 2D monitor or dome screen) in an arcade game device, a television in a home game device, or a display in a personal computer (PC).

音出力部192は、本実施形態により生成された音を出力するものであり、例えばスピーカ又はヘッドホン等により実現できる。

The sound output unit 192 outputs the sound generated by the present embodiment, and can be realized by, for example, a speaker or headphones.

I/F(インターフェース)部194は、携帯型情報記憶媒体195とのインターフェース処理を行うものであり、その機能はI/F処理用のASICなどにより実現できる。携帯型情報記憶媒体195は、ユーザが各種の情報を保存するためのものであり、電源が非供給になった場合にもこれらの情報の記憶を保持する記憶装置である。携帯型情報記憶媒体195は、ICカード(メモリカード)、USBメモリ、或いは磁気カードなどにより実現できる。

The I / F (interface) unit 194 performs interface processing with the portable information storage medium 195, and its function can be realized by an ASIC for I / F processing or the like. The portable information storage medium 195 is for a user to save various types of information, and is a storage device that retains storage of such information even when power is not supplied. The portable information storage medium 195 can be realized by an IC card (memory card), a USB memory, a magnetic card, or the like.

通信部196は、有線や無線のネットワークを介して外部(他の装置)との間で通信を行うものであり、その機能は、通信用ASIC又は通信用プロセッサなどのハードウェアや、通信用ファームウェアにより実現できる。

The communication unit 196 communicates with the outside (another apparatus) via a wired or wireless network, and functions thereof are hardware such as a communication ASIC or communication processor, or communication firmware. Can be realized.

なお本実施形態の各部としてコンピュータを機能させるためのプログラム(データ)は、サーバ(ホスト装置)が有する情報記憶媒体からネットワーク及び通信部196を介して情報記憶媒体180(あるいは記憶部170)に配信してもよい。このようなサーバ(ホスト装置)による情報記憶媒体の使用も本発明の範囲内に含めることができる。

A program (data) for causing a computer to function as each unit of this embodiment is distributed from the information storage medium of the server (host device) to the information storage medium 180 (or storage unit 170) via the network and communication unit 196. May be. Use of an information storage medium by such a server (host device) can also be included in the scope of the present invention.

処理部100(プロセッサ)は、操作部160からの操作情報や、HMD200でのトラッキング情報(HMDの位置及び方向の少なくとも一方の情報。視点位置及び視線方向の少なくとも一方の情報)や、プログラムなどに基づいて、ゲーム処理(シミュレーション処理)、仮想空間設定処理、移動体処理、仮想カメラ制御処理、表示処理、或いは音処理などを行う。

The processing unit 100 (processor) is used for operation information from the operation unit 160, tracking information in the HMD 200 (information on at least one of the position and direction of the HMD, information on at least one of the viewpoint position and the line-of-sight direction), a program, and the like. Based on this, game processing (simulation processing), virtual space setting processing, moving body processing, virtual camera control processing, display processing, sound processing, or the like is performed.

処理部100の各部が行う本実施形態の各処理(各機能)はプロセッサ(ハードウェアを含むプロセッサ)により実現できる。例えば本実施形態の各処理は、プログラム等の情報に基づき動作するプロセッサと、プログラム等の情報を記憶するメモリにより実現できる。プロセッサは、例えば各部の機能が個別のハードウェアで実現されてもよいし、或いは各部の機能が一体のハードウェアで実現されてもよい。例えば、プロセッサはハードウェアを含み、そのハードウェアは、デジタル信号を処理する回路及びアナログ信号を処理する回路の少なくとも一方を含むことができる。例えば、プロセッサは、回路基板に実装された1又は複数の回路装置(例えばIC等)や、1又は複数の回路素子(例えば抵抗、キャパシター等)で構成することもできる。プロセッサは、例えばCPU(Central Processing Unit)であってもよい。但し、プロセッサはCPUに限定されるものではなく、GPU(Graphics Processing Unit)、或いはDSP(Digital Signal Processor)等、各種のプロセッサを用いることが可能である。またプロセッサはASICによるハードウェア回路であってもよい。またプロセッサは、アナログ信号を処理するアンプ回路やフィルター回路等を含んでもよい。メモリ(記憶部170)は、SRAM、DRAM等の半導体メモリであってもよいし、レジスターであってもよい。或いはハードディスク装置(HDD)等の磁気記憶装置であってもよいし、光学ディスク装置等の光学式記憶装置であってもよい。例えば、メモリはコンピュータにより読み取り可能な命令を格納しており、当該命令がプロセッサにより実行されることで、処理部100の各部の処理(機能)が実現されることになる。ここでの命令は、プログラムを構成する命令セットでもよいし、プロセッサのハードウェア回路に対して動作を指示する命令であってもよい。

Each process (each function) of this embodiment performed by each unit of the processing unit 100 can be realized by a processor (a processor including hardware). For example, each process of the present embodiment can be realized by a processor that operates based on information such as a program and a memory that stores information such as a program. In the processor, for example, the function of each unit may be realized by individual hardware, or the function of each unit may be realized by integrated hardware. For example, the processor may include hardware, and the hardware may include at least one of a circuit that processes a digital signal and a circuit that processes an analog signal. For example, the processor can be configured by one or a plurality of circuit devices (for example, ICs) mounted on a circuit board or one or a plurality of circuit elements (for example, resistors, capacitors, etc.). The processor may be, for example, a CPU (Central Processing Unit). However, the processor is not limited to the CPU, and various processors such as a GPU (GraphicsGProcessing Unit) or a DSP (Digital Signal Processor) can be used. The processor may be an ASIC hardware circuit. The processor may include an amplifier circuit, a filter circuit, and the like that process an analog signal. The memory (storage unit 170) may be a semiconductor memory such as SRAM or DRAM, or may be a register. Alternatively, it may be a magnetic storage device such as a hard disk device (HDD) or an optical storage device such as an optical disk device. For example, the memory stores instructions that can be read by a computer, and the processing (function) of each unit of the processing unit 100 is realized by executing the instructions by the processor. The instruction here may be an instruction set constituting a program, or an instruction for instructing an operation to the hardware circuit of the processor.

処理部100は、入力処理部102、演算処理部110、出力処理部140を含む。演算処理部110は、情報取得部111、仮想空間設定部112、移動体処理部113、仮想カメラ制御部114、ゲーム処理部115、報知処理部116、体感装置制御部117、表示処理部120、音処理部130を含む。上述したように、これらの各部により実行される本実施形態の各処理は、プロセッサ(或いはプロセッサ及びメモリ)により実現できる。なお、これらの構成要素(各部)の一部を省略したり、他の構成要素を追加するなどの種々の変形実施が可能である。

The processing unit 100 includes an input processing unit 102, an arithmetic processing unit 110, and an output processing unit 140. The arithmetic processing unit 110 includes an information acquisition unit 111, a virtual space setting unit 112, a moving body processing unit 113, a virtual camera control unit 114, a game processing unit 115, a notification processing unit 116, a sensation device control unit 117, a display processing unit 120, A sound processing unit 130 is included. As described above, each process of the present embodiment executed by these units can be realized by a processor (or a processor and a memory). Various modifications such as omitting some of these components (each unit) or adding other components are possible.

入力処理部102は、操作情報やトラッキング情報を受け付ける処理や、記憶部170から情報を読み出す処理や、通信部196を介して情報を受信する処理を、入力処理として行う。例えば入力処理部102は、操作部160を用いてユーザが入力した操作情報やHMD200のセンサ部210等により検出されたトラッキング情報を取得する処理や、読み出し命令で指定された情報を、記憶部170から読み出す処理や、外部装置(サーバ等)からネットワークを介して情報を受信する処理を、入力処理として行う。ここで受信処理は、通信部196に情報の受信を指示したり、通信部196が受信した情報を取得して記憶部170に書き込む処理などである。

The input processing unit 102 performs processing for receiving operation information and tracking information, processing for reading information from the storage unit 170, and processing for receiving information via the communication unit 196 as input processing. For example, the input processing unit 102 stores, in the storage unit 170, processing for acquiring operation information input by the user using the operation unit 160, tracking information detected by the sensor unit 210 of the HMD 200, and the information specified by the read command. A process for reading data from a computer or a process for receiving information from an external device (such as a server) via a network is performed as an input process. Here, the reception process includes a process of instructing the communication unit 196 to receive information, a process of acquiring information received by the communication unit 196, and writing the information in the storage unit 170, and the like.

演算処理部110は、各種の演算処理を行う。例えば情報取得処理、仮想空間設定処理、移動体処理、仮想カメラ制御処理、ゲーム処理(シミュレーション処理)、表示処理、或いは音処理などの演算処理を行う。

The arithmetic processing unit 110 performs various arithmetic processes. For example, arithmetic processing such as information acquisition processing, virtual space setting processing, moving body processing, virtual camera control processing, game processing (simulation processing), display processing, or sound processing is performed.

情報取得部111(情報取得処理のプログラムモジュール)は種々の情報の取得処理を行う。例えば情報取得部111は、HMD200を装着するユーザの位置情報などを取得する。情報取得部111はユーザの方向情報などを取得してもよい。

The information acquisition unit 111 (program module for information acquisition processing) performs various information acquisition processing. For example, the information acquisition unit 111 acquires position information of the user wearing the HMD 200 and the like. The information acquisition unit 111 may acquire user direction information and the like.

仮想空間設定部112(仮想空間設定処理のプログラムモジュール)は、オブジェクトが配置される仮想空間(オブジェクト空間)の設定処理を行う。例えば、移動体(人、ロボット、車、電車、飛行機、船、モンスター又は動物等)、マップ(地形)、建物、観客席、コース(道路)、樹木、壁、水面などの表示物を表す各種オブジェクト(ポリゴン、自由曲面又はサブディビジョンサーフェイスなどのプリミティブ面で構成されるオブジェクト)を仮想空間に配置設定する処理を行う。即ちワールド座標系でのオブジェクトの位置や回転角度(向き、方向と同義)を決定し、その位置(X、Y、Z)にその回転角度(X、Y、Z軸回りでの回転角度)でオブジェクトを配置する。具体的には、記憶部170のオブジェクト情報記憶部172には、仮想空間でのオブジェクト(パーツオブジェクト)の位置、回転角度、移動速度、移動方向等の情報であるオブジェクト情報がオブジェクト番号に対応づけて記憶される。仮想空間設定部112は、例えば各フレーム毎にこのオブジェクト情報を更新する処理などを行う。

The virtual space setting unit 112 (program module for virtual space setting processing) performs setting processing for a virtual space (object space) in which objects are arranged. For example, various objects representing display objects such as moving objects (people, robots, cars, trains, airplanes, ships, monsters, animals, etc.), maps (terrain), buildings, auditoriums, courses (roads), trees, walls, water surfaces, etc. A process of placing and setting an object (an object composed of a primitive surface such as a polygon, a free-form surface, or a subdivision surface) in a virtual space is performed. In other words, the position and rotation angle of the object in the world coordinate system (synonymous with direction and direction) are determined, and the rotation angle (rotation angle around the X, Y, and Z axes) is determined at that position (X, Y, Z). Arrange objects. Specifically, in the object information storage unit 172 of the storage unit 170, object information that is information such as the position, rotation angle, moving speed, and moving direction of an object (part object) in the virtual space is associated with the object number. Is memorized. The virtual space setting unit 112 performs a process of updating the object information for each frame, for example.

移動体処理部113(移動体処理のプログラムモジュール)は、仮想空間内で移動する移動体についての種々の処理を行う。例えば仮想空間(オブジェクト空間、ゲーム空間)において移動体を移動させる処理や、移動体を動作させる処理を行う。例えば移動体処理部113は、操作部160によりユーザが入力した操作情報や、取得されたトラッキング情報や、プログラム(移動・動作アルゴリズム)や、各種データ(モーションデータ)などに基づいて、移動体(モデルオブジェクト)を仮想空間内で移動させたり、移動体を動作(モーション、アニメーション)させる制御処理を行う。具体的には、移動体の移動情報(位置、回転角度、速度、或いは加速度)や動作情報(パーツオブジェクトの位置、或いは回転角度)を、1フレーム(例えば1/60秒)毎に順次求めるシミュレーション処理を行う。なおフレームは、移動体の移動・動作処理(シミュレーション処理)や画像生成処理を行う時間の単位である。移動体は、例えば実空間のユーザ(プレーヤ)に対応するユーザ移動体である。ユーザ移動体は、仮想空間の仮想ユーザ(仮想プレーヤ、アバター)や、或いは当該仮想ユーザが搭乗(操作)する搭乗移動体(操作移動体)などである。

The moving body processing unit 113 (moving body processing program module) performs various processes on the moving body moving in the virtual space. For example, processing for moving the moving body in virtual space (object space, game space) and processing for moving the moving body are performed. For example, the mobile object processing unit 113 is based on operation information input by the user through the operation unit 160, acquired tracking information, a program (movement / motion algorithm), various data (motion data), and the like. Control processing for moving the model object) in the virtual space or moving the moving object (motion, animation) is performed. Specifically, a simulation for sequentially obtaining movement information (position, rotation angle, speed, or acceleration) and motion information (part object position or rotation angle) of a moving body for each frame (for example, 1/60 second). Process. A frame is a unit of time for performing a moving / movement process (simulation process) and an image generation process of a moving object. The moving body is, for example, a user moving body corresponding to a user (player) in real space. The user moving body is a virtual user (virtual player, avatar) in the virtual space, or a boarding moving body (operation moving body) on which the virtual user is boarded (operated).

仮想カメラ制御部114(仮想カメラ制御処理のプログラムモジュール)は、仮想カメラの制御を行う。例えば、操作部160により入力されたユーザの操作情報やトラッキング情報などに基づいて、仮想カメラを制御する処理を行う。

The virtual camera control unit 114 (virtual camera control processing program module) controls the virtual camera. For example, a process for controlling the virtual camera is performed based on user operation information, tracking information, and the like input by the operation unit 160.

例えば仮想カメラ制御部114は、ユーザの一人称視点又は三人称視点として設定される仮想カメラの制御を行う。例えば仮想空間において移動するユーザ移動体の視点(一人称視点)に対応する位置に、仮想カメラを設定して、仮想カメラの視点位置や視線方向を設定することで、仮想カメラの位置(位置座標)や姿勢(回転軸回りでの回転角度)を制御する。或いは、ユーザ移動体に追従する視点(三人称視点)の位置に、仮想カメラを設定して、仮想カメラの視点位置や視線方向を設定することで、仮想カメラの位置や姿勢を制御する。

For example, the virtual camera control unit 114 controls the virtual camera set as the first-person viewpoint or the third-person viewpoint of the user. For example, by setting a virtual camera at a position corresponding to the viewpoint (first-person viewpoint) of a user moving body moving in the virtual space, and setting the viewpoint position and line-of-sight direction of the virtual camera, the position (positional coordinates) of the virtual camera And control the attitude (rotation angle around the rotation axis). Alternatively, the position and orientation of the virtual camera are controlled by setting the virtual camera at the position of the viewpoint (third-person viewpoint) following the user moving body and setting the viewpoint position and line-of-sight direction of the virtual camera.

例えば仮想カメラ制御部114は、視点トラッキングにより取得されたユーザの視点情報のトラッキング情報に基づいて、ユーザの視点変化に追従するように仮想カメラを制御する。例えば本実施形態では、ユーザの視点位置、視線方向の少なくとも1つである視点情報のトラッキング情報(視点トラッキング情報)が取得される。このトラッキング情報は、例えばHMD200のトラッキング処理を行うことで取得できる。そして仮想カメラ制御部114は、取得されたトラッキング情報(ユーザの視点位置及び視線方向の少なくとも一方の情報)に基づいて仮想カメラの視点位置、視線方向を変化させる。例えば、仮想カメラ制御部114は、実空間でのユーザの視点位置、視線方向の変化に応じて、仮想空間での仮想カメラの視点位置、視線方向(位置、姿勢)が変化するように、仮想カメラを設定する。このようにすることで、ユーザの視点情報のトラッキング情報に基づいて、ユーザの視点変化に追従するように仮想カメラを制御できる。

For example, the virtual camera control unit 114 controls the virtual camera so as to follow the change of the user's viewpoint based on the tracking information of the user's viewpoint information acquired by the viewpoint tracking. For example, in the present embodiment, tracking information (viewpoint tracking information) of viewpoint information that is at least one of the user's viewpoint position and line-of-sight direction is acquired. This tracking information can be acquired by performing tracking processing of the HMD 200, for example. Then, the virtual camera control unit 114 changes the viewpoint position and the line-of-sight direction of the virtual camera based on the acquired tracking information (information on at least one of the user's viewpoint position and the line-of-sight direction). For example, the virtual camera control unit 114 is configured so that the viewpoint position and the line-of-sight direction (position and posture) of the virtual camera change in the virtual space according to changes in the viewpoint position and the line-of-sight direction of the user in the real space. Set up the camera. By doing in this way, a virtual camera can be controlled to follow a user's viewpoint change based on tracking information of a user's viewpoint information.

ゲーム処理部115(ゲーム処理のプログラムモジュール)は、ユーザがゲームをプレイするための種々のゲーム処理を行う。別の言い方をすれば、ゲーム処理部115(シミュレーション処理部)は、ユーザが仮想現実(バーチャルリアリティ)を体験するための種々のシミュレーション処理を実行する。ゲーム処理は、例えば、ゲーム開始条件が満たされた場合にゲームを開始する処理、開始したゲームを進行させる処理、ゲーム終了条件が満たされた場合にゲームを終了する処理、或いはゲーム成績を演算する処理などである。

The game processor 115 (game processing program module) performs various game processes for the user to play the game. In other words, the game processing unit 115 (simulation processing unit) executes various simulation processes for the user to experience virtual reality (virtual reality). The game process is, for example, a process for starting a game when a game start condition is satisfied, a process for advancing the started game, a process for ending a game when a game end condition is satisfied, or calculating a game result. Processing.

報知処理部116(報知処理のプログラムモジュール)は各種の報知処理を行う。例えばユーザに対する警告の報知処理などを行う。報知処理は、例えば画像や音による報知処理であってもよいし、振動デバイスや音響や空気砲などの体感装置を用いた報知処理であってもよい。体感装置制御部117(体感装置制御処理のプログラムモジュール)は、体感装置の各種の制御処理を行う。例えばユーザに仮想現実を体験させるための体感装置の制御を行う。

The notification processing unit 116 (program module for notification processing) performs various types of notification processing. For example, a warning notification process for the user is performed. The notification process may be a notification process using an image or sound, for example, or may be a notification process using a sensation device such as a vibration device, sound, or an air cannon. The sensation device control unit 117 (program module for sensation device control processing) performs various control processes of the sensation device. For example, the sensation device is controlled to allow the user to experience virtual reality.

表示処理部120(表示処理のプログラムモジュール)は、ゲーム画像(シミュレーション画像)の表示処理を行う。例えば処理部100で行われる種々の処理(ゲーム処理、シミュレーション処理)の結果に基づいて描画処理を行い、これにより画像を生成し、表示部220に表示する。具体的には、座標変換(ワールド座標変換、カメラ座標変換)、クリッピング処理、透視変換、或いは光源処理等のジオメトリ処理が行われ、その処理結果に基づいて、描画データ(プリミティブ面の頂点の位置座標、テクスチャ座標、色データ、法線ベクトル或いはα値等)が作成される。そして、この描画データ(プリミティブ面データ)に基づいて、透視変換後(ジオメトリ処理後)のオブジェクト(1又は複数プリミティブ面)を、描画バッファ178(フレームバッファ、ワークバッファ等のピクセル単位で画像情報を記憶できるバッファ)に描画する。これにより、仮想空間において仮想カメラ(所与の視点。左眼用、右眼用の第1、第2の視点)から見える画像が生成される。なお、表示処理部120で行われる描画処理は、頂点シェーダ処理やピクセルシェーダ処理等により実現することができる。

The display processing unit 120 (display processing program module) performs display processing of a game image (simulation image). For example, a drawing process is performed based on the results of various processes (game process, simulation process) performed by the processing unit 100, thereby generating an image and displaying it on the display unit 220. Specifically, geometric processing such as coordinate transformation (world coordinate transformation, camera coordinate transformation), clipping processing, perspective transformation, or light source processing is performed. Based on the processing result, drawing data (the position of the vertex of the primitive surface) Coordinates, texture coordinates, color data, normal vector, α value, etc.) are created. Based on the drawing data (primitive surface data), the object (one or a plurality of primitive surfaces) after perspective transformation (after geometry processing) is converted into image information in units of pixels such as a drawing buffer 178 (frame buffer, work buffer, etc.). Draw in a buffer that can be stored. As a result, an image that can be seen from the virtual camera (given viewpoints, the first and second viewpoints for the left eye and the right eye) in the virtual space is generated. Note that the drawing processing performed by the display processing unit 120 can be realized by vertex shader processing, pixel shader processing, or the like.

音処理部130(音処理のプログラムモジュール)は、処理部100で行われる種々の処理の結果に基づいて音処理を行う。具体的には、楽曲(音楽、BGM)、効果音、又は音声などのゲーム音を生成し、ゲーム音を音出力部192に出力させる。なお音処理部130の音処理の一部(例えば3次元音響処理)を、HMD200の処理部240により実現してもよい。

The sound processing unit 130 (sound processing program module) performs sound processing based on the results of various processes performed by the processing unit 100. Specifically, game sounds such as music (music, BGM), sound effects, or sounds are generated, and the game sounds are output to the sound output unit 192. Note that part of the sound processing of the sound processing unit 130 (for example, three-dimensional sound processing) may be realized by the processing unit 240 of the HMD 200.

出力処理部140は各種の情報の出力処理を行う。例えば出力処理部140は、記憶部170に情報を書き込む処理や、通信部196を介して情報を送信する処理を、出力処理として行う。例えば出力処理部140は、書き込み命令で指定された情報を、記憶部170に書き込む処理や、外部の装置(サーバ等)に対してネットワークを介して情報を送信する処理を行う。送信処理は、通信部196に情報の送信を指示したり、送信する情報を通信部196に指示する処理などである。

The output processing unit 140 performs various types of information output processing. For example, the output processing unit 140 performs processing for writing information in the storage unit 170 and processing for transmitting information via the communication unit 196 as output processing. For example, the output processing unit 140 performs a process of writing information specified by a write command in the storage unit 170 or a process of transmitting information to an external apparatus (server or the like) via a network. The transmission process is a process of instructing the communication unit 196 to transmit information, or instructing the communication unit 196 to transmit information.

そして本実施形態のシミュレーションシステムは、図1に示すように、仮想空間設定部112と、移動体処理部113と、表示処理部120を含む。

And the simulation system of this embodiment contains the virtual space setting part 112, the mobile body process part 113, and the display process part 120, as shown in FIG.

仮想空間設定部112は、オブジェクトが配置される仮想空間の設定処理を行う。例えばユーザに対応するユーザ移動体のオブジェクトや、敵等の相手の移動体のオブジェクトや、マップや背景を構成するオブジェクトを、仮想空間に配置設定する処理を行う。ユーザに対応するユーザ移動体は、例えばユーザが操作部160により操作する移動体や、実空間でのユーザの移動に追従して仮想空間において移動する移動体である。このユーザ移動体は、例えばキャラクタやアバターと呼ばれるものである。ユーザ移動体は、ユーザが搭乗するロボット等の搭乗移動体であってもよい。またユーザ移動体は、その画像が表示される表示物であってもよいし、画像が表示されない仮想的なものであってもよい。

The virtual space setting unit 112 performs processing for setting a virtual space in which objects are arranged. For example, a process is performed in which an object of a user moving object corresponding to the user, an object of an opponent moving object such as an enemy, and an object constituting a map or background are set in the virtual space. The user moving body corresponding to the user is, for example, a moving body that the user operates with the operation unit 160 or a moving body that moves in the virtual space following the movement of the user in the real space. This user moving body is called, for example, a character or an avatar. The user mobile body may be a boarding mobile body such as a robot on which the user is boarding. Further, the user moving body may be a display object on which the image is displayed, or may be a virtual object on which the image is not displayed.

移動体処理部113は、仮想空間において、ユーザに対応するユーザ移動体(仮想カメラ)を移動させる処理を行う。例えば、ユーザが操作部160により入力した操作情報に基づいて、仮想空間においてユーザ移動体を移動させる。或いは、情報取得部111が、実空間でのユーザの位置情報を取得する場合には、移動体処理部113は、取得された位置情報(視点トラッキング情報)に基づいて、仮想空間においてユーザ移動体を移動させる処理を行う。例えば、実空間でのユーザの移動に追従して移動するように、仮想空間においてユーザ移動体を移動させる。例えばユーザ移動体の移動速度や移動加速度に基づいて、ユーザ移動体の位置等をフレーム毎に更新する処理を行って、ユーザ移動体を仮想空間(仮想フィールド)において移動させる。

The moving body processing unit 113 performs processing for moving a user moving body (virtual camera) corresponding to the user in the virtual space. For example, the user moving body is moved in the virtual space based on the operation information input by the user through the operation unit 160. Or when the information acquisition part 111 acquires the positional information on the user in real space, the mobile body process part 113 is a user mobile body in virtual space based on the acquired positional information (viewpoint tracking information). Process to move. For example, the user moving body is moved in the virtual space so as to move following the movement of the user in the real space. For example, based on the moving speed and moving acceleration of the user moving body, a process of updating the position of the user moving body for each frame is performed to move the user moving body in the virtual space (virtual field).

表示処理部120(描画処理部)は、仮想空間の画像(オブジェクト)の描画処理を行う。例えば仮想空間において仮想カメラ(所与の視点)から見える画像の描画処理を行う。例えばキャラクタ(アバター)等のユーザ移動体の視点(一人称視点)に設定された仮想カメラから見える画像の描画処理を行う。或いは、ユーザ移動体に追従する視点(三人称視点)に設定された仮想カメラから見える画像の描画処理を行う。生成される画像は、例えば左眼用画像、右眼用画像などの立体視用の画像であることが望ましい。

The display processing unit 120 (drawing processing unit) performs drawing processing of an image (object) in the virtual space. For example, a drawing process of an image viewed from a virtual camera (a given viewpoint) in the virtual space is performed. For example, a drawing process of an image seen from a virtual camera set as a viewpoint (first person viewpoint) of a user moving body such as a character (avatar) is performed. Alternatively, a drawing process of an image seen from a virtual camera set to a viewpoint (third person viewpoint) that follows the user moving body is performed. The generated image is desirably a stereoscopic image such as a left-eye image or a right-eye image.

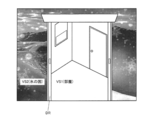

そして本実施形態では仮想空間設定部112は、仮想空間として、複数の第1~第M(Mは2以上の整数)の仮想空間を設定する。具体的には仮想空間設定部112は、仮想空間として、第1の仮想空間と第2の仮想空間を設定する。例えば第1の仮想空間を構成するオブジェクトの配置設定処理や、第2の仮想空間を構成するオブジェクトの配置設定処理を行う。第1の仮想空間が、後述するような部屋の空間である場合には、部屋に配置される物体に対応するオブジェクトの配置設定処理を行う。第2の仮想空間が、後述するような氷の国の空間である場合には、氷の国の氷河や海等に対応するオブジェクトの配置設定処理を行う。更に仮想空間設定部112は、例えば第3の仮想空間を設定する。第3の仮想空間が、後述する電車の上の空間である場合には、電車、トンネル、背景等に対応するオブジェクトの配置設定処理を行う。そして、例えば第2の仮想空間は、第1の仮想空間に対して特異点(別の言い方をすれば通過ポイント。以下、同様)を介して結びつけられる仮想空間である。第3の仮想空間は、例えば第1の仮想空間に対して特異点を介して結びつけられる仮想空間であってもよいし、第2の仮想空間に対して特異点を介して結びつけられる仮想空間であってもよい。

In this embodiment, the virtual space setting unit 112 sets a plurality of first to Mth virtual spaces (M is an integer of 2 or more) as the virtual space. Specifically, the virtual space setting unit 112 sets a first virtual space and a second virtual space as virtual spaces. For example, an arrangement setting process for objects constituting the first virtual space and an arrangement setting process for objects constituting the second virtual space are performed. When the first virtual space is a room space as described later, an object placement setting process corresponding to an object placed in the room is performed. When the second virtual space is an ice country space as will be described later, an object placement setting process corresponding to a glacier or sea of the ice country is performed. Furthermore, the virtual space setting unit 112 sets, for example, a third virtual space. When the third virtual space is a space above a train, which will be described later, an object placement setting process corresponding to a train, tunnel, background, or the like is performed. For example, the second virtual space is a virtual space that is linked to the first virtual space via a singular point (in other words, a passing point; hereinafter the same). For example, the third virtual space may be a virtual space that is linked to the first virtual space via a singular point, or may be a virtual space that is linked to the second virtual space via a singular point. There may be.

そして表示処理部120は、所与の切替条件(特異点の通過条件)が成立する前においては(切替条件が成立していない場合には)、ユーザ移動体又は仮想カメラの位置情報(位置座標、方向等)を、第1の仮想空間の位置情報(位置座標、方向等)として設定する。例えばユーザ移動体又は仮想カメラの位置情報を、第1の仮想空間の位置情報として対応づける。そして表示処理部120は、第1の描画処理として、少なくとも第1の仮想空間の画像を描画する処理を行う。例えば表示処理部120は、第1の描画処理として、第1の仮想空間の画像に加えて第2の仮想空間の画像を描画する処理を行って、特異点に対応する領域(特異点を内包する領域等)に第2の仮想空間の画像が表示される画像を生成する。第1の仮想空間の画像の描画処理は、例えば第1の仮想空間を構成するオブジェクトを描画し、第1の仮想空間において仮想カメラから見える画像を描画することなどで実現される。第1の仮想空間の画像に加えて第2の仮想空間の画像を描画する処理は、例えば特異点に対応する領域以外の領域(表示領域)については、第1の仮想空間を構成するオブジェクトを描画し、特異点に対応する領域(表示領域)については、第2の仮想空間を構成するオブジェクトを描画して、第1の仮想空間において仮想カメラから見える画像を描画することなどで実現される。

Then, before the given switching condition (single point passage condition) is satisfied (when the switching condition is not satisfied), the display processing unit 120 detects the position information (position coordinates) of the user moving object or the virtual camera. , Direction, etc.) is set as position information (position coordinates, direction, etc.) of the first virtual space. For example, the position information of the user moving body or the virtual camera is associated as the position information of the first virtual space. Then, the display processing unit 120 performs a process of drawing at least an image of the first virtual space as the first drawing process. For example, as the first drawing process, the display processing unit 120 performs a process of drawing an image of the second virtual space in addition to the image of the first virtual space, and includes an area corresponding to the singular point (including the singular point). An image in which the image of the second virtual space is displayed in a region to be generated) is generated. The drawing process of the image in the first virtual space is realized, for example, by drawing an object configuring the first virtual space and drawing an image that can be seen from the virtual camera in the first virtual space. In the process of drawing the image of the second virtual space in addition to the image of the first virtual space, for example, for an area (display area) other than the area corresponding to the singular point, the object constituting the first virtual space is changed. A region (display region) corresponding to a singular point is rendered by rendering an object constituting the second virtual space and rendering an image that can be viewed from the virtual camera in the first virtual space. .

一方、表示処理部120は、切替条件が成立した場合には、ユーザ移動体又は仮想カメラの位置情報を、第2の仮想空間の位置情報として設定する。例えばユーザ移動体又は仮想カメラが特異点に対応する場所を第1の進行方向で通過することで切替条件が成立した場合には、ユーザ移動体又は仮想カメラの位置情報を、第2の仮想空間の位置情報として設定する。例えばユーザ移動体又は仮想カメラの位置情報を、第1の仮想空間ではなく第2の仮想空間の位置情報として対応づける。そして表示処理部120は、第2の描画処理として、少なくとも第2の仮想空間の画像を描画する処理を行う。例えば表示処理部120は、第2の描画処理として、第2の仮想空間の画像に加えて第1の仮想空間の画像を描画する処理を行って、特異点に対応する領域に第1の仮想空間の画像が表示される画像を生成する。第2の仮想空間の画像の描画処理は、例えば第2の仮想空間を構成するオブジェクトを描画し、第2の仮想空間において仮想カメラから見える画像を描画することなどで実現される。第2の仮想空間の画像に加えて第1の仮想空間の画像を描画する処理は、例えば特異点に対応する領域以外の領域(表示領域)については、第2の仮想空間を構成するオブジェクトを描画し、特異点に対応する領域(表示領域)については、第1の仮想空間を構成するオブジェクトを描画して、第2の仮想空間において仮想カメラから見える画像を描画することなどで実現される。

On the other hand, when the switching condition is satisfied, the display processing unit 120 sets the position information of the user moving body or the virtual camera as the position information of the second virtual space. For example, when the switching condition is satisfied when the user moving body or the virtual camera passes through the place corresponding to the singular point in the first traveling direction, the position information of the user moving body or the virtual camera is stored in the second virtual space. Set as location information. For example, the position information of the user moving body or the virtual camera is associated as the position information of the second virtual space instead of the first virtual space. And the display process part 120 performs the process which draws the image of a 2nd virtual space at least as a 2nd drawing process. For example, as the second drawing process, the display processing unit 120 performs a process of drawing an image of the first virtual space in addition to the image of the second virtual space, and the first virtual space is displayed in the region corresponding to the singular point. An image in which an image of the space is displayed is generated. The drawing process of the image in the second virtual space is realized, for example, by drawing an object constituting the second virtual space and drawing an image that can be seen from the virtual camera in the second virtual space. In the process of drawing the image of the first virtual space in addition to the image of the second virtual space, for example, for an area (display area) other than the area corresponding to the singular point, the object constituting the second virtual space is changed. The region (display region) corresponding to the singular point is drawn and is realized by drawing an object constituting the first virtual space and drawing an image seen from the virtual camera in the second virtual space. .

例えば特異点に対応する領域(オブジェクト又はエリア)が、後述するドア(ゲート)の領域であったとする。この場合に、第1の仮想空間の画像に加えて第2の仮想空間の画像を描画する第1の描画処理では、このドアの領域に対して、ドアの向こう側の第2の仮想空間の画像が表示されるように描画処理を行う。同様に、第2の仮想空間の画像に加えて第1の仮想空間の画像を描画する第2の描画処理では、このドアの領域に対して、ドアの向こう側の第1の仮想空間の画像が表示されるように描画処理を行う。

For example, it is assumed that an area (object or area) corresponding to a singular point is an area of a door (gate) described later. In this case, in the first drawing process for drawing the image of the second virtual space in addition to the image of the first virtual space, the second virtual space on the other side of the door with respect to the door region. Drawing processing is performed so that an image is displayed. Similarly, in the second drawing process for drawing the image of the first virtual space in addition to the image of the second virtual space, the image of the first virtual space on the other side of the door with respect to the door area. The drawing process is performed so that is displayed.

そして表示処理部120は、仮想カメラの視線方向が、第1の進行方向の反対方向側を向いた場合に、特異点に対応する領域に第1の仮想空間の画像が表示される画像を生成する。例えばユーザ移動体又は仮想カメラが特異点に対応する場所を通過後、仮想カメラの視線方向が、その進行方向の反対の方向側に振り返った場合に、当該仮想カメラの視線方向に見える画像として、特異点に対応する領域に第1の仮想空間の画像が表示される画像を生成する。例えば、第2の仮想空間の画像に加えて第1の仮想空間の画像を描画する処理を行うことで、特異点に対応する領域以外の領域(主領域)については、第2の仮想空間を構成するオブジェクトが描画され、特異点に対応する領域については、第1の仮想空間を構成するオブジェクトを描画される画像を生成する。一方、特異点に対応する場所の裏側に回り込んで、特異点に対応する場所の方に、仮想カメラの視線方向が向いた場合には、第2の描画処理として、第2の仮想空間の画像を描画する処理を行い、第1の仮想空間の画像を描画する処理は行わないようにする。具体的には、特異点に対応する領域に対しても第2の仮想空間の画像を描画する。なお第1の進行方向の反対方向側とは、第1の進行方向の反対方向そのものである必要はなく、第1の進行方向を例えば正の方向とした場合に、例えば負の方向に相当する。

Then, the display processing unit 120 generates an image in which an image of the first virtual space is displayed in a region corresponding to the singular point when the line-of-sight direction of the virtual camera faces the opposite direction side of the first traveling direction. To do. For example, after the user moving body or virtual camera passes through a place corresponding to a singular point, when the visual line direction of the virtual camera turns to the opposite direction side of the traveling direction, as an image that can be seen in the visual line direction of the virtual camera, An image in which an image of the first virtual space is displayed in a region corresponding to the singular point is generated. For example, by performing the process of drawing the image of the first virtual space in addition to the image of the second virtual space, the second virtual space is changed for the region (main region) other than the region corresponding to the singular point. For the area corresponding to the singular point, an image that draws the object constituting the first virtual space is generated. On the other hand, when the direction of the line of sight of the virtual camera is turned to the back side of the place corresponding to the singular point and the direction corresponding to the singular point is directed to the place corresponding to the singular point, the second drawing process A process of drawing an image is performed, and a process of drawing an image of the first virtual space is not performed. Specifically, the image of the second virtual space is drawn also in the region corresponding to the singular point. The direction opposite to the first direction of travel does not have to be the direction opposite to the first direction of travel, and corresponds to, for example, a negative direction when the first direction of travel is a positive direction. .

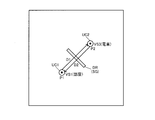

ここで特異点は、ある基準の下、その基準が適用できなくなるポイントである。例えば第1の仮想空間でユーザ移動体又は仮想カメラが移動している場合に、当該ユーザ移動体又は仮想カメラに対しては、第1の仮想空間内だけにおいて移動するという基準である法則が適用される。即ち、ユーザ移動体又は仮想カメラは、第1の仮想空間内において移動するという法則の下で移動する。本実施形態の特異点は、このような基準である法則が適用されず、当該法則に従わなくなるポイントである。例えば本実施形態では、特異点の通過により切替条件が成立すると、第1の仮想空間内で移動するという法則(基準)がユーザ移動体又は仮想カメラに対して適用されなくなり、当該ユーザ移動体又は仮想カメラは、第1の仮想空間とは異なる第2の仮想空間で移動するようになる。例えば特異点は、ユーザ移動体又は仮想カメラの位置情報を、第1の仮想空間の位置情報に対応づけるか、第2の仮想空間の位置情報に対応づけるかを、切り替えるポイントと言うことができる。そして切替条件の成立により、ユーザ移動体又は仮想カメラの位置情報との対応づけが切り替わるように、第1の仮想空間と第2の仮想空間は特異点を介して結びつけられている。例えば第1の仮想空間と第2の仮想空間を特異点を介して結びつけるための情報が記憶部170に記憶される。本実施形態の切替条件は、このようなユーザ移動体又は仮想カメラの位置情報と第1、第2の仮想空間の位置情報の対応づけを、特異点により切り替える条件である。第1、第2の仮想空間との第3の仮想空間との間の特異点による結びつきも同様である。なお特異点に対応する場所は、例えば点である必要はなく、面や領域であってもよい。例えば特異点を内包する面や領域であってもよい。

Here, a singular point is a point at which the standard cannot be applied under a certain standard. For example, when a user moving object or a virtual camera is moving in the first virtual space, the rule that is a criterion for moving only in the first virtual space is applied to the user moving object or the virtual camera. Is done. That is, the user moving body or the virtual camera moves under the law of moving in the first virtual space. The singular point of the present embodiment is a point at which such a rule, which is the reference, is not applied and the rule is not followed. For example, in this embodiment, when the switching condition is satisfied by passing a singular point, the law (reference) of moving in the first virtual space is not applied to the user moving body or the virtual camera. The virtual camera moves in a second virtual space different from the first virtual space. For example, the singular point can be said to be a switching point for associating the position information of the user moving body or the virtual camera with the position information of the first virtual space or the position information of the second virtual space. . The first virtual space and the second virtual space are linked via a singular point so that the association with the position information of the user moving body or the virtual camera is switched by the establishment of the switching condition. For example, information for connecting the first virtual space and the second virtual space via a singular point is stored in the storage unit 170. The switching condition of the present embodiment is a condition for switching the correspondence between the position information of such a user moving body or virtual camera and the position information of the first and second virtual spaces by a singular point. The same is true for the singularity connection between the first and second virtual spaces and the third virtual space. The location corresponding to the singular point need not be a point, for example, and may be a surface or a region. For example, it may be a surface or region including a singular point.

また表示処理部120は、ユーザ移動体又は仮想カメラが、第1の進行方向とは異なる第2の進行方向で特異点を通過した場合には、ユーザ移動体又は仮想カメラの位置情報を、第1の仮想空間の位置情報として設定する。そして表示処理部120は、第1の描画処理として、少なくとも第1の仮想空間の画像を描画する処理を行う。例えば第1の描画処理として、第1の仮想空間の画像を描画する、或いは第1の仮想空間の画像に加えて第2の仮想空間の画像を描画する処理を行う。例えば特異点を介して第1の仮想空間から第2の仮想空間に移動したユーザ移動体又は仮想カメラが、第1の仮想空間に戻った場合には、ユーザ移動体又は仮想カメラの位置情報を、第1の仮想空間の位置情報として対応づけて、第1の仮想空間での第1の描画処理を行う。このようにすることで、ユーザ移動体等は、第1の仮想空間と第2の仮想空間を、特異点を介して行き来できるようになる。また、第2の仮想空間内だけにおいて移動するという法則(基準)が適用されていたユーザ移動体又は仮想カメラは、第2の進行方向で特異点に対応する場所を通過することにより、当該法則が適用されなくなり、第1の仮想空間内で移動できるようになる。