KR20180020123A - 비동기 신호 처리 방법 - Google Patents

비동기 신호 처리 방법 Download PDFInfo

- Publication number

- KR20180020123A KR20180020123A KR1020177029339A KR20177029339A KR20180020123A KR 20180020123 A KR20180020123 A KR 20180020123A KR 1020177029339 A KR1020177029339 A KR 1020177029339A KR 20177029339 A KR20177029339 A KR 20177029339A KR 20180020123 A KR20180020123 A KR 20180020123A

- Authority

- KR

- South Korea

- Prior art keywords

- context

- event

- pixel

- representative

- current

- Prior art date

Links

Images

Classifications

-

- G06K9/6212—

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V10/00—Arrangements for image or video recognition or understanding

- G06V10/70—Arrangements for image or video recognition or understanding using pattern recognition or machine learning

- G06V10/74—Image or video pattern matching; Proximity measures in feature spaces

- G06V10/75—Organisation of the matching processes, e.g. simultaneous or sequential comparisons of image or video features; Coarse-fine approaches, e.g. multi-scale approaches; using context analysis; Selection of dictionaries

- G06V10/758—Involving statistics of pixels or of feature values, e.g. histogram matching

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V10/00—Arrangements for image or video recognition or understanding

- G06V10/70—Arrangements for image or video recognition or understanding using pattern recognition or machine learning

- G06V10/74—Image or video pattern matching; Proximity measures in feature spaces

- G06V10/761—Proximity, similarity or dissimilarity measures

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V40/00—Recognition of biometric, human-related or animal-related patterns in image or video data

- G06V40/10—Human or animal bodies, e.g. vehicle occupants or pedestrians; Body parts, e.g. hands

- G06V40/16—Human faces, e.g. facial parts, sketches or expressions

- G06V40/161—Detection; Localisation; Normalisation

- G06V40/166—Detection; Localisation; Normalisation using acquisition arrangements

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N25/00—Circuitry of solid-state image sensors [SSIS]; Control thereof

- H04N25/40—Extracting pixel data from image sensors by controlling scanning circuits, e.g. by modifying the number of pixels sampled or to be sampled

- H04N25/44—Extracting pixel data from image sensors by controlling scanning circuits, e.g. by modifying the number of pixels sampled or to be sampled by partially reading an SSIS array

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F2218/00—Aspects of pattern recognition specially adapted for signal processing

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F2218/00—Aspects of pattern recognition specially adapted for signal processing

- G06F2218/08—Feature extraction

- G06F2218/10—Feature extraction by analysing the shape of a waveform, e.g. extracting parameters relating to peaks

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V2201/00—Indexing scheme relating to image or video recognition or understanding

- G06V2201/07—Target detection

Landscapes

- Engineering & Computer Science (AREA)

- Theoretical Computer Science (AREA)

- Computer Vision & Pattern Recognition (AREA)

- Multimedia (AREA)

- Health & Medical Sciences (AREA)

- General Physics & Mathematics (AREA)

- Physics & Mathematics (AREA)

- General Health & Medical Sciences (AREA)

- Databases & Information Systems (AREA)

- Software Systems (AREA)

- Medical Informatics (AREA)

- Evolutionary Computation (AREA)

- Computing Systems (AREA)

- Artificial Intelligence (AREA)

- Signal Processing (AREA)

- Oral & Maxillofacial Surgery (AREA)

- Human Computer Interaction (AREA)

- Image Analysis (AREA)

- Studio Devices (AREA)

- Image Processing (AREA)

Abstract

본 발명은 픽셀 매트릭스가 장면의 맞은 편에 배치된 광센서에 의해 발생된 비동기 신호를 처리하는 방법으로서,

- 매트릭스의 각 픽셀에 대해, 상기 픽셀로부터 연속 이벤트들을 포함한 비동기 신호를 광센서로부터 수신하는 단계(500); 및

- 비동기 신호에 이벤트가 수신되면, 활동 프로파일을 이용해 비동기 신호를 분석하는 단계(501)를 포함하는 비동기 신호를 처리하는 방법에 관한 것이다.

활동 프로파일은, 센서의 각 픽셀(p)에 대해, 상기 픽셀로부터 연속 이벤트들 가운데 가장 최근의 이벤트(310, 311, 312, 313, 314, 320, 321, 322) 이후로 경과된 시간(t)의 함수로서 감소하는 활동값(S(p))을 적어도 포함한다.

- 매트릭스의 각 픽셀에 대해, 상기 픽셀로부터 연속 이벤트들을 포함한 비동기 신호를 광센서로부터 수신하는 단계(500); 및

- 비동기 신호에 이벤트가 수신되면, 활동 프로파일을 이용해 비동기 신호를 분석하는 단계(501)를 포함하는 비동기 신호를 처리하는 방법에 관한 것이다.

활동 프로파일은, 센서의 각 픽셀(p)에 대해, 상기 픽셀로부터 연속 이벤트들 가운데 가장 최근의 이벤트(310, 311, 312, 313, 314, 320, 321, 322) 이후로 경과된 시간(t)의 함수로서 감소하는 활동값(S(p))을 적어도 포함한다.

Description

본 발명은 비동기 신호 처리 분야에 관한 것으로, 보다 상세하게는 신호 모양의 감지에 관한 것이다.

다양한 비디오 신호 처리 기술이 역사적으로 개발되어왔다. 상기 기술들은 일반적으로 기존의 래스터 이미지 접근 방식을 기반으로 한다.

비동기 센서(DVS, ATIS)가 있다. 이러한 센서는 기존의 카메라를 이점적으로 대체할 수 있다.

그러나, 신호 처리는 래스터 이미지 카메라 업계보다 직관적이지 않다. 문제의 특정 계열들(가령, 광학 흐름, 모양 추적)을 처리하기 위해 특정 알고리즘이 개발되어 왔지만, 다른 문제들은 미미하거나 아직가 해결되지 않았거나 해결하기가 더 까다롭다.

이는 특히 모양 인식에 대한 경우이다.

모양 및/또는 움직임을 감지하기 위해, 현재의 방법(즉, 종래의 카메라로부터의 비디오 데이터를 이용하는 방법)은 문제의 비디오 데이터의 부근에 위치한 픽셀 세트에 적절한 특정 시각적 특성을 식별하고자 한다.

이러한 시각적 특징은 대부분 (이동시 이 공간 정보가 있을 수 있는 경우에도) 이미지의 공간 정보로서 당업자는 이해한다.

그런 다음, 비디오 데이터 시간 정보는 종종 무시된다: 시각적 특성의 변화/변경은, 많아야, 비디오 데이터의 2이상의 이미지(또는 프레임) 사이에서 발견될 수 있다.

시간 구성요소를 무시하면 주로 일상적인 비디오 획득기술로 설명 할 수 있다. 비디오 데이터는 다수의 정적 이미지(또는 프레임)를 생성하는 획득의 결과이다.

이 비디오 획득기술은 역사적으로 비디오가 처리되거나 표시되는 방식을 조절해왔다. 이러한 연속된 정적 이미지의 존재로 비디오 데이터의 시간(또는 동적) 정보를 조작하기가 어렵다.

비디오 데이터의 초당 이미지 수를 늘릴 수는 있지만, 모양 감지를 위한 기존 도구가 갖는 획득 면에서 하드웨어 제한 이유나 이 데이터의 실시간 처리 이유로 인한 것이든 간에 이 이미지의 주파수가 100Hz를 초과하는 경우는 거의 없다.

이와 같이 신뢰할만한 모양의 감지가 필요하고 이는 비디오 데이터의 시간 정보를 최대한 활용하여 사용될 수 있다.

본 발명은 이와 같은 상황을 개선한다.

정기적인 샘플링 인스턴스에 연속적인 이미지를 기록하는 종래의 카메라와 달리, 인간의 눈의 동작으로부터 영감을 얻은 생물학적 망막이 개발되었다. 생물학적 망막은 보려는 장면에서 매우 적은 중복 정보만 전송하며 비동기적으로 전송한다.

이벤트 중심의 비동기 시각센서는 압축된 디지털 데이터를 이벤트 모양로 전달한다.

이러한 센서의 표현은 "Activity-Driven, Event-Based Vision Sensors", T. Delbruck 등, Proceedings of 2010 IEEE International Symposium on Circuits and Systems (ISCAS), pp. 2426-2429에서 참조할 수 있다. 이벤트 기반 시각센서는 중복을 제거하고 지연시간을 줄이며 기존 카메라와 관련하여 동적 범위를 늘리는 이점이 있다.

이러한 시각센서의 출력은 장면이 발생할 때 장면의 반사율 변화를 나타내는 일련의 비동기 이벤트로, 각 픽셀 어드레스에 대해, 구성될 수 있다.

센서의 각 픽셀은 독립적이며 마지막 이벤트의 방출 이후 임계치보다 큰 강도 변화(가령, 강도의 로그에 대해 15%의 콘트라스트)를 감지한다. 강도의 변화가 임계치 세트를 초과하면, 강도가 증가 또는 감소하는지에 따라 픽셀에 의해 ON 또는 OFF 이벤트가 생성된다(DVS 센서). 특정 비동기 센서는 감지된 이벤트를 광도 의 측정과 연관시킨다(ATIS 센서).

센서는 기존의 카메라처럼 클록에 샘플링되지 않으므로, 큰 시간 정밀도(가령, 약 1㎲)로 이벤트 시퀀싱을 고려할 수 있다. 이러한 센서를 사용하여 일련의 이미지들을 재구성하면, 기존 카메라의 경우 수십 헤르츠에 비해 수 킬로 헤르쯔의 이미지 레이트를 얻을 수 있다.

이 카메라의 큰 시간 정밀도는 비디오의 시간 정보를 최대한 활용할 수 있게한다.

그러나, 이벤트는 시간(t) 및 공간(x, y)에서 시간엄수 개념이기 때문에, 이러한 센서의 이벤트를 처리하는 것은 복잡할 수 있다. 따라서, 그 처리 및 분석이 어려울 수 있다.

그러므로, 비동기식 센서에서 나오는 신호를 적절히 분석하기 위해 조작할 수 있는 간단한 계측기를 만들 필요가 있다.

분석은 그러한 센서가 제공하는 매우 많은 사건에서 시공간 특성의 식별을 용이하게 하기 위해, 센서의 다이나믹스를 잃지 않고, 공간 차원과 시간 차원을 포함해야 한다.

이런 취지로, 본 발명은 픽셀 매트릭스가 장면의 맞은 편에 배치된 광센서에 의해 발생된 비동기 신호를 처리하는 방법으로서,

- 매트릭스의 각 픽셀에 대해, 상기 픽셀로부터 연속 이벤트들을 포함한 비동기 신호를 광센서로부터 수신하는 단계; 및

- 비동기 신호에 이벤트가 수신되면, 활동 프로파일을 이용해 비동기 신호를 분석하는 단계를 포함하는 비동기 신호를 처리하는 방법에 관한 것이다.

활동 프로파일은, 센서의 각 픽셀에 대해, 상기 픽셀로부터 연속 이벤트들 가운데 가장 최근의 이벤트 이후로 경과된 시간의 함수로서 감소하는 활동값을 적어도 포함한다.

픽셀의 "활동 프로파일"은 값이 나타내는 시간, 적어도 이 픽셀에 대해 수신된 마지막 이벤트의 시간 (주어진 극성에 대해 필터링되었을 수 있음)의 함수로서 곡선으로 볼 수 있다.

활동 프로파일은 시공간 구조를 국소적으로 유지함으로써 이벤트의 출현을 요약하는 이와 같은 모양의 분석 도구로서 확립된다.

활성 프로파일의 형태는 센서에 의해 관찰된 장면에서의 특정 기본 형태의 존재를 나타낸다는 것이 관찰되었다.

이러한 프로파일은 비동기 이벤트가 수신되면 변경되고 이에 따라 센서의 다이나믹스를 유지한다.

활동 프로파일 세트는 센서의 "신선도 카드"라고 할 수 있는 것을 형성한다.

활동 프로파일을 사용한 분석을 통해 많은 신호 처리 응용 프로그램을 개발할 수 있다. 비제한적으로 다음과 같은 용도로 사용할 수 있다:

- 모양 인식: 사전 정의된 기본 모양의 사전 정의된 동작을 변환하는 대표적인 프로파일의 라이브러리가 참조된다. 분석이 라이브러리의 대표적인 프로파일과 유사한 활동 프로파일을 감지하면, 모양 인식이 수행되고 이 모양의 이동속도 표시가 추정된다;

- 장면에서 이동의 추정: 근방 영역에서 활동 프로파일(또는 매우 유사한 활동 프로파일)이 최초로 감지된 직후이면, 센서의 시야에서 대상물의 이동 속도의 추정이 결정될 수 있다;

- 이미지에서 깊이의 추정(스테레오): 동일한(또는 유사한) 활동 프로파일이 동일한 장면을 캡쳐하는 2개의 센서에서 나온 2개의 이미지에서 감지되면, 활성 프로파일과 연관된 픽셀이 캡처된 장면의 동일한 지점에 대응하고 이와 같이 이 점의 깊이를 결정한다고 고려할 수 있다;

- 등등.

"비동기 신호"는 주어진 망막 센서에서 나온 이벤트 세트 또는 이 이벤트의 서브세트(특정 픽셀에만 제한된 공간 서브세트; 및/또는 주어진 시간주기에 국한된 시간 서브세트)일 수 있다.

또한, 활동 프로파일은 상기 픽셀로부터의 연속 이벤트들 가운데 가장 최근의 이벤트 이후에 경과된 시간에 따라 지수함수적으로 감소할 수 있다.

이 지수적 감소로 센서가 수신한 마지막 이벤트가 더 잘 감지될 수 있다.

특별한 실시예에서, 활동 프로파일은 상기 픽셀로부터 연속 이벤트들 가운데 가장 최근의 이벤트 이전의 이벤트 이후로 경과된 시간의 함수일 수 있다.

심지어 연관된 활동 프로파일을 결정하기 위해 이 픽셀에 대해 수신된 모든 이벤트를 고려하는 것도 가능하다.

본 발명은 또한 망막 센서에 특히 적합한 모양을 인식하고 상술한 비동기 신호의 처리를 이용하는 방법을 제안한다.

본 발명은 또한:

(a) 상술한 비동기 신호를 처리하는 방법을 실행하는 단계;

(b) 상기 센서의 각 현재 픽셀에 대해, 이벤트가 수신됨에 따라:

(b1) 상기 픽셀로부터 기설정된 거리 미만에 위치된 픽셀들의 활동 프로파일 세트로서 정의된, 상기 현재 픽셀에 대한 컨텍스트를 결정하는 단계와,

(b2) 기설정된 대표적인 컨텍스트의 세트로부터 대표적인 컨텍스트를 결정하는 단계;

(c) 단계(b2)에서 대표적인 컨텍스트의 결정의 발생횟수의 함수로서 서명을 결정하는 단계; 및

(d) 서명 타입의 베이스로 상기 서명의 비교를 통해 모양을 결정하는 단계를 포함하고,

결정된 대표적인 컨텍스트는, 대표적인 컨텍스트 세트로부터, 단계(b1)에서 결정된 컨텍스트까지의 최소 거리를 갖는 모양을 인식하는 방법에 관한 것이다.

거리는 수학적 용어의 거리일 수 있다. 따라서, 유클리드 거리, 맨하탄 거리, 민코프스키 거리, 체비셰프 거리 또는 임의의 다른 거리가 될 수 있다.

대부분의 경우, "컨텍스트"를 3차원 공간(픽셀의 좌표를 나타내는 2개의 축과 (시간의 함수로) 차원이 없는 한 개의 축)에서 면으로 표현할 수 있다.

이 컨텍스트는 고려된 이벤트(즉, 현재)의 가까운 환경을 공간적으로 및 시간적으로 파악하는 것을 가능하게 한다. 컨텍스트는 해당 픽셀에 대해 현재 이벤트가 발생하는 픽셀("현재 픽셀"이라고 함)로부터 기설정된 거리보다 적은 곳에 위치한 픽셀 좌표와 관련된 값들의 세트로 볼 수 있다.

대부분의 경우, "구성요소 세트"를 그래픽으로 "히스토그램"으로 표현할 수 있다. 용어 "히스토그램" 또는 "서명"은 명세서의 나머지에서도 또한 사용된다.

또 다른 실시예로, 사용된 대표적인 컨텍스트에 대해 계층적 모델을 고려하는 것이 가능하다.

본 발명은:

(a) 센서의 비동기 신호의 이벤트를 현재 이벤트로 사용 및 제 1 계층 레벨 모델의 대표적인 컨텍스트를 현재 타입의 컨텍스트로 사용하는 단계;

(b) 현재 이벤트로 상술한 바와 같이 비동기 신호를 처리하기 위한 방법을 실행하는 단계;

(c) 상기 센서의 각 현재 픽셀에 대해, 현재 이벤트들이 수신됨에 따라,

(c1) 상기 픽셀로부터 기설정된 거리 미만에 위치된 픽셀들에 대해 단계(b)에 이용된 활동 프로파일 세트로서 정의된, 상기 현재 픽셀에 대한 컨텍스트를 결정하는 단계와,

(c2) 현재 대표적인 컨텍스트로부터 대표적인 컨텍스트를 결정하는 단계와,

(c3) 단계(c2)에서 식별된 대표적인 컨텍스트의 함수로서 이벤트를 생성하는 단계;

(d) 계층 레벨 모델이 이용되지 않은 경우:

- 현재 이벤트로서 단계(c3)에서 생성된 이벤트를 사용하는 단계와,

- 현재 대표적인 컨텍스트로서 아직 사용되지 않은 계층 레벨 모델의 대표적인 컨텍스트를 사용하는 단계와,

- 단계(b) 내지 (e)를 재실행하는 단계; 및

(e) 모든 계층 레벨 모델이 이용된 경우:

- 단계(c2)의 마지막 발생에서 대표적인 컨텍스트의 결정의 발생횟수의 함수로서 서명을 결정하는 단계와,

- 대표적인 서명의 베이스로 상기 서명의 비교를 통해 모양을 결정하는 단계를 포함하고,

결정된 대표적인 컨텍스트는, 모든 현재 대표적인 컨텍스트들 가운데, 단계(c1)에서 결정된 컨텍스트까지의 최소 거리를 갖는, 모양을 인식하는 방법에 관한 것이다.

이러한 계층적 레벨을 통해 단계별 인식을 진행할 수 있다. 제 1 계층 레벨은 상위 레벨의 계층 레벨을 사용하여 매우 기본적인 모양을 식별 할 수 있게 하므로 하위 레벨을 사용하여 더 복잡한 모양을 식별 할 수 있다.

특정 실시예에서, 콘텍스트의 결정은 상이한 극성을 갖는 이벤트를 개별적으로 고려한다.

예를 들어, 극성은 픽셀 강도가 변할 수 있다는 사실(예를 들면, 증가의 경우 +1, 감소의 경우 -1)에 해당할 수 있다. 극성은 바로 아래의 계층 레벨에 대해 식별된 대표적인 컨텍스트에도 해당될 수 있다.

극성이 서로 다른 이벤트를 별도로 고려하면 결정된 컨텍스트의 적합성을 높일 수 있다.

이 경우, 컨텍스트는

- 현재 픽셀에 대해, "현재 픽셀"로부터 적어도 기설정된 거리 미만에 위치된 픽셀들의 좌표; 및

- 소정의 극성과 관련된 값의 세트로 볼 수 있다:

이점적으로, 단계(e)에서 사용된 거리는 바타차리아 거리 또는 표준화 된 거리이다.

기존의 장비 상에 설치되는 상술한 방법의 전부 또는 일부를 구현하는 컴퓨터 프로그램이 그 자체로 이점적이다.

이와 같이, 본 발명은 또한 프로세서에 의한 프로그램 실행시, 상술한 방법의 실행을 위한 명령어를 포함한 컴퓨터 프로그램 제품에 관한 것이다.

이 프로그램은 임의의 프로그래밍 언어(예를 들어, 객체지향언어 또는 기타)를 사용할 수 있으며 해석 가능한 소스 코드, 부분적으로 컴파일된 코드 또는 완전히 컴파일된 코드의 형태로 사용할 수 있다.

하기에 기술된 도 5는 그러한 컴퓨터 프로그램의 일반적인 알고리즘의 흐름도를 형성할 수 있다.

본 발명의 내용에 포함됨.

본 발명의 다른 특징 및 이점은 하기의 명세서를 읽을 때 더욱 명백해질 것이다. 명세서는 단지 예시적이며 첨부도면과 함께 읽어야 한다.

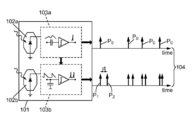

도 1은 ATIS 타입의 비동기식 광센서의 개략도이다.

도 2는 회전하는 별을 포함하는 장면의 맞은편에 배치된 비동기 센서에 의해 생성된 이벤트를 도시하는 다이어그램이다.

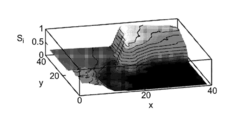

도 3a 및 도 3b는 주어진 픽셀의 이벤트에 대한 "활동 신호"의 실시예이다.

도 3c는 본 발명의 일실시예에 따른 주어진 "신선도" 카드를 나타내는 3D 표면의 예이다.

도 3d는 본 발명의 일실시예에 따른 콘텍스트를 나타내는 3D 표면의 예이다.

도 4는 카드가 반환될 때 이벤트 스트림에서 이벤트의 발생을 도시한 것이다.

도 5는 본 발명의 가능한 실시예의 흐름도의 예이다.

도 6a 내지 도 6c는 본 발명의 가능한 실시예에서의 전형적인 상황의 예이다.

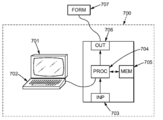

도 7은 본 발명에 따른 실시예의 구현을 위한 장치를 도시한다.

도 8a 내지 도 8c는 인식될 다양한 모양에 대한 모양을 감지하는 성능예이다.

도 1은 ATIS 타입의 비동기식 광센서의 개략도이다.

도 2는 회전하는 별을 포함하는 장면의 맞은편에 배치된 비동기 센서에 의해 생성된 이벤트를 도시하는 다이어그램이다.

도 3a 및 도 3b는 주어진 픽셀의 이벤트에 대한 "활동 신호"의 실시예이다.

도 3c는 본 발명의 일실시예에 따른 주어진 "신선도" 카드를 나타내는 3D 표면의 예이다.

도 3d는 본 발명의 일실시예에 따른 콘텍스트를 나타내는 3D 표면의 예이다.

도 4는 카드가 반환될 때 이벤트 스트림에서 이벤트의 발생을 도시한 것이다.

도 5는 본 발명의 가능한 실시예의 흐름도의 예이다.

도 6a 내지 도 6c는 본 발명의 가능한 실시예에서의 전형적인 상황의 예이다.

도 7은 본 발명에 따른 실시예의 구현을 위한 장치를 도시한다.

도 8a 내지 도 8c는 인식될 다양한 모양에 대한 모양을 감지하는 성능예이다.

도 1은 ATIS의 원리를 도시한 것이다.

센서를 형성하는 매트릭스의 픽셀(101)은 각각 전자감지회로(103a, 103b)와 관련된 포토다이오드와 같은 2개의 감광소자(102a, 102b)를 포함한다.

센서(102a)와 센서의 회로(103a)는 포토다이오드(102a)가 수신한 광강도가 기정의된 양만큼 변할 때 펄스(P0)를 발생한다.

이러한 강도의 변화를 표시하는 펄스(P0)는 다른 포토다이오드(102b)와 연관된 전자회로(103b)를 트리거한다. 그런 후 이 회로(103b)는 주어진 광량(광자수)이 포토다이오드(102b)에 의해 수신되는 즉시 제 1 펄스(P1)를 생성 한 후 제 2 펄스 (P2)를 생성한다.

펄스들(P1 및 P2) 간에 시간차(δt)는 펄스(P0)의 출현 후 바로 픽셀(101)에 의해 수신된 광강도에 반비례한다.

ATIS로부터의 비동기 정보는 각각의 픽셀(104)에 결합된 두 개의 펄스 트레인들을 포함한다: 제 1 펄스 트레인(P0)은 광강도가 감지 임계치를 초과하여 변화된 인스턴스를 나타내며, 제 2 펄스 트레인은 시간차(δt)가 해당 광강도 또는 그레이 레벨을 나타내는 펄스(P1 및 P2)로 구성된다.

ATIS의 행렬 위치(p)의 픽셀(101)로부터의 이벤트 e(p,t)는 두 가지 타입의 정보, 즉 이벤트의 인스턴스(t)를 부여하는 펄스(P0)의 위치에 의해 주어진 시간 정보와, 펄스 P1 및 P2 간의 시간차(δt)에 의해 주어진 그레이스케일 정보를 포함한다.

그런 후, 픽셀로에서 나온 이벤트는 도 2에 도시된 바와 같이 3 차원 공간 시공간 표현으로 배치될 수 있다. 이 도면에서, 각 점(p)은 박스 A에서 도표로 나타낸 바와 같이 일정한 각속도로 회전하는 별의 움직임에 의한 위치의 센서의 픽셀 p의 레벨에서 인스턴스(t)에서 비동기로 생성된 이벤트 e(p,t)를 표시한다. 이러한 점들의 대부분은 전반적으로 나선형인 면 부근에 분포된다. 또한, 이 도면은 별의 실제 이동에 따르지 않고 나선형 면으로부터 떨어져 있는 일정한 개수의 이벤트를 나타낸다. 이러한 이벤트는 획득 노이즈이다.

이벤트 e(p,t)는 모든 하기의 정보에 의해 정의될 수 있다:

여기서, C는 센서의 공간영역이고, pol은 휘도의 변화 방향을 나타내는 극성(가령, 증가에 대해 1, 감소에 대해 -1)이며, I(p,t)는 점(p)의 광강도 신호이다.

광강도 신호는 이와 같이 도 1에 기술된 바와 같이 조합된 펄스 트레인(104) 세트가 될 수 있다. tu가 이벤트의 발생시간을 나타내고, te+,u 및 te-,u 간에 차가 광강도에 반비례하는 값을 나타내면, I(p,t)=δ(t-tu)+δ(t-te+,u)+δ(t-te-,u) 식으로 3개의 디랙(δ)을 이용해 강도를 코드화할 수 있다. 그런 후, 좌표(p)에 위치된 픽셀 강도신호는 휘도정보가 임시로 코드화될 수 있게 한다.

ev(i)가 모든 하기의 정보에 의해 정의되는 ev(i)로서 센서의 i번째 이벤트를 표기할 수 있다:

여기서, C는 센서의 공간영역이고, pi는 i번째 이벤트에 대한 센서의 지점이며, poli는 이벤트 타입을 나타내는 극성(가령, i번째 이벤트의 휘도 변화방향으로, 예컨대, 증가에 대해 1, 감소에 대해 -1)이고, ti는 i번째 이벤트의 발생시간이며, Ii(p,t)는 (이 값이 이용될 수 있는 경우) 점(pi)의 광강도 신호이다.

더 간단한 방식으로 이벤트를 조작하기 위해, 각 픽셀(p)과 각 극성(S)에 대해 이벤트의 "신선도(freshness)"를 나타내는 함수(S)를 정의할 수 있고, S(p,pol)는 적어도 이 극성(pol)을 갖고 이 픽셀에 대한 마지막 이벤트의 발생시간(t)의 함수이다.

함수(S)를 주어진 시간(t)에서, 주어진 픽셀(p)에 대해 각 이벤트 와 주어진 극성(plo)에 대해 원시함수 의 합으로서 정의할 수 있고, 여기서 h는 기설정된 값이고 θ는 원시함수의 감소속도에 해당하는 기설정된 인수이다.

원시함수의 "합"은 또한:

예시를 위해, 도 3a는 센서의 3개의 픽셀들(p1, p2, p3))(및 주어진 극성값(pol))에 대한 3개의 가능한 활동신호(t→S)를 나타낸다.

이벤트가 없는 경우, S(p1,t), S(p2,t) 또는 S(p3,t)의 값은 0이다. 그러나, 픽셀(p1) 수준에서 극성 이벤트(pol)의 발생시(예를 들어, 310), S(p1,t)는 소정의 임계값을 취한다(여기서, 이 값(h)은 단위가 될 수 있다).

이 이벤트가 0에 도달 한 후 활성신호 S(p1,t)의 값은 점차 감소한다.

이것은 픽셀(p1)에 대한 이벤트(311), 픽셀(p2)에 대한 이벤트(312), 또는 픽셀(p3)에 대한 이벤트(313/314)에 대해 동일하다.

여기에서 활동신호(S)의 감소가 선형적인 경우, 임의의 타입의 감소를 지수적 감소로 예상할 수 있다:

이 지수적 감소는 도 3b(곡선(3b) 및 이벤트(320) 참조)로 설명될 수 있다.

또한, 고려되는 픽셀에 대한 이벤트의 발생시(가령, 여기서 p4), 함수(S)의 값이 h 값과 관련해 무시될 수 없다(예를 들어, 이벤트(321)가 이벤트(322)에 일시적으로 가깝다).

일실시예에서, 연이은 이벤트(322)의 발생시, 활동신호(S)의 값은 현재 S 값, 바로 뒤의 이벤트(322)(즉, h0), 및 h의 (가능하게는 가중화된) 합으로 설정될 수 있다. 이와 같이, 곡선 S에서의 감소는 도 3b에 도시된 바와 같이 값 h+h0로부터 시작할 것이다. 더욱이, 값 h+h0이 기설정된 값 h1(즉, min(h1, h+h0))에서 캡되는 것을 제공할 수 있다.

다른 실시예에서, 연이은 이벤트(322)의 발생 동안, 곡선(S)의 값은 h0의 값에 무관하게 값(h)로 설정된다(즉, 마지막 이벤트(즉, 연이은 이벤트) 이전의 이벤트가 무시된다). 이런 다른 실시예에서, 다음과 같이 정의된 "마지막 이벤트 시간"으로 알려진 시간을 정의할 수 있다:

또는

여기서, tj 이벤트 시간은 극성(pol)을 가진 픽셀(p)에 대해 발생한다.

이들 픽셀의 이벤트의 "신선도"를 나타내는 픽셀 카드(S)의 생성은 불연속 개념(즉, 이벤트)의 연속적이고 단순한 표현을 가능하게하므로 이점적이다. 이 생성된 카드로 이벤트 표현이 단순한 이해 영역으로 변환될 수 있다.

그런 후, 이런 생성으로 이벤트의 조작 및 비교를 간단하게 한다.

Sp를 픽셀(p) 부근에 (즉, 픽셀(p)의 기설정된 거리, 가령, 수학적 용어로, 가령 픽셀(p)에 중심을 둔 면(2R+1)의 제곱의 거리에 위치된) 픽셀(q)에 대한 값들의 세트를 픽셀(p)의 "컨텍스트"라 한다. (다수의 가능한 극성 값들을 포함한) 컨텍스트를 시각적으로 나타내기 위해, pol의 다양한 극성값들에 대해 의 여러 표현들을 병기할 수 있다.

예컨대, 도 3d는 픽셀(p)의 "컨텍스트"(350)을 나타낼 수 있고, 플래토(351)는 함수 값을 나타내며, 플래토(352)는 함수 값을 나타낸다(물론, 플래토는 임의의 모양을 가질 수 있고, 상기 플래토의 선택은 단순히 보기 쉬울 수 있기 때문이다). 마찬가지로, 점(353 및 354)은 동일한 픽셀이지만 극성이 다른 함수 S의 값에 해당한다.

임의의 픽셀(p)에 대해 컨텍스트(Sp)를 정의할 수 있다.

가능한 다양한 컨텍스트들을 특징지을 수 있도록 하기 위해, "대표적"이라는 컨텍스트를 정의할 수 있다.

이들 대표적 컨텍스트는 기설정될 수 있고 D. Ballard 및 J. Jehee의 "Dynamic coding of signed quantities in cortical feedback circuits" Frontiers in Psychology, vol. 3 no. 254, 2012의 참조문헌에 제공된 알고리즘을 기반으로 또는 다른 방법(예컨대, "k-수단" 방법)을 이용해 정해질 수 있다.

픽셀 p에 대해 식별된 각 컨텍스트(Sp)에 대해, (Sp)에 가장 가까운 대표적인 컨텍스트에 해당하는 대표적인 컨텍스트를 픽셀(p)에 연관시킬 수 있다. 컨텍스트(Sp)와 대표적인 컨텍스트 사이의 거리는, 예를 들어, 컨텍스트(Sp)의 값과 동일한 픽셀(p) 및 동일한 극성(pol)에 대한 대표적인 컨텍스트 간의 유클리드 거리의 합을 계산함으로써 결정될 수 있다. 거리는 또한 유클리드 거리의 제곱의 합의 함수일 수 있다.

계산된 거리가 소정의 소정의 임계치 이상이면, 임의의 대표적인 콘텍스트를 픽셀(p)에 연관시킬 수 없다.

이러한 대표적인 컨텍스트{Ck}는 컨텍스트(Sp)(예를 들어, 면(2R + 1)의 제곱에 대한)에 대해 위에서 상술한 바와 같이 한정된 공간 영역에 대해 정의된다.

각각의 계층적 레벨(m)이 복수의 대표적인 컨텍스트를 정의하는 대표적인 컨텍스트의 몇가지 계층적 레벨을 또한 정의할 수 있다. 그러한 계층적 레벨에 대한 관심은 도 5의 설명과 관련하여 자세히 설명되어 있다.

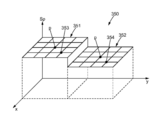

예시를 위해, 도 6a는 가능한 대표적인 컨텍스트들의 제 1 계층 레벨(즉, 극성이 1 (대표적인 컨텍스트들 각 하나의 좌측 영역) 또는 극성 -1 (대표적인 컨텍스트들의 각 하나의 우측 영역)에 대한 크기 5x5 픽셀들)을 도시한 것이다.

또한, 주어진 인스턴스(t)에서, 그리고 각 픽셀(p)과 관련된 대표적인 컨텍스트{Ck}(또는 보다 일반적으로 고정된 계층적 레벨(m)에 대해 {Ck_m})의 식별 후에, 모든 가능한 픽셀들(p)에 대한 대표적인 컨텍스트들 중 각 하나의 발생횟수를 계산할 수 있다.

모양 인식을 허용하는 이벤트 스트림을 특징지으면 ESN(Echo-State Networks) 또는 순환 신경망과 같은 다른 방법을 또한 사용할 수 있다.

예시를 위해, 도 4는 클럽, 다이아몬드, 하트 및 스페이드를 포함하는 카드를 플레이할 때 "ON" 이벤트(흰점) 및 "오프"이벤트(검은점)의 발생을 나타낸다. 각각의 이벤트 스트림 (a), (b), (c) 및 (d) 각각 연관된 히스토그램이 이러한 이벤트 스트림 아래에 디스플레이된다. 이러한 히스토그램은 이벤트의 스트림에서 인식되는 모양의 일종의 "서명"을 형성한다.

사전 설정된 수의 트레이닝 동안 이러한 히스토그램을 구성(즉, 동일한 모양을 나타내는 이벤트 스트림의 표현에 의한 히스토그램 생성)하는 것이 가능하다: 이와 같이, 동일한 모양 및/또는 동일한 움직임에 대한 트레이닝 중에 얻은 히스토그램을 평균화하여 "대표적인 히스토그램"을 결정할 수 있다

일단 이러한 대표적인 히스토그램이 결정되면, 이벤트의 스트림으로부터 다시 현재의 히스토그램을 결정하고 이 히스토그램을 트레이닝 단계 동안 결정된 대표적인 히스토그램과 비교하는 것이 가능하다.

현재 히스토그램과 가장 가까운 거리를 갖는 대표적인 히스토그램은 이벤트 스트림에 해당하는 모양을 식별 할 수 있게 한다.

또한 (가능하게는 근접성에 해당하는 점수로) k-최근사 히스토그램 타입들이 반환되는 것이 가능하다.

이는 또한 다음과 같이 표준하 거리를 계산할 수 있다:

바타차리아 거리(Bhattacharyya distance)는 또한 종래 거리를 대신해 사용될 수 있다:

임의의 다른 수학적 거리를 또한 사용할 수 있다.

그런 후, 연관된 대표적인 히스토그램에 대응하는 모양이 이벤트 스트림에서 발생했다고 생각할 수 있다.

이 대표적인 히스토그램으로 인해, 모양 인식이 이와 같이 가능하다.

도 5는 본 발명의 가능한 실시예의 흐름도의 예이다.

비동기 센서에서 나온 이벤트 스트림(500)의 이벤트(i)를 시간(ti)와 관련하여 수신하면, 상기에 나타낸 바와 같이, 센서의 각 픽셀(p) 및 pol의 각 값에 대한 S(p,pol,ti)의 값을 결정하거나 업데이트할 수 있다(단계 501): 이 단계는 센서의 "신선도" 카드를 생성하거나 업데이트할 수 있다.

단계(501)에 대해, S의 원시함수의 감소에 사용된 시간 상수는(τ1)로 표시된다. 이와 같이, 예를 들어, 다음을 가질 수 있다:

이 결정이 수행된 다음, 센서의 각각의 픽셀(p)에 대해, 단계(501)에서 이전에 계산된 신선도 카드로부터 컨텍스트(Sp)를 추출할 수 있다(단계 502): 이 추출은 고려되는 픽셀(p)에 대한 공간 근접성(Np)을 가진 픽셀(q) 및 소정의 극성값(pol)에 대한 S(q,pol,ti)의 소정의 값들을 분리시킬 수 있게 한다. 예시를을 위해, Np_1은 고려되는 공간위치(p) 주위에 중심을 둔 정사각형 또는 직사각형을 정의할 수 있다. 공간 근접성(Np_1)은 그와 같이 추출된 컨텍스트가 제 1 계층 레벨(503)(Ck_1)의 대표적인 컨텍스트의 차원과 동일한 차원인 것으로 정의될 수 있어 대표적 컨텍스트와 비교될 수 있다.

예시의 목적으로, 도 6a는 가능한 대표적인 컨텍스트의 제 1 계층 레벨(즉, 극성 1(대표적인 컨텍스트들 각각의 좌측 영역) 또는 극성 -1(대표적인 컨텍스트들 각각의 우측 영역)에 대한 크기 5x5 픽셀들)을 도시한 것이다.

결정된 컨텍스트 Sp_1를 픽셀(p)와 관련하여 제 1 계층 레벨의 가능한 대표적인 컨텍스트{Ck_1}와 비교하면 전술한 바와 같이 Sp_1에 가장 가까운 대표적인 컨텍스트가 식별될 수 있다(단계 504).

제 1 계층 레벨의 가능한 대표적인 컨텍스트들{Ck_1} 중 가장 가까운 대표적인 컨텍스트 Ck_1prox의 이러한 식별은 픽셀(p)에 대해 이 픽셀(p)과 연관된 대표적인 컨텍스트를 나타내는 이벤트(ev1)를 생성하는 것을 가능하게 한다(단계 505):

여기서, t는 현재 시간이다.

가장 가까운 대표적인 컨텍스트가 식별되지 않으면(전술 참조), 이벤트는 생성되지 않는다.

이러한 이벤트를 생성하면 ev 1 (p)도 비동기 이벤트 스트림을 형성한다(단계 506).

그런 다음, 센서에서 나온 이벤트(500)와 유사한 방식으로 이들 이벤트 (506)를 처리하는 것이 가능하다.

이와 같이, 시간(tj)와 관련하여 이벤트 스트림(506)의 각 이벤트(j)의 수신시, 상기에 나타낸 바와 같이, (이 단계(511)에 대해 pol의 값들이 제 1 계층 레벨에 대한 단계(504) 동안 식별된 대표적인 컨텍스트, 즉, 각각의 대표적인 컨텍스트가 2개의 극성을 갖는 도 6a의 기본틀에서 가능한 4개의 대표적인 컨텍스트들을 나타내는 것으로 알고 있는) 센서의 각 픽셀(p) 및 pol의 각 값에 대한 값(p,pol)→S2(p,pol,tj)으로 갖는 새로운 "신선도" 카드(즉, 제 2 계층 레벨에 대한 패(carte))의 값을 결정하거나 업데이트할 수 있다.

이 결정을 수행한 후에, 센서의 각 픽셀(p)은 상기 단계(511)에서 계산된 신선도 카드로부터 컨텍스트(Sp_2)를 추출할 수 있다(단계 512): 이 추출로 고려된 픽셀(p)에 대한 공간 근접성(Np_2)을 갖는 픽셀(q) 및 주어진 극성값(pol)에 대해 S2(q,pol,ti)의 특정 값이 분리될 수 있다. 예시를 위해, Np_2는 고려 된 공간위치(p)를 중심으로 정사각형 또는 직사각형을 정의할 수 있다. 공간 근접성(Np_2)은 그와 같이 추출된 컨텍스트가 제 2 계층 레벨(Ck_2)의 대표적인 컨텍스트의 차원과 동일한 차원인 것으로 정의되어 상기 대표적인 컨텍스트와 비교될 수 있다(단계 513).

예시를 위해, 도 6b는 8개의 가능한 대표적인 컨텍스트의 제 2 계층 레벨을 도시한 것이다.

제 1 계층 레벨의 각각의 대표적인 컨텍스트가 2개의 영역(극성 -1(OFF)의 이벤트에 대한 한 영역과 극성 1(ON)의 이벤트에 대한 영역, 도 6a 참조)을 가지면, 제 2 계층의 대표적인 컨텍스트 레벨은 즉각적으로 하위 계층 레벨(즉, 여기서 제 1 계층 레벨, 도 6b 참조)에서 대표적인 컨텍스트처럼 영역들(즉, 4)만큼 많다.

더욱이, 제 2 계층 레벨의 대표적인 컨텍스트는 공간 근접성(Np_2)이 공간 근접성(Np_1)에 의해 정의된 것보다 큰 영역을 정의하도록 될 수 있다(예를 들어, Np_1이 면(2R1+1)의 제곱으로 정의되면 Np_2는 R2≥R1인 면(2R2+1)의 제곱으로 정의될 수 있습니다.

픽셀(p)과 관련해 결정된 컨텍스트(Sp_2)를 제 1 계층의 가능한 대표적인 컨텍스트{Ck_2}와 비교함으로써, 전술한 바와 같이 Sp_2에 가장 가까운 대표적인 컨텍스트를 식별 할 수 있다(단계 514)

제 2 계층 레벨의 가능한 대표적인 컨텍스트들{Ck_2} 중 가장 가까운 대표적인 컨텍스트(Ck_2prox)의 식별로 픽셀(p)에 대해 이 픽셀(p)과 연관된 대표적인 컨텍스트를 나타내는 이벤트(ev2)가 생성될 수 있다(단계 515):

여기서, t는 현재 시간이다.

가장 가까운 전형적인 컨텍스트가 식별되지 않으면(상기 참조), 이벤트는 생성되지 않는다.

이러한 이벤트를 생성하는 이벤트ev2(p)도 또한 비동기 이벤트 스트림을 형성한다(단계 516).

그런 다음, 이는 이벤트 506과 유사한 방식으로 이들 이벤트 516을 처리할 수 있다: 보다 높은 계층 레벨이 존재하면(테스트 517, 예를 들어 도 6c(6c의 1 및 6c의 2)로 표현된 레벨 3의 계층 레벨을 출력 OK), 바로 하위 계층 레벨에 의해 생성된 이벤트를 입력으로 취하고 이 상위 계층 레벨의 대표적인 컨텍스트를 사용함으로써 단계 511 내지 515를 반복할 수 있다(단계 513 참조).

상위 계층 레벨이 없으면, 모든 픽셀(p) 및 고정된 시간(t)에 대해 식별된 대표적인 컨텍스트의 발생횟수를 카운트하는 것이 가능하다(513). 전술한 바와 같이, 이 카운트는 식별된 대표적인 콘텍스트의 발생횟수를 나타내는 히스토그램 의 결정을 허용한다(단계 521).

단계(513)에서 결정된 히스토그램을 사용하여, 모양 및/또는 움직임을 나타내는 대표적인 히스토그램 간의 거리를 계산할 수 있고(단계 523), 따라서 최근사한 대표적인 히스토그램을 결정할 수 있다(단계 522).

이러한 전형적인 히스토그램이 결정됨에 따라, 모양 및/또는 이와 연관된 움직임을 결정할 수 있고(단계 524), 이러한 모양 및/또는 이 움직임을 반환할 수 있다(525).

물론, 도 5의 흐름도가 대표적인 컨텍스트의 적어도 하나의 제 2 계층 레벨의 분석 후 단계들(520 내지 524)의 실행을 나타내면, 단계들(520 내지 524)은 단계들(501 내지 505) 후에 (즉, 단일 계층 레벨의 분석으로) 전체적으로 실행될 수 있다

도 7은 본 발명에 따른 실시예의 구현을 위한 장치를 도시한 것이다.

이 실시예에서, 장치는 본 방법의 구현을 허용하는 명령어, 수신된 이벤트의 스트림에 관한 데이터 및 상술한 바와 같은 방법의 다양한 단계들을 수행하기 위한 임시 데이터를 저장하기 위한 메모리(705)를 포함하는 컴퓨터(700)를 구비한다.

컴퓨터는 회로(704)를 더 구비한다. 이 회로는 가령:

- 컴퓨터 프로그램의 형태로 명령어를 해석할 수 있는 프로세서, 또는

- 본 발명의 방법 단계들이 실리콘에 기술되어 있는 전자카드, 또는

- FPGA(Field-Programmable Gate Array) 칩과 같은 프로그램가능한 전자칩일 수 있다.

이 컴퓨터는 센서로부터 이벤트를 수신하기 위한 입력 인터페이스(703), 및 이벤트 스트림에서 식별된 모양(707)을 공급하기 위한 출력 인터페이스(706)를 포함한다. 최종적으로, 컴퓨터는 사용자와의 용이한 상호작용을 허용하기 위해 스크린(701) 및 키보드(702)를 포함 할 수있다. 물론, 키보드는 특히 가령 터치 감지식 태블릿 형태를 갖는 컴퓨터의 프레임 워크에서 선택적이다.

도 8a는 모양(클럽, 다이아몬드, 하트 및 스페이드) 감지의 성능예이다.

각 행(세로좌표(801) 참조)은 학습된 특정 모양에 관한 데이터(즉, 대표적인 히스토그램, 상기 참조)에 해당한다.

각 열(세로좌표(802) 참조)은 인식되어야 하는 특정 모양(즉, 인식되는 히스토그램)에 관한 데이터에 해당한다.

(예를 들어 세트(803)에 해당하는) 행과 열의 교차점을 사용하면 모양의 여러 표현에 대해 인식할 히스토그램을 사용하여 대표적인 히스토그램의 거리를 볼 수 있다(여기서 모양의 9 가지 표현, 이러한 표현은 점선 수직선으로 구분된다):

- 흰색 바(왼쪽 바)는 일반적인 거리에 해당하고,

- 회색 바(가운데 바)는 표준화된 거리에 해당하며,

- 검정색 바(오른쪽 바는 바타차리아(Bhattacharyya) 거리에 해당한다.

이와 같이 표현된 3개의(각각 일반적인, 표준화된, 바타차리아) 거리는 이러한 모양에 대해 각각 94%, 100% 및 97%의 성능을 나타낸다.

그림 8b는 모양(자릿수와 대문자)을 감지한 성능예이다.

각 행(세로좌표(804) 참조)은 학습된 특정 모양에 관한 데이터(즉, 대표적인 히스토그램, 상기 참조)에 해당한다.

각 열(세로좌표(805) 참조)은 인식되어야 하는 특정 모양(즉, 인식되는 히스토그램)에 관한 데이터에 해당한다.

(예를 들어 세트(806)에 해당하는) 행과 열의 교차점을 사용하면 모양의 여러 표현에 대해 인식할 히스토그램을 사용하여 대표적인 히스토그램의 거리를 볼 수 있다:

- 흰색 바(왼쪽 바)는 일반적인 거리에 해당하고,

- 회색 바(가운데 바)는 표준화된 거리에 해당하며,

- 검정색 바(오른쪽 바)는 바타차리아 거리에 해당한다.

이와 같이 표현된 3개의(각각 일반적인, 표준화된, 바타차리아) 거리 모두는 이러한 모양에 대해 100%의 성능을 갖는다.

도 8c는 모양(면)의 감지 성능예이다.

각 테이블(807, 808 및 809)은 이 얼굴의 19가지 표현에 대해 학습된 얼굴 (세로좌표)을 이용하여 표현된 얼굴(가로좌표)의 인식 발생횟수를 나타낸다.

테이블(807)은 일반적 거리를 사용하여 얼굴 인식을 수행한다 (인식률: 37%).

테이블(808)은 표준화된 거리를 사용하여 얼굴 인식을 수행한다(인식률: 78%).

테이블(808)은 바타차리아 거리를 사용하여 얼굴 인식을 수행한다 (인식률: 79%).

더욱이, 도 5에 도시된 기능적 다이어그램은 기술된 디바이스로 특정 명령들이 수행될 수 있는 프로그램의 전형적인 예이다. 이와 같이, 도 5는 본 발명에 따른 컴퓨터 프로그램의 일반적인 알고리즘의 흐름도에 해당할 수 있다.

물론, 본 발명은 상술한 실시예에 국한되지 않고, 다른 대안으로 확장된다.

다른 실시예도 가능하다.

예를 들어,도 6a 내지 도 6c의 전형적인 상황은 임의의 치수일 수 있다.

또한, 설명은 주로 광/비디오 센서에서 발생하는 이벤트의 원인에 대해 언급한다. 그러나, 기술된 본 발명은 예를 들어 그러한 비동기 모드에 대해 기능하고 공간 배열이 비디오 센서와 유사할 수 있는 압력 센서의 네트워크와 같은 임의의 이벤트 소스 세트로 일반화된다.

Claims (9)

- 픽셀 매트릭스가 장면의 맞은 편에 배치된 광센서에 의해 발생된 비동기 신호를 처리하는 방법으로서,

- 매트릭스의 각 픽셀에 대해, 상기 픽셀로부터 연속 이벤트들을 포함한 비동기 신호를 광센서로부터 수신하는 단계(500); 및

- 비동기 신호에 이벤트가 수신되면, 활동 프로파일을 이용해 비동기 신호를 분석하는 단계(501)를 포함하고,

활동 프로파일은, 센서의 각 픽셀(p)에 대해, 상기 픽셀로부터 연속 이벤트들 가운데 가장 최근의 이벤트(310, 311, 312, 313, 314, 320, 321, 322) 이후로 경과된 시간(t)의 함수로서 감소하는 활동값(S(p))을 적어도 포함하는 비동기 신호를 처리하는 방법. - 제 1 항에 있어서,

활동 프로파일은 상기 픽셀로부터 연속 이벤트들 가운데 가장 최근의 이벤트(310, 311, 312, 313, 314, 320, 321, 322) 이후로 경과된 시간(t)의 함수로서 지수함수적으로 감소하는 비동기 신호를 처리하는 방법. - 제 1 항 또는 제 2 항에 있어서,

활동 프로파일은 상기 픽셀로부터 연속 이벤트들 가운데 가장 최근의 이벤트(310, 311, 312, 313, 314, 320, 321, 322) 이전의 이벤트 이후로 경과된 시간(t)의 함수로서 또한 감소하는 비동기 신호를 처리하는 방법. - (a) 제 1 항 내지 제 3 항 중 어느 한 항에 따른 비동기 신호를 처리하는 방법을 실행하는 단계;

(b) 상기 센서의 각 현재 픽셀(p)에 대해, 이벤트가 수신됨에 따라:

(b1) 상기 픽셀(p)로부터 기설정된 거리 미만에 위치된 픽셀들의 활동 프로파일 세트로서 정의된, 상기 현재 픽셀에 대한 컨텍스트(Sp)를 결정하는 단계(501)와,

(b2) 기설정된 대표적인 컨텍스트의 세트로부터 대표적인 컨텍스트(Ck)를 결정하는 단계(504);

(c) 단계(b2)에서 대표적인 컨텍스트의 결정의 발생횟수의 함수로서 서명을 결정하는 단계(521); 및

(d) 서명 타입의 베이스로 상기 서명의 비교를 통해 모양을 결정하는 단계(524)를 포함하고,

결정된 대표적인 컨텍스트는, 대표적인 컨텍스트 세트로부터, 단계(b1)에서 결정된 컨텍스트까지의 최소 거리를 갖는 모양을 인식하는 방법. - (a) 센서의 비동기 신호의 이벤트를 현재 이벤트로 사용 및 제 1 계층 레벨 모델의 대표적인 컨텍스트를 현재 타입의 컨텍스트로 사용하는 단계;

(b) 현재 이벤트로 제 1 항 내지 제 3 항 중 어느 한 항에 따른 비동기 신호를 처리하기 위한 방법을 실행하는 단계;

(c) 상기 센서의 각 현재 픽셀(p)에 대해, 현재 이벤트들이 수신됨에 따라,

(c1) 상기 픽셀(p)로부터 기설정된 거리 미만에 위치된 픽셀들에 대해 단계(b)에 이용된 활동 프로파일 세트로서 정의된, 상기 현재 픽셀에 대한 컨텍스트(Sp)를 결정하는 단계(501)와,

(c2) 현재 대표적인 컨텍스트로부터 대표적인 컨텍스트(Ck)를 결정하는 단계(504)와,

(c3) 단계(c2)에서 식별된 대표적인 컨텍스트의 함수로서 이벤트를 생성하는 단계;

(d) 계층 레벨 모델이 이용되지 않은 경우:

- 현재 이벤트로서 단계(c3)에서 생성된 이벤트를 사용하는 단계와,

- 현재 대표적인 컨텍스트로서 아직 사용되지 않은 계층레벨 모델의 대표적인 컨텍스트를 사용하는 단계와,

- 단계(b) 내지 (e)를 재실행하는 단계; 및

(e) 모든 계층 레벨 모델이 이용된 경우:

- 단계(c2)의 마지막 발생에서 대표적인 컨텍스트의 결정의 발생횟수의 함수로서 서명을 결정하는 단계(521)와,

- 대표적인 서명의 베이스로 상기 서명의 비교를 통해 모양을 결정하는 단계(524)를 포함하고,

결정된 대표적인 컨텍스트는, 모든 현재 대표적인 컨텍스트들 가운데, 단계(c1)에서 결정된 컨텍스트까지의 최소 거리를 갖는, 모양을 인식하는 방법. - 제 4 항 또는 제 5 항에 있어서,

컨텍스트의 결정은 다른 극성을 갖는 이벤트들을 별도로 고려하는 모양을 인식하는 방법. - 제 5 항 또는 제 6 항에 있어서,

단계(e)의 비교는 바타차리아 거리의 계산을 포함하는 모양을 인식하는 방법. - 제 5 항 또는 제 6 항에 있어서,

단계(e)의 비교는 표준화 거리의 계산을 포함하는 모양을 인식하는 방법. - 프로세서에 의한 프로그램 실행시, 제 1 항 내지 제 8 항 중 어느 한 항에 따른 방법의 실행을 위한 명령어를 포함한 컴퓨터 프로그램 제품.

Applications Claiming Priority (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| FR1552155A FR3033914A1 (fr) | 2015-03-16 | 2015-03-16 | Procede de traitement d'un signal asynchrone |

| FR1552155 | 2015-03-16 | ||

| PCT/FR2016/050574 WO2016146937A1 (fr) | 2015-03-16 | 2016-03-15 | Procédé de traitement d'un signal asynchrone |

Publications (1)

| Publication Number | Publication Date |

|---|---|

| KR20180020123A true KR20180020123A (ko) | 2018-02-27 |

Family

ID=54140531

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020177029339A KR20180020123A (ko) | 2015-03-16 | 2016-03-15 | 비동기 신호 처리 방법 |

Country Status (9)

| Country | Link |

|---|---|

| US (1) | US10440296B2 (ko) |

| EP (1) | EP3271869B1 (ko) |

| JP (1) | JP6833708B2 (ko) |

| KR (1) | KR20180020123A (ko) |

| CN (1) | CN107873097A (ko) |

| ES (1) | ES2764484T3 (ko) |

| FR (1) | FR3033914A1 (ko) |

| HK (1) | HK1248357A1 (ko) |

| WO (1) | WO2016146937A1 (ko) |

Families Citing this family (8)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| EP3120897A1 (en) * | 2015-07-22 | 2017-01-25 | Université Pierre et Marie Curie (Paris 6) | Method for downsampling a signal outputted by an asynchronous sensor |

| CN109844739B (zh) * | 2016-09-09 | 2023-07-18 | 国家科学研究中心 | 用于在多种信号中模式识别的方法 |

| CN108961318B (zh) * | 2018-05-04 | 2020-05-15 | 上海芯仑光电科技有限公司 | 一种数据处理方法及计算设备 |

| CN108764078B (zh) * | 2018-05-15 | 2019-08-02 | 上海芯仑光电科技有限公司 | 一种事件数据流的处理方法及计算设备 |

| WO2020067410A1 (ja) * | 2018-09-28 | 2020-04-02 | ソニーセミコンダクタソリューションズ株式会社 | データ処理装置、データ処理方法、及び、プログラム |

| EP3694202A1 (en) * | 2019-02-11 | 2020-08-12 | Prophesee | Method of processing a series of events received asynchronously from an array of pixels of an event-based light sensor |

| JP7120180B2 (ja) * | 2019-08-07 | 2022-08-17 | トヨタ自動車株式会社 | イメージセンサ |

| WO2022254789A1 (ja) * | 2021-05-31 | 2022-12-08 | ソニーグループ株式会社 | 受信装置および送受信システム |

Family Cites Families (3)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| KR101724513B1 (ko) * | 2011-12-19 | 2017-04-07 | 유니베르시태트 취리히 | 포토어레이, 특히 시간 의존성 이미지 데이터의 비동기성 검출과 샘플링된 밝기의 감지를 동시 실시하기 위한 포토어레이 |

| FR2985065B1 (fr) * | 2011-12-21 | 2014-01-10 | Univ Paris Curie | Procede d'estimation de flot optique a partir d'un capteur asynchrone de lumiere |

| EP2677500B1 (en) * | 2012-06-19 | 2021-06-23 | Samsung Electronics Co., Ltd. | Event-based image processing apparatus and method |

-

2015

- 2015-03-16 FR FR1552155A patent/FR3033914A1/fr not_active Withdrawn

-

2016

- 2016-03-15 US US15/556,632 patent/US10440296B2/en not_active Expired - Fee Related

- 2016-03-15 WO PCT/FR2016/050574 patent/WO2016146937A1/fr active Application Filing

- 2016-03-15 CN CN201680019785.4A patent/CN107873097A/zh active Pending

- 2016-03-15 EP EP16715016.8A patent/EP3271869B1/fr active Active

- 2016-03-15 JP JP2017549000A patent/JP6833708B2/ja active Active

- 2016-03-15 ES ES16715016T patent/ES2764484T3/es active Active

- 2016-03-15 KR KR1020177029339A patent/KR20180020123A/ko not_active Application Discontinuation

-

2018

- 2018-06-14 HK HK18107724.8A patent/HK1248357A1/zh unknown

Also Published As

| Publication number | Publication date |

|---|---|

| CN107873097A (zh) | 2018-04-03 |

| EP3271869B1 (fr) | 2019-10-16 |

| HK1248357A1 (zh) | 2018-10-12 |

| JP6833708B2 (ja) | 2021-02-24 |

| FR3033914A1 (fr) | 2016-09-23 |

| JP2018509847A (ja) | 2018-04-05 |

| ES2764484T3 (es) | 2020-06-03 |

| WO2016146937A1 (fr) | 2016-09-22 |

| US20180063449A1 (en) | 2018-03-01 |

| EP3271869A1 (fr) | 2018-01-24 |

| US10440296B2 (en) | 2019-10-08 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| KR20180020123A (ko) | 비동기 신호 처리 방법 | |

| CN107358149B (zh) | 一种人体姿态检测方法和装置 | |

| US6499025B1 (en) | System and method for tracking objects by fusing results of multiple sensing modalities | |

| US8706663B2 (en) | Detection of people in real world videos and images | |

| KR102357680B1 (ko) | 이벤트에 기반하여 객체의 이동을 감지하는 장치 및 방법 | |

| US20180121739A1 (en) | Setting apparatus, output method, and non-transitory computer-readable storage medium | |

| JP7452016B2 (ja) | 学習データ生成プログラム、及び学習データ生成方法 | |

| JPWO2018025831A1 (ja) | 人流推定装置、人流推定方法およびプログラム | |

| CN105631399A (zh) | 用于体育视频识别的快速对象跟踪框架 | |

| US20150092981A1 (en) | Apparatus and method for providing activity recognition based application service | |

| US10846515B2 (en) | Efficient face detection and tracking | |

| JP2018181273A (ja) | 画像処理装置及びその方法、プログラム | |

| KR20160033800A (ko) | 카운팅 방법 및 카운팅 장치 | |

| Nghiem et al. | Background subtraction in people detection framework for RGB-D cameras | |

| Nguyen et al. | Single camera based fall detection using motion and human shape features | |

| KR20210099450A (ko) | 딥러닝을 이용한 원거리 소형 드론 탐지 방법 | |

| Goudelis et al. | Fall detection using history triple features | |

| KR20170025535A (ko) | 스켈레톤 자세 데이터세트를 이용한 비디오 기반 상호 활동 모델링 방법 | |

| Iazzi et al. | Fall detection based on posture analysis and support vector machine | |

| CN110211021B (zh) | 图像处理装置、图像处理方法和存储介质 | |

| JPWO2019171574A1 (ja) | 商品分析システム、商品分析方法および商品分析プログラム | |

| JP2002366958A (ja) | 画像認識方法および画像認識装置 | |

| CN110580708A (zh) | 一种快速移动检测方法、装置及电子设备 | |

| JP6336935B2 (ja) | 移動物体追跡装置 | |

| JP2007048232A (ja) | 情報処理装置、および情報処理方法、並びにコンピュータ・プログラム |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A201 | Request for examination | ||

| E902 | Notification of reason for refusal | ||

| E601 | Decision to refuse application |