JP7071240B2 - Inspection support equipment, methods and programs - Google Patents

Inspection support equipment, methods and programs Download PDFInfo

- Publication number

- JP7071240B2 JP7071240B2 JP2018140044A JP2018140044A JP7071240B2 JP 7071240 B2 JP7071240 B2 JP 7071240B2 JP 2018140044 A JP2018140044 A JP 2018140044A JP 2018140044 A JP2018140044 A JP 2018140044A JP 7071240 B2 JP7071240 B2 JP 7071240B2

- Authority

- JP

- Japan

- Prior art keywords

- image

- endoscope

- depth image

- tubular structure

- depth

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

- 238000007689 inspection Methods 0.000 title claims description 47

- 238000000034 method Methods 0.000 title claims description 40

- 238000004364 calculation method Methods 0.000 claims description 20

- 238000006243 chemical reaction Methods 0.000 claims description 15

- 238000013528 artificial neural network Methods 0.000 claims description 7

- 210000000621 bronchi Anatomy 0.000 description 30

- 238000003860 storage Methods 0.000 description 24

- 238000012545 processing Methods 0.000 description 18

- 238000010586 diagram Methods 0.000 description 12

- 238000002591 computed tomography Methods 0.000 description 7

- 238000001514 detection method Methods 0.000 description 7

- 238000003384 imaging method Methods 0.000 description 7

- 239000011159 matrix material Substances 0.000 description 7

- 238000003780 insertion Methods 0.000 description 6

- 230000037431 insertion Effects 0.000 description 6

- 238000003325 tomography Methods 0.000 description 5

- 230000006870 function Effects 0.000 description 4

- 238000010801 machine learning Methods 0.000 description 4

- 238000002595 magnetic resonance imaging Methods 0.000 description 4

- 238000009877 rendering Methods 0.000 description 3

- 238000004891 communication Methods 0.000 description 2

- 238000012937 correction Methods 0.000 description 2

- 238000000605 extraction Methods 0.000 description 2

- 210000002429 large intestine Anatomy 0.000 description 2

- 238000002600 positron emission tomography Methods 0.000 description 2

- 238000005070 sampling Methods 0.000 description 2

- 206010028980 Neoplasm Diseases 0.000 description 1

- 230000006978 adaptation Effects 0.000 description 1

- 238000013459 approach Methods 0.000 description 1

- 238000003491 array Methods 0.000 description 1

- 238000003705 background correction Methods 0.000 description 1

- 210000004204 blood vessel Anatomy 0.000 description 1

- 210000001124 body fluid Anatomy 0.000 description 1

- 239000010839 body fluid Substances 0.000 description 1

- 238000004422 calculation algorithm Methods 0.000 description 1

- 238000013527 convolutional neural network Methods 0.000 description 1

- 238000003745 diagnosis Methods 0.000 description 1

- 238000009826 distribution Methods 0.000 description 1

- 229940079593 drug Drugs 0.000 description 1

- 239000003814 drug Substances 0.000 description 1

- 230000005611 electricity Effects 0.000 description 1

- 238000001839 endoscopy Methods 0.000 description 1

- 239000004973 liquid crystal related substance Substances 0.000 description 1

- 238000004519 manufacturing process Methods 0.000 description 1

- 210000003097 mucus Anatomy 0.000 description 1

- 230000003287 optical effect Effects 0.000 description 1

- 239000013307 optical fiber Substances 0.000 description 1

- 238000003909 pattern recognition Methods 0.000 description 1

- 230000000306 recurrent effect Effects 0.000 description 1

- 239000004065 semiconductor Substances 0.000 description 1

- 210000002784 stomach Anatomy 0.000 description 1

- 238000012916 structural analysis Methods 0.000 description 1

- 238000002910 structure generation Methods 0.000 description 1

- 238000012706 support-vector machine Methods 0.000 description 1

Images

Classifications

-

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61B—DIAGNOSIS; SURGERY; IDENTIFICATION

- A61B1/00—Instruments for performing medical examinations of the interior of cavities or tubes of the body by visual or photographical inspection, e.g. endoscopes; Illuminating arrangements therefor

- A61B1/00002—Operational features of endoscopes

- A61B1/00004—Operational features of endoscopes characterised by electronic signal processing

- A61B1/00009—Operational features of endoscopes characterised by electronic signal processing of image signals during a use of endoscope

- A61B1/000094—Operational features of endoscopes characterised by electronic signal processing of image signals during a use of endoscope extracting biological structures

-

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61B—DIAGNOSIS; SURGERY; IDENTIFICATION

- A61B1/00—Instruments for performing medical examinations of the interior of cavities or tubes of the body by visual or photographical inspection, e.g. endoscopes; Illuminating arrangements therefor

- A61B1/00002—Operational features of endoscopes

- A61B1/00004—Operational features of endoscopes characterised by electronic signal processing

- A61B1/00009—Operational features of endoscopes characterised by electronic signal processing of image signals during a use of endoscope

- A61B1/000096—Operational features of endoscopes characterised by electronic signal processing of image signals during a use of endoscope using artificial intelligence

-

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61B—DIAGNOSIS; SURGERY; IDENTIFICATION

- A61B1/00—Instruments for performing medical examinations of the interior of cavities or tubes of the body by visual or photographical inspection, e.g. endoscopes; Illuminating arrangements therefor

- A61B1/00002—Operational features of endoscopes

- A61B1/00043—Operational features of endoscopes provided with output arrangements

- A61B1/00045—Display arrangement

- A61B1/0005—Display arrangement combining images e.g. side-by-side, superimposed or tiled

-

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61B—DIAGNOSIS; SURGERY; IDENTIFICATION

- A61B1/00—Instruments for performing medical examinations of the interior of cavities or tubes of the body by visual or photographical inspection, e.g. endoscopes; Illuminating arrangements therefor

- A61B1/04—Instruments for performing medical examinations of the interior of cavities or tubes of the body by visual or photographical inspection, e.g. endoscopes; Illuminating arrangements therefor combined with photographic or television appliances

-

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61B—DIAGNOSIS; SURGERY; IDENTIFICATION

- A61B1/00—Instruments for performing medical examinations of the interior of cavities or tubes of the body by visual or photographical inspection, e.g. endoscopes; Illuminating arrangements therefor

- A61B1/267—Instruments for performing medical examinations of the interior of cavities or tubes of the body by visual or photographical inspection, e.g. endoscopes; Illuminating arrangements therefor for the respiratory tract, e.g. laryngoscopes, bronchoscopes

- A61B1/2676—Bronchoscopes

-

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61B—DIAGNOSIS; SURGERY; IDENTIFICATION

- A61B17/00—Surgical instruments, devices or methods

- A61B17/24—Surgical instruments, devices or methods for use in the oral cavity, larynx, bronchial passages or nose; Tongue scrapers

-

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61B—DIAGNOSIS; SURGERY; IDENTIFICATION

- A61B5/00—Measuring for diagnostic purposes; Identification of persons

- A61B5/06—Devices, other than using radiation, for detecting or locating foreign bodies ; Determining position of diagnostic devices within or on the body of the patient

- A61B5/065—Determining position of the probe employing exclusively positioning means located on or in the probe, e.g. using position sensors arranged on the probe

-

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61B—DIAGNOSIS; SURGERY; IDENTIFICATION

- A61B5/00—Measuring for diagnostic purposes; Identification of persons

- A61B5/74—Details of notification to user or communication with user or patient ; user input means

- A61B5/742—Details of notification to user or communication with user or patient ; user input means using visual displays

- A61B5/7425—Displaying combinations of multiple images regardless of image source, e.g. displaying a reference anatomical image with a live image

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/20—Image signal generators

- H04N13/271—Image signal generators wherein the generated image signals comprise depth maps or disparity maps

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N23/00—Cameras or camera modules comprising electronic image sensors; Control thereof

- H04N23/50—Constructional details

- H04N23/555—Constructional details for picking-up images in sites, inaccessible due to their dimensions or hazardous conditions, e.g. endoscopes or borescopes

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N23/00—Cameras or camera modules comprising electronic image sensors; Control thereof

- H04N23/60—Control of cameras or camera modules

- H04N23/63—Control of cameras or camera modules by using electronic viewfinders

Landscapes

- Health & Medical Sciences (AREA)

- Life Sciences & Earth Sciences (AREA)

- Surgery (AREA)

- Engineering & Computer Science (AREA)

- Medical Informatics (AREA)

- Biomedical Technology (AREA)

- Public Health (AREA)

- Animal Behavior & Ethology (AREA)

- Molecular Biology (AREA)

- General Health & Medical Sciences (AREA)

- Heart & Thoracic Surgery (AREA)

- Veterinary Medicine (AREA)

- Nuclear Medicine, Radiotherapy & Molecular Imaging (AREA)

- Pathology (AREA)

- Physics & Mathematics (AREA)

- Biophysics (AREA)

- Radiology & Medical Imaging (AREA)

- Optics & Photonics (AREA)

- Signal Processing (AREA)

- Pulmonology (AREA)

- Otolaryngology (AREA)

- Multimedia (AREA)

- Physiology (AREA)

- Evolutionary Computation (AREA)

- Artificial Intelligence (AREA)

- Dentistry (AREA)

- Oral & Maxillofacial Surgery (AREA)

- Human Computer Interaction (AREA)

- Endoscopes (AREA)

- Image Analysis (AREA)

- Apparatus For Radiation Diagnosis (AREA)

- Magnetic Resonance Imaging Apparatus (AREA)

- Instruments For Viewing The Inside Of Hollow Bodies (AREA)

Description

本開示は、気管支等の管状構造物に対する内視鏡等を用いた検査を支援する検査支援装置、方法およびプログラムに関するものである。 The present disclosure relates to an inspection support device, method and program for supporting an inspection using an endoscope or the like on a tubular structure such as a bronchus.

近年、患者の大腸および気管支等の管状構造物を内視鏡を用いて観察したり、処置したりする技術が注目されている。しかしながら、内視鏡画像は、CCD(Charge Coupled Device)等の撮像素子により管状構造物内部の色および質感が鮮明に表現された画像が得られる一方で、管状構造物の内部を2次元の画像に表すものである。このため、内視鏡画像が管状構造物内のどの位置を表しているものかを把握することが困難である。とくに、気管支の内視鏡は、径が細く視野が狭いため、内視鏡の先端を目的とする位置まで到達させることは困難である。 In recent years, attention has been focused on techniques for observing and treating tubular structures such as the large intestine and bronchi of patients using an endoscope. However, as an endoscopic image, an image in which the color and texture inside the tubular structure are clearly expressed by an image sensor such as a CCD (Charge Coupled Device) can be obtained, while a two-dimensional image of the inside of the tubular structure is obtained. It is represented by. For this reason, it is difficult to know which position in the tubular structure the endoscopic image represents. In particular, since the bronchial endoscope has a small diameter and a narrow field of view, it is difficult to reach the target position at the tip of the endoscope.

そこで、CT(Computed Tomography)装置またはMRI(Magnetic Resonance Imaging)装置等のモダリティによる断層撮影により取得された3次元画像を用いて、管状構造物内の目標とする地点までの経路を予め取得し、3次元画像から実際に内視鏡によって撮影した画像と類似した仮想内視鏡画像を生成し、仮想内視鏡画像を用いて目標とする地点までの内視鏡の経路をナビゲーションする手法が提案されている。例えば、特許文献1には、3次元画像から管状構造物の経路を表す経路情報を取得し、経路に沿って仮想内視鏡画像を多数生成し、仮想内視鏡画像と内視鏡により撮影を行うことにより取得した実際の内視鏡画像である実内視鏡画像とのマッチングを行い、内視鏡の現在位置における仮想内視鏡画像を特定することにより、内視鏡の先端位置を特定する手法が提案されている。 Therefore, using a three-dimensional image acquired by tomography using a modality such as a CT (Computed Tomography) device or an MRI (Magnetic Resonance Imaging) device, a route to a target point in the tubular structure is obtained in advance. A method is proposed to generate a virtual endoscopic image similar to the image actually taken by the endoscope from the 3D image and to navigate the path of the endoscope to the target point using the virtual endoscopic image. Has been done. For example, in Patent Document 1, path information representing a path of a tubular structure is acquired from a three-dimensional image, a large number of virtual endoscopic images are generated along the path, and images are taken by the virtual endoscopic image and the endoscope. By matching with the actual endoscopic image, which is the actual endoscopic image obtained by performing, and specifying the virtual endoscopic image at the current position of the endoscope, the tip position of the endoscope can be determined. Specific methods have been proposed.

しかしながら、ナビゲーション画像を用いても、気管支のような多段階に分岐する経路を有する構造物の場合、内視鏡の先端を目標とする位置まで短時間で到達させるのは熟練した技術を要する。 However, even if a navigation image is used, in the case of a structure having a multi-step branching path such as a bronchus, it requires a skillful technique to reach the target position of the tip of the endoscope in a short time.

このため、仮想内視鏡画像の画像強度をグレースケールに変換し、実内視鏡画像とグレースケールに変換した仮想内視鏡画像とのマッチングを行うことにより、内視鏡の先端位置を特定する手法が提案されている(特許文献2参照)。 Therefore, the tip position of the endoscope is specified by converting the image intensity of the virtual endoscope image to gray scale and matching the real endoscope image with the virtual endoscope image converted to gray scale. (See Patent Document 2).

一方、内視鏡は管状構造物内に挿入されるものであるため、体内の粘液等の影響により、内視鏡先端のレンズに体液が付着したり、レンズが曇ったりする場合がある。また、断層撮影によっては捉えることができない物体が実内視鏡画像に含まれる場合もある。このように、レンズの曇りおよび断層撮影によっては捉えることができない物体等がノイズとして実内視鏡画像に含まれる場合、仮想内視鏡画像をグレースケールに変換したとしても、実内視鏡画像と仮想内視鏡画像とのマッチングを精度よく行うことができない。その結果、内視鏡の先端位置を精度よく特定することができなくなる。 On the other hand, since the endoscope is inserted into a tubular structure, body fluid may adhere to the lens at the tip of the endoscope or the lens may become cloudy due to the influence of mucus or the like in the body. In addition, an object that cannot be captured by tomography may be included in the actual endoscopic image. In this way, when the real endoscope image contains objects such as cloudiness of the lens and objects that cannot be captured by tomography as noise, even if the virtual endoscope image is converted to gray scale, the real endoscope image And the virtual endoscopic image cannot be matched accurately. As a result, the position of the tip of the endoscope cannot be accurately specified.

本開示は上記事情に鑑みなされたものであり、実内視鏡画像と仮想内視鏡画像とのマッチングを精度よく行うことができるようにすることを目的とする。 The present disclosure has been made in view of the above circumstances, and an object of the present disclosure is to enable accurate matching between a real endoscopic image and a virtual endoscopic image.

本開示による検査支援装置は、第1の表現形式の第1の医用画像、および第1の表現形式とは異なる第2の表現形式の第2の医用画像を取得する画像取得部と、

第1の医用画像の第1の表現形式および第2の医用画像の第2の表現形式を、それぞれ第3の表現形式に変換することにより、変換済み第1の医用画像および変換済み第2の医用画像を取得する変換部と、

変換済み第1の医用画像と変換済み第2の医用画像との類似度を算出する類似度算出部とを備える。

The inspection support device according to the present disclosure includes an image acquisition unit that acquires a first medical image in a first expression format and a second medical image in a second expression format different from the first expression format.

By converting the first expression format of the first medical image and the second expression format of the second medical image into the third expression format, respectively, the converted first medical image and the converted second expression format are obtained. A conversion unit that acquires medical images, and

A similarity calculation unit for calculating the similarity between the converted first medical image and the converted second medical image is provided.

「表現形式」とは、画像を表示した際に、見た者に対する画像の印象に影響を与える、いわば画像の画風を意味する。例えば、医用画像が実際に撮影をすることにより取得されたものであれば、その医用画像の表現形式は実写風となる。また、医用画像がCG(computer graphics)により生成されたものであれば、その医用画像の表現形式はCG風となる。また、医用画像が、ボリュームレンダリング等の投影法を用いて3次元画像を投影することにより生成されたものであれば、その医用画像の表現形式はCG風であってボリュームレンダリング画像風となる。さらに、医用画像が実内視鏡画像であれば、その医用画像は実写風であって実内視鏡画像風となる。実内視鏡画像においても、狭帯域光観察によって撮影された医用画像は狭帯域光風となり、白色光観察によって撮影された医用画像は白色光風となる。 医用画像が仮想内視鏡画像であれば、その医用画像はCG風であって仮想内視鏡画像風となる。なお、各表現形式は、画像の階調および色彩表現に関するパラメータの範囲、テクスチャ表現(画像の粗さ、細かさ、ノイズ量およびノイズ特徴)、表面反射率、並びに透明度等の特徴によって決定されるものであるが、これらに限定されない。 The "expression format" means, so to speak, the style of an image that affects the impression of the image on the viewer when the image is displayed. For example, if the medical image is acquired by actually taking a picture, the expression format of the medical image is a live-action style. Further, if the medical image is generated by CG (computer graphics), the expression format of the medical image is CG style. Further, if the medical image is generated by projecting a three-dimensional image using a projection method such as volume rendering, the expression format of the medical image is CG style and volume rendering image style. Further, if the medical image is a real endoscopic image, the medical image is a live-action style and is a real endoscopic image style. Even in the actual endoscopic image, the medical image taken by narrow-band light observation is a narrow-band light breeze, and the medical image taken by white light observation is a white light breeze. If the medical image is a virtual endoscopic image, the medical image is CG-like and virtual endoscopic image-like. Each expression format is determined by characteristics such as a range of parameters related to image gradation and color expression, texture expression (image roughness, fineness, noise amount and noise characteristics), surface reflectance, and transparency. However, it is not limited to these.

なお、本開示による検査支援装置においては、第1の医用画像は被検体を撮影することにより取得された実画像であり、第2の医用画像は実画像とは異なる方式により被検体を撮影することにより取得された画像から生成された画像であってもよい。 In the inspection support device according to the present disclosure, the first medical image is an actual image acquired by photographing the subject, and the second medical image captures the subject by a method different from the actual image. It may be an image generated from the acquired image.

また、本開示による検査支援装置においては、第1の医用画像は、被検体における管状構造物内に挿入された内視鏡により生成された、管状構造物の内壁を表す実内視鏡画像であり、

第2の医用画像は、被検体の管状構造物を含む3次元画像から生成された、管状構造物の内壁を擬似的に表す仮想内視鏡画像であり、

変換済み第1の医用画像は、第1の医用画像の視点からの管状構造物の内壁までの距離を表す第1の深度画像であり、

変換済み第2の医用画像は、第2の医用画像の視点からの管状構造物の内壁までの距離を表す第2の深度画像であってもよい。

Further, in the examination support device according to the present disclosure, the first medical image is a real endoscopic image showing the inner wall of the tubular structure generated by the endoscope inserted into the tubular structure in the subject. can be,

The second medical image is a virtual endoscopic image that simulates the inner wall of the tubular structure, which is generated from a three-dimensional image including the tubular structure of the subject.

The converted first medical image is a first depth image showing the distance from the viewpoint of the first medical image to the inner wall of the tubular structure.

The converted second medical image may be a second depth image representing the distance from the viewpoint of the second medical image to the inner wall of the tubular structure.

また、本開示による検査支援装置においては、算出された類似度が予め定められたしきい値以上となる仮想内視鏡画像を用いて、管状構造物内における内視鏡の位置を推定する位置推定部をさらに備えるものであってもよい。 Further, in the inspection support device according to the present disclosure, a position for estimating the position of the endoscope in the tubular structure by using a virtual endoscope image in which the calculated similarity is equal to or higher than a predetermined threshold value. It may further include an estimation unit.

また、本開示による検査支援装置においては、位置推定部は、第1の深度画像と第2の深度画像との画素値の相違にも基づいて、管状構造物内における内視鏡の位置を推定するものであってもよい。 Further, in the inspection support device according to the present disclosure, the position estimation unit estimates the position of the endoscope in the tubular structure based on the difference in the pixel values between the first depth image and the second depth image. It may be something to do.

また、本開示による検査支援装置においては、推定された内視鏡の位置に対応する第2の深度画像と第1の深度画像とを表示部に表示する表示制御部をさらに備えるものであってもよい。 Further, the inspection support device according to the present disclosure further includes a display control unit that displays a second depth image and a first depth image corresponding to the estimated position of the endoscope on the display unit. May be good.

また、本開示による検査支援装置においては、3次元画像から仮想内視鏡画像を生成する仮想内視鏡画像生成部をさらに備えるものであってもよい。 Further, the inspection support device according to the present disclosure may further include a virtual endoscope image generation unit that generates a virtual endoscope image from a three-dimensional image.

本開示による検査支援方法は、第1の表現形式の第1の医用画像、および第1の表現形式とは異なる第2の表現形式の第2の医用画像を取得し、

第1の医用画像の第1の表現形式および第2の医用画像の第2の表現形式を、それぞれ第3の表現形式に変換することにより、変換済み第1の医用画像および変換済み第2の医用画像を取得し、

変換済み第1の医用画像と変換済み第2の医用画像との類似度を算出する。

The examination support method according to the present disclosure acquires a first medical image of the first expression format and a second medical image of a second expression format different from the first expression format.

By converting the first expression format of the first medical image and the second expression format of the second medical image into the third expression format, respectively, the converted first medical image and the converted second expression format are obtained. Get a medical image,

The degree of similarity between the converted first medical image and the converted second medical image is calculated.

なお、本開示による検査支援方法をコンピュータに実行させるためのプログラムとして提供してもよい。 It should be noted that the inspection support method according to the present disclosure may be provided as a program for causing a computer to execute the inspection support method.

本開示による他の検査支援装置は、コンピュータに実行させるための命令を記憶するメモリと、

記憶された命令を実行するよう構成されたプロセッサとを備え、プロセッサは、

第1の表現形式の第1の医用画像、および第1の表現形式とは異なる第2の表現形式の第2の医用画像を取得し、

第1の医用画像の第1の表現形式および第2の医用画像の第2の表現形式を、それぞれ第3の表現形式に変換することにより、変換済み第1の医用画像および変換済み第2の医用画像を取得し、

変換済み第1の医用画像と変換済み第2の医用画像との類似度を算出する。

Other inspection support devices according to the present disclosure include a memory for storing an instruction to be executed by a computer and a memory.

The processor comprises a processor configured to execute a stored instruction.

The first medical image of the first expression format and the second medical image of the second expression format different from the first expression format are acquired.

By converting the first expression format of the first medical image and the second expression format of the second medical image into the third expression format, respectively, the converted first medical image and the converted second expression format are obtained. Get a medical image,

The degree of similarity between the converted first medical image and the converted second medical image is calculated.

本開示によれば、第1の表現形式の第1の医用画像、および第1の表現形式とは異なる第2の表現形式の第2の医用画像が取得される。そして、第1の医用画像および第2の医用画像の表現形式が第3の表現形式に変換されて、変換済み第1の医用画像および変換済み第2の医用画像が取得される。さらに、変換済み第1の医用画像と変換済み第2の医用画像との類似度が算出される。このため、第1の医用画像および第2の医用画像にノイズが含まれていても、表現形式を第3の表現形式に変換する際に、ノイズをキャンセルすることができる。したがって、本開示によれば、第1の医用画像と第2の医用画像との類似度を精度よく算出することができる。 According to the present disclosure, a first medical image having a first expression format and a second medical image having a second expression format different from the first expression format are acquired. Then, the expression formats of the first medical image and the second medical image are converted into the third expression format, and the converted first medical image and the converted second medical image are acquired. Further, the degree of similarity between the converted first medical image and the converted second medical image is calculated. Therefore, even if the first medical image and the second medical image contain noise, the noise can be canceled when the expression format is converted to the third expression format. Therefore, according to the present disclosure, the degree of similarity between the first medical image and the second medical image can be calculated accurately.

以下、図面を参照して本開示の実施形態について説明する。図1は、本実施形態による検査支援装置を適用した、診断支援システムの概要を示すハードウェア構成図である。図1に示すように、本実施形態のシステムでは、内視鏡装置3、3次元画像撮影装置4、画像保管サーバ5および検査支援装置6が、ネットワーク8を経由して通信可能な状態で接続されている。

Hereinafter, embodiments of the present disclosure will be described with reference to the drawings. FIG. 1 is a hardware configuration diagram showing an outline of a diagnosis support system to which the inspection support device according to the present embodiment is applied. As shown in FIG. 1, in the system of the present embodiment, the endoscope device 3, the three-dimensional image capturing device 4, the

内視鏡装置3は、被検体の管状構造物の内部を撮影する内視鏡スコープ31、並びに撮影により得られた信号に基づいて管状構造物の内部の画像を生成するプロセッサ装置32等を備える。

The endoscope device 3 includes an

内視鏡スコープ31は、被検体の管状構造物内に挿入される挿入部が操作部3Aに連続して取り付けられたものである。内視鏡スコープ31は、プロセッサ装置32に着脱可能に接続されたユニバーサルコードを介してプロセッサ装置32に接続されている。操作部3Aは、挿入部の先端3Bが予め定められた角度範囲内で上下方向および左右方向に湾曲するように動作を指令したり、内視鏡スコープ31の先端に取り付けられた穿刺針を操作して組織のサンプルの採取を行ったりするための各種ボタンを含む。本実施形態では、内視鏡スコープ31は気管支用の軟性鏡であり、被検体の気管支内に挿入される。そして、プロセッサ装置32に設けられた不図示の光源装置から光ファイバーで導かれた光が内視鏡スコープ31の挿入部の先端3Bから照射され、内視鏡スコープ31の撮像光学系により被検体の気管支内の画像が取得される。なお、内視鏡スコープ31の挿入部の先端3Bについて、説明を容易なものとするために、以降の説明においては内視鏡先端3Bと称するものとする。

The

プロセッサ装置32は、内視鏡スコープ31で撮影された撮影信号をデジタル画像信号に変換し、ホワイトバランス調整およびシェーディング補正等のデジタル信号処理によって画質の補正を行い、内視鏡画像T0を生成する。生成される画像は、例えば30fps等の所定のサンプリングレートにより表されるカラーの動画像であり、動画像の1フレームが内視鏡画像T0となる。内視鏡画像T0は、画像保管サーバ5または検査支援装置6に順次送信される。ここで、以降の説明において、内視鏡装置3により撮影した内視鏡画像T0を、後述する仮想内視鏡画像と区別するために実内視鏡画像T0と称するものとする。

The

3次元画像撮影装置4は、被検体の検査対象部位を撮影することにより、その部位を表す3次元画像V0を生成する装置であり、具体的には、内視鏡スコープ31を管状構造物に挿入して管状構造物を撮影する方式以外の方式で撮影するCT装置、MRI装置、PET(Positron Emission Tomography)、および超音波診断装置等である。この3次元画像撮影装置4により生成された3次元画像V0は画像保管サーバ5に送信され、保存される。本実施形態では、3次元画像撮影装置4は、気管支を含む胸部を撮影した3次元画像V0を生成する。なお、本実施形態においては、3次元画像撮影装置4はCT装置であるものとするが、これに限定されるものではない。

The three-dimensional imaging apparatus 4 is an apparatus that generates a three-dimensional image V0 representing the portion to be inspected of the subject by photographing the portion to be inspected. Specifically, the

画像保管サーバ5は、各種データを保存して管理するコンピュータであり、大容量外部記憶装置およびデータベース管理用ソフトウェアを備えている。画像保管サーバ5は、ネットワーク8を介して他の装置と通信を行い、画像データ等を送受信する。具体的には内視鏡装置3で取得された実内視鏡画像T0および3次元画像撮影装置4で生成された3次元画像V0等の画像データをネットワーク経由で取得し、大容量外部記憶装置等の記録媒体に保存して管理する。なお、実内視鏡画像T0は動画像である。このため、実内視鏡画像T0は、画像保管サーバ5を経由することなく、検査支援装置6に送信されることが好ましい。なお、画像データの格納形式やネットワーク8経由での各装置間の通信は、DICOM(Digital Imaging and Communication in Medicine)等のプロトコルに基づいている。

The

検査支援装置6は、1台のコンピュータに、本開示の検査支援プログラムをインストールしたものである。コンピュータは、診断を行う医師が直接操作するワークステーションまたはパーソナルコンピュータでもよく、それらとネットワークを介して接続されたサーバコンピュータでもよい。検査支援プログラムは、DVD(Digital Versatile Disc)あるいはCD-ROM(Compact Disk Read Only Memory)等の記録媒体に記録されて配布され、その記録媒体からコンピュータにインストールされる。または、ネットワークに接続されたサーバコンピュータの記憶装置、もしくはネットワークストレージに、外部からアクセス可能な状態で記憶され、要求に応じて検査支援装置6の操作者である医師が使用するコンピュータにダウンロードされ、インストールされる。

The

図2は、コンピュータに検査支援プログラムをインストールすることにより実現される検査支援装置の概略構成を示す図である。図2に示すように、検査支援装置6は、標準的なワークステーションの構成として、CPU(Central Processing Unit)11、メモリ12およびストレージ13を備えている。また、検査支援装置6には、表示部14と、マウス等の入力部15とが接続されている。表示部14は、液晶ディスプレイ等からなる。

FIG. 2 is a diagram showing a schematic configuration of an inspection support device realized by installing an inspection support program on a computer. As shown in FIG. 2, the

ストレージ13は、ハードディスクドライブ等からなり、ネットワーク8を経由して内視鏡装置3、3次元画像撮影装置4および画像保管サーバ5等から取得した実内視鏡画像T0、3次元画像V0および検査支援装置6での処理によって生成された画像(例えば後述する仮想内視鏡画像)および処理に必要な各種情報等が記憶されている。

The

また、メモリ12には、検査支援プログラムが記憶されている。検査支援プログラムは、CPU11に実行させる処理として、プロセッサ装置32が生成した実内視鏡画像T0、3次元画像撮影装置4で生成された3次元画像V0、および後述するように生成された仮想内視鏡画像等の画像データを取得する画像取得処理、3次元画像V0から気管支のグラフ構造を表す3次元の気管支画像B0を生成する気管支画像生成処理、3次元画像V0から仮想内視鏡画像を生成する仮想内視鏡画像生成処理、実内視鏡画像の表現形式および仮想内視鏡画像の表現形式をそれぞれ深度画像の表現形式に変換することにより、実内視鏡画像に対応する第1の深度画像および仮想内視鏡画像に対応する第2の深度画像を取得する変換処理、第1の深度画像と第2の深度画像との類似度を算出する類似度算出処理、算出された類似度が予め定められたしきい値以上となる仮想内視鏡画像を用いて、気管支内における内視鏡先端3Bの位置を推定する位置推定処理、並びに実内視鏡画像T0、仮想内視鏡画像、気管支画像B0および特定された内視鏡先端3Bの位置等を表示部14に表示する表示制御処理を規定する。

Further, the inspection support program is stored in the

そして、CPU11がプログラムに従いこれらの処理を実行することで、検査支援装置6であるコンピュータは、画像取得部21、気管支画像生成部22、仮想内視鏡画像生成部23、変換部24、類似度算出部25、位置推定部26、および表示制御部27として機能する。

Then, when the

画像取得部21は、3次元画像V0および内視鏡装置3により気管支内を所定の視点位置において撮影した実内視鏡画像T0を取得する。画像取得部21は、3次元画像V0および実内視鏡画像T0が既にストレージ13に記憶されている場合には、3次元画像V0および実内視鏡画像T0をストレージ13から取得するようにしてもよい。実内視鏡画像T0は、気管支の内側の表面、すなわち気管支内壁を表す画像である。実内視鏡画像T0は表示制御部27に出力されて表示部14に表示される。また、画像取得部21は、後述するように仮想内視鏡画像生成部23によって生成され、ストレージ13に保存された仮想内視鏡画像K0をストレージ13から取得する。

The

気管支画像生成部22は、3次元画像V0から気管支の構造を抽出することにより、3次元の気管支画像B0を生成する。具体的には、気管支画像生成部22は、例えば特開2010-220742号公報等に記載された手法を用いて、入力された3次元画像V0に含まれる気管支領域のグラフ構造を、3次元の気管支画像B0として抽出する。以下、このグラフ構造の抽出方法の一例を説明する。

The bronchial

3次元画像V0においては、気管支の内部の画素は空気領域に相当するため低い画素値を示す領域として表されるが、気管支壁は比較的高い画素値を示す円柱または線状の構造物として表される。そこで、画素毎に画素値の分布に基づく形状の構造解析を行って気管支を抽出する。 In the three-dimensional image V0, the pixels inside the bronchus are represented as regions showing low pixel values because they correspond to the air region, but the bronchial walls are represented as cylinders or linear structures showing relatively high pixel values. Will be done. Therefore, the bronchi are extracted by performing structural analysis of the shape based on the distribution of pixel values for each pixel.

気管支は多段階に分岐し、末端に近づくほど気管支の径は小さくなっていく。気管支画像生成部22は、異なるサイズの気管支を検出することができるように、3次元画像V0を多重解像度変換して解像度が異なる複数の3次元画像を生成し、各解像度の3次元画像毎に検出アルゴリズムを適用する。

The bronchus branches in multiple stages, and the diameter of the bronchi becomes smaller as it approaches the end. The bronchial

まず、各解像度において、3次元画像の各画素のヘッセ行列を算出し、ヘッセ行列の固有値の大小関係から管状構造物内の画素であるか否かを判定する。ヘッセ行列は、各軸(3次元画像のx軸、y軸、z軸)方向における濃度値の2階の偏微分係数を要素とする行列であり、下式のように3×3行列となる。 First, at each resolution, the Hessian matrix of each pixel of the three-dimensional image is calculated, and it is determined whether or not the pixel is in the tubular structure from the magnitude relation of the eigenvalues of the Hessian matrix. The Hessian matrix is a matrix whose elements are the second-order partial differential coefficients of the density values in the directions of each axis (x-axis, y-axis, z-axis of the three-dimensional image), and is a 3 × 3 matrix as shown in the following equation. ..

任意の画素におけるヘッセ行列の固有値をλ1、λ2、λ3としたとき、固有値のうち2つの固有値が大きく、1つの固有値が0に近い場合、例えば、λ3,λ2≫λ1、λ1≒0を満たすとき、その画素は管状構造物であることが知られている。また、ヘッセ行列の最小の固有値(λ1≒0)に対応する固有ベクトルが管状構造物の主軸方向に一致する。 When the eigenvalues of the Hessian matrix in an arbitrary pixel are λ1, λ2, and λ3, when two eigenvalues of the eigenvalues are large and one eigenvalue is close to 0, for example, when λ3, λ2 >> λ1, λ1≈0 is satisfied. , The pixel is known to be a tubular structure. Further, the eigenvector corresponding to the minimum eigenvalue (λ1≈0) of the Hessian matrix coincides with the main axis direction of the tubular structure.

気管支はグラフ構造で表すことができるが、このようにして抽出された管状構造物は、腫瘍等の影響により、全ての管状構造物が繋がった1つのグラフ構造として検出されるとは限らない。そこで、3次元画像V0全体からの管状構造物の検出が終了した後、抽出された各管状構造物が一定の距離内にあり、かつ抽出された2つの管状構造物上の任意の点を結ぶ基本線の向きと各管状構造物の主軸方向とがなす角が一定角度以内であるかについて評価することにより、複数の管状構造物が接続されるものであるか否かを判定して、抽出された管状構造物の接続関係を再構築する。この再構築により、気管支のグラフ構造の抽出が完了する。 Although the bronchi can be represented by a graph structure, the tubular structure extracted in this way is not always detected as one graph structure in which all the tubular structures are connected due to the influence of a tumor or the like. Therefore, after the detection of the tubular structure from the entire three-dimensional image V0 is completed, each of the extracted tubular structures is within a certain distance and connects arbitrary points on the two extracted tubular structures. By evaluating whether the angle formed by the direction of the basic line and the main axis direction of each tubular structure is within a certain angle, it is determined whether or not a plurality of tubular structures are connected and extracted. Reconstruct the connection relationship of the tubular structure. This reconstruction completes the extraction of the bronchial graph structure.

そして、気管支画像生成部22は、抽出したグラフ構造を、開始点、端点、分岐点および辺に分類し、開始点、端点および分岐点を辺で連結することによって、気管支を表す3次元のグラフ構造を気管支画像B0として得ることができる。図3は気管支画像B0を示す図である。なお、グラフ構造の生成方法としては、上述した方法に限定されるものではなく、他の方法を採用するようにしてもよい。

Then, the bronchial

仮想内視鏡画像生成部23は、気管支内の目標とする経路において、実内視鏡画像T0の視点に対応する3次元画像V0中の視点から見た、気管支内壁を描写した仮想内視鏡画像K0を生成する。以下、仮想内視鏡画像K0の生成について説明する。

The virtual endoscope

まず、仮想内視鏡画像生成部23は、気管支において予め設定された、内視鏡先端3Bを挿入する経路の情報を取得する。経路の情報は、例えば気管支画像B0を表示部14に表示し、表示された気管支画像B0において、操作者が入力部15を用いて指定されたものを用いるが、これに限定されるものではない。図4に気管支画像B0に設定された内視鏡の経路40を示す。

First, the virtual endoscope

仮想内視鏡画像生成部23は、取得した経路の情報により表される気管支内の経路40に沿った予め定められた間隔により、気管支の内壁を表す仮想内視鏡画像K0を生成する。なお、予め定められた間隔は、経路40上の例えば10画素間隔とすればよいが、これに限定されるものではない。

The virtual endoscopic

仮想内視鏡画像生成部23は、経路40上の各位置を視点に設定する。そして、設定した各視点から内視鏡先端3Bの挿入方向(すなわち気管支の末端に向かう方向)に放射線状に伸ばした複数の視線上の3次元画像V0を、予め定められた投影面に投影する中心投影を行うことにより、投影画像を生成する。この投影画像が、内視鏡の先端位置において撮影を行ったものとして仮想的に生成された仮想内視鏡画像K0となる。なお、中心投影の具体的な方法としては、例えば公知のボリュームレンダリング手法等を用いることができる。また、仮想内視鏡画像K0の画角(視線の範囲)および視野の中心(投影方向の中心)は、操作者による入力等によってあらかじめ設定されているものとする。生成された複数の仮想内視鏡画像K0はストレージ13に保存される。なお、本実施形態においては3次元画像V0はCT画像であるため、仮想内視鏡画像K0はCT値により表されるモノクロの画像である。

The virtual endoscope

変換部24は、実内視鏡画像T0の表現形式を深度画像の表現形式に変換する。また、仮想内視鏡画像生成部23が生成した仮想内視鏡画像K0の表現形式を深度画像の表現形式に変換する。このために、変換部24は、例えば「Atapour-Abarghouei, A. and Breckon, T.P. (2018) 'Real-time monocular depth estimation using synthetic data with domain adaptation.', 2018 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Salt Lake City, Utah, USA, 18-22 June 2018.」(以下、非特許文献1とする)に記載されている手法を用いる。非特許文献1に記載された手法は、画像が入力されるとその深度画像を出力するニューラルネットワーク等のモデルを用いて、画像を深度画像に変換する手法である。モデルは各種画像およびその画像の奥行き(すなわち深さ)を表す情報を教師データとして機械学習を行うことにより生成される。深度画像はその画素値が視点位置からの距離を表す。具体的には、深度画像の画素値は、視点位置からの距離が大きいほど低い値となり、その結果、視点位置からの距離が大きいほど画像は暗くなる。そして、深度画像の画素値と距離との関係を予め設定しておくことにより、深度画像の画素値に基づいて視点位置からの距離を算出することができる。

The

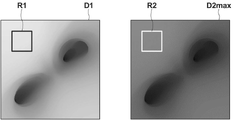

本実施形態における変換部24は、非特許文献1に記載された、画像の表現形式を深度画像の表現形式に変換するように機械学習がなされたニューラルネットワーク等からなるモデルを変換器として備える。機械学習の手法としては、公知の手法を用いることができる。例えば、サポートベクタマシン、ディープニューラルネットワーク、畳み込みニューラルネットワーク、およびリカレントニューラルネットワーク等を用いることができる。なお、本実施形態においては、実内視鏡画像T0にレンズの曇りおよび断層撮影によっては捉えることができない物体等がノイズとして含まれる場合には、ノイズを除去して実内視鏡画像T0を深度画像に変換するように機械学習が行われる。また、論理演算により実内視鏡画像T0および仮想内視鏡画像K0の表現形式を深度画像の表現形式に変換する変換器を用いてもよい。このような変換器により、図5に示すように、実内視鏡画像T0および仮想内視鏡画像K0の表現形式は深度画像の表現形式に変換され、その結果、実内視鏡画像T0に対応する第1の深度画像D1および仮想内視鏡画像に対応する第2の深度画像D2が取得される。また、レンズの曇りおよび断層撮影によっては捉えることができない物体等の実内視鏡画像T0に含まれるノイズは、変換によりキャンセルされる。なお、第1の深度画像D1が第1の変換済み医用画像に、第2の深度画像D2が変換済み第2の医用画像にそれぞれ対応する。

The

なお、実内視鏡画像T0は動画像の1フレームを構成する。このため、変換部24は順次取得される実内視鏡画像T0の表現形式を深度画像の表現形式に変換する。また、変換部24は、仮想内視鏡画像生成部23が生成したすべての仮想内視鏡画像K0を予め深度画像に変換しておくものであってもよい。また、後述するように、推定された内視鏡先端3Bの位置の周囲の仮想内視鏡画像K0を、位置推定の処理を行う毎に深度画像に変換するものであってもよい。本実施形態においては、仮想内視鏡画像生成部23が生成したすべての仮想内視鏡画像K0を予め深度画像に変換しておくものとする。これにより取得される第2の深度画像D2は、ストレージ13に保存される。

The actual endoscopic image T0 constitutes one frame of a moving image. Therefore, the

類似度算出部25は、後述する内視鏡先端3Bの位置を推定するために、順次取得される実内視鏡画像T0についての第1の深度画像D1と第2の深度画像D2との類似度を算出する。なお、類似度としては、第1の深度画像D1と第2の深度画像D2との対応する画素間の画素値の差分の絶対値の和の逆数、または差分の二乗和の逆数等を用いることができる。

The

位置推定部26は、類似度算出部25が算出した類似度が予め定められたしきい値Th1以上となる仮想内視鏡画像を用いて、気管支内における内視鏡先端3Bの位置を推定する。

The

上述したように、実内視鏡画像T0は動画像の1フレームを構成する。このため、類似度算出部25は、動画像において順次取得される実内視鏡画像T0のうちの最新の実内視鏡画像T0についての第1の深度画像D1と第2の深度画像D2との類似度を算出する。ここで、内視鏡先端3Bの位置を推定するために、類似度算出部25は、第1の深度画像D1とストレージ13に保存されたすべての仮想内視鏡画像K0から生成されたすべての第2の深度画像D2との類似度を算出してもよいが、演算量が多くなる。このため、本実施形態においては、以下のように類似度を算出する。

As described above, the real endoscopic image T0 constitutes one frame of the moving image. Therefore, the

まず、類似度算出部25は、気管支内の基準位置において生成された基準となる第2の深度画像D2を基準深度画像DBに特定する。そして、順次取得される第1の深度画像D1のうちの最新の第1の深度画像D1と基準深度画像DBとの類似度を算出する。基準深度画像DBとしては、気管支の経路40における気管支の入り口に最も近い位置を視点位置とする仮想内視鏡画像から生成された第2の深度画像D2を用いればよい。位置推定部26は、基準深度画像DBとの類似度がしきい値Th2以上となる第1の深度画像D1が取得されると、内視鏡先端3Bの位置が基準位置にあると推定する。なお、しきい値Th2はしきい値Th1と同一値であっても異なる値であってもよい。

First, the

このようにして、内視鏡先端3Bの位置が基準位置にあると位置推定部26が推定すると、類似度算出部25は、図6に示すように、基準位置Pbから予め定められた範囲A0内にある1以上の第2の深度画像D2と最新の第1の深度画像D1との類似度を算出する。なお、内視鏡先端3Bが気管支の内部に移動し、ある実内視鏡画像T0が取得された時点において、図6に示すように内視鏡先端3Bが位置P1にあると推定された場合、類似度算出部25は、次に取得された実内視鏡画像T0についての第1の深度画像D1に関して、位置P1を含む予め定められた範囲A0内にある1以上の第2の深度画像D2と実内視鏡画像T0との類似度を算出する。すなわち、実内視鏡画像T0は動画像の1つのフレームを構成するため、実内視鏡画像T0が取得される毎に、類似度算出部25は最新の第1の深度画像D1と第2の深度画像D2との類似度を算出する。

In this way, when the

位置推定部26は、範囲A0内におけるすべての第2の深度画像D2と最新の第1の深度画像D1との類似度のうち、しきい値Th1以上となり、かつ最も類似度が大きい第2の深度画像D2に対応する仮想内視鏡画像K0を生成した視点の位置を、内視鏡先端3Bの位置であると推定する。

The

なお、本実施形態においては、第1の深度画像D1および第2の深度画像D2を用いているため、気管支内における内視鏡先端3Bの進行方向における位置をより正確であると推定することができる。図7は内視鏡先端3Bの位置の推定を説明するための図である。上述したように深度画像においては画素値が奥行き方向の距離を表すものとなる。このため、位置推定部26は、第1の深度画像D1および第1の深度画像D1との類似度が最も大きい第2の深度画像D2maxに対して、それぞれ対応する領域R1、R2を設定する。そして、領域R1内の画素値の代表値(例えば平均値、中間値および最大値等)を算出し、代表値を視点位置からの距離L1に換算する。同様に、領域R2内の画素値の代表値(例えば平均値、中間値および最大値等)を算出し、代表値を視点位置からの距離L2に換算する。

Since the first depth image D1 and the second depth image D2 are used in the present embodiment, it can be estimated that the position of the

このようにして算出した距離L1と距離L2との差ΔLが、類似度が最大となる第2の深度画像D2maxに対応する仮想内視鏡画像K0を生成した視点の位置と、内視鏡先端3Bの位置との位置ずれ量を表すものとなる。以下、位置ずれ量についても参照符号としてΔLを用いる。例えば、算出した距離L1=11mm、距離L2=20mmである場合、位置ずれ量ΔLはL2-L1=9mmとなる。位置推定部26はこのように算出した位置ずれ量ΔLに基づいて、類似度が最も大きい第2の深度画像D2に対応する仮想内視鏡画像K0を生成した視点の位置を修正し、修正した位置を内視鏡先端3Bの位置として推定する。例えば、位置ずれ量ΔLが9mmであった場合、視点の位置を9mm前方(すなわち内視鏡先端3Bの挿入方向)に修正する。なお、位置ずれ量が負の値となった場合には、位置推定部26は、視点の位置を後方(すなわち内視鏡先端3Bが戻る方向)に修正する。

The difference ΔL between the distance L1 and the distance L2 calculated in this way is the position of the viewpoint that generated the virtual endoscope image K0 corresponding to the second depth image D2max having the maximum similarity, and the tip of the endoscope. It represents the amount of misalignment with the position of 3B. Hereinafter, ΔL is used as a reference code for the amount of misalignment. For example, when the calculated distance L1 = 11 mm and the distance L2 = 20 mm, the misalignment amount ΔL is L2-L1 = 9 mm. Based on the misalignment amount ΔL calculated in this way, the

図8は視点の位置の修正を説明するための図である。図8に示すように、類似度が最も大きい第2の深度画像D2に対応する仮想内視鏡画像K0を生成した視点の位置が位置P10であったとする。また、位置ずれ量ΔLは正の値であったとする。位置推定部26は、位置P10を内視鏡先端3Bの進行方向に位置ずれ量ΔL分ずらし、内視鏡先端3Bの位置を位置P11として推定する。

FIG. 8 is a diagram for explaining the correction of the position of the viewpoint. As shown in FIG. 8, it is assumed that the position of the viewpoint that generated the virtual endoscopic image K0 corresponding to the second depth image D2 having the highest similarity is the position P10. Further, it is assumed that the misalignment amount ΔL is a positive value. The

表示制御部27は、第1の深度画像D1および内視鏡先端3Bの位置における仮想内視鏡画像K0に対応する第2の深度画像D2を表示部14に表示する。なお、表示制御部27は、気管支画像B0を表示部14に表示し、表示した気管支画像B0における内視鏡先端3Bを特定する表示を行うようにしてもよい。また、第1の深度画像D1に代えて、またはこれに加えて実内視鏡画像T0を表示してもよい。また、第2の深度画像D2に代えて、またはこれに加えて仮想内視鏡画像K0を表示してもよい。

The

図9は表示部14の表示画像を示す図である。図9に示すように、表示画像50には、第1の深度画像D1、内視鏡先端3Bの位置における第2の深度画像D2および気管支画像B0が表示されている。なお、気管支画像B0には、内視鏡の移動軌跡51および内視鏡先端3Bの位置Ptが表示されている。

FIG. 9 is a diagram showing a display image of the

次いで、本実施形態において行われる処理について説明する。図10は本実施形態において行われる処理を示すフローチャートである。なお、気管支画像B0は気管支画像生成部22により生成され、かつ仮想内視鏡画像K0は仮想内視鏡画像生成部23により生成され、さらに仮想内視鏡画像K0についての第2の深度画像D2は変換部24により生成されて、それぞれストレージ13に保存されているものとする。内視鏡先端3Bが被検体に挿入され、操作開始の指示が入力部15から入力されると、画像取得部21が実内視鏡画像T0を取得し(ステップST1)、変換部24が、実内視鏡画像T0の表現形式を深度画像の表現形式に変換して、第1の深度画像D1を取得する(ステップST2)。そして、類似度算出部25が第1の深度画像D1と基準深度画像DBとの類似度を算出する(ステップST3)。さらに、位置推定部26が、類似度算出部25が算出した類似度がしきい値Th2以上であるか否かを判定する(ステップST4)。ステップST4が否定されると、ステップST1に戻り、ステップST1~ST4の処理が繰り返される。

Next, the processing performed in this embodiment will be described. FIG. 10 is a flowchart showing the processing performed in the present embodiment. The bronchial image B0 is generated by the bronchial

ステップST4が肯定されると、位置推定部26は、内視鏡先端3Bが基準位置Pbにあると推定する(ステップST5)。引き続き画像取得部21が実内視鏡画像T0を取得し(ステップST6)、変換部24が、実内視鏡画像T0の表現形式を深度画像の表現形式に変換して、第1の深度画像D1を取得する(ステップST7)。続いて類似度算出部25が、ステップST7において取得した第1の深度画像D1と、内視鏡先端3Bの現在位置から予め定められた範囲内にある仮想内視鏡画像K0に対応する第2の深度画像D2との類似度を算出する(ステップST8)。そして、位置推定部26が、類似度がしきい値Th1以上となり、かつ類似度が最も大きい第2の深度画像D2に対応する仮想内視鏡画像K0を取得した位置を、内視鏡先端3Bの位置であると推定する(ステップST9)。続いて、表示制御部27が、第1の深度画像D1および第2の深度画像D2を表示する(ステップST10)。そして、終了の指示がなされるまで(ステップST11:肯定)ステップST6~ステップST10の処理が繰り返される。

When step ST4 is affirmed, the

なお、上記実施形態の処理においては、類似度がしきい値Th1以上となる第2の深度画像D2が存在しない場合があり得る。このような場合には、類似度を算出する第2の深度画像D2を取得した範囲を広げる等して、内視鏡先端3Bの位置を推定すればよい。

In the processing of the above embodiment, there may be a case where the second depth image D2 whose similarity is equal to or higher than the threshold value Th1 does not exist. In such a case, the position of the

このように、本実施形態においては、実内視鏡画像T0および仮想内視鏡画像K0の表現形式を深度画像の表現形式に変換して第1の深度画像D1および第2の深度画像D2を取得し、第1の深度画像D1と第2の深度画像D2との類似度を算出するようにした。このため、レンズの曇りおよび断層撮影によっては捉えることができない物体等がノイズとして実内視鏡画像T0に含まれていても、実内視鏡画像T0を深度画像の表現形式に変換する際に、ノイズをキャンセルすることができる。したがって、本実施形態によれば、実内視鏡画像T0と仮想内視鏡画像K0との類似度を精度よく算出することができる。また、このように算出された類似度を用いることにより、内視鏡先端3Bの位置を精度よく推定することができる。

As described above, in the present embodiment, the representation formats of the real endoscope image T0 and the virtual endoscope image K0 are converted into the representation formats of the depth image, and the first depth image D1 and the second depth image D2 are obtained. It was acquired and the degree of similarity between the first depth image D1 and the second depth image D2 was calculated. Therefore, even if the real endoscope image T0 contains an object or the like that cannot be captured by cloudiness of the lens or tomography as noise, when the real endoscope image T0 is converted into the expression format of the depth image, , Noise can be canceled. Therefore, according to the present embodiment, the degree of similarity between the real endoscope image T0 and the virtual endoscope image K0 can be calculated accurately. Further, by using the similarity calculated in this way, the position of the

なお、上記実施形態においては、位置推定部26が内視鏡先端3Bの基準位置を推定しているが、これに限定されるものではない。例えば、図11に示すように、内視鏡装置3を位置検出装置34を有するものとし、位置検出装置34により内視鏡先端3Bの位置を検出しつつ、第1の深度画像D1と第2の深度画像D2との類似度を算出して、内視鏡先端3Bの位置を推定するようにしてもよい。

In the above embodiment, the

この場合、位置検出装置34は、被検体の体内における内視鏡先端3Bの位置および向きを検出する。具体的には、位置検出装置34は、被検体の特定部位の位置を基準とした3次元座標系の検出領域を有するエコー装置を有し、エコー装置により、内視鏡先端3Bの特徴的な形状を検出することによって、被検体の体内における内視鏡先端3Bの相対的な位置および向きを検出する。そして、検出した内視鏡先端3Bの位置および向きの情報を位置情報Q0として検査支援装置6に出力する(例えば、特開2006-61274号公報参照)。検出した内視鏡先端3Bの位置および向きは、撮影して得られた実内視鏡画像T0の視点および視線方向にそれぞれ該当する。ここで、内視鏡先端3Bの位置は、上述した被検体の特定部位の位置を基準とした3次元座標により表される。また、位置情報Q0は、実内視鏡画像T0と同様のサンプリングレートにより検査支援装置6に出力される。

In this case, the

このように、位置検出装置34を用いた場合、類似度算出部25は、位置情報Q0により表される気管支内の位置から予め定められた範囲A0内にある1以上の第2の深度画像D2と第1の深度画像D1との類似度を算出する。位置推定部26は、上記実施形態と同様に、範囲A0内におけるすべての第2の深度画像D2と第1の深度画像D1との類似度のうち、しきい値Th1以上となり、かつ最も類似度が大きい第2の深度画像D2に対応する仮想内視鏡画像K0を生成した位置を内視鏡先端3Bの位置であると推定する。この場合においても、上記実施形態と同様に第1の深度画像D1と第2の深度画像D2との画素値に基づいて位置ずれ量を求めて、推定した位置を修正するようにしてもよい。

As described above, when the

また、上記実施形態においては、類似度算出部25は、実内視鏡画像T0が取得される毎に、第1の深度画像D1と第2の深度画像D2との類似度を算出しているが、これに限定されるものではない。例えば、特開2016-163609号公報に記載された手法を用いて、実内視鏡画像T0に気管支の分岐構造が含まれるか否かを判定し、実内視鏡画像T0に気管支の分岐構造が含まれる場合にのみ、第1の深度画像D1を取得して、第1の深度画像D1と第2の深度画像D2との類似度を算出するようにしてもよい。

Further, in the above embodiment, the

また、上記実施形態においては、本開示の検査支援装置を気管支の観察に適用した場合について説明したが、これに限定されるものではなく、胃、大腸および血管等の管状構造物を内視鏡により観察する場合にも、本開示を適用できる。 Further, in the above embodiment, the case where the inspection support device of the present disclosure is applied to the observation of the bronchus has been described, but the present invention is not limited to this, and tubular structures such as stomach, large intestine and blood vessels are endoscopeed. The present disclosure can also be applied when observing by.

また、上記実施形態においては、第1の深度画像D1および第2の深度画像D2の画素値から位置ずれ量を算出して、内視鏡先端3Bの位置を修正しているが、これに限定されるものではない。位置推定部26は、類似度に基づいて推定した仮想内視鏡画像K0の視点位置を、そのまま内視鏡先端3Bの位置として推定してよい。

Further, in the above embodiment, the position shift amount is calculated from the pixel values of the first depth image D1 and the second depth image D2 to correct the position of the

また、上記実施形態においては、検査支援装置6が気管支画像生成部22および仮想内視鏡画像生成部23を備えているが、これに限定されるものではない。気管支画像生成部22および仮想内視鏡画像生成部23を検査支援装置6とは別個の装置として設けるようにしてもよい。この場合、気管支画像B0および仮想内視鏡画像K0は別個の装置から検査支援装置6に入力され、画像取得部21により取得される。

Further, in the above embodiment, the

また、上記実施形態においては、実内視鏡画像T0および仮想内視鏡画像K0の表現形式を深度画像の表現形式に変換しているが、これに限定されるものではない。例えばCG風の表現形式等、深度画像の表現形式以外の表現形式に、実内視鏡画像T0および仮想内視鏡画像K0を変換するようにしてもよい。 Further, in the above embodiment, the representation formats of the real endoscope image T0 and the virtual endoscope image K0 are converted into the representation format of the depth image, but the present invention is not limited to this. For example, the real endoscope image T0 and the virtual endoscope image K0 may be converted into an expression format other than the expression format of the depth image such as a CG-like expression format.

また、上記実施形態においては、第1の医用画像として実内視鏡画像を、第2の医用画像として仮想内視鏡画像を用いているが、これに限定されるものではない。第1の医用画像をCT画像とし、第2の医用画像をMRI画像とする等、第1の医用画像と第2の医用画像との表現形式が異なれば、任意の医用画像を用いることができる。 Further, in the above embodiment, the real endoscopic image is used as the first medical image and the virtual endoscopic image is used as the second medical image, but the present invention is not limited thereto. Any medical image can be used as long as the expression formats of the first medical image and the second medical image are different, such as the first medical image being a CT image and the second medical image being an MRI image. ..

また、上記実施形態においては、本開示による検査支援装置を、内視鏡検査を支援する装置に適用しているが、これに限定されるものではない。第1の表現形式の第1の医用画像、および第1の表現形式とは異なる第2の表現形式の第2の医用画像を取得する検査を支援する任意の装置に本開示を適用することができる。 Further, in the above embodiment, the inspection support device according to the present disclosure is applied to a device that supports endoscopy, but is not limited thereto. The present disclosure may be applied to any device that assists in an examination to obtain a first medical image in a first representation and a second medical image in a second representation that is different from the first representation. can.

また、上記実施形態において、例えば、画像取得部21、気管支画像生成部22、仮想内視鏡画像生成部23、変換部24、類似度算出部25、位置推定部26、および表示制御部27といった各種の処理を実行する処理部(processing unit)のハードウェア的な構造としては、次に示す各種のプロセッサ(processor)を用いることができる。上記各種のプロセッサには、上述したように、ソフトウェア(プログラム)を実行して各種の処理部として機能する汎用的なプロセッサであるCPUに加えて、FPGA(Field Programmable Gate Array)等の製造後に回路構成を変更可能なプロセッサであるプログラマブルロジックデバイス(Programmable Logic Device :PLD)、ASIC(Application Specific Integrated Circuit)等の特定の処理を実行させるために専用に設計された回路構成を有するプロセッサである専用電気回路等が含まれる。

Further, in the above embodiment, for example, an

1つの処理部は、これらの各種のプロセッサのうちの1つで構成されてもよいし、同種または異種の2つ以上のプロセッサの組み合わせ(例えば、複数のFPGAの組み合わせまたはCPUとFPGAとの組み合わせ)で構成されてもよい。また、複数の処理部を1つのプロセッサで構成してもよい。 One processing unit may be composed of one of these various processors, or a combination of two or more processors of the same type or different types (for example, a combination of a plurality of FPGAs or a combination of a CPU and an FPGA). ) May be configured. Further, a plurality of processing units may be configured by one processor.

複数の処理部を1つのプロセッサで構成する例としては、第1に、クライアントおよびサーバ等のコンピュータに代表されるように、1つ以上のCPUとソフトウェアとの組み合わせで1つのプロセッサを構成し、このプロセッサが複数の処理部として機能する形態がある。第2に、システムオンチップ(System On Chip:SoC)等に代表されるように、複数の処理部を含むシステム全体の機能を1つのIC(Integrated Circuit)チップで実現するプロセッサを使用する形態がある。このように、各種の処理部は、ハードウェア的な構造として、上記各種のプロセッサの1つ以上を用いて構成される。 As an example of configuring a plurality of processing units with one processor, first, as represented by a computer such as a client and a server, one processor is configured by a combination of one or more CPUs and software. There is a form in which this processor functions as a plurality of processing units. Second, as typified by System On Chip (SoC), there is a form that uses a processor that realizes the functions of the entire system including multiple processing units with one IC (Integrated Circuit) chip. be. As described above, the various processing units are configured by using one or more of the above-mentioned various processors as a hardware-like structure.

さらに、これらの各種のプロセッサのハードウェア的な構造としては、より具体的には、半導体素子等の回路素子を組み合わせた電気回路(circuitry)を用いることができる。 Further, as the hardware structure of these various processors, more specifically, an electric circuit (circuitry) in which circuit elements such as semiconductor elements are combined can be used.

3 内視鏡装置

3A 操作部

3B 内視鏡先端

4 3次元画像撮影装置

5 画像保管サーバ

6 検査支援装置

8 ネットワーク

11 CPU

12 メモリ

13 ストレージ

14 表示部

15 入力部

21 画像取得部

22 気管支画像生成部

23 仮想内視鏡画像生成部

24 変換部

25 類似度算出部

26 位置推定部

27 表示制御部

31 内視鏡スコープ

32 プロセッサ装置

40 経路

50 表示画像

51 移動軌跡

A0 範囲

B0 気管支画像

D1 第1の深度画像

D2 第2の深度画像

K0 仮想内視鏡画像

ΔL 位置ずれ量

P1 位置

Pb 基準位置

Pt 位置

R1,R2 領域

T0 実内視鏡画像

3

12

Claims (7)

学習されたニューラルネットワークを用いて、前記実内視鏡画像の前記実写風の表現形式を深度画像風の表現形式に変換することにより前記実内視鏡画像の視点からの前記管状構造物の内壁までの距離を表す第1の深度画像を取得し、前記仮想内視鏡画像の前記CG風の表現形式を前記深度画像風の表現形式に変換することにより前記仮想内視鏡画像の視点からの前記管状構造物の内壁までの距離を表す第2の深度画像を取得する変換部と、

前記第1の深度画像と前記第2の深度画像との類似度を算出する類似度算出部とを備えた検査支援装置。 A real endoscopic image having a live-like representation of the inner wall of the tubular structure, generated by an endoscope inserted into the tubular structure in the subject, and the tubular structure of the subject. An image acquisition unit that acquires a virtual endoscopic image having a CG-like expression format that pseudo-represents the inner wall of the tubular structure, which is generated from a three-dimensional image including the image.

The inner wall of the tubular structure from the viewpoint of the real endoscope image by converting the expression form of the live-viewing style of the real endoscopic image into the expression format of the depth image-like using the trained neural network. By acquiring a first depth image representing the distance to and converting the CG-like expression format of the virtual endoscope image into the depth image-like expression format, the virtual endoscope image is viewed from the viewpoint. A conversion unit that acquires a second depth image showing the distance to the inner wall of the tubular structure, and

An inspection support device including a similarity calculation unit for calculating the similarity between the first depth image and the second depth image.

学習されたニューラルネットワークを用いて、前記実内視鏡画像の前記実写風の表現形式を深度画像風の表現形式に変換することにより前記実内視鏡画像の視点からの前記管状構造物の内壁までの距離を表す第1の深度画像を取得し、前記仮想内視鏡画像の前記CG風の表現形式を前記深度画像風の表現形式に変換することにより前記仮想内視鏡画像の視点からの前記管状構造物の内壁までの距離を表す第2の深度画像を取得し、

前記第1の深度画像と前記第2の深度画像との類似度を算出する検査支援方法。 A real endoscopic image having a live-like representation of the inner wall of the tubular structure generated by a computer inserted into the tubular structure in the subject, and the tubular of the subject. A virtual endoscopic image having a CG-like expression format that pseudo-represents the inner wall of the tubular structure, which is generated from a three-dimensional image including the structure, is acquired.

The inner wall of the tubular structure from the viewpoint of the real endoscopic image by converting the real-life representation of the real endoscopic image into a depth image-like representation using the trained neural network. By acquiring a first depth image representing the distance to and converting the CG-like expression format of the virtual endoscope image into the depth image-like expression format, the virtual endoscope image is viewed from the viewpoint. A second depth image showing the distance to the inner wall of the tubular structure was obtained.

An inspection support method for calculating the degree of similarity between the first depth image and the second depth image.

学習されたニューラルネットワークを用いて、前記実内視鏡画像の前記実写風の表現形式を深度画像風の表現形式に変換することにより前記実内視鏡画像の視点からの前記管状構造物の内壁までの距離を表す第1の深度画像を取得し、前記仮想内視鏡画像の前記CG風の表現形式を前記深度画像風の表現形式に変換することにより前記仮想内視鏡画像の視点からの前記管状構造物の内壁までの距離を表す第2の深度画像を取得する手順と、

前記第1の深度画像と前記第2の深度画像との類似度を算出する手順とをコンピュータに実行させる検査支援プログラム。 A real endoscopic image having a live-like representation of the inner wall of the tubular structure, generated by an endoscope inserted into the tubular structure in the subject, and the tubular structure of the subject. A procedure for acquiring a virtual endoscopic image having a CG-like representation format that pseudo-represents the inner wall of the tubular structure, which is generated from the including three-dimensional image.

The inner wall of the tubular structure from the viewpoint of the real endoscopic image by converting the real-life representation of the real endoscopic image into a depth image-like representation using the trained neural network. By acquiring a first depth image representing the distance to and converting the CG-like expression format of the virtual endoscope image into the depth image-like expression format, the virtual endoscope image is viewed from the viewpoint. A procedure for acquiring a second depth image showing the distance to the inner wall of the tubular structure, and

An inspection support program that causes a computer to execute a procedure for calculating the degree of similarity between the first depth image and the second depth image.

Priority Applications (2)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2018140044A JP7071240B2 (en) | 2018-07-26 | 2018-07-26 | Inspection support equipment, methods and programs |

| US16/453,701 US10939800B2 (en) | 2018-07-26 | 2019-06-26 | Examination support device, examination support method, and examination support program |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2018140044A JP7071240B2 (en) | 2018-07-26 | 2018-07-26 | Inspection support equipment, methods and programs |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2020014711A JP2020014711A (en) | 2020-01-30 |

| JP2020014711A5 JP2020014711A5 (en) | 2020-09-24 |

| JP7071240B2 true JP7071240B2 (en) | 2022-05-18 |

Family

ID=69179480

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2018140044A Active JP7071240B2 (en) | 2018-07-26 | 2018-07-26 | Inspection support equipment, methods and programs |

Country Status (2)

| Country | Link |

|---|---|

| US (1) | US10939800B2 (en) |

| JP (1) | JP7071240B2 (en) |

Families Citing this family (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| CN113544743B (en) * | 2019-09-20 | 2024-03-12 | Hoya株式会社 | Endoscope processor, program, information processing method, and information processing device |

| JPWO2022009285A1 (en) * | 2020-07-06 | 2022-01-13 | ||

| JPWO2022202400A1 (en) * | 2021-03-22 | 2022-09-29 | ||

| WO2022202520A1 (en) * | 2021-03-26 | 2022-09-29 | 富士フイルム株式会社 | Medical information processing device, endoscope system, medical information processing method, and medical information processing program |

Citations (5)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2003265408A (en) | 2002-03-19 | 2003-09-24 | Mitsubishi Electric Corp | Endoscope guide device and method |

| US20080071143A1 (en) | 2006-09-18 | 2008-03-20 | Abhishek Gattani | Multi-dimensional navigation of endoscopic video |

| JP2011000173A (en) | 2009-06-16 | 2011-01-06 | Toshiba Corp | Endoscopic examination supporting system |

| JP2012050606A (en) | 2010-08-31 | 2012-03-15 | Fujifilm Corp | Endoscopic image processing device, method and program |

| WO2012108085A1 (en) | 2011-02-08 | 2012-08-16 | オリンパスメディカルシステムズ株式会社 | Medical device |

Family Cites Families (2)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP5718537B2 (en) | 2013-03-12 | 2015-05-13 | オリンパスメディカルシステムズ株式会社 | Endoscope system |

| JP7023195B2 (en) * | 2018-07-13 | 2022-02-21 | 富士フイルム株式会社 | Inspection support equipment, methods and programs |

-

2018

- 2018-07-26 JP JP2018140044A patent/JP7071240B2/en active Active

-

2019

- 2019-06-26 US US16/453,701 patent/US10939800B2/en active Active

Patent Citations (5)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2003265408A (en) | 2002-03-19 | 2003-09-24 | Mitsubishi Electric Corp | Endoscope guide device and method |

| US20080071143A1 (en) | 2006-09-18 | 2008-03-20 | Abhishek Gattani | Multi-dimensional navigation of endoscopic video |

| JP2011000173A (en) | 2009-06-16 | 2011-01-06 | Toshiba Corp | Endoscopic examination supporting system |

| JP2012050606A (en) | 2010-08-31 | 2012-03-15 | Fujifilm Corp | Endoscopic image processing device, method and program |

| WO2012108085A1 (en) | 2011-02-08 | 2012-08-16 | オリンパスメディカルシステムズ株式会社 | Medical device |

Also Published As

| Publication number | Publication date |

|---|---|

| JP2020014711A (en) | 2020-01-30 |

| US10939800B2 (en) | 2021-03-09 |

| US20200029789A1 (en) | 2020-01-30 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP6348078B2 (en) | Branch structure determination apparatus, operation method of branch structure determination apparatus, and branch structure determination program | |

| JP6371729B2 (en) | Endoscopy support apparatus, operation method of endoscopy support apparatus, and endoscope support program | |

| JP6594133B2 (en) | Endoscope position specifying device, operation method of endoscope position specifying device, and endoscope position specifying program | |

| JP6254053B2 (en) | Endoscopic image diagnosis support apparatus, system and program, and operation method of endoscopic image diagnosis support apparatus | |

| JP7071240B2 (en) | Inspection support equipment, methods and programs | |

| US20110242301A1 (en) | Image processing device, image processing method, and program | |

| JP7023196B2 (en) | Inspection support equipment, methods and programs | |

| US9396576B2 (en) | Method and apparatus for estimating the three-dimensional shape of an object | |

| JP6824078B2 (en) | Endoscope positioning device, method and program | |

| JP7023195B2 (en) | Inspection support equipment, methods and programs | |

| JP6199267B2 (en) | Endoscopic image display device, operating method thereof, and program | |

| JP6745748B2 (en) | Endoscope position specifying device, its operating method and program | |

| WO2024195100A1 (en) | Endoscopy assistance device, endoscopy assistance method, and recording medium | |

| US20230081476A1 (en) | Method of multiple image reconstruction and registration | |

| US20230078857A1 (en) | Method of robust surface and depth estimation | |

| US20240324849A1 (en) | Information processing apparatus, information processing method, and information processing program | |

| US20240324848A1 (en) | Information processing apparatus, information processing method, and information processing program |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20200812 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20200812 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20210721 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20210810 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20211005 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20220111 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20220209 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20220412 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20220506 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 7071240 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 |