JP6912481B2 - 画像ベースのロボット誘導 - Google Patents

画像ベースのロボット誘導 Download PDFInfo

- Publication number

- JP6912481B2 JP6912481B2 JP2018533939A JP2018533939A JP6912481B2 JP 6912481 B2 JP6912481 B2 JP 6912481B2 JP 2018533939 A JP2018533939 A JP 2018533939A JP 2018533939 A JP2018533939 A JP 2018533939A JP 6912481 B2 JP6912481 B2 JP 6912481B2

- Authority

- JP

- Japan

- Prior art keywords

- robot

- end effector

- image

- planned

- reference object

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

Images

Classifications

-

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61B—DIAGNOSIS; SURGERY; IDENTIFICATION

- A61B34/00—Computer-aided surgery; Manipulators or robots specially adapted for use in surgery

- A61B34/10—Computer-aided planning, simulation or modelling of surgical operations

-

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61B—DIAGNOSIS; SURGERY; IDENTIFICATION

- A61B34/00—Computer-aided surgery; Manipulators or robots specially adapted for use in surgery

- A61B34/30—Surgical robots

-

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61B—DIAGNOSIS; SURGERY; IDENTIFICATION

- A61B34/00—Computer-aided surgery; Manipulators or robots specially adapted for use in surgery

- A61B34/20—Surgical navigation systems; Devices for tracking or guiding surgical instruments, e.g. for frameless stereotaxis

-

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61B—DIAGNOSIS; SURGERY; IDENTIFICATION

- A61B34/00—Computer-aided surgery; Manipulators or robots specially adapted for use in surgery

- A61B34/30—Surgical robots

- A61B34/32—Surgical robots operating autonomously

-

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61B—DIAGNOSIS; SURGERY; IDENTIFICATION

- A61B34/00—Computer-aided surgery; Manipulators or robots specially adapted for use in surgery

- A61B34/30—Surgical robots

- A61B34/35—Surgical robots for telesurgery

-

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61B—DIAGNOSIS; SURGERY; IDENTIFICATION

- A61B34/00—Computer-aided surgery; Manipulators or robots specially adapted for use in surgery

- A61B34/30—Surgical robots

- A61B34/37—Master-slave robots

-

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61B—DIAGNOSIS; SURGERY; IDENTIFICATION

- A61B90/00—Instruments, implements or accessories specially adapted for surgery or diagnosis and not covered by any of the groups A61B1/00 - A61B50/00, e.g. for luxation treatment or for protecting wound edges

- A61B90/10—Instruments, implements or accessories specially adapted for surgery or diagnosis and not covered by any of the groups A61B1/00 - A61B50/00, e.g. for luxation treatment or for protecting wound edges for stereotaxic surgery, e.g. frame-based stereotaxis

- A61B90/11—Instruments, implements or accessories specially adapted for surgery or diagnosis and not covered by any of the groups A61B1/00 - A61B50/00, e.g. for luxation treatment or for protecting wound edges for stereotaxic surgery, e.g. frame-based stereotaxis with guides for needles or instruments, e.g. arcuate slides or ball joints

- A61B90/13—Instruments, implements or accessories specially adapted for surgery or diagnosis and not covered by any of the groups A61B1/00 - A61B50/00, e.g. for luxation treatment or for protecting wound edges for stereotaxic surgery, e.g. frame-based stereotaxis with guides for needles or instruments, e.g. arcuate slides or ball joints guided by light, e.g. laser pointers

-

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61B—DIAGNOSIS; SURGERY; IDENTIFICATION

- A61B34/00—Computer-aided surgery; Manipulators or robots specially adapted for use in surgery

- A61B34/10—Computer-aided planning, simulation or modelling of surgical operations

- A61B2034/107—Visualisation of planned trajectories or target regions

-

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61B—DIAGNOSIS; SURGERY; IDENTIFICATION

- A61B34/00—Computer-aided surgery; Manipulators or robots specially adapted for use in surgery

- A61B34/20—Surgical navigation systems; Devices for tracking or guiding surgical instruments, e.g. for frameless stereotaxis

- A61B2034/2046—Tracking techniques

- A61B2034/2055—Optical tracking systems

Landscapes

- Health & Medical Sciences (AREA)

- Engineering & Computer Science (AREA)

- Life Sciences & Earth Sciences (AREA)

- Surgery (AREA)

- Robotics (AREA)

- Medical Informatics (AREA)

- Public Health (AREA)

- Heart & Thoracic Surgery (AREA)

- Nuclear Medicine, Radiotherapy & Molecular Imaging (AREA)

- Molecular Biology (AREA)

- Animal Behavior & Ethology (AREA)

- General Health & Medical Sciences (AREA)

- Biomedical Technology (AREA)

- Veterinary Medicine (AREA)

- Physics & Mathematics (AREA)

- Optics & Photonics (AREA)

- Oral & Maxillofacial Surgery (AREA)

- Pathology (AREA)

- Manipulator (AREA)

Description

Claims (20)

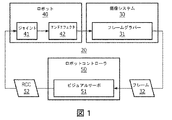

- 2つのモータ軸を有する遠隔運動中心(RCM:remote center of motion)機構とロボットの遠位端部に設けられたエンドエフェクタとを有する当該ロボットと、

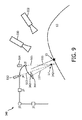

前記RCMで交差する2つ以上の光ビームを投影する光投影装置と、

予定進入ポイントと前記RCMを通る予定パスとを含む手術フィールドにおける前記RCM機構の画像を撮影する撮像システムと、

前記ロボットを制御し、前記RCM機構を位置決めするロボットコントローラであって、前記撮像システムから撮影された画像を受信し、前記撮影された画像を3次元的手術前画像に対してレジストレーションし、投影された光ビームを使用して前記撮影された画像において前記RCMに対する進入ポイント及びパスを定め、前記撮影された画像において、前記エンドエフェクタと関連付けられる、既知の形状を有する基準オブジェクトを検知及び追跡する画像プロセッサを含む前記ロボットコントローラと、を含み、

前記ロボットコントローラは、前記エンドエフェクタを前記予定進入ポイント及び前記予定パスに対して位置合わせするロボットジョイント運動パラメータを、定められた進入ポイント、定められたパス、及び検知された基準オブジェクトに応じて計算し、計算されたロボットジョイント運動パラメータに基づいて、前記エンドエフェクタを前記予定進入ポイント及び前記予定パスに対して位置合わせするロボット制御コマンドを生成し、前記ロボット制御コマンドを前記ロボットに通信し、

前記ロボットコントローラは、前記撮影された画像における前記基準オブジェクトの1つ又は複数の幾何学的パラメータを決定し、前記基準オブジェクトが当該基準オブジェクトの予定位置に位置付けられるときに前記撮像システムに現れるように、前記撮影された画像における前記基準オブジェクトの前記1つ又は複数の幾何学的パラメータを、既知の対応する前記基準オブジェクトの1つ又は複数の幾何学的パラメータに対して位置合わせすることによって、前記ロボットジョイント運動パラメータを計算する、システム。 - 前記画像プロセッサは、前記投影された光ビームの交差点として前記進入ポイントを検知し、前記ロボットコントローラは、前記投影された光ビームの交差点が前記予定進入ポイントに対して位置合わせされるように前記ロボットを制御する、請求項1に記載のシステム。

- 前記画像プロセッサは、前記予定位置における前記基準オブジェクトの既知の形状を前記撮影された画像上に投影し、前記ロボットコントローラは、撮影された画像における前記検知された基準オブジェクトが投影された既知の形状と重畳するように前記ロボットを制御する、請求項1に記載のシステム。

- 前記撮像システムは、既知の構成において離間された複数のカメラから、手術フィールドにおける前記RCM機構の2次元的(2D)画像を撮影し、前記画像プロセッサは、前記複数のカメラの各々からの撮影された2D画像における既知の形状を有する前記基準オブジェクトを検知及び追跡し、前記撮影された2D画像から前記基準オブジェクトの3次元的(3D)形状を再構成する、請求項1に記載のシステム。

- 前記RCM機構は、前記予定進入ポイントを通る挿入軸の周りで前記エンドエフェクタを回転し、前記エンドエフェクタは、前記挿入軸に垂直な平面内でその向きを定める特徴を有し、前記画像プロセッサは、前記撮影された画像において前記特徴を検知し、前記特徴の予定位置を撮影された画像上に投影し、前記ロボットコントローラは、検知された前記特徴と前記予定位置とが位置合わせされるように前記ロボットを制御する、請求項1に記載のシステム。

- 前記基準オブジェクトは前記エンドエフェクタである、請求項1に記載のシステム。

- 前記撮像システムは、カメラと、前記カメラを移動させるためのアクチュエータとを含み、前記カメラは前記アクチュエータによって前記予定パスに沿って位置決めされ、前記ロボットコントローラは、前記画像プロセッサが前記エンドエフェクタの平行投影を検知するように前記エンドエフェクタの位置を制御する、請求項4に記載のシステム。

- 前記撮像システムは、前記予定パスの回転3次元的スキャンを生成するX線システムを含む、請求項1に記載のシステム。

- 遠位端部にエンドエフェクタを有するロボットの遠隔運動中心(RCM:remote center of motion)機構によって定められるRCMにおいて交差する少なくとも2つの光ビームを提供するステップと、

予定進入ポイントと前記RCMを通る予定パスとを含む手術フィールドにおける前記RCM機構の画像を撮影するステップと、

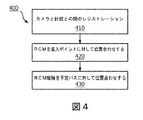

撮影された前記画像を3次元的(3D)手術前画像に対してレジストレーションするステップと、

投影された光ビームを使用して前記撮影された画像において前記RCMのための進入ポイント及びパスを定めるステップと、

前記撮影された画像において、前記エンドエフェクタと関連付けられる、既知の形状を有する基準オブジェクトを検知及び追跡するステップと、

前記進入ポイント、前記パス、及び前記基準オブジェクトについての情報に応じて、前記エンドエフェクタを前記予定進入ポイント及び前記予定パスに対して位置合わせするロボットジョイント運動パラメータを計算するステップと、

計算された前記ロボットジョイント運動パラメータに基づいて、前記エンドエフェクタを前記予定進入ポイント及び前記予定パスに対して位置合わせするロボット制御コマンドをロボットに通信するステップと、を有する、方法であって、

前記ロボットジョイント運動パラメータを計算するステップは、前記撮影された画像における前記基準オブジェクトの1つ又は複数の幾何学的パラメータを決定し、前記基準オブジェクトが当該基準オブジェクトの予定位置に位置付けられるときに撮像システムに現れるように、前記撮影された画像における前記基準オブジェクトの前記1つ又は複数の幾何学的パラメータを、既知の対応する前記基準オブジェクトの1つ又は複数の幾何学的パラメータに対して位置合わせするステップを含む、方法。 - 前記投影された光ビームの交差点として前記進入ポイントを検知するステップと、前記投影された光ビームの交差点が前記予定進入ポイントに対して位置合わせされるように前記ロボットを制御するステップと、

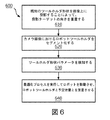

を有する、請求項9に記載の方法。 - 前記予定位置における前記基準オブジェクトの前記既知の形状を前記撮影された画像上に投影するステップと、

前記撮影された画像における検知された前記基準オブジェクトが投影された既知の形状と重畳するよう前記にロボットを制御するステップと、

を有する、請求項9に記載の方法。 - 既知の構成において離間された複数のカメラから、前記手術フィールドにおける前記RCM機構の2次元的(2D)画像を撮影するステップと、

前記複数のカメラの各々から撮影された2D画像における既知の形状を有する前記基準オブジェクトを検知及び追跡するステップと、

前記撮影された2D画像から前記基準オブジェクトの3D形状を再構成するステップと、

を有する、請求項9に記載の方法。 - 前記予定進入ポイントを通る挿入軸の周りで前記エンドエフェクタを回転させるステップであって、前記エンドエフェクタは、前記挿入軸に垂直な平面内でその向きを定めるような特徴を有する、ステップと、

前記撮影された画像において前記特徴を検知するステップと、

前記特徴の予定位置を撮影された画像上に投影するステップと、

検知された前記特徴と予定位置とが位置合わせされるように前記ロボットを制御するステップと、

を有する、請求項9に記載の方法。 - 前記予定パスに沿って位置決めされたカメラを使用して前記RCM機構の画像を撮影するステップであって、前記基準オブジェクトは前記エンドエフェクタである、ステップと、

前記撮影された画像において前記エンドエフェクタの平行投影が検知されるように前記エンドエフェクタの位置を制御するステップと、を有する、請求項9に記載の方法。 - 2つのモータ軸を有する遠隔運動中心(RCM:remote center of motion)機構及び遠位端部に設けられたエンドエフェクタを有するロボットを制御するためのロボットコントローラであって、

前記ロボットコントローラは、前記RCMで交差する2つ以上の光ビームを投影して撮影された画像であって、予定進入ポイント及びRCMを通る予定パスを含む手術フィールドにおける前記RCM機構の撮影された画像を受信し、前記撮影された画像を3次元的(3D)手術前画像に対してレジストレーションし、前記撮影された画像において前記RCMに対する進入ポイント及びパスを定め、前記撮影された画像において、前記エンドエフェクタと関連付けられる、既知の形状を有する基準オブジェクトを検知及び追跡する画像プロセッサと、ロボット制御コマンドを前記ロボットに通信するロボット制御コマンドインターフェースと、を備え、

前記ロボットコントローラは、前記エンドエフェクタを前記予定進入ポイント及び前記予定パスに対して位置合わせするロボットジョイント運動パラメータを、定められた前記進入ポイント、定められたパス、及び検知された前記基準オブジェクトに応じて計算する計算されたロボットジョイント運動パラメータに基づいて、前記エンドエフェクタを前記予定進入ポイント及び前記予定パスに対して位置合わせするロボット制御コマンドを生成し、

前記ロボットコントローラは、前記撮影された画像における前記基準オブジェクトの1つ又は複数の幾何学的パラメータを決定し、前記基準オブジェクトが当該基準オブジェクトの予定位置に位置付けられるときに撮像システムに現れるように、前記撮影された画像における前記基準オブジェクトの前記1つ又は複数の幾何学的パラメータを、既知の対応する前記基準オブジェクトの1つ又は複数の幾何学的パラメータに対して位置合わせすることによって、前記ロボットジョイント運動パラメータを計算する、ロボットコントローラ。 - 前記画像プロセッサは、投影された光ビームの交差点として前記進入ポイントを検知し、前記ロボットコントローラは、前記投影された光ビームの交差点が前記予定進入ポイントに対して位置合わせされるように前記ロボットを制御する、請求項15に記載のロボットコントローラ。

- 前記画像プロセッサは、前記予定位置における前記基準オブジェクトの既知の形状を前記撮影された画像上に投影し、前記ロボットコントローラは、前記撮影された画像における検知された前記基準オブジェクトが投影された既知の形状と重畳するように前記ロボットを制御する、請求項15に記載のロボットコントローラ。

- 前記画像プロセッサは、既知の構成において離間された複数のカメラから、前記手術フィールドにおける前記RCM機構の2次元的(2D)画像を受信し、前記複数のカメラの各々からの撮影された2D画像における既知の形状を有する前記基準オブジェクトを検知及び追跡し、撮影された2D画像から前記基準オブジェクトの3D形状を再構成する、請求項15に記載のロボットコントローラ。

- 前記RCM機構は、前記予定進入ポイントを通る挿入軸の周りで前記エンドエフェクタを回転し、前記エンドエフェクタは、前記挿入軸に垂直な平面内でその向きを定めるような特徴を有し、前記画像プロセッサは、前記撮影された画像において前記特徴を検知し、前記特徴の予定位置を撮影された画像上に投影し、前記ロボットコントローラは、検知された前記特徴と予定位置とが位置合わせされるように前記ロボットを制御する、請求項15に記載のロボットコントローラ。

- 前記ロボットコントローラは、アクチュエータによって予定パスに沿って位置決めされたカメラからの前記撮影された画像を受信し、前記ロボットコントローラは、前記画像プロセッサが前記エンドエフェクタの平行投影を検知するように前記エンドエフェクタの位置を制御する、請求項15に記載のロボットコントローラ。

Applications Claiming Priority (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| US201562272737P | 2015-12-30 | 2015-12-30 | |

| US62/272,737 | 2015-12-30 | ||

| PCT/IB2016/057863 WO2017115227A1 (en) | 2015-12-30 | 2016-12-21 | Image based robot guidance |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2019502462A JP2019502462A (ja) | 2019-01-31 |

| JP2019502462A5 JP2019502462A5 (ja) | 2020-02-06 |

| JP6912481B2 true JP6912481B2 (ja) | 2021-08-04 |

Family

ID=57838433

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2018533939A Active JP6912481B2 (ja) | 2015-12-30 | 2016-12-21 | 画像ベースのロボット誘導 |

Country Status (5)

| Country | Link |

|---|---|

| US (1) | US20200261155A1 (ja) |

| EP (1) | EP3397187A1 (ja) |

| JP (1) | JP6912481B2 (ja) |

| CN (1) | CN108601626A (ja) |

| WO (1) | WO2017115227A1 (ja) |

Families Citing this family (17)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US11033341B2 (en) | 2017-05-10 | 2021-06-15 | Mako Surgical Corp. | Robotic spine surgery system and methods |

| EP4344658A3 (en) | 2017-05-10 | 2024-07-03 | MAKO Surgical Corp. | Robotic spine surgery system |

| US11432877B2 (en) * | 2017-08-02 | 2022-09-06 | Medtech S.A. | Surgical field camera system that only uses images from cameras with an unobstructed sight line for tracking |

| CN111699077B (zh) | 2018-02-01 | 2024-01-23 | Abb瑞士股份有限公司 | 用于机器人的基于视觉的操作 |

| CN109223176B (zh) * | 2018-10-26 | 2021-06-25 | 中南大学湘雅三医院 | 一种手术规划系统 |

| EP3930615A1 (en) * | 2019-02-28 | 2022-01-05 | Koninklijke Philips N.V. | Feedforward continuous positioning control of end-effectors |

| EP3824839A1 (en) * | 2019-11-19 | 2021-05-26 | Koninklijke Philips N.V. | Robotic positioning of a device |

| KR102278149B1 (ko) * | 2020-01-08 | 2021-07-16 | 최홍희 | 의료용 다목적 레이저 포인팅장치 |

| RU2753118C2 (ru) * | 2020-01-09 | 2021-08-11 | Федеральное государственное автономное образовательное учреждение высшего образования "Севастопольский государственный университет" | Роботизированная система для удержания и перемещения хирургического инструмента при проведении лапароскопических операций |

| US20230139402A1 (en) * | 2020-02-24 | 2023-05-04 | Intuitive Surgical Operations, Inc. | Systems and methods for registration feature integrity checking |

| JP7459234B2 (ja) * | 2020-04-10 | 2024-04-01 | 川崎重工業株式会社 | 医療用移動体システム及びその運転方法 |

| CN112932669B (zh) * | 2021-01-18 | 2024-03-15 | 广州市微眸医疗器械有限公司 | 一种执行视网膜层防渗漏隧道的机械臂控制方法 |

| US20230100638A1 (en) * | 2021-02-05 | 2023-03-30 | Shenzhen Institutes Of Advanced Technology Chinese Academy Of Sciences | Soft-bodied apparatus and method for opening eyelid |

| CN113687627B (zh) * | 2021-08-18 | 2022-08-19 | 太仓中科信息技术研究院 | 一种基于摄像机器人的目标跟踪方法 |

| CN113766083B (zh) * | 2021-09-09 | 2024-05-14 | 思看科技(杭州)股份有限公司 | 跟踪式扫描系统的参数配置方法、电子装置和存储介质 |

| CN115192092B (zh) * | 2022-07-04 | 2024-06-25 | 合肥工业大学 | 面向体内柔性动态环境的机器人自主活检取样方法 |

| CN117103286B (zh) * | 2023-10-25 | 2024-03-19 | 杭州汇萃智能科技有限公司 | 一种机械手手眼标定方法、系统和可读存储介质 |

Family Cites Families (13)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US6187018B1 (en) * | 1999-10-27 | 2001-02-13 | Z-Kat, Inc. | Auto positioner |

| US7008373B2 (en) * | 2001-11-08 | 2006-03-07 | The Johns Hopkins University | System and method for robot targeting under fluoroscopy based on image servoing |

| WO2008152542A2 (en) * | 2007-06-12 | 2008-12-18 | Koninklijke Philips Electronics N.V. | Image guided therapy |

| US20110071541A1 (en) * | 2009-09-23 | 2011-03-24 | Intuitive Surgical, Inc. | Curved cannula |

| JP5814938B2 (ja) | 2010-01-08 | 2015-11-17 | コーニンクレッカ フィリップス エヌ ヴェKoninklijke Philips N.V. | リアルタイム速度最適化を使用した校正不要のビジュアルサーボ |

| CN102711650B (zh) | 2010-01-13 | 2015-04-01 | 皇家飞利浦电子股份有限公司 | 用于内窥镜手术的基于图像整合的配准和导航 |

| DE102010029275A1 (de) * | 2010-05-25 | 2011-12-01 | Siemens Aktiengesellschaft | Verfahren zum Bewegen eines Instrumentenarms eines Laparoskopierobotors in einer vorgebbare Relativlage zu einem Trokar |

| BR112013005879A2 (pt) | 2010-09-15 | 2016-05-10 | Konink Philps Electronics Nv | ''sistema de orientação de robôs, unidades de controle para um endoscópio e método de orientação de robôs'' |

| KR20140090374A (ko) * | 2013-01-08 | 2014-07-17 | 삼성전자주식회사 | 싱글 포트 수술 로봇 및 그 제어 방법 |

| GB201303917D0 (en) * | 2013-03-05 | 2013-04-17 | Ezono Ag | System for image guided procedure |

| US10130433B2 (en) * | 2014-02-04 | 2018-11-20 | Koninklijke Philips N.V. | Remote center of motion definition using light sources for robot systems |

| KR102237597B1 (ko) * | 2014-02-18 | 2021-04-07 | 삼성전자주식회사 | 수술 로봇용 마스터 장치 및 그 제어 방법 |

| DE102014209368A1 (de) * | 2014-05-16 | 2015-11-19 | Siemens Aktiengesellschaft | Magnetresonanztomographie-System und Verfahren zur Unterstützung einer Person bei der Positionierung eines medizinischen Instruments für eine perkutane Intervention |

-

2016

- 2016-12-21 WO PCT/IB2016/057863 patent/WO2017115227A1/en active Application Filing

- 2016-12-21 CN CN201680080556.3A patent/CN108601626A/zh active Pending

- 2016-12-21 EP EP16828779.5A patent/EP3397187A1/en not_active Withdrawn

- 2016-12-21 JP JP2018533939A patent/JP6912481B2/ja active Active

- 2016-12-21 US US16/066,079 patent/US20200261155A1/en not_active Abandoned

Also Published As

| Publication number | Publication date |

|---|---|

| WO2017115227A1 (en) | 2017-07-06 |

| CN108601626A (zh) | 2018-09-28 |

| JP2019502462A (ja) | 2019-01-31 |

| EP3397187A1 (en) | 2018-11-07 |

| US20200261155A1 (en) | 2020-08-20 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP6912481B2 (ja) | 画像ベースのロボット誘導 | |

| CN109069217B (zh) | 图像引导外科手术中的姿势估计以及透视成像系统的校准的系统和方法 | |

| CN110051436B (zh) | 自动化协同工作组件及其在手术器械中的应用 | |

| US8971597B2 (en) | Efficient vision and kinematic data fusion for robotic surgical instruments and other applications | |

| US9066737B2 (en) | Method for moving an instrument arm of a laparoscopy robot into a predeterminable relative position with respect to a trocar | |

| US20230000565A1 (en) | Systems and methods for autonomous suturing | |

| JP2018110873A (ja) | 画像キャプチャ装置及び操作可能な装置可動アームの制御された動作の間の衝突回避 | |

| Zhang et al. | Autonomous scanning for endomicroscopic mosaicing and 3D fusion | |

| KR20080027256A (ko) | 최소침습 로봇수술 동안 센서 및/또는 카메라로부터 도출된데이터와의 융합에 의한 3차원 툴 추적을 수행하기 위한방법 및 시스템 | |

| Zhan et al. | Autonomous tissue scanning under free-form motion for intraoperative tissue characterisation | |

| KR20240021747A (ko) | 초음파 안내식 바늘 배치를 위한 의료용 로봇 | |

| Molnár et al. | Visual servoing-based camera control for the da Vinci Surgical System | |

| Marmol et al. | ArthroSLAM: Multi-sensor robust visual localization for minimally invasive orthopedic surgery | |

| Wang et al. | Robot-assisted occlusion avoidance for surgical instrument optical tracking system | |

| Heunis et al. | Collaborative surgical robots: Optical tracking during endovascular operations | |

| Nageotte et al. | Visual servoing-based endoscopic path following for robot-assisted laparoscopic surgery | |

| US20220241032A1 (en) | Multi-arm robotic systems and methods for identifying a target | |

| Vrooijink et al. | A preliminary study on using a robotically-actuated delivery sheath (rads) for transapical aortic valve implantation | |

| Piccinelli et al. | Rigid 3D registration of pre-operative information for semi-autonomous surgery | |

| Vitrani et al. | Robust ultrasound-based visual servoing for beating heart intracardiac surgery | |

| Krupa et al. | Autonomous retrieval and positioning of surgical instruments in robotized laparoscopic surgery using visual servoing and laser pointers | |

| Wang et al. | Image-based trajectory tracking control of 4-DOF laparoscopic instruments using a rotation distinguishing marker | |

| EP4284287A1 (en) | Multi-arm robotic systems for identifying a target | |

| US11596567B2 (en) | Systems and methods for determining and maintaining a center of rotation | |

| US20220323157A1 (en) | System and method related to registration for a medical procedure |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Written amendment |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20191219 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20191219 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20201228 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20210222 |

|

| A521 | Written amendment |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20210518 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20210609 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20210708 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 6912481 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 |