JP6842395B2 - ニューラルネットワークにトレーニングデータを提供するための画像解析アルゴリズムの使用 - Google Patents

ニューラルネットワークにトレーニングデータを提供するための画像解析アルゴリズムの使用 Download PDFInfo

- Publication number

- JP6842395B2 JP6842395B2 JP2017182561A JP2017182561A JP6842395B2 JP 6842395 B2 JP6842395 B2 JP 6842395B2 JP 2017182561 A JP2017182561 A JP 2017182561A JP 2017182561 A JP2017182561 A JP 2017182561A JP 6842395 B2 JP6842395 B2 JP 6842395B2

- Authority

- JP

- Japan

- Prior art keywords

- image

- digital

- training

- images

- relevance

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06N—COMPUTING ARRANGEMENTS BASED ON SPECIFIC COMPUTATIONAL MODELS

- G06N3/00—Computing arrangements based on biological models

- G06N3/02—Neural networks

- G06N3/08—Learning methods

- G06N3/084—Backpropagation, e.g. using gradient descent

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/0002—Inspection of images, e.g. flaw detection

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F18/00—Pattern recognition

- G06F18/20—Analysing

- G06F18/24—Classification techniques

- G06F18/241—Classification techniques relating to the classification model, e.g. parametric or non-parametric approaches

- G06F18/2413—Classification techniques relating to the classification model, e.g. parametric or non-parametric approaches based on distances to training or reference patterns

- G06F18/24133—Distances to prototypes

- G06F18/24137—Distances to cluster centroïds

- G06F18/2414—Smoothing the distance, e.g. radial basis function networks [RBFN]

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06N—COMPUTING ARRANGEMENTS BASED ON SPECIFIC COMPUTATIONAL MODELS

- G06N3/00—Computing arrangements based on biological models

- G06N3/02—Neural networks

- G06N3/04—Architecture, e.g. interconnection topology

- G06N3/045—Combinations of networks

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06N—COMPUTING ARRANGEMENTS BASED ON SPECIFIC COMPUTATIONAL MODELS

- G06N3/00—Computing arrangements based on biological models

- G06N3/02—Neural networks

- G06N3/04—Architecture, e.g. interconnection topology

- G06N3/0464—Convolutional networks [CNN, ConvNet]

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06N—COMPUTING ARRANGEMENTS BASED ON SPECIFIC COMPUTATIONAL MODELS

- G06N3/00—Computing arrangements based on biological models

- G06N3/02—Neural networks

- G06N3/08—Learning methods

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T1/00—General purpose image data processing

- G06T1/20—Processor architectures; Processor configuration, e.g. pipelining

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V10/00—Arrangements for image or video recognition or understanding

- G06V10/40—Extraction of image or video features

- G06V10/46—Descriptors for shape, contour or point-related descriptors, e.g. scale invariant feature transform [SIFT] or bags of words [BoW]; Salient regional features

- G06V10/462—Salient features, e.g. scale invariant feature transforms [SIFT]

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V10/00—Arrangements for image or video recognition or understanding

- G06V10/70—Arrangements for image or video recognition or understanding using pattern recognition or machine learning

- G06V10/82—Arrangements for image or video recognition or understanding using pattern recognition or machine learning using neural networks

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V30/00—Character recognition; Recognising digital ink; Document-oriented image-based pattern recognition

- G06V30/10—Character recognition

- G06V30/19—Recognition using electronic means

- G06V30/191—Design or setup of recognition systems or techniques; Extraction of features in feature space; Clustering techniques; Blind source separation

- G06V30/19173—Classification techniques

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/10—Image acquisition modality

- G06T2207/10016—Video; Image sequence

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/20—Special algorithmic details

- G06T2207/20081—Training; Learning

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/20—Special algorithmic details

- G06T2207/20084—Artificial neural networks [ANN]

Landscapes

- Engineering & Computer Science (AREA)

- Theoretical Computer Science (AREA)

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- Evolutionary Computation (AREA)

- Artificial Intelligence (AREA)

- Computer Vision & Pattern Recognition (AREA)

- Software Systems (AREA)

- Data Mining & Analysis (AREA)

- Health & Medical Sciences (AREA)

- Computing Systems (AREA)

- General Health & Medical Sciences (AREA)

- Life Sciences & Earth Sciences (AREA)

- General Engineering & Computer Science (AREA)

- Molecular Biology (AREA)

- Mathematical Physics (AREA)

- Biophysics (AREA)

- Computational Linguistics (AREA)

- Biomedical Technology (AREA)

- Multimedia (AREA)

- Databases & Information Systems (AREA)

- Medical Informatics (AREA)

- Bioinformatics & Cheminformatics (AREA)

- Bioinformatics & Computational Biology (AREA)

- Evolutionary Biology (AREA)

- Quality & Reliability (AREA)

- Image Analysis (AREA)

- Information Retrieval, Db Structures And Fs Structures Therefor (AREA)

Description

複数のデジタル画像を取り込み、

複数のデジタル画像の画像データをトレーニングされたニューラルネットワークに提供し、複数のデジタル画像の各特定のデジタル画像について、特定のデジタル画像のピクセル群に各々対応する複数の関連度を取得するように構築されてもよい。

102 畳み込みレイヤ

102a 畳み込みレイヤ

102b 畳み込みレイヤ

104 回帰ヘッド

104a 完全接続レイヤ

104b 完全接続レイヤ

104c 完全接続レイヤ

104d 完全接続レイヤ

106 出力

200 デバイス、コンピュータ

208 デジタルトレーニング画像

212 トレーニングデータセット

204 第1の画像解析アルゴリズム

206 第2の画像解析アルゴリズム

214 人物

210 画像

302 無線ネットワーク

304 カメラ

Claims (10)

- エンコーディングプロセス中に、画像にビットレートバジェットを分配するときにビデオカメラで使用される、複数の入力用デジタル画像を受信し、特定の入力用デジタル画像内のマクロブロックの関連度を決定するためのデータを前記特定の入力用デジタル画像の各々について出力するニューラルネットワークをトレーニングするためのコンピュータプログラムであって、

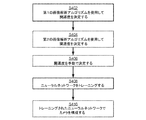

第1の複数のデジタルトレーニング画像について、前記マクロブロック内の画像特性に基づく関連度で前記マクロブロックを自動的にラベル付けするように構成された第1の画像解析アルゴリズムを使用することによって、前記複数のデジタルトレーニング画像の各特定のデジタルトレーニング画像内の前記マクロブロックの関連度を決定することと(S402)、

ユーザが特定した状況を表示する第2の複数のデジタルトレーニング画像について、マクロブロックの画像特性に基づく関連度で前記マクロブロックを自動的にラベル付けするように構成された第2の画像解析アルゴリズムを使用することにより、前記第2の複数のデジタルトレーニング画像の各特定のデジタルトレーニング画像内の前記マクロブロックの関連度を決定すること(S404)、

によってトレーニングデータセットを決定することであって、

前記第2の画像解析アルゴリズムは、前記ユーザが特定した状況を表示する画像を解析するように特別に適合されている点で、第1の画像解析アルゴリズムとは異なり、

比較的高い関連度のマクロブロックは、より低い関連度を有するマクロブロックと比較して、エンコーディングプロセス中にそのマクロブロックに前記ビットレートバジェットのより大きい部分が費やされることをビデオカメラに示す、前記トレーニングデータセットを決定すること、

前記第1および第2の複数のデジタルトレーニング画像および前記関連するラベルを前記トレーニングデータセットとして含めること、および

前記ニューラルネットワークのトレーニング(S408)に前記トレーニングデータセットを使用すること、

を含み、

前記第1の複数のデジタルトレーニング画像および前記関連する関連度は、前記ニューラルネットワークを最初にトレーニングするのに使用され、その後、前記第2の複数のデジタルトレーニング画像および前記関連する関連度は、前記ニューラルネットワークの前記トレーニングを前記ユーザが特定した状況に微調整するのに使用される、コンピュータプログラム。 - 前記第1の画像解析アルゴリズムが、

前記マクロブロックの空間的統計測定値を計算することと、

前記複数のデジタルトレーニング画像の画像シーケンスに時間的フィルタリングを適用することによって、前記マクロブロックの時間的統計測定値を計算することであって、前記画像シーケンスは前記特定のデジタルトレーニング画像を含む、前記マクロブロックの時間的統計測定値を計算することと、

前記マクロブロックの前記時間的統計測定値および前記空間的統計測定値を重み付けすることによって重み付け統計測定値を計算して、前記重み付け統計測定値に基づいて前記マクロブロックに関連度をラベル付けすることと

を行うことにより、前記マクロブロックに関連度を自動的にラベル付けするように構成される、請求項1に記載のコンピュータプログラム。 - 前記第2の複数のデジタルトレーニング画像が、前記第1の複数のデジタルトレーニング画像の一部である少なくとも1つのデジタルトレーニング画像を含む、請求項1または2に記載のコンピュータプログラム。

- 前記第2の複数のデジタルトレーニング画像が、前記第1の複数のデジタルトレーニング画像の一部ではない少なくとも1つのデジタルトレーニング画像を含む、請求項1から3のいずれか一項に記載のコンピュータプログラム。

- 前記トレーニングデータセットが、前記第1の複数のデジタルトレーニング画像の中の少なくとも1つのデジタルトレーニング画像のマクロブロックに関連度を手動でラベル付けすること(S406)によってさらに決定される、請求項1から4のいずれか一項に記載のコンピュータプログラム。

- 前記トレーニングデータセットが、前記第2の複数のデジタルトレーニング画像の中の少なくとも1つのデジタルトレーニング画像のマクロブロックに関連度を手動でラベル付けすることによってさらに決定される、請求項1から5のいずれか一項に記載のコンピュータプログラム。

- 請求項1から6のいずれか一項に記載のコンピュータプログラムを収容した、コンピュータ可読記憶媒体。

- エンコーディングプロセス中に、画像にビットレートバジェットを分配するときにビデオカメラで使用される、複数の入力用デジタル画像を受信し、特定の入力用デジタル画像内のマクロブロックの関連度を決定するためのデータを前記特定の入力用デジタル画像の各々について出力するニューラルネットワークをトレーニングするように構成されたプロセッサを備えるコンピュータであって、前記ニューラルネットワークの前記トレーニングが、

第1の複数のデジタルトレーニング画像について、前記マクロブロック内の画像特性に基づく関連度で前記マクロブロックを自動的にラベル付けするように構成された第1の画像解析アルゴリズムを使用することによって、前記複数のデジタルトレーニング画像の各特定のデジタルトレーニング画像内の前記マクロブロックの関連度を決定することと、

ユーザが特定した状況を表示する第2の複数のデジタルトレーニング画像について、マクロブロックの画像特性に基づく関連度で前記マクロブロックを自動的にラベル付けするように構成された第2の画像解析アルゴリズムを使用することにより、前記第2の複数のデジタルトレーニング画像の各特定のデジタルトレーニング画像内の前記マクロブロックの関連度を決定すること(S404)、

とによってトレーニングデータセットを決定することであって、

前記第2の画像解析アルゴリズムは、前記ユーザが特定した状況を表示する画像を解析するように特別に適合されている点で、第1の画像解析アルゴリズムとは異なり、

比較的高い関連度のマクロブロックは、より低い関連度を有するマクロブロックと比較して、エンコーディングプロセス中にそのマクロブロックに前記ビットレートバジェットのより大きい部分が費やされることをビデオカメラに示す、前記トレーニングデータセットを決定すること、

前記第1および第2の複数のデジタルトレーニング画像および前記関連するラベルを前記トレーニングデータセットとして含めること、および

前記ニューラルネットワークのトレーニングに前記トレーニングデータセットを使用すること、

を含み、

前記第1の複数のデジタルトレーニング画像および前記関連する関連度は、前記ニューラルネットワークを最初にトレーニングするのに使用され、その後、前記第2の複数のデジタルトレーニング画像および前記関連する関連度は、前記ニューラルネットワークの前記トレーニングを前記ユーザが特定した状況に微調整するのに使用される、コンピュータ。 - ビデオカメラと請求項8に記載のコンピュータとを備えるシステムであって、

前記プロセッサが、結果として得られたトレーニングされたニューラルネットワークを前記カメラに提供する(S410)ようにさらに構成され、

前記カメラが、

前記トレーニングされたニューラルネットワークを受信し、

複数のデジタル画像を取り込み、前記複数のデジタル画像の画像データを前記トレーニングされたニューラルネットワークに供給し、前記複数のデジタル画像の各特定のデジタル画像について、前記特定のデジタル画像のマクロブロックに各々対応する複数の関連度を取得するように構成された、システム。 - 前記カメラが、

前記取得された関連度に従って前記特定のデジタル画像の圧縮度を制御することによって前記特定のデジタル画像をエンコードするようにさらに構成された、請求項9に記載のシステム。

Applications Claiming Priority (2)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| EP16192142.4 | 2016-10-04 | ||

| EP16192142.4A EP3306528B1 (en) | 2016-10-04 | 2016-10-04 | Using image analysis algorithms for providing traning data to neural networks |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2018101406A JP2018101406A (ja) | 2018-06-28 |

| JP2018101406A5 JP2018101406A5 (ja) | 2020-08-20 |

| JP6842395B2 true JP6842395B2 (ja) | 2021-03-17 |

Family

ID=57083180

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2017182561A Active JP6842395B2 (ja) | 2016-10-04 | 2017-09-22 | ニューラルネットワークにトレーニングデータを提供するための画像解析アルゴリズムの使用 |

Country Status (6)

| Country | Link |

|---|---|

| US (1) | US10496903B2 (ja) |

| EP (1) | EP3306528B1 (ja) |

| JP (1) | JP6842395B2 (ja) |

| KR (1) | KR102203694B1 (ja) |

| CN (1) | CN107895359B (ja) |

| TW (1) | TWI735669B (ja) |

Families Citing this family (23)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP6624125B2 (ja) * | 2017-03-13 | 2019-12-25 | コニカミノルタ株式会社 | 画像検査装置、画像形成システム及び画像圧縮方法 |

| WO2019171121A1 (en) * | 2018-03-05 | 2019-09-12 | Omron Corporation | Method, device, system and program for setting lighting condition and storage medium |

| DE102019208257A1 (de) * | 2018-07-03 | 2020-01-09 | Heidelberger Druckmaschinen Ag | Druckqualitätsanalyse mit neuronalen Netzen |

| CN109271847B (zh) | 2018-08-01 | 2023-04-07 | 创新先进技术有限公司 | 无人结算场景中异常检测方法、装置及设备 |

| KR102194303B1 (ko) | 2018-10-08 | 2020-12-22 | 단국대학교 산학협력단 | 3d 데이터 프로세싱에 이용되는 ai 트레이닝을 위한 데이터 셋 확장 생성과 전처리를 위한 장치 및 방법 |

| EP3667557B1 (en) * | 2018-12-13 | 2021-06-16 | Axis AB | Method and device for tracking an object |

| TWI701565B (zh) * | 2018-12-19 | 2020-08-11 | 財團法人工業技術研究院 | 資料標記系統及資料標記方法 |

| US11853812B2 (en) * | 2018-12-20 | 2023-12-26 | Here Global B.V. | Single component data processing system and method utilizing a trained neural network |

| US10762393B2 (en) * | 2019-01-31 | 2020-09-01 | StradVision, Inc. | Learning method and learning device for learning automatic labeling device capable of auto-labeling image of base vehicle using images of nearby vehicles, and testing method and testing device using the same |

| US10540572B1 (en) * | 2019-01-31 | 2020-01-21 | StradVision, Inc. | Method for auto-labeling training images for use in deep learning network to analyze images with high precision, and auto-labeling device using the same |

| EP3928102A4 (en) | 2019-02-22 | 2022-12-14 | Stratuscent Inc. | SYSTEMS AND METHODS OF LEARNING ACROSS MULTIPLE CHEMICAL SENSING UNITS USING RECIPROCAL LATENTED REPRESENTATION |

| CN119721121A (zh) * | 2019-05-17 | 2025-03-28 | 巴科股份有限公司 | 用于训练具有异构数据的生成式对抗网络的方法和系统 |

| DE102019207575A1 (de) * | 2019-05-23 | 2020-11-26 | Volkswagen Aktiengesellschaft | Verfahren zum Beurteilen einer funktionsspezifischen Robustheit eines Neuronalen Netzes |

| DE102019208733A1 (de) * | 2019-06-14 | 2020-12-17 | neurocat GmbH | Verfahren und Generator zum Erzeugen von gestörten Eingangsdaten für ein neuronales Netz |

| KR102339181B1 (ko) * | 2020-03-09 | 2021-12-13 | 에스케이 주식회사 | Machine Learning을 이용한 데이터 연관성 자동 탐색 방법 및 시스템 |

| TWI809266B (zh) * | 2020-04-21 | 2023-07-21 | 中華電信股份有限公司 | 電梯事件偵測模型之產生與更新方法 |

| EP3905659B1 (en) * | 2020-04-28 | 2022-06-01 | Axis AB | Statistics-based electronics image stabilization |

| WO2021230675A1 (ko) * | 2020-05-13 | 2021-11-18 | (주)사맛디 | 딥러닝 기반 대상체 감성 인식 방법 및 장치 |

| US11379697B2 (en) | 2020-05-20 | 2022-07-05 | Bank Of America Corporation | Field programmable gate array architecture for image analysis |

| US11295430B2 (en) | 2020-05-20 | 2022-04-05 | Bank Of America Corporation | Image analysis architecture employing logical operations |

| CN111767985B (zh) * | 2020-06-19 | 2022-07-22 | 深圳市商汤科技有限公司 | 一种神经网络的训练方法、视频识别方法及装置 |

| KR102213291B1 (ko) * | 2020-07-30 | 2021-02-04 | 배도연 | 웹사이트 제작 시스템 |

| WO2023085457A1 (ko) * | 2021-11-11 | 2023-05-19 | 한국전자기술연구원 | 효율적인 딥러닝 학습을 위한 메모리 구조 및 제어 방법 |

Family Cites Families (17)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US6757602B2 (en) * | 1997-02-06 | 2004-06-29 | Automotive Technologies International, Inc. | System for determining the occupancy state of a seat in a vehicle and controlling a component based thereon |

| JP3524250B2 (ja) * | 1995-11-27 | 2004-05-10 | キヤノン株式会社 | デジタル画像処理プロセッサ |

| US7444030B2 (en) * | 2004-11-12 | 2008-10-28 | Micron Technology, Inc. | Image encoding with dynamic buffer-capacity-level-based compression adjustment |

| US7840502B2 (en) * | 2007-06-13 | 2010-11-23 | Microsoft Corporation | Classification of images as advertisement images or non-advertisement images of web pages |

| JP5193931B2 (ja) * | 2009-04-20 | 2013-05-08 | 富士フイルム株式会社 | 画像処理装置、画像処理方法およびプログラム |

| US9208405B2 (en) * | 2010-08-06 | 2015-12-08 | Sony Corporation | Systems and methods for digital image analysis |

| EP2499961B1 (en) * | 2011-03-18 | 2016-09-21 | SensoMotoric Instruments Gesellschaft für innovative Sensorik mbH | Spectacle device with an adjustable field of view and method |

| EP2557789B1 (en) * | 2011-08-09 | 2017-09-27 | Dolby Laboratories Licensing Corporation | Guided image up-sampling in video coding |

| US20140368737A1 (en) * | 2013-06-17 | 2014-12-18 | Spotify Ab | System and method for playing media during navigation between media streams |

| US8965112B1 (en) * | 2013-12-09 | 2015-02-24 | Google Inc. | Sequence transcription with deep neural networks |

| CN104103033B (zh) * | 2014-08-05 | 2017-06-06 | 广州国米科技有限公司 | 图像实时处理方法 |

| EP3021583B1 (en) | 2014-11-14 | 2019-10-23 | Axis AB | Method of identifying relevant areas in digital images, method of encoding digital images, and encoder system |

| EP3029937B1 (en) * | 2014-12-03 | 2016-11-16 | Axis AB | Method and encoder for video encoding of a sequence of frames |

| CN104679863B (zh) | 2015-02-28 | 2018-05-04 | 武汉烽火众智数字技术有限责任公司 | 一种基于深度学习的以图搜图方法和系统 |

| CN105260734A (zh) * | 2015-10-10 | 2016-01-20 | 燕山大学 | 一种具有自建模功能的商品油表面激光标码识别方法 |

| CN105430394A (zh) | 2015-11-23 | 2016-03-23 | 小米科技有限责任公司 | 视频数据压缩处理方法、装置和设备 |

| CN105551036B (zh) * | 2015-12-10 | 2019-10-08 | 中国科学院深圳先进技术研究院 | 一种深度学习网络的训练方法和装置 |

-

2016

- 2016-10-04 EP EP16192142.4A patent/EP3306528B1/en active Active

-

2017

- 2017-09-22 JP JP2017182561A patent/JP6842395B2/ja active Active

- 2017-09-28 KR KR1020170126009A patent/KR102203694B1/ko active Active

- 2017-09-29 TW TW106133689A patent/TWI735669B/zh active

- 2017-09-29 CN CN201710905791.6A patent/CN107895359B/zh active Active

- 2017-10-04 US US15/725,029 patent/US10496903B2/en active Active

Also Published As

| Publication number | Publication date |

|---|---|

| CN107895359A (zh) | 2018-04-10 |

| EP3306528A1 (en) | 2018-04-11 |

| KR20180037593A (ko) | 2018-04-12 |

| US10496903B2 (en) | 2019-12-03 |

| US20180096232A1 (en) | 2018-04-05 |

| TW201814596A (zh) | 2018-04-16 |

| CN107895359B (zh) | 2023-06-09 |

| EP3306528B1 (en) | 2019-12-25 |

| KR102203694B1 (ko) | 2021-01-15 |

| TWI735669B (zh) | 2021-08-11 |

| JP2018101406A (ja) | 2018-06-28 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP6842395B2 (ja) | ニューラルネットワークにトレーニングデータを提供するための画像解析アルゴリズムの使用 | |

| US11477468B2 (en) | Method and device for compressing image and neural network using hidden variable | |

| US11729406B2 (en) | Video compression using deep generative models | |

| CN111738231B (zh) | 目标对象检测方法、装置、计算机设备和存储介质 | |

| US10834415B2 (en) | Devices for compression/decompression, system, chip, and electronic device | |

| US20200329233A1 (en) | Hyperdata Compression: Accelerating Encoding for Improved Communication, Distribution & Delivery of Personalized Content | |

| CN110637460B (zh) | 利用深层神经网络的视觉质量保持量化参数预测 | |

| CN108780499B (zh) | 基于量化参数的视频处理的系统和方法 | |

| WO2020191200A1 (en) | Video compression using deep generative models | |

| TW202215303A (zh) | 使用基於自我注意之神經網路處理影像 | |

| CN110574077A (zh) | 利用虚拟三维深层神经网络的影像分析装置及方法 | |

| JP2023512570A (ja) | 画像処理方法および関連装置 | |

| CN114096987A (zh) | 视频处理方法及装置 | |

| WO2007097586A1 (en) | Portable apparatuses having devices for tracking object's head, and methods of tracking object's head in portable apparatus | |

| WO2015078017A1 (en) | Method and system for exacting face features from data of face images | |

| KR102472971B1 (ko) | 인공지능 모델을 이용한 동영상 인코딩 최적화 방법, 시스템, 및 컴퓨터 프로그램 | |

| TWI512685B (zh) | 移動物體偵測方法及其裝置 | |

| CN119031147B (zh) | 基于可学习任务感知机制的视频编解码加速方法及系统 | |

| Li et al. | ROI-based deep image compression with Swin transformers | |

| CN110225342A (zh) | 基于语义失真度量的视频编码的比特分配系统及方法 | |

| CN117218013A (zh) | 事件相机图像处理方法、训练方法、系统、设备及介质 | |

| CN104125470A (zh) | 一种视频数据传输方法 | |

| CN112418223A (zh) | 一种基于改进优化的野生动物图像显著性目标检测方法 | |

| KR20240136217A (ko) | 이미지 처리 장치 및 방법 | |

| Khodadadi et al. | Variable bit allocation method based on meta-heuristic algorithms for facial image compression |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20200708 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20200708 |

|

| A871 | Explanation of circumstances concerning accelerated examination |

Free format text: JAPANESE INTERMEDIATE CODE: A871 Effective date: 20200708 |

|

| A975 | Report on accelerated examination |

Free format text: JAPANESE INTERMEDIATE CODE: A971005 Effective date: 20200714 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20201030 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20201104 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20210121 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20210216 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20210219 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 6842395 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |