JP6260375B2 - 管理装置、管理プログラム及び情報処理システム - Google Patents

管理装置、管理プログラム及び情報処理システム Download PDFInfo

- Publication number

- JP6260375B2 JP6260375B2 JP2014053665A JP2014053665A JP6260375B2 JP 6260375 B2 JP6260375 B2 JP 6260375B2 JP 2014053665 A JP2014053665 A JP 2014053665A JP 2014053665 A JP2014053665 A JP 2014053665A JP 6260375 B2 JP6260375 B2 JP 6260375B2

- Authority

- JP

- Japan

- Prior art keywords

- level

- amount

- secured

- site

- unit

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Expired - Fee Related

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F9/00—Arrangements for program control, e.g. control units

- G06F9/06—Arrangements for program control, e.g. control units using stored programs, i.e. using an internal store of processing equipment to receive or retain programs

- G06F9/46—Multiprogramming arrangements

- G06F9/50—Allocation of resources, e.g. of the central processing unit [CPU]

- G06F9/5005—Allocation of resources, e.g. of the central processing unit [CPU] to service a request

- G06F9/5011—Allocation of resources, e.g. of the central processing unit [CPU] to service a request the resources being hardware resources other than CPUs, Servers and Terminals

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04L—TRANSMISSION OF DIGITAL INFORMATION, e.g. TELEGRAPHIC COMMUNICATION

- H04L47/00—Traffic control in data switching networks

- H04L47/70—Admission control; Resource allocation

- H04L47/82—Miscellaneous aspects

- H04L47/822—Collecting or measuring resource availability data

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F11/00—Error detection; Error correction; Monitoring

- G06F11/07—Responding to the occurrence of a fault, e.g. fault tolerance

- G06F11/16—Error detection or correction of the data by redundancy in hardware

- G06F11/20—Error detection or correction of the data by redundancy in hardware using active fault-masking, e.g. by switching out faulty elements or by switching in spare elements

- G06F11/2053—Error detection or correction of the data by redundancy in hardware using active fault-masking, e.g. by switching out faulty elements or by switching in spare elements where persistent mass storage functionality or persistent mass storage control functionality is redundant

- G06F11/2094—Redundant storage or storage space

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F11/00—Error detection; Error correction; Monitoring

- G06F11/30—Monitoring

- G06F11/34—Recording or statistical evaluation of computer activity, e.g. of down time, of input/output operation ; Recording or statistical evaluation of user activity, e.g. usability assessment

- G06F11/3409—Recording or statistical evaluation of computer activity, e.g. of down time, of input/output operation ; Recording or statistical evaluation of user activity, e.g. usability assessment for performance assessment

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04L—TRANSMISSION OF DIGITAL INFORMATION, e.g. TELEGRAPHIC COMMUNICATION

- H04L47/00—Traffic control in data switching networks

- H04L47/70—Admission control; Resource allocation

- H04L47/83—Admission control; Resource allocation based on usage prediction

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F11/00—Error detection; Error correction; Monitoring

- G06F11/07—Responding to the occurrence of a fault, e.g. fault tolerance

- G06F11/16—Error detection or correction of the data by redundancy in hardware

- G06F11/20—Error detection or correction of the data by redundancy in hardware using active fault-masking, e.g. by switching out faulty elements or by switching in spare elements

- G06F11/2097—Error detection or correction of the data by redundancy in hardware using active fault-masking, e.g. by switching out faulty elements or by switching in spare elements maintaining the standby controller/processing unit updated

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F11/00—Error detection; Error correction; Monitoring

- G06F11/30—Monitoring

- G06F11/3003—Monitoring arrangements specially adapted to the computing system or computing system component being monitored

- G06F11/3006—Monitoring arrangements specially adapted to the computing system or computing system component being monitored where the computing system is distributed, e.g. networked systems, clusters, multiprocessor systems

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F11/00—Error detection; Error correction; Monitoring

- G06F11/30—Monitoring

- G06F11/3055—Monitoring arrangements for monitoring the status of the computing system or of the computing system component, e.g. monitoring if the computing system is on, off, available, not available

Landscapes

- Engineering & Computer Science (AREA)

- Theoretical Computer Science (AREA)

- General Engineering & Computer Science (AREA)

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- Software Systems (AREA)

- Quality & Reliability (AREA)

- Computer Networks & Wireless Communication (AREA)

- Signal Processing (AREA)

- Computer Hardware Design (AREA)

- Hardware Redundancy (AREA)

- Information Retrieval, Db Structures And Fs Structures Therefor (AREA)

Description

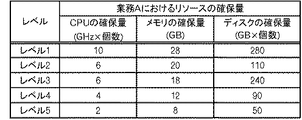

第1サイトで稼動しているシステムの復旧に用いられるデータを保持している第2サイトにおけるリソースの空き状況を取得する第1取得部と、

前記システムの復旧のリハーサル処理で確保すべきリソースの規模を定めた複数のレベルのうち、前記空き状況が適合するレベルを特定する特定部と、

前記適合するレベルに応じた前記リハーサル処理を起動させる起動部と

を有する管理装置。

更に、

前記第1サイトでモニタされた、前記システムにおけるリソースの使用量を取得する第2取得部と、

前記使用量によって、前記規模についての閾値を設定する設定部と

を有する付記1記載の管理装置。

更に、

前記第1サイトでモニタされた、前記システムにおけるリソースの使用量を取得する第2取得部と、

前記使用量から前記システムにおける冗長化のための使用量を差し引き、残余の使用量によって、前記規模についての閾値を設定する設定部と

を有する付記1記載の管理装置。

前記設定部は、複数の時点におけるリソースの使用量を比較し、少ない方の使用量を用いる

付記2又は3記載の管理装置。

更に、

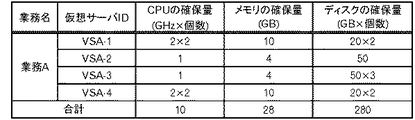

前記第1サイトから、前記システムに対するリソースの割当量を取得する第2取得部と、

前記割当量から前記システムにおける冗長化のための割当量を差し引き、残余の割当量によって、前記規模についての閾値を設定する設定部と

を有する付記1記載の管理装置。

更に、

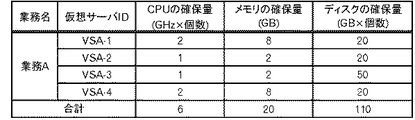

前記第1サイトでモニタされた、前記システムに含まれる複数の仮想マシンの各々におけるリソースの使用量を取得する第2取得部と、

前記仮想マシンの各々における前記使用量を比較して、最も大きい使用量によって、前記規模についての閾値を設定する設定部と

を有する付記1記載の管理装置。

第1サイトで稼動しているシステムの復旧に用いられるデータを保持している第2サイトにおけるリソースの空き状況を取得する処理と、

前記システムの復旧のリハーサル処理で確保すべきリソースの規模を定めた複数のレベルのうち、前記空き状況が適合するレベルを特定する処理と、

前記適合するレベルに応じた前記リハーサル処理を起動させる処理と

をコンピュータに実行させるための管理プログラム。

第1サイトで稼動しているシステムの復旧に用いられるデータを保持している第2サイトにおけるリソースの空き状況を取得する取得部と、

前記システムの復旧のリハーサル処理で確保すべきリソースの規模を定めた複数のレベルのうち、前記空き状況が適合するレベルを特定する特定部と、

前記適合するレベルに応じた前記リハーサル処理を起動させる起動部と、

前記適合するレベルに応じた前記リハーサル処理を実行するリハーサル部と

を有する情報処理システム。

105 ストレージ装置 107 管理サーバ

109 モニタ部 111 待機サイト

113 物理サーバ 115 ストレージ装置

117 管理サーバ 119 モニタ部

121 リハーサル部 131 管理装置

133 準備部 135 制御部

401 構成情報 403 システムイメージ

405 ユーザデータ 411 構成情報

413 システムイメージ 415 ユーザデータ

501 第1取得部 503 データ記憶部

505 第1サイズ記憶部 507 第1特定部

509 第2サイズ記憶部 511 設定部

513 送信部 521 第3サイズ記憶部

531 受付部 533 第2取得部

535 第4サイズ記憶部 537 第2特定部

539 判定部 541 起動部

Claims (12)

- 第1サイトで稼動しているシステムの復旧に用いられるデータを保持している第2サイトにおけるリソースの空き状況を取得する第1取得部と、

前記システムの復旧のリハーサル処理で確保すべきリソースの規模を定めた複数のレベルのうち、前記空き状況が適合するレベルを特定する特定部と、

前記適合するレベルに応じた前記リハーサル処理を起動させる起動部と

を有する管理装置であって、

更に、

前記第1サイトでモニタされた、前記システムにおけるリソースの使用量を取得する第2取得部と、

前記使用量から前記システムにおける冗長化のための使用量を差し引き、残余の使用量によって、前記複数のレベルのうちの1のレベルにおいて確保すべき前記リソースの規模を設定する設定部と

を有する管理装置。 - 第1サイトで稼動しているシステムの復旧に用いられるデータを保持している第2サイトにおけるリソースの空き状況を取得する第1取得部と、

前記システムの復旧のリハーサル処理で確保すべきリソースの規模を定めた複数のレベルのうち、前記空き状況が適合するレベルを特定する特定部と、

前記適合するレベルに応じた前記リハーサル処理を起動させる起動部と

を有する管理装置であって、

更に、

前記第1サイトでモニタされた、前記システムにおけるリソースの使用量を取得する第2取得部と、

複数の時点におけるリソースの使用量を比較し、少ない方の使用量によって、前記複数のレベルのうちの1のレベルにおいて確保すべき前記リソースの規模を設定する設定部と

を有する管理装置。 - 第1サイトで稼動しているシステムの復旧に用いられるデータを保持している第2サイトにおけるリソースの空き状況を取得する第1取得部と、

前記システムの復旧のリハーサル処理で確保すべきリソースの規模を定めた複数のレベルのうち、前記空き状況が適合するレベルを特定する特定部と、

前記適合するレベルに応じた前記リハーサル処理を起動させる起動部と

を有する管理装置であって、

更に、

前記第1サイトから、前記システムに対するリソースの割当量を取得する第2取得部と、

前記割当量から前記システムにおける冗長化のための割当量を差し引き、残余の割当量によって、前記複数のレベルのうちの1のレベルにおいて確保すべき前記リソースの規模を設定する設定部と

を有する管理装置。 - 第1サイトで稼動しているシステムの復旧に用いられるデータを保持している第2サイトにおけるリソースの空き状況を取得する第1取得部と、

前記システムの復旧のリハーサル処理で確保すべきリソースの規模を定めた複数のレベルのうち、前記空き状況が適合するレベルを特定する特定部と、

前記適合するレベルに応じた前記リハーサル処理を起動させる起動部と

を有する管理装置であって、

更に、

前記第1サイトでモニタされた、前記システムに含まれる複数の仮想マシンの各々におけるリソースの使用量を取得する第2取得部と、

前記仮想マシンの各々における前記使用量を比較して、最も大きい使用量によって、前記複数のレベルのうちの1のレベルにおいて確保すべき前記リソースの規模を設定する設定部と

を有する管理装置。 - 第1サイトで稼動しているシステムの復旧に用いられるデータを保持している第2サイトにおけるリソースの空き状況を取得する処理と、

前記システムの復旧のリハーサル処理で確保すべきリソースの規模を定めた複数のレベルのうち、前記空き状況が適合するレベルを特定する処理と、

前記適合するレベルに応じた前記リハーサル処理を起動させる処理と

をコンピュータに実行させるための管理プログラムであって、

更に、

前記第1サイトでモニタされた、前記システムにおけるリソースの使用量を取得する処理と、

前記使用量から前記システムにおける冗長化のための使用量を差し引き、残余の使用量によって、前記複数のレベルのうちの1のレベルにおいて確保すべき前記リソースの規模を設定する処理と

を前記コンピュータに実行させる管理プログラム。 - 第1サイトで稼動しているシステムの復旧に用いられるデータを保持している第2サイトにおけるリソースの空き状況を取得する処理と、

前記システムの復旧のリハーサル処理で確保すべきリソースの規模を定めた複数のレベルのうち、前記空き状況が適合するレベルを特定する処理と、

前記適合するレベルに応じた前記リハーサル処理を起動させる処理と

をコンピュータに実行させるための管理プログラムであって、

更に、

前記第1サイトでモニタされた、前記システムにおけるリソースの使用量を取得する処理と、

複数の時点におけるリソースの使用量を比較し、少ない方の使用量によって、前記複数のレベルのうちの1のレベルにおいて確保すべき前記リソースの規模を設定する処理と

を前記コンピュータに実行させる管理プログラム。 - 第1サイトで稼動しているシステムの復旧に用いられるデータを保持している第2サイトにおけるリソースの空き状況を取得する処理と、

前記システムの復旧のリハーサル処理で確保すべきリソースの規模を定めた複数のレベルのうち、前記空き状況が適合するレベルを特定する処理と、

前記適合するレベルに応じた前記リハーサル処理を起動させる処理と

をコンピュータに実行させるための管理プログラムであって、

更に、

前記第1サイトから、前記システムに対するリソースの割当量を取得する処理と、

前記割当量から前記システムにおける冗長化のための割当量を差し引き、残余の割当量によって、前記複数のレベルのうちの1のレベルにおいて確保すべき前記リソースの規模を設定する処理と

を前記コンピュータに実行させる管理プログラム。 - 第1サイトで稼動しているシステムの復旧に用いられるデータを保持している第2サイトにおけるリソースの空き状況を取得する処理と、

前記システムの復旧のリハーサル処理で確保すべきリソースの規模を定めた複数のレベルのうち、前記空き状況が適合するレベルを特定する処理と、

前記適合するレベルに応じた前記リハーサル処理を起動させる処理と

をコンピュータに実行させるための管理プログラムであって、

更に、

前記第1サイトでモニタされた、前記システムに含まれる複数の仮想マシンの各々におけるリソースの使用量を取得する処理と、

前記仮想マシンの各々における前記使用量を比較して、最も大きい使用量によって、前記複数のレベルのうちの1のレベルにおいて確保すべき前記リソースの規模を設定する処理と

を前記コンピュータに実行させる管理プログラム。 - 第1サイトで稼動しているシステムの復旧に用いられるデータを保持している第2サイトにおけるリソースの空き状況を取得する第1取得部と、

前記システムの復旧のリハーサル処理で確保すべきリソースの規模を定めた複数のレベルのうち、前記空き状況が適合するレベルを特定する特定部と、

前記適合するレベルに応じた前記リハーサル処理を起動させる起動部と、

前記適合するレベルに応じた前記リハーサル処理を実行するリハーサル部と

を有する情報処理システムであって、

更に、

前記第1サイトでモニタされた、前記システムにおけるリソースの使用量を取得する第2取得部と、

前記使用量から前記システムにおける冗長化のための使用量を差し引き、残余の使用量によって、前記複数のレベルのうちの1のレベルにおいて確保すべき前記リソースの規模を設定する設定部と

を有する情報処理システム。 - 第1サイトで稼動しているシステムの復旧に用いられるデータを保持している第2サイトにおけるリソースの空き状況を取得する第1取得部と、

前記システムの復旧のリハーサル処理で確保すべきリソースの規模を定めた複数のレベルのうち、前記空き状況が適合するレベルを特定する特定部と、

前記適合するレベルに応じた前記リハーサル処理を起動させる起動部と、

前記適合するレベルに応じた前記リハーサル処理を実行するリハーサル部と

を有する情報処理システムであって、

更に、

前記第1サイトでモニタされた、前記システムにおけるリソースの使用量を取得する第2取得部と、

複数の時点におけるリソースの使用量を比較し、少ない方の使用量によって、前記複数のレベルのうちの1のレベルにおいて確保すべき前記リソースの規模を設定する設定部と

を有する情報処理システム。 - 第1サイトで稼動しているシステムの復旧に用いられるデータを保持している第2サイトにおけるリソースの空き状況を取得する第1取得部と、

前記システムの復旧のリハーサル処理で確保すべきリソースの規模を定めた複数のレベルのうち、前記空き状況が適合するレベルを特定する特定部と、

前記適合するレベルに応じた前記リハーサル処理を起動させる起動部と、

前記適合するレベルに応じた前記リハーサル処理を実行するリハーサル部と

を有する情報処理システムであって、

更に、

前記第1サイトから、前記システムに対するリソースの割当量を取得する第2取得部と、

前記割当量から前記システムにおける冗長化のための割当量を差し引き、残余の割当量によって、前記複数のレベルのうちの1のレベルにおいて確保すべき前記リソースの規模を設定する設定部と

を有する情報処理システム。 - 第1サイトで稼動しているシステムの復旧に用いられるデータを保持している第2サイトにおけるリソースの空き状況を取得する第1取得部と、

前記システムの復旧のリハーサル処理で確保すべきリソースの規模を定めた複数のレベルのうち、前記空き状況が適合するレベルを特定する特定部と、

前記適合するレベルに応じた前記リハーサル処理を起動させる起動部と、

前記適合するレベルに応じた前記リハーサル処理を実行するリハーサル部と

を有する情報処理システムであって、

更に、

前記第1サイトでモニタされた、前記システムに含まれる複数の仮想マシンの各々におけるリソースの使用量を取得する第2取得部と、

前記仮想マシンの各々における前記使用量を比較して、最も大きい使用量によって、前記複数のレベルのうちの1のレベルにおいて確保すべき前記リソースの規模を設定する設定部と

を有する情報処理システム。

Priority Applications (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2014053665A JP6260375B2 (ja) | 2014-03-17 | 2014-03-17 | 管理装置、管理プログラム及び情報処理システム |

| US14/576,461 US20150263988A1 (en) | 2014-03-17 | 2014-12-19 | Management device and information processing system |

| EP14199634.8A EP2921956A1 (en) | 2014-03-17 | 2014-12-22 | Information processing system |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2014053665A JP6260375B2 (ja) | 2014-03-17 | 2014-03-17 | 管理装置、管理プログラム及び情報処理システム |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2015176459A JP2015176459A (ja) | 2015-10-05 |

| JP6260375B2 true JP6260375B2 (ja) | 2018-01-17 |

Family

ID=52272893

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2014053665A Expired - Fee Related JP6260375B2 (ja) | 2014-03-17 | 2014-03-17 | 管理装置、管理プログラム及び情報処理システム |

Country Status (3)

| Country | Link |

|---|---|

| US (1) | US20150263988A1 (ja) |

| EP (1) | EP2921956A1 (ja) |

| JP (1) | JP6260375B2 (ja) |

Families Citing this family (3)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP6377197B1 (ja) * | 2017-03-03 | 2018-08-22 | 三菱電機インフォメーションシステムズ株式会社 | スレッド数変動通信装置及びスレッド数変動通信プログラム |

| JP7661864B2 (ja) | 2021-10-19 | 2025-04-15 | 中国電力株式会社 | 仮想サーバの管理方法とそれに用いられる仮想サーバ管理システム |

| FR3134407B1 (fr) | 2022-04-06 | 2024-04-26 | Pommier | Poignée pour porte de camion |

Family Cites Families (11)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2000347997A (ja) | 1999-06-03 | 2000-12-15 | Mitsubishi Electric Corp | 分散構成計算機装置 |

| US7287086B2 (en) * | 2003-07-09 | 2007-10-23 | Internatinonal Business Machines Corporation | Methods, systems and computer program products for controlling data transfer for data replication or backup based on system and/or network resource information |

| JP4207938B2 (ja) | 2005-02-01 | 2009-01-14 | セイコーエプソン株式会社 | ソフトウェア認証システム、ソフトウェア認証プログラム、およびソフトウェア認証方法 |

| US7669020B1 (en) * | 2005-05-02 | 2010-02-23 | Symantec Operating Corporation | Host-based backup for virtual machines |

| WO2007024478A2 (en) * | 2005-08-23 | 2007-03-01 | Mimosa Systems, Inc. | Enterprise server version migration through identity preservation |

| JP2010198060A (ja) | 2009-02-23 | 2010-09-09 | Nec Corp | サーバシステム及びサーバシステムの制御方法 |

| US9424094B2 (en) * | 2009-06-01 | 2016-08-23 | International Business Machines Corporation | Server consolidation using virtual machine resource tradeoffs |

| JP2011128967A (ja) * | 2009-12-18 | 2011-06-30 | Hitachi Ltd | 仮想計算機の移動方法、仮想計算機システム及びプログラム |

| US8397039B2 (en) * | 2010-02-12 | 2013-03-12 | Symantec Corporation | Storage systems and methods |

| US9032414B1 (en) * | 2011-12-08 | 2015-05-12 | Symantec Corporation | Systems and methods for managing system resources allocated for backup validation |

| US9602426B2 (en) * | 2013-06-21 | 2017-03-21 | Microsoft Technology Licensing, Llc | Dynamic allocation of resources while considering resource reservations |

-

2014

- 2014-03-17 JP JP2014053665A patent/JP6260375B2/ja not_active Expired - Fee Related

- 2014-12-19 US US14/576,461 patent/US20150263988A1/en not_active Abandoned

- 2014-12-22 EP EP14199634.8A patent/EP2921956A1/en not_active Ceased

Also Published As

| Publication number | Publication date |

|---|---|

| JP2015176459A (ja) | 2015-10-05 |

| US20150263988A1 (en) | 2015-09-17 |

| EP2921956A1 (en) | 2015-09-23 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| US11782794B2 (en) | Methods and apparatus for providing hypervisor level data services for server virtualization | |

| US11797395B2 (en) | Application migration between environments | |

| CN111488241B (zh) | 在容器编排平台实现无代理备份与恢复操作的方法和系统 | |

| US10651926B2 (en) | State transfer among satellite platforms | |

| US11074143B2 (en) | Data backup and disaster recovery between environments | |

| US9977704B1 (en) | Automated backup and replication of virtual machine data centers | |

| Wang et al. | Efficient task replication for fast response times in parallel computation | |

| US12250160B2 (en) | Provisioning of resources | |

| US9026858B2 (en) | Testing server, information processing system, and testing method | |

| JP2010503074A5 (ja) | ||

| CN106445741B (zh) | 一种基于ceph实现oracle数据库容灾备份方法 | |

| US20150234713A1 (en) | Information processing apparatus and virtual machine migration method | |

| JP6260375B2 (ja) | 管理装置、管理プログラム及び情報処理システム | |

| CN102629224A (zh) | 一种基于云平台的一体化数据容灾方法及其装置 | |

| CN104750573B (zh) | 分布式数据系统数据节点的全局一致性备份和还原方法 | |

| JP6212934B2 (ja) | ストレージシステム、情報処理装置の制御プログラム、およびストレージシステムの制御方法 | |

| JP2012043071A (ja) | 調整システム、調整装置、調整方法、及びそのプログラム | |

| JP5054220B1 (ja) | 仮想データセンタシステム | |

| RU2010102826A (ru) | Способ установки, настройки, администрирования и резервного копирования программного обеспечения | |

| JP7192388B2 (ja) | 並列処理装置、並列演算実行プログラムおよびバックアップ方法 | |

| US20130262393A1 (en) | Database backup without particularly specifying server | |

| US20130263128A1 (en) | Computer-readable recording medium, migration control method and control device | |

| CN110554933A (zh) | 一种云管理平台、云平台服务的跨云高可用方法及系统 | |

| US20150278027A1 (en) | Backup apparatus, backup method, and storage medium that stores backup program | |

| JP2009271839A (ja) | 情報処理システム、情報処理方法、プログラム、及び、記録媒体 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20161206 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20170905 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20171102 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20171114 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20171127 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 6260375 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 |

|

| LAPS | Cancellation because of no payment of annual fees |