JP6197702B2 - 入力方法,プログラム及び入力装置 - Google Patents

入力方法,プログラム及び入力装置 Download PDFInfo

- Publication number

- JP6197702B2 JP6197702B2 JP2014046159A JP2014046159A JP6197702B2 JP 6197702 B2 JP6197702 B2 JP 6197702B2 JP 2014046159 A JP2014046159 A JP 2014046159A JP 2014046159 A JP2014046159 A JP 2014046159A JP 6197702 B2 JP6197702 B2 JP 6197702B2

- Authority

- JP

- Japan

- Prior art keywords

- head

- terminal

- input

- relative

- movement

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Expired - Fee Related

Links

Images

Landscapes

- User Interface Of Digital Computer (AREA)

Description

本実施形態の入力装置,入力方法及びプログラムは、コンピューターにジェスチャーUIを提供するものである。このジェスチャーUIでは、頭部の動作がコンピューターへの入力操作として認識され、その入力操作の情報がコンピューターに入力される。ここでいうコンピューターには、電子計算機を内蔵し可搬性を有する装置が含まれる。例えば、携帯電話機,スマートフォン,インターネット端末といった携帯情報端末や、ノートパソコン,スレートパソコンといったパーソナルコンピューター、あるいは、音楽プレーヤー,カメラ,ビデオプレーヤー,携帯型ゲーム機,GPS(Global Positioning System)装置,リモコン装置などの電子機器類(ガジェット)がこれに含まれる。以下、入力操作の情報が入力されるこれらのコンピューター全般のことを単に「端末」と呼ぶ。

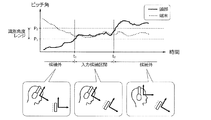

第一の選別は、情報の入力に係る動作を選別するためのものであり、少なくとも端末及び頭部の相対的な傾きに基づいて行われる。第一の選別では、情報の入力に係る動作が実施された区間の候補が特定される。第一の選別条件が成立すると、頭部のジェスチャーによる端末への情報入力が有効な状態(Mode-In状態)とされる。一方、この第一の選別条件が不成立の場合には、ジェスチャーによる端末への情報入力が有効でない(無効化された)状態とされる(Mode-Out状態)。このように、第一の選別条件は、頭部のジェスチャーを参照するか否かを大まかに決定するON-OFFスイッチのように機能する。

頭部が回転方向に激しく運動すれば、回転強度は増大する。回転強度の具体例には、頭部の角速度の定積分値,頭部の加速度の定積分値,端末に対する頭部の相対角速度の定積分値,端末に対する頭部の相対加速度の定積分値などが含まれ、あるいはこれらの定積分値に対応する値が含まれる。本実施形態では、計測装置で計測された角速度(AV,Angular Velocity)についての信号強度面積SMA(AV)に基づいて、回転強度の大きさが判断される。積分区間は、例えば0.1〜数秒の範囲内で適宜設定される。

図1は、本実施形態に係る入力装置の全体構成を示す斜視図である。ここでは、頭部30のジェスチャーを用いて携帯型のタブレット端末10(端末)への入力操作の情報を制御するものを例示する。端末10を操作するユーザーの頭部30には、ヘッドセット型の頭部ガジェット20(ウェアラブルデバイス)が装着される。頭部ガジェット20は、頭部30の動作を検出し、その情報を端末10へと伝達する機能を持つ。頭部30のジェスチャーは、頭部ガジェット20から伝達された情報に基づいて端末10側で認識され、入力操作として解釈されるものとする。

CPU21は、制御ユニット(制御回路)や演算ユニット(演算回路),キャッシュメモリ(レジスタ群)等を内蔵するプロセッサである。また、メモリ22は、プログラムや作業中のデータが一時的に格納される短期記憶素子と、長期的に保持されるデータやプログラムが格納される長期記憶素子とを含む。前者は例えばROM(Read Only Memory),RAM(Random Access Memory)であり、後者は例えばフラッシュメモリやEEPROM(Electrically Erasable Programmable Read-Only Memory)等の不揮発性メモリである。

通信装置24は、端末10との間で通信を行う装置である。頭部IMU23で得られた頭部データは、通信装置24を介してリアルタイムに端末10側へと伝達される。あるいは、メモリ22上に記録されたデータが通信装置24を介して端末10側へと伝達される。通信の種類は任意であり、有線通信であっても無線通信であってもよい。

端末IMU13は、端末10の絶対的な傾きや姿勢,動作などを検出する慣性計測装置であり、端末10の方向(向き),加速度,角速度を計測する。端末IMU13には、ジャイロセンサー13A,加速度センサー13B,地磁気センサー13Cが内蔵され、端末10に固定された座標軸である三軸回りの角速度,三軸方向の加速度,地理座標系を基準とした端末10の向き(姿勢,方位)が検出される。以下、これらのデータを「端末データ」と呼ぶ。端末データは、リアルタイムにCPU11や通信装置14へと伝達される。また、頭部IMU23で得られた頭部データも、通信装置14を介してCPU11へと伝達される。これらの頭部データ及び端末データは、必要に応じてメモリ12上やリムーバブルメディア上に記録される。

データベース16は、動作(ジェスチャー)の特徴とそのジェスチャーに対応する入力操作との対応関係を記憶する記憶装置である。ここには、動作の軌跡の形状や長さ,軌跡を構成する各軌跡点の速度ベクトル,各軌跡点の位置などの組み合わせに対する、コンピューターへの入力操作が予め定義される。ディスプレイ17は、CPU11での演算結果や端末データ,頭部データなどの情報を出力する表示装置である。本実施形態では、頭部30の動作認識に係るデータ区間の選別段階が表示される。例えば、第一の選別条件が成立すると、そのことを示す画像,記号などがディスプレイ17上に表示され、第二,第三の選別条件が判定されている最中であることがユーザーに報知される。なお、このようなユーザーへの報知は、省略してもよい。

図3は、端末10のCPU11で実行される処理内容(プログラム1)を説明するためのブロック図である。これらの処理内容は、例えばアプリケーションプログラムとしてメモリ12の長期記憶素子に記録され、短期記憶素子のメモリ空間内に展開されて実行される。ここで実行される処理内容を機能的に分類すると、このプログラム1には、取得部2,選別部3,確定部4,軌跡・特徴抽出部5,リアルタイム照合・分類部6が設けられる。

取得部2は、端末IMU13から伝達される端末データと頭部IMU23から伝達される頭部データとに基づき、端末10及び頭部30の動作に関する情報を取得するものである。取得部2には、頭部姿勢推定部2A,端末姿勢推定部2B,相対姿勢推定部2Cが設けられる。

頭部姿勢推定部2Aは、頭部データに基づいて地理座標系を基準とした頭部30の姿勢を推定する。頭部30の姿勢(向き)は、地磁気センサー23Cで検出される地磁気方向から推定でき、頭部30の停止時における加速度データからも推定できる。あるいは、ドリフトによるオフセットやノイズの影響が小さければ、角速度の積分値を用いて推定してもよい。頭部姿勢推定部2Aは、頭部30の姿勢を地理座標系に対するピッチ角,ヨー角,ロール角でリアルタイムに算出し、RTC15から出力される時刻情報を付加して相対姿勢推定部2Cに伝達する。なお、地理座標系に対するピッチ角,ヨー角,ロール角の定義は任意に設定可能である。本実施形態では、正面を北向きとした物体の回転運動を基準として東西方向をピッチ角の回転軸方向とし、鉛直上下方向をヨー角の回転軸方向とする。

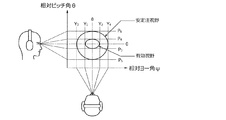

相対姿勢推定部2Cは、端末10及び頭部30の相対的な傾きを推定する。ここでは、ピッチ方向,ヨー方向,ロール方向の三軸についての相対的な傾き(すなわち、相対ピッチ角θ,相対ヨー角ψ,相対ロール角φ)が推定される。相対姿勢推定部2Cは、同一時刻に取得された端末10の傾きと頭部30の傾きとの差分をリアルタイムに算出する。ここで算出された相対的な傾きの情報には時刻情報が付加され、選別部3に伝達される。

選別部3は、取得部で取得された相対的な傾きの情報に基づき、ジェスチャーによる操作入力に対応する動作を選別するものである。選別部3には、ピッチ角範囲判定部3A,有効視野判定部3B,区間候補特定部3Cが設けられる。

=第一の選別条件=

A.相対ピッチ角θが所定値未満である

B.端末10のピッチ角が所定範囲内にある

C.頭部30のピッチ角が所定範囲内にある

=第二の選別条件=

D.参考姿勢を基準として、相対ピッチ角θの変動が第一範囲内

E.参考姿勢を基準として、相対ヨー角ψの変動が第二範囲内

(第一範囲,第二範囲はともに有効視野に対応する範囲)

確定部4は、ジェスチャー区間候補の中から、ジェスチャー動作として認識される動作区間を確定するものである。確定部4には、差分算出部4A,回転強度算出部4B,区間確定部4Cが設けられる。

差分算出部4Aは、「ジェスチャー区間候補」として特定された区間内に取得された角速度の情報に基づき、端末10及び頭部30の角速度の差分(相対角速度)を算出する。ここでは、ピッチ方向,ヨー方向,ロール方向のそれぞれの角速度について、端末IMU13で得られた角速度と頭部IMU23で得られた値との差が算出される。このような差分の算出により、ジャイロセンサー13A,13Bのオフセット(初期姿勢差)が除去される。

ここで、角速度の信号強度面積SMA(AV)の変化を図7に例示する。ジェスチャー動作の入力区間は、信号強度面積SMA(AV)が閾値A0以上となる時刻t3〜t4,時刻t5〜t6,時刻t7〜t8の区間である。これ以外の区間は、仮に何らかの動作がなされているとしても、ジェスチャー動作の入力区間ではないものと判断される。このような判断により、ジェスチャー以外の動作による小さなノイズがフィルタリングされる。その後、入力区間内に含まれる相対ピッチ角θ及び相対ヨー角ψの情報が抽出され、軌跡・特徴抽出部5に伝達される。

軌跡・特徴抽出部5は、確定した入力区間内に含まれる相対ピッチ角θ,相対ヨー角ψに基づき、視線の移動軌跡を算出するものである。ここでは、頭部30の正面前方に仮想キャンバスがあるものと仮定して、仮想キャンバス上での視点(視線と仮想キャンバスとの交点)の移動軌跡が算出される。この算出に際し、入力区間内に含まれる相対ピッチ角θ,相対ヨー角ψの情報は、その入力区間のジェスチャーが認識されるまで、図示しないバッファに記録される。また、相対ピッチ角θの変化量は仮想キャンバス上での視点の垂直移動量に変換され、相対ヨー角ψの変化量は水平移動量に変換される。これらの変換により、図8(A)に示すように、入力区間内における視線の移動軌跡が描出される。また、軌跡・特徴抽出部5は、描出された移動軌跡の特徴を抽出する。ここで抽出される特徴の種類としては、軌跡の形状や長さ,軌跡を構成する各軌跡点の速度ベクトル,各軌跡点の位置などが挙げられる。これらの特徴の情報は、リアルタイム照合・分類部6に伝達される。

また、リアルタイム照合・分類部6は、認識されたジェスチャーに対応する入力操作の情報を出力する。例えば、図8(B)に示すジェスチャーが認識された場合、そのジェスチャーが「右方向への移動」の操作であると解釈される。あるいは、図8(C)に示す場合は、数字の「9」の入力操作であると解釈される。このように解釈された情報は、端末10に対する操作入力としてCPU11へと伝達される。

図9,図10は、端末10におけるジェスチャーの入力方法の手順を説明するためのフローチャートである。これらのフローは、例えばメモリ12や図示しないリムーバブルメディアに記録されたアプリケーションプログラムによる制御手順に対応するものであり、CPU11に読み込まれて所定周期で繰り返し実行される。プログラムの実行周期は、例えば端末IMU13,頭部IMU23における端末データ,頭部データのサンプリングレートに応じた周期(例えば0.01秒以下)とされる。

図9のフローは、ジェスチャー区間候補の特定に関するものであり、第一の選別条件と第二の選別条件とを判定する。このフローでは、相対姿勢フラグFCと回転範囲フラグFRとが用いられる。相対姿勢フラグFCは第一の選別条件が成立しているときにFC=1に設定されるフラグであり、回転範囲フラグFRは第二の選別条件が成立しているときにFR=1に設定されるフラグである。これらのフラグの初期値は0である。

図10のフローは、ジェスチャー区間の確定に関するものであり、第三の選別条件を判定する。このフローは、図9に示すフローに並行して実行される。ステップB1では、相対姿勢フラグFC及び回転範囲フラグFRがともに1に設定されているか否かが判定される。ここでは、第一,第二の選別条件が成立した状態であることが確認される。この条件の不成立時にはステップB2に進み、後述するジェスチャー認識のためにバッファリングされていたデータが消去(クリア)されてこのフローが終了する。一方、この条件の成立時にはステップB3に進む。

ジェスチャーの認識及び出力が完了したステップB11には、相対姿勢フラグFC,回転範囲フラグFR,バッファフラグFBが全て0にリセットされる。また、ステップB12では、その後の新たなジェスチャー入力に備えて、軌跡・特徴抽出部5のバッファが消去(クリア)される。

(1)上記の実施形態〔端末10(入力装置),端末10で実行されるジェスチャーの入力方法(図9,図10に示すフローチャート)及びジェスチャーの入力に係るプログラム1〕では、情報の入力に係る動作が実施された「データ区間(すなわちジェスチャー動作の入力区間)」を確定する際に、端末10及び頭部30の相対的な傾きに基づいて「ジェスチャー区間候補」が特定される。また、特定された「ジェスチャー区間候補」内における頭部30の回転強度に基づいて、最終的な「データ区間」が確定される。

つまり、「ジェスチャー区間候補」の特定には、相対的な傾きの情報が用いられるのに対し、その候補をさらに絞り込んで確定する際には、頭部30の回転運動の激しさを表す回転強度の情報が用いられる。

例えば、ユーザーによる意識的な随意運動と、無意識のうちに生じる不随意動作とを高精度に区別することができ、誤入力の発生確率を大幅に低減させることができる。また、ユーザーに拘束感を与えない自然な小さい頭部30の動きであっても、その動きを入力操作に係るジェスチャーとして判別することができる。

(7)上記の実施形態では、区間確定部4Cにおいて、回転強度が所定強度以上となる期間がジェスチャー動作の入力区間として確定される。このように、回転方向についての運動の激しさを用いることで、頭部30の意識的な動作を精度よく把握することができ、動作の識別精度を向上させることができる。

(9)また、上記の実施形態では、差分算出部4Aで算出された相対角速度を用いて信号強度面積SMA(AV)を算出している。これにより、体動ノイズ(体動アーティファクト,歩行動作や乗り物の揺れなどに起因するノイズ)の影響を除去することができ、動作の識別精度を向上させることができる。

開示の実施形態の一例に関わらず、本実施形態の趣旨を逸脱しない範囲で種々変形して実施することができる。本実施形態の各構成及び各処理は、必要に応じて取捨選択することができ、あるいは適宜組み合わせてもよい。

以上の変形例を含む実施形態に関し、さらに以下の付記を開示する。

[7−1.入力方法]

(付記1)

頭部の動作を用いて端末に情報を入力する入力方法において、

前記端末及び前記頭部の相対的な傾きを取得し、

前記傾きに基づき、前記情報の入力に係る動作を選別し、

選別された前記動作における前記頭部の回転強度を算出し、

前記回転強度に基づき、前記動作の入力区間を確定する

ことを特徴とする、入力方法。

(付記2)

前記端末に対する前記頭部の相対的な回転強度を算出する

ことを特徴とする、付記1記載の入力方法。

前記端末及び前記頭部の相対的なピッチ角が所定値未満の前記動作を選別する

ことを特徴とする、付記1又は2記載の入力方法。

(付記4)

前記端末及び前記頭部の各ピッチ角が所定範囲内にある前記動作を選別する

ことを特徴とする、付記1〜3の何れか1項に記載の入力方法。

前記端末及び前記頭部の相対的なピッチ角及びヨー角の変動が有効視野に対応する範囲内である前記動作を選別する

ことを特徴とする、付記1〜4の何れか1項に記載の入力方法。

(付記6)

前記端末及び前記頭部の相対的なピッチ角及びヨー角に基づき、前記有効視野の基準位置を設定する

ことを特徴とする、付記5記載の入力方法。

前記端末及び前記頭部の相対的なピッチ角の変動が第一範囲内であり、かつ、前記端末及び前記頭部の相対的なヨー角の変動が第二範囲内である前記動作を選別する

ことを特徴とする、付記5又は6記載の入力方法。

(付記8)

前記回転強度が所定強度以上となる期間を前記入力区間とする

ことを特徴とする、付記1〜7の何れか1項に記載の入力方法。

前記頭部の角速度についての信号強度面積(すなわち、前記頭部の角速度の定積分値に対応するパラメーター)を前記回転強度として算出する

ことを特徴とする、付記1〜8の何れか1項に記載の入力方法。

(付記10)

以下の式1を用いて前記信号強度面積を算出する

ことを特徴とする、付記9記載の入力方法。

(付記11)

頭部の動作を用いて端末に情報を入力する入力装置であって、

プロセッサと、

メモリと、

前記端末及び前記頭部の相対的な傾きを取得する取得部と、

前記取得部で取得された前記傾きに基づき、前記情報の入力に係る動作を選別する選別部と、

前記選別部で選別された前記動作における前記頭部の回転強度を算出する算出部と、

前記算出部で算出された前記回転強度に基づき、前記動作の入力区間を確定する確定部と、

を備えたことを特徴とする、入力装置。

(付記12)

前記算出部が、前記端末に対する前記頭部の相対的な回転強度を算出する

ことを特徴とする、付記11記載の入力装置。

前記選別部は、前記端末及び前記頭部の相対的なピッチ角が所定値未満の前記動作を選別する

ことを特徴とする、付記11又は12記載の入力装置。

(付記14)

前記選別部は、前記端末及び前記頭部の各ピッチ角が所定範囲内にある前記動作を選別する

ことを特徴とする、付記11〜13の何れか1項に記載の入力装置。

前記選別部は、前記端末及び前記頭部の相対的なピッチ角及びヨー角の変動が有効視野に対応する範囲内である前記動作を選別する

ことを特徴とする、付記11〜14の何れか1項に記載の入力装置。

(付記16)

前記選別部は、前記端末及び前記頭部の相対的なピッチ角及びヨー角に基づき、前記有効視野の基準位置を設定する

ことを特徴とする、付記15記載の入力装置。

前記選別部は、前記端末及び前記頭部の相対的なピッチ角の変動が第一範囲内であり、かつ、前記端末及び前記頭部の相対的なヨー角の変動が第二範囲内である前記動作を選別する

ことを特徴とする、付記15又は16記載の入力装置。

(付記18)

前記確定部は、前記回転強度が所定強度以上となる期間を前記入力区間とする

ことを特徴とする、付記11〜17の何れか1項に記載の入力装置。

前記算出部が、前記頭部の角速度についての信号強度面積(すなわち、前記頭部の角速度の定積分値に対応するパラメーター)を前記回転強度として算出する

ことを特徴とする、付記11〜18の何れか1項に記載の入力装置。

(付記20)

前記算出部が、上記の式1を用いて前記信号強度面積を算出する

ことを特徴とする、付記19記載の入力装置。

(付記21)

頭部の動作を用いて端末に情報を入力するプログラム〔又は、プログラムを記録したコンピューター読取可能な記録媒体〕において、

前記端末及び前記頭部の相対的な傾きを取得し、

前記傾きに基づき、前記情報の入力に係る動作を選別し、

選別された前記動作における前記頭部の回転強度を算出し、

前記回転強度に基づき、前記動作の入力区間を確定する

処理をコンピューターに実行させるプログラム〔又は、プログラムを記録したコンピューター読取可能な記録媒体〕。

(付記22)

前記端末に対する前記頭部の相対的な回転強度を算出する

処理をコンピューターに実行させる付記21記載のプログラム〔又は、プログラムを記録したコンピューター読取可能な記録媒体〕。

前記端末及び前記頭部の相対的なピッチ角が所定値未満の前記動作を選別する

処理をコンピューターに実行させる付記21又は22記載のプログラム〔又は、プログラムを記録したコンピューター読取可能な記録媒体〕。

(付記24)

前記端末及び前記頭部の各ピッチ角が所定範囲内にある前記動作を選別する

処理をコンピューターに実行させる付記21〜23の何れか1項に記載のプログラム〔又は、プログラムを記録したコンピューター読取可能な記録媒体〕。

前記端末及び前記頭部の相対的なピッチ角及びヨー角の変動が有効視野に対応する範囲内である前記動作を選別する

処理をコンピューターに実行させる付記21〜24の何れか1項に記載のプログラム〔又は、プログラムを記録したコンピューター読取可能な記録媒体〕。

(付記26)

前記端末及び前記頭部の相対的なピッチ角及びヨー角に基づき、前記有効視野の基準位置を設定する

処理をコンピューターに実行させる付記25記載のプログラム〔又は、プログラムを記録したコンピューター読取可能な記録媒体〕。

前記端末及び前記頭部の相対的なピッチ角の変動が第一範囲内であり、かつ、前記端末及び前記頭部の相対的なヨー角の変動が第二範囲内である前記動作を選別する

処理をコンピューターに実行させる付記25又は26記載のプログラム〔又は、プログラムを記録したコンピューター読取可能な記録媒体〕。

(付記28)

前記回転強度が所定強度以上となる期間を前記入力区間とする

処理をコンピューターに実行させる付記21〜27の何れか1項に記載のプログラム〔又は、プログラムを記録したコンピューター読取可能な記録媒体〕。

前記頭部の角速度についての信号強度面積(すなわち、前記頭部の角速度の定積分値に対応するパラメーター)を前記回転強度として算出する

処理をコンピューターに実行させる付記21〜28の何れか1項に記載のプログラム〔又は、プログラムを記録したコンピューター読取可能な記録媒体〕。

(付記30)

上記の式1を用いて前記信号強度面積を算出する

処理をコンピューターに実行させる付記29記載のプログラム〔又は、プログラムを記録したコンピューター読取可能な記録媒体〕。

2 取得部

2A 頭部姿勢推定部

2B 端末姿勢推定部

2C 相対姿勢推定部

3 選別部

3A ピッチ角範囲判定部

3B 有効視野判定部

3C 区間候補特定部

4 確定部

4A 差分算出部

4B 回転強度算出部(算出部)

4C 区間確定部(確定部)

5 軌跡・特徴抽出部

6 リアルタイム照合・分類部

10 端末

13 端末IMU

20 頭部ガジェット

23 頭部IMU

30 頭部

Claims (10)

- 頭部の動作を用いて端末に情報を入力する入力方法において、

前記端末及び前記頭部の相対的な傾きを取得し、

前記傾きに基づき、前記情報の入力に係る動作を選別し、

選別された前記動作における前記頭部の回転強度を算出し、

前記回転強度に基づき、前記動作の入力区間を確定する

ことを特徴とする、入力方法。 - 前記端末に対する前記頭部の相対的な回転強度を算出する

ことを特徴とする、請求項1記載の入力方法。 - 前記端末及び前記頭部の相対的なピッチ角が所定値未満の前記動作を選別する

ことを特徴とする、請求項1又は2記載の入力方法。 - 前記端末及び前記頭部の各ピッチ角が所定範囲内にある前記動作を選別する

ことを特徴とする、請求項1〜3の何れか1項に記載の入力方法。 - 前記端末及び前記頭部の相対的なピッチ角及びヨー角の変動が有効視野に対応する範囲内である前記動作を選別する

ことを特徴とする、請求項1〜4の何れか1項に記載の入力方法。 - 前記端末及び前記頭部の相対的なピッチ角及びヨー角に基づき、前記有効視野の基準位置を設定する

ことを特徴とする、請求項5記載の入力方法。 - 前記端末及び前記頭部の相対的なピッチ角の変動が第一範囲内であり、かつ、前記端末及び前記頭部の相対的なヨー角の変動が第二範囲内である前記動作を選別する

ことを特徴とする、請求項5又は6記載の入力方法。 - 前記回転強度が所定強度以上となる期間を前記入力区間とする

ことを特徴とする、請求項1〜6の何れか1項に記載の入力方法。 - 頭部の動作を用いて端末に情報を入力するプログラムにおいて、

前記端末及び前記頭部の相対的な傾きを取得し、

前記傾きに基づき、前記情報の入力に係る動作を選別し、

選別された前記動作における前記頭部の回転強度を算出し、

前記回転強度に基づき、前記動作の入力区間を確定する

処理をコンピューターに実行させる、プログラム。 - 頭部の動作を用いて端末に情報を入力する入力装置において、

前記端末及び前記頭部の相対的な傾きを取得する取得部と、

前記取得部で取得された前記傾きに基づき、前記情報の入力に係る動作を選別する選別部と、

前記選別部で選別された前記動作における前記頭部の回転強度を算出する算出部と、

前記算出部で算出された前記回転強度に基づき、前記動作の入力区間を確定する確定部と、

を備えたことを特徴とする、入力装置。

Priority Applications (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2014046159A JP6197702B2 (ja) | 2014-03-10 | 2014-03-10 | 入力方法,プログラム及び入力装置 |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2014046159A JP6197702B2 (ja) | 2014-03-10 | 2014-03-10 | 入力方法,プログラム及び入力装置 |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2015170257A JP2015170257A (ja) | 2015-09-28 |

| JP6197702B2 true JP6197702B2 (ja) | 2017-09-20 |

Family

ID=54202900

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2014046159A Expired - Fee Related JP6197702B2 (ja) | 2014-03-10 | 2014-03-10 | 入力方法,プログラム及び入力装置 |

Country Status (1)

| Country | Link |

|---|---|

| JP (1) | JP6197702B2 (ja) |

Families Citing this family (6)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2017134630A (ja) * | 2016-01-28 | 2017-08-03 | セイコーエプソン株式会社 | 表示装置、表示装置の制御方法、及び、プログラム |

| JP2018530016A (ja) * | 2016-08-30 | 2018-10-11 | 北京小米移動軟件有限公司Beijing Xiaomi Mobile Software Co.,Ltd. | Vr制御方法、装置及び電子機器、プログラム、及び記録媒体 |

| FR3059415B1 (fr) * | 2016-11-29 | 2020-06-26 | Airbus Operations | Procede et systeme de determination de l'attitude et de la position de la tete d'un pilote d'aeronef. |

| CN109917909B (zh) * | 2019-02-01 | 2022-05-31 | 成都思悟革科技有限公司 | 基于非传播电磁场的多点接收阵列的动作捕捉装置及方法 |

| US10989916B2 (en) * | 2019-08-20 | 2021-04-27 | Google Llc | Pose prediction with recurrent neural networks |

| TWI779481B (zh) * | 2021-02-05 | 2022-10-01 | 洛克火箭股份有限公司 | 以智能戒指實現的無線控制系統其無線控制方法 |

Family Cites Families (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2010231290A (ja) * | 2009-03-26 | 2010-10-14 | National Institute Of Advanced Industrial Science & Technology | 頭部運動による入力装置及び方法 |

| JP5757791B2 (ja) * | 2011-06-03 | 2015-07-29 | オリンパス株式会社 | 入力システム、頭部装着型表示装置、情報端末装置及びプログラム |

| US8879801B2 (en) * | 2011-10-03 | 2014-11-04 | Qualcomm Incorporated | Image-based head position tracking method and system |

| US20130342672A1 (en) * | 2012-06-25 | 2013-12-26 | Amazon Technologies, Inc. | Using gaze determination with device input |

-

2014

- 2014-03-10 JP JP2014046159A patent/JP6197702B2/ja not_active Expired - Fee Related

Also Published As

| Publication number | Publication date |

|---|---|

| JP2015170257A (ja) | 2015-09-28 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| US12002232B2 (en) | Systems and methods for simultaneous localization and mapping | |

| JP6197702B2 (ja) | 入力方法,プログラム及び入力装置 | |

| US11079860B2 (en) | Kinematic chain motion predictions using results from multiple approaches combined via an artificial neural network | |

| KR101872907B1 (ko) | 듀얼 스마트 밴드를 이용한 모션 분석 장치 및 방법 | |

| KR102245267B1 (ko) | 서명 등록 방법, 서명 인증 방법 및 그 장치 | |

| KR102207510B1 (ko) | 모션 신호와 마우스 신호를 사용하여 호스트 장치를 제어하기 위한 전자 장치 | |

| US9354712B2 (en) | Recognition device, intelligent device and information providing method for human machine interaction | |

| JP6011127B2 (ja) | 行為検出プログラム及び行為検出装置 | |

| JP2017191426A (ja) | 入力装置、入力制御方法、コンピュータプログラム、及び記憶媒体 | |

| US20240393877A1 (en) | Information processing system and information processing method | |

| US12244960B2 (en) | Information display system, information display method, and non-transitory recording medium | |

| US10678337B2 (en) | Context aware movement recognition system | |

| US20250190057A1 (en) | Method and apparatus for user-defined gesture profile generation and gesture recognition, based on repeated motion of user | |

| KR20220131658A (ko) | 기계 학습에 기반하여 호스트 장치를 제어하기 위한 모션 신호를 결정하는 웨어러블 디바이스 | |

| US10156907B2 (en) | Device for analyzing the movement of a moving element and associated method | |

| KR102901144B1 (ko) | 카메라 기반 관절 움직임 트래킹과 센서에 기반한 모션 트래킹 방법 및 시스템 | |

| US12386415B2 (en) | Information processing apparatus for achieving cross reality, control method therefor, and storage medium storing control program therefor | |

| KR101499044B1 (ko) | 사용자의 손동작 및 음성에 기초하여 사용자가 의도한 텍스트를 취득하는 웨어러블 컴퓨터 및 사용자가 의도한 텍스트를 취득하는 방법 | |

| Noh et al. | Description and recognition based on directional motion vector for spatial hand gestures | |

| CN120161936A (zh) | 设备控制方法、装置、存储介质及智能穿戴设备 | |

| CN118509695A (zh) | 摄像组件的启动方法、装置、头戴式设备及存储介质 | |

| CN119781656A (zh) | 智能设备的界面切换方法、装置、计算机设备和存储介质 | |

| CN121330038A (zh) | 使用者识别装置、方法及其非暂态电脑可读取存储介质 | |

| CN113031753A (zh) | 运动传感数据产生方法和运动传感数据产生系统 | |

| CN112560565A (zh) | 人类行为理解系统及人类行为理解方法 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20161102 |

|

| TRDD | Decision of grant or rejection written | ||

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20170719 |

|

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20170725 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20170807 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 6197702 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 |

|

| LAPS | Cancellation because of no payment of annual fees |