JP6025519B2 - Image processing apparatus and image processing method - Google Patents

Image processing apparatus and image processing method Download PDFInfo

- Publication number

- JP6025519B2 JP6025519B2 JP2012255530A JP2012255530A JP6025519B2 JP 6025519 B2 JP6025519 B2 JP 6025519B2 JP 2012255530 A JP2012255530 A JP 2012255530A JP 2012255530 A JP2012255530 A JP 2012255530A JP 6025519 B2 JP6025519 B2 JP 6025519B2

- Authority

- JP

- Japan

- Prior art keywords

- image

- shadow

- stereoscopic

- virtual object

- data

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

Images

Description

本発明は立体像表示技術における画像処理に関する。 The present invention relates to image processing in stereoscopic image display technology.

従来、コンピュータグラフィックスによって表現された仮想物体の影を作成する方法としては、現実空間を撮像した画像上に、その撮像シーンの光源環境を用いて仮想物体とその影を合成する画像合成技術が知られている(例えば、特許文献1)。この画像合成技術は、現実空間の複数の位置について設定された光のパラメータの中から、仮想物体が置かれた位置に対応するものを参照することで、現実空間における光源環境を適正に反映した影を画像内に作成するものであった。 Conventionally, as a method of creating a shadow of a virtual object represented by computer graphics, there is an image composition technique for synthesizing a virtual object and its shadow on an image obtained by capturing a real space by using a light source environment of the imaging scene. Known (for example, Patent Document 1). This image composition technology appropriately reflects the light source environment in the real space by referring to the light parameters set for a plurality of positions in the real space corresponding to the positions where the virtual objects are placed. A shadow was created in the image.

しかしながら、上記従来技術は、あくまで画像内に仮想物体の影を作成するものである。現在、両眼視差を利用して観察者に立体像を知覚させる3D画像表示技術が普及している。この技術は、同一の仮想物体に関して両眼の視差の分だけ見え方の異なる画像(視差画像)を左右それぞれの眼に別個に提示することにより立体像を知覚させる技術である。このような画面から飛び出して見える立体像によって生じるべき影を、現実空間における床や壁などに作成することは、上記従来技術では不可能である。 However, the above-described conventional technique only creates a shadow of a virtual object in an image. Currently, 3D image display technology that allows a viewer to perceive a stereoscopic image using binocular parallax has become widespread. This technique is a technique for perceiving a three-dimensional image by separately presenting to the left and right eyes images (parallax images) that differ in appearance by the amount of parallax between both eyes with respect to the same virtual object. It is impossible with the above-described conventional technology to create a shadow to be generated by a stereoscopic image that appears to jump out of such a screen on a floor or a wall in a real space.

本発明に係る画像処理装置は、視差画像を表示することにより仮想物体の立体像を観察者に知覚させる場合における、当該立体像の擬似的な影を現実空間に作成するための陰影画像を、前記仮想物体の位置及び形状を特定するデータと、前記陰影画像を現実空間に投影する画像投影手段による投影領域の位置と大きさを示す情報とに基づいて生成する、ことを特徴とする。 The image processing apparatus according to the present invention, when displaying a parallax image to make an observer perceive a stereoscopic image of a virtual object, creates a shadow image for creating a pseudo shadow of the stereoscopic image in a real space. It is generated based on data specifying the position and shape of the virtual object, and information indicating the position and size of the projection area by the image projection means for projecting the shadow image onto the real space.

本発明によれば、視差画像によって生み出される立体像の擬似的な影等を現実空間に作成することができる。これにより、映像の臨場感が向上する。 According to the present invention, a pseudo shadow or the like of a stereoscopic image generated by a parallax image can be created in a real space. Thereby, the realistic sensation of the video is improved.

[実施例1]

実施例1では、仮想物体の位置および形状を表すモデルデータを立体像の位置情報として取得し、この位置情報に応じた陰影画像を生成して、生成された陰影画像を現実空間に投影することで、立体像の擬似的な影を現実空間に作成する態様について説明する。

[Example 1]

In the first embodiment, model data representing the position and shape of a virtual object is acquired as position information of a stereoscopic image, a shadow image corresponding to this position information is generated, and the generated shadow image is projected onto a real space. Now, an aspect of creating a pseudo shadow of a stereoscopic image in the real space will be described.

図1は、本実施例に係る立体像表示システム100のシステム構成例を示す図である。立体像表示システム100は、陰影画像の生成処理などを行う画像処理装置101、立体像表示装置としての液晶3Dディスプレイ102、画像投影装置としての液晶プロジェクタ103で構成される。

FIG. 1 is a diagram illustrating a system configuration example of a stereoscopic

本実施例の画像処理装置101は、モデルデータを用いて、左眼用画像と右眼用画像とからなる視差画像を生成する。生成された視差画像のデータは液晶3Dディスプレイ102によって表示され、これにより仮想物体の立体像104が表示される。また、画像処理装置101は、モデルデータに応じた陰影画像105を生成する。生成された陰影画像のデータは液晶プロジェクタ103によって現実空間の床に投影され、これにより立体像の擬似的な影が作成される。

The

なお、以下では、本実施例中で用いる3次元座標の原点を液晶3Dディスプレイ102の画面中心Oとし、x軸、y軸、z軸をそれぞれ液晶3Dディスプレイ102の水平方向、鉛直方向、法線方向として説明する。

In the following, the origin of the three-dimensional coordinates used in this embodiment is the screen center O of the liquid

図2は、画像処理装置101の内部構成を示す図である。

FIG. 2 is a diagram illustrating an internal configuration of the

画像処理装置101は、CPU201、RAM202、ROM203、ハードディスクドライブ(HDD)204、HDDI/F205、入力I/F206、出力I/F207、システムバス208で構成される。

The

CPU201は、RAM202をワークメモリとして、ROM203及びHDD204に格納されたプログラムを実行し、システムバス208を介して後述する各構成を統括的に制御する。これにより、後述する様々な処理が実行される。

The

HDDI/F205は、例えばシリアルATA(SATA)等のインタフェイスであり、二次記憶装置としてのHDD204を接続する。CPU201は、HDDI/F205を介してHDD204からのデータ読み出し、およびHDD204へのデータ書き込みが可能である。さらにCPU201は、HDD204に格納されたデータをRAM202に展開し、同様に、RAM202に展開されたデータをHDD204に保存することが可能である。そしてCPU201は、RAM202に展開したデータをプログラムとみなし、実行することができる。なお、二次記憶装置はHDDの他、光ディスクドライブ等の記憶デバイスでもよい。

The HDD I / F 205 is an interface such as serial ATA (SATA), for example, and connects the

入力I/F206は、例えばUSBやIEEE1394等のシリアルバスインタフェイスである。入力I/F206は、キーボード・マウス209などの各種入力デバイスや、赤外線や電磁波などを用いた位置センサ210を接続する。CPU201は、入力I/F206を介してキーボード・マウス209や位置センサ210から様々なデータを取得することが可能である。

The input I / F 206 is a serial bus interface such as USB or IEEE1394. The input I / F 206 connects various input devices such as a keyboard /

出力I/F207は、例えばDVIやHDMI等の映像出力インタフェイスであり、液晶3Dディスプレイ102およびプロジェクタ103を接続する。この出力I/F207を介して、液晶3Dディスプレイ102に視差画像データが送られ、液晶プロジェクタ103に陰影画像データが送られる。視差画像データを受け取った液晶3Dディスプレイ102は、その画面上に視差画像を表示する。(以後、立体像表示装置における視差画像が表示される画面領域を「立体像表示領域」と呼ぶ。)また、陰影画像データを受け取った液晶プロジェクタ103は、現実空間の床などに陰影画像を投影する。

The output I /

なお、図1に示すシステムでは立体像表示装置として液晶3Dディスプレイ102を用いているが、これに限られない。例えば、液晶3Dディスプレイに代えてプラズマ3Dディスプレイや有機EL3Dディスプレイを用いてもよい。また、画像投影装置として液晶プロジェクタ103を用いているが、DLPプロジェクタやLCOSプロジェクタであっても構わない。

In the system shown in FIG. 1, the liquid

図3は、本実施例に係る画像処理装置101の機能ブロック図である。画像処理装置101は、視点位置情報取得部301、表示領域情報取得部302、モデルデータ取得部303、投影特性情報取得部304、視差画像生成部305、投影画像生成部306で構成される。

FIG. 3 is a functional block diagram of the

視点位置情報取得部301は、観察者の左右の眼の位置を示す情報(以下、「視点位置情報」と呼ぶ。)を取得する。本実施例では、観察者の左右の眼の位置を示す3次元座標EL(xL0,yL0,zL0)、ER(xR0,yR0,zR0)が、例えば位置センサ210を介して取得される。或いは、観察者の顔を撮像する複数のカメラを別途用意し、得られた複数の顔画像に対し顔認識技術を用いて画像上における眼の位置を求め、得られた画像上の眼の位置と撮像したカメラの姿勢情報とに基づいて、左右の眼の3次元座標を導出してもよい。取得した視点位置情報は、視差画像生成部305に送られる。

The viewpoint position

表示領域情報取得部302は、立体像表示装置(ここでは、液晶3Dディスプレイ102)における立体像表示領域のサイズ(W×H)の情報(以下、「表示領域情報」と呼ぶ。)を取得する。立体像表示領域のサイズは、例えば、16:9の50インチのディスプレイの場合であれば、W:110cm、H:62cm、のような値となる。この表示領域情報の取得は、例えばキーボード・マウス209等を介したユーザ入力によって行ってもよいし或いは予めHDD204などに記憶しておきそれを読み込むことで取得してもよい。取得した表示領域情報は、視差画像生成部305に送られる。

The display area

モデルデータ取得部303は、立体像として表示される仮想物体の位置および形状を特定するモデルデータを、HDDI/F205を介してHDD204などの二次記憶装置から取得する。本実施例におけるモデルデータはメッシュデータとする。ここで、メッシュデータとは、複数の辺を有する板状の要素の集合で物体の形状を表現するメッシュモデルの表示に必要なデータ(例えば四辺形の各頂点の座標データ等)のことである。モデルデータのデータ形式は、仮想物体の位置と形状を特定できるものであればよく、例えば、NURBS曲面などで表現されるパラメトリックモデルでもよい。さらに、モデルデータは、仮想物体の反射率、透過率、屈折率など、仮想物体の色や質感を表す情報を含んでいてもよい。本実施例では、モデルデータは立体像の位置情報として用いられる。取得したモデルデータは、視差画像生成部305及び投影画像生成部306へ送られる。

The model

投影特性情報取得部304は、陰影画像を投影する画像投影装置(ここでは液晶プロジェクタ103)の投影領域の位置と大きさを示す投影特性の情報を取得する。本実施例では、液晶プロジェクタ103の位置を示す3次元座標P0(x0,y0,z0)、液晶プロジェクタ103の光軸が通過する点P1(x1,y1,z1)、水平画角θ、垂直画角ψ、水平解像度Wp、垂直解像度Hpを投影特性として用いている。この投影特性情報は、予め測定して得られたデータをHDD204等に記憶しておき、処理実行時にHDDI/F205を介して読み込んで取得する。或いは、液晶プロジェクタ103に別途位置センサや傾きセンサを取り付け、入力I/F206を介して位置や向きを取得してもよいし、液晶プロジェクタ103から双方向通信可能な出力I/F207を介して画角を取得してもよい。取得した投影特性情報は、投影画像生成部306へ送られる。

The projection characteristic

視差画像生成部305は、受け取った視点位置情報、表示領域情報及びモデルデータを用いて、互いに視差のある左眼用画像と右眼用画像とからなる視差画像を生成する。生成された視差画像のデータは液晶3Dディスプレイ102に送られる。

The parallax

投影画像生成部305は、受け取ったモデルデータ及び投影特性情報を用いて、投影の対象となる画像(ここでは陰影画像)を生成する。生成された陰影画像のデータは液晶プロジェクタ103に送られる。

The projection

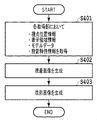

図4は、本実施例に係る画像処理装置101における一連の処理の流れを示すフローチャートである。なお、この一連の処理は、以下に示す手順を記述したコンピュータ実行可能なプログラムを、ROM203あるいはHDD204からRAM202上に読み込んだ後、該プログラムがCPU201で実行されることによって実現される。

FIG. 4 is a flowchart showing a flow of a series of processes in the

ステップ401において、各取得部301〜304は、上述した視点位置情報、表示領域情報、モデルデータ、投影特性情報を、それぞれHDD204等から取得する。取得された各情報は、上述のとおり視差画像生成部305及び/又は投影画像生成部306に送られる。

In step 401, the

ステップ402において、視差画像生成部305は、受け取った視点位置情報、表示領域情報及びモデルデータを用いて視差画像を生成する。具体的には、視点位置情報によって示される左右それぞれの眼の位置から、表示領域情報によって示される立体像表示領域越しに見える仮想空間のシーンをレンダリングして、視差画像を生成する。本実施例においては、レンダリングに用いる仮想カメラの位置を観察者の視点位置とする。また、仮想カメラの光軸方向は、観察者の視点位置を通り立体像表示領域に垂直なベクトルと一致するものとする。図5の(a)は現実空間における観察者の視点位置と立体表示領域(液晶3Dプロジェクタ102)との関係を示しており、同(b)は仮想空間における観察者の視点位置と立体表示領域との関係を示している。モデルデータにより示される仮想物体501が配置された仮想空間中において、観察者の視点位置(左眼:EL、右眼:ER)から立体像表示領域の四隅(r0〜r3)へ向かう4つのベクトルで囲まれる範囲をレンダリングする。このように、観察者の右眼と左眼それぞれの位置を視点位置としてレンダリング処理を行うことで、互いに視差のある左眼用画像と右眼用画像とからなる視差画像が生成される。図6は、仮想物体501が配置された視差画像の一例を示す図であり、(a)は左眼用画像、(b)は右眼用画像を示している。生成された視差画像のデータは液晶3Dディスプレイ102に送られる。上記のようにして得られた視差画像を所定の3D画像表示方式に従って液晶3Dディスプレイで表示することで、現実空間において、モデルデータで示された所定の位置に仮想物体の立体像が存在するように観察者に知覚させることができる。

In

ステップ403において、投影画像生成部306は、受け取ったモデルデータ内のメッシュデータ及び投影特性情報を用いて陰影画像を生成する。以下、液晶プロジェクタ103の解像度と同じ解像度(Wp×Hp:例えば、1920×1080)の陰影画像fを、256階調のグレイスケール画像として生成する場合を例に詳しく説明する。図7は陰影画像の生成過程を説明する図であり、(a)は斜め上方から見た場合、(b)は−x方向から見た場合(x0=x1)をそれぞれ示している。

In step 403, the projection

まず、Wp×Hp画素の陰影画像fについて、画素値をすべて255に初期化する。そして、液晶プロジェクタ103の位置を示す点P0(x0,y0,z0)から陰影画像平面701上の任意の点Qを通って延びる直線Lが、仮想物体の表面形状を表す板状の要素(以下、単に「メッシュ」と呼ぶ)702と交差するか否かを判定する。直線Lがメッシュ702と交差すると判定された場合には当該点Qに対応する陰影画像f上の画素の画素値を0等に設定し、影部分を示す黒画素等とする。一方、交差しないと判定された場合には当該点Qに対応する陰影画像f上の画素値は初期値(すなわち、255)のままとする。交差しないと判定された場合において、当該点Qに対応する陰影画像f上の画素値を、0以外の所定の値(例えば、メッシュが存在する仮想空間や陰影画像が投影される現実空間における照度等の照明条件に応じて決定)としてもよい。ここで、陰影画像平面とは、その中心において液晶プロジェクタ103の光軸(すなわち、直線P0-P1)と直交する仮想的な平面である。液晶プロジェクタ103の光軸と陰影画像平面701との交点を原点、液晶プロジェクタの水平方向を横軸s、鉛直方向を縦軸tとすると、陰影画像fの画素(u,v)に対応する陰影画像平面上の点Qの座標(s,t)は次の式(1)及び式(2)で求められる。

First, for the shadow image f of Wp × Hp pixels, all pixel values are initialized to 255. A straight line L extending from an arbitrary point Q on the

ここで、Dは点P0(x0,y0,z0)から陰影画像平面701までの距離である。また、θは点P0(x0,y0,z0)と横軸s上の陰影画像平面の端点701a/701cとをそれぞれ結ぶ線分間のなす角度、ψは点P0(x0,y0,z0)と横軸s上の陰影画像平面の端点701b/701dとをそれぞれ結ぶ線分間のなす角度である。

Here, D is the distance from the point P0 (x0, y0, z0) to the

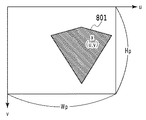

陰影画像fの全画素について、上記式(1)および(2)を用いて対応する点Qを求め、仮想物体の表面形状を表すメッシュ702との交差判定を行って画素値を設定することで、陰影画像fが得られる。図8は、上述した処理によって得られる陰影画像fの一例であり、立体像の対応する領域801(画素値が0等の領域)が陰影となる部分として存在している。このようにして生成された陰影画像のデータは液晶プロジェクタ103に出力され、現実空間の床などに立体像の影として投影される。

For all the pixels of the shaded image f, the corresponding points Q are obtained using the above formulas (1) and (2), intersection determination with the

この場合において、液晶プロジェクタ103と立体像との間に実物体(例えば、観察者の体の一部など)が存在する場合には、実物体の影になるメッシュに対しては影を生成しないことが望ましい。例えば、液晶プロジェクタ103の光軸に沿った距離センサを別途用意して実物体までの距離を取得し、実物体の手前(実物体よりも液晶プロジェクタ103に近い位置)に存在するメッシュに対してのみ上述の交差判定を行って陰影画像を生成すればよい。これにより実物体上に不要な影が生じるのを防止できる。

In this case, when a real object (for example, a part of the observer's body) exists between the

なお、本実施例では仮想物体によって生み出される影を現実空間に投影する例を説明したが、例えば仮想物体により生じる擬似的な集光模様の画像を生成し、これを現実空間に投影してもよい。この場合には、投影画像生成部306は、モデルデータに含まれる仮想物体の反射率、透過率、屈折率など、仮想物体の色や質感を表す光学特性を示す情報を利用して、集光模様画像を生成することになる。具体的には、上述のステップ403において、直線Lが仮想物体内を通過する区間を求め、その距離や仮想物体の屈折率等に基づいて透過光の強度を導出し、得られる強度に応じた値で画素値を置き換えた集光模様画像(上述の陰影画像fに相当)を求めればよい。また、集光模様画像をカラー画像で生成し、透過光の強度の導出を光の波長毎に行って画素値を決定することで、より精巧な集光模様とすることができる。

In this embodiment, the example in which the shadow generated by the virtual object is projected onto the real space has been described. However, for example, a pseudo-condensing pattern image generated by the virtual object is generated and projected onto the real space. Good. In this case, the projection

以上のとおり、本実施例によれば、画面から飛び出して見える仮想物体の影等を現実空間に生じさせすることが可能となる。 As described above, according to the present embodiment, it is possible to cause a shadow or the like of a virtual object that appears to jump out of the screen in the real space.

[実施例2]

実施例1では、立体像として表示される仮想物体の位置および形状を特定するモデルデータを取得し、モデルデータで特定された立体像の位置に応じた影等を現実空間に生じさせるための陰影画像等を生成した。次に、視差画像データと観察者の視点位置情報から立体像の位置を導出して、陰影画像等を生成する態様について、実施例2として説明する。なお、実施例1と共通する部分については説明を簡略化ないしは省略し、ここでは差異点を中心に説明することとする。

[Example 2]

In the first embodiment, model data for specifying the position and shape of a virtual object displayed as a three-dimensional image is acquired, and a shadow for causing a shadow or the like according to the position of the three-dimensional image specified by the model data in the real space. Images etc. were generated. Next, an embodiment in which the position of the stereoscopic image is derived from the parallax image data and the viewpoint position information of the observer to generate a shadow image or the like will be described as a second embodiment. Note that description of parts common to the first embodiment is simplified or omitted, and here, differences will be mainly described.

図9は、本実施例に係る画像処理装置101の機能ブロック図である。なお、立体像表示システムのシステム構成は実施例1と共通であるものとする。

FIG. 9 is a functional block diagram of the

視差画像データ取得部901は、視差画像のデータを、HDDI/F205を介してHDD204などの二次記憶装置から取得する。この場合の視差画像データは、例えば多眼カメラ等で撮像して得たものでもよいし、或いは市販されている3D画像生成ソフトウェアを使って生成したものでもよい。取得した視差画像データは、立体像位置導出部905及び立体像表示装置としての液晶3Dディスプレイ102に送られる。

The parallax image

表示領域情報取得部902は、立体像表示装置の表示領域情報を取得する。これについては実施例1に係る表示領域情報取得部302と同じである。取得した表示領域情報は、立体像位置導出部905に送られる。

The display area

視点位置情報取得部903は、観察者の視点位置情報を取得する。これについては実施例1に係る視点位置情報取得部301と同じである。取得した視点位置情報は、立体像位置導出部905に送られる。

The viewpoint position

投影特性情報取得部904は、画像投影装置の投影特性情報を取得する。これについては実施例1に係る投影特性情報取得部304と同じである。取得した投影特性情報は、投影画像生成部906に送られる。

The projection characteristic

立体像位置導出部905は、受け取った視差画像データ、表示領域情報及び視点位置情報に基づき、立体像として表示される仮想物体の位置及び形状を特定可能なデータ(ここでは、前述のメッシュデータ)を生成する。

The three-dimensional image

投影画像生成部906は、立体像位置導出部905から受け取ったメッシュデータおよび投影特性取得部904から受け取った画像投影装置の投影特性情報を用いて、陰影画像を生成する。生成された陰影画像データは、液晶プロジェクタ103に送られる。

The projection

図10は、本実施例に係る画像処理装置101における一連の処理の流れを示すフローチャートである。

FIG. 10 is a flowchart illustrating a flow of a series of processes in the

ステップ1001において、各取得部901〜904は、上述した視差画像データ、表示領域情報、視点位置情報、投影特性情報を、それぞれHDD204等から取得する。取得された視差画像データ及び各情報は、上述のとおり立体像位置導出部905又は投影画像生成部906に送られる。

In step 1001, each

ステップ1002において、立体像位置導出部905は、受け取った視差画像データ、表示領域情報及び視点位置情報に基づいて、立体像として表示される仮想物体の位置を導出する。ここで、別フローチャートを用いて詳しく説明する。図11は、この立体像の位置を導出する処理の流れを示すフローチャートである。また、図12は、立体像の位置が導出される過程を説明する図である。

In step 1002, the stereoscopic image

ステップ1101において、立体像位置導出部905は、視差画像データに含まれる左眼用画像と右眼用画像との間で各画素の対応付けを行う。具体的には、以下のとおりである。まず、左眼用画像gL上の注目画素(uL,vL)とその近傍画素とからなる領域画像をテンプレートとする。そして、このテンプレートを用いたパターンマッチングを右眼用画像gRに対して行い、注目画素(uL,vL)に対する右眼用画像gR上の対応画素(uR,vR)を求める。この処理を左眼用画像gL上の各画素に対して行い、全ての画素について右眼用画像gR上の画素との対応付けを行う。

In

ステップ1102において、立体像位置導出部905は、左眼用画像と右眼用画像との間で対応付けた画素のペア(uL,vL)と(uR,vR)について、液晶3Dディスプレイ102で表示する場合の表示画面上の画素位置を導出する。具体的には、画素位置を示す3次元座標PL(xL1,yL1,zL1)およびPR(xR1,yR1,zR1)を、次の式(3)及び式(4)に従って求める。

In step 1102, the stereoscopic image

ここで、W及びHは表示領域情報で示される液晶3Dディスプレイ102における横及び縦のサイズ(cm)であり、Wg及びHgは視差画像における横方向と縦方向の画素数である。

Here, W and H are horizontal and vertical sizes (cm) in the liquid

ステップ1103において、立体像位置導出部905は、ステップ1102で得られた立体表示装置の画面上の画素位置の情報とステップ1003で取得された観察者の視点位置情報とを用いて、立体像の位置を求める。具体的には、立体表示装置の画面上の画素位置を示す3次元座標PL(xL1,yL1,zL1)/PR(xR1,yR1,zR1)と、観察者の左右の眼の位置を示す3次元座標EL(xL0,yL0,zL0)/ER(xR0,yR0,zR0)とから、ELとPLとを結ぶ直線(直線EL-PL)とERとPRとを結ぶ直線(直線ER-PR)との交点P(x,y,z)を求める。この交点P(x,y,z)の座標が、視差画像間で対応付けた画素のペア(uL,vL)と(uR,vR)により形成される立体像の位置を示す頂点座標に相当する。

In step 1103, the stereoscopic image

この場合において、直線EL-PLと直線ER-PRとが互いに平行である場合には、奥行きが無限遠の位置に像が形成されると見做し、後述の陰影画像生成処理の対象外とする。また、直線EL-PLと直線ER-PRとが同一平面上に存在しない場合には、2点間の距離が最小となる直線EL-PL上の点P'Lと直線ER-PR上の点P'Rを求め、これら2点の中点を2直線の交点と見做せばよい。 In this case, when the straight line EL-PL and the straight line ER-PR are parallel to each other, it is considered that an image is formed at a position where the depth is infinite, and is not subject to the shadow image generation processing described later. To do. If the straight line EL-PL and the straight line ER-PR do not exist on the same plane, the point P'L on the straight line EL-PL and the point on the straight line ER-PR that minimize the distance between the two points Find P'R and consider the midpoint of these two points as the intersection of two straight lines.

以上の処理を全ての画素のペアについて行い、立体像を構成する頂点座標群を得る。 The above processing is performed for all pixel pairs to obtain vertex coordinate groups constituting a stereoscopic image.

ステップ1104において、立体像位置導出部905は、得られた頂点座標群に公知の表面形状復元技術やテセレーション技術を適用して立体像の表面形状を推定し、立体像として表示される仮想物体の位置を特定可能なメッシュデータを生成する。

In

本実施例では、以上のようにして得られたメッシュデータを立体像の位置情報として用いて、陰影画像の生成がなされる。 In the present embodiment, a shadow image is generated using the mesh data obtained as described above as the position information of the stereoscopic image.

図10のフローチャートの説明に戻る。 Returning to the flowchart of FIG.

ステップ1003において、視差画像データ取得部901は、取得した視差画像のデータを液晶3Dディスプレイ102に出力する。そして、液晶3Dディスプレイ102によって、視差画像データに従った立体像が表示される。

In

ステップ1004において、投影画像生成部906は、ステップ1001で取得された画像投影装置の投影特性情報及びステップ1002で生成されたメッシュデータを用いて陰影画像を生成する。陰影画像生成の詳細については、実施例1に係る図4のフローチャートのステップ403で述べたとおりである。

In

このようにして生成された陰影画像のデータは、実施例1と同様に液晶プロジェクタ103に出力され、陰影画像データに従った仮想物体の影が現実空間の床などに投影されることになる。

The shadow image data generated in this way is output to the

(その他の実施形態)

また、本発明の目的は、以下の処理を実行することによっても達成される。即ち、上述した実施形態の機能を実現するソフトウェアのプログラムコードを記録した記憶媒体を、システム或いは装置に供給し、そのシステム或いは装置のコンピュータ(またはCPUやMPU等)が記憶媒体に格納されたプログラムコードを読み出す処理である。この場合、記憶媒体から読み出されたプログラムコード自体が前述した実施の形態の機能を実現することになり、そのプログラムコード及び該プログラムコードを記憶した記憶媒体は本発明を構成することになる。

(Other embodiments)

The object of the present invention can also be achieved by executing the following processing. That is, a storage medium that records a program code of software that realizes the functions of the above-described embodiments is supplied to a system or apparatus, and a computer (or CPU, MPU, etc.) of the system or apparatus is stored in the storage medium. This is the process of reading the code. In this case, the program code itself read from the storage medium realizes the functions of the above-described embodiments, and the program code and the storage medium storing the program code constitute the present invention.

Claims (12)

前記画像投影手段の位置を示す点と前記画像投影手段の光軸と直交する仮想的な平面上の任意の点とを結ぶ直線が、前記メッシュデータで特定される仮想物体の表面形状を示す板状の要素と交差するかどうかを判定し、交差すると判定された場合に、当該交差する点に対応する画素を、影部分を示す画素とすることで前記陰影画像を生成する

ことを特徴とする請求項1に記載の画像処理装置。 The data specifying the position and shape of the virtual object is mesh data,

A plate in which a straight line connecting a point indicating the position of the image projecting unit and an arbitrary point on a virtual plane orthogonal to the optical axis of the image projecting unit indicates the surface shape of the virtual object specified by the mesh data It is determined whether or not to intersect with an element of a shape, and when it is determined to intersect, the shadow image is generated by setting a pixel corresponding to the intersecting point as a pixel indicating a shadow portion. The image processing apparatus according to claim 1.

取得した前記視差画像のデータ、前記視差画像を表示する立体像表示手段における表示領域のサイズを示す情報及び前記観察者の視点位置を示す情報に基づいて、前記メッシュデータを生成する手段と、

をさらに備えたことを特徴とする請求項2又は3に記載の画像処理装置。 Means for acquiring data of the parallax image;

Means for generating the mesh data based on the acquired parallax image data, information indicating the size of the display area in the stereoscopic image display means for displaying the parallax image, and information indicating the viewpoint position of the observer;

The image processing apparatus according to claim 2, further comprising:

前記メッシュデータを生成する手段は、前記左眼用画像と前記右眼用画像とを対応付け、対応付けられた画素のペアについて前記立体像表示手段の表示画面上の画素位置を導出し、導出された画素位置及び前記観察者の視点位置を示す情報から前記立体像を構成する頂点座標群を得て、得られた頂点座標群を用いて前記立体像の表面形状を推定することにより、前記メッシュデータを生成することを特徴とする請求項5に記載の画像処理装置。 The parallax image is composed of an image for the left eye and an image for the right eye,

The means for generating the mesh data associates the image for the left eye with the image for the right eye, derives a pixel position on the display screen of the stereoscopic image display means for the associated pixel pair, and derives By obtaining a vertex coordinate group constituting the stereoscopic image from the information indicating the pixel position and the observer's viewpoint position, and estimating the surface shape of the stereoscopic image using the obtained vertex coordinate group, The image processing apparatus according to claim 5, wherein mesh data is generated.

前記視差画像を表示する立体像表示手段と、

前記陰影画像を現実空間に投影する画像投影手段と、

を含むことを特徴とする立体像表示システム。 The image processing apparatus according to any one of claims 1 to 6,

Stereoscopic image display means for displaying the parallax image;

Image projection means for projecting the shadow image onto a real space;

A stereoscopic image display system comprising:

前記視差画像を表示する立体像表示手段と、

前記集光模様画像を現実空間に投影する画像投影手段と、

を含むことを特徴とする立体像表示システム。 An image processing apparatus according to claim 7;

Stereoscopic image display means for displaying the parallax image;

Image projecting means for projecting the focused pattern image on a real space;

A stereoscopic image display system comprising:

Priority Applications (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2012255530A JP6025519B2 (en) | 2012-11-21 | 2012-11-21 | Image processing apparatus and image processing method |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2012255530A JP6025519B2 (en) | 2012-11-21 | 2012-11-21 | Image processing apparatus and image processing method |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2014103599A JP2014103599A (en) | 2014-06-05 |

| JP2014103599A5 JP2014103599A5 (en) | 2016-01-07 |

| JP6025519B2 true JP6025519B2 (en) | 2016-11-16 |

Family

ID=51025716

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2012255530A Active JP6025519B2 (en) | 2012-11-21 | 2012-11-21 | Image processing apparatus and image processing method |

Country Status (1)

| Country | Link |

|---|---|

| JP (1) | JP6025519B2 (en) |

Family Cites Families (5)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH0664621B2 (en) * | 1986-09-25 | 1994-08-22 | 工業技術院長 | Image generation method |

| JP3579162B2 (en) * | 1995-06-29 | 2004-10-20 | 松下電器産業株式会社 | 3D CG image generation device |

| JP3387856B2 (en) * | 1999-08-06 | 2003-03-17 | キヤノン株式会社 | Image processing method, image processing device, and storage medium |

| JP2003187264A (en) * | 2001-12-17 | 2003-07-04 | Denso Corp | Image display device |

| JP2010055131A (en) * | 2008-07-28 | 2010-03-11 | Namco Bandai Games Inc | Program, information storage medium, and image generation system |

-

2012

- 2012-11-21 JP JP2012255530A patent/JP6025519B2/en active Active

Also Published As

| Publication number | Publication date |

|---|---|

| JP2014103599A (en) | 2014-06-05 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| US10506223B2 (en) | Method, apparatus, and device for realizing virtual stereoscopic scene | |

| TWI531212B (en) | System and method of rendering stereoscopic images | |

| KR102049456B1 (en) | Method and apparatus for formating light field image | |

| EP3591966B1 (en) | Image processing apparatus, image processing method, and program | |

| AU2018249563B2 (en) | System, method and software for producing virtual three dimensional images that appear to project forward of or above an electronic display | |

| TWI786157B (en) | Apparatus and method for generating a tiled three-dimensional image representation of a scene | |

| CN102905145B (en) | Stereoscopic image system, image generation method, image adjustment device and method thereof | |

| WO2015196791A1 (en) | Binocular three-dimensional graphic rendering method and related system | |

| US8866887B2 (en) | Computer graphics video synthesizing device and method, and display device | |

| WO2018032841A1 (en) | Method, device and system for drawing three-dimensional image | |

| JP2020173529A (en) | Information processing device, information processing method, and program | |

| JP2011164781A (en) | Stereoscopic image generation program, information storage medium, apparatus and method for generating stereoscopic image | |

| EP2904581A1 (en) | Method and apparatus for determining a depth of a target object | |

| US9225968B2 (en) | Image producing apparatus, system and method for producing planar and stereoscopic images | |

| JP5712737B2 (en) | Display control apparatus, display control method, and program | |

| CA3155612A1 (en) | Method and system for providing at least a portion of content having six degrees of freedom motion | |

| JP6025519B2 (en) | Image processing apparatus and image processing method | |

| WO2017191703A1 (en) | Image processing device | |

| JP5868055B2 (en) | Image processing apparatus and image processing method | |

| KR100893381B1 (en) | Methods generating real-time stereo images | |

| TWI812548B (en) | Method and computer device for generating a side-by-side 3d image | |

| JP2014135006A (en) | Image processing system, image processing method and program | |

| CN111754558B (en) | Matching method for RGB-D camera system and binocular imaging system and related system thereof | |

| US20220044351A1 (en) | Method and system for providing at least a portion of content having six degrees of freedom motion | |

| Chen et al. | A View-Dependent Stereoscopic System Using Depth-Image-Based Tracking |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Written amendment |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20151111 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20151111 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20160822 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20160913 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20161011 |

|

| R151 | Written notification of patent or utility model registration |

Ref document number: 6025519 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R151 |