JP4873258B2 - Information processing apparatus and method, and program - Google Patents

Information processing apparatus and method, and program Download PDFInfo

- Publication number

- JP4873258B2 JP4873258B2 JP2007273045A JP2007273045A JP4873258B2 JP 4873258 B2 JP4873258 B2 JP 4873258B2 JP 2007273045 A JP2007273045 A JP 2007273045A JP 2007273045 A JP2007273045 A JP 2007273045A JP 4873258 B2 JP4873258 B2 JP 4873258B2

- Authority

- JP

- Japan

- Prior art keywords

- image

- correlation

- model

- feature

- generated

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Expired - Fee Related

Links

Images

Landscapes

- Image Processing (AREA)

- Image Analysis (AREA)

Description

本発明は、情報処理装置および方法、並びにプログラムに関し、特に、より確実に画像内の物体を認識することができるようになった情報処理装置および方法、並びにプログラムに関する。 The present invention relates to an information processing apparatus, method, and program, and more particularly, to an information processing apparatus, method, and program that can recognize an object in an image more reliably.

従来、局所特徴量を用いたテクスチャベースの一般物体認識手法が存在する(特許文献1参照)。かかる手法は、照明変化に強く、ロバストに物体の認識を可能にする一方で、テクスチャの少ない物体に適用すると識別能力が低下するという特徴がある。 Conventionally, there is a texture-based general object recognition method using local features (see Patent Document 1). Such a method is resistant to changes in illumination and can recognize an object robustly, but has a feature that the discrimination ability is lowered when applied to an object with less texture.

また、本願の出願当初の出願人によって既に特願2006-100705号として出願された願書に添付した明細書等には、エッジ情報やサポート点を使用することにより、テクスチャのない物体に対して局所特徴マッチングの手法の適用を可能にするといった手法が開示されている。即ち、かかる手法とは、モデル画像とクエリ画像とから特徴点を抽出し、その周辺の局所特徴量を記述し、特徴量同士のマッチングを行い、ハフ変換やRANSAC等を用いたアウトライヤ(ミスマッチ)除去を行った後のマッチングペア数で、モデル画像内の物体とクエリ画像内の物体の識別をするという手法である。

しかしながら、これらの従来の手法では、次のような3つの問題点が存在していた。その結果、これらの従来の手法よりも確実に画像内の物体を認識できる手法の実現が期待されている状況である。 However, these conventional methods have the following three problems. As a result, it is expected to realize a method that can recognize an object in an image more reliably than these conventional methods.

即ち、第1の問題点とは、モデル画像の特徴点位置とクエリ画像の特徴点位置の出現再現性が悪い場合には、識別能力が著しく低下するという問題点である。この第1の問題点は、エッジを使用した場合には、モデル画像のエッジとクエリ画像のエッジの再現性が識別能力に大きく影響するというという問題点となる。 That is, the first problem is that when the appearance reproducibility of the feature point position of the model image and the feature point position of the query image is poor, the discrimination ability is remarkably lowered. The first problem is that when edges are used, the reproducibility of the model image edges and the query image edges greatly affects the discrimination ability.

第2の問題点とは、最終的にモデルの識別をインライヤ(ミスマッチペア除去後)のマッチペア数で判断しているため、モデル画像内の物体とクエリ画像内の物体の類似度によらず、複雑なテクスチャや輪郭で、特徴点が多く出る物体同士のマッチペアは多くなり、単純なテクスチャや形状の物体は、マッチペアが少なくなるという傾向がある、という問題点である。 The second problem is that the identification of the model is finally determined by the number of match pairs of the inlier (after mismatched pair removal), so regardless of the similarity between the object in the model image and the object in the query image, The problem is that there are a large number of match pairs between objects that have many feature points due to complex textures and contours, and objects that have simple textures and shapes tend to have fewer match pairs.

第3の問題点とは、ベース点周辺にサポート点を設け、マッチングの精度向上に利用する場合、サポート点の選択基準が、複数のモデル画像間の差異を考慮していない、という問題点である。 The third problem is that when support points are provided around the base points and used for improving the accuracy of matching, the support point selection criteria do not take into account differences between multiple model images. is there.

本発明は、このような状況に鑑みてなされたものであり、より確実に画像内の物体を認識することができるようにするものである。 The present invention has been made in view of such a situation, and makes it possible to more reliably recognize an object in an image.

本発明の一側面の情報処理装置は、クエリ画像とモデル画像とを比較し、前記モデル画像の被写体と前記クエリ画像の被写体とを同定する情報処理装置であって、前記モデル画像からN個(Nは1以上の整数値)の特徴点が抽出され、抽出された前記N個の特徴点の特徴量がそれぞれ記述された場合、前記N個の特徴点とそれらの前記特徴量を示す情報が登録されるモデル辞書が自身内部または外部に存在し、前記モデル辞書に登録されている前記モデル画像の前記N個の特徴点のそれぞれについて、対応する前記特徴量と、前記クエリ画像との相関画像をそれぞれ生成する相関画像生成手段と、前記相関画像生成手段により生成された前記N個の相関画像のそれぞれについて、対応する前記特徴点の前記モデル画像内の配置位置に応じて、各画素の画素位置をシフトすることで、N個のシフト相関画像を生成するシフト相関画像生成手段と、前記シフト相関画像生成手段により生成された前記N個のシフト相関画像の各画素の画素値を加算することで、相関和画像を生成する相関和画像生成手段と、前記相関和画像生成手段により生成された前記相関和画像に基づいて、前記モデル画像の被写体と前記クエリ画像の被写体とが一致するか否かを判定する判定手段とを備える。 An information processing apparatus according to one aspect of the present invention is an information processing apparatus that compares a query image and a model image and identifies a subject of the model image and a subject of the query image, and includes N ( N is an integer value of 1 or more), and when the feature values of the extracted N feature points are respectively described, the N feature points and information indicating the feature values are included. A model dictionary to be registered exists inside or outside, and a correlation image between the corresponding feature quantity and the query image for each of the N feature points of the model image registered in the model dictionary For each of the N correlation images generated by the correlation image generation unit and the correlation image generation unit for generating the corresponding feature points in the model image, By shifting the pixel position of the pixel, a shift correlation image generation unit that generates N shift correlation images, and a pixel value of each pixel of the N shift correlation images generated by the shift correlation image generation unit Based on the correlation sum image generation unit that generates a correlation sum image by addition and the correlation sum image generated by the correlation sum image generation unit, the subject of the model image matches the subject of the query image Determination means for determining whether or not to do.

前記モデル辞書に登録されている前記モデル画像の1以上の前記特徴点のそれぞれについて、記述された自身の前記特徴量と、自身が抽出された前記モデル画像、および1以上の別モデル画像との相関画像がそれぞれ生成され、それらの相関画像に基づいて、前記モデル画像の前記被写体を識別するための寄与度を示す識別能力値が演算された場合、それらの識別能力値も、対応する前記特徴点を示す情報とともに前記モデル辞書にさらに登録され、前記シフト相関画像生成手段は、さらに、前記N個のシフト相関画像の各画素の画素値を、前記モデル辞書に登録された前記識別能力値に応じて重み付けをすることで、N個の重みつきシフト相関画像を生成し、前記相関和画像生成手段は、前記シフト相関画像生成手段により生成された前記N個の重みつきシフト相関画像の各画素の画素値を加算することで、前記相関和画像を生成する。 For each of the one or more feature points of the model image registered in the model dictionary, the described feature quantity of the model image, the model image from which the model image is extracted, and one or more different model images When correlation images are respectively generated and, based on the correlation images, a discrimination capability value indicating a degree of contribution for identifying the subject of the model image is calculated, the discrimination capability values also correspond to the corresponding feature The shift correlation image generation means is further registered in the model dictionary together with information indicating points, and the shift correlation image generation means further converts the pixel value of each pixel of the N shift correlation images to the identification capability value registered in the model dictionary. N weighted shift correlation images are generated by weighting in response, and the correlation sum image generation means generates the shift correlation image generation means. By adding the pixel value of each pixel of the number of weighted shift correlation image, to generate the correlation sum image.

前記モデル辞書に登録されている前記モデル画像の1以上の前記特徴点のうちの少なくとも1つがベース点とされ、前記ベース点の一定範囲内に存在する前記特徴点の中から1以上のサポート点が選択された場合、それらのベース点とサポート点を示す情報も前記モデル辞書にさらに登録され、前記相関画像生成手段は、さらに、前記モデル辞書に登録されている前記モデル画像の前記N個の特徴点のそれぞれについて、対応するmb個(mbは0以上の整数値)のサポート点の前記特徴量と、前記クエリ画像とのmb個のサポート点相関画像をそれぞれ生成し、前記mb個のサポート点相関画像のそれぞれについて、対応する前記サポート点と前記ベース点の前記モデル画像内の配置位置に応じて、各画素の画素位置をシフトすることで、mb個のサポート点シフト相関画像を生成し、前記N個の相関画像のそれぞれについて、自身および前記mb個のサポート点シフト相関画像の各画素の画素値を加算することで、N個の相関画像和を生成し、前記シフト相関画像生成手段は、前記相関画像生成手段により生成された前記N個の相関画像和のそれぞれから、前記N個のシフト相関画像を生成する。 At least one of the one or more feature points of the model image registered in the model dictionary is a base point, and one or more support points from among the feature points existing within a certain range of the base point Is selected, information indicating their base points and support points is also registered in the model dictionary, and the correlation image generation means further includes the N images of the model images registered in the model dictionary. For each feature point, the mb support point correlation images of the feature amount of the corresponding mb support points (mb is an integer value of 0 or more) and the query image are generated, and the mb support points are generated. For each of the point correlation images, by shifting the pixel position of each pixel according to the arrangement position of the corresponding support point and the base point in the model image, the mb support images are supported. Point correlation image, and for each of the N correlation images, the sum of the pixel values of each pixel of itself and the mb support point shift correlation images is generated to generate N correlation image sums. Then, the shift correlation image generation unit generates the N shift correlation images from each of the N correlation image sums generated by the correlation image generation unit.

前記モデル辞書に登録されている前記モデル画像の1以上の前記特徴点のそれぞれについて、記述された自身の前記特徴量と、自身が抽出された前記モデル画像、および1以上の別モデル画像との相関画像がそれぞれ生成され、それらの相関画像に基づいて、前記モデル画像の前記被写体を識別するための寄与度を示す識別能力値が演算された場合、それらの識別能力値も、対応する前記特徴点を示す情報とともに前記モデル辞書にさらに登録され、前記モデル辞書に登録されている前記モデル画像の1以上の前記特徴点のうちの少なくとも1つがベース点とされ、前記ベース点の一定範囲内に存在する前記特徴点の中から前記識別能力値が前記ベース点よりも高い前記特徴点がサポート点として選択された場合、それらのベース点とサポート点を示す情報も前記モデル辞書にさらに登録され、前記相関画像生成手段は、さらに、前記モデル辞書に登録されている前記モデル画像の前記N個の特徴点のそれぞれについて、対応するmb個のサポート点の前記特徴量と、前記クエリ画像とのmb個のサポート点相関画像をそれぞれ生成し、前記mb個のサポート点相関画像のそれぞれについて、対応する前記サポート点と前記ベース点の前記モデル画像内の配置位置に応じて、各画素の画素位置をシフトすることで、mb個のサポート点シフト相関画像を生成し、前記N個の相関画像のそれぞれについて、自身および前記mb個のサポート点シフト相関画像の各画素の画素値を加算することで、N個の相関画像和を生成し、前記シフト相関画像生成手段は、前記相関画像生成手段により生成された前記N個の相関画像和の各画素の画素値を、前記モデル辞書に登録された前記識別能力値に応じて重み付けをすることで、N個の重みつきシフト相関画像を生成し、前記相関和画像生成手段は、前記シフト相関画像生成手段により生成された前記N個の重みつきシフト相関画像の各画素の画素値を加算することで、前記相関和画像を生成する。 For each of the one or more feature points of the model image registered in the model dictionary, the described feature quantity of the model image, the model image from which the model image is extracted, and one or more different model images When correlation images are respectively generated and, based on the correlation images, a discrimination capability value indicating a degree of contribution for identifying the subject of the model image is calculated, the discrimination capability values also correspond to the corresponding feature It is further registered in the model dictionary together with information indicating a point, and at least one of the one or more feature points of the model image registered in the model dictionary is set as a base point, and within a certain range of the base point If the feature point having a higher discrimination ability value than the base point is selected as a support point from the existing feature points, those base points and support points are selected. Information indicating points is also registered in the model dictionary, and the correlation image generation means further supports corresponding mb pieces for each of the N feature points of the model image registered in the model dictionary. Mb support point correlation images of the feature amount of the points and the query image are generated, respectively, and the corresponding support points and base points in the model image for each of the mb support point correlation images. Mb support point shift correlation images are generated by shifting the pixel position of each pixel in accordance with the arrangement position of the N and the mb support point shift correlations for each of the N correlation images. By adding the pixel values of each pixel of the image, N correlation image sums are generated, and the shift correlation image generation unit generates the previous correlation image generation unit generated by the correlation image generation unit. N weighted shift correlation images are generated by weighting the pixel value of each pixel of the N correlation image sums according to the discrimination ability value registered in the model dictionary, and the correlation sum image The generation unit generates the correlation sum image by adding pixel values of each pixel of the N weighted shift correlation images generated by the shift correlation image generation unit.

本発明の一側面の情報処理方法およびプログラムは、上述した本発明の一側面の情報処理装置に対応する方法およびプログラムである。 An information processing method and program according to one aspect of the present invention are a method and program corresponding to the information processing apparatus according to one aspect of the present invention described above.

本発明の一側面においては、クエリ画像とモデル画像とを比較し、前記モデル画像の被写体と前記クエリ画像の被写体とを同定する情報処理として、次のような処理が実行される。ただし、前記モデル画像からN個(Nは1以上の整数値)の特徴点が抽出され、抽出された前記N個の特徴点の特徴量がそれぞれ記述された場合、前記N個の特徴点とそれらの前記特徴量を示す情報が登録されるモデル辞書が存在する。この場合、前記モデル辞書に登録されている前記モデル画像の前記N個の特徴点のそれぞれについて、対応する前記特徴量と、前記クエリ画像との相関画像がそれぞれ生成され、生成された前記N個の相関画像のそれぞれについて、対応する前記特徴点の前記モデル画像内の配置位置に応じて、各画素の画素位置をシフトすることで、N個のシフト相関画像が生成され、生成された前記N個のシフト相関画像の各画素の画素値を加算することで、相関和画像が生成され、生成された前記相関和画像に基づいて、前記モデル画像の被写体と前記クエリ画像の被写体とが一致するか否かが判定される。 In one aspect of the present invention, the following processing is executed as information processing for comparing the query image and the model image and identifying the subject of the model image and the subject of the query image. However, when N feature points (N is an integer value of 1 or more) are extracted from the model image and the feature values of the extracted N feature points are respectively described, the N feature points and There is a model dictionary in which information indicating these feature quantities is registered. In this case, for each of the N feature points of the model image registered in the model dictionary, a correlation image between the corresponding feature amount and the query image is generated, and the generated N images are generated. For each of the correlation images, N shift correlation images are generated by shifting the pixel position of each pixel in accordance with the arrangement position of the corresponding feature point in the model image, and the generated N A correlation sum image is generated by adding the pixel values of each pixel of the number of shift correlation images, and the subject of the model image matches the subject of the query image based on the generated correlation sum image. It is determined whether or not.

以上のように、本発明の一側面によれば、画像内の物体を認識することができる。特に、本発明の一側面によれば、より確実に画像内の物体を認識することができる。 As described above, according to one aspect of the present invention, an object in an image can be recognized. In particular, according to one aspect of the present invention, an object in an image can be recognized more reliably.

以下に本発明の実施の形態を説明するが、本発明の構成要件と、明細書又は図面に記載の実施の形態との対応関係を例示すると、次のようになる。この記載は、本発明をサポートする実施の形態が、明細書又は図面に記載されていることを確認するためのものである。したがって、明細書又は図面中には記載されているが、本発明の構成要件に対応する実施の形態として、ここには記載されていない実施の形態があったとしても、そのことは、その実施の形態が、その構成要件に対応するものではないことを意味するものではない。逆に、実施の形態が構成要件に対応するものとしてここに記載されていたとしても、そのことは、その実施の形態が、その構成要件以外の構成要件には対応しないものであることを意味するものでもない。 Embodiments of the present invention will be described below. Correspondences between the constituent elements of the present invention and the embodiments described in the specification or the drawings are exemplified as follows. This description is intended to confirm that the embodiments supporting the present invention are described in the specification or the drawings. Therefore, even if there is an embodiment that is described in the specification or the drawings but is not described here as an embodiment that corresponds to the constituent elements of the present invention, that is not the case. It does not mean that the form does not correspond to the constituent requirements. Conversely, even if an embodiment is described here as corresponding to a configuration requirement, that means that the embodiment does not correspond to a configuration requirement other than the configuration requirement. It's not something to do.

本発明の一側面の情報処理装置は、

クエリ画像(例えば図12(A)のクエリ画像22)とモデル画像(例えば図12(B)のモデル画像21)とを比較し、前記モデル画像の被写体と前記クエリ画像の被写体とを同定する情報処理装置において(例えば図11のクエリ画像認識部13を有する図1の物体認識装置)、

前記モデル画像からN個(Nは1以上の整数値)の特徴点が抽出され、抽出された前記N個の特徴点の特徴量がそれぞれ記述された場合、前記N個の特徴点とそれらの前記特徴量を示す情報が登録されるモデル辞書(例えば図11のモデル特徴量辞書12)が自身内部または外部に存在し、

前記モデル辞書に登録されている前記モデル画像の前記N個の特徴点のそれぞれについて、対応する前記特徴量と、前記クエリ画像との相関画像をそれぞれ生成する相関画像生成手段(例えば図11の相関画像生成部52)と、

前記相関画像生成手段により生成された前記N個の相関画像のそれぞれについて、対応する前記特徴点の前記モデル画像内の配置位置に応じて、各画素の画素位置をシフトすることで、N個のシフト相関画像を生成するシフト相関画像生成手段(例えば図11のシフト相関画像生成部53)と、

前記シフト相関画像生成手段により生成された前記N個のシフト相関画像の各画素の画素値を加算することで、相関和画像を生成する相関和画像生成手段(例えば図11の相関画像和生成部54)と、

前記相関和画像生成手段により生成された前記相関和画像に基づいて、前記モデル画像の被写体と前記クエリ画像の被写体とが一致するか否かを判定する判定手段(例えば図11の判定部55)と

を備える。

An information processing apparatus according to one aspect of the present invention includes:

Information for comparing a query image (for example,

When N feature points are extracted from the model image (N is an integer value equal to or greater than 1), and the feature amounts of the extracted N feature points are respectively described, the N feature points and their feature points are described. A model dictionary (for example, the

Correlation image generation means for generating a correlation image between the corresponding feature quantity and the query image for each of the N feature points of the model image registered in the model dictionary (for example, the correlation in FIG. 11). An image generator 52);

For each of the N correlation images generated by the correlation image generation unit, the pixel position of each pixel is shifted in accordance with the arrangement position of the corresponding feature point in the model image, so that N Shift correlation image generation means (for example, shift correlation image generation unit 53 in FIG. 11) for generating a shift correlation image;

Correlation sum image generation means for generating a correlation sum image by adding pixel values of each pixel of the N shift correlation images generated by the shift correlation image generation means (for example, the correlation image sum generation unit in FIG. 11) 54)

Determination means for determining whether or not the subject of the model image and the subject of the query image match based on the correlation sum image generated by the correlation sum image generation means (for example, the

前記モデル辞書に登録されている前記モデル画像の1以上の前記特徴点のそれぞれについて、記述された自身の前記特徴量と、自身が抽出された前記モデル画像、および1以上の別モデル画像との相関画像がそれぞれ生成され、それらの相関画像に基づいて、前記モデル画像の前記被写体を識別するための寄与度を示す識別能力値が演算された場合、それらの識別能力値も、対応する前記特徴点を示す情報とともに前記モデル辞書にさらに登録され、

前記シフト相関画像生成手段は、さらに、前記N個のシフト相関画像の各画素の画素値を、前記モデル辞書に登録された前記識別能力値に応じて重み付けをすることで、N個の重みつきシフト相関画像を生成し(例えば図14のステップS142を実行し)、

前記相関和画像生成手段は、前記シフト相関画像生成手段により生成された前記N個の重みつきシフト相関画像の各画素の画素値を加算することで、前記相関和画像を生成する。

For each of the one or more feature points of the model image registered in the model dictionary, the described feature quantity of the model image, the model image from which the model image is extracted, and one or more different model images When correlation images are respectively generated and, based on the correlation images, a discrimination capability value indicating a degree of contribution for identifying the subject of the model image is calculated, the discrimination capability values also correspond to the corresponding feature It is further registered in the model dictionary along with information indicating points,

The shift correlation image generation means further weights the pixel values of each pixel of the N shift correlation images according to the identification capability value registered in the model dictionary, thereby giving N weighted values. A shift correlation image is generated (for example, step S142 in FIG. 14 is executed),

The correlation sum image generation means generates the correlation sum image by adding pixel values of each pixel of the N weighted shift correlation images generated by the shift correlation image generation means.

前記モデル辞書に登録されている前記モデル画像の1以上の前記特徴点のうちの少なくとも1つがベース点とされ、前記ベース点の一定範囲内に存在する前記特徴点の中から1以上のサポート点が選択された場合、それらのベース点とサポート点を示す情報も前記モデル辞書にさらに登録され、

前記相関画像生成手段は、さらに、

前記モデル辞書に登録されている前記モデル画像の前記N個の特徴点のそれぞれについて、対応するmb個のサポート点の前記特徴量と、前記クエリ画像とのmb個のサポート点相関画像をそれぞれ生成し、前記mb個のサポート点相関画像のそれぞれについて、対応する前記サポート点と前記ベース点の前記モデル画像内の配置位置に応じて、各画素の画素位置をシフトすることで、mb個のサポート点シフト相関画像を生成し(例えば図15のS151−2を実行し)、

前記N個の相関画像のそれぞれについて、自身および前記mb個のサポート点シフト相関画像の各画素の画素値を加算することで、N個の相関画像和を生成し(例えば図15のS151−3を実行し)、

前記シフト相関画像生成手段は、

前記相関画像生成手段により生成された前記N個の相関画像和のそれぞれから、前記N個のシフト相関画像を生成する(例えば図15のS152を実行する)。

At least one of the one or more feature points of the model image registered in the model dictionary is a base point, and one or more support points from among the feature points existing within a certain range of the base point Is selected, information indicating their base points and support points is also registered in the model dictionary,

The correlation image generation means further includes:

For each of the N feature points of the model image registered in the model dictionary, the feature amount of the corresponding mb support points and the mb support point correlation images of the query image are generated. Then, for each of the mb support point correlation images, mb support is provided by shifting the pixel position of each pixel according to the arrangement position of the corresponding support point and the base point in the model image. A point shift correlation image is generated (for example, S151-2 in FIG. 15 is executed)

For each of the N correlation images, N correlation image sums are generated by adding the pixel values of each pixel of itself and the mb support point shift correlation images (for example, S151-3 in FIG. 15). Run)

The shift correlation image generation means includes

The N shift correlation images are generated from each of the N correlation image sums generated by the correlation image generation means (for example, S152 in FIG. 15 is executed).

前記モデル辞書に登録されている前記モデル画像の1以上の前記特徴点のそれぞれについて、記述された自身の前記特徴量と、自身が抽出された前記モデル画像、および1以上の別モデル画像との相関画像がそれぞれ生成され、それらの相関画像に基づいて、前記モデル画像の前記被写体を識別するための寄与度を示す識別能力値が演算された場合、それらの識別能力値も、対応する前記特徴点を示す情報とともに前記モデル辞書にさらに登録され、

前記モデル辞書に登録されている前記モデル画像の1以上の前記特徴点のうちの少なくとも1つがベース点とされ、前記ベース点の一定範囲内に存在する前記特徴点の中から前記識別能力値が前記ベース点よりも高い前記特徴点がサポート点として選択された場合、それらのベース点とサポート点を示す情報も前記モデル辞書にさらに登録され、

前記相関画像生成手段は、さらに、

前記モデル辞書に登録されている前記モデル画像の前記N個の特徴点のそれぞれについて、対応するmb個のサポート点の前記特徴量と、前記クエリ画像とのmb個のサポート点相関画像をそれぞれ生成し、前記mb個のサポート点相関画像のそれぞれについて、対応する前記サポート点と前記ベース点の前記モデル画像内の配置位置に応じて、各画素の画素位置をシフトすることで、mb個のサポート点シフト相関画像を生成し(例えば図16のS161−2を実行し)、

前記N個の相関画像のそれぞれについて、自身および前記mb個のサポート点シフト相関画像の各画素の画素値を加算することで、N個の相関画像和を生成し(例えば図16のS161−3を実行し)、

前記シフト相関画像生成手段は、

前記相関画像生成手段により生成された前記N個の相関画像和の各画素の画素値を、前記モデル辞書に登録された前記識別能力値に応じて重み付けをすることで、N個の重みつきシフト相関画像を生成し(例えば図16のS162を実行し)、

前記相関和画像生成手段は、前記シフト相関画像生成手段により生成された前記N個の重みつきシフト相関画像の各画素の画素値を加算することで、前記相関和画像を生成する(例えば図16のS163を実行する)。

For each of the one or more feature points of the model image registered in the model dictionary, the described feature quantity of the model image, the model image from which the model image is extracted, and one or more different model images When correlation images are respectively generated and, based on the correlation images, a discrimination capability value indicating a degree of contribution for identifying the subject of the model image is calculated, the discrimination capability values also correspond to the corresponding feature It is further registered in the model dictionary along with information indicating points,

At least one of the one or more feature points of the model image registered in the model dictionary is set as a base point, and the discrimination ability value is selected from the feature points existing within a certain range of the base point. When the feature point higher than the base point is selected as a support point, information indicating the base point and the support point is also registered in the model dictionary,

The correlation image generation means further includes:

For each of the N feature points of the model image registered in the model dictionary, the feature amount of the corresponding mb support points and the mb support point correlation images of the query image are generated. Then, for each of the mb support point correlation images, mb support is provided by shifting the pixel position of each pixel according to the arrangement position of the corresponding support point and the base point in the model image. A point shift correlation image is generated (for example, S161-2 in FIG. 16 is executed)

For each of the N correlation images, N correlation image sums are generated by adding the pixel values of each pixel of itself and the mb support point shift correlation images (for example, S161-3 in FIG. 16). Run)

The shift correlation image generation means includes

N weighted shifts are performed by weighting the pixel value of each pixel of the N correlated image sums generated by the correlated image generating means in accordance with the discrimination ability value registered in the model dictionary. Generate a correlation image (for example, execute S162 of FIG. 16),

The correlation sum image generation means generates the correlation sum image by adding pixel values of each pixel of the N weighted shift correlation images generated by the shift correlation image generation means (for example, FIG. 16). Step S163 is executed).

本発明の一側面の情報処理方法およびプログラムは、上述した本発明の一側面の情報処理装置に対応する方法およびプログラムである。詳細については後述するが、このプログラムは、例えば、図17のリムーバブルメディア211や、記憶部208に含まれるハードディスク等の記録媒体に記録され、図17の構成のコンピュータにより実行される。

An information processing method and program according to one aspect of the present invention are a method and program corresponding to the information processing apparatus according to one aspect of the present invention described above. Although details will be described later, this program is recorded on, for example, a

その他、本発明の一側面としては、上述した本発明の一側面のプログラムを記録した記録媒体も含まれる。 In addition, as one aspect of the present invention, a recording medium on which the program according to one aspect of the present invention described above is recorded is also included.

以下、図面を参照しながら本発明の実施の形態について説明する。 Hereinafter, embodiments of the present invention will be described with reference to the drawings.

図1は、本発明の一実施の形態である物体認識装置の機能の構成を示すブロック図である。 FIG. 1 is a block diagram showing a functional configuration of an object recognition apparatus according to an embodiment of the present invention.

図1において、物体認識装置は、モデル特徴量抽出部11、モデル特徴量辞書12、およびクエリ画像認識部13から構成される。

In FIG. 1, the object recognition apparatus includes a model feature

モデル特徴量抽出部11は、物体の認識において、認識の対象の物体をそれぞれ含むモデル画像21−1乃至21−N(Nは1以上の整数値)から、モデル特徴量をそれぞれ抽出して、モデル特徴量辞書12に登録する。

In the recognition of an object, the model feature

なお、モデル画像21−1乃至21−Nは、静止画像そのものまたは動画像のフレーム画像とされる。 The model images 21-1 to 21-N are still images themselves or frame images of moving images.

クエリ画像認識部13は、モデル画像21−1乃至21−Nに含まれる各物体と比較され、認識される物体を含むクエリ画像22から、クエリ特徴量を抽出し、モデル特徴量辞書12に登録されているモデル特徴量とのマッチングを行い、そのマッチングの結果に基づいて、モデル画像21−1乃至21−N内の各物体とクエリ画像22内の物体との同定を試みる。

The query

なお、クエリ画像22は、モデル画像21−1乃至21−Nと同様に、静止画像そのものまたは動画像のフレーム画像とされる。

The

以下、モデル特徴量抽出部11とクエリ画像認識部13とのそれぞれの詳細について、その順番で個別に説明していく。

Hereinafter, the details of the model feature

なお、以下、モデル画像21−1乃至21−Nを個々に区別する必要がない場合、換言すると、モデル画像21−1乃至21−Nのうちの1つについて言及する場合、単にモデル画像21と称する。

Hereinafter, when it is not necessary to distinguish the model images 21-1 to 21-N individually, in other words, when referring to one of the model images 21-1 to 21-N, the

図2は、モデル特徴量抽出部11の機能の詳細な構成を示すブロック図である。

FIG. 2 is a block diagram showing a detailed configuration of the function of the model feature

モデル特徴量抽出部11は、特徴点抽出部31、特徴量記述部32、特徴点識別能力値演算部33、サポート点選択部34、および、モデル特徴量情報生成部35を含むように構成される。

The model feature

特徴点抽出部31は、モデル画像21から特徴点を抽出し、その抽出結果を特徴量記述部32とモデル特徴量情報生成部35とに提供する。

The feature

なお、特徴点抽出部31が採用する特徴点抽出手法自体は特に限定されない。

Note that the feature point extraction method itself employed by the feature

具体的には例えば、図3は、Harrisコーナーディテクタ等を使用した特徴点抽出手法が採用された場合の特徴点の抽出結果を示している。図3の○(白丸印)が特徴点を示している。かかる手法では、図3に示されるように、コーナ点が特徴点として抽出される。 Specifically, for example, FIG. 3 shows a feature point extraction result when a feature point extraction method using a Harris corner detector or the like is employed. The circles (white circles) in FIG. 3 indicate feature points. In this method, as shown in FIG. 3, corner points are extracted as feature points.

また例えば、図4は、Cannyエッジディテクタ等を使用した特徴点抽出手法が採用された場合の特徴点の抽出結果を示している。図4の○(白丸印)が特徴点を示している。かかる手法では、図4に示されるように、エッジ点が特徴点として抽出される。 Further, for example, FIG. 4 shows a feature point extraction result when a feature point extraction method using a Canny edge detector or the like is employed. The circles (white circles) in FIG. 4 indicate feature points. In this method, as shown in FIG. 4, edge points are extracted as feature points.

特徴量記述部32は、特徴点抽出部31によって抽出された各特徴点の周辺で、局所特徴量記述を行う処理をそれぞれ行い、各処理結果を特徴点識別能力値演算部33とモデル特徴量情報生成部35とに提供する。

The feature

なお、特徴量記述部32が採用する局所特徴量記述手法自体は特に限定されない。

Note that the local feature description method itself employed by the

例えば、画素値の輝度勾配等を利用した、局所特徴量のベクトル記述を行う手法を採用できる。 For example, it is possible to employ a method of performing a vector description of local feature amounts using a luminance gradient of pixel values.

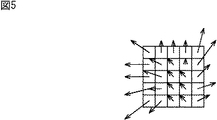

具体的には例えば、図5に示されるように、特徴点周辺で、5x5画素の範囲の輝度勾配をベクトル記述する場合は、各画素の輝度勾配の、x成分、y成分をそれぞれ次元とし、(Vx(0,0),Vy(0,0), Vx(0,1), Vy(0,1),…Vx(4,4), Vy(4,4))で50次元ベクトルを構成する、といった手法を採用することができる。 Specifically, for example, as shown in FIG. 5, when describing the luminance gradient in the range of 5 × 5 pixels around the feature point as a vector, the x component and the y component of the luminance gradient of each pixel are respectively dimensioned. (Vx (0,0), Vy (0,0), Vx (0,1), Vy (0,1), ... Vx (4,4), Vy (4,4)) constitutes a 50-dimensional vector Can be employed.

また、別の手法としては、例えば、輝度勾配ベクトルの方向別にヒストグラムを取った記述手法等も採用できる。例えば特徴点周辺の起動勾配ベクトルの方向を、10度ごとにヒストグラムをとった場合36次元ベクトルとなる。 As another method, for example, a description method using a histogram for each direction of the luminance gradient vector can be employed. For example, when the direction of the starting gradient vector around the feature point is taken every 10 degrees, a 36-dimensional vector is obtained.

また例えば、輝度情報をそのまま特徴量とするといった手法等も採用できる。たとえば特徴量周辺の5x5画素の範囲で、輝度情報をそのままベクトル記述する場合は、25次元ベクトルとなる。 Further, for example, a method of directly using luminance information as a feature amount can be employed. For example, when the luminance information is described as a vector in the range of 5 × 5 pixels around the feature amount, it becomes a 25-dimensional vector.

さらにまた、上述した各種記述手法を組み合わせてもよい。 Furthermore, the various description methods described above may be combined.

特徴点識別能力値演算部33は、特徴点抽出部31によって抽出された各特徴点(特徴量記述部32により特徴量記述化された各特徴点)のそれぞれについて、識別能力値を演算し、それらの各演算結果をサポート点選択部34とモデル特徴量情報生成部35に提供する。

The feature point identification capability value calculation unit 33 calculates a discrimination capability value for each feature point (each feature point described by the feature amount description unit 32) extracted by the feature

ここで、識別能力値とは、モデル画像21に含まれる被写体、即ち認識対象の物体を、他の物体(他のモデル画像に含まれる物体等)と区別して識別する場合において、その特徴点がその識別にどの程度寄与しているのか、即ち、その特徴点がその識別においてどの程度影響を及ぼしているのか、といった被写体を識別するための特徴点の能力(モデル識別の能力)を示す値をいう。

Here, the discriminating ability value is a characteristic point when the subject included in the

図6は、識別能力値が算出されるまでの一連の処理を説明するフローチャートである。 FIG. 6 is a flowchart for explaining a series of processes until the discrimination ability value is calculated.

なお、以下、図6の記載に併せて、モデル画像21−1から抽出された各特徴点についての識別能力値が演算される場合の処理について説明をする。ただし、実際には、モデル画像21−1のみならず、別のモデル画像21−2乃至21−Nから抽出された各特徴点のそれぞれについても、以下の説明と同様の処理が施されて、識別能力値がそれぞれ演算される。 In the following, in conjunction with the description of FIG. 6, processing in the case where the discrimination ability value for each feature point extracted from the model image 21-1 is calculated will be described. However, in practice, not only the model image 21-1, but also each feature point extracted from the other model images 21-2 to 21-N is subjected to the same processing as described below. Discrimination ability values are respectively calculated.

図6のステップS100において、モデル特徴量抽出部11は、全モデル画像21−1乃至21−Nを取得する。

In step S100 of FIG. 6, the model feature

ステップS102において、特徴点抽出部31は、上述したように、モデル画像21−1から1以上の特徴点を抽出する。ステップS103において、特徴量記述部32は、上述したように、モデル画像21−1から抽出された各特徴点について特徴量記述をそれぞれ行う。

In step S102, the feature

このようなステップS102とS103の処理と並行して、ステップS104において、特徴点識別能力値演算部33は、モデル画像21−1乃至21−Nのそれぞれから、特徴量画像41−1乃至41−Nをそれぞれ生成する。 In parallel with the processing of steps S102 and S103, in step S104, the feature point identification capability value calculation unit 33 extracts the feature amount images 41-1 to 41- from the model images 21-1 to 21-N, respectively. N is generated respectively.

ここで、特徴量画像41−K(Kは、1乃至Nのうちの何れかの整数値)とは、モデル画像21−Kの全画素を対象として、特徴量記述部32に採用された局所特徴量記述手法と同一手法に従って特徴量記述がそれぞれ行われた場合、その記述結果、即ち、各特徴量を各画素値として構成された画像をいう。

Here, the feature amount image 41-K (K is an integer value of 1 to N) is a local amount adopted by the feature

ステップS105において、特徴点識別能力値演算部33は、モデル画像21−1の各特徴点(ステップS102の処理で抽出されて、ステップS103の処理で特徴量記述化された各特徴点)のうちの、識別能力を演算したいP個(Pは、ステップS102の処理で抽出された個数以下の整数値)の特徴点についてそれぞれ、相関画像を生成する。 In step S105, the feature point identification capability value calculation unit 33 out of each feature point of the model image 21-1 (each feature point extracted in the process of step S102 and described in the feature amount in the process of step S103). A correlation image is generated for each of P feature points (P is an integer value equal to or smaller than the number extracted in the process of step S102) for which the discrimination ability is to be calculated.

ここで、相関画像42−KL(Kは、上述の特徴量画像41−KのKと同一値。Lは、1乃至Pのうちのいずれかの値)とは、次のような画像をいう。即ち、識別能力を演算したいP個の特徴点に1乃至Pの番号を付したする。そして、そのうちの処理の対象として注目すべき番号Lの特徴点を、注目特徴点Lと称するとする。この場合、注目特徴点Lの特徴量と、特徴量画像41−Kを構成する各画素値(即ち、各特徴量)とのマッチングがそれぞれ行われ、それぞれ相関(距離)値が求められたときに、それらの各相関値を各画素値として構成された画像が、相関画像42−KLとなる。このとき、相関値としては、例えば、ベクトル同士の正規化相関、距離0としてはユーグリッド距離等の尺度を採用することができる。 Here, the correlation image 42-KL (K is the same value as K of the above-described feature amount image 41-K. L is any value from 1 to P) refers to the following image. . That is, the number of 1 to P is given to P feature points for which the discrimination ability is to be calculated. And the feature point of the number L which should be noted as the object of the process is called the feature point L of interest. In this case, when the feature amount of the target feature point L is matched with each pixel value (that is, each feature amount) constituting the feature amount image 41-K, and a correlation (distance) value is obtained, respectively. In addition, an image configured with each of the correlation values as a pixel value is a correlation image 42-KL. At this time, as the correlation value, for example, a normalized correlation between vectors can be used, and a scale such as a Eugrid distance can be used as the distance 0.

即ち、注目特徴点Lに対して、N枚の特徴量画像41−1,41−2,・・・,41−Nのそれぞれの各画素との相関を示すN枚の相関画像42−1L,42−2L,・・・,42−NLが生成される。 That is, N correlation images 42-1L indicating the correlation with each pixel of the N feature amount images 41-1, 41-2,. 42-2L,..., 42-NL are generated.

換言すると、1つの特徴量画像41−Kに対しては、番号1乃至Pがそれぞれ付されたP個の各特徴点毎に1枚ずつの相関画像、即ち、P枚の相関画像42−K1,42−K2,・・・,42−KPが生成される。 In other words, for one feature value image 41-K, one correlation image for each of P feature points numbered 1 to P, that is, P correlation images 42-K1. , 42-K2,..., 42-KP are generated.

ステップS106において、特徴点識別能力値演算部33は、番号1乃至Pが付されたP個の各特徴点毎に、全相関画像の平均または最大値から識別能力値をそれぞれ演算する。即ち、特徴点識別能力値演算部33は、この平均または最大値の低いものから順に、モデル識別が高いものとして、識別能力値を与えていく。なお、全相関画像とは、注目特徴点Lに対して生成された相関画像の全て、即ち、N枚の相関画像42−1L,42−2L,・・・,42−NLをいう。 In step S106, the feature point discriminating ability value calculation unit 33 calculates the discriminating ability value from the average or maximum value of all correlation images for each of the P feature points numbered 1 to P. In other words, the feature point identification capability value calculation unit 33 gives the identification capability value as the model identification is higher in order from the lowest average or maximum value. The all correlation images are all correlation images generated for the target feature point L, that is, N correlation images 42-1L, 42-2L,..., 42-NL.

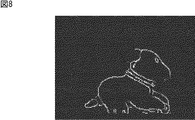

例えば、図7や図8には、識別能力値を画像化したものが示されている。ここで、識別能力値が高い特徴点ほど、明るく(白色に)なっている。即ち、図7は、カエルの形状を有する物体(以下、カエルと略称する)を含む画像がモデル画像21−1とされた場合の識別能力値の例を示している。図7に示されるように、カエルの目の付近が、識別能力値が高い、即ち、カエルであることを識別するために重要な部分であることがわかる。一方、図8は、犬の形状を有する物体(以下、犬と略記する)を含む画像がモデル画像21−1とされた場合の識別能力値の例を示している。図8に示されるように、犬の尾の付近が、識別能力値が高い、即ち、犬であることを識別するために重要な部分であることがわかる。 For example, FIGS. 7 and 8 show an image of the discrimination ability value. Here, the feature points with higher discrimination ability values are brighter (whiter). That is, FIG. 7 shows an example of the discrimination ability value when an image including an object having a frog shape (hereinafter abbreviated as a frog) is the model image 21-1. As shown in FIG. 7, it can be seen that the vicinity of the frog eye has a high discrimination ability value, that is, an important part for identifying that it is a frog. On the other hand, FIG. 8 shows an example of the discrimination ability value when an image including an object having a dog shape (hereinafter abbreviated as a dog) is a model image 21-1. As shown in FIG. 8, it can be seen that the vicinity of the tail of the dog is an important part for identifying the dog having a high discrimination capability value, that is, a dog.

なお、図示はしないが、特徴点識別能力値演算部33は、図6のステップS106の処理後、例えば、P個の各特徴点の番号を、識別能力値の高い順に並び替える処理を実行してもよい。即ち、かかる処理後のP個の各特徴点の番号とは、モデル識別に重要な順番を示すことになる。 Although not shown, the feature point identification capability value calculation unit 33 executes, for example, a process of rearranging the numbers of the P feature points in descending order of the identification capability value after the process of step S106 in FIG. May be. That is, the numbers of the P feature points after the processing indicate the order important for model identification.

図2に戻り、サポート点選択部34は、特徴点識別能力値演算部33により算出された識別能力値を利用してサポート点を選択する。

Returning to FIG. 2, the support

ここで、サポート点とは、次のような点をいう。即ち、特徴点抽出部31により抽出された特徴点の中から基準となる点として選択された点を、以下、ベース点と称する。この場合、ベース点以外の特徴点であってベース点に従属して決定される点を、サポート点と称する。

Here, the support points refer to the following points. That is, the point selected as a reference point from the feature points extracted by the feature

サポート点の決定手法自体は特に限定されず、例えば本実施の形態では、モデル画像21において、ベース点の配置位置から一定範囲内にある特徴点のうちの、識別能力値がベース点よりも高い値を有する特徴点を、サポート点として選択する、といった手法が採用されているとする。かかる手法を採用した場合には、1つのベース点に対して、複数のサポート点が選択される場合もある。図9は、かかる手法に従ったサポート点選択部34の処理(以下、サポート点選択処理と称する)の一例を説明するフローチャートである。

The support point determination method itself is not particularly limited. For example, in the present embodiment, in the

図9のステップS121において、サポート点選択部34は、モデル画像21におけるP個の各特徴点の識別能力値を取得する。

In step S <b> 121 of FIG. 9, the support

ステップS122において、サポート点選択部34は、P個の特徴点から1以上のベース点を選択する。なお、ベース点の選択手法自体は特に限定されない。

In step S122, the support

ステップS123において、サポート点選択部34は、1以上のベース点のうちの所定の1つを処理対象として、その処理対象のベース点の位置から一定範囲内にある他の特徴点を抽出する。

In step S123, the support

ステップS124において、サポート点選択部34は、抽出された特徴点の識別能力値が、ベース点の識別能力値より高いか否かを判定する。

In step S124, the support

ここで、ステップS123の処理で、1つの特徴点も抽出されない場合がある。かかる場合には、ステップS124の処理でNOであると強制的に判定されて、処理はステップS126に進むとする。なお、ステップS126以降の処理については後述する。 Here, in the process of step S123, one feature point may not be extracted. In such a case, it is forcibly determined as NO in the process of step S124, and the process proceeds to step S126. The processing after step S126 will be described later.

逆に、ステップS123の処理で、複数の特徴点が抽出される場合がある。かかる場合には、複数の特徴点のうちの所定の1つがステップS124の処理対象となり、その処理対象の特徴点の識別能力値が、ベース点の識別能力値より高いか否かが判定される。 Conversely, a plurality of feature points may be extracted in the process of step S123. In such a case, it is determined whether or not a predetermined one of the plurality of feature points is a processing target in step S124, and the discrimination capability value of the processing target feature point is higher than the discrimination capability value of the base point. .

サポート点選択部34は、ステップS124において、抽出された特徴点の識別能力値がベース点の識別能力値より高いと判定した場合、ステップS125において、抽出された特徴点(複数の特徴点が抽出されている場合には、処理対象の特徴点)をサポート点として選択する。これにより、処理はステップS126に進む。

If the support

これに対して、ステップS124において、抽出された特徴点の識別能力値がベース点の識別能力値より低いと判定された場合、ステップS125の処理は実行されずに、即ち、抽出された特徴点(複数の特徴点が抽出されている場合には、処理対象の特徴点)はサポート点として選択されずに、処理はステップS126に進む。 On the other hand, if it is determined in step S124 that the discriminating capability value of the extracted feature point is lower than the discriminating capability value of the base point, the process of step S125 is not executed, that is, the extracted feature point (If a plurality of feature points are extracted, the feature point to be processed) is not selected as a support point, and the process proceeds to step S126.

ステップS126において、サポート点選択部34は、他に抽出された特徴点があるか否かを判定する。

In step S126, the support

即ち、上述したように、ステップS123の処理で複数の特徴点が抽出された場合には、ステップS126の処理でYESであると判定され、処理はステップS124に戻され、それ以降の処理が繰り返される。即ち、複数の特徴点のそれぞれが順次処理対象となり、ステップS124,S125,S126のループ処理が繰り返し実行される。その結果、複数の特徴点のうちの、ベース点よりも識別能力値が高い特徴点のみがサポート点として選択されることになる。複数の特徴点の全てについて上述のループ処理が実行されると、最後のループ処理のステップS126においてNOであると判定されて、処理はステップS127に進む。 That is, as described above, when a plurality of feature points are extracted in the process of step S123, it is determined YES in the process of step S126, the process returns to step S124, and the subsequent processes are repeated. It is. That is, each of the plurality of feature points is sequentially processed, and the loop processing of steps S124, S125, and S126 is repeatedly executed. As a result, among the plurality of feature points, only a feature point having a higher discrimination ability value than the base point is selected as a support point. When the above loop processing is executed for all of the plurality of feature points, it is determined NO in step S126 of the last loop processing, and the processing proceeds to step S127.

また、ステップS123の処理で1つの特徴点のみが抽出された場合または1つの特徴点も抽出されなかった場合におけるステップS126の処理では、直ちにNOであると判定され、処理はステップS127に進む。 Further, when only one feature point is extracted in the process of step S123 or when one feature point is not extracted, it is immediately determined as NO in the process of step S126, and the process proceeds to step S127.

ステップS127において、サポート点選択部34は、他にベース点があるか否かを判定する。

In step S127, the support

まだ、処理対象となっていないベース点が存在する場合には、ステップS127の処理でYESであると判定されて、処理はステップS123に戻されてそれ以降の処理が繰り返される。 If there is still a base point that is not subject to processing, it is determined YES in step S127, the process returns to step S123, and the subsequent processing is repeated.

このようにして、1以上のベース点のそれぞれについて、サポート点が0以上選択されると、ステップS127の処理でNOであると判定されて、サポート点選択処理は終了する。 In this manner, when 0 or more support points are selected for each of one or more base points, it is determined NO in the process of step S127, and the support point selection process ends.

具体的には例えば、図10(A)乃至(C)のそれぞれには、ベース点とサポート点の選択結果が示されている。即ち、同一のモデル画像21から、3つのベース点が選択されており、それぞれのベース点が○(白丸)として、図10(A)乃至(C)のそれぞれに示されている。そして、それらの3つのベース点に対して選択された複数のサポート点が、図10(A)乃至(C)に、ベース点を示す○(白丸)よりも小さな●(黒丸)としてそれぞれ示されている。

Specifically, for example, in each of FIGS. 10A to 10C, the selection result of the base point and the support point is shown. That is, three base points are selected from the

図2に戻り、モデル特徴量情報生成部35は、以上説明した特徴点抽出部31乃至サポート点選択部34の各種処理結果を示すモデル特徴量情報(ベース点+サポート点)を生成し、モデル特徴量辞書12に登録する。即ち、モデル特徴量情報とは、モデル画像21−1乃至21−Nのそれぞれについて、抽出された各特徴点に関する情報をいう。具体的には例えば、それらの特徴点がベース点とサポート点との別に区別されて、それぞれについての局所特徴量や識別能力値、また、サポート点情報等から構成される情報が、モデル特徴量情報である。

Returning to FIG. 2, the model feature amount

以上、図1の物体認識装置のうちのモデル特徴量抽出部11の詳細について説明した。以下、クエリ画像認識部13の詳細について説明する。

The details of the model feature

図11は、クエリ画像認識部13の機能の詳細な構成を示すブロック図である。

FIG. 11 is a block diagram illustrating a detailed configuration of functions of the query

クエリ画像認識部13は、特徴画像生成部51、相関画像生成部52、シフト相関画像生成部53、相関画像和生成部54、および判定部55を含むように構成される。

The query

特徴画像生成部51は、認識させたい物体を含むクエリ画像22が入力されると、そのクエリ画像22から特徴量画像を生成する。即ち、上述した図6のステップS104と同様の処理がクエリ画像22に施されることになる。

When a

相関画像生成部52は、クエリ画像22の特徴量画像の各画素値(即ち、各画素の特徴量)と、モデル特徴量辞書12に記録された各モデル画像21−1乃至21−Nの各特徴点(以下、各モデル特徴点と称する)の特徴量とのマッチングを行い、それぞれの相関(距離)値を各画素値として構成する画像、即ち、相関画像を生成する。

The correlation image generation unit 52 stores each pixel value of the feature amount image of the query image 22 (that is, the feature amount of each pixel) and each of the model images 21-1 to 21-N recorded in the model

シフト相関画像生成部53は、各モデル特徴点の位置に応じて、それぞれ対応する相関画像の各画素位置をシフトさせた画像(以下、シフト相関画像と称する)を生成する。なお、シフト相関画像の生成手法については、図12乃至図16を参照して後述する。 The shift correlation image generation unit 53 generates an image (hereinafter referred to as a shift correlation image) obtained by shifting each pixel position of the corresponding correlation image according to the position of each model feature point. A method for generating a shift correlation image will be described later with reference to FIGS.

相関画像和生成部54は、モデル画像21−1乃至21−N毎に、各モデル特徴点の各シフト相関画像、若しくは、それらに対して各種画像処理を施した後の各画像の和を取った画像(以下、相関和画像と称する)を生成する。即ち、相関和画像とは、2以上の画像の各画素値の総和を、それぞれの画素値として構成される画像をいう。

The correlation image

なお、相関和画像の生成手法(シフト相関画像に対して施される各種画像処理の例含む)の具体例については、図12乃至図16を参照して後述する。 A specific example of the correlation sum image generation method (including examples of various image processes performed on the shift correlation image) will be described later with reference to FIGS.

判定部55は、モデル画像21−1乃至21−Nのそれぞれに対して生成された各相関和画像に基づいて、モデル画像21−1乃至21−Nに含まれる各物体がクエリ画像22に含まれている物体と同一であるか否かを判定し、その判定結果を出力する。

The

即ち、所定のモデル画像21−Kについての相関和画像のうちの、シフト相関画像の生成時のシフト位置(後述する例では中央付近の位置)の画素値が、相関和画像のローカルピークとなる。そして、かかるローカルピークが、モデル画像21−Kに含まれる物体が、クエリ画像22においてどの程度の割合で存在するのかを示す存在推定度を表すことになる。よって、判定部55は、モデル画像21−Kの相関和画像のローカルピークが閾値以上の場合、モデル画像21−Kに含まれる物体がクエリ画像22に含まれる画像と一致すると判定すること、即ち、その物体を認識することができる。

That is, among the correlation sum images for the predetermined model image 21-K, the pixel value at the shift position (position near the center in the example described later) at the time of generation of the shift correlation image becomes the local peak of the correlation sum image. . Then, the local peak represents a presence estimation degree indicating how much an object included in the model image 21 -K is present in the

以下、図12乃至図16を参照して、クエリ画像認識部13の動作のうちの、主に相関画像生成部52乃至相関画像和生成部54の動作について説明する。

Hereinafter, the operations of the correlation image generation unit 52 to the correlation image

即ち、図13乃至図16は、図12(A)の画像がクエリ画像22として入力された場合における、図12(B)のモデル画像21との相関和画像が生成されるまでの各種処理結果の具体例を示している。

That is, FIGS. 13 to 16 show various processing results until the correlation sum image with the

図13の例では、モデル画像21の特徴量情報として、4つのベース点b1乃至b4の特徴量のみが利用されて、相関和画像が生成される。換言すると、図13の例では、後述する他の例のように、サポート点の情報や、識別能力値は一切利用されない。なお、ベース点b1乃至b4は例示にしか過ぎず、ベース点の位置や個数は図13の例に限定されず任意であることは言うまでもない。

In the example of FIG. 13, as the feature amount information of the

図13のステップS131において、相関画像生成部52は、クエリ画像22の特徴量画像の各画素値(即ち、各画素の特徴量)と、モデル画像21のベース点b1乃至b4の各特徴量とのマッチングを行うことで、図13のS131の枠内に示されるような4つの相関画像を生成する。

In step S131 of FIG. 13, the correlation image generation unit 52 determines each pixel value of the feature amount image of the query image 22 (that is, a feature amount of each pixel) and each feature amount of the base points b1 to b4 of the

ステップS132において、シフト相関画像生成部53は、各ベース点b1乃至b4の位置に応じて、それぞれ対応する相関画像の各画素位置をシフトさせることで、図13のS132の枠内に示されるような4つのシフト相関画像を生成する。 In step S132, the shift correlation image generation unit 53 shifts each pixel position of the corresponding correlation image in accordance with the positions of the base points b1 to b4, as shown in the frame of S132 in FIG. Four shift correlation images are generated.

図13の例のシフト相関画像は、モデル画像21におけるベース点bn(nは整数値であって、図13の例ではnは1乃至4のうちの何れかの値)の存在位置(相関画像の対応画素位置)が、画像の中央位置にシフトするように、相関画像の各画素位置がシフトされた結果得られる画像となっている。 The shift correlation image in the example of FIG. 13 is the presence position (correlation image) of the base point bn (n is an integer value, and n is any one of 1 to 4 in the example of FIG. 13). Is obtained as a result of shifting each pixel position of the correlation image so that the corresponding pixel position is shifted to the center position of the image.

ステップS133において、相関画像和生成部54は、これらの4つのシフト相関画像を単純に足し合わせることで、図13のS133の枠内に示されるような相関和画像を生成する。なお、「足し合わせるとは」、上述の如く、各画素毎に、各画素値を足し合わせることを意味する。このことは、以下の説明でも同様である。

In step S133, the correlation image

このような図13の例に対して、図14の例では、モデル画像21の特徴量情報として、4つのベース点b1乃至b4の特徴量に加えて、それらの識別能力値に基づく重み値α1乃至α4が利用されて、相関和画像が生成される。

In contrast to the example of FIG. 13, in the example of FIG. 14, as the feature amount information of the

即ち、ステップS141において、相関画像生成部52は、クエリ画像22の特徴量画像の各画素値(即ち、各画素の特徴量)と、モデル画像21のベース点b1乃至b4の各特徴量とのマッチングを行うことで、図14のS141の枠内に示されるような4つの相関画像を生成する。

That is, in step S <b> 141, the correlation image generation unit 52 calculates each pixel value (that is, a feature amount of each pixel) of the feature amount image of the

なお、図14のS141の枠内に示される4つの相関画像とは、図13のS131の枠内に示される4つの相関画像と同一である。即ち、ステップS141の処理とステップS131の処理とは同様の処理である。 Note that the four correlation images shown in the frame of S141 in FIG. 14 are the same as the four correlation images shown in the frame of S131 in FIG. That is, the process of step S141 and the process of step S131 are the same process.

ステップS142の処理では、シフト相関画像の生成処理が実行される。ただし、ステップS142の処理は、図13のステップS132の処理とは異なる。 In the process of step S142, a shift correlation image generation process is executed. However, the process of step S142 is different from the process of step S132 of FIG.

即ち、ステップS142−1において、シフト相関画像生成部53は、各ベース点b1乃至b4の位置に応じて、それぞれ対応する相関画像の各画素位置をシフトさせることで、図14のS142−1の点線枠内に示されるような4つのシフト相関画像を生成する。 That is, in step S142-1, the shift correlation image generation unit 53 shifts each pixel position of the corresponding correlation image in accordance with the position of each base point b1 to b4, so that the process of S142-1 in FIG. Four shift correlation images as shown in the dotted frame are generated.

なお、図14のS142−1の点線枠内に示される4つのシフト相関画像とは、図13のS132の枠内に示される4つのシフト相関画像と同一である。即ち、ステップS142−1の処理とは、図13のステップS132の処理と同様の処理である。 Note that the four shift correlation images shown in the dotted frame in S142-1 in FIG. 14 are the same as the four shift correlation images shown in the frame in S132 in FIG. That is, the process of step S142-1 is the same process as the process of step S132 of FIG.

換言すると、ステップS142の処理とは、図13のステップS132(=ステップS142−1)の処理に加えて、さらに次のようなステップS142−2の処理が付加された処理であるといる。なお、ステップS142−2の処理で最終的に得られるシフト相関画像と、ステップS142−1の処理の結果得られるシフト相関画像とを個々に区別すべく、以下、前者を重みつきシフト相関画像と称し、後者を単純シフト相関画像と称する。 In other words, the process of step S142 is a process in which the following process of step S142-2 is further added to the process of step S132 (= step S142-1) of FIG. In order to distinguish the shift correlation image finally obtained by the process of step S142-2 from the shift correlation image obtained as a result of the process of step S142-1, hereinafter, the former will be referred to as a weighted shift correlation image. The latter is referred to as a simple shift correlation image.

即ち、ステップS142−1の処理では、図14のS142−1の点線枠内に示される4つの単純シフト相関画像が生成される。そこで、ステップS142−2において、シフト相関画像生成部53は、各ベース点b1乃至b4のそれぞれに対応する各単純シフト相関画像の各画素値に対して、各ベース点b1乃至b4の識別能力値に基づく重み値α1乃至α4をそれぞれ掛けることで、識別能力値に応じた重み付けがなされた各画素値により構成される画像、即ち、図14のS142−2の点線枠内に示されるような4つの重みつきシフト相関画像を生成する。 That is, in the process of step S142-1, four simple shift correlation images shown in the dotted line frame of S142-1 in FIG. 14 are generated. Therefore, in step S142-2, the shift correlation image generation unit 53 determines the discrimination capability value of each base point b1 to b4 for each pixel value of each simple shift correlation image corresponding to each of the base points b1 to b4. Are multiplied by the weight values α1 to α4 based on the image, respectively, and an image composed of each pixel value weighted according to the discriminating ability value, that is, 4 as shown in the dotted line frame of S142-2 in FIG. One weighted shift correlation image is generated.

ステップS143において、相関画像和生成部54は、これらの4つの重みつきシフト相関画像を単純に足し合わせることで、図14のS143の枠内に示されるような相関和画像を生成する。

In step S143, the correlation image

このような図13,図14の例に対して、図15の例では、モデル画像21の特徴量情報として、4つのベース点b1乃至b4の特徴量に加えてさらに、各ベース点b1乃至b4のサポート点の情報が利用されて、相関和画像が生成される。ただし、図15の例では、図14の例のように、識別能力値に基づく重み値α1乃至α4は利用されない。

In contrast to the examples of FIGS. 13 and 14, in the example of FIG. 15, in addition to the feature amounts of the four base points b1 to b4, the base points b1 to b4 are added as the feature amount information of the

ステップS151の処理では、相関画像の生成処理が実行される。ただし、ステップS151の処理は、図13のステップS131や図14のステップS141の処理とは異なる。 In the process of step S151, a correlation image generation process is executed. However, the process of step S151 is different from the process of step S131 of FIG. 13 and step S141 of FIG.

即ち、ステップS152−1において、相関画像生成部52は、クエリ画像22の特徴量画像の各画素値(即ち、各画素の特徴量)と、モデル画像21のベース点b1乃至b4の各特徴量とのマッチングを行うことで、図15のS151−1の枠内に示されるような4つの相関画像を生成する。

That is, in step S152-1, the correlation image generation unit 52 determines each pixel value of the feature amount image of the query image 22 (ie, the feature amount of each pixel) and each feature amount of the base points b1 to b4 of the

なお、図15のS151−1の枠内に示される4つの相関画像とは、図13のS131の枠内に示される4つの相関画像と同一、即ち図14のS141の枠内に示される4つの相関画像と同一である。即ち、ステップS151−1の処理とは、図13のステップS131や図14のステップS141の処理と同様の処理である。 Note that the four correlation images shown in the frame of S151-1 in FIG. 15 are the same as the four correlation images shown in the frame of S131 in FIG. 13, that is, 4 shown in the frame of S141 in FIG. Identical to two correlation images. That is, the process of step S151-1 is the same process as the process of step S131 of FIG. 13 or step S141 of FIG.

換言すると、ステップS151の処理とは、図13のステップS131(=図14のステップS141=図15のステップS151−1)の処理に加えて、さらに次のようなステップS151−2,S151−3の処理が付加された処理であるといる。なお、以下、各ステップS151−1乃至S151−3の各処理の結果得られる相関画像を個々に区別すべく、ステップS151−1の処理の結果得られる相関画像をベース点相関画像と称し、ステップS151−2の処理の結果得られる相関画像をサポート点シフト相関画像と称し、ステップS151−3の処理の結果得られる相関画像を、ベース点bnを中心としたサポート点シフト相関画像和と称する。 In other words, in addition to the processing of step S131 in FIG. 13 (= step S141 in FIG. 14 = step S151-1 in FIG. 15), the processing in step S151 further includes the following steps S151-2 and S151-3. This process is added. Hereinafter, the correlation image obtained as a result of the process of step S151-1 is referred to as a base point correlation image in order to individually distinguish the correlation images obtained as a result of the processes of steps S151-1 to S151-3. The correlation image obtained as a result of the process of S151-2 is referred to as a support point shift correlation image, and the correlation image obtained as a result of the process of step S151-3 is referred to as a support point shift correlation image sum centered on the base point bn.

即ち、ステップS151−1の処理では、図15のS151−1の点線枠内に示される4つのベース点相関画像が生成される。 That is, in the process of step S151-1, four base point correlation images shown in the dotted line frame of S151-1 of FIG. 15 are generated.

ステップS151−2において、相関画像生成部52は、モデル画像21のベース点bnについて、クエリ画像22の特徴量画像の各画素値(即ち、各画素の特徴量)と、ベース点bnにおけるサポート点snm(mは、1以上の整数値)の各特徴量とのマッチングをそれぞれ行うことで、m個の相関画像を生成する。さらに、相関画像生成部52は、サポート点snmの存在位置(相関画像の対応画素位置)を、ベース点bnの存在位置(相関画像の対応画素位置)にシフトすることで、ベース点b1乃至b4のそれぞれについて、図15のS151−2の枠内に示されるようなm個のサポート点シフト相関画像をそれぞれ生成する。

In step S151-2, the correlation image generation unit 52 determines each pixel value of the feature amount image of the query image 22 (that is, the feature amount of each pixel) and the support point at the base point bn for the base point bn of the

即ち、ベース点b1には、2個のサポート点s11,s12が存在する。よって、サポート点s11についてのサポート点シフト相関画像と、サポート点s12についてのサポート点シフト相関画像が生成される。 That is, there are two support points s11 and s12 at the base point b1. Therefore, a support point shift correlation image for the support point s11 and a support point shift correlation image for the support point s12 are generated.

以下同様に、ベース点b2には、3個のサポート点s21,s22,s23が存在する。よって、サポート点s21についてのサポート点シフト相関画像、サポート点s22についてのサポート点シフト相関画像、および、サポート点s23についてのサポート点シフト相関画像が生成される。 Similarly, there are three support points s21, s22, and s23 at the base point b2. Therefore, a support point shift correlation image for the support point s21, a support point shift correlation image for the support point s22, and a support point shift correlation image for the support point s23 are generated.

ベース点b3には、2個のサポート点s31,s32が存在する。よって、サポート点s31についてのサポート点シフト相関画像と、サポート点s32についてのサポート点シフト相関画像が生成される。 There are two support points s31 and s32 at the base point b3. Therefore, a support point shift correlation image for the support point s31 and a support point shift correlation image for the support point s32 are generated.

ベース点b4には、1個のサポート点s41が存在する。よって、サポート点s41についてのサポート点シフト相関画像が生成される。 There is one support point s41 at the base point b4. Therefore, a support point shift correlation image for the support point s41 is generated.

ステップS151−3において、相関画像生成部52は、モデル画像21のベース点bnについて、対応するベース点相関画像(ステップS151−1の処理の結果得られる画像)と、対応するm個のサポート点シフト相関画像(ステップS151−2の処理の結果得られる画像)を単純に足し合わせることで、図15のS151−3の枠内に示されるような、ベース点bnを中心としたサポート点シフト相関画像和を生成する。

In step S151-3, the correlation image generation unit 52 performs the corresponding base point correlation image (the image obtained as a result of the processing in step S151-1) and the corresponding m support points for the base point bn of the

即ち、ベース点b1については、ベース点b1についてのベース点相関画像、並びに、サポート点s11についてのサポート点シフト相関画像およびサポート点s12についてのサポート点シフト相関画像が足し合わされ、その結果、ベース点b1を中心としたサポート点シフト相関画像和が生成される。 That is, for the base point b1, the base point correlation image for the base point b1, and the support point shift correlation image for the support point s11 and the support point shift correlation image for the support point s12 are added together. A support point shift correlation image sum centered on b1 is generated.

以下同様に、ベース点b2については、ベース点b2についてのベース点相関画像、並びに、サポート点s21についてのサポート点シフト相関画像、サポート点s22についてのサポート点シフト相関画像、および、サポート点s23についてのサポート点シフト相関画像が足し合わされ、その結果、ベース点b2を中心としたサポート点シフト相関画像和が生成される。 Similarly, for the base point b2, the base point correlation image for the base point b2, the support point shift correlation image for the support point s21, the support point shift correlation image for the support point s22, and the support point s23. These support point shift correlation images are added together, and as a result, a support point shift correlation image sum centered on the base point b2 is generated.

ベース点b3については、ベース点b3についてのベース点相関画像、並びに、サポート点s31についてのサポート点シフト相関画像およびサポート点s32についてのサポート点シフト相関画像が足し合わされ、その結果、ベース点b3を中心としたサポート点シフト相関画像和が生成される。 For the base point b3, the base point correlation image for the base point b3, and the support point shift correlation image for the support point s31 and the support point shift correlation image for the support point s32 are added together. A centered support point shift correlation image sum is generated.

ベース点b4については、ベース点b4についてのベース点相関画像、並びに、サポート点s41についてのサポート点シフト相関画像が足し合わされ、その結果、ベース点b4を中心としたサポート点シフト相関画像和が生成される。 For the base point b4, the base point correlation image for the base point b4 and the support point shift correlation image for the support point s41 are added, and as a result, a support point shift correlation image sum centered on the base point b4 is generated. Is done.

その後のステップS152,S153の処理は、図13のステップS132,S133の処理と基本的に同様の処理が実行される。ただし、図13のステップS132の処理対象は、図15のステップS151−1の処理結果であるベース点相関画像となっていた。これに対して、図15のステップS152の処理対象は、上述の如く、図15のステップS151−1の処理結果であるベース点相関画像に対して、ステップS151−2の処理結果であるサポート点シフト相関画像が足し合わされた結果得られる画像、即ち、ベース点を中心としたサポート点シフト相関画像和である。 Subsequent processes in steps S152 and S153 are basically the same as the processes in steps S132 and S133 in FIG. However, the processing target in step S132 in FIG. 13 is the base point correlation image that is the processing result in step S151-1 in FIG. On the other hand, as described above, the processing target of step S152 in FIG. 15 is the support point that is the processing result of step S151-2 with respect to the base point correlation image that is the processing result of step S151-1 of FIG. This is an image obtained as a result of adding the shift correlation images, that is, a support point shift correlation image sum centered on the base point.

図16の例は、図14の例と図15の例とを組み合わせた例である。即ち、図16の例では、モデル画像21の特徴量情報として、4つのベース点b1乃至b4の特徴量に加えて、それらの識別能力値に基づく重み値α1乃至α4と、各ベース点b1乃至b4のサポート点の情報との両者が利用されて、相関和画像が生成される。

The example of FIG. 16 is an example in which the example of FIG. 14 and the example of FIG. 15 are combined. That is, in the example of FIG. 16, in addition to the feature amounts of the four base points b1 to b4, as the feature amount information of the

換言すると、図16のステップS161の処理が、図15のステップS151の処理と同様の処理である。即ち、図16のステップS161−1乃至S161−3のそれぞれが、図15のステップS151−1乃至S151−3のそれぞれと同様の処理である。 In other words, the process in step S161 in FIG. 16 is the same as the process in step S151 in FIG. That is, each of steps S161-1 to S161-3 in FIG. 16 is the same processing as each of steps S151-1 to S151-3 in FIG.

一方、図16のステップS162の処理が、図14のステップS142の処理と同様の処理である。即ち、図16のステップS162−1,S162−2のそれぞれが、図14のステップS141−1,S141−2のそれぞれと同様の処理である。 On the other hand, the process in step S162 in FIG. 16 is the same as the process in step S142 in FIG. That is, each of steps S162-1, S162-2 in FIG. 16 is the same processing as each of steps S141-1, S141-2 in FIG.

式で表すと、図16のステップS161の処理結果は、次の式(1)のように表される。 Expressed as an expression, the processing result of step S161 in FIG. 16 is expressed as the following expression (1).

式(1)の左辺のSumSpCorbn(x,y)が、ベース点bnを中心としたサポート点シフト相関画像和の座標(x,y)における画素値を示している。なお、nは、図16の例では1乃至4のうちの何れかの値とされているが、任意の整数値に一般化できることはいうまでもない。 SumSpCor bn (x, y) on the left side of Expression (1) indicates the pixel value at the coordinates (x, y) of the support point shift correlation image sum centered on the base point bn. Note that n is any value from 1 to 4 in the example of FIG. 16, but it goes without saying that it can be generalized to an arbitrary integer value.

また、式(1)の右辺において、Corsnm(x,y)が、サポート点snmの相関画像の(x,y)における画素値を示している。mbnは、ベース点bnにおけるサポート点の数を示している。即ち、図16の例では、mb1=2,mb2=3,mb3=2,mb4=1とされている。(bxn,byn)は、ベース点bnの座標を示している。(snxm,snym)は、サポート点snmの座標を示している。 In addition, on the right side of Equation (1), Cor snm (x, y) indicates the pixel value in (x, y) of the correlation image at the support point snm. m bn indicates the number of support points at the base point bn. That is, in the example of FIG. 16, m b1 = 2, m b2 = 3, m b3 = 2 and m b4 = 1. (bx n , by n ) indicates the coordinates of the base point bn. (snx m , sny m ) indicates the coordinates of the support point snm.

そして、図16のステップS163の最終的な処理結果は、次の式(2)のように表される。即ち、式(2)の右辺のΣ内の式が、図16のステップS162の処理結果を示している。 Then, the final processing result of step S163 in FIG. 16 is expressed as the following equation (2). That is, the expression in Σ on the right side of Expression (2) indicates the processing result of Step S162 in FIG.

式(2)の左辺のSumCor(x,y)が、ステップS163の処理の結果得られる相関和画像の座標(x,y)における画素値を示している。 SumCor (x, y) on the left side of Expression (2) indicates the pixel value at the coordinates (x, y) of the correlation sum image obtained as a result of the processing in step S163.

また、式(2)の右辺において、(cx,cy)が、モデル画像21の中心座標を示している。

Further, on the right side of Expression (2), (cx, cy) indicates the center coordinates of the

以上説明したように、本発明を適用することで、モデル画像と、クエリ画像の特徴点抽出のリピータビリティーを考慮する必要がなくなり、よりロバストな認識が可能になる。 As described above, by applying the present invention, it is not necessary to consider the repeatability of model image and query image feature point extraction, and more robust recognition is possible.

また、相関画像和の所定画素値(例えば中央付近の画素値)、即ち、相関値の総和の値が、物体の存在推定度を表すので、この値を比較することにより、どの物体がどれ位の確率で存在しているかが分かるようになる。 In addition, the predetermined pixel value of the correlation image sum (for example, the pixel value near the center), that is, the sum of the correlation values represents the existence estimation degree of the object. You can see if it exists with the probability of.

また、自分のモデル画像の他の部分や、他のモデル画像との相関具合を考慮して、特徴量の識別能力値を演算し、その識別能力値に基づいてサポート点の選択もできるので、マッチングの精度が向上する。 Also, considering the correlation with other parts of your model image and other model images, you can calculate the feature value discrimination ability value, and you can also select the support point based on the discrimination ability value, Matching accuracy is improved.

上述した一連の処理は、ハードウェアにより実行することもできるし、ソフトウェアにより実行することもできる。一連の処理をソフトウェアにより実行する場合には、そのソフトウェアを構成するプログラムが、専用のハードウェアに組み込まれているコンピュータ、または、各種のプログラムをインストールすることで、各種の機能を実行することが可能な、例えば汎用のパーソナルコンピュータなどに、プログラム記録媒体からインストールされる。 The series of processes described above can be executed by hardware or can be executed by software. When a series of processing is executed by software, a program constituting the software may execute various functions by installing a computer incorporated in dedicated hardware or various programs. For example, it is installed from a program recording medium in a general-purpose personal computer or the like.

図17は、上述した一連の処理をプログラムにより実行するパーソナルコンピュータの構成の例を示すブロック図である。CPU(Central Processing Unit)201は、ROM(Read Only Memory)202、または記憶部208に記憶されているプログラムに従って各種の処理を実行する。RAM(Random Access Memory)203には、CPU201が実行するプログラムやデータなどが適宜記憶される。これらのCPU201、ROM202、およびRAM203は、バス204により相互に接続されている。

FIG. 17 is a block diagram showing an example of the configuration of a personal computer that executes the above-described series of processing by a program. A CPU (Central Processing Unit) 201 executes various processes according to a program stored in a ROM (Read Only Memory) 202 or a

CPU201にはまた、バス204を介して入出力インターフェース205が接続されている。入出力インターフェース205には、キーボード、マウス、マイクロフォンなどよりなる入力部206、ディスプレイ、スピーカなどよりなる出力部207が接続されている。CPU201は、入力部206から入力される指令に対応して各種の処理を実行する。そして、CPU201は、処理の結果を出力部207に出力する。

An input /

入出力インターフェース205に接続されている記憶部208は、例えばハードディスクからなり、CPU201が実行するプログラムや各種のデータを記憶する。通信部209は、インターネットやローカルエリアネットワークなどのネットワークを介して外部の装置と通信する。

The

また、通信部209を介してプログラムを取得し、記憶部208に記憶してもよい。

Further, a program may be acquired via the

入出力インターフェース205に接続されているドライブ210は、磁気ディスク、光ディスク、光磁気ディスク、或いは半導体メモリなどのリムーバブルメディア211が装着されたとき、それらを駆動し、そこに記録されているプログラムやデータなどを取得する。取得されたプログラムやデータは、必要に応じて記憶部208に転送され、記憶される。

The

コンピュータにインストールされ、コンピュータによって実行可能な状態とされるプログラムを格納するプログラム記録媒体は、図17に示されるように、磁気ディスク(フレキシブルディスクを含む)、光ディスク(CD-ROM(Compact Disc-Read Only Memory),DVD(Digital Versatile Disc)を含む)、光磁気ディスク、もしくは半導体メモリなどよりなるパッケージメディアであるリムーバブルメディア211、または、プログラムが一時的もしくは永続的に格納されるROM202や、記憶部208を構成するハードディスクなどにより構成される。プログラム記録媒体へのプログラムの格納は、必要に応じてルータ、モデムなどのインターフェースである通信部209を介して、ローカルエリアネットワーク、インターネット、デジタル衛星放送といった、有線または無線の通信媒体を利用して行われる。

As shown in FIG. 17, a program recording medium that stores a program that is installed in a computer and can be executed by the computer is a magnetic disk (including a flexible disk), an optical disk (CD-ROM (Compact Disc-Read). Only memory), DVD (Digital Versatile Disc),

なお、本明細書において、プログラム記録媒体に格納されるプログラムを記述するステップは、記載された順序に沿って時系列的に行われる処理はもちろん、必ずしも時系列的に処理されなくとも、並列的あるいは個別に実行される処理をも含むものである。 In the present specification, the step of describing the program stored in the program recording medium is not limited to the processing performed in time series in the order described, but is not necessarily performed in time series. Or the process performed separately is also included.

また、本発明の実施の形態は、上述した実施の形態に限定されるものではなく、本発明の要旨を逸脱しない範囲において種々の変更が可能である。例えば、以上においては、本発明を物体認識装置に適用した実施の形態について説明したが、本発明は、例えば、画像内の物体を比較し認識する情報処理装置に適用することができる。 The embodiments of the present invention are not limited to the above-described embodiments, and various modifications can be made without departing from the scope of the present invention. For example, the embodiment in which the present invention is applied to an object recognition apparatus has been described above. However, the present invention can be applied to an information processing apparatus that compares and recognizes objects in an image, for example.

11 モデル特徴量抽出部, 12 モデル特徴量辞書, 13 クエリ画像認識部, 21 モデル画像21 クエリ画像, 31 特徴点抽出部, 32 特徴量記述部, 33 特徴点識別能力値演算部, 34 サポート点選択部, 51 特徴画像生成部, 52 相関画像生成部, 53 シフト相関画像生成部, 54 相関画像和生成部, 55 判定部, 201 CPU, 202 ROM, 203 RAM, 208 記憶部, 211 リムーバブルメディア

DESCRIPTION OF

Claims (6)

前記モデル画像からN個(Nは1以上の整数値)の特徴点が抽出され、抽出された前記N個の特徴点の特徴量がそれぞれ記述された場合、前記N個の特徴点とそれらの前記特徴量を示す情報が登録されるモデル辞書が自身内部または外部に存在し、

前記モデル辞書に登録されている前記モデル画像の前記N個の特徴点のそれぞれについて、対応する前記特徴量と、前記クエリ画像との相関画像をそれぞれ生成する相関画像生成手段と、

前記相関画像生成手段により生成された前記N個の相関画像のそれぞれについて、対応する前記特徴点の前記モデル画像内の配置位置に応じて、各画素の画素位置をシフトすることで、N個のシフト相関画像を生成するシフト相関画像生成手段と、

前記シフト相関画像生成手段により生成された前記N個のシフト相関画像の各画素の画素値を加算することで、相関和画像を生成する相関和画像生成手段と、

前記相関和画像生成手段により生成された前記相関和画像に基づいて、前記モデル画像の被写体と前記クエリ画像の被写体とが一致するか否かを判定する判定手段と

を備える情報処理装置。 In an information processing apparatus that compares a query image and a model image and identifies a subject of the model image and a subject of the query image,

When N feature points are extracted from the model image (N is an integer value equal to or greater than 1), and the feature amounts of the extracted N feature points are respectively described, the N feature points and their feature points are described. A model dictionary in which information indicating the feature amount is registered exists inside or outside itself,

Correlation image generation means for generating a correlation image between the corresponding feature amount and the query image for each of the N feature points of the model image registered in the model dictionary;

For each of the N correlation images generated by the correlation image generation unit, the pixel position of each pixel is shifted in accordance with the arrangement position of the corresponding feature point in the model image, so that N Shift correlation image generation means for generating a shift correlation image;

Correlation sum image generation means for generating a correlation sum image by adding pixel values of each pixel of the N shift correlation images generated by the shift correlation image generation means;

An information processing apparatus comprising: a determination unit that determines whether the subject of the model image matches the subject of the query image based on the correlation sum image generated by the correlation sum image generation unit.

前記シフト相関画像生成手段は、さらに、前記N個のシフト相関画像の各画素の画素値を、前記モデル辞書に登録された前記識別能力値に応じて重み付けをすることで、N個の重みつきシフト相関画像を生成し、

前記相関和画像生成手段は、前記シフト相関画像生成手段により生成された前記N個の重みつきシフト相関画像の各画素の画素値を加算することで、前記相関和画像を生成する

請求項1に記載の情報処理装置。 For each of the one or more feature points of the model image registered in the model dictionary, the described feature quantity of the model image, the model image from which the model image is extracted, and one or more different model images When correlation images are respectively generated and, based on the correlation images, a discrimination capability value indicating a degree of contribution for identifying the subject of the model image is calculated, the discrimination capability values also correspond to the corresponding feature It is further registered in the model dictionary along with information indicating points,

The shift correlation image generation means further weights the pixel values of each pixel of the N shift correlation images according to the identification capability value registered in the model dictionary, thereby giving N weighted values. Generate a shift correlation image,

The correlation sum image generation unit generates the correlation sum image by adding pixel values of pixels of the N weighted shift correlation images generated by the shift correlation image generation unit. The information processing apparatus described.

前記相関画像生成手段は、さらに、

前記モデル辞書に登録されている前記モデル画像の前記N個の特徴点のそれぞれについて、対応するmb個(mbは0以上の整数値)のサポート点の前記特徴量と、前記クエリ画像とのmb個のサポート点相関画像をそれぞれ生成し、前記mb個のサポート点相関画像のそれぞれについて、対応する前記サポート点と前記ベース点の前記モデル画像内の配置位置に応じて、各画素の画素位置をシフトすることで、mb個のサポート点シフト相関画像を生成し、

前記N個の相関画像のそれぞれについて、自身および前記mb個のサポート点シフト相関画像の各画素の画素値を加算することで、N個の相関画像和を生成し、

前記シフト相関画像生成手段は、

前記相関画像生成手段により生成された前記N個の相関画像和のそれぞれから、前記N個のシフト相関画像を生成する

請求項1に記載の情報処理装置。 At least one of the one or more feature points of the model image registered in the model dictionary is a base point, and one or more support points from among the feature points existing within a certain range of the base point Is selected, information indicating their base points and support points is also registered in the model dictionary,

The correlation image generation means further includes:

For each of the N feature points of the model image registered in the model dictionary, the feature amount of the corresponding mb support points (mb is an integer value of 0 or more) and the mb of the query image Each of the support point correlation images is generated, and for each of the mb support point correlation images, the pixel position of each pixel is determined according to the arrangement position of the corresponding support point and the base point in the model image. By shifting, mb support point shift correlation images are generated,

For each of the N correlation images, by adding the pixel values of each pixel of itself and the mb support point shift correlation images, N correlation image sums are generated,

The shift correlation image generation means includes

The information processing apparatus according to claim 1, wherein the N shift correlation images are generated from each of the N correlation image sums generated by the correlation image generation unit.

前記モデル辞書に登録されている前記モデル画像の1以上の前記特徴点のうちの少なくとも1つがベース点とされ、前記ベース点の一定範囲内に存在する前記特徴点の中から前記識別能力値が前記ベース点よりも高い前記特徴点がサポート点として選択された場合、それらのベース点とサポート点を示す情報も前記モデル辞書にさらに登録され、

前記相関画像生成手段は、さらに、

前記モデル辞書に登録されている前記モデル画像の前記N個の特徴点のそれぞれについて、対応するmb個(mbは0以上の整数値)のサポート点の前記特徴量と、前記クエリ画像とのmb個のサポート点相関画像をそれぞれ生成し、前記mb個のサポート点相関画像のそれぞれについて、対応する前記サポート点と前記ベース点の前記モデル画像内の配置位置に応じて、各画素の画素位置をシフトすることで、mb個のサポート点シフト相関画像を生成し、

前記N個の相関画像のそれぞれについて、自身および前記mb個のサポート点シフト相関画像の各画素の画素値を加算することで、N個の相関画像和を生成し、

前記シフト相関画像生成手段は、

前記相関画像生成手段により生成された前記N個の相関画像和の各画素の画素値を、前記モデル辞書に登録された前記識別能力値に応じて重み付けをすることで、N個の重みつきシフト相関画像を生成し、

前記相関和画像生成手段は、前記シフト相関画像生成手段により生成された前記N個の重みつきシフト相関画像の各画素の画素値を加算することで、前記相関和画像を生成する

請求項1に記載の情報処理装置。 For each of the one or more feature points of the model image registered in the model dictionary, the described feature quantity of the model image, the model image from which the model image is extracted, and one or more different model images When correlation images are respectively generated and, based on the correlation images, a discrimination capability value indicating a degree of contribution for identifying the subject of the model image is calculated, the discrimination capability values also correspond to the corresponding feature It is further registered in the model dictionary along with information indicating points,

At least one of the one or more feature points of the model image registered in the model dictionary is set as a base point, and the discrimination ability value is selected from the feature points existing within a certain range of the base point. When the feature point higher than the base point is selected as a support point, information indicating the base point and the support point is also registered in the model dictionary,

The correlation image generation means further includes:

For each of the N feature points of the model image registered in the model dictionary, the feature amount of the corresponding mb support points (mb is an integer value of 0 or more) and the mb of the query image Each of the support point correlation images is generated, and for each of the mb support point correlation images, the pixel position of each pixel is determined according to the arrangement position of the corresponding support point and the base point in the model image. By shifting, mb support point shift correlation images are generated,

For each of the N correlation images, by adding the pixel values of each pixel of itself and the mb support point shift correlation images, N correlation image sums are generated,

The shift correlation image generation means includes

N weighted shifts are performed by weighting the pixel value of each pixel of the N correlated image sums generated by the correlated image generating means in accordance with the discrimination ability value registered in the model dictionary. Generate correlation images,

The correlation sum image generation unit generates the correlation sum image by adding pixel values of pixels of the N weighted shift correlation images generated by the shift correlation image generation unit. The information processing apparatus described.

前記モデル画像からN個(Nは1以上の整数値)の特徴点が抽出され、抽出された前記N個の特徴点の特徴量がそれぞれ記述された場合、前記N個の特徴点とそれらの前記特徴量を示す情報が登録されるモデル辞書が自身内部または外部に存在し、

前記情報処理装置が実行するステップとして、

前記モデル辞書に登録されている前記モデル画像の前記N個の特徴点のそれぞれについて、対応する前記特徴量と、前記クエリ画像との相関画像をそれぞれ生成し、

生成された前記N個の相関画像のそれぞれについて、対応する前記特徴点の前記モデル画像内の配置位置に応じて、各画素の画素位置をシフトすることで、N個のシフト相関画像を生成し、

生成された前記N個のシフト相関画像の各画素の画素値を加算することで、相関和画像を生成し、

生成された前記相関和画像に基づいて、前記モデル画像の被写体と前記クエリ画像の被写体とが一致するか否かを判定する

ステップを含む情報処理方法。 In the information processing method of the information processing apparatus for comparing the query image and the model image and identifying the subject of the model image and the subject of the query image,

When N feature points are extracted from the model image (N is an integer value equal to or greater than 1), and the feature amounts of the extracted N feature points are respectively described, the N feature points and their feature points are described. A model dictionary in which information indicating the feature amount is registered exists inside or outside itself,

As the step executed by the information processing apparatus,

For each of the N feature points of the model image registered in the model dictionary, a correlation image between the corresponding feature amount and the query image is generated, respectively.

For each of the generated N correlation images, N shift correlation images are generated by shifting the pixel position of each pixel according to the arrangement position of the corresponding feature point in the model image. ,

A correlation sum image is generated by adding pixel values of each pixel of the generated N shift correlation images,

An information processing method including a step of determining whether or not a subject of the model image matches a subject of the query image based on the generated correlation sum image.

前記モデル画像からN個(Nは1以上の整数値)の特徴点が抽出され、抽出された前記N個の特徴点の特徴量がそれぞれ記述された場合、前記N個の特徴点とそれらの前記特徴量を示す情報が登録されるモデル辞書が自身内部または外部に存在するコンピュータに、

前記モデル辞書に登録されている前記モデル画像の前記N個の特徴点のそれぞれについて、対応する前記特徴量と、前記クエリ画像との相関画像をそれぞれ生成し、

生成された前記N個の相関画像のそれぞれについて、対応する前記特徴点の前記モデル画像内の配置位置に応じて、各画素の画素位置をシフトすることで、N個のシフト相関画像を生成し、

生成された前記N個のシフト相関画像の各画素の画素値を加算することで、相関和画像を生成し、

生成された前記相関和画像に基づいて、前記モデル画像の被写体と前記クエリ画像の被写体とが一致するか否かを判定する

ステップを実行させるプログラム。 A computer that controls an information processing apparatus that compares a query image and a model image and identifies a subject of the model image and a subject of the query image,