JP4846892B2 - Image processing system and material storage method - Google Patents

Image processing system and material storage method Download PDFInfo

- Publication number

- JP4846892B2 JP4846892B2 JP2000113275A JP2000113275A JP4846892B2 JP 4846892 B2 JP4846892 B2 JP 4846892B2 JP 2000113275 A JP2000113275 A JP 2000113275A JP 2000113275 A JP2000113275 A JP 2000113275A JP 4846892 B2 JP4846892 B2 JP 4846892B2

- Authority

- JP

- Japan

- Prior art keywords

- data

- metadata

- audio

- indicating

- video

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Expired - Fee Related

Links

Images

Description

【0001】

【発明の属する技術分野】

本発明は、映像データ、音声データ及びメタデータを記録する画像処理システム及び素材蓄積方法に関する。

【0002】

【従来の技術】

撮像装置が画像データを記録する際に、記録する画像データとともに、その編集点に対応する付加情報を記録媒体に記録させる技術が普及しつつある。編集者は、この付加情報を参照することによって、必要な編集点を検索することができる。

【0003】

従来、この付加情報は、撮影前に撮影者が撮像装置に設けられた入力装置を操作することにより入力されていた。撮像装置は、入力された付加情報を画像データとともに記録媒体に記録している。

【0004】

また、ビデオテープ等の記録媒体に記録された映像情報を編集する方法の1つとして、オフライン編集がある。オフライン編集は、撮影現場において、オリジナルテープに記録した映像情報を、一旦別の記録テープ即ち編集用テープにコピーし、この編集用テープ上で編集点等の編集データを作成し、この編集データに基づいてマスターテープを作成する方法がある。オフライン編集では、オリジナルテープ上の記録情報を誤って消去したり、書き換えるおそれがなく所望のマスターテープを作成することができる。

【0005】

しかし、オフライン編集では、オリジナルテープをコピーした編集用テープを使用して編集作業を行うため、オリジナルテープ上に記録された情報を編集用テープにコピーする際に時間や手間がかかるといった問題がある。

【0006】

そこで、上述のような問題を解決する方法の1つとして、オリジナルテープ上の情報を、ハードディスク等の記録可能で、且つランダムアクセス可能なディスク状記録媒体に一旦コピーし、このディスク状記録媒体上のコピー情報を用いて編集データを作製する方法がある。

【0007】

【発明が解決しようとする課題】

しかしながら、撮影に注力すべき撮影者にとって、付加情報を入力することは煩わしい作業であるため、撮像装置に付加情報を入力する機能が備えられているのにも関わらず、付加情報の入力が行われないことが多かった。

【0008】

一方、複数のネットワークを互いにパケット通信で結ぶことによって仮想的なネットワークを構成した、いわゆるインターネットのようなネットワークを利用した通信の普及とともに、映像データや音声データ等の様々なコンテンツデータの配信が可能になってきている。

【0009】

それにともなって、番組を制作して放送する放送局等においては、断片化されている映像データ及び音声データに対しても、これらのコンテンツデータに関する詳細な情報を管理する必要がある。具体的には、放送局等で番組として制作された放送用素材を識別するための情報、著作権に関する情報等、種々の付加情報がコンテンツとともに配信される必要がある。

【0010】

そこで本発明は、このような従来の実情に鑑みて提案されたものであり、上記画像データ及び音声データとともに、上記画像データ及び音声データを識別するための付加情報とを記録することを可能とする画像処理システム及び素材蓄積方法を提供することを目的とする。

【0011】

【課題を解決するための手段】

上述した目的を達成するために、本発明に係る画像処理システムは、撮像装置に収録された映像データ及び音声データを、該映像データ及び音声データが上記撮像装置に収録される際に該音声データ及び映像データを識別するための第1のメタデータとともに記録する記録手段から、該映像データ、音声データ及び第1のメタデータが入力される入力処理手段と、上記第1のメタデータとは別の第2のメタデータを生成するメタデータ生成手段と、上記入力処理手段に入力された映像データ、音声データ及び第1のメタデータを上記メタデータ生成手段で生成された第2のメタデータとともに記録するデータ蓄積手段と、上記データ蓄積手段に記録された映像データ、音声データ、第1のメタデータ及び第2のメタデータを読み出して出力する出力処理手段とを備える素材蓄積装置と、上記出力処理手段から出力された第1のメタデータ及び第2のメタデータに基づいて、上記出力処理手段から出力された映像データ及び音声データを編集する編集装置と、上記編集装置により編集された映像データ及び音声データを、該編集された映像データ及び音声データを保管する際に新たに入力される第3のメタデータとともに保管する保管用データ記録装置とを備え、上記保管用データ記録装置では、上記編集装置からの要求に応じて、上記素材蓄積装置に記録されている映像データ及び音声データが取り出される。

【0012】

上述した目的を達成するために、本発明に係る素材蓄積方法は、撮像装置に収録された映像データ及び音声データを、該映像データ及び音声データが上記撮像装置に収録される際に該音声データ及び映像データを識別するための第1のメタデータとともに記録手段に記録する記録工程と、上記記録手段に記録された映像データ、音声データ及び第1のメタデータが入力処理手段に入力される入力処理工程と、上記第1のメタデータとは別の第2のメタデータを生成するメタデータ生成工程と、上記入力処理手段に入力された映像データ、音声データ及び第1のメタデータを、上記メタデータ生成工程で生成された第2のメタデータとともにデータ蓄積手段に記録するデータ蓄積工程と、上記データ蓄積手段に記録された映像データ、音声データ、第1のメタデータ及び第2のメタデータを読み出して出力する出力処理工程と、上記出力処理工程で出力された第1のメタデータ及び第2のメタデータに基づいて、上記映像データ及び音声データを編集する編集工程と、上記編集工程で編集された映像データ及び音声データを、該編集された映像データ及び音声データを保管する際に新たに入力される第3のメタデータとともに保管する保管用データ記録工程とを有し、上記保管用データ記録工程では、上記編集工程からの要求に応じて、上記データ蓄積工程で記録された映像データ及び音声データが取り出される。

【0013】

ここで、別のメタデータには、素材データの供給源を示すソース(Source)、データストリームの形式を示すフォーマット(Format)、映像の圧縮を示すビデオ・ビット・レイト(Video Bit Rate)、映像がMPEG形式の場合の圧縮率を示すジー・オー・ピー・サイズ(GOP Size)、解像度を表すレゾリューション(Resolution)、音声データのチャンネル数を表すオーディオ・ナンバ・オブ・チャンネル(Audio Number of Channel)、音声データが圧縮されているか否かを表すオーディオ・コンプレッション(Audio Compression)、オーディオサンプリング周波数を表すオーディオ・サンプリング・レイト(Audio Sampling Rate)、音声データのサイズを表すオーディオ・データ・サイズ(Audio Data Size)、収録方法を示すレック・タイプ(REC_Type)、既存の画像処理システムにおいて使用されている素材を識別するためのIDを示すマテリアル・ID(Material_ID)、素材に対して、数回の編集等を施す間に変形したか否か等を示すサブ・キー(Sub Key)、素材データの種類を示すIDであるユーミッド・データ(UMID(Data))、ユーミッド・オーディオとユーミッド・ビデオとを纏めたユーミッド・システム(UMID(System))、素材の長さを表すファイル・レングス(File Length)、映像及び音声データを含むファイル全体のサイズ表したエッセンシャル・サイズ(Essence_Size)、映像及び音声データを含むファイル全体のサイズ表したエッセンシャル・サイズ(Essence_Size)、映像データが静止画であるか否かを示すオブジェクト・タイプ(Object Type)、素材データの有効期限を示すバリッド・デイト(Valid Date)を表すメタデータが挙げられる。

【0014】

【発明の実施の形態】

本発明に係る画像処理システムは、例えば放送局,映像制作会社等において、映像及び音声等(以下、素材と記す。)を取材し、これらの素材を編集・加工して放送用の映像を制作し、更にこの映像を保管する画像処理システムであって、素材の取材工程,編集工程,保管工程等の各画像処理工程において、素材を詳細に識別するための付加情報を記録媒体、或いは専用の記録サーバに入力するものである。

【0015】

なお、付加情報としてはメタデータが挙げられる。メタデータとは、例えば取材時刻,取材ID,取材題目,撮影者名,レポータ名等、取材によって得られた素材を識別するために必要な情報を記述するためのデータである。

【0016】

放送局において、例えばニュース番組の制作を行う場合を、図1を用いて説明する。ただし、図1は、ニュース番組を制作する際の作業の流れを説明するものであり、装置等の構成要素を示すいわゆるブロック図とは異なる。

【0017】

放送局におけるニュース番組制作は、図1に示すように、撮影前段階(Pri-Production;プリプロダクション)10,撮影制作段階(Production;プロダクション)20,撮影後処理段階(Post-production;ポストプロダクション)30,放送段階(Distribution;ディストリビューション)40,保管段階(Archive;アーカイブ)50の5つに分類することができる。

【0018】

撮影前段階10は、プロデューサー,ディレクター,アナウンサー,取材スタッフ等の関係者が、ニュース番組の放送内容等を関する打ち合わせを行う段階であり、放送項目の決定、中継車,取材機材,取材クルーの割り振り等が行われる。図1においては、計画(Planning;プラニング)工程11として示される。

【0019】

撮影制作段階20は、主に映像及び音声の収集を行う段階であり、図1においては、取材(Acquisition;アクイジション)工程21,素材蓄積(Ingest;インジェスト)工程22及びボイスオーバ(Voice Over)工程23が、この撮影制作段階20に相当する。

【0020】

取材工程21は、映像及び音声の収集に相当する「取材」を示している。また、素材蓄積工程22では、取材で得られた映像及び音声(以下、素材と記す。)の蓄積が行われる。素材蓄積工程22は、例えば素材が記録されたビデオカセットテープ等を保管棚に保管すること、又は素材蓄積用サーバに素材のデータを記憶することに相当するものである。また、ボイスオーバ工程23では、映像にナレーション等の音声が挿入される。

【0021】

撮影後処理段階30は、収集した素材を編集して放送できる状態に仕上げる段階であり、図1においては、CG(Computer Graphics;コンピュータグラフィクス)作成工程31及び本編集(Complete Edit;コンプリートエディット)工程32が、この撮影後処理段階30に相当する。

【0022】

CG作成工程31は、コンピュータグラフィクスにより映像を作成すること、及び映像に重ねて表示する地図,天気図,文字等を作成することである。また、本編集工程32は、計画工程11で決定された内容に基づいて、素材の編集を行うことである。

【0023】

放送段階40は、編集した素材をオンエア(放送)する段階であり、図1においては、クローズドキャプション(Closed Caption)工程41,生中継(Live;ライブ)42,オートメーション(Automation)工程43及び放送工程44が、この放送段階40に相当する。

【0024】

クローズドキャプション工程41は、文字放送用の文字を作成する作業を示している。また、生中継42は、ニュース番組の放送中に、中継をリアルタイムで放映する場合を示している。また、オートメーション工程43は、コンピュータの制御によって、編集された素材,クローズドキャプション信号,及び生中継42の映像データ等を混成して、放送用のニュース番組を自動的に生成する作業を示す。また、放送工程44は、オートメーション工程43で生成した放送用のニュース番組を送信することを示している。

【0025】

保管段階50は、映像データ及び音声データの保管を行う段階であり、図1においては、仮保管工程(Near Line Archive;ニアラインアーカイブ)51及び保管工程(Archive;アーカイブ)52が、この保管段階50に相当する。

【0026】

仮保管工程51は、編集された素材の中で、近日中に再度使用される可能性があるものを仮に保管する場合を示す。また、保管工程52は、素材を長期保管する場合を示す。

【0027】

図1に示すNCS60は、Newsroom Computer System(ニュースルームコンピュータシステム)を示し、ニュースルーム全体の情報を統括管理する場所である。NCS60では、オンエア項目の管理、及びどの素材がどの段階の処理を受けているか等の素材管理が行われているほか、他の放送局等との間における素材の売買等の管理も行われている。また、NCS60では、記者によって、当該NCS60に接続された端末から記事を書くことも行われる。

【0028】

次に、上述のような作業の流れに基づいてニュース番組を制作する場合に、上述した各段階で入力されるメタデータの例を示す。メタデータのデータ構造等については後述する。

【0029】

まず、計画工程11において、放送項目の決定、中継車,取材機材,取材クルーの割り振り等が行われる。

【0030】

計画工程11では、ニュース番組の放送内容が検討され、検討されたニュース番組の内容に基づいたメタデータが入力される。このメタデータの例を図2に示す。計画工程11で決定されるメタデータの例としては、撮影開始時間を表すGathering_Start_DateTimeと、撮影終了時間を表すGathering_End_DateTimeと、撮影地名を表すGathering_Location_Placeと、撮影者名を表すPhotographerと、記者に関する情報を表すJurnalist Informationと、ニュース番組のディレクターを表すDirectorと、ニュース番組のプロデューサを表すProducerと、ニュース取材題目を表すTitleと、撮影内容に関連するその他の情報が入力されるContentsと、NCS(Newsroom Computer System)に登録されているニュース番組・放送項目毎に設定されたID(identifier:識別子)であるNCS ID等がある。

【0031】

計画工程11において、以上に例示したメタデータがNCS60に備えられるメモリ等に書き込まれる。なお、計画工程11で記述されたメタデータは、後述する段階で変更されて書き換えられる場合がある。

【0032】

計画工程11から取材工程21に移行する過程で、取材工程21の段階で取材を行う機器、即ち撮像装置等に対してメタデータが伝送される。ここで伝送されるメタデータの例を図3に示す。計画工程11から取材工程21に移行する過程とは、例えば中継車が取材場所に向かって移動する期間と考えることができる。

【0033】

この過程において、計画工程11の段階で検討されたニュース番組の内容に基づいて、図2に示したGathering_Start_DateTime,Gathering_End_DateTime,Gathering_Location_Place,Photographer,Jurnalist Information,Director,Producer,Title,Contents,及びNCS IDを表すメタデータが放送局から取材場所に移動する撮像装置に送信される。

【0034】

取材工程21の段階では取材が行われる。取材工程21において使用される素材のデータを記録する撮像装置は、無線通信によりメタデータを受信し、当該撮像装置が備えるメモリに記憶する。撮像装置は、映像を撮影する際に、上述のメタデータをメモリから読み出して映像データ及び音声データとともに記録媒体に記録する。このとき撮像装置は、放送局より送信されたメタデータの他に、新たなメタデータを自動的に発生し、上述のメタデータとともに入力する。新たに入力されるメタデータの例を図4(a)に示す。

【0035】

取材工程21において新たに入力されるメタデータとしては、図3に示したメタデータに加えて、GPS(Grobal Positioning System )で検出される位置情報を示すGathering_Location_Latitude(GPS緯度)・Gathering_Location_Longitude(GPS経度)・Gathering_Location_Altitude(GPS高度)と、GPSで検出される時間を示すGathering_Location_Time(GPS Time)と、取材場所の地名を表すGathering_Location_Place(地名)と、撮像装置毎のIDである機材IDと、レンズ情報等を示すCamera Setup Imformationと、記録媒体を識別するReel Numberと、撮影に要した時間を示すDuration(Time)と、各シーンの開始時間を示すSOM(Start Of Material)と、手動で入力されるマーク点に関するGood Shot Mark & REC Start Markと、マイクの割り当てを示すAudio Channel Informationと、音声の記録方法を示すAudio Typeと、素材を識別するためのUMID(Audio)及びUMID(Video)と、著作権を表すCopyright等が挙げられる。

【0036】

以上のメタデータが記録媒体及び専用の記録サーバに対して入力される。取材工程21の段階で生成及び変更された上述のメタデータは、NCS60に送信される場合もある。

【0037】

取材工程21において収集された素材は、素材蓄積工程22の段階を経ることによって、使用の機会があるまで素材記録サーバに蓄積される。図4(b)に素材蓄積工程22において記録媒体に入力されるメタデータの例を示す。

【0038】

素材蓄積工程22では、図4(a)に例示したメタデータに加えて、素材データの供給元を表すSourceと、素材データの開始時間を表すSTC(Start Of Contents)と、データストリームの形式を示すFormatと、映像の圧縮率を示すVideo Bit Rateと、映像データがMPEG圧縮されている場合のピクチャグループを示すGOP(Group Of Pictures) Sizeと、解像度を表すResolutionと、音声データのチャンネル数を表すAudio Channel数と、音声データが圧縮されているか否かを表すAudio Compressionと、オーディオサンプリング周波数を表すAudio Sampling Rateと、音声データのサイズを表すAudio Date Sizeと、収録方法を示すREC_Typeと、既存の画像処理システムにおいて使用されている素材を識別するためのIDであるMaterial_IDと、編集した際に内容を変更したか否かを表すSub Keyと、素材データに関する情報を記述するUMID(Data)と、UMID(Audio)とUMID(Video)とを纏めたIDを表すUMID(System)と、素材の長さを時間で表すFile Lengthと、ファイル全体のサイズを表すEssence_Sizeと、映像データが静止画であるか否か、又は音声データか映像データかを示したObject Typeと、素材の有効期限を示すValid Date等が入力される。

【0039】

図4(a)及び(b)に示したメタデータは、記録媒体に画像データ及び音声データとともに記録されるほか、画像データ及び音声データから切り離され、NCS60等で管理される場合もある。

【0040】

以上説明した計画工程11,取材工程21及び素材蓄積工程22のそれぞれの段階で生成されて記録されたメタデータ及び素材データは、記者によって粗編集及び記事作成が行われる際に使用される。

【0041】

図5(b)に、記者によって粗編集及び記事作成等が行われる際に使用及び入力されるメタデータを例示する。図5(a)は、撮像装置において主に入力されるメタデータを示し、図5(b)は、素材蓄積工程22で主に入力されるメタデータを示している。これらに加え、更に新たなメタデータが入力される。

【0042】

図5(a)及び(b)に示すGathering_Start_DateTime,Gathering_End_DateTime,Gathering_Location_Place,Photographer,Jurnalist Information,Director,Producer,Title,Contents,NCS ID,Gathering_Location_Latitude(GPS緯度),Gathering_Location_Longitude(GPS経度),Gathering_Location_Altitude(GPS高度),Gathering_Location_Time(GPS Time),Gathering_Location_Place(地名),機材ID,Camera Setup Imformation,Reel Number,Duration(Time),SOM,Good Shot Mark & REC Start Mark,Audio Channel Information,Audio Type,UMID(Audio),UMID(Video),Copyright,Source,STC,Format,圧縮率(Video Bit Rate),GOP Size,Resolution,Audio Channel数,Audio Compression,Audio Sampling Rate,Audio Date Size,REC_Type,Material_ID,Sub Key,UMID(Data),UMID(System),File Length,Essence_Size,Object Type,Valid Dateの各メタデータは、計画工程11,取材工程21及び素材蓄積工程22の各段階で入力されるものであり、これらメタデータは、粗編集において使用される。また、これらのメタデータの中には、粗編集によって書き換えられるメタデータもある。

【0043】

記者によって行われる粗編集及び記事作成の段階で新たに入力されるメタデータとしては、編集内容に関する情報を表すEDL(Editing Decision List) Information,記事原稿を記述したScriptが挙げられる。

【0044】

本編集工程32では、計画工程11で決定された内容に基づいて、ボイスオーバ工程23からの素材と素材蓄積工程22において記録サーバに蓄積されている素材とを使用して本編集が行われ、最終的に放送するニュース番組映像(以下、放送用素材と記す。)が制作される。また、このときCG合成15において作成されたCG画像,保管工程52及び仮保管工程51にて保管された素材が使用される場合もある。図6(a)及び(b)に、本編集が行われる際に使用されるメタデータを例示する。図6(a)は、撮像装置において主に入力されるメタデータを示し、図6(b)は、素材蓄積工程22で主に入力されるメタデータを示している。これらに加え、更に新たなメタデータが入力される、或いは内容が書き換えられる。

【0045】

Gathering_Start_DateTime,Gathering_End_DateTime,Time Zone,Gathering_Location_Place,Photographer,Jurnalist Information,Director,Producer,Title,Contents,NCS ID,Gathering_Location_Latitude(GPS緯度),Gathering_Location_Longitude(GPS経度),Gathering_Location_Altitude(GPS高度),Gathering_Location_Time(GPS Time),Gathering_Location_Place(地名),機材ID,Camera Setup Imformation,Reel Number,Reel Number,Duration(Time),SOM,Good Shot Mark & REC Start Mark,Audio Channel Information,Audio Type,UMID(Audio),UMID(Video),Copyright,Source,STC,Format,圧縮率(Video Bit Rate),GOP Size,Resolution,Audio Channel数,Audio Compression,Audio Sampling Rate,Audio Date Size,REC_Type,Material_ID,Sub Key,UMID(Data),UMID(System),File Length(Time),Essence_Size(Byte),Object Type,Valid Date,EDL Information,Scriptの各メタデータは、計画工程11,取材工程21,素材蓄積工程22及び記者による粗編集で生成・使用されるものである。これらのメタデータは、本編集工程32において素材の編集を行う際に使用される。

【0046】

これらのメタデータの中には、本編集によって書き換えられるメタデータもある。本編集工程32では、主にEDL Information,Scriptを表すメタデータが、編集した内容に応じて書き換えられ、確定される。

【0047】

一方、CG作成工程31では、コンピュータグラフィクスにより映像に重ねて表示する天気図,地図,文字等が作成される。このときCG合成画面は、位置情報を示すメタデータに基づいて自動的に作成される。この様子を図7に示す。

【0048】

ここで使用されるメタデータには、例えば、取材工程21段階で撮影装置によって入力されるGathering_Location_Latitude(GPS緯度),Gathering_Location_Longitude(GPS経度),Gathering_Location_Altitude(GPS高度),Gathering_Location_Time(GPS Time)等の位置情報を示すメタデータや、Script,Title等のメタデータがある。

【0049】

素材に記録されたGathering_Location_Latitude(GPS緯度),Gathering_Location_Longitude(GPS経度),Gathering_Location_Altitude(GPS高度)のメタデータに基づいて、これらの位置情報に対応する地域の地図が、地図を記憶するデータベースから自動的に抽出される。また、Gathering_Location_Time(GPS Time)を参考にして、自動的に時間が表示される。

【0050】

このように自動的に作成されたCG合成画面は、編集用のCG合成GUI(Graphical User Interface)において、編集者が自由に編集を行える。

【0051】

続くオートメーション工程43の段階では、編集された映像に加えて、クローズドキャプション工程41で生成されたクローズドキャプション信号と、CG合成画面と、生中継42からの中継映像が加えられて放送される映像データ,音声データ及びメタデータが合成される。

【0052】

ここで映像及び音声データとともに合成されて送出されるメタデータは、計画工程11,取材工程21,素材蓄積工程22,記者による粗編集,本編集工程32において生成及び使用されたメタデータである。

【0053】

特に、Gathering_Start_DateTime,Gathering_End_DateTime,Time Zone,Gathering_Location_Place,Photographer,Jurnalist Information,Director,Producer,Title,Contents,NCS ID,Gathering_Location_Latitude(GPS緯度),Gathering_Location_Longitude(GPS経度),Gathering_Location_Altitude(GPS高度),Gathering_Location_Time(GPS Time),Gathering_Location_Place(地名),機材ID,Camera Setup Imformation,Reel Number,Reel Number,Duration,SOM,Good Shot Mark & REC Start Mark,Audio Channel Information,Audio Type,UMID(Audio),UMID(Video),Copyrightが挙げられる。Source,STC,Format,圧縮率(Video Bit Rate),GOP Size,Resolution,Audio Channel数,Audio Compression,Audio Sampling Rate,Audio Date Size,REC_Type,Material_ID,Sub Key,UMID(Data),UMID(System),File Length,Essence_Size,Object Type,Valid Date,EDL Information,Scriptの各メタデータの中から放送用素材を受信する視聴者にとって必要とされるメタデータを抽出して送信することもできる。

【0054】

オートメーション工程43において、合成されたニュース番組は、放送段階40において、オンエア(放送)される。

【0055】

放送後の映像データ,音声データ及びメタデータは、仮保管工程51の段階で一定期間仮保管され、その後、保管工程52の段階で長期保管される。保管された素材は、保管用の記録装置等から適宜抽出され使用される。

【0056】

このとき、メタデータとして記述されている素材の付加情報を素材を識別するための素材固有の識別子として使用することができる。また、メタデータとして入力されている付加情報を参照することによって、例えば編集者・記者等は、直ちに所望の素材を検索できる。

【0057】

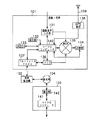

以上説明したような作業の流れに基づいて、画像処理を行う画像処理システムを、図8を用いて具体的に説明する。画像処理システム1は、素材(映像及び音声)の取材,編集,保管等を行う各装置を備えたものであり、各装置での処理工程で、素材を詳細に識別するための付加情報を記録媒体、或いは専用の記録サーバに入力するものである。ここでは、特にニュース番組を制作する場合について示す。

【0058】

画像処理システム1は、映像及び音声を映像データ及び音声データとして記録媒体に記録する撮像装置101と、後述の基地局を介して付加情報を入力し、撮像装置101へとこれを送信する携帯型電話機102と、基地局へ付加情報を送信するデータ管理装置103と、データ管理装置103から携帯型電話機102へ送信されるデータを中継する基地局104とを備える。

【0059】

また、画像処理システム1は、映像データ及び音声データの記録及び/又は再生が行われる記録媒体を内部に有する記録媒体筐体105と、記録媒体に記録されたデータの再生を行う記録再生装置106と、記録再生装置106における操作及び再生される映像等を表示するモニタ107と、再生された映像データ及び音声データを一時的に蓄積する素材蓄積装置108と、素材の編集を行う編集装置109と、編集装置109における操作及び編集画像を表示するモニタ110とを備える。

【0060】

また、画像処理システム1は、当該システムにおける素材管理等を行う統合管理装置111と、記者等が素材に対しての情報を入力する記者用端末112と、他のネットワークに接続されて情報の入出力を行う入出力端末113とを備える。

【0061】

また、画像処理システム1は、制作された放送用素材を保管する保管用記録装置114と、放送用素材の時間軸とは関係のない情報を生成して付加するオーサリング端末115と、オーサリング端末115で生成された情報に配信のための配信用データを付加するメディアキャスタ116と、編集装置109によって編集された放送用素材と、時間軸とは関係のない情報と、配信用データとを混成するマルチプレクサ117と、送出用の放送用素材を一時的に記録する送出用映像音声記録装置118と、マルチプレクサ117によって生成された放送用素材を送出する送出部119と、送出部119から送出される放送用素材を受信するためのセットトップボックス120と、放送用素材を受信して表示するテレビジョン受像機121とを備える。

【0062】

更に、画像処理システム1は、撮像装置101,素材蓄積装置108,編集装置109,保管用記録装置114の各装置において素材の撮影,蓄積,編集,保管等を行った際に、素材に関する付加情報を示したメタデータを、映像データ及び音声データ(以下、素材データと記す。)とともに入力することによって、素材を明確に識別することを可能としたものである。

【0063】

図9乃至図11に、付加情報として入力されるメタデータの具体例を示す。図9乃至図11は、便宜上分割して示すが、これらは一連の図である。

【0064】

図9乃至図11に、「F」,「T」,「Sh」,「Sc」,「M」,「P」の記号として示される周期とは、メタデータの変更周期を表している。即ち、「F」(Frame)は、1/30秒毎に連続的に撮影される映像の1コマ周期で変更されるメタデータである「T」(Take)は、テイク毎に変更されるメタデータである。「Sh」(Shot)は、ショット周期で変更されるメタデータである。「Sc」(Scene)は、シーン周期で変更されるメタデータである「M」(Media)は、記録媒体毎に決められたメタデータである。「P」(Project)は、ニュース番組毎に決められたメタデータである。

【0065】

図9乃至図11には他に、メタデータを説明する日本語表記と英語表記とが示されている。また、SMPTE(Society of Motion Picture and Television Engineers,Inc)によって既に規定されているメタデータは、SMPTE Dictionaryの欄に「07 01 05 02 04 00 00 00」のように実際の値を示している。

【0066】

図9乃至図11に示したメタデータを具体的に説明する。

【0067】

Gathering_Location_Latitudeは、GPS(Grobal Positioning System )で検出される緯度を表すメタデータであり、Gathering_Location_Longitudeは、GPSで検出される経度を表すメタデータであり、Gathering_Location_Altitudeは、GPSで検出される高度を表すメタデータであり、Gathering_Location_Timeは、GPSで検出される時間を表すメタデータである。これらのGPSによる位置情報は、撮像装置101が備えるGPS受信部138から随時発生されている。また、GPSで検出される時間情報は、UTC(Coordinated Universal Time;調整済グリニジ平均時)によって表されており、UTCからの時差を表すTime Zone情報を含んで示されている。例えば日本の場合、UTCとの時差は9時間であるため、+9を示す情報が含まれている。

【0068】

Gathering_Location_Placeは、取材場所の地名を表すメタデータである。

【0069】

UMID(Audio)及びUMID(Video)は、素材を識別するために付される全世界で唯一になるように決められたIDである。UMIDについての詳細は後述する。

【0070】

UMID(Data)は、素材データに関する情報を記述するためのメタデータであるが、取材時に撮像装置によって記述されるUMID(Audio),UMID(Video)とは異なり、映像データが静止画であるか,グラフィックであるか,クローズドキャプション信号であるか、音声データがMIDI(Musical Instrument Digital Interface)であるか等を表すIDである。

【0071】

UMID(System)は、ある素材に対して付されるUMID(Audio)とUMID(Video)とを纏めたIDを表している。

【0072】

Photographerは、撮影者の名前を表すメタデータである。Jurnalist Informationは、取材を担当する記者に関する情報が書き込まれるメタデータである。 Directorは、ニュース番組のディレクターを表すメタデータである。

【0073】

Good Shot Mark & REC Start Markは、撮影の際、手動で入力されるマーク点に関するメタデータである。

【0074】

Camera Setup Imformationは、例えば撮像装置が備えるCCD(Charge Coupled Device)の設定情報,レンズメーカ・絞り値・レンズ倍率等を記述するレンズデータ,及びクレーン角度等を含むメタデータである。Camera Setup Imformationは、特にCG合成15の段階で必要となる。

【0075】

機材IDは、取材に使用する撮像装置を表すメタデータであり、撮像装置毎に固有の識別ナンバを有する。

【0076】

Take Numberは、テイク周期で変更されるメタデータである。

【0077】

素材開始タイムコード(Start Of Material)は、各シーンの開始時間を示すメタデータである。

【0078】

Contentsは、撮影内容に関連するその他の情報が入力されるメタデータである。

【0079】

Valid Dateは、素材の有効期限を示すメタデータである。

【0080】

Audio Channel Informationは、マイクチャンネルインフォメーションを示すメタデータである。Audio Channel Informationは、例えば1チャンネルがレポータマイクに割り当てられ、2チャンネルが相手マイクに割り当てられている等のマイク情報が記述されている。

【0081】

Audio Typeは、音声の記録がモノラルか、ステレオか、バイリンガルかを示すメタデータである。

【0082】

Sourceは、記録サーバに供給される素材が、記録媒体等に記録されて直接放送局に持ち込まれたものであるか、衛星通信,無線通信等によって取材場所から送信されたものであるか、或いは他の放送局から配信されたものであるか等の映像データの供給源を表すメタデータである。

【0083】

Formatは、DVフォーマットであるか,MPEG_MP@MLフォーマットであるか,MPEG_4:2:2P@MLフォーマットであるか等のデータストリームの形式を示すメタデータである。

【0084】

Video Bit Rateは、映像の圧縮率を示すメタデータである。

【0085】

Audio Number of Channelは、オーディオデータのチャンネル数を表すメタデータである。Audio Compressionは、オーディオデータが圧縮されているか否かを表すメタデータである。

【0086】

Audio Compressionは、オーディオデータの圧縮率を表すメタデータである。

【0087】

Audio Sampling Rateは、オーディオサンプリング周波数を表すメタデータである。

【0088】

Audio Date Sizeは、オーディオデータのサイズを時間、或いはバイト数によって表示するメタデータである。

【0089】

REC_Typeは、Auto,Manual,GPI,Endress,Open End等の収録方法を示すメタデータである。

【0090】

Material_IDは、既存の画像処理システムにおいて使用されている素材を識別するためのIDである。即ち、Material IDは、UMIDに相当するものであり、記述されない場合もある。

【0091】

Sub Keyは、Version,Segment,Revision等を示すメタデータであり、素材に対して、数回の編集等を施す間に変形したか否か等を示すものである。

【0092】

File Length(Time)は、素材の長さを時間で表すためのメタデータである。

【0093】

Gathering_Start_DateTimeは、撮影を開始する時間を表すメタデータであり、UTCによって表される。Gathering_End_DateTimeは、同様にUTCで表され、撮影終了時間を表すメタデータである。これらの時間データは、UTCからの時差を表すTime Zone情報を含んでいる。

【0094】

REC_Start_DateTimeは、編集装置109において、放送用素材を制作する際の編集開始時間をUTCで表したメタデータである。また、REC_End_DateTimeは、編集の終了時間をUTCで表したメタデータである。これらの時間情報には、UTCからの時差を表すTime Zone情報が含まれている。

【0095】

Recording_Operatorは、編集装置109において編集を行ったオペレータの情報を表すメタデータである。

【0096】

File_Ownerは、撮影者等、素材データの所有権情報を表すメタデータである。

【0097】

Shot Numberは、ショット周期で変更されるメタデータである。

【0098】

Duration(Time)は、撮影に要した時間を示すメタデータである。

【0099】

GOP Sizeは、映像がMPEG形式によって圧縮されている場合、その圧縮率を示すメタデータである。

【0100】

Resolutionは、720*512,720*480,544*480,480*480,352*480等の解像度を表すメタデータである。

【0101】

Essence_Size(Byte)は、映像及び音声データを含むファイル全体のサイズをバイト数によって表したメタデータであり、時間によって表示する場合もある。

【0102】

Object Type(Still,Audio,Video,Key Source)は、映像データが静止画であるか否かを示すStill,オーディオデータであるか映像データであるかを示すAudio及びVideo,テロップ用の指示を示すKey Source等のデータを含むメタデータである。

【0103】

Index,Index_Type,Index_Memoは、検索を行うためのメタデータである。

【0104】

Scene Numberは、シーン周期で変更されるメタデータである。

【0105】

Recording Terminal,REC Portは、収録を行った端末に関する情報を表すメタデータである。

【0106】

Reel Numberは、映像データが記録される記録媒体を識別するためのメタデータであり、同じテープであっても撮像装置から出し入れする毎に異なるNumberとして生成される。

【0107】

Copyrightは、撮影されて記録された映像データの著作権を示すメタデータであり、個人名、或いは放送局名等が入力されるようになっている。

【0108】

Modified_DateTimeは、編集装置109において編集された放送用素材に変更が加えられた日付を示すメタデータであり、OnAir_DateTimeは、放送用素材がオンエアされた日付を示すメタデータであり、Archive_DateTimeは、放送用素材が保管された日付を示すメタデータである。これらは、Time Zone情報を含むUTCによって表される。

【0109】

Producerは、ニュース番組のプロデューサを表すメタデータである。

【0110】

Archive_Operatorは、放送用素材の保管を行ったオペレーターの情報を表すメタデータである。

【0111】

Titleは、撮影題目、或いは取材する内容(素材の内容)を使用する番組名を表すメタデータである。

【0112】

Archive Terminalは、放送用素材の保管を行った端末に関する情報を表すメタデータである。

【0113】

NCS IDは、NCS(Newsroom Computer System)に登録されているニュース番組項目・番組毎に設定されたID(identifier:識別子)である。ただしNCS IDは、NCS60にアクセスするためのIDを示すものではない。

【0114】

EDL Informationは、編集内容に関するメタデータである。具体的には、使用する映像データのイン点,アウト点等が、時間又はReel Numberによって示されたものであり、編集点リストとして記述されている。また、Scriptは、主として読み原稿の内容を示すメタデータである。

【0115】

OnAir_Flagは、編集された放送用素材が、オンエアされたか否かを表すメタデータであり、OnAir_Counterは、何回オンエアされたかを表すメタデータである。

【0116】

Archive_Flagは、取材によって収集した素材が、保管されたか否かを表すメタデータである。

【0117】

Compile_Flagは、一旦保管されている素材を再度整理し、消去するか否かの処理を行った際に、再度記録し直されたことを表すメタデータである。

【0118】

Distribution_Flagは、放送用素材が自局以外の放送局から送出されたか否かを表すメタデータである。素材の売買を行った際にもその情報が記述される。

【0119】

File_Status_Bitは、素材蓄積装置108及び編集装置109における素材の状態を表すメタデータである。

【0120】

以上のようなメタデータを各装置における処理工程で入力することにより、素材の状態,素材にかかる付加情報によって、素材を明確に識別することが可能となる。

【0121】

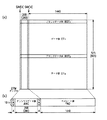

画像処理システム1において、映像データ,音声データ及びメタデータを伝送するための伝送フォーマットとしては、SMPTE(Society of Motion Picture and Television Engineers,Inc)によって規格化されているデジタルデータ伝送フォーマットであるSDI(Serial Digital Interface )を使用する。図12(a)に、SDIフォーマットデータ全体の構成を示す。

【0122】

SDIフォーマットは、終了同期を示す4ドットのEAV(End of Video)領域と、268ドットのアンシラリ(Ancillary;ANS)領域と、開始同期を示す4ドットのSAV(Start of Video)領域と、1440ドットのアクティブビデオ領域とを有し、ライン数525で構成されている。ただし、括弧内の数字は、PAL(Phase Alternation Line)方式で定義される値を示している。

【0123】

アクティブビデオ領域は、9ラインの垂直ブランキング部(VBK1)と、10ラインのオプショナルブランキング部(OBK1)と、244ラインのアクティブビデオ部(ACV1)と、9ラインの垂直ブランキング部(VBK2)と、10ラインのオプショナルブランキング部(OBK2)と、243ラインのアクティブビデオ領域(ACV2)とを有する。

【0124】

SDIは、いわゆるD1フォーマット,D2フォーマットのような非圧縮デジタルデータを伝送するためのフォーマットであり、アンシラリ領域に音声データを格納し、アクティブビデオ領域にD1やD2のようなビデオデータを格納して伝送している。SDIフォーマットにおいて、メタデータは、アンシラリ領域に挿入されて伝送される。

【0125】

図12(b)は、SDIフォーマットの1ラインを示したものである。伝送される際には、1ライン10ビット幅のデータがパラレル―シリアル変換及び伝送路符号化されて伝送される。

【0126】

また、画像処理システム1において映像データ、音声データ及びメタデータを伝送するための伝送フォーマットとしては、上述のSDIフォーマットのほか、MPEG方式,DV方式等で圧縮された圧縮データを伝送するためのSDTI(Serial Digital Transfer Interface)フォーマットや、SDTIフォーマットを更に限定したSDTI-CP(Serial Digital Transfer Interface - Content Package)フォーマットを用いても良い。

【0127】

図13(a)に、SDTIフォーマットのデータ構造を示す。SDTIフォーマットは、SDIフォーマットと同様に、終了同期を示す4ドットのEAV(End of Video)領域と、268ドットのアンシラリ(Ancillary;ANC)領域と、開始同期を示す4ドットのSAV(Start of Video)領域とを有しているが、SDIフォーマットにおいてライン数525で構成されるアクティブビデオ領域が、ペイロード領域と定義されている。ただし、括弧内の数字は、PAL(Phase Alternation Line)方式で定義される値を示している。

【0128】

SDTIフォーマットにおいてペイロード領域は、ブランクデータ部(BDT1、BDT2)と、データ部(DT1、DT2)とを有するが、各データ部のライン数は定義されていない。

【0129】

図13(b)は、SDTIフォーマットの1ラインを示したものである。SDTIフォーマットで伝送される際には、1ライン10ビット幅のデータがパラレル―シリアル変換及び伝送路符号化されて伝送される。

【0130】

SDTIフォーマットでは、アンシラリ領域に、送信元アドレス、宛先アドレス、ラインナンバCRC等が挿入される53ワードのSDTIヘッダデータが含まれている。SDTIフォーマットにおいてメタデータは、アンシラリ領域のSDTIヘッダデータを除いた部分の領域に挿入される。

【0131】

図14に、SDTI-CPフォーマットのデータ構造を示す。SDTI-CPにおけるパケット構成は、SDTIフォーマットを更に限定したものであり、ペイロードの構成に変更を加えて各種データが挿入しやすいようにされている。

【0132】

SDTI-CPフォーマットによって伝送されるデータは、MPEG(Moving Picture Expert Group)2 Video Elementary Stream 等を含むほか、音声やメタデータを含む補助データ等の種々のデータをまとめて伝送することができる。

【0133】

ペイロードに挿入するデータは、「アイテム」で区切られ、各種データは、各アイテムに挿入されている。具体的に、アイテムには、System Item、Picture Item、Audio Item、Auxiliary Itemの4種類がある。

【0134】

System Itemは、System Item Bitmap, Content Package rate,SMPTE Universal Label,Package Metadata Set,Picture Metadata Set,Audio Metadata Set,Auxiliary Metadata Set等の領域を有している。

【0135】

SDTI-CPフォーマットにおいてメタデータは、System ItemのPackage Metadata Set,Picture Metadata Set,Audio Metadata Set,Auxiliary Metadata Set領域に挿入されて伝送される。

【0136】

メタデータは、映像データ及び音声データ等の素材を識別するために付加され、入力される固有のデータであって、SMPTE規格に基づくKLV(Key Length Value)プロトコル及びUMID(Unique Material Identifier)のデータフォーマットによって伝送される。

【0137】

KLVフォーマットとは、Universal Label Dataを記述する16バイトのUniversal Label Data Keyと、Value領域に格納されるメタデータのデータ長を示すValue Lengthと、SMPTE Dictionaryに対応する実際のメタデータが格納されるValueの3つの領域を備えたデータ伝送フォーマットである。図15にKLVフォーマットを示す。

【0138】

Universal Label Data Keyは、格納されるメタデータに対してユニークなラベリングを施すためのデータ領域である。Universal Label Data Keyは、更に、それぞれ1バイトのObject IDと、UL(Universal Label) Sizeとを含むUL(Unibersal Label) Header領域,それぞれ1バイトのUL(Universal Label) Codeと、SMPTE Designと、Registry Designと、Data Designと、Reference Versionとを含むUL(Universal Label) Designatores領域,9バイトのData Element Tag領域の各領域に分けられてる。

【0139】

UMIDは、映像データ,オーディオ(音声)データ及びその他の素材データを識別するために唯一的に決定される識別子である。図16にUMIDのデータ構造を示す。

【0140】

UMIDは、一連の映像、音声及びメタデータ(以下、コンテンツと記す。)から構成される素材データを識別するためのIDとしてのBasic UMIDと、素材データ内の各コンテンツを識別するためのシグネイチャとしてのExtended UMIDとから構成されている。

【0141】

Basic UMIDは、32バイトのデータ領域を有し、12バイトのUniversal Label領域と、1バイトのLength Value領域と、3バイトのInstance Number領域と、16バイトで示されるMaterial Number領域とから構成されている。

【0142】

Universal Label領域は、デジタルデータを識別するための符号が格納しており、詳細は、SMPTE-298Mにおいて規格化されている。Length Value領域は、UMIDの長さを示す。Basic UMIDと、Extended UMIDとでは符号の長さは異なるため、Basic UMIDの場合、13hで示され、Extended UMIDの場合、33hで示される。Instance Number領域は、素材データに上書き処理や、編集処理が施されたか否かを示している。Material Number領域は、3つの領域を有し、素材データを区別するための符号が格納される。

【0143】

4バイトで示されるTime Snapは、1日のスナップクロックサンプル数を示している。クロック単位で素材データの作成時刻等を示すものである。8バイトのRnd(Random Number)は、正確でない時刻をセットした場合や、例えばIEEE(The Institute of Electrical and Electronics Engineers,Inc.)で定義された機器のネットワークアドレスが変化した場合に、2重の番号が付されないようにするためのランダムナンバである。

【0144】

一方、Extended UMIDは、素材が生成された時間と日付とを識別するための8バイトのTime/Date Codeと、素材が生成された時間に関する補正(時差情報)や、緯度、経度、高度で表される位置情報を定義する12バイトのSpatial Co-oredinatesと、省略されたアルファベット等の文字や記号によって、国名4を定義するバイトのAlphnumeric Code(Country)と、省略されたアルファベット等の文字や記号によって、組織名を定義する4バイトのAlphnumeric Code(Organization)と、素材を生成したユーザ名を定義する4バイトのAlphnumeric Code(User)とで構成されている。

【0145】

以上説明したBasic UMID及びExtended UMIDは、映像サイズ、ジェネレーションナンバ等を示すメタデータは含まない。特に、Material Numberは、素材の状態や素材の映像に関する他の情報を示すものではない。映像サイズ、ジェネレーションナンバ等を示すメタデータは、KLVフォーマットに基づいて伝送される。

【0146】

上述の画像処理システム1における撮像装置101,携帯型電話機102,データ管理装置103,基地局104について、図17を用いて詳細に説明する。

【0147】

撮像装置101は、素材管理装置108と接続されたデータ管理装置103から、基地局104及び携帯型電話機102を介して、メタデータを受信するものである。したがって、これらの装置間でのデータの伝送は、図1における計画工程11から取材12へと移行する過程において、移動する撮像装置101が、放送局からメタデータを送信される場合に相当する。

【0148】

撮像装置101は、デジタルビデオカメラであって、映像及び音声を入力する画像音声入力部131と、撮像装置101の操作及びメタデータの入力等を行うための操作部132と、後述するマイクロコンピュータ140のOS(Operating System)等が記録されるHDD(Hard Disk Drive)133と、記録媒体105に対して少なくとも映像及び音声を記録する記録部134と、映像及び音声データと他のデータとを多重化するマルチプレクサ135と、主としてメタデータを記憶するメモリ136と、携帯型電話機102との間の無線インターフェイスであるブルートゥースデバイス137と、GPS(Global Positioning System)信号を受信して位置情報を検出するGPS受信部138と、GPS信号を受信するためのアンテナ139と、上述の各構成を統括して制御するマイクロコンピュータ140とを少なくとも備えている。

【0149】

画像音声入力部131は、図示しないがCCD(Charge Coupled Device)等の撮像するための回路や,マイクロフォン等の録音のための回路を有し、マイクロコンピュータ140からの指示に基づいて、入力された映像及び音声を映像データ及び音声データに変換してマルチプレクサ135に供給する。

【0150】

操作部132は、図示しない各種ボタン,スイッチを有し、撮像装置101の操作、及び必要に応じてメタデータが入力される。

【0151】

HDD133には、マイクロコンピュータ140のOS(Operating System)や、携帯型電話機102を制御するソフトウェア等が記録されており、マイクロコンピュータ140が適宜これらのデータを読み込んで使用する。また、HDD133は、マイクロコンピュータ140によってデータが書き込まれる。

【0152】

記録部134は、図示しないが記録媒体に映像データ,音声データ及びメタデータを記録及び/又は再生する記録再生ヘッド等を有し、マイクロコンピュータ140により制御されてマルチプレクサ135から供給された映像データを記録媒体に記録する。また、記録部134は、マイクロコンピュータ140からの指示に基づいて、記録媒体に記述されるメタデータを検出し、マイクロコンピュータ140に供給する。

【0153】

マルチプレクサ135は、マイクロコンピュータ140により制御され、映像音声入力部131から供給される映像データと、マイクロコンピュータ140から供給されるメタデータとを多重化し、記録部134へと供給する。

【0154】

メモリ136は、消去及び書込が可能な、いわゆるEPROM(Erasable and Programmable ROM)であって、マイクロコンピュータ140からの指示に基づいて、データ管理装置103から供給されるメタデータを記憶する。またメモリ136は、マイクロコンピュータ140から指示に基づいて、記憶しているメタデータをマルチプレクサ135へと供給する。

【0155】

ブルートゥースデバイス137は、携帯型電話機102との間の無線インターフェイスとして使用されるものであり、マイクロコンピュータ140に制御されて、データ管理装置から供給されるメタデータを、携帯型電話機102を介して受信する。また、ブルートゥースデバイス137は、マイクロコンピュータ140より出力されるテープ位置情報を携帯型電話機102を介してデータ管理装置に供給する。

【0156】

ブルートゥースとは、Ericsson社(スウェーデン)が標準化している2.4GHz帯域の電波を使用した近距離無線通信であり、最大転送速度は、1Mbit/sec、変調方式は、GFSK(Gaussian Frequency Shift Keying)とされている。ブルートゥースの最大伝送距離は、10m(出力:1mW)と、100m(出力:100mW)とがあり、これらは用途により使い分けることができる。

【0157】

GPS受信部138は、アンテナ139を介してGPS信号を受信し、撮像装置101の位置情報を検出している。位置情報は、緯度,経度,高度等として表される。

【0158】

マイクロコンピュータ140は、図示しないがCPU(Central Processing Unit),RAM(Random-Access Memory),及びROM(Read Only Memory)を内蔵し、上述の各構成を統括して制御するほか、操作部132からの信号に対応してデジタルビデオカメラ全体の動作の制御を行う。また、撮影に関する種々のメタデータを生成する。

【0159】

一方、データ管理装置103は、例えば電話回線網等に接続されて統合管理装置111と通信が可能なコンピュータであり、例えば撮像装置101を使用して撮影を行う撮影者が所属する放送局等に設置されているものである。データ管理装置103に備えられるマイクロコンピュータ141は、データ管理装置103の全体の動作を統括して制御している。マイクロコンピュータ141は、通信部142を制御して、携帯型電話機102を介して撮像装置101からの信号を受信すると、携帯型電話機102の電話番号を識別して、発信元となっている携帯型電話機102を所有する撮影者が使用している撮像装置101を認識する。データ管理装置103は、認識した撮像装置101に対応するメタデータを携帯型電話機102へと送信する。

【0160】

送信される個々の撮像装置101に対応するメタデータは、予め図8に示す統合管理装置111等において入力され、例えば、統合管理装置111に備えられる図示しないHDDに蓄積されている。

【0161】

図8に示す記録再生装置106は、映像データ及び音声データを、少なくとも再生することが可能な装置であり、特にデジタルビデオテープレコーダである。図18を用いて、記録再生装置106の構成を説明する。

【0162】

記録再生装置106は、SDIフォーマットで供給される映像データ,音声データ及びメタデータを入力する入力端子151と、映像データ,音声データ及びメタデータをSDIフォーマットで外部に出力する出力端子152と、SDIフォーマットで入力されたデータから映像データ,音声データ及びメタデータを抽出する入力処理部153と、データの圧縮符号化、及び復号(伸張)処理を行う圧縮符号化/復号部154と、当該圧縮符号化/復号部154において復号された信号をSDIフォーマットへと変換して出力端子152へと供給する出力処理部155とを備えている。

【0163】

ここで、圧縮符号化/復号部154は、離散コサイン変換を用いた圧縮符号化処理を行っている。

【0164】

記録再生装置106は、更に、圧縮符号化/復号部154によって圧縮符号化された信号に対してエラー訂正コードの付加を行うとともに、記録媒体から再生して得られた信号に対してエラー訂正処理を行って映像信号符号化/復号部154に出力するエラー訂正処理部156と、エラー訂正処理部156によってエラー訂正コードが付加された信号に対して、記録媒体に記録するのに適した符号化処理を行うとともに、この符号化処理に対応する復号処理を記録媒体から再生した映像信号に対して行ってエラー訂正処理部156に出力するチャネルコーディング部157と、このチャネルコーディング部157によって符号化された信号を、記録媒体に記録するとともに、記録媒体に記録された信号を再生してチャネルコーディング部157へと出力する記録再生部158とを備えている。

【0165】

記録再生装置106は、更に、記録媒体筐体105のローディング及び記録再生部158の駆動を行う機構部159と、使用者が各種の操作を行うための操作部160と、記録媒体筐体105に備えられた不揮発性メモリ105aの端子105bと接続される端子162と、圧縮符号化/復号部154,エラー訂正処理部156,チャネルコーディング部157,機構部159,操作部160及び端子161に接続されたコントローラ162とを備えている。

【0166】

記録再生装置106において、操作部160には、詳細は図示しないが、所定の指示を行うための複数のスイッチが備えられている。複数のスイッチには、各シーン又はテイクにおける有効領域の開始点(マークイン点)を指示するスイッチ,有効領域の終了点(マークアウト点)を指示するスイッチ,各シーン又はテイクに対するOK,NG(No Good)を指示するスイッチ,テイク番号を指示するテイクスイッチ等、及びその他のメタデータの入力を行うスイッチが備えられている。

【0167】

記録再生装置106におけるコントローラ162は、図示しないがCPU(Central Processing Unit),ROM(Read Only Memory),RAM(Random Access Memory),入出力部等で構成され、RAMを作業領域として、ROMに格納されたプログラムを実行することによって、タイムコード信号に基づいて記録再生装置106全体の作業を統括して制御している。

【0168】

上述した記録再生装置106では、記録媒体に記録された映像データを再生する際や、再生された映像データを素材蓄積装置108へと記録する際に、操作部161からの操作によって、必要に応じてマークイン点,マークアウト点,及びその他のメタデータ等の付加情報を入力することができるようになっている。これらの付加情報は、不揮発性メモリ105a及び記録媒体に記録される映像データとともに記録されるようになっている。

【0169】

図8に示す素材蓄積装置108は、記録再生装置106から再生された映像データ,音声データ及びメタデータ等の付加情報を一時的に蓄積する記憶装置である。図19を用いて、素材蓄積装置108の構成を説明する。図19において実線は、映像データ,音声データ及びメタデータが伝送されることを示し、破線は、制御信号の流れを示している。

【0170】

素材蓄積装置108は、SDIフォーマットによって伝送される映像データ,音声データ及びメタデータを入力して分離する入力処理部171と、映像データ及び音声データを符号化するエンコーダ(ENC)172と、映像データ,音声データ及びメタデータ等の付加情報を記録する記録部173と、上述のエンコーダに対応する復号を行うデコーダ(DEC)174と、復号した映像データ及び音声データとメタデータとをSDIフォーマットで出力する出力処理部175と、各部を統括して制御するコントローラ176とを備える。

【0171】

入力処理部171は、コントローラ176に制御されて、SDIフォーマットで入力されるデータから、映像データ,音声データ及びメタデータを抽出し、映像データ及び音声データをエンコーダ172へと供給する。また、抽出したメタデータをコントローラへと供給する。

【0172】

エンコーダ172は、コントローラ176に制御されて、入力処理部171から入力した映像データ及び音声データを、フレーム間相関にて圧縮するMPEG方式や、フレーム内圧縮であるDV,JPEG方式で符号化して、符号化して得られた信号を記録部173へと供給する。

【0173】

記録部173は、例えばHDD(Hard Disk Drive)等の記録媒体であって、映像データ,音声データ及びメタデータ等の付加情報を記録する。記録部173は、エンコーダ172において符号化された圧縮ストリームを入力し、記録する。また、コントローラ176から供給されるメタデータ等の付加情報を入力して記録する。このような記録部173は、映像データ及び音声データ等のA/V(Audio/Video)データを記録するためのA/Vデータ記録部と、メタデータ等の付加情報を記録するための付加情報記録部とを有していても良い。

【0174】

デコーダ174は、コントローラ176に制御されて、エンコーダ172において符号化されたデータに対して、エンコーダ172における符号化に対応した復号処理を行って、出力処理部175へと供給する。

【0175】

出力処理部175は、コントローラ176に制御されて、デコーダ174において復号された映像データ及び音声データとコントローラ176からのメタデータとを入力し、これらデータをSDIフォーマットへと変換して出力する。

【0176】

コントローラ176は、図示しないがCPU,ROM,RAM,入出力部,メモリ等で構成され、RAMを作業領域として、ROMに格納されたプログラムを実行することによって、素材蓄積装置108全体の作業を統括して制御している。

【0177】

また、コントローラ176は、入力処理部171から供給されるメタデータを管理し、必要に応じてメタデータの内容を変更したり、新たなメタデータの生成を行う。コントローラ176は、メタデータを出力処理部175へと送る。

【0178】

図8に示す編集装置109は、映像データ及び音声データ(素材データ)を編集するための編集装置であって、メタデータとして付加されている素材に関する情報に基づいて素材の編集を行うことが可能なものである。図20に編集装置109の構成を説明する。

【0179】

編集装置109は、各種編集のための操作入力を行う入力操作部181と、SDIフォーマットで伝送される素材データを入力する入力処理部182と、映像データ、音声データ及びメタデータを記録する記録部183と、音声データを加工する音声ミキサ184と、映像データに特殊効果処理を施す特殊効果処理部185と、映像データ,音声データ及びメタデータをSDIフォーマットで出力する出力処理部186と、各部を統括して制御する制御部187と、編集結果をメタデータとして記憶するメモリ188とを備えている。

【0180】

入力操作部181は、当該編集装置109に接続されたモニタに表示されたGUI(Graphical User Interface)等から素材の編集を行うためのマウスやキーボードを示している。入力操作部181から、各種編集のための操作、及び記事原稿の作成、CG合成画面の編集等が行われる。入力操作は、入力操作部181によって行われるほか、図8に示す統合管理装置111から行うことも可能である。

【0181】

入力処理部182は、制御部187に制御されて、SMPTEにおいて規格化されているSDIフォーマットで伝送された素材蓄積装置108からのデータを入力し、このデータから映像データ,音声データ及びメタデータを抽出して後述の記録部183へと供給する。このとき抽出された各データのうち、映像データ及び音声データは、図示しない圧縮処理部において、フレーム間相関を利用したMPEG方式、或いはフレーム内圧縮であるJPEG方式及びDV方式等で圧縮されるようになっていてもよい。また、入力処理部182は、メタデータに基づいて、図示しない記録サーバから、地図等のCG画面を抽出する。

【0182】

記録部183は、HDD(Hard Disk Drive)や、複数のHDDから構成されるRAID(Reduntant Array of Inexpensive Disks)のような記録媒体であり、入力処理部182からの映像データ,音声データ及びメタデータを記録する。

【0183】

音声ミキサ184は、記録部183から複数チャンネルの入力系統によって供給される複数の音声データを同時に入力することができ、例えば、一方の音声データの音声レベルを徐々に下げ、他方の音声データへとなめらかに移行する等のように音声データの加工を行うものである。音声ミキサ184は、加工された音声データを記録部183へと供給する。

【0184】

特殊効果処理部185は、記録部183から複数チャンネルの入力系統によって供給される複数の映像データを同時に入力することができ、例えば、フェードイン・フェードアウト等の特殊効果を映像データに施すものである。また、特殊効果処理部185は、特殊効果処理を加えた映像データを記録部183へと供給する。

【0185】

出力処理部186は、制御部187に制御されて、編集された映像データ,音声データ及びメタデータを記録部183から入力し、SDIフォーマットへと変換して出力する。

【0186】

制御部187は、上述の各部を統括して制御するほか、入力処理部182から供給されるメタデータを管理し、必要に応じてメタデータの内容を変更したり、新たなメタデータの生成を行う。制御部187は、出力処理部186へとメタデータを送る。

【0187】

メモリ188は、音声ミキサ184及び特殊効果処理部185にて行った編集結果を当該編集結果に基づくメタデータであるEDL_Information(EDL;Editing Decision List)として記憶する。また、入力操作部181において入力された記事原稿に基づくメタデータ、或いは記事内容を示したメタデータであるScriptとして記憶する。作成されたEDL_Information及びScriptは、出力処理部186へと送られる。ここで編集結果とは、記録媒体上のイン点及びアウト点を、Reel Number、或いはタイムコードで表した編集点に関する情報を示している。

【0188】

図8に示すモニタ107は、SDIフォーマットで伝送される映像データ,音声データ及びメタデータを入力し、記録再生装置106で再生される映像及び操作に関する各種の表示を行うものである。

【0189】

図8に示すモニタ110は、SDIフォーマットで伝送される映像データ,音声データ及びメタデータを入力し、編集装置109で行われる編集に必要な情報及び映像等の表示を行う。

【0190】

図8に示す統合管理装置111は、当該画像処理システム1における映像データ、音声データ,メタデータ等の付加情報及びニュース番組制作における全体の情報を統括管理するものであり、図1に示すNCS60に相当するものである。具体的には、統合管理装置111は、オンエア項目の管理及びどの素材がどの段階の処理を受けているか等の素材管理を行うほか、当該統合管理装置111に接続される入出力端末113を介して、他の放送局等との間における素材の売買等の管理を行う。また、当該統合管理装置111と接続された記者用端末112から、記者によって作成された記事を入力する。

【0191】

図8に示す記者用端末112及び入出力端末113は、統合管理装置111とホスト,クライアントの関係にあり、ホストコンピュータである統合管理装置111に接続されて、統合管理装置111に対する種々の入出力作業が可能である。入出力端末113は、外部のネットワークと接続され、外部のネットワークに存在する他の端末との間で、各種データの交換(場合によっては、売り買い)を行うことが可能とされている。このとき各種データの交換・売買等の情報も、統合管理装置111によって管理されている。

【0192】

図8に示す保管用記録装置114は、編集された放送用素材を保管するための記録装置であり、例えばHDDのような記録媒体を備えている。ここでは図示しないが、保管用記録装置114は、放送用素材の長期保管を行う長期記録部と、一定期間の間に再び使用される可能性のある放送用素材を一定期間保管する仮記録部とを備えていてもよい。保管用記録装置114は、編集装置109,統合管理装置111等からの要求に応じて、記録している放送用素材が自由に取り出せるようになっている。

【0193】

図8に示すオーサリング端末115は、例えば、出演者が着ている服装や、装着している時計に関するショッピング情報等、時間軸上で放送用素材とは異なる情報を付加するための端末である。

【0194】

図8に示すメディアキャスタ116は、オーサリング端末115で付加された時間軸の異なる情報に関して、例えば服や時計を販売している店舗のホームページアドレス等の付加情報を付加するための端末である。

【0195】

図8に示すマルチプレクサ117は、上述のメディアキャスタ116からの付加情報に関する信号と、編集装置109からのSDIフォーマットの放送用素材の信号とを混合し、最終的に送出される、即ち視聴者が視る番組構成としての放送用素材を生成する。マルチプレクサ117は、この放送用素材を送出部119へと供給する。

【0196】

図8に示す送出用映像音声記録装置118は、編集装置109から送られるSDIフォーマットで構成された送出用の放送用素材を一時的に記録するものであり、HDDのような記録媒体を備えている。送出用映像音声記録装置118は、送出部119に対して放送用素材を供給する。

【0197】

送出部119は、マルチプレクサ117及び送出用映像音声記録装置118から供給される放送用素材を送出する。送出部119は、SDIフォーマットで供給されるデータのうち、メタデータに関して、特に受信側で必要と思われるメタデータを抽出して映像データ及び音声データとともに送出している。

【0198】

以上示した構成が放送用素材を制作して送信する放送局等に相当するのに対し、セットトップボックス120及びテレビジョン受像機121は、放送局等から供給される放送用素材を受信する側に備えられる構成である。

【0199】

セットトップボックス120は、各種の通信端末をつなぐための接続装置であり、双方向通信機能,インターネット接続機能,CATV接続機能等を備えた受信装置である。セットトップボックス120は、送出部119から送出される放送用素材の電波を受信し、テレビジョン受像機121へと供給する。テレビジョン受像機121は、供給された信号を処理して表示する。

【0200】

続いて、上述の画像処理システム1を用いてニュース番組を制作する際の各装置における動作を説明する。まず、図11に示す計画工程11の段階で、取材に関する内容が決定される。この取材内容に基づいて、図8に示す統合管理装置111において、取材に関するメタデータの入力が行われる。統合管理装置111では、取材に向かう撮像装置101に対して上記メタデータを伝送するために、上記メタデータをデータ管理装置103へと伝送する。データ管理装置103によって、撮像装置101へとメタデータが伝送される。

【0201】

まず図21を用いて、撮像装置101の動作について説明する。撮像装置101を使用して撮影を行う使用者は、所定のタイミングで操作部132を操作してメタデータの転送要求を指令すると、撮像装置101のマイクロコンピュータ140は、ステップS1において、ブルートゥースデバイス137を制御して携帯型電話機102を介してデータ管理装置103に対してメタデータの転送を要求する。

【0202】

ここで転送されるメタデータは、図1に示す計画工程11の段階で決定されたメタデータであり、撮影される取材毎に固有のデータである。具体的には、図9乃至図11に示す取材地名,撮影者,ジャーナリスト,ディレクター,内容に関する記述,取材開始日時,取材終了日時,プロデューサー,ニュース取材項目,NCS IDを表すメタデータがこれに相当する。

【0203】

ただし、上述のメタデータのうち、内容に関する記述,ニュース取材項目以外のメタデータは、仮に入力されるメタデータであって、後に示す工程で変更される場合がある。

【0204】

このメタデータは、取材前の取材計画に基づいて、素材管理装置108から、取材開始前に撮像装置毎に入力され、図8には図示しない素材管理装置108の記録部に予め記憶されているものである。

【0205】

個々の撮像装置は、予め割り当てられ、メモリ136に記憶されているID、又は当該撮像装置101とともに対向される携帯型電話機102の電話番号等により認識される。したがって、複数の撮像装置のメタデータは、撮像装置の機材ID又は携帯型電話機102の電話番号毎に管理されている。

【0206】

図22に示すメタデータは、携帯型電話機の電話番号が、例えば「090−××××−××××」の携帯型電話機102とともに取材に使用されている撮像装置101のものを示している。

【0207】

この場合、取材開始日時として、「2000/3/3 9:00-10:00」,「2000/3/3 13:00-14:00」及び「2000/3/3 17:00-19:00」が示されており、それぞれに対応するNCS IDが、「0001」,「0002」,「0003」のように示されている。各々のNCS IDに対応して、ニュース取材題目として「首相インタビュー」,「街頭インタビュー」及び「記者クラブ取材」が示されている。同様に、撮影者,ジャーナリストが対応して示されている。

【0208】

ここで、ステップS1の工程において、撮像装置101からメタデータの転送が要求されたときのデータ管理装置103における処理について図23を参照して説明する。

【0209】

携帯型電話機102を介して、撮像装置101からのメタデータの要求が受信されると、ステップS21において、データ管理装置103は、受信したメタデータを発信している携帯型電話機103の電話番号又は撮像装置101の機器IDを認識する。

【0210】

ステップS22において、データ管理装置103は、受信した携帯型電話機102の電話番号に対応する撮像装置101のメタデータのうち、受信した時刻に対応したメタデータを携帯型電話機102に送信する。例えば撮像装置101からのメタデータの転送要求が2000年3月3日の9:00に為されたとすると、データ管理装置103は、この時刻に対応するNCS ID「0001」に対応するニュース取材題目「首相インタビュー」,撮影者及びジャーナリストを表すメタデータを、携帯型電話機102を介して撮像装置101に送信する。

【0211】

ここで、図21に戻って説明する。ステップS2において、ブルートゥースデバイス137は、携帯型電話機102を介してデータ管理装置103からのメタデータを受信し、受信したことをマイクロコンピュータ140に通知する。

【0212】

ステップS3において、マイクロコンピュータ140は、ブルートゥースデバイス137からメタデータを受信したことを知らせる通知を受けて、ブルートゥースデバイス137で受信されたメタデータをメモリ136に一時的に記憶する。

【0213】

ステップS4において、マイクロコンピュータ140は、録画が開始されたか否かを判定し、録画が開始されていないとき判定された場合、ステップS5へと進んで、録画スタンバイの状態が解除された場合にマイクロコンピュータ140は、その処理を終了する。一方、録画スタンバイが解除されなかった場合には、ステップS4の工程に戻る。即ち、撮像装置101は、録画スタンバイが解除されるまで、ステップS4,S5の処理を繰り返し、録画開始待ちの状態となる。

【0214】

ステップS4において、録画が開始されたと判定されると、ステップS6へと進み、マイクロコンピュータ140は、記録部134を制御し、記録媒体の記録開始点のタイムスタンプを読み出してメモリ136に記憶させるとともに、ブルートゥースデバイス137を制御して、携帯型電話機102を介して、データ管理装置103に送信する。

【0215】

また、マイクロコンピュータ140は、画像音声入力部131を制御し、画像データをマルチプレクサ135に出力させるとともに、メモリ136を制御し、メモリ136に記憶されているメタデータをマルチプレクサ135に出力させる。

【0216】

ステップS7において、マイクロコンピュータ140は、マルチプレクサ135を制御し、画像及び音声データとメタデータとを多重化させてSDIフォーマットとして記録部134に供給する。

【0217】

ステップS8において、記録部134は、マルチプレクサ135から供給される画像及び音声データとメタデータとが多重化されたSDIフォーマットのデータを記録媒体に記録する。

【0218】

ステップS9において、マイクロコンピュータ140は、録画が終了されたか否かを判定し、録画が終了されていない場合は、録画終了待ちの状態、即ち録画状態を継続する。

【0219】

一方、ステップS9において、録画が終了されたと判定されると、ステップS10において、マイクロコンピュータ140は、記録部134を制御し、記録媒体の記録終了点を示すタイムスタンプを読取り、ブルートゥースデバイス137を制御し、携帯型電話機102を介して、読み取った記録開始点及び記録終了点のテープ位置情報をデータ管理装置103に送信し、処理を終了する。

【0220】

図8に示す記録媒体は、例えばテープ状の磁気記録媒体であり、特にここでは、デジタルビデオテープを示している。記録媒体は、映像及び音声をデジタル化された映像データ及び音声データとして記録することが可能なものであり、映像データ及び音声データのほかにメタデータ等の補助データを記録できる領域を備えたものである。また、補助データを記録媒体筐体105に不揮発性メモリ105aを付設し、この不揮発性メモリ105aに補助データを記憶するようにしてもよい。

【0221】

続いて、データ管理装置103が、撮像装置101からテープ位置情報を受信したときの処理について説明する。データ管理装置103は、図21のステップS10により撮像装置101よりテープ位置情報を受信すると、図24に示すステップS31において、受信したテープ位置情報の送信元となる携帯型電話機102の電話番号を認識する。

【0222】

ステップS32において、データ管理装置103は、図示しないHDDに記録されているメタデータのうち、認識した電話番号に対応するメタデータに、上述のテープ位置情報を付加して記録する。

【0223】

以上の説明では、取材地名,撮影者,ジャーナリスト,ディレクター,内容に関する記述,取材開始日時,取材終了日時,プロデューサー,ニュース取材項目,NCS IDのなかから、撮影者,ジャーナリスト,取材開始日時,ニュース取材項目,NCS IDを例示して説明したが、ディレクター,内容に関する記述,取材終了日時,プロデューサーに関しても同様である。

【0224】

また、撮像装置101によって生成され、自動的に付加して入力されるメタデータがある。具体的には、図9乃至図11に示すメタデータのうち、取材位置(GPS緯度),取材位置(GPS経度),取材位置(GPS高度),取材位置(GPS時刻),取材地名,UMID(ビデオ),UMID(オーディオ),撮影者,ジャーナリスト,グットショットマーカ,カメラセットアップ情報,機材ID,テイクナンバー,素材開始タイムコード,内容に関する記述,オーディオチャンネル割,オーディオタイプ,取材開始日時,取材終了日時,ファイル所有権者,ショットナンバー,収録端末,収録ポート,リールナンバー,権利,ニュース取材題目を表すメタデータである。

【0225】

このように、記録媒体及びデータ管理装置103に、素材データに関する情報を表すメタデータとテープ位置情報とを記録することによって、記録媒体に記録される素材データを、直ちに検索して編集を行うことが可能となる。

【0226】

撮像装置101によって収集され、記録媒体に記録された素材データ及びメタデータは、図8に示す記録再生装置106によって再生され、SDIフォーマットのデータとして素材蓄積装置108へと供給される。素材蓄積装置108において、SDIフォーマットで伝送された映像データ,音声データ及びメタデータはそれぞれ分離され、記録部173へと記録される。

【0227】

このとき、コントローラ176は、必要に応じてメタデータの内容を変更し、新たなメタデータの生成を行う。新たに生成されるメタデータとしては、図9乃至図11に示すUMID(ビデオ),UMID(オーディオ),UMID(データ),UMID(システム),グッドショットマーカ,テイクナンバ,素材開始タイムコード,内容に関する記述,有効期限,オーディオチャンネル割,オーディオタイプ,ソース情報,収録フォーマット,圧縮率,オーディオチャンネル数,オーディオ圧縮率,オーディオサンプリング周波数,オーディオデータサイズ,収録方法,マテリアルID,サブキー,ファイルの長さ,取材開始日時,取材終了日時,収録オペレータ,ファイル所有権者,ショットナンバー,取材期間,GOPサイズ,解像度,エッセンスサイズ,オブジェクトタイプ,インデックス,インデックスの種類,インデックスメモ,シーンナンバー,リールナンバー,権利,NCS ID,ファイルステータスを表すメタデータが挙げられる。

【0228】

このように、素材蓄積装置108において、素材を一時的に蓄える際に、素材を明確に識別するための上述のようなメタデータを、素材蓄積装置108の記録部173及び記録媒体に付加して入力することにより、素材データを直ちに検索して編集を行うことが可能となる。

【0229】

素材蓄積装置108に一時的に記録される映像データ,音声データ及びメタデータは、必要に応じたタイミングで編集装置109へと送られる。

【0230】

一方、統合管理装置111に接続される記者用端末112において、記者により粗編集及び記事作成が行われる。記者用端末112を介して、粗編集が行われ、作成された記事が入力される際に、図9乃至図11に示すエディティングデシジョンリスト,スクリプトを表すメタデータが付加されて入力される。

【0231】

また、このとき、編集装置109では、図7に示したように、上述のメタデータのうち、例えば取材位置(GPS緯度),取材位置(GPS経度),取材位置(GPS高度),取材時刻(GPS時刻),ニュース取材題目,スクリプトを表すメタデータ使用して、CG合成画面を自動的に作成する。

【0232】

記者用端末112では、自動的に作成されたCG合成画面から、ジャーナリストが、粗編集を行って、CG合成画面を自由に編集することが可能である。

【0233】

このとき、自動的に合成されたCG合成画面は、GUI(Graphical User Interface)画面を操作することによって編集することができる。GUI画面における編集の動作を、図25、図26及び図27を用いて説明する。

【0234】

図24は、自動的に作成されたCG合成画面の編集を行うGUI画面200を模式的に示している。図25において、画像201は、CG合成を開始するフレームを示している。画像202は、CG合成を終了するフレームを示している。合成画像203は、自動的に作成されたCG合成画面を示している。手動選択ボタン204は、CGが合成される位置変更を手動で行うための画面に切り換える選択を行うためのボタンである。テンプレート選択ボタン205は、CGの合成位置を変更するためのボタンである。テンプレート206,207,208,209,210及び211は、CGの合成位置の各パターンを示している。図25においては、枠が付されているテンプレート208の位置パターンで表示されている。スクロールバー212は、テンプレート206乃至211を選択するためのスクロールバーである。

【0235】

CG合成画面の編集は、図26及び図27に示す工程に基づいて行われる。図26及び図27に示す工程は、テンプレート選択ボタン205が選択されて、用意されたテンプレートに基づいてCG合成画面を表示する処理について示している。

【0236】

画像データに関する地図を合成して表示する場合の処理を、図26を用いて説明する。

【0237】

ステップS40において、画像データと位置情報を表すメタデータとが入力される。続いて、ステップS41において、メタデータが示す位置情報に基づいて、図示しないが地図等を記録している記録サーバから位置情報に対応する地図が読み出される。ステップS42において、自動的にCG合成画面が作成される。

【0238】

続いて、ステップS43において、テンプレートの変更が指示されると、ステップS44において、指示に従ってテンプレートに基づいたCG合成画面が表示される。

【0239】

一方、画像データに関する時刻情報、或いはタイトルを合成して表示する場合の処理を、図27を用いて示す。時刻情報,タイトル等は、これらを示すメタデータがそのまま使用される。即ち、ステップS50において、画像データと時刻情報及びタイトル情報としてのメタデータとが入力される。続いて、ステップS51において、自動的にCG合成画面が作成される。

【0240】

続いて、ステップS52において、テンプレートの変更が指示されると、ステップS53において、指示に従ってCG合成画面が変更されて表示される。

【0241】

例えば、時刻情報及びタイトルの字体、文字サイズ等の情報を記録サーバから読み出して表示する場合もある。

【0242】

上述のように、GPSによって検出される位置情報を示すメタデータと、記事内容を示すメタデータとを使用することによって、記録サーバから地図情報や画面に表示する文字等を抽出し、これらを用いて自動的にCG合成画面を行うことが可能となる。

【0243】

粗編集に続いて、編集装置109において本編集が行われる。本編集では、粗編集された素材を、実際に放送する状態にするために更に厳密な編集が行われる。編集に伴って、具体的には、図9乃至図11に示すメタデータのうち、ディレクター,プロデューサー,エディティングデシジョンリストを表すメタデータが新たに入力される。上記以外のメタデータは、前段階で使用されたメタデータ、或いは前段階で入力されたメタデータが再度使用されるものである。このときメタデータとして記述された種々の情報が編集に用いられる。

【0244】

記者用端末112において入力されたEDL_Information,Scriptを表すメタデータは、編集装置109における本編集処理で確定される。

【0245】

編集装置109において編集された放送用素材は、マルチプレクサ117において、オーサリング端末115及びメディアキャスター116で付加される他の情報と混成され、図8における送出部119へと送られる。

【0246】

送出部119から放送用素材を送出する処理は、図1における放送工程44に相当するものである。送出部119では、変更日時,ディストリビューションフラグを表すメタデータが新たに入力される。上記メタデータは、前段階で使用されたメタデータ、或いは前段階で入力されたメタデータが、放送工程44において再度使用されるものである。

【0247】

送出部119から送出される際には、図9乃至図11に示されるメタデータのうち、受信側で必要とされるメタデータが抽出されて送信されている。

【0248】

放送用素材は、送出された後、保管用記録装置114に記録され、統合管理装置111によって管理される。保管用記録装置114に放送用素材を記録する際に、新たに入力されるメタデータとしては、保管日時,アーカイブオペレーター,アーカイブ端末,アーカイブフラグ,コンパイルフラグがある。

【0249】

上記以外のメタデータは、前段階で使用されたメタデータ、或いは前段階で入力されたメタデータが、保管段階において再度使用される。

【0250】

以上、詳細に説明した画像処理システム1は、放送局においてニュース番組を制作する際に、撮影前段階10,撮影制作段階20,撮影後処理段階30,放送段階40,保管段階50の各段階において、映像データ及び音声データを識別するためのメタデータを記録媒体、或いは記録装置に記録することにより、これらの素材を編集する際に素材データを直ちに検索して編集を行うことが可能となる。

【0251】

なお、本発明は上述した実施の形態のみに限定されるものではなく、本発明の要旨を逸脱しない範囲において種々の変更が可能であることは勿論である。

【0252】

【発明の効果】

以上詳細に説明したように本発明に係る画像処理システムは、撮像装置に収録された映像データ及び音声データを、該映像データ及び音声データが上記撮像装置に収録される際に該音声データ及び映像データを識別するための第1のメタデータとともに記録する記録手段から、該映像データ、音声データ及び第1のメタデータが入力される入力処理手段と、上記第1のメタデータとは別の第2のメタデータを生成するメタデータ生成手段と、上記入力処理手段に入力された映像データ、音声データ及び第1のメタデータを上記メタデータ生成手段で生成された第2のメタデータとともに記録するデータ蓄積手段と、上記データ蓄積手段に記録された映像データ、音声データ、第1のメタデータ及び第2のメタデータを読み出して出力する出力処理手段とを備える素材蓄積装置と、上記出力処理手段から出力された第1のメタデータ及び第2のメタデータに基づいて、上記出力処理手段から出力された映像データ及び音声データを編集する編集装置と、上記編集装置により編集された映像データ及び音声データを、該編集された映像データ及び音声データを保管する際に新たに入力される第3のメタデータとともに保管する保管用データ記録装置とを備え、上記保管用データ記録装置では、上記編集装置からの要求に応じて、該保管用データ記録装置に保管されている映像データ及び音声データが取り出される。

【0253】

上記別のメタデータとしては、素材データの供給源を示すソース(Source)、データストリームの形式を示すフォーマット(Format)、映像の圧縮を示すビデオ・ビット・レイト(Video Bit Rate)、映像がMPEG形式の場合の圧縮率を示すジー・オー・ピー・サイズ(GOP Size)、解像度を表すレゾリューション(Resolution)、音声データのチャンネル数を表すオーディオ・ナンバ・オブ・チャンネル(Audio Number of Channel)、音声データが圧縮されているか否かを表すオーディオ・コンプレッション(Audio Compression)、オーディオサンプリング周波数を表すオーディオ・サンプリング・レイト(Audio Sampling Rate)、音声データのサイズを表すオーディオ・データ・サイズ(Audio Data Size)、収録方法を示すレック・タイプ(REC_Type)、既存の画像処理システムにおいて使用されている素材を識別するためのIDを示すマテリアル・ID(Material_ID)、素材に対して、数回の編集等を施す間に変形したか否か等を示すサブ・キー(Sub Key)、素材データの種類を示すIDであるユーミッド・データ(UMID(Data))、ユーミッド・オーディオとユーミッド・ビデオとを纏めたユーミッド・システム(UMID(System))、素材の長さを表すファイル・レングス(File Length)、映像及び音声データを含むファイル全体のサイズ表したエッセンシャル・サイズ(Essence_Size)、映像及び音声データを含むファイル全体のサイズ表したエッセンシャル・サイズ(Essence_Size)、映像データが静止画であるか否かを示すオブジェクト・タイプ(Object Type)、素材データの有効期限を示すバリッド・デイト(Valid Date)を表すメタデータが挙げられる。

【0254】

したがって、付加情報としてのメタデータを画像データ及び音声データとともに記録することによって、放送局においてニュース番組を制作する際に、画像データ及び音声データを識別することができる上、素材の編集を行う際に、素材データを直ちに検索することが可能となる。

【0255】

以上詳細に説明したように本発明に係る素材蓄積方法は、撮像装置に収録された映像データ及び音声データを、該映像データ及び音声データが上記撮像装置に収録される際に該音声データ及び映像データを識別するための第1のメタデータとともに記録手段に記録する記録工程と、上記記録手段に記録された映像データ、音声データ及び第1のメタデータが入力処理手段に入力される入力処理工程と、上記第1のメタデータとは別の第2のメタデータを生成するメタデータ生成工程と、上記入力処理手段に入力された映像データ、音声データ及び第1のメタデータを、上記メタデータ生成工程で生成された第2のメタデータとともにデータ蓄積手段に記録するデータ蓄積工程と、上記データ蓄積手段に記録された映像データ、音声データ、第1のメタデータ及び第2のメタデータを読み出して出力する出力処理工程と、上記出力処理工程で出力された第1のメタデータ及び第2のメタデータに基づいて、上記映像データ及び音声データを編集する編集工程と、上記編集工程で編集された映像データ及び音声データを、該編集された映像データ及び音声データを保管する際に新たに入力される第3のメタデータとともに保管する保管用データ記録工程とを有し、上記保管用データ記録工程では、上記編集工程からの要求に応じて、上記データ蓄積工程で記録された映像データ及び音声データが取り出される。

【0256】

したがって、付加情報としてのメタデータを画像データ及び音声データとともに記録することによって、放送局においてニュース番組を制作する際に、画像データ及び音声データを識別することができる上、素材の編集を行う際に、素材データを直ちに検索することが可能となる。

【図面の簡単な説明】

【図1】取材計画を立てて、取材を行い、取材で得た素材を編集して放送し、これを保管するまでの一連の工程を説明する説明図である。

【図2】計画工程で生成されるメタデータの具体例を示す図である。

【図3】計画工程から取材工程に移行する段階で、基地局から撮像装置に対して伝送されるメタデータの具体例を示す図である。

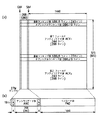

【図4】 (a)は、撮影時に撮像装置において入力されるメタデータの具体例を示す図であり、(b)は、素材蓄積装置に記憶される際に入力されるメタデータの具体例を示す図である。

【図5】 (a)は、撮影時に撮像装置において入力されるメタデータの具体例を示す図であり、(b)は、NCSにおいて仮編集が行われる際に入力されるメタデータの具体例を示す図である。

【図6】 (a)は、撮影時に撮像装置において入力されるメタデータの具体例を示す図であり、(b)は、本編集工程で入力及び変更されるメタデータの具体例を示す図である。

【図7】自動的にCG合成画面が作成される際に使用されるメタデータの具体例を示す図である。

【図8】本発明の実施の形態の一構成例として示す画像処理システムの具体的な構成を示すブロック図である。

【図9】本発明の実施の形態の一構成例として示す画像処理システムにおいて使用されるメタデータを示す図である。

【図10】本発明の実施の形態の一構成例として示す画像処理システムにおいて使用されるメタデータを示す図である。

【図11】本発明の実施の形態の一構成例として示す画像処理システムにおいて使用されるメタデータを示す図である。

【図12】本発明の実施の形態の一構成例として示す画像処理システムのデータ伝送フォーマットとして用いられるSDIフォーマットを説明する模式図である。

【図13】本発明の実施の形態の一構成例として示す画像処理システムのデータ伝送フォーマットとして用いられるSDTIフォーマットを説明する模式図である。

【図14】本発明の実施の形態の一構成例として示す画像処理システムのデータ伝送フォーマットとして用いられるSDTI-CPフォーマットを説明する模式図である。

【図15】本発明の実施の形態の一構成例として示す画像処理システムのデータ伝送フォーマットとして用いられるKLVフォーマットを説明する模式図である。

【図16】本発明の実施の形態の一構成例として示す画像処理システムのデータ伝送フォーマットとして用いられるUMIDのフォーマットを説明する模式図である。

【図17】本発明の実施の形態の一構成例として示す画像処理システムの撮像装置、基地局、データ管理装置の具体的な構成を示すブロック図である。

【図18】本発明の実施の形態の一構成例として示す画像処理システムの記録再生装置の具体的な構成を示すブロック図である。

【図19】本発明の実施の形態の一構成例として示す画像処理システムの素材蓄積装置の具体的な構成を示すブロック図である。

【図20】本発明の実施の形態の一構成例として示す画像処理システムの編集装置の具体的な構成を示すブロック図である。

【図21】本発明の実施の形態の一構成例として示す画像処理システムにおいて、データ管理装置から送信されるメタデータを撮像装置が受信するときの処理を示すフローチャートである。

【図22】本発明の実施の形態の一構成例として示す画像処理システムにおいて、使用されるメタデータを説明する図である。

【図23】本発明の実施の形態の一構成例として示す画像処理システムにおいて、データ管理装置が、メタデータを受信するときの処理を説明するフローチャートである。

【図24】本発明の実施の形態の一構成例として示す画像処理システムにおけるデータ管理装置が、メタデータを更新するときの処理を説明するフローチャートである。

【図25】本発明の実施の形態の一構成例として示す画像処理システムにおいてCG合成画面を作成するためのグラフィカル・ユーザ・インターフェイスを説明する模式図である。

【図26】本発明の実施の形態の一構成例として示す画像処理システムにおいて、編集装置が位置情報に基づいて地図を検索し、画像データに合成するときの処理を示すフローチャートである。

【図27】本発明の実施の形態の一構成例として示す画像処理システムにおいて、編集装置が時間情報及びタイトルを表示するときの処理を示すフローチャートである。

【符号の説明】

0 画像処理システム、10 撮影前段階、11 計画工程、20 撮影制作段階、21 取材工程、22 素材蓄積工程、23 ボイスオーバ工程、30 撮影後処理段階、31 CG作成工程、32 本編集工程、40 放送段階、41 クローズドキャプション工程、42 生中継、43 オートメーション工程、44 放送工程、50 保管段階、51 仮保管工程、52 保管工程、60NCS、101 撮像装置、102 携帯型電話機、103 データ管理装置、104 基地局、105 記録媒体筐体、106 記録再生装置、107 モニタ、108 素材蓄積装置、109 編集装置、110 モニタ、111 統合管理装置、112 記者用端末、113 入出力端末、114 保管用記録装置、115 オーサリング端末、116 メディアキャスタ、117 マルチプレクサ、118 送出用映像音声記録装置、119 送出部、120 セットトップボックス、121 テレビジョン受像装置、131 画像音声入力部、132 操作部、133 HDD、134 記録部、135 マルチプレクサ、136 アンテナ、140 マイクロコンピュータ、141 マイクロコンピュータ、142 通信部、151 入力端子、152 出力端子、153 入力処理部、154 圧縮符号化/復号部、155 出力処理部、156 エラー訂正処理部、157 チャネルコーディング部、158 記録再生部、159 機構部、160 操作部、161 端子、162 コントローラ、171 入力部、172 エンコーダ、173 記録部、174 デコーダ、175 出力部、176コントローラ、181 入力操作部、182 入力処理部、183 記録部、184 音声ミキサ、185 特殊効果処理部、186 出力処理部、187 制御部、188 メモリ[0001]

BACKGROUND OF THE INVENTION

The present invention records video data, audio data, and metadata. Image processing system And a material storage method.

[0002]

[Prior art]

When an image pickup apparatus records image data, a technique for recording additional information corresponding to the editing point on a recording medium along with the image data to be recorded is becoming widespread. The editor can search for necessary editing points by referring to the additional information.

[0003]

Conventionally, this additional information has been input by a photographer operating an input device provided in the imaging device before photographing. The imaging apparatus records input additional information together with image data on a recording medium.

[0004]

One of the methods for editing video information recorded on a recording medium such as a video tape is offline editing. In offline editing, video information recorded on the original tape is temporarily copied to another recording tape, that is, an editing tape at the shooting site, and the editing points are recorded on the editing tape. etc There is a method of creating edit data and creating a master tape based on the edit data. In off-line editing, a desired master tape can be created without fear of accidentally erasing or rewriting information recorded on the original tape.

[0005]

However, in offline editing, editing work is performed using an editing tape that is a copy of the original tape, so there is a problem that it takes time and effort to copy the information recorded on the original tape to the editing tape. .

[0006]

Therefore, as one method for solving the above problems, information on the original tape is temporarily copied to a recordable recording medium such as a hard disk and can be randomly accessed. There is a method of creating edit data using the copy information.

[0007]

[Problems to be solved by the invention]

However, since it is troublesome to input additional information for a photographer who should focus on shooting, input of additional information is performed even though the imaging apparatus has a function of inputting additional information. There were many things that I didn't.

[0008]

On the other hand, various contents data such as video data and audio data can be distributed along with the spread of communication using a network such as the so-called Internet, in which a plurality of networks are connected by packet communication to each other. It is becoming.

[0009]

Accordingly, it is necessary for a broadcasting station or the like that produces and broadcasts a program to manage detailed information regarding these pieces of content data even for fragmented video data and audio data. Specifically, various additional information such as information for identifying broadcast material produced as a program at a broadcasting station or the like, information on copyright, and the like need to be distributed along with the content.

[0010]

Therefore, the present invention has been proposed in view of such a conventional situation, and it is possible to record the image data and the audio data together with the additional information for identifying the image data and the audio data. Do Image processing system And a material storage method.

[0011]

[Means for Solving the Problems]

In order to achieve the above-described object, an image processing system according to the present invention uses video data and audio data recorded in an imaging device when the video data and audio data are recorded in the imaging device. And input processing means for inputting the video data, audio data, and first metadata from the recording means for recording together with the first metadata for identifying the video data, and the first metadata is different from the first metadata. Metadata generating means for generating the second metadata, and video data, audio data and first metadata input to the input processing means together with the second metadata generated by the metadata generating means Data storage means for recording, and video data, audio data, first metadata and second metadata recorded in the data storage means are read and output. Edit the video data and audio data output from the output processing means based on the material storage device including the output processing means and the first metadata and the second metadata output from the output processing means. Editing device and storage data recording device for storing video data and audio data edited by said editing device together with third metadata newly input when storing the edited video data and audio data And with In the storage data recording device, the video data and audio data recorded in the material storage device are retrieved in response to a request from the editing device. The

[0012]

In order to achieve the above-described object, the material storage method according to the present invention includes video data and audio data recorded in an imaging device, and the audio data when the video data and audio data are recorded in the imaging device. And a recording step for recording in the recording means together with the first metadata for identifying the video data, and an input for inputting the video data, audio data and first metadata recorded in the recording means to the input processing means A processing step, a metadata generation step for generating second metadata different from the first metadata, and the video data, audio data, and first metadata input to the input processing means, A data storage step for recording in the data storage means together with the second metadata generated in the metadata generation step; and the video data and audio data recorded in the data storage means. An output processing step of reading out and outputting the first metadata and the second metadata, and the video data and audio based on the first metadata and the second metadata output in the output processing step. An editing process for editing data, and a storage for storing the video data and audio data edited in the editing process together with the third metadata newly input when storing the edited video data and audio data Data recording process In the storage data recording step, the video data and audio data recorded in the data storage step are taken out in response to a request from the editing step. The

[0013]

Here, the other metadata includes a source indicating the source of the material data, a format indicating the data stream format (Format), a video bit rate indicating video compression, and a video. GOP Size indicating the compression ratio when MPEG is in MPEG format, Resolution indicating resolution, and Audio Number of Channels indicating the number of channels of audio data (Audio Number of channels) Channel), audio compression indicating whether the audio data is compressed (Audio Compression), audio sampling rate indicating the audio sampling frequency (Audio Sampling Rate), audio data size indicating the size of the audio data ( Audio Data Size), Rec type indicating the recording method (REC_Type), and existing image processing system Material ID (Material_ID) that indicates the ID used to identify the material being used, Sub Key that indicates whether the material has been deformed during several edits, etc. , Umid data (UMID (Data)) which is an ID indicating the type of material data, Umid system (UMID (System)) that combines Umid audio and Umid video, and file length representing the length of the material (File Length), the essential size (Essence_Size) representing the size of the entire file including video and audio data, the essential size (Essence_Size) representing the size of the entire file including video and audio data, and the video data are still images The object type (Object Type) indicating whether or not, and the metadata representing the valid date (Valid Date) indicating the expiration date of the material data are listed It is.

[0014]

DETAILED DESCRIPTION OF THE INVENTION

The image processing system according to the present invention, for example, in a broadcasting station, a video production company, etc., covers video and audio (hereinafter referred to as materials), and edits and processes these materials to produce video for broadcasting. In addition, the image processing system for storing the video includes additional information for identifying the material in detail in each of the image processing processes such as the material gathering process, the editing process, and the storage process. Input to the recording server.

[0015]

The additional information includes metadata. The metadata is data for describing information necessary for identifying the material obtained by the coverage, such as the coverage time, coverage ID, coverage title, photographer name, reporter name, and the like.

[0016]

A case where a news program is produced at a broadcasting station will be described with reference to FIG. However, FIG. 1 illustrates a work flow when producing a news program, and is different from a so-called block diagram showing components such as a device.

[0017]

As shown in FIG. 1, news program production at a broadcasting station includes a pre-production stage (Pri-Production) 10, a production stage (Production) 20, and a post-production stage (Post-production). 30, broadcast stage (Distribution) 40, and archive stage (Archive) 50.

[0018]

[0019]

The shooting and

[0020]

The

[0021]

The

[0022]

The

[0023]

The

[0024]

The

[0025]

The

[0026]

The

[0027]

An

[0028]

Next, an example of metadata input at each stage described above when a news program is produced based on the above-described work flow will be described. The data structure of metadata will be described later.

[0029]

First, in the

[0030]

In the

[0031]

In the

[0032]

In the process of shifting from the

[0033]

In this process, the Gathering_Start_DateTime, Gathering_End_DateTime, Gathering_Location_Place, Photographer, Journalist Information, Director, Producer, Title, Contents, and NCS ID shown in FIG. The metadata is transmitted from the broadcasting station to the imaging device that moves to the coverage location.

[0034]

In the stage of the

[0035]

As metadata newly input in the

[0036]

The above metadata is input to the recording medium and the dedicated recording server. The above-mentioned metadata generated and changed in the stage of the

[0037]

The material collected in the

[0038]

In the

[0039]

The metadata shown in FIGS. 4A and 4B is recorded together with image data and audio data on a recording medium, and may be separated from the image data and audio data and managed by the

[0040]

The metadata and material data generated and recorded at each stage of the

[0041]

FIG. 5B illustrates metadata used and input when a reporter performs rough editing, article creation, and the like. FIG. 5A shows metadata input mainly in the imaging apparatus, and FIG. 5B shows metadata input mainly in the

[0042]

Gathering_Start_DateTime, Gathering_End_DateTime, Gathering_Location_Place, Photographer, Journalist Information, Director, Producer, Title, Contents, NCS ID, Gathering_Location_Latitude (GPS latitude), Gathering_Location_Longitude (GPS longitude), Gathering_Location_Altitude (GPS longitude), Gathering_Location_Altitude (GPS longitude) , Gathering_Location_Time (GPS Time), Gathering_Location_Place (place name), equipment ID, Camera Setup Imformation, Reel Number, Duration (Time), SOM, Good Shot Mark & REC Start Mark, Audio Channel Information, Audio Type, UMID (Audio), UMID (Video), Copyright, Source, STC, Format, Compression rate (Video Bit Rate), GOP Size, Resolution, Number of Audio Channels, Audio Compression, Audio Sampling Rate, Audio Date Size, REC_Type, Material_ID, Sub Key, UMID (Data ), UMID (System), File Length, Essence_Size, Object Type, and Valid Date metadata are the

[0043]

Examples of metadata newly input at the stage of rough editing and article creation performed by a reporter include EDL (Editing Decision List) Information representing information related to editing contents and Script describing an article manuscript.

[0044]

In the

[0045]

Gathering_Start_DateTime, Gathering_End_DateTime, Time Zone, Gathering_Location_Place, Photographer, Journalist Information, Director, Producer, Title, Contents, NCS ID, Gathering_Location_Latitude (GPS latitude), Gathering_Location_Longitude (GPS longitude), Gathering_Location_Altitude (GPS altitude), Gathering_Location_lace_Location_Location_Location_Location_Location_Location_Location_Location_Location_Location_Location_Location_Location_Location_Location (Name), Equipment ID, Camera Setup Imformation, Reel Number, Reel Number, Duration (Time), SOM, Good Shot Mark & REC Start Mark, Audio Channel Information, Audio Type, UMID (Audio), UMID (Video), Copyright , Source, STC, Format, Compression rate (Video Bit Rate), GOP Size, Resolution, Number of Audio Channels, Audio Compression, Audio Sampling Rate, Audio Date Size, REC_Type, Material_ID, Sub Key, UMID (Data), UMID (System ), File Length (Time), Essence_Size (Byte), Object Type, Valid Date, EDL Information, Script metadata,

[0046]

Some of these metadata can be rewritten by this editing. In the

[0047]

On the other hand, in the

[0048]

The metadata used here includes, for example, location information such as Gathering_Location_Latitude (GPS latitude), Gathering_Location_Longitude (GPS longitude), Gathering_Location_Altitude (GPS altitude), Gathering_Location_Time (GPS Time), etc., which are input by the photographing apparatus in the

[0049]

Based on the Gathering_Location_Latitude (GPS latitude), Gathering_Location_Longitude (GPS longitude), and Gathering_Location_Altitude (GPS altitude) metadata recorded in the material, a map of the area corresponding to these location information is automatically generated from the database that stores the map. Extracted. The time is automatically displayed with reference to Gathering_Location_Time (GPS Time).

[0050]

The CG composition screen automatically created in this way can be freely edited by the editor in a CG composition GUI (Graphical User Interface) for editing.

[0051]

In the

[0052]

Here, the metadata that is synthesized and transmitted together with the video and audio data is metadata that is generated and used in the

[0053]

In particular, Gathering_Start_DateTime, Gathering_End_DateTime, Time Zone, Gathering_Location_Place, Photographer, Journalist Information, Director, Producer, Title, Contents, NCS ID, Gathering_Location_Latitude (GPS latitude), Gathering_Location_Longitude (GPS longitude), Gathering_Location_Altitude (GPS altitude) , Gathering_Location_Place (place name), equipment ID, Camera Setup Imformation, Reel Number, Reel Number, Duration, SOM, Good Shot Mark & REC Start Mark, Audio Channel Information, Audio Type, UMID (Audio), UMID (Video), Copyright Can be mentioned. Source, STC, Format, Compression rate (Video Bit Rate), GOP Size, Resolution, Number of Audio Channels, Audio Compression, Audio Sampling Rate, Audio Date Size, REC_Type, Material_ID, Sub Key, UMID (Data), UMID (System) , File Length, Essence_Size, Object Type, Valid Date, EDL Information, and Script metadata required for viewers receiving broadcast material can be extracted and transmitted.

[0054]

The news program synthesized in the

[0055]

The broadcasted video data, audio data, and metadata are temporarily stored for a certain period in the

[0056]

At this time, the additional information of the material described as metadata can be used as a material-specific identifier for identifying the material. Further, by referring to the additional information input as metadata, for example, an editor / reporter can immediately search for a desired material.

[0057]

An image processing system that performs image processing based on the work flow described above will be specifically described with reference to FIG. The

[0058]

The

[0059]

In addition, the

[0060]

In addition, the

[0061]

In addition, the

[0062]

Further, when the

[0063]

9 to 11 show specific examples of metadata input as additional information. 9 to 11 are divided for convenience, they are a series of diagrams.

[0064]

In FIG. 9 to FIG. 11, the periods indicated as “F”, “T”, “Sh”, “Sc”, “M”, and “P” represent metadata change periods. That is, “F” (Frame) is metadata that is changed in one frame period of video continuously shot every 1/30 seconds, and “T” (Take) is metadata that is changed for each take. It is data. “Sh” (Shot) is metadata that is changed in a shot cycle. “Sc” (Scene) is metadata that is changed in a scene cycle, and “M” (Media) is metadata determined for each recording medium. “P” (Project) is metadata determined for each news program.

[0065]

In addition, FIG. 9 to FIG. 11 show Japanese notation and English notation for explaining metadata. Further, the metadata already defined by SMPTE (Society of Motion Picture and Television Engineers, Inc) shows an actual value such as “07 01 05 02 04 00 00 00” in the SMPTE Dictionary column.

[0066]

The metadata shown in FIGS. 9 to 11 will be specifically described.

[0067]

Gathering_Location_Latitude is metadata that represents latitude detected by GPS (Grobal Positioning System), Gathering_Location_Longitude is metadata that represents longitude detected by GPS, and Gathering_Location_Altitude is metadata that represents altitude detected by GPS Gathering_Location_Time is metadata representing the time detected by GPS. These GPS position information is generated from time to time by a

[0068]

Gathering_Location_Place is metadata representing the place name of the coverage location.

[0069]

UMID (Audio) and UMID (Video) are IDs determined so as to be unique all over the world to identify materials. Details of UMID will be described later.

[0070]

UMID (Data) is metadata for describing information about material data. Unlike UMID (Audio) and UMID (Video), which are described by the imaging device at the time of coverage, whether video data is a still image. ID indicating whether it is a graphic, closed caption signal, audio data is MIDI (Musical Instrument Digital Interface), or the like.

[0071]

UMID (System) represents an ID in which UMID (Audio) and UMID (Video) attached to a certain material are collected.

[0072]

Photographer is metadata that represents the name of the photographer. Jurnalist Information is metadata in which information about a reporter in charge of coverage is written. Director is metadata representing the director of a news program.

[0073]

Good Shot Mark & REC Start Mark is metadata related to mark points that are manually input during shooting.

[0074]

Camera Setup Imformation is metadata including setting information of a CCD (Charge Coupled Device) provided in the imaging apparatus, lens data describing a lens manufacturer, an aperture value, a lens magnification, and the like, and a crane angle, for example. Camera Setup Imformation is particularly necessary at the stage of CG synthesis 15.

[0075]

The equipment ID is metadata representing an imaging device used for coverage, and has a unique identification number for each imaging device.

[0076]

Take Number is metadata that is changed in the take cycle.

[0077]

The material start time code (Start Of Material) is metadata indicating the start time of each scene.

[0078]

Contents is metadata in which other information related to the shooting contents is input.

[0079]

Valid Date is metadata indicating the expiration date of the material.

[0080]

Audio Channel Information is metadata indicating microphone channel information. Audio Channel Information describes microphone information such that, for example, one channel is assigned to a reporter microphone and two channels are assigned to a partner microphone.

[0081]

Audio Type is metadata indicating whether audio recording is monaural, stereo, or bilingual.

[0082]

Source is the material supplied to the recording server recorded on a recording medium etc. and directly brought into the broadcasting station, or transmitted from the interview location by satellite communication, wireless communication, etc. This is metadata representing a video data supply source such as whether it is distributed from another broadcasting station.

[0083]

Format is metadata indicating the format of the data stream, such as whether it is a DV format, an MPEG_MP @ ML format, or an MPEG_4: 2: 2P @ ML format.

[0084]

Video Bit Rate is metadata indicating a video compression rate.

[0085]

Audio Number of Channel is metadata representing the number of channels of audio data. Audio Compression is metadata indicating whether audio data is compressed.

[0086]

Audio Compression is metadata representing the compression rate of audio data.

[0087]

Audio Sampling Rate is metadata representing an audio sampling frequency.

[0088]

Audio Date Size is metadata that displays the size of audio data by time or the number of bytes.

[0089]

REC_Type is metadata indicating a recording method such as Auto, Manual, GPI, Endress, and Open End.

[0090]

Material_ID is an ID for identifying a material used in an existing image processing system. That is, Material ID corresponds to UMID and may not be described.

[0091]

Sub Key is metadata indicating Version, Segment, Revision, etc., and indicates whether or not the material has been deformed during several edits.

[0092]

File Length (Time) is metadata for representing the length of a material in time.

[0093]

Gathering_Start_DateTime is metadata representing the time at which shooting starts, and is expressed in UTC. Gathering_End_DateTime is similarly expressed in UTC, and is metadata representing the photographing end time. These time data include Time Zone information representing a time difference from UTC.

[0094]

REC_Start_DateTime is metadata representing the editing start time in UTC when producing the broadcast material in the

[0095]

Recording_Operator is metadata that represents information on an operator who has performed editing in the

[0096]

File_Owner is metadata representing ownership information of material data such as a photographer.

[0097]

Shot Number is metadata that is changed in the shot cycle.

[0098]

Duration (Time) is metadata indicating the time required for shooting.

[0099]

GOP Size is metadata indicating the compression rate when video is compressed in MPEG format.

[0100]

Resolution is 720 * 512, 720 * 480,544 * 480, 480 * 480, 352 * Metadata representing a resolution such as 480.

[0101]

Essence_Size (Byte) is metadata that represents the size of the entire file including video and audio data by the number of bytes, and may be displayed by time.

[0102]

Object Type (Still, Audio, Video, Key Source) indicates an instruction for Still, which indicates whether the video data is a still image, Audio, Video, or telop, which indicates whether the data is audio data or video data. Metadata including data such as Key Source.

[0103]

Index, Index_Type, and Index_Memo are metadata for performing a search.

[0104]

Scene Number is metadata that is changed in a scene cycle.

[0105]

Recording Terminal and REC Port are metadata representing information related to the terminal that performed recording.

[0106]

The Reel Number is metadata for identifying a recording medium on which video data is recorded, and is generated as a different Number every time the same tape is taken in or out of the imaging apparatus.

[0107]

Copyright is metadata indicating the copyright of video data that has been photographed and recorded, and an individual name, a broadcasting station name, or the like is input.

[0108]

Modified_DateTime is metadata that indicates the date when the broadcast material edited by the

[0109]

Producer is metadata representing the producer of a news program.

[0110]

Archive_Operator is metadata representing the information of the operator who stored the broadcast material.

[0111]

Title is metadata representing the title of a program that uses the subject of photography or the content to be collected (content of the material).

[0112]

Archive Terminal is metadata representing information related to a terminal that stores broadcast materials.

[0113]

The NCS ID is an ID (identifier) set for each news program item / program registered in the NCS (Newsroom Computer System). However, the NCS ID does not indicate an ID for accessing the

[0114]

EDL Information is metadata relating to edited contents. Specifically, the in-point and out-point of the video data to be used are indicated by time or Reel Number, and are described as an edit point list. Script is metadata that mainly indicates the content of a read original.

[0115]

OnAir_Flag is metadata indicating whether or not the edited broadcast material is on air, and OnAir_Counter is metadata indicating how many times the on-air air has been on air.

[0116]

Archive_Flag is metadata indicating whether or not the material collected by the coverage has been stored.

[0117]

Compile_Flag is metadata indicating that the material once stored is re-arranged and re-recorded when the process of whether or not to delete is performed.

[0118]

Distribution_Flag is metadata indicating whether or not the broadcast material is transmitted from a broadcast station other than the own station. The information is also described when the material is bought and sold.

[0119]

File_Status_Bit is metadata representing the status of the material in the

[0120]

By inputting the metadata as described above in the processing steps in each device, the material can be clearly identified by the state of the material and the additional information related to the material.

[0121]

In the

[0122]

The SDI format includes a 4-dot EAV (End of Video) area indicating end synchronization, a 268-dot ancillary (ANS) area, a 4-dot SAV (Start of Video) area indicating start synchronization, and 1440 dots. Active video area and is composed of 525 lines. However, the numbers in parentheses indicate values defined by the PAL (Phase Alternation Line) method.

[0123]

The active video area is a 9-line vertical blanking section (VBK 1 ) And 10-line optional blanking section (OBK) 1 ) And 244 lines of active video (ACV) 1 ) And 9-line vertical blanking section (VBK) 2 ) And 10-line optional blanking section (OBK) 2 ) And 243 lines of active video area (ACV) 2 ).

[0124]

SDI is a format for transmitting uncompressed digital data such as the so-called D1 and D2 formats. Audio data is stored in the ancillary area, and video data such as D1 and D2 is stored in the active video area. Is transmitting. In the SDI format, the metadata is inserted into the ancillary area and transmitted.

[0125]

FIG. 12B shows one line of the SDI format. When transmitted, data of 10 bits width per line is transmitted after being subjected to parallel-serial conversion and transmission path coding.

[0126]

Further, as a transmission format for transmitting video data, audio data, and metadata in the

[0127]

FIG. 13A shows the data structure of the SDTI format. Similar to the SDI format, the SDTI format is a 4-dot EAV (End of Video) area indicating end synchronization, an 268-dot Ancillary (ANC) area, and a 4-dot SAV (Start of Video) indicating start synchronization. ) Area, but an active video area composed of 525 lines in the SDI format is defined as a payload area. However, the numbers in parentheses indicate values defined by the PAL (Phase Alternation Line) method.

[0128]

In SDTI format, the payload area is the blank data part (BDT 1 , BDT 2 ) And data section (DT 1 , DT 2 ), But the number of lines in each data part is not defined.

[0129]

FIG. 13B shows one line of the SDTI format. When transmitted in the SDTI format, data of 10 bits width per line is transmitted after being subjected to parallel-serial conversion and transmission path coding.

[0130]

In the SDTI format, the ancillary area includes 53 words of SDTI header data into which a source address, a destination address, a line number CRC, and the like are inserted. In the SDTI format, metadata is inserted into the area of the ancillary area excluding the SDTI header data.

[0131]