JP3987172B2 - Interactive communication terminal device - Google Patents

Interactive communication terminal device Download PDFInfo

- Publication number

- JP3987172B2 JP3987172B2 JP28735297A JP28735297A JP3987172B2 JP 3987172 B2 JP3987172 B2 JP 3987172B2 JP 28735297 A JP28735297 A JP 28735297A JP 28735297 A JP28735297 A JP 28735297A JP 3987172 B2 JP3987172 B2 JP 3987172B2

- Authority

- JP

- Japan

- Prior art keywords

- information

- document structure

- document

- stored

- specified

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Expired - Fee Related

Links

Images

Landscapes

- Processing Or Creating Images (AREA)

- Information Transfer Between Computers (AREA)

- Computer And Data Communications (AREA)

- User Interface Of Digital Computer (AREA)

Description

【0001】

【発明の属する技術分野】

本発明は、対話型コミュニケーション端末装置に係り、詳しくは、ネットワークを介して接続された他の端末装置と画像によるインタフェースを用いてコミュニケーションを行なう対話型コミュニケーション端末装置に関する。

【0002】

【従来の技術】

従来、パーソナルコンピュータ等の端末装置どうしを通信回線を介して接続し、お互いに相手側にメッセージを送ることによって対話を行なう通信システムが構築されている。このようなシステムでは、例えば、各利用者は、各端末装置に展開された仮想共有空間内においてアバタと呼ばれる自分の化身となるCG(コンピュータグラフィックス)オブジェクトの言動、動作等を制御することによって他の利用者との対話を行なう。この仮想共有空間は、そのシステムによって、奥行きをもたない二次元世界から構成されるものや、奥行きをもつ三次元世界から構成されるものがある。

【0003】

このようなシステムでは、利用者の意図する行動がアバタのアニメーションとして表現される。利用者は、他の利用者のアバタの仮想共有空間内での行動を見ることによって当該他の利用者の意思を理解する。

【0004】

【発明が解決しようとする課題】

上記のような画像(CG)によるインタフェースを利用した対話型コミュニケーション端末装置では、更に、コミュニケーションにおける表現形式の多様化が望まれている。

そこで、本発明の課題は、多様な表現形式にてコミュニケーションのできる対話型コミュニケーション端末装置を提供することである。

【0005】

【課題を解決するための手段】

上記課題を解決するため、本発明は、請求項1に記載されるように、他のシステムとの間で情報を交わし、その情報に基づいて当該他のシステムとの間でコミュニケーションを行うようにした対話型コミュニケーションシステムに使用される対話型コミュニケーション端末装置において、他のシステムに送出する情報を生成するための入力操作を受け付ける情報入力手段と、前記情報入力手段にて受け付けた操作内容に応じて、コミュニケーションシステムで操作可能な操作対象と文書構造を特定する文書構造識別情報とが対応付けて記憶された動作表現定義テーブルを参照して文書構造識別情報を特定し、特定された文書構造識別情報に基づいて、文書構造識別情報と文書構造が対応づけて記憶されたプロトコル構造テーブルを参照して文書構造を特定し、前記情報入力手段にて受け付けた操作内容から、特定された文書構造に基づいて情報を生成する情報生成手段と、生成された情報を他のシステムに送出する情報送出手段と、他のシステムからの情報を受信する受信手段と、受信手段にて受信した情報に含まれる文書構造識別情報に基づいて、文書構造識別情報と文書構造が対応づけて記憶された文書構造テーブルを参照して文書構造を特定し、さらに、前記文書構造の要素を識別する要素番号と当該要素の構造内容とが対応づけて記憶されたルールベースを参照して要素毎の構造を特定し、特定された文書構造と要素毎の構造内容に基づいて、受信した情報を変換する情報変換手段と、前記変換した情報を出力する情報出力手段とを有するように構成される。

【0006】

このような対話型コミュニケーション端末装置では、他のシステムから所定の表現形式の情報を受信したときに、その情報がの表現形式に変換される。そして、受信した情報及び表現形式の変換された情報のいずれかが選択され、その選択された情報がその表現形式に基づいて出力される。

他のシステムから供給される情報の表現形式及び変換後の表現形式は、システムに応じて任意に定められる。例えば、文字、画像、音声等いずれでもよい。

【0008】

【発明の実施の形態】

以下、本発明の実施の一形態について図面に基づいて説明する。

図1は、本発明の実施の一形態に係る対話型コミュニケーション装置が実現されたコンピュータシステムの基本的なハードウエア構成を示す。

図1において、このシステムは、システム全体を制御するCPU(中央演算処理ユニット)10、メモリユニット11、通信ユニット12、入力ユニット13、表示ユニット14、音声合成ユニット15、ディスクユニット16、CD−ROMドライブユニット17を備えている。各ユニットはバスによって相互に接続されている。

【0009】

メモリユニット11は、ROM(リードオンリメモリ)及びRAM(ランダムアクセスメモリ)を備えており、CPU10にて実行されるプログラム、CPU10での処理に必要なデータ、表示すべき仮想空間、CGオブジェクト等の画像データ等を格納する。通信ユニット12は、所定の通信回線を介して他のシステムとのデータ通信を行なう。CPU10での処理にて生成された対話に係る情報が通信ユニット12を介して他のシステムに送信される一方、他のシステムから送信された対話に関する情報が通信ユニット12にて受信される。

【0010】

入力ユニット13は、キーボード及びマウスを備えており、ユーザが他のシステムのユーザと対話を行なうための情報を入力するために用いられる。表示ユニット14は、メモリユニット11(画像メモリ)に格納された画像データに基づいて仮想空間やCGオブジェクト等の画像や、文字で構成されるメッセージ等を表示する。音声合成ユニット15は、CPU10での処理により生成されたメッセージの音声信号を所定のアルゴリズムに従って生成する。音声合成ユニット15にて生成された音声信号は、スピーカ18に提供され、当該メッセージの音声がスピーカ18から出力される。

【0011】

ディスクユニット16は、CPU10で実行可能なプログラム、種々のファイル、テーブル等が格納されている。また、更に、仮想空間についての情報がファイルとしてディスクユニット16に格納されている。

対話型コミュニケーションに係るプログラムは、CD−ROM100にて当該システムに提供される。即ち、対話型コミュニケーションに係るプログラムが記録されたCD−ROM100がCD−ROMドライブユニット17にセットされると、当該プログラムがCD−ROMドライブユニット17にてCD−ROMから読み出されてディスクユニット16にインストールされる。このインストールされた当該プログラムがディスクユニット16から更に読み出されてメモリユニット11に格納されると、CPU10は、そのメモリユニット11内の当該プログラムに従って、対話型コミュニケーションに係る処理を実行する。

【0012】

通信回線にて接続された各コンピュータシステム(対話型コミュニケーション装置)において、仮想空間に関するファイルが開かれて、表示ユニット14の画面上には、共通の仮想空間を示す画像が表示される。そして、画面上の仮想空間内には、各コンピュータシステムのユーザ(対話を行なう者)に対応したCGオブジェクト(アバタ)が表示される。また、仮想空間内には種々の操作可能な種々のオブジェクトが表示される。

【0013】

このような状態で、ユーザが入力ユニット13(マウス、キーボード)を用いて画面上のあるオブジェクトを操作すると、そのオブジェクトの動きを特定するCG表現データが、従来と同様のアルゴリズムに従って生成されると共に、その動きを他の表現方法にて表したデータが生成される。この他の表現方法にて表したデータは、例えば、オブジェクトの動きを表した文字によるメッセージであって、CPU10は、例えば、図2に示す手順に従って当該メッセージの生成処理及び上記CG表現データと共に通信回線を介した他のシステムへの当該メッセージの送信処理を実行する。

【0014】

図2において、マウス(入力ユニット13)を操作して、マウスカーソルを該当するオブジェクトに位置づけてクリックすることで処理が開始される(S1)。例えば、画面上の各オブジェクトとその位置(座標)とが関連付けられて管理されており、マウスがクリックされたときのマウスカーソルの座標からオブジェクトIDが取得される(S2)。なお、画面上に存在するオブジェクトには、IDがシステム内でユニークに割り当てられている。

【0015】

このように対象となるオブジェクトのIDが取得されると、図5に示すようなIDとオブジェクト名の対応テーブルを参照して、取得したIDに対応するオブジェクト名が得られる。そして、例えば、図6に示すようなオブジェクト毎に定義された動作を表す動作定義テーブルを参照して、当該特定されたオブジェクトに対して登録された動作を表すID(動作ID)が取得される(S3)。この対象となるオブジェクト名と、取得された動作IDで特定される動作が、例えば、図3に示すように表示画面上に、動作メニューとして表示される(S3)。

【0016】

なお、図3に示す例の場合、「ボール」というオブジェクトに対して定義された動作が「回す」、「持つ」、「押す」であることを意味している。

また、システム内では、言語のデフォルト値として「日本語」が設定されており、他の言語(英語等)を用いる場合は、入力ユニット13を用いて指定言語を入力する。この入力された言語が「日本語」に代えてシステム内に設定される。

【0017】

上記のように表示画面上に動作メニューが表示された状態で、ユーザがマウス(入力ユニット13)を用いて、動作メニュー内の何れかの動作を選択すると、その選択された動作が取得システム内(CPU10)に取得される(S4)。そして、動作に対する言語表現を定義した、図7に示すような、動作表現定義テーブルを参照して、選択された動作の言語表現に対応する構造番号(1、2、...)が取得される(S5)。そして、この取得された構造番号がバッファ(メモリユニット11内)に出力される(S6)。この構造番号は、動作の言語表現を用いた文章(メッセージ)の構造を特定するものである。

【0018】

構造番号と文章の構造(プロトコル構造)との関係が、例えば、図4に示すようなプロトコル構造テーブルに記述されている。この場合、文書番号「1」によって、動作主体(私)、動作(投げる)、動作の対象(ボール)のように配列された構造要素をからなる文書構造が特定される。また、文書番号「2」によって、動作主体(私)、動作(笑う)のように配列された構造要素からなる文書構造が特定される。

【0019】

上記のようにして構造番号が取得されると、プロトコル構造テーブルを参照して、当該構造番号に対応するプロトコル構造が特定される(S7)。そして、特定されたプロトコル構造の各構造要素の値が先頭から順次読み込まれる(S8、S9、S10、S11)。構造番号が「1」の場合、先頭の構造要素の値である「動作主体のユーザID」、次の構造要素の値である「動作を表すID」、更に三番目の構造要素の値である「動作対象オブジェクトID」がそれぞれバッファに出力される。上記「動作主体のユーザID」については、例えば、ログイン処理にて登録されたユーザIDから得られ、「動作を表すID」については、選択された動作に対応するIDが動作定義テーブル(図7参照)から得られ、更に、「動作対象オブジェクトID」については、マウスのクリック操作時(S2)に取得されたオブジェクトに対応するIDがオブジェクト名とIDの対応テーブル(図5参照)から得られる。

【0020】

そして、構造要素の値が終了であることが判別されると(S9、YES)、上記処理の結果、例えば、図8に示すように、「文書構造(構造番号)」、「動作主体のユーザID」、「動作を表すID」、「動作対象オブジェクトID」で構成されるメッセージデータが動作表現データとして新たにバッファ内に格納される(S12)。このように、ユーザが指定したオブジェクトの動作を表現する動作表現データがバッファ内に生成されると、この動作表現データがバッファ内から読み出されて、通信ユニット12から回線を介して同様の仮想空間を共有する他の全てのシステムに対して当該動作表現データが送信される(S13)。

【0021】

上記のようにあるコンピュータシステム(対話型コミュニケーション装置)から通信回線を介して送られてきた動作表現データを受信すると、例えば、図9に示す手順に従って処理が行なわれる。

図9において、動作を言語的に表したメッセージとを含む動作表現データを受信すると(S100)、このデータがバッファ内に蓄積される。その後、ユーザが希望する表現がCG表現(画像)であるか、文字列で構成されたメッセージであるか、更に、その双方であるかが、入力ユニット13からのユーザによる指定入力に基づいて判定される(S101、S102)。ユーザの希望が文字列で構成されたメッセージであれば、文字列出力処理P1が実行される。また、ユーザの希望がCG表現であれば、CG出力処理P2が実行され、更に、ユーザが双方を希望する場合には、文字列出力処理とCG出力処理の双方処理P3が実行される。

【0022】

CG出力処理P2及び双方処理P3におけるCG出力処理部分では、例えば、図18に示すような、表現形式変換テーブルを用いて、受信した文字列の表現形式のメッセージデータ(動作表現データ)をCG(画像)による表現形式の動作表データ(CG表現データ)に変換する。この表現形式変換テーブルは、文字列の表現形式のメッセージデータを特定するための「構造番号」、「動作主体のユーザID」、「動作を表すID」、「動作対象オブジェクトID」をインデックスとし、そのメッセージデータの内容を表現するCGによる表現データとの関係を表している。

【0023】

そして、上記のように得られたCG表現データを用いて従来の手法に従った画像処理を行う。その結果、送信元で指定されたオブジェクトの動作が受信側の当該システム内の表示画面上に再現される。

一方、文字列出力処理P1は、例えば、図10に示す手順に従って実行される。

【0024】

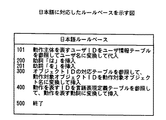

図10において、バッファ内に蓄積された動作表現データ(メッセージデータ)がシステム内(CPU10)に取得される(S22)。更に、上記メッセージデータには送信側のコンピュータシステムにて設定された言語に関する情報が含まれており、受信側のシステムは、メッセージデータから設定言語に関する情報を取得する(S23)。このように設定言語に関する情報が取得されると、その言語に対応したルールベース及び文書構造テーブルが選択される(S24)。例えば、日本語の場合には、図11に示すような文書構造テーブルと、図12に示すルールベースが選択される。この文書構造テーブルには、構造番号で特定される文書構造の内容(主体の挿入、助詞の挿入、動詞の挿入等)を特定する番号が記述され、ルールベースには、その番号で特定される構造内容が規定されている。

【0025】

上記のようにして設定された言語に対応する文書構造テーブル及びルールベースが選択されると、メッセージデータ(図8参照)の第一パラメータ(構造番号)が抽出され、この第一パラメータをキーにしてプロトコル構造テーブル(図4参照)が検索される(S25)。その結果、プロトコル構造が決定される。その後、決定されプロトコル構造の各構造要素の値が先頭から順次バッファに出力される(S26、S27、S28、S29)。構造番号が「1」の場合、送信側のシステムと同様に、先頭の構造要素の値である「動作主体のユーザID」、次の構造要素の値である「動作を表すID」、更に三番目の構造要素の値である「動作対象オブジェクトID」がそれぞれバッファに出力される。

【0026】

そして、終了を表す構造要素が検出されると(S27、YES)、更に、上記のようにメッセージデータから抽出した第一パラメータ(構造番号)をキーにして上記文書構造テーブル(図11参照)が検索される(S30)。そして、構造番号に対応した文書構造の要素(番号)が順次読み出され、その各要素番号をキーにしてルールベース(図12参照)が検索されて、そのルールベースに従った文字列が選択される(S31、S32、S33、S34、S35)。選択された文字列は順次バッファ内に蓄積される。このような処理は、読み出される文書構造の要素が終了コードであることを検出する(S32、YES)まで繰り返される。

【0027】

図11に示される文書構造テーブルの例では、指定された構造番号「1」に対して、要素番号「100」、「200」、「300」、「201」、「400」及び「500」が読み出される。そして、図12に示されるルールベースの例では、要素番号「100」は、動作主体を表すユーザIDをユーザ情報テーブル(図15参照)を参照してユーザ名に変更して代入することを表し、要素番号「200」は、助詞「は」を挿入することを表し、要素番号「201」は、助詞「を」を挿入することを表す。また、要素番号「300」は、オブジェクトIDの対応テーブル(図5参照)を参照して、動作対象オブジェクトIDを動作対象オブジェクト名に変換して挿入することを表し、要素番号「400」は、動作を表すIDを言語表現定義テーブル(図7参照)を参照して動作を表す動詞に変換挿入することを表す。更に、要素番号「500」は、メッセージの終了を表す。

【0028】

ここで、文書構造テーブル(図11参照)から読み出された要素番号から上記ルールベースに従って文字列(メッセージ)を生成する処理(S33、S34)は、例えば、図13に示す手順に従って実行される。

即ち、ルールベースに基づいて、文書構造テーブルから読み出された文書要素番号が、動詞変化を指示する番号か(S301)、ユーザ情報から動詞の型を決定したうえで動詞を変化させることを指示する番号か(S302)、ユーザ名をそのまま挿入することを指示する番号か(S303)、オブジェクト名をそのまま挿入することを指示する番号か(S304)、決まった文字をそのまま出力することを指示する番号か(S305)がそれぞれ判定される。例えば、図11に示す文書構造テーブルに示される構造番号「1」で特定される文書の場合、まず、読み出された要素番号「100」がユーザ名を挿入することを表すと判定されると(S303、YES)、例えば、図15に示すユーザ情報テーブルを参照してメッセージデータから抽出された「動作主体ユーザID」が対応するユーザ名に変換される(S309)。そのユーザ名(例えば、「私」)がバッファに格納される。次に、読み出された要素番号「200」が助詞「は」を挿入することを表すと判定されると(S305、YES)、文字「は」がバッファに格納され、読み出された要素番号「300」がオブジェクト名を挿入することを表すと判定されると(S304、YES)、対応テーブル(図5参照)を参照して、メッセージから抽出された「動作対象オブジェクトID」が対応するオブジェクト名に変換される(S310)。そのオブジェクト名(例えば、「ボール」)がバッファに格納される。

【0029】

更に、読み出された要素番号「201」が助詞「を」を挿入することを表すと判定されると(S305、YES)、その文字「を」がバッファに格納される。また、読み出された要素番号「400」が動詞を挿入することを表すと判定されると(S301、YES)、言語表現定義テーブル(図7)を参照してメッセージから抽出された動作内容のIDがその動作を表す文字列に変換される。そして、その動作を表す文字列がバッファに格納される。なお、図示されていないが、動詞の挿入を表す要素番号にはサブ要素番号がリンクされており、そのサブ要素番号は、各動詞の変化(現在形、過去形、未来形等)を特定する。このサブ要素番号と各動詞の変化との関係が、例えば、図14に示すような動詞変換テーブルにまとめられている。上記のように、動詞を挿入する際、この動詞変換テーブルを参照して、サブ要素番号に対応する活用形の動詞が選択される。

【0030】

文書構造テーブル(図11参照)に記載された全ての要素番号について上述したような処理が終了すると、その時点でバッファ内に格納された文字情報が順次読み出され(「私」「は」「ボール」「を」「投げる」)、例えば、表示ユニット14に提供される。その結果、表示ユニット13の画面上に表示された仮想空間内に新たなウインドウが開かれ、そのウインドウ内に提供された文字情報に基づいて送信元で操作されたオブジェクトの動作を表すメッセージ(私はボールを投げる)が表示される。

【0031】

なお、図13に示す処理では、動詞が動作主体に応じて変化する文法の言語(英語、独語等)を想定している。即ち、読み出された要素番号がユーザ情報に応じて動詞を変化させることを表すと判定されると(S302、YES)、ルールベースに従ってユーザ情報(図15参照)から変形する動詞の型が決定される(S306)。そして、その決定された動詞の型が要素番号に変換され(S307)、その要素番号と動詞IDから表示すべき動詞を表す文字列が決定される(S308)。

【0032】

また、設定される言語が英語の場合、例えば、文章構造テーブルは図16に示すように構成されると共に、図17に示すようなルールベースが使用される。

更に、上記のようにして出力すべき情報としてバッファ内に蓄積された文字情報(「私」「は」「ボール」「を」「投げる」)は音声合成ユニット15に提供することができる。この場合、音声合成ユニット15は、提供された文字情報に基づいて対応する音声信号を生成する。そして、その音声信号に基づいてスピーカ18が駆動され、文字情報に対応した音声がスピーカ18から出力される。

【0033】

このように音声出力を行なう場合、更に、動作の主体を表すユーザIDの性別をユーザ情報テーブル(図15参照)から取得し、その性別(男性、女性)に応じて出力周波数特性を切り換えることも可能である。

上記のようなシステムによれば、通信回線で相互に接続されたコンピュータシステム間において、CG画像、文字情報、音声を用いたコミュニケーションがユーザの希望に応じて自由に行なうことができるようになる。また、設定された言語に対応した文書構造テーブル及びルールベースが選択され、その選択された構造テーブル及びルールベースを用いて直接設定された言語での文書(文章)を生成している。従って、例えば、英語の文書を出力する場合等、日本語の文書構造を英語の文書構造に変更する等の処理が必要となる一般的な翻訳の処理に比べて、その処理が容易になる。

【0034】

【発明の効果】

以上、説明してきたように、各請求項に記載された本発明によれば、受信した情報が所定の表現形式であっても、当該表現形式以外の表現形式でのコミュニケーション情報でも出力できるようになるので、多様な表現形式にてコミュニケーションのできる対話型コミュニケーション端末装置が実現される。

【図面の簡単な説明】

【図1】本発明の実施の一形態に係る対話型コミュニケーション装置が実現されるコンピュータシステムの基本的なハードウエア構成を示すブロック図である。

【図2】対話型コミュニケーション装置での送信時の処理の手順を示すフローチャートである。

【図3】CGオブジェクトの動作を指定するための画面表示の例を示す図である。

【図4】プロトコル構造テーブルを示す図である。

【図5】オブジェクトIDとオブジェクト名との対応関係のテーブルを示す図である。

【図6】オブジェクトの動作定義テーブルを示す図である。

【図7】動作を表す言語表現定義テーブルを示す図である。

【図8】生成されるメッセージの内容を示す図である。

【図9】対話型コミュニケーション装置での受信時の処理の手順を示すフローチャートである。

【図10】文字列出力処理の詳細な手順を示すフローチャートである。

【図11】日本語に対応した文書構造テーブルを示す図である。

【図12】日本語に対応したルールベースを示す図である。

【図13】ルールベースに基づいて文字列を生成するための処理の詳細を示すフローチャートである。

【図14】動詞変換テーブルを示す図である。

【図15】ユーザ情報テーブルを示す図である。

【図16】英語に対応した文書構造テーブルである。

【図17】英語に対応したルールベースである。

【図18】表現形式変換テーブルを示す図である。

【符号の説明】

10 CPU(中央演算処理ユニット)

11 メモリユニット

12 通信ユニット

13 入力ユニット

14 表示ユニット

15 音声合成ユニット

16 ディスクユニット

17 CD−ROMユニット

18 スピーカ

100 CD−ROM[0001]

BACKGROUND OF THE INVENTION

The present invention relates to an interactive communication terminal device, and more particularly, to an interactive communication terminal device that performs communication with another terminal device connected via a network using an image interface.

[0002]

[Prior art]

2. Description of the Related Art Conventionally, a communication system has been constructed in which terminal devices such as personal computers are connected to each other via a communication line and a dialogue is performed by sending messages to each other. In such a system, for example, each user controls the behavior, operation, and the like of a CG (computer graphics) object that is an avatar called an avatar in a virtual shared space developed in each terminal device. Talk with other users. Depending on the system, this virtual shared space may be composed of a two-dimensional world without depth, or may be composed of a three-dimensional world with depth.

[0003]

In such a system, the behavior intended by the user is expressed as an avatar animation. The user understands the intention of the other user by observing the behavior of the other user's avatar in the virtual shared space.

[0004]

[Problems to be solved by the invention]

In the interactive communication terminal device using the image (CG) interface as described above, further diversification of expression formats in communication is desired.

Therefore, an object of the present invention is to provide an interactive communication terminal device that can communicate in various expression formats.

[0005]

[Means for Solving the Problems]

In order to solve the above-described problems, the present invention is configured to exchange information with another system and perform communication with the other system based on the information as described in

[0006]

In such an interactive communication terminal device, when information in a predetermined expression format is received from another system, the information is converted into the expression format. Then, either the received information or the converted information of the expression format is selected, and the selected information is output based on the expression format.

The representation format of information supplied from other systems and the representation format after conversion are arbitrarily determined according to the system. For example, any of characters, images, sounds and the like may be used.

[0008]

DETAILED DESCRIPTION OF THE INVENTION

Hereinafter, an embodiment of the present invention will be described with reference to the drawings.

FIG. 1 shows a basic hardware configuration of a computer system in which an interactive communication apparatus according to an embodiment of the present invention is realized.

1, this system includes a CPU (central processing unit) 10 that controls the entire system, a memory unit 11, a

[0009]

The memory unit 11 includes a ROM (Read Only Memory) and a RAM (Random Access Memory), such as a program executed by the

[0010]

The

[0011]

The disk unit 16 stores programs that can be executed by the

A program related to interactive communication is provided to the system by the CD-

[0012]

In each computer system (interactive communication apparatus) connected by a communication line, a file relating to the virtual space is opened, and an image showing the common virtual space is displayed on the screen of the display unit 14. In the virtual space on the screen, a CG object (avatar) corresponding to the user of each computer system (person who performs dialogue) is displayed. Various objects that can be operated in various ways are displayed in the virtual space.

[0013]

In this state, when the user operates an object on the screen using the input unit 13 (mouse, keyboard), CG expression data specifying the movement of the object is generated according to the same algorithm as before. Then, data representing the movement by another expression method is generated. The data represented by the other expression method is, for example, a message using characters representing the movement of the object, and the

[0014]

In FIG. 2, the process is started by operating the mouse (input unit 13), positioning the mouse cursor on the corresponding object, and clicking (S1). For example, each object on the screen and its position (coordinates) are managed in association with each other, and the object ID is acquired from the coordinates of the mouse cursor when the mouse is clicked (S2). Note that IDs are uniquely assigned in the system to objects existing on the screen.

[0015]

When the ID of the target object is acquired in this way, the object name corresponding to the acquired ID is obtained with reference to the ID / object name correspondence table as shown in FIG. Then, for example, with reference to an action definition table representing an action defined for each object as shown in FIG. 6, an ID (action ID) representing an action registered for the identified object is acquired. (S3). The target object name and the action specified by the acquired action ID are displayed as an action menu on the display screen as shown in FIG. 3, for example (S3).

[0016]

In the case of the example shown in FIG. 3, the actions defined for the object “ball” mean “turn”, “hold”, and “push”.

In the system, “Japanese” is set as the default value of the language. When another language (English or the like) is used, the designated language is input using the

[0017]

When the operation menu is displayed on the display screen as described above, when the user selects any operation in the operation menu using the mouse (input unit 13), the selected operation is stored in the acquisition system. Acquired by (CPU 10) (S4). The structure number (1, 2,...) Corresponding to the language expression of the selected action is acquired with reference to the action expression definition table as shown in FIG. (S5). Then, the acquired structure number is output to the buffer (in the memory unit 11) (S6). This structure number specifies the structure of a sentence (message) using the language expression of the action.

[0018]

The relationship between the structure number and the sentence structure (protocol structure) is described in, for example, a protocol structure table as shown in FIG. In this case, the document number “1” specifies a document structure composed of structural elements arranged like an action subject (I), an action (throwing), and an action target (ball). Further, the document number “2” identifies the document structure composed of the structural elements arranged as the subject of action (I) and the action (laugh).

[0019]

When the structure number is acquired as described above, the protocol structure corresponding to the structure number is specified with reference to the protocol structure table (S7). Then, the value of each structural element of the specified protocol structure is sequentially read from the top (S8, S9, S10, S11). When the structure number is “1”, the value of the first structure element is the “user ID of the operation subject”, the value of the next structure element is “the ID indicating the action”, and the value of the third structure element. “Action object ID ” is output to the buffer. The “user ID of the operation subject” is obtained from, for example, the user ID registered in the login process, and for the “ID representing the operation”, the ID corresponding to the selected operation is the operation definition table (FIG. 7). Further, for “action object ID”, an ID corresponding to the object acquired at the time of the mouse click operation (S2) is obtained from the object name / ID correspondence table (see FIG. 5). .

[0020]

When it is determined that the value of the structure element is complete (S9, YES), as a result of the above processing, for example, as shown in FIG. 8, “document structure (structure number)”, “acting user” Message data composed of “ID”, “ID representing motion”, and “motion target object ID” is newly stored in the buffer as motion representation data (S12). As described above, when the motion expression data representing the motion of the object designated by the user is generated in the buffer, the motion expression data is read from the buffer and the same virtual data is transmitted from the

[0021]

When the operation expression data sent from the computer system (interactive communication apparatus) as described above is transmitted via the communication line, the processing is performed according to the procedure shown in FIG. 9, for example.

In FIG. 9, when motion expression data including a message that expresses the motion linguistically is received (S100), this data is stored in the buffer. Thereafter, whether the expression desired by the user is a CG expression (image), a message composed of a character string, or both of them is determined based on a designation input by the user from the

[0022]

In the CG output processing part in the CG output processing P2 and the both-side processing P3, for example, using the expression format conversion table as shown in FIG. The image is converted into operation table data (CG expression data) in an expression format. This representation format conversion table uses “structure number”, “user ID of operation subject”, “ID representing motion”, “object ID of motion” as an index for specifying message data in the character string representation format, The relationship with the expression data by CG expressing the content of the message data is shown.

[0023]

Then, image processing according to a conventional method is performed using the CG expression data obtained as described above. As a result, the operation of the object specified by the transmission source is reproduced on the display screen in the receiving system.

On the other hand, the character string output process P1 is executed, for example, according to the procedure shown in FIG.

[0024]

10, the operation expression data stored in the buffer (message data) is acquired in the system (CPU 10) (S22). Further, the message data includes information related to the language set in the transmitting computer system, and the receiving system acquires information related to the set language from the message data (S23). When the information about the set language is acquired in this way, the rule base and document structure table corresponding to the language are selected (S24). For example, in the case of Japanese, a document structure table as shown in FIG. 11 and a rule base as shown in FIG. 12 are selected. In this document structure table, a number specifying the content of the document structure specified by the structure number (subject insertion, particle insertion, verb insertion, etc.) is described, and the rule base specifies the number. The structure content is specified.

[0025]

When the document structure table and rule base corresponding to the language set as described above are selected, the first parameter (structure number) of the message data (see FIG. 8) is extracted, and this first parameter is used as a key. Then, the protocol structure table (see FIG. 4) is retrieved (S25). As a result, the protocol structure is determined. Thereafter, the determined values of the respective structural elements of the protocol structure are sequentially output from the head to the buffer (S26, S27, S28, S29). When the structure number is “1”, as in the system on the transmission side, “the user ID of the operation subject” that is the value of the first structure element, “the ID that represents the operation” that is the value of the next structure element, and three more The value of the second structural element “action object ID ” is output to the buffer.

[0026]

When a structural element indicating the end is detected (S27, YES), the document structure table (see FIG. 11) is further stored using the first parameter (structure number) extracted from the message data as described above as a key. Search is performed (S30). Then, the elements (numbers) of the document structure corresponding to the structure number are sequentially read out, the rule base (see FIG. 12) is searched using each element number as a key, and the character string according to the rule base is selected. (S31, S32, S33, S34, S35). The selected character string is sequentially stored in the buffer. Such a process is repeated until it is detected that the element of the document structure to be read is an end code (S32, YES).

[0027]

In the example of the document structure table shown in FIG. 11, element numbers “100”, “200”, “300”, “201”, “400”, and “500” are assigned to the designated structure number “1”. Read out. In the example of the rule base shown in FIG. 12, the element number “100” represents that the user ID representing the operation subject is changed and substituted into the user name with reference to the user information table (see FIG. 15). The element number “200” indicates that the particle “ha” is inserted, and the element number “201” indicates that the particle “ha” is inserted. The element number “300” indicates that the action target object ID is converted into the action target object name and inserted by referring to the object ID correspondence table (see FIG. 5). The element number “400” This indicates that an ID representing an action is converted and inserted into a verb representing an action with reference to a language expression definition table (see FIG. 7). The element number “500” represents the end of the message.

[0028]

Here, the processing (S33, S34) for generating the character string (message) according to the rule base from the element number read from the document structure table (see FIG. 11) is executed according to the procedure shown in FIG. 13, for example. .

That is, based on the rule base, the document element number read from the document structure table is a number indicating verb change (S301), or the verb type is determined after determining the verb type from the user information. The number to be inserted (S302), the number for instructing to insert the user name as it is (S303), or the number for instructing to insert the object name as it is (S304). It is determined whether it is a number (S305). For example, in the case of a document specified by the structure number “1” shown in the document structure table shown in FIG. 11, first, it is determined that the read element number “100” represents that the user name is to be inserted. (S303, YES), for example, the “operation subject user ID” extracted from the message data with reference to the user information table shown in FIG. 15 is converted into a corresponding user name (S309). The username (eg, “I”) is stored in the buffer. Next, when it is determined that the read element number “200” represents that the particle “ha” is inserted (S305, YES), the character “ha” is stored in the buffer and the read element number is read. If it is determined that “300” represents that an object name is to be inserted (S304, YES), the object to which the “action target object ID” extracted from the message refers to the correspondence table (see FIG. 5). It is converted into a name (S310). The object name (eg, “ball”) is stored in the buffer.

[0029]

Further, when it is determined that the read element number “201” indicates that the particle “O” is to be inserted (S305, YES), the character “O” is stored in the buffer. If it is determined that the read element number “400” indicates that a verb is to be inserted (S301, YES), the action content extracted from the message with reference to the language expression definition table (FIG. 7) is displayed. The ID is converted into a character string representing the operation. A character string representing the operation is stored in the buffer. Although not shown, a sub-element number is linked to an element number representing the insertion of a verb, and the sub-element number specifies a change of each verb (present tense, past tense, future tense, etc.). . The relationship between the sub element number and the change of each verb is summarized in a verb conversion table as shown in FIG. 14, for example. As described above, when a verb is inserted, an inflected verb corresponding to the sub-element number is selected with reference to this verb conversion table.

[0030]

When the above-described processing is completed for all the element numbers described in the document structure table (see FIG. 11), the character information stored in the buffer at that time is sequentially read (“I”, “ha”, “ Ball ”“ to ”“ throw ”), for example, provided to the display unit 14. As a result, a new window is opened in the virtual space displayed on the screen of the

[0031]

Note that the processing shown in FIG. 13 assumes a grammar language (English, German, etc.) in which the verb changes according to the subject of action. That is, when it is determined that the read element number represents changing the verb according to the user information (S302, YES), the type of verb to be transformed from the user information (see FIG. 15) is determined according to the rule base. (S306). The determined verb type is converted into an element number (S307), and a character string representing a verb to be displayed is determined from the element number and the verb ID (S308).

[0032]

When the language to be set is English, for example, the sentence structure table is configured as shown in FIG. 16, and a rule base as shown in FIG. 17 is used.

Furthermore, the character information (“I”, “ha”, “ball”, “throw”) and “throw” accumulated in the buffer as information to be output as described above can be provided to the speech synthesis unit 15. In this case, the speech synthesis unit 15 generates a corresponding speech signal based on the provided character information. Then, the

[0033]

When voice output is performed in this way, the gender of the user ID representing the subject of the operation is acquired from the user information table (see FIG. 15), and the output frequency characteristics can be switched according to the gender (male or female). Is possible.

According to the system as described above, communication using CG images, text information, and voice can be freely performed between computer systems connected to each other via a communication line according to the user's wishes. Also it generates a set documented structure table and rule base corresponding to the language selection, documents directly set language using the selected structure table and rule base (sentence). Therefore, for example, when outputting an English document, the process becomes easier than a general translation process that requires a process such as changing the Japanese document structure to an English document structure.

[0034]

【The invention's effect】

As described above, according to the present invention described in each claim, even if the received information is in a predetermined expression format, communication information in an expression format other than the expression format can be output. Therefore, an interactive communication terminal device that can communicate in various expression formats is realized.

[Brief description of the drawings]

FIG. 1 is a block diagram showing a basic hardware configuration of a computer system in which an interactive communication apparatus according to an embodiment of the present invention is realized.

FIG. 2 is a flowchart showing a processing procedure at the time of transmission in the interactive communication apparatus.

FIG. 3 is a diagram illustrating an example of a screen display for designating an operation of a CG object.

FIG. 4 is a diagram showing a protocol structure table.

FIG. 5 is a diagram illustrating a correspondence table between object IDs and object names.

FIG. 6 is a diagram showing an object action definition table;

FIG. 7 is a diagram illustrating a language expression definition table representing operations.

FIG. 8 is a diagram showing the contents of a message to be generated.

FIG. 9 is a flowchart showing a procedure of processing at the time of reception in the interactive communication apparatus.

FIG. 10 is a flowchart showing a detailed procedure of character string output processing.

FIG. 11 is a diagram showing a document structure table corresponding to Japanese.

FIG. 12 is a diagram showing a rule base corresponding to Japanese.

FIG. 13 is a flowchart showing details of a process for generating a character string based on a rule base.

FIG. 14 is a diagram showing a verb conversion table.

FIG. 15 is a diagram showing a user information table.

FIG. 16 is a document structure table corresponding to English.

FIG. 17 is a rule base corresponding to English.

FIG. 18 is a diagram illustrating an expression format conversion table.

[Explanation of symbols]

10 CPU (Central Processing Unit)

11

Claims (1)

他のシステムに送出する情報を生成するための入力操作を受け付ける情報入力手段と、 Information input means for receiving an input operation for generating information to be sent to another system;

前記情報入力手段にて受け付けた操作内容に応じて、コミュニケーションシステムで操作可能な操作対象と文書構造を特定する文書構造識別情報とが対応付けて記憶された動作表現定義テーブルを参照して文書構造識別情報を特定し、特定された文書構造識別情報に基づいて、文書構造識別情報と文書構造が対応づけて記憶されたプロトコル構造テーブルを参照して文書構造を特定し、前記情報入力手段にて受け付けた操作内容から、特定された文書構造に基づいて情報を生成する情報生成手段と、 The document structure with reference to the action expression definition table in which the operation target operable by the communication system and the document structure identification information for specifying the document structure are stored in association with each other according to the operation content received by the information input unit The identification information is specified, the document structure is specified by referring to the protocol structure table in which the document structure identification information and the document structure are stored in association with each other based on the specified document structure identification information, and the information input means Information generating means for generating information from the received operation content based on the specified document structure;

生成された情報を他のシステムに送出する情報送出手段と、 Information sending means for sending the generated information to another system;

他のシステムからの情報を受信する受信手段と、 Receiving means for receiving information from other systems;

受信手段にて受信した情報に含まれる文書構造識別情報に基づいて、文書構造識別情報と文書構造が対応づけて記憶された文書構造テーブルを参照して文書構造を特定し、さらに、前記文書構造の要素を識別する要素番号と当該要素の構造内容とが対応づけて記憶されたルールベースを参照して要素毎の構造を特定し、特定された文書構造と要素毎の構造内容に基づいて、受信した情報を変換する情報変換手段と、 Based on the document structure identification information included in the information received by the receiving means, the document structure is specified by referring to a document structure table in which the document structure identification information and the document structure are stored in association with each other, and the document structure The structure of each element is identified with reference to the rule base stored by associating the element number identifying the element with the structure content of the element, and based on the identified document structure and the structure content of each element, Information conversion means for converting the received information;

前記変換した情報を出力する情報出力手段と Information output means for outputting the converted information;

を有する対話型コミュニケーション端末装置。An interactive communication terminal device.

Priority Applications (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP28735297A JP3987172B2 (en) | 1997-10-20 | 1997-10-20 | Interactive communication terminal device |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP28735297A JP3987172B2 (en) | 1997-10-20 | 1997-10-20 | Interactive communication terminal device |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JPH11119880A JPH11119880A (en) | 1999-04-30 |

| JP3987172B2 true JP3987172B2 (en) | 2007-10-03 |

Family

ID=17716264

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP28735297A Expired - Fee Related JP3987172B2 (en) | 1997-10-20 | 1997-10-20 | Interactive communication terminal device |

Country Status (1)

| Country | Link |

|---|---|

| JP (1) | JP3987172B2 (en) |

Families Citing this family (2)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP3450760B2 (en) * | 1999-10-14 | 2003-09-29 | 富士通株式会社 | Communication promotion method and system |

| US20050021344A1 (en) * | 2003-07-24 | 2005-01-27 | International Business Machines Corporation | Access to enhanced conferencing services using the tele-chat system |

-

1997

- 1997-10-20 JP JP28735297A patent/JP3987172B2/en not_active Expired - Fee Related

Also Published As

| Publication number | Publication date |

|---|---|

| JPH11119880A (en) | 1999-04-30 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| KR101130379B1 (en) | A system and process for controlling a shared display given inputs from multiple users using multiple input modalities | |

| CN101998107B (en) | Information processing apparatus, conference system and information processing method | |

| JP2023539820A (en) | Interactive information processing methods, devices, equipment, and media | |

| MXPA04010107A (en) | Sequential multimodal input. | |

| JP2006511112A (en) | Mobile graphic display | |

| JP2009145965A (en) | Browser program and information processor | |

| EP1139335B1 (en) | Voice browser system | |

| JPH10207684A (en) | Information processor and information processing method for three-dimensional virtual reality space sharing system, and medium | |

| JP2011175598A (en) | Device and program for generating sign language animation | |

| JP3733322B2 (en) | Multimodal document receiving apparatus, multimodal document transmitting apparatus, multimodal document transmitting / receiving system, control method therefor, and program | |

| JP2002288213A (en) | Data-forwarding device, data two-way transmission device, data exchange system, data-forwarding method, data-forwarding program, and data two-way transmission program | |

| JP3987172B2 (en) | Interactive communication terminal device | |

| JP2003116095A (en) | Video processor | |

| JP2001197461A (en) | Sharing operation method for multimedia information operation window | |

| JP2003271532A (en) | Communication system, data transfer method of the system, server of the system, processing program for the system and record medium | |

| JPH09305787A (en) | Animation production and reproduction device and animation retrieval device | |

| JP7048141B1 (en) | Programs, file generation methods, information processing devices, and information processing systems | |

| CN113542706B (en) | Screen throwing method, device and equipment of running machine and storage medium | |

| JP6912749B1 (en) | Information processing equipment, information processing systems, and information processing programs | |

| JPH0962687A (en) | Information processor and information providing system | |

| JP3825234B2 (en) | Hypertext relay method and apparatus for voice browsing, and recording medium | |

| JP6736940B2 (en) | Operation support device, operation support method, and program | |

| JP2000339132A (en) | Document voicing device and its method | |

| JP3469231B2 (en) | Animation search device | |

| JP4366168B2 (en) | DATA GENERATION DEVICE, DATA PROCESSING DEVICE, THEIR SYSTEM, DATA GENERATION METHOD, PROGRAM THEREOF, AND RECORDING MEDIUM CONTAINING THE PROGRAM |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20040803 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20040803 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20061205 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20070201 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20070410 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20070606 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20070710 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20070712 |

|

| R150 | Certificate of patent or registration of utility model |

Free format text: JAPANESE INTERMEDIATE CODE: R150 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20100720 Year of fee payment: 3 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20100720 Year of fee payment: 3 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20110720 Year of fee payment: 4 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20110720 Year of fee payment: 4 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20120720 Year of fee payment: 5 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20120720 Year of fee payment: 5 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20130720 Year of fee payment: 6 |

|

| LAPS | Cancellation because of no payment of annual fees |