JP3937660B2 - Image processing method and computer-readable storage medium - Google Patents

Image processing method and computer-readable storage medium Download PDFInfo

- Publication number

- JP3937660B2 JP3937660B2 JP25418499A JP25418499A JP3937660B2 JP 3937660 B2 JP3937660 B2 JP 3937660B2 JP 25418499 A JP25418499 A JP 25418499A JP 25418499 A JP25418499 A JP 25418499A JP 3937660 B2 JP3937660 B2 JP 3937660B2

- Authority

- JP

- Japan

- Prior art keywords

- image

- gradation conversion

- circuit

- value

- region

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Expired - Fee Related

Links

- 238000003672 processing method Methods 0.000 title claims description 10

- 238000006243 chemical reaction Methods 0.000 claims description 102

- 238000012545 processing Methods 0.000 claims description 47

- 238000000034 method Methods 0.000 description 30

- 238000000605 extraction Methods 0.000 description 14

- 238000007781 pre-processing Methods 0.000 description 14

- 230000000694 effects Effects 0.000 description 13

- 230000014509 gene expression Effects 0.000 description 13

- 230000006870 function Effects 0.000 description 12

- 230000000007 visual effect Effects 0.000 description 10

- 238000010586 diagram Methods 0.000 description 9

- 239000011800 void material Substances 0.000 description 9

- 230000006835 compression Effects 0.000 description 8

- 238000007906 compression Methods 0.000 description 8

- 238000003384 imaging method Methods 0.000 description 8

- 210000004072 lung Anatomy 0.000 description 6

- 238000012217 deletion Methods 0.000 description 5

- 230000037430 deletion Effects 0.000 description 5

- 210000000988 bone and bone Anatomy 0.000 description 4

- 238000012937 correction Methods 0.000 description 4

- 238000003745 diagnosis Methods 0.000 description 4

- 210000004872 soft tissue Anatomy 0.000 description 4

- 230000002829 reductive effect Effects 0.000 description 3

- 230000000717 retained effect Effects 0.000 description 3

- 230000002238 attenuated effect Effects 0.000 description 2

- 210000000746 body region Anatomy 0.000 description 2

- 210000000038 chest Anatomy 0.000 description 2

- 238000007796 conventional method Methods 0.000 description 2

- 230000007423 decrease Effects 0.000 description 2

- 230000000877 morphologic effect Effects 0.000 description 2

- 238000004364 calculation method Methods 0.000 description 1

- 238000013480 data collection Methods 0.000 description 1

- 230000003247 decreasing effect Effects 0.000 description 1

- 230000006866 deterioration Effects 0.000 description 1

- 229940079593 drug Drugs 0.000 description 1

- 239000003814 drug Substances 0.000 description 1

- 230000003628 erosive effect Effects 0.000 description 1

- 238000011156 evaluation Methods 0.000 description 1

- 238000002474 experimental method Methods 0.000 description 1

- 239000000284 extract Substances 0.000 description 1

- 210000003127 knee Anatomy 0.000 description 1

- 210000001370 mediastinum Anatomy 0.000 description 1

- 230000003287 optical effect Effects 0.000 description 1

- 239000004065 semiconductor Substances 0.000 description 1

- 210000000115 thoracic cavity Anatomy 0.000 description 1

Images

Landscapes

- Apparatus For Radiation Diagnosis (AREA)

- Image Processing (AREA)

- Facsimile Image Signal Circuits (AREA)

Description

【0001】

【発明の属する技術分野】

本発明は、X線画像等の画像のダイナミックレンジ圧縮処理機能を有する画像処理方法及びコンピュータ読み取り可能な記憶媒体に関するものである。

【0002】

【従来の技術】

例えば、X線胸部画像は、X線が透過しやすい肺野の画像及びX線が非常に透過しにくい縦隔部の画像より構成されるため、画素値の存在するレンジが非常に広い。このため、肺野及び縦隔部の両方を同時に観察することが可能なX線胸部画像を得ることは困難であるとされてきた。

【0003】

そこで、この問題を回避する方法として、「SPIE Vol.626 MedicineXIV/PACS IV(1986)」に記載された方法(以下、「方法1」と言う)がある。この方法1は、処理後の画素値SD 、オリジナル画素値(入力画素値)Sorg 、オリジナル画像(入力画像)の低周波数画像の画素値SUS、定数A,B,C(例えば、A=2,B=0.7)を持って、

SD =A[Sorg −SUS]+B[SUS]+C ・・・・(1)

なる式(1)で表されるものである。

【0004】

上述のような方法1では、高周波成分(第1項)、低周波成分(第2項)の重み付けを変えることが可能で、例えば、定数A,BをA=2,B=0.7とした場合、高周波成分を強調し、且つ全体のダイナミックレンジを圧縮する効果が得られる。これは、ある放射線医師達によれば、本処理なしの画像と比較して、診断に有効であるという評価が得られている。

【0005】

また、第2509503特許公報等には、処理後の画素値SD 、オリジナル画素値(入力画素値)Sorg 、オリジナル画像(入力画像)のY方向のプロファイルの平均プロファイルPyとX方向のプロファイルの平均プロファイルPxを持って、

SD =Sorg +F[G(Px,Py)] ・・・・(2)

なる式(2)で表される方法(以下、「方法2」と言う)が記載されている。

【0006】

ここで、式(2)での関数f(x)が有する特性について説明すると、まず、「x>Dth」ではf(x)が「0」となり、「0≦x≦Dth」ではf(x)が切片を「E」、傾きを「E/Dth」として単調減少するものとなり、次の式(3)で表される。

if(x≦Dth) f(x)=E−(E/Dth)x

else f(x)=0 ・・・・(3)

また、”Px”及び”Py”は、

Py=(ΣPyi)/n ・・・・(4)

Px=(ΣPxi)/n ・・・・(5)

なる式(4)及び(5)で表される。

【0007】

式(4)及び(5)において、”i”は”i=1〜n”であり、”Pyi”及び”Pxi”はプロファイルであり、また、式(2)での”G(Px,Py)”は、例えば、

G(Px,Py)=max(Px,Py) ・・・・(6)

で示される。

【0008】

上述のような方法2では、低周波画像の画素値で”Dth”以下の濃度レンジが圧縮される。

【0009】

また、方法2(第2509503特許公報等に記載の方法)と同様の方法(以下、「方法3」と言う)が「日本放射線技術学会雑誌 第45巻第8号1989年8月 1030頁 阿部ほか」に記載されている。この方法3は、処理後の画素値SD 、オリジナル画素値(入力画素値)Sorg 、オリジナル画像(入力画像)をマスクサイズM×M画素で移動平均をとった時の平均画素値SUS、単調減少関数f(x)を持って、

SD =Sorg +f(SUS) ・・・・(7)

SUS=ΣSorg /M2 ・・・・(8)

なる式(7)及び(8)で表されるものである。

【0010】

方法3は、式(2)によって表される方法2とは低周波画像の作成方法が異なり、方法2では1次元データで低周波画像を作成していたのに対し、2次元データで低周波画像を作成する方法である。このような方法3によっても、低周波画像の画素値で”Dth”以下の濃度レンジが圧縮される。

【0011】

また、第2663189特許公報等には、処理後の画素値SD 、オリジナル画素値(入力画素値)Sorg 、オリジナル画像(入力画像)をマスクサイズM×M画素で移動平均をとった時の平均画素値SUS、単調増加関数f1(x)を持って、

SD =Sorg +f1(SUS) ・・・・(7)

SUS=ΣSorg /M2 ・・・・(8)

なる式(7)及び(8)で表される方法(以下、「方法4」と言う)が記載されている。

【0012】

ここで、式(7)での関数f1(x)が有する特性について説明すると、まず、「x<Dth」ではf(x)が「0」となり、「Dth≦x」ではf(x)が切片を「E」、傾きを「E/Dth」として単調減少するものとなり、次の式(11)で表される。

f1[x]=E−(E/Dth)X ・・・・(11)

【0013】

上述のような方法4では、低周波画像の画素値Dth以上の画素値(濃度値)が圧縮される。このときのアルゴリズムについては、方法3(「日本放射線技術学会雑誌 第45巻第8号1989年8月 1030頁 阿部ほか」等に記載の方法)と同様である。

【0014】

【発明が解決しようとする課題】

しかしながら、上述したような従来の方法では、取得画像(入力画像)を階調変換してフィルムやCRTに対して出力した場合、視認確認できない濃度値もしくは輝度値の範囲に階調変換後の注目領域(被写体領域等)の濃度値もしくは輝度値がかかるのを防ぐことを目的としていた。

【0015】

このため、従来の方法では、圧縮開始位置や圧縮率が固定であり、ダイナミックレンジ圧縮を施した取得画像を階調変換した場合、注目領域の濃度値もしくは輝度値が視認領域に入らないことがあった。これは診断等に支障をきたす問題につながる。

【0016】

また、取得画像によっては、被写体部分の圧縮が必要以上に行なわれてしまい、本来被写体部分が保持している情報量が無意味に損出される場合があった。これは、診断能等が低下する問題につながる。

【0017】

さらに、ダイナミックレンジを拡大するという発想が無かったので、フィルムやCRT上に画像を出力する場合に、注目領域のダイナミックレンジを有効に出力することができないという問題があった。すなわち、注目領域のダイナミックレンジを所定の領域に変換するという思想がなかった。

【0018】

本発明は上記のような問題を解決するためになされたもので、高周波成分の振幅を保った状態で、注目領域のダイナミックレンジを所定の濃度領域に変換できるようにすることを目的とする。

【0019】

【課題を解決するための手段】

本発明の画像処理方法は、原画像データに対し諧調変換処理及び周波数処理を施す画像処理方法であって、前記原画像データにおける被写体内の領域から、階調変換曲線を生成するための値を抽出する工程と、前記原画像データに基づく高周波成分を生成する工程と、前記高周波成分を、前記階調変換曲線の傾きに基づいて変更する工程と、前記変更した高周波波成分に基づき画像データを生成する工程とを備えることを特徴とする。

本発明のコンピュータ読み取り可能な記憶媒体は、原画像データに対し諧調変換処理及び周波数処理を施す画像処理方法をコンピュータに実行させるためのプログラムを記録したコンピュータ読み取り可能な記憶媒体であって、前記原画像データにおける被写体内の領域から、階調変換曲線を生成するための値を抽出する工程と、前記原画像データに基づく高周波成分を生成する工程と、前記高周波成分を、前記階調変換曲線の傾きに基づいて変更する工程と、前記変更した高周波波成分に基づき画像データを生成する工程とをコンピュータに実行させるためのプログラムを記憶したことを特徴とする。

【0043】

【発明の実施の形態】

以下、本発明の実施の形態を図面と共に説明する。

【0044】

(第1の実施の形態)

図1は、本発明の実施の形態による画像処理装置100を示す。

この画像処理装置100は、濃度値変換機能を有するX線画像の画像処理装置であり、前処理回路106、濃度値変換部113,CPU108、メインメモリ109、操作パネル110、画像表示装置111を備えており、CPUバス107を介して互いにデータ授受されるようになされている。

【0045】

また、画像処理装置100は、前処理回路106に接続されたデータ収集回路105と、データ収集回路105に接続された2次元X線センサ104及びX線発生回路101とを備えており、これらの各回路はCPUバス107にも接続されている。

【0046】

図2は画像処理装置の処理の流れを示すフローチャートである。

図3(a)は入力画像を示し、図3(b)は上記入力画像からX線の照射領域とす抜け領域(X線が素通りした領域)とを削除した図である。

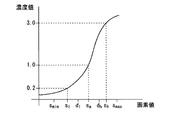

図4は階調変換曲線上で視認できる濃度域と注目領域の濃度域との関係を示す図であり、横軸が入力画像の濃度値、縦軸が出力画像の濃度値である。

【0047】

上記構成による画像処理装置100において、メインメモリ109は、CPU108の処理に必要な各種のデータなどが記憶されると共に、CPU108の作業用としてのワークメモリを含む。CPU108は、メインメモリ109を用いて、操作パネル110からの操作に従って装置全体の動作制御等を行う。これにより画像処理装置100は、以下のように動作する。

【0048】

まず、X線発生回路101は、被検査体103に対してX線ビーム102を放射する。このX線ビーム102は、被検査体103を減衰しながら透過して、2次元X線センサ104に到達し、2次元X線センサ104よりX線画像として出力される。ここでは、2次元X線センサ104から出力されるX線画像を、例えば図3(a)のような膝、胸椎画像とする。

【0049】

データ収集回路105は、2次元X線センサ104から出力されたX線画像を電気信号に変換して前処理回路106に供給する。前処理回路106は、データ収集回路105からの信号(X線画像信号)に対して、オフセット補正処理やゲイン補正処理等の前処理を行う。前処理が行われたX線画像信号は入力画像として、CPU108の制御により、CPUバス107を介してメインメモリ109、照射領域抽出回路112及び濃度値変換部113のす抜け削除回路113aに転送される。

【0050】

濃度値変換部113において、113aはす抜け領域とす抜け領域と一定幅で接する体領域とを削除するす抜け削除回路、113bはす抜け削除回路113aで削除されなかった領域から、濃度値の最大値と最小値を算出する最高値最小値抽出回路、113cは入力画像の平滑化画像を作成する平滑化画像作成回路、113dは入力画像と平滑化画像との差分から高周波成分を作成する高周波成分作成回路、113eは最大値最小値抽出回路113bで抽出された最大値と最小値に基づき平滑化画像の濃度値を変換する濃度値変換回路、113fは濃度値変換回路113eで変換された画像に高周波成分作成回路113dで作成した高周波を足し込む高周波成分足し込み回路である。

【0051】

次に濃度値変換部113の動作について図2のフローチャートにより説明する。

CPUバス107を介して前処理回路106で処理された入力画像をCPU108の制御により受信した照射領域抽出回路112は、入力画像中の照射領域を抽出する(ステップS201)。また、同時に入力画像を受信したす抜け削除回路113aは照射領域外及び照射領域内のす抜け領域とす抜け領域と一定間隔内で接する体領域とを例えば0画素で置き換える(ステップS202)。具体的には次の式(12)で表されるような画像の変換を行う。

【0052】

【数1】

【0053】

ここで、f(x,y)は画像データを示し、f1(x,y)はす抜け領域及びす抜け領域と一定間隔内で接する体領域を削除した後の画像を示す。Sgn(x,y)は以下の式(4)のように表される。Th1は実験により定められる定数、d1,d2は体領域を削除する幅を決める定数である。

sgn(x,y)=0 f(x,y)≧Th1のとき

sgn(x,y)=1 その他 ・・・・(13)。

図3(b)は、入力画像の照射領域外及びす抜け領域を0で置き換えた場合の画像である。

【0054】

次に、最大最小値抽出回路113bでは、画像濃度値の最大値(図4の”d2”)と最小値(図4の”d3”)を算出する(ステップS203)。ここで、最大値、最小値を算出するのに、照射領域及びす抜け領域を除去した領域の平滑化画像から抽出してもよい。次に平滑化画像作成回路113cは次式に従い平滑化画像を作成する(ステップS204)。fus(x,y)は入力画像f0(x,y)の平滑化(低周波)画像の画素値であり、例えば、式(14)〜(18)、又は式(19)で示される。

【0055】

【0056】

”D(x,y)”は、円盤状フィルタであり、r1を任意の定数とし、入力画像に応じて選択される。

【0057】

ここで得られたfus(x,y)のプロファイルはエッジ構造を保存しているものであり、従来ダイナミックレンジ圧縮の欠点であるオーバーシュート、アンダーシュートが起きないものである。

【0058】

平滑化画像は、例えば式(17)で示される平均濃度を用いてもよいし、次の式(19)を用いてもよい。ここでdは定数である。

【0059】

【数2】

【0060】

また、例えばErosion、Dai1ation、Opening、C1osinng等のモルフォロジカルフィルタを用い平滑化画像を作成してもよい。

【0061】

次に、高周波成分作成回路113cでは、入力画像f0(x,y)と平滑化画像fus(x,y)とから次式に従い高周波画像fh(x,y)を作成する(ステップS205)。次に濃度値変換回路113eは、最大最小値値抽出回路113bで抽出した最大値(d3)、最小値(d2)、そして階調変換後の視認濃度値で決まる濃度値d1,d4に基づき次式により濃度値を変換し、濃度値変換した平滑化画像Sus0×(x,y)を作成する(ステップS206)。

【0062】

図4において、SightmaxとSightminが視認できる最大最小濃度値であり、d1,d4に対応する。平滑化画像の濃度値がmin(平滑化画像が取り得る最小値)からd1以下の場合、

【0063】

d2<Sus(x,y)≦d3の場合、

【0064】

d3<Sus(x,y)≦maxの場合、

【0065】

そして、濃度値変換した画像Susuo(x,y)に高周波画像fh(x,y)を足し込み、最終画像fe(x,y)を得る(ステップS207)。

fe(x,y)=Susu0(x,y)十fh(x,y) ・・・(23)

最終的には、得られた画像fe(x,y)を階調変換回路114で階調変換してフィルム出力又は画像表示装置111に表示する。

【0066】

尚、本実施の形態では、す抜け領域がある画像に対する場合について説明したが、す抜け領域がない場合は、す抜け削除回路113aを経由せず、照射領域内の画像から、最大最小値抽出回路113bにより最大値と最小値を抽出すればよい。

【0067】

本実施の形態によれば、高周波成分を保持したまま、注目領域の画像を一定幅に圧縮、拡大することが可能であり、画像情報を有効に使える効果がある。さらに、上記一定幅をフィルムなどの視認領域とすれば、フィルム上の視認領域の幅に注目領域を拡大縮小することができる効果が有る。また、最大値、最小値を平滑化画像から抽出する場合は、濃度値変換部113での変換をより精度よく行える効果が有る。

【0068】

(第2の実施の形態)

図5は、本発明の実施の形態による画像処理装置を適用したX線撮影装置600の構成を示す。

【0069】

X線撮影装置600は、画像処理機能を有するものであり、前処理回路606、CPU608、メインメモリ609、操作パネル610、画像表示器611、及び画像処理回路612を備えており、これらの各回路はCPUバス607を介して互いにデータ授受されるようになされている。

【0070】

また、X線撮影装置600は、前処理回路606に接続されたデータ収集回路605と、データ収集回路605に接続された2次元X線センサ604及びX線発生回路601とを備えており、これらの各回路もCPUバス607に接続されている。

【0071】

画像処理回路612は、階調変換のための特徴量を算出する特徴抽出回路612aと、後述する第1の階調変換回路612dの階調変換曲線からダイナミックレンジを変更する範囲と変更量を算出する制御回路612bと、制御回路612bで算出されたダイナミックレンジを変更する範囲と変更量から原画像のダイナミックレンジを変更するDRC回路612cと、DRC回路612cにてダイナミックレンジが変更された原画像の階調変換を行なう第1の階調変換回路612dとを備えている。

【0072】

DRC回路612cは、原画像の階調変換を行なう第2の階調変換回路613と、第2の階調変換回路613にて階調変換された画像に対して原画像の高周波成分を足し込む高周波成分調整回路とを備えている。

【0073】

図6は、例えば、頸椎側面で撮影を行なった場合に得られる画像(X線撮影画像)において、特徴量を抽出する領域aを示したものである。

【0074】

図7は、第1の階調変換回路612dの階調変換曲線を示したものであり、この図7において、横軸は画素値を示し、縦軸は濃度値を示す。”Sl”は、濃度上で視認識限界の下限濃度値に対応する画素値を示し、”Sh”は、濃度上で視認識限界の上限濃度値に対応する画素値を示す。”Smin”及び”Smax”は、注目領域の最小画素値及び最大画素値を示す。”Sa”は、特徴抽出回路612aにて算出された特徴量に対応する画素値を示し、”dl”及び”dh”はそれぞれ、ダイナミックレンジの変更しない範囲の下限濃度値及び上限濃度値に対応する画素値を示す。

【0075】

図8は、第2の階調変換回路613の階調変換曲線を示したものであり、こ の図8において、横軸は入力画素値を示し、縦軸は出力画素値を示す。”dl”、”dh”、及び”Sa”は、図7での画素値と同じ画素値を示す。

図8に示す階調変換曲線aは、直線成分のみから構成され、同図に示す階調変換曲線bは、階調変換曲線aの微分値が連続となるようななだらかな曲線から構成されている。

【0076】

ここで、上述のようなX線撮影装置600において、メインメモリ609は、CPU608による本装置全体の動作制御のための処理に必要な処理プログラムや各種のデータ等が記憶されるものであると共に、CPU608の作業用メモリとしてのワークメモリを含むものである。

したがって、CPU608は、メインメモリ609及びメインメモリ609に記憶された情報を用いて、操作パネル610からの操作に従った本装置全体の動作制御等を行なう。これにより、X線撮影装置600は次のように動作する。

【0077】

先ず、X線発生回路601が被写体603に対してX線ビーム602を放射する。X線発生回路601から放射されたX線ビーム602は、被写体603を減衰しながら透過して、2次元X線センサ604に到達し、2次元X線センサ604によりX線画像として出力される。この2次元X線センサ604から出力されるX線画像は、例えば、人体部画像である。

【0078】

データ収集回路605は、2次元X線センサ604から出力されたX線画像を電気信号に変換して前処理回路606に供給する。前処理回路606は、データ収集回路605からの信号(X線画像信号)に対して、オフセット補正処理やゲイン補正処理等の前処理を施す。この前処理回路606にて前処理が施されたX線画像信号は入力画像として、CPU608の制御により、CPUバス607を介して、メインメモリ609及び画像処理回路612にそれぞれ転送される。

【0079】

画像処理回路612は、例えば、図9に示すフローチャートに従って次のように動作する。

【0080】

先ず、CPUバス607を介して前処理回路606から供給された入力画像(前処理が施された原画像)f0(x,y)を、CPU608の制御により受信した特徴抽出回路612aは、階調変換のための特徴量Sa を算出する(ステップS701)。

ここでの特徴量の抽出方法は、入力画像f0(x,y)での被写体の部位毎に異なり、本出願人から複数の方法が提案されている。例えば、入力画像f0(x,y)が、頸椎の撮影により得られた画像である場合には、特願平10−272284号に記載された方法を用いる。この方法は、特徴量Saとして、図6の”a”に示した領域内の画素値の平均値を算出する方法である。

【0081】

次に、第1の階調変換回路612dでの階調変換曲線を、特徴抽出回路612aにて得られた特徴量Saを用いて規定する(ステップS702)。

例えば、図7に示すように、特徴量Saの画素値が濃度値1.0に変更されるような階調変換曲線を規定する。

【0082】

次に、制御回路612bは、ステップS702にて規定された階調変換曲線から入力画像f0(x,y)のダイナミックレンジを変更する範囲と変更量を算出する(ステップS703)。この算出方法としての一例を次に述べる。

【0083】

例えば、通常の日本人は、画像での視認識できるの濃度値が、濃度値0.2から3.0の範囲となっている。

そこで、先ず、ステップS702にて規定された階調変換曲線に基づき、濃度値0.2、3.0に階調変換される画素値Sl、Shを算出する。

次に、ダイナミックレンジを変更しない幅を、

dl=Sa−hl ・・・・(24)

dh=Sa+hh ・・・・(25)

なる式(24)及び(25)に従って算出する。

式(24)及び(25)において、”hl”及び”hh”は定数であり、”dl”及び”dh”はダイナミックレンジを変更する起点となる画素である。

【0084】

そして、”dl”以下の画素値、”dl”以上の画素値の変更量Rl,Rhを、

Rl=(Sl−dl)/(Smin−dl) ・・・・(26)

Rh=(Sh−dh)/(Smax−dh) ・・・・(27)

なる式(26)及び(27)に従って算出する。

式(26)及び(27)において、”Smin”及び”Smax”は、被写体領域(注目領域)の画素値のうちの最小値及び最大値を示す。すなわち、dl以下の画素値のダイナミックレンジをRl倍すると、画素値Sminは画素値Slに変更される。同様に、画素値Smaxは画素値Shに変更される。換言すれば、起点をdl,dhとし、変更量をRl,Rhとすると、階調変換後の被写体領域の濃度値は、視野領域(ここでは例えば、濃度値0.2〜3.0)の幅と一致する。

【0085】

上述のように、変更量Rl,Rhを求めることにより、ダイナミックレンジを圧縮しても、撮影画像の注目領域の全てを出力画像上に再現することができる。したがって、特徴抽出の不安定性を吸収することができ、診断能力の向上を図ることができる。

【0086】

また、変更量Rl,Rhに対する拘束条件として、

Rl<Cl ・・・・(28)

Rh<Ch ・・・・(29)

なる式(28)及び(29)に示すような条件を設けるようにしてもよい。

式(28)及び(29)において、”Cl”及び”Ch”はそれぞれ定数を示す。これらの定数Cl,Ch、及び上述した定数hl,hhは、例えば、撮影対象となる被写体の部位毎に実験的に決まる定数である。

このように、拘束条件を設けることによって、圧縮のしすぎを防ぐことができるため、圧縮のしすぎによる診断能力の低下を確実に防止することができる。

【0087】

上述のようにして、ダイナミックレンジを変更する起点となる画素dl,dh、及び変更量Rl,Rhが求まると、これらのdl,dh,Rl,Rhに基づき、図8に示したような第2の階調変換回路613の階調変換曲線を規定する。

図8に示す階調変換曲線aでの画素値dl以下の傾きは”Rl”であり、画素値dlから画素値dhの範囲の傾きは”1”であり、画素値dh以上の傾きは”Rh ”である。一方、同じく図8に示す階調変換曲線bは、特願昭11−76882号等に記載されている技術によって、階調変換曲線aの微分値が連続となるようになだらかにした曲線である。第2の階調変換回路613の階調変換曲線として、階調変換曲線aを用いる場合には、微分不連続点で偽輪郭が発生することがあるが、階調変換曲線bを用いる場合には、当該偽輪郭が発生することはない。ここでは一例として、階調変換曲線bを第2の階調変換回路613で用いるものとする。

【0088】

次に、DRC回路612cは、以降の処理で、高周波成分を保持するか否かを選択する(ステップS704)。

高周波成分を保持せずに処理実行した場合に得られる結果画像は、低周波成分が重要である軟部組織等を診断する場合に用いて有効である。一方、高周波成分を保持して処理実行した場合に得られる結果画像は、高周波成分が重要である骨部、肺野等を診断する場合に用いて有効である。すなわち、処理対象の画像が軟部組織等の画像であれば、高周波成分を保持しないと選択し、処理対象の画像が骨部、肺野等の画像であれば、高周波成分を保持すると選択することによって、軟部組織や、骨部、肺野等のそれぞれの診断に有効な結果画像が得られる。

このステップS704での選択は、撮影部位(軟部組織、骨部、肺野等)に基づき自動選択する構成としてもよいし、ユーザがマニュアル選択する構成としてもよい。

【0089】

ステップS704での選択の結果、高周波成分を保持しない場合、第2の階調変換回路613により、入力画像(原画像)に対して階調変換曲線b(図8参照)を用いた階調変換を施す(ステップS708)。

そして、第1の階調変換回路612dにより、第2の階調変換回路613での階調変換後の入力画像に対して階調変換を施す(ステップS709)。

【0090】

ここで、入力画像(原画像)の座標を”x,y”、原画像の画素値を”f0(x,y)”、第2の階調変換回路613の階調変換曲線bを”F(x)”、階調変換曲線bを用いた階調変換後の画像の画素値を”f1(x,y)”、第1の階調変換回路612dの階調変換曲線を”F1(x)”とすると、結果的に得られる画像(最終画像)f2(x,y)は、

f2(x,y)=F1(F(f0(x,y)) ・・・・(30)

なる式(30)で表される。

この場合、”F1(F(x))を、1つの階調変換曲線と考えてよい。

【0091】

一方、ステップS704での選択の結果、高周波成分を保持する場合、先ず、高周波成分調整回路614により、原画像f0(x,y)の高周波成分fh(x,y)を、

fh(x,y)=f0(x,y)−fus(x,y) ・・・・(31)

なる式(31)により算出する(ステップS705)。

式(31)において、”fus(x,y)”は、平滑化画像であり、マスクサイズの大きさを示す定数dを持って、

【0092】

【数3】

【0093】

なる式(32)により算出される。

【0094】

次に、第2の階調変換回路613により、原画像f0(x,y)に対して、

f1(x,y)=F(f0(x,y)) ・・・・(33)

なる式(33)で示される階調変換を施し、当該階調変換後の画像f1(x,y)を取得する(ステップS706)。

【0095】

次に、高周波成分調整回路614により、第2の階調変換回路613の階調変換曲線bの微係数から係数c(x)を、

【0096】

【数4】

【0097】

なる式(34)により算出する。この式(34)に示されるように、係数c(x)は、階調変換曲線bの傾きから”1”を引いた値である。

そして、係数c(x)に基づいて、ステップS706にて取得された第2の階調変換回路613での階調変換後の画像f1(x,y)に対して、ステップS706にて取得された原画像f0(x,y)の高周波成分fh(x,y)を足し込み、その処理後画像f3(x,y)を得る。すなわち、処理後画像f3(x,y)は、

なる式(35)で表される(ステップS707)。

【0098】

そして、第1の階調変換回路612dにより、ステップS707にて得られた処理後画像f3(x,y)に対して、

f2(x,y)=F1(f3(x,y)) ・・・・(36)

なる式(36)に従った階調変換を行い、この結果得られた画像f2(x,y)を最終画像として得る(ステップS709)。

【0099】

尚、ステップS705の式(31)における平滑化画像fus(x,y)を、例えば、次の式(37)〜(41)で示されるモルフォジ演算を用いて算出するようにしてもよい。

式(37)〜(40)において、”D(x1,y1)”は、円盤状フィルタであり、入力画像に応じて選択される任意の定数r1を持って、

なる式(41)で表される。

【0100】

式(37)〜(41)により得られる平滑化画像fus(x,y)のプロファイルは、エッジ構造を保存しているものであり、従来ダイナミックレンジ圧縮の欠点であるオーバーシュート、アンダーシュートが起きないものである。

【0101】

本実施の形態によれば、入力画像の任意の階調領域の濃度分布幅を圧縮、伸張することができ、且つ階調変換後の高周波成分の振幅を階調変換前の画像の高周波成分の振幅を保持できる効果がある。

また、階調変換曲線で決まる画素値に基づき、画像のダイナミックレンジを変更するので、階調変換後の画像の濃度値を想定して、ダイナミックレンジを変更できるので、階調変換後の濃度値の範囲を一意に調整できる効果がある。

【0102】

また、階調変換曲線から視認限界で決まる画素値を求め、その画素値の値に基づきダイナミックレンジを変更する範囲、量を決定できるので、注目領域の画素値の濃度値の範囲を視認範囲にすることができる効果がある。

また、注目領域が視認領域にあることから、注目領域全体を観察することが可能であり、診断能が上がる効果がある。

また、注目領域を視認領域の幅に一致することが可能であり、注目領域の情報量を濃度値として最大限に表現できる。

また、画像のダイナミックレンジを変更しない範囲を有するので、診断等で重要となる画素範囲をダイナミックレンジを変更しない領域とし、従来通りの濃度値で表現し、さらに、従来では視認できなかった領域も濃度値として観察できるため、診断能が上がる効果がある。

また、ダイナミックレンジの変更手段において高周波成分を保持するため、高周波成分の情報量を落とすことがなく、さらに従来では濃度値上で視認できなかった領域の濃度値も観察できるため、診断能が上がる効果がある。

【0103】

(他の実施の形態)

上述の実施の形態は、ハード的に実現してもよく、また、ソフト的に構成してもよい。例えば、CPUやメインメモリ等のメモリ等からなるコンピュータシステムを用いて、図2又は図9に示したフローチャートによる処理を実行するためのプログラムを実現することにより、上述の実施の形態における構成を実現してもよい。

【0104】

上記プログラムを記憶する記憶媒体としては、ROM、RAM等の半導体メモリ、光ディスク、光磁気ディスク、磁気記憶媒体等を用いてよく、これらをCD−ROM、FD、磁気カード、磁気テープ、不揮発性メモリカード等を用いることができる。

【0105】

また、コンピュータ上で稼働しているOS等が処理の一部又は全部を行う場合、あるいは記憶媒体から読み出されたプログラムコードが、コンピュータに挿入された拡張機能ボードやコンピュータに接続された拡張機能ユニットに備わるメモリに書き込まれた後、そのプログラムコードの指示に基づいて、上記拡張機能ボードや拡張機能ユニットに備わるCPU等が処理の一部又は全部を行う場合にも、上記実施の形態と同等の機能を実現できると共に、同等の効果を得ることができ、本発明に含まれることは言うまでもない。

【0106】

【発明の効果】

以上説明したように、本発明によれば、画像の微細な部分である高周波成分を保持したまま、注目領域の画像を一定幅に圧縮、拡大することが可能であり、これにより、画像情報を有効に使うことができる効果がある。また、上記一定幅をフィルムなどの視認領域とすれば、フィルム上の視認領域の幅に注目領域を拡大縮小することができる効果がある。

【0107】

また、画像にす抜け領域がある場合に、す抜け領域を除去することにより、注目領域をさらに精度よく抽出することが可能であり、濃度値変換の精度が上がる効果がある。

【0108】

さらに、平滑化画像から最大値、最小値を抽出することにより、濃度値変換をより精度よく行うことができる効果がある。

【図面の簡単な説明】

【図1】第1の実施の形態に係る画像処理装置の構成を示すブロック図である。

【図2】第1の実施の形態での処理手順を示すフローチャートである。

【図3】入力画像と照射領域とす抜け領域とを除去した画像を示す構成図である。

【図4】第1の実施の形態での動作を説明するための特性図である。

【図5】第2の実施の形態に係る画像処理装置を適用したX線撮影装置の構成を示すブロック図である。

【図6】特徴量を抽出する領域を説明するための図である。

【図7】上記画像処理装置の第1の階調変換曲線の階調変換曲線を説明するための図である。

【図8】上記画像処理装置の第2の階調変換曲線の階調変換曲線を説明するための図である。

【図9】第2の実施の形態での処理手順を示すフローチャートである。

【符号の説明】

105 データ収集回路

108 CPU

109 メインメモリ

110 操作パネル

112 照射領域抽出回路

113 濃度値変換回路

113a す抜け削除回路

113b 最大最小値抽出回路

113c 平滑化画像作成回路

113d 高周波成分作成回路

113e 濃度値変換回路

112f 高周波成分足し込み回路[0001]

BACKGROUND OF THE INVENTION

The present invention relates to an image processing method having a dynamic range compression processing function for an image such as an X-ray image and a computer-readable storage medium.

[0002]

[Prior art]

For example, since an X-ray chest image is composed of an image of a lung field through which X-rays are easily transmitted and an image of a mediastinal portion through which X-rays are very difficult to transmit, the range in which pixel values exist is very wide. For this reason, it has been considered difficult to obtain an X-ray chest image capable of simultaneously observing both the lung field and the mediastinum.

[0003]

Therefore, as a method for avoiding this problem, there is a method described in “SPIE Vol. 626 Medicine XIV / PACS IV (1986)” (hereinafter referred to as “

S D = A [S org -S US ] + B [S US ] + C (1)

It is represented by the following formula (1).

[0004]

In the

[0005]

In addition, in the 2509503 patent publication, etc., the pixel value S after processing is described. D Original pixel value (input pixel value) S org , Having an average profile Py of the Y-direction profile and an average profile Px of the X-direction profile of the original image (input image),

S D = S org + F [G (Px, Py)] (2)

A method represented by the following formula (2) (hereinafter referred to as “method 2”) is described.

[0006]

Here, the characteristics of the function f (x) in the expression (2) will be described. First, f (x) is “0” when “x> Dth”, and f (x) when “0 ≦ x ≦ Dth”. ) Monotonously decreases with the intercept being “E” and the slope being “E / Dth”, and is expressed by the following equation (3).

if (x ≦ Dth) f (x) = E− (E / Dth) x

else f (x) = 0 (3)

“Px” and “Py” are

Py = (ΣPyi) / n (4)

Px = (ΣPxi) / n (5)

It is represented by the following formulas (4) and (5).

[0007]

In equations (4) and (5), “i” is “i = 1 to n”, “Pyi” and “Pxi” are profiles, and “G (Px, Py) in equation (2) ) ”

G (Px, Py) = max (Px, Py) (6)

Indicated by

[0008]

In the method 2 as described above, the density range equal to or lower than “Dth” in the pixel value of the low frequency image is compressed.

[0009]

In addition, the same method (hereinafter referred to as “Method 3”) as Method 2 (the method described in Patent Publication No. 2509503 Patent Gazette) is described in “The Journal of Japanese Society of Radiological Technology, Vol. 45, No. 8, Aug. 1989, page 1030, Abe et al. "It is described in. This method 3 uses the processed pixel value S D Original pixel value (input pixel value) S org , Average pixel value S when moving average of original image (input image) with mask size M × M pixels US Have a monotonically decreasing function f (x),

S D = S org + F (S US (7)

S US = ΣS org / M 2 .... (8)

It is represented by the following formulas (7) and (8).

[0010]

Method 3 is different from Method 2 represented by Expression (2) in that a low-frequency image is created. In Method 2, a low-frequency image is created using one-dimensional data, whereas a low-frequency image is created using two-dimensional data. This is a method of creating an image. According to the method 3 as described above, the density range equal to or lower than “Dth” is compressed as the pixel value of the low-frequency image.

[0011]

In addition, in the 2663189 patent publication and the like, the pixel value S after processing is described. D Original pixel value (input pixel value) S org , Average pixel value S when moving average of original image (input image) with mask size M × M pixels US Have a monotonically increasing function f1 (x),

S D = S org + F1 (S US (7)

S US = ΣS org / M 2 .... (8)

A method represented by the following formulas (7) and (8) (hereinafter referred to as “method 4”) is described.

[0012]

Here, the characteristics of the function f1 (x) in Expression (7) will be described. First, f (x) is “0” when “x <Dth”, and f (x) is “Dth ≦ x”. The intercept is “E” and the slope is “E / Dth”, which monotonously decreases, and is expressed by the following equation (11).

f1 [x] = E− (E / Dth) X (11)

[0013]

In the method 4 as described above, a pixel value (density value) equal to or higher than the pixel value Dth of the low-frequency image is compressed. The algorithm at this time is the same as method 3 (the method described in “Journal of Japanese Society of Radiological Technology, Vol. 45, No. 8, August 1989, page 1030, Abe et al.”).

[0014]

[Problems to be solved by the invention]

However, in the conventional method as described above, when the acquired image (input image) is subjected to gradation conversion and output to a film or CRT, attention after gradation conversion is applied to a range of density values or luminance values that cannot be visually confirmed. The object is to prevent the density value or luminance value of an area (subject area, etc.) from being applied.

[0015]

For this reason, in the conventional method, the compression start position and compression rate are fixed, and when the acquired image subjected to dynamic range compression is subjected to gradation conversion, the density value or luminance value of the attention area may not enter the viewing area. there were. This leads to problems that impede diagnosis and the like.

[0016]

Depending on the acquired image, the subject portion may be compressed more than necessary, and the amount of information originally held by the subject portion may be lost meaninglessly. This leads to a problem that the diagnostic ability and the like are lowered.

[0017]

Furthermore, since there was no idea of expanding the dynamic range, there was a problem that the dynamic range of the region of interest could not be output effectively when outputting an image on a film or CRT. That is, there was no idea of converting the dynamic range of the attention area into a predetermined area.

[0018]

The present invention has been made to solve the above-described problems, and an object thereof is to convert the dynamic range of a region of interest into a predetermined density region while maintaining the amplitude of a high-frequency component.

[0019]

[Means for Solving the Problems]

An image processing method of the present invention is an image processing method for performing gradation conversion processing and frequency processing on original image data, and a value for generating a gradation conversion curve from a region within a subject in the original image data. Extracting, generating a high-frequency component based on the original image data, changing the high-frequency component based on the slope of the gradation conversion curve, and image data based on the changed high-frequency wave component And a generating step.

The computer-readable storage medium of the present invention is a computer-readable storage medium recording a program for causing a computer to execute an image processing method for performing gradation conversion processing and frequency processing on original image data. Extracting a value for generating a gradation conversion curve from a region within the subject in the image data, generating a high-frequency component based on the original image data, and converting the high-frequency component into the gradation conversion curve. A program for causing a computer to execute a step of changing based on an inclination and a step of generating image data based on the changed high-frequency wave component is stored.

[0043]

DETAILED DESCRIPTION OF THE INVENTION

Embodiments of the present invention will be described below with reference to the drawings.

[0044]

(First embodiment)

FIG. 1 shows an

This

[0045]

The

[0046]

FIG. 2 is a flowchart showing a processing flow of the image processing apparatus.

FIG. 3A shows an input image, and FIG. 3B is a diagram in which an X-ray irradiation region and a through region (region through which X-rays pass) are deleted from the input image.

FIG. 4 is a diagram showing the relationship between the density range that can be visually recognized on the tone conversion curve and the density range of the attention area, where the horizontal axis represents the density value of the input image and the vertical axis represents the density value of the output image.

[0047]

In the

[0048]

First, the

[0049]

The

[0050]

In the density

[0051]

Next, the operation of the

The irradiation

[0052]

[Expression 1]

[0053]

Here, f (x, y) indicates image data, and f1 (x, y) indicates an image after deleting a void region and a body region that contacts the void region within a certain interval. Sgn (x, y) is expressed as the following equation (4). Th1 is a constant determined by experiments, and d1 and d2 are constants that determine the width for deleting the body region.

When sgn (x, y) = 0 f (x, y) ≧ Th1

sgn (x, y) = 1 Others (13).

FIG. 3B is an image in the case where the outside of the irradiation area and the omission area of the input image are replaced with 0.

[0054]

Next, the maximum / minimum

[0055]

[0056]

“D (x, y)” is a disk-shaped filter, and is selected according to the input image, with r1 being an arbitrary constant.

[0057]

The profile of fus (x, y) obtained here preserves the edge structure and does not cause overshoot and undershoot, which are disadvantages of conventional dynamic range compression.

[0058]

For the smoothed image, for example, the average density represented by the equation (17) may be used, or the following equation (19) may be used. Here, d is a constant.

[0059]

[Expression 2]

[0060]

Further, for example, a smoothed image may be created using a morphological filter such as Erosion, Dai1ation, Opening, or C1osing.

[0061]

Next, the high frequency component creation circuit 113c creates a high frequency image fh (x, y) from the input image f0 (x, y) and the smoothed image fus (x, y) according to the following equation (step S205). Next, the density

[0062]

In FIG. 4, Lightmax and Lightmin are the maximum and minimum density values that can be visually recognized, and correspond to d1 and d4. When the density value of the smoothed image is less than d1 from min (minimum value that the smoothed image can take),

[0063]

If d2 <Sus (x, y) ≦ d3,

[0064]

If d3 <Sus (x, y) ≦ max,

[0065]

Then, the high-frequency image fh (x, y) is added to the density-converted image Susuo (x, y) to obtain the final image fe (x, y) (step S207).

fe (x, y) = Susu0 (x, y) + fh (x, y) (23)

Finally, the obtained image fe (x, y) is subjected to gradation conversion by the

[0066]

In this embodiment, the case of an image having a void area has been described. However, when there is no void area, the maximum and minimum values are extracted from the image in the irradiation area without passing through the

[0067]

According to the present embodiment, it is possible to compress and enlarge an image of a region of interest to a certain width while retaining a high frequency component, and there is an effect that image information can be used effectively. Furthermore, if the fixed width is set as a visual recognition area such as a film, there is an effect that the attention area can be enlarged or reduced to the width of the visual recognition area on the film. In addition, when the maximum value and the minimum value are extracted from the smoothed image, there is an effect that the conversion by the density

[0068]

(Second Embodiment)

FIG. 5 shows a configuration of an

[0069]

The

[0070]

The

[0071]

The image processing circuit 612 calculates a range and change amount for changing the dynamic range from a

[0072]

The DRC circuit 612c adds a high-frequency component of the original image to the second

[0073]

FIG. 6 shows, for example, a region a from which a feature amount is extracted in an image (X-ray image) obtained when imaging is performed on the side surface of the cervical spine.

[0074]

FIG. 7 shows a gradation conversion curve of the first

[0075]

FIG. 8 shows a gradation conversion curve of the second

The gradation conversion curve a shown in FIG. 8 is composed only of linear components, and the gradation conversion curve b shown in FIG. 8 is composed of a gentle curve in which the differential value of the gradation conversion curve a is continuous. Yes.

[0076]

Here, in the

Therefore, the

[0077]

First, the X-ray generation circuit 601 emits an

[0078]

The

[0079]

The image processing circuit 612 operates as follows, for example, according to the flowchart shown in FIG.

[0080]

First, the

The feature amount extraction method here is different for each part of the subject in the input image f0 (x, y), and a plurality of methods have been proposed by the present applicant. For example, when the input image f0 (x, y) is an image obtained by photographing the cervical spine, the method described in Japanese Patent Application No. 10-272284 is used. This method is a method of calculating an average value of pixel values in the region indicated by “a” in FIG. 6 as the feature amount Sa.

[0081]

Next, a gradation conversion curve in the first

For example, as shown in FIG. 7, a gradation conversion curve is defined such that the pixel value of the feature value Sa is changed to a density value of 1.0.

[0082]

Next, the

[0083]

For example, a normal Japanese has a density value that can be visually recognized in an image in a range of a density value of 0.2 to 3.0.

Therefore, first, pixel values Sl and Sh that are to be converted to density values of 0.2 and 3.0 are calculated based on the gradation conversion curve defined in step S702.

Next, the width that does not change the dynamic range,

dl = Sa-hl (24)

dh = Sa + hh (25)

It calculates according to the formulas (24) and (25).

In Expressions (24) and (25), “hl” and “hh” are constants, and “dl” and “dh” are pixels serving as starting points for changing the dynamic range.

[0084]

Then, the amount of change Rl, Rh of the pixel value below “dl” and the pixel value above “dl”

Rl = (Sl−dl) / (Smin−dl) (26)

Rh = (Sh-dh) / (Smax-dh) (27)

It calculates according to the following formulas (26) and (27).

In Expressions (26) and (27), “Smin” and “Smax” indicate the minimum value and the maximum value among the pixel values of the subject area (target area). That is, when the dynamic range of pixel values less than or equal to dl is multiplied by R1, the pixel value Smin is changed to the pixel value S1. Similarly, the pixel value Smax is changed to the pixel value Sh. In other words, assuming that the starting points are dl and dh and the change amounts are Rl and Rh, the density value of the subject area after gradation conversion is that of the visual field area (for example, density value 0.2 to 3.0 here). Matches the width.

[0085]

As described above, by obtaining the change amounts Rl and Rh, even if the dynamic range is compressed, all of the attention area of the captured image can be reproduced on the output image. Therefore, the instability of feature extraction can be absorbed, and the diagnostic ability can be improved.

[0086]

In addition, as a constraint condition for the change amounts Rl and Rh,

Rl <Cl (28)

Rh <Ch (29)

Conditions as shown in the following equations (28) and (29) may be provided.

In the expressions (28) and (29), “Cl” and “Ch” each represent a constant. These constants Cl and Ch and the above-described constants hl and hh are constants determined experimentally for each part of the subject to be imaged, for example.

In this way, by providing the constraint condition, it is possible to prevent excessive compression, and thus it is possible to reliably prevent a deterioration in diagnostic ability due to excessive compression.

[0087]

As described above, when the pixels dl and dh as starting points for changing the dynamic range and the change amounts Rl and Rh are obtained, the second values as shown in FIG. 8 are obtained based on these dl, dh, Rl, and Rh. The gradation conversion curve of the

In the gradation conversion curve a shown in FIG. 8, the slope below the pixel value dl is “Rl”, the slope from the pixel value dl to the pixel value dh is “1”, and the slope above the pixel value dh is “ R h On the other hand, the gradation conversion curve b shown in FIG. 8 is also smoothed so that the differential value of the gradation conversion curve a becomes continuous by the technique described in Japanese Patent Application No. 11-762882. When the gradation conversion curve a is used as the gradation conversion curve of the second

[0088]

Next, the DRC circuit 612c selects whether or not to retain the high frequency component in the subsequent processing (step S704).

The result image obtained when the processing is executed without retaining the high frequency component is effective for diagnosing soft tissue or the like where the low frequency component is important. On the other hand, a result image obtained when processing is executed while holding a high-frequency component is effective when diagnosing a bone part, a lung field, or the like where the high-frequency component is important. That is, if the image to be processed is an image of a soft tissue or the like, select that the high frequency component is not retained, and if the image to be processed is an image of a bone or lung field, select to retain the high frequency component. As a result, a result image effective for diagnosis of soft tissue, bone, lung field, and the like can be obtained.

The selection in step S704 may be configured to be automatically selected based on the imaging region (soft tissue, bone, lung field, etc.), or may be configured to be manually selected by the user.

[0089]

If the high-frequency component is not retained as a result of the selection in step S704, the second

Then, the first

[0090]

Here, the coordinates of the input image (original image) are “x, y”, the pixel value of the original image is “f0 (x, y)”, and the gradation conversion curve b of the second

f2 (x, y) = F1 (F (f0 (x, y)) (30)

It is represented by the following formula (30).

In this case, “F1 (F (x)) may be considered as one gradation conversion curve.

[0091]

On the other hand, when the high frequency component is held as a result of the selection in step S704, first, the high frequency

fh (x, y) = f0 (x, y) −fus (x, y) (31)

This is calculated by the following equation (31) (step S705).

In Expression (31), “fus (x, y)” is a smoothed image, and has a constant d indicating the size of the mask size.

[0092]

[Equation 3]

[0093]

It is calculated by the following equation (32).

[0094]

Next, the second

f1 (x, y) = F (f0 (x, y)) (33)

Gradation conversion represented by the following equation (33) is performed, and the image f1 (x, y) after the gradation conversion is acquired (step S706).

[0095]

Next, the high frequency

[0096]

[Expression 4]

[0097]

It calculates with the type | formula (34) which becomes. As shown in the equation (34), the coefficient c (x) is a value obtained by subtracting “1” from the gradient of the gradation conversion curve b.

Then, based on the coefficient c (x), the image f1 (x, y) after the gradation conversion by the second

This is expressed by the following equation (35) (step S707).

[0098]

Then, with respect to the processed image f3 (x, y) obtained in step S707 by the first

f2 (x, y) = F1 (f3 (x, y)) (36)

Gradation conversion according to the following equation (36) is performed, and an image f2 (x, y) obtained as a result is obtained as a final image (step S709).

[0099]

Note that the smoothed image fus (x, y) in the equation (31) in step S705 may be calculated using, for example, the morphological operation represented by the following equations (37) to (41).

In Expressions (37) to (40), “D (x1, y1)” is a disk-shaped filter, and has an arbitrary constant r1 selected according to the input image,

It is represented by the following formula (41).

[0100]

The profile of the smoothed image fus (x, y) obtained by the equations (37) to (41) preserves the edge structure, and overshoot and undershoot, which are disadvantages of conventional dynamic range compression, occur. There is nothing.

[0101]

According to the present embodiment, the density distribution width of an arbitrary gradation region of the input image can be compressed and expanded, and the amplitude of the high-frequency component after gradation conversion is set to the high-frequency component of the image before gradation conversion. There is an effect that the amplitude can be maintained.

Also, since the dynamic range of the image is changed based on the pixel value determined by the gradation conversion curve, the dynamic range can be changed assuming the density value of the image after gradation conversion. The range can be adjusted uniquely.

[0102]

In addition, since the pixel value determined by the visibility limit is obtained from the gradation conversion curve, and the range and amount for changing the dynamic range can be determined based on the pixel value, the density value range of the pixel value in the region of interest can be set as the viewing range. There is an effect that can be done.

In addition, since the attention area is in the visual recognition area, it is possible to observe the entire attention area, which has the effect of improving the diagnostic ability.

Further, the attention area can be matched with the width of the visual recognition area, and the information amount of the attention area can be expressed to the maximum as the density value.

Also, since it has a range that does not change the dynamic range of the image, the pixel range that is important for diagnosis etc. is set as a region where the dynamic range is not changed, and it is expressed by the conventional density value, and there are also regions that could not be visually recognized in the past Since it can be observed as a concentration value, it has the effect of improving diagnostic ability.

In addition, since the high frequency component is retained in the dynamic range changing means, the amount of information of the high frequency component is not reduced, and the density value of the region that could not be visually recognized on the density value can be observed conventionally. effective.

[0103]

(Other embodiments)

The above-described embodiment may be realized in hardware or may be configured in software. For example, the configuration in the above-described embodiment is realized by realizing a program for executing the processing according to the flowchart shown in FIG. 2 or FIG. 9 using a computer system including a memory such as a CPU and a main memory. May be.

[0104]

As a storage medium for storing the program, a semiconductor memory such as a ROM or a RAM, an optical disk, a magneto-optical disk, a magnetic storage medium, or the like may be used. These may be a CD-ROM, an FD, a magnetic card, a magnetic tape, or a nonvolatile memory. A card etc. can be used.

[0105]

Further, when an OS or the like running on the computer performs part or all of the processing, or an extended function board in which a program code read from a storage medium is inserted into the computer or an extended function connected to the computer Even when the CPU or the like provided in the extension function board or extension function unit performs part or all of the processing based on the instruction of the program code after being written in the memory provided in the unit, it is equivalent to the above embodiment. It is needless to say that these functions can be realized, and equivalent effects can be obtained, which are included in the present invention.

[0106]

【The invention's effect】

As described above, according to the present invention, it is possible to compress and expand the image of the region of interest to a certain width while retaining the high-frequency component that is a fine part of the image. There is an effect that can be used effectively. Further, if the constant width is set as a visual recognition region such as a film, the attention region can be enlarged or reduced to the width of the visual recognition region on the film.

[0107]

In addition, when there is a void region in the image, it is possible to extract the region of interest more accurately by removing the void region, which has the effect of increasing the accuracy of density value conversion.

[0108]

Furthermore, there is an effect that density value conversion can be performed more accurately by extracting the maximum value and the minimum value from the smoothed image.

[Brief description of the drawings]

FIG. 1 is a block diagram illustrating a configuration of an image processing apparatus according to a first embodiment.

FIG. 2 is a flowchart showing a processing procedure in the first embodiment.

FIG. 3 is a configuration diagram illustrating an image from which an input image, an irradiation region, and a void region are removed.

FIG. 4 is a characteristic diagram for explaining an operation in the first embodiment;

FIG. 5 is a block diagram showing a configuration of an X-ray imaging apparatus to which an image processing apparatus according to a second embodiment is applied.

FIG. 6 is a diagram for explaining a region from which a feature amount is extracted.

FIG. 7 is a diagram for explaining a gradation conversion curve of a first gradation conversion curve of the image processing apparatus.

FIG. 8 is a diagram for explaining a gradation conversion curve of a second gradation conversion curve of the image processing apparatus.

FIG. 9 is a flowchart showing a processing procedure in the second embodiment;

[Explanation of symbols]

105 Data collection circuit

108 CPU

109 Main memory

110 Operation panel

112 Irradiation area extraction circuit

113 Density value conversion circuit

113a Through hole deletion circuit

113b Maximum and minimum value extraction circuit

113c Smoothed image creation circuit

113d High frequency component creation circuit

113e Density value conversion circuit

112f High frequency component addition circuit

Claims (5)

前記原画像データにおける被写体内の領域から、階調変換曲線を生成するための値を抽出する工程と、

前記原画像データに基づく高周波成分を生成する工程と、

前記高周波成分を、前記階調変換曲線の傾きに基づいて変更する工程と、

前記変更した高周波波成分に基づき画像データを生成する工程とを備えることを特徴とする画像処理方法。An image processing method for performing gradation conversion processing and frequency processing on original image data,

Extracting a value for generating a gradation conversion curve from a region in the subject in the original image data;

Generating a high frequency component based on the original image data;

Changing the high-frequency component based on the slope of the gradation conversion curve;

And a step of generating image data based on the changed high-frequency wave component.

前記原画像データにおける被写体内の領域から、階調変換曲線を生成するための値を抽出する工程と、

前記原画像データに基づく高周波成分を生成する工程と、

前記高周波成分を、前記階調変換曲線の傾きに基づいて変更する工程と、

前記変更した高周波波成分に基づき画像データを生成する工程とをコンピュータに実行させるためのプログラムを記憶したコンピュータ読み取り可能な記憶媒体。A computer-readable storage medium storing a program for causing a computer to execute an image processing method for performing gradation conversion processing and frequency processing on original image data,

Extracting a value for generating a gradation conversion curve from a region in the subject in the original image data;

Generating a high frequency component based on the original image data;

Changing the high-frequency component based on the slope of the gradation conversion curve;

A computer-readable storage medium storing a program for causing a computer to execute the step of generating image data based on the changed high-frequency wave component.

Priority Applications (4)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP25418499A JP3937660B2 (en) | 1998-09-18 | 1999-09-08 | Image processing method and computer-readable storage medium |

| US09/396,740 US7050648B1 (en) | 1998-09-18 | 1999-09-15 | Image processing apparatus, image processing method, and recording medium |

| US10/912,129 US7564582B2 (en) | 1998-09-18 | 2004-08-06 | Image processing apparatus, image processing method, and recording medium |

| US11/146,054 US7636495B2 (en) | 1998-09-18 | 2005-06-07 | Image processing apparatus, image processing method, and recording medium |

Applications Claiming Priority (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP10-265354 | 1998-09-18 | ||

| JP26535498 | 1998-09-18 | ||

| JP25418499A JP3937660B2 (en) | 1998-09-18 | 1999-09-08 | Image processing method and computer-readable storage medium |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2000155838A JP2000155838A (en) | 2000-06-06 |

| JP2000155838A5 JP2000155838A5 (en) | 2005-07-28 |

| JP3937660B2 true JP3937660B2 (en) | 2007-06-27 |

Family

ID=26541570

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP25418499A Expired - Fee Related JP3937660B2 (en) | 1998-09-18 | 1999-09-08 | Image processing method and computer-readable storage medium |

Country Status (1)

| Country | Link |

|---|---|

| JP (1) | JP3937660B2 (en) |

Families Citing this family (7)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP4634591B2 (en) * | 2000-09-29 | 2011-02-16 | 株式会社東芝 | X-ray diagnostic equipment |

| JP2004030596A (en) * | 2002-05-10 | 2004-01-29 | Canon Inc | Image gradation conversion method, image gradation conversion apparatus, system, program, and storage medium |

| JP4626138B2 (en) * | 2003-09-30 | 2011-02-02 | コニカミノルタエムジー株式会社 | Image processing apparatus, image processing method, and program |

| JP2010015607A (en) * | 2003-11-05 | 2010-01-21 | Seiko Epson Corp | Image processing apparatus and image processing method |

| JP2010256536A (en) * | 2009-04-23 | 2010-11-11 | Sharp Corp | Image processing device and image display device |

| JP6071805B2 (en) * | 2013-08-27 | 2017-02-01 | 富士フイルム株式会社 | Image area designating apparatus and method, and radiation image processing apparatus and method |

| JP6146907B2 (en) | 2013-09-30 | 2017-06-14 | 富士フイルム株式会社 | Image processing apparatus and method |

Family Cites Families (13)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2631663B2 (en) * | 1987-08-20 | 1997-07-16 | 富士写真フイルム株式会社 | Desired image signal range determination method |

| JP2835954B2 (en) * | 1988-05-16 | 1998-12-14 | 株式会社日立メディコ | Image processing method and apparatus |

| JP2892677B2 (en) * | 1989-04-17 | 1999-05-17 | 株式会社日立製作所 | Image processing method |

| JP2849964B2 (en) * | 1991-12-26 | 1999-01-27 | 富士写真フイルム株式会社 | Image processing method and apparatus |

| JP2509503B2 (en) * | 1992-09-11 | 1996-06-19 | コニカ株式会社 | Image processing method and apparatus |

| JP3434532B2 (en) * | 1993-04-01 | 2003-08-11 | コニカ株式会社 | Dynamic range compression method for radiographic images |

| JP3425780B2 (en) * | 1993-03-30 | 2003-07-14 | コニカ株式会社 | Dynamic range compression method for radiographic images |

| JPH06292008A (en) * | 1993-04-01 | 1994-10-18 | Konica Corp | Dynamic range compression processing unit for radiation picture |

| JP3467285B2 (en) * | 1993-04-02 | 2003-11-17 | コニカミノルタホールディングス株式会社 | Radiation image processing method |

| JP3455566B2 (en) * | 1993-07-22 | 2003-10-14 | コニカミノルタホールディングス株式会社 | Dynamic range compression method for radiographic images |

| JP3738788B2 (en) * | 1995-09-29 | 2006-01-25 | 富士写真フイルム株式会社 | Image dynamic range compression processing method and apparatus |

| JPH0998293A (en) * | 1995-09-29 | 1997-04-08 | Fuji Photo Film Co Ltd | Image processing method and device |

| JP3700804B2 (en) * | 1996-12-13 | 2005-09-28 | 富士写真フイルム株式会社 | Image processing method and apparatus |

-

1999

- 1999-09-08 JP JP25418499A patent/JP3937660B2/en not_active Expired - Fee Related

Also Published As

| Publication number | Publication date |

|---|---|

| JP2000155838A (en) | 2000-06-06 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| US6813335B2 (en) | Image processing apparatus, image processing system, image processing method, program, and storage medium | |

| EP1339018B1 (en) | Image processing device, image processing method, recording medium and program | |

| US7564582B2 (en) | Image processing apparatus, image processing method, and recording medium | |

| JP3733260B2 (en) | Image processing apparatus and image processing method | |

| JP4486784B2 (en) | Noise reduction method | |

| JP3937660B2 (en) | Image processing method and computer-readable storage medium | |

| JP2003283927A (en) | Method for enhancing contrast of image | |

| US20030210831A1 (en) | Gradation conversion processing | |

| WO2000032016A2 (en) | Method for automatic detection of region of interest for digital x-ray detectors using a filtered histogram | |

| US7418122B2 (en) | Image processing apparatus and method | |

| JP4146958B2 (en) | Image processing method, image processing apparatus, and storage medium | |

| JP3814421B2 (en) | Image processing apparatus, method, and computer-readable storage medium | |

| US20060008131A1 (en) | Image processing method, apparatus and program | |

| JP2000101840A (en) | Image processor, its method and computer readable storage medium | |

| JP4497756B2 (en) | Image processing apparatus, image processing system, image processing method, storage medium, and program | |

| JP4323708B2 (en) | Image processing method, image processing apparatus, and recording medium | |

| JP3937616B2 (en) | Image processing apparatus, method, and computer-readable storage medium | |

| JP3937607B2 (en) | Image processing apparatus, method, and computer-readable storage medium | |

| JPH1141541A (en) | Image processing method, image processing unit, image collection device and image processing system | |

| JP4612774B2 (en) | Image processing apparatus, image processing system, image processing method, storage medium, and program | |

| JP2002330953A (en) | Image processing apparatus, image processing system, image processing method, storage medium, and program | |

| JP4810002B2 (en) | Image processing apparatus, image processing system, image processing method, storage medium, and program | |

| JP4669163B2 (en) | Image processing apparatus, image processing system, image processing method, storage medium, and program | |

| JP2000324341A (en) | Picture processor, system therefor, its method and storage medium | |

| JP2003283926A (en) | Method for normalizing digital signal representation of image |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20041214 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20041214 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20070126 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20070130 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20070213 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20070306 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20070319 |

|

| R150 | Certificate of patent or registration of utility model |

Free format text: JAPANESE INTERMEDIATE CODE: R150 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20110406 Year of fee payment: 4 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20120406 Year of fee payment: 5 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20130406 Year of fee payment: 6 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20130406 Year of fee payment: 6 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20140406 Year of fee payment: 7 |

|

| LAPS | Cancellation because of no payment of annual fees |