JP2020523668A - 仮想カメラを構成するシステム及び方法 - Google Patents

仮想カメラを構成するシステム及び方法 Download PDFInfo

- Publication number

- JP2020523668A JP2020523668A JP2019565904A JP2019565904A JP2020523668A JP 2020523668 A JP2020523668 A JP 2020523668A JP 2019565904 A JP2019565904 A JP 2019565904A JP 2019565904 A JP2019565904 A JP 2019565904A JP 2020523668 A JP2020523668 A JP 2020523668A

- Authority

- JP

- Japan

- Prior art keywords

- virtual camera

- movement

- display area

- interface

- gesture

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Withdrawn

Links

Images

Classifications

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N5/00—Details of television systems

- H04N5/222—Studio circuitry; Studio devices; Studio equipment

- H04N5/262—Studio circuits, e.g. for mixing, switching-over, change of character of image, other special effects ; Cameras specially adapted for the electronic generation of special effects

- H04N5/2628—Alteration of picture size, shape, position or orientation, e.g. zooming, rotation, rolling, perspective, translation

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/011—Arrangements for interaction with the human body, e.g. for user immersion in virtual reality

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/048—Interaction techniques based on graphical user interfaces [GUI]

- G06F3/0484—Interaction techniques based on graphical user interfaces [GUI] for the control of specific functions or operations, e.g. selecting or manipulating an object, an image or a displayed text element, setting a parameter value or selecting a range

- G06F3/04847—Interaction techniques to control parameter settings, e.g. interaction with sliders or dials

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/048—Interaction techniques based on graphical user interfaces [GUI]

- G06F3/0487—Interaction techniques based on graphical user interfaces [GUI] using specific features provided by the input device, e.g. functions controlled by the rotation of a mouse with dual sensing arrangements, or of the nature of the input device, e.g. tap gestures based on pressure sensed by a digitiser

- G06F3/0488—Interaction techniques based on graphical user interfaces [GUI] using specific features provided by the input device, e.g. functions controlled by the rotation of a mouse with dual sensing arrangements, or of the nature of the input device, e.g. tap gestures based on pressure sensed by a digitiser using a touch-screen or digitiser, e.g. input of commands through traced gestures

- G06F3/04883—Interaction techniques based on graphical user interfaces [GUI] using specific features provided by the input device, e.g. functions controlled by the rotation of a mouse with dual sensing arrangements, or of the nature of the input device, e.g. tap gestures based on pressure sensed by a digitiser using a touch-screen or digitiser, e.g. input of commands through traced gestures for inputting data by handwriting, e.g. gesture or text

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T15/00—3D [Three Dimensional] image rendering

- G06T15/10—Geometric effects

- G06T15/20—Perspective computation

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T19/00—Manipulating 3D models or images for computer graphics

Landscapes

- Engineering & Computer Science (AREA)

- Theoretical Computer Science (AREA)

- Physics & Mathematics (AREA)

- General Engineering & Computer Science (AREA)

- General Physics & Mathematics (AREA)

- Human Computer Interaction (AREA)

- Computer Graphics (AREA)

- Multimedia (AREA)

- Computing Systems (AREA)

- Geometry (AREA)

- Signal Processing (AREA)

- Computer Hardware Design (AREA)

- Software Systems (AREA)

- User Interface Of Digital Computer (AREA)

- Processing Or Creating Images (AREA)

Abstract

仮想カメラを構成するコンピュータ実施方法。この方法は、第1の表示領域に表示されるシーンの描写における位置を特定するポインティング操作を、電子デバイスのインターフェースにおいて受信することと、上記特定の操作の位置から遠ざかる連続した動きを含む、第1の表示領域における更なる操作を、インターフェースにおいて受信することとを含む。この方法は、ポインティング操作の位置及び少なくとも更なる操作の方向に基づいて仮想カメラを構成することを更に含み、構成された仮想カメラに対応する画像は、第1の表示領域と異なる第2の表示領域に表示される。【選択図】図1

Description

本発明は、仮想カメラの制御に関し、特に、インタラクション手段を通じた仮想カメラビューの生成及び仮想カメラ設定の制御に関する。

画像ベースレンダリングは、カメラ画像の集合体からの仮想視点の合成を可能にする。例えば、被写体が環状に並んだ物理カメラによって取り囲まれた配置では、カメラ構成及び物理カメラによってキャプチャーされたシーンの十分な知識が利用可能である場合に、(物理カメラ)キャプチャービューの間の位置に対応する被写体の新たな(仮想カメラ)ビューを、キャプチャービュー又はビデオストリームから合成することができる。

近時、任意の視点を合成する能力が、「自由視点」ビデオを目的として推進されてきた。「自由視点」ビデオでは、視聴者は、ビデオキャプチャーシステムの制約内でカメラ視点を自身の好みに能動的に調整することができる。或いは、ビデオ制作者又はカメラマンは、自由視点技術を用いて、受動的な放送視聴者の視点を構築することができる。スポーツ放送の場合、制作者又はカメラマンは、スポーツのライブ放送中に該当する視点をキャプチャーするために、正確かつタイムリーな方法で仮想カメラ視点を構築する役割を負う。

3D Studio Max等の製品コンセプト開発及びレンダリングに用いられる3Dモデリングソフトウェアにおいて使用される方法のような、仮想環境内に仮想カメラを位置決めする業界標準方法が存在する。3D Studio Max等のシステムでは、仮想カメラは、仮想カメラ、仮想カメラの視線、又は仮想カメラ及び仮想カメラの視線の双方を選択し、移動させ、ドラッグすることによって構成される。カメラの移動は、3D世界が視認される角度を変更することによって、3D位置決めウィジェット(例えば、3D Studio MaxにおけるGizmo)を用いることによって、又はユーザインターフェース(UI)における制約をアクティブ化すること、例えば、アクティブ平面を選択することによって制約することができる。3D Studio Max等のシステムでは、3D環境において、マウスによってクリック及びドラッグして、カメラの位置及び視線(向き)の双方を設定することが可能である。一方、視野又は焦点距離等の他のカメラ設定値の編集は、ユーザインターフェース制御を用いて行われる。

ケーブルカム及びドローンベースカメラのリモート制御のような実世界において物理カメラを移動させる方法も知られている。これらのリモート制御を伴う方法は、仮想環境又は実環境において仮想カメラを構成するのに用いることができる。ケーブルカム及びドローンカメラを構成することは、1つ以上のジョイスティック又は他のハードウェアコントローラを用いてカメラの位置及び視点を変更することを伴う。ケーブルカム及びドローンシステムは、カメラを正確に位置決めすることができるが、カメラ(複数の場合もある)を位置にナビゲートするのに時間を要するので、高速に位置決めすることができない。ナビゲーションを原因とするこの遅延によって、リモート制御システムは、多くの場合に速いペースで進行し得るスポーツフィールド、競技フィールド、又はスタジアム上でのアクションに対する応答性が低下する。ズーム(視野)、焦点距離(焦点)等の他のカメラ設定の変更は、「ズームロッカー」又は「フォーカスホイール」等の他のハードウェアコントローラを同時に操作することによって達成される。これらのハードウェアコントローラの操作には、多くの場合、両手が必要とされ、時に2人のオペレーター(4つの手)が必要とされることもあり、多くの時間を要する。

仮想カメラを構成する別の既知の方法は、1つのフリーエアー(free air)ジェスチャーを用いて、カメラの位置及び向きの双方を設定するものである。このフリーエアージェスチャーは、空中で指を用いて対象物体を円形に囲むと同時にその指を対象物体に向けて指差すことを伴う。フリーエアージェスチャーは、2つの仮想カメラ設定値を同時に設定する。しかしながら、フリーエアージェスチャー方法は、仮想カメラの他の設定値を設定するのに、フリーエアージェスチャー及びその後のジェスチャー又はインタラクションの双方を必要とする。

上述のカメラ制御インタラクションは、通常、スポーツ放送等の用途には不適切である。なぜならば、上述のインタラクション及びシステムを用いたカメラナビゲーションは、比較的多くの時間を要するからである。仮想カメラ制御においては、正確かつタイムリーな方法で仮想カメラビューを生成及び制御する方法について、満たされていない要求が存在する。

本発明の目的は、現在の構成の少なくとも1つの不利点を実質的に克服するか又は少なくとも改善することである。

本開示の1つの態様は、仮想カメラを構成する、コンピュータによって実行される方法であって、第1の表示領域に表示されるシーンの描写における位置を特定するポインティング操作を、電子デバイスのインターフェースにおいて受信することと、前記ポインティング操作の前記位置から遠ざかる連続した動きを含む、前記第1の表示領域における更なる操作を、前記インターフェースにおいて受信することと、前記ポインティング操作の前記位置及び少なくとも前記更なる操作の方向に基づいて仮想カメラを構成することとを含み、前記構成された仮想カメラに対応する画像は、前記第1の表示領域と異なる第2の表示領域に表示される、方法を提供する。

本開示の別の態様は、仮想カメラを構成するコンピュータプログラムが記憶された非一時的コンピュータ可読媒体であって、前記プログラムは、第1の表示領域に表示されるシーンの描写における位置を特定するポインティング操作を、電子デバイスのインターフェースにおいて受信するコードと、前記ポインティング操作の前記位置から遠ざかる連続した動きを含む、前記第1の表示領域における更なる操作を、前記インターフェースにおいて受信するコードと、前記ポインティング操作の前記位置及び少なくとも前記更なる操作の方向に基づいて仮想カメラを構成し、該構成された仮想カメラに対応する画像を前記第1の表示領域と異なる第2の表示領域に表示するコードとを含む、非一時的コンピュータ可読媒体を提供する。

本開示の別の態様は、インターフェースと、ディスプレイと、メモリと、仮想カメラを構成する方法を実施する、前記メモリに記憶されたコードを実行するように構成されたプロセッサとを備えるシステムであって、前記方法は、第1の表示領域に表示されるシーンの描写における位置を特定するポインティング操作を、前記インターフェースにおいて受信することと、前記ポインティング操作の前記位置から遠ざかる連続した動きを含む、前記第1の表示領域における更なる操作を、前記インターフェースにおいて受信することと、前記ポインティング操作の前記位置及び少なくとも前記更なる操作の方向に基づいて前記仮想カメラを構成することとを含み、前記構成された仮想カメラに対応する画像は、前記第1の表示領域と異なる第2の表示領域に表示される、システムを提供する。

本開示の別の態様は、仮想カメラを構成するように適合されるタブレットデバイスであって、タッチスクリーンと、メモリと、プロセッサであって、前記タッチスクリーンの第1の領域にシーンのビデオ描写を表示することと、前記第1の領域内の前記シーンにおける位置を特定するポインティング操作を、前記タッチスクリーンにおいて受信することと、前記位置から遠ざかる連続した動きを含む、前記第1の領域における更なる操作を、前記タッチスクリーンにおいて受信することと、前記ポインティング操作の前記位置及び少なくとも前記更なる操作の方向に基づいて前記仮想カメラを構成することと、前記構成された仮想カメラに対応する画像を、前記第1の領域と異なる前記タッチスクリーンの第2の領域に表示することとを行う、前記メモリに記憶されたコードを実行するように構成されたプロセッサとを備える、タブレットデバイスを提供する。

本開示の別の態様は、仮想カメラを構成する、コンピュータによって実行される方法であって、電子デバイスによって表示される競技フィールドの描写における位置での初期タッチを、前記電子デバイスのインターフェースにおいて受信することと、前記初期タッチの前記位置から遠ざかる、前記初期タッチからの連続した動きである第1の動きの方向を、前記インターフェースを介して特定することと、前記第1の動きからの連続した動きである、前記第1の動きの前記受信された方向から遠ざかる第2の動きの長さを、前記インターフェースを介して特定することと、前記第1の動きの前記特定された方向に基づく向きと、前記第2の動きの前記特定された長さに基づく視野とを有する前記仮想カメラを、前記競技フィールドにおける前記初期タッチの前記位置に生成することとを含む、方法を提供する。

幾つかの態様では、前記インターフェースはタッチスクリーンであり、前記第1の動き及び前記第2の動きのそれぞれは、前記タッチスクリーンに適用されるスワイプジェスチャーである。

幾つかの態様では、前記方法は、前記第1の動きに対する前記第2の動きの角度を求めることと、該角度に基づいて前記仮想カメラの範囲を求めることとを更に含む。

幾つかの態様では、前記角度は所定の閾値内にある。

幾つかの態様では、前記方法は、前記仮想カメラの前記視野内の物体を判断することと、該検出された物体を強調表示することとを更に含む。

幾つかの態様では、前記初期タッチの前記位置は、前記競技フィールド内の物体の位置であると判断され、前記仮想カメラは、前記物体が前記競技フィールドを動き回るとき、前記物体に関する位置を保持するように構成される。

幾つかの態様では、前記物体はプレーヤーであり、前記仮想カメラは、前記人の視点を追跡するように構成される。

幾つかの態様では、前記第1の動きは、前記競技フィールド上の物体上で終了し、前記仮想カメラは、前記物体を追跡するように生成される。

幾つかの態様では、前記仮想カメラは、前記初期タッチの持続時間に基づく高さを有するように生成される。

幾つかの態様では、前記インターフェースはホバーセンサを備え、前記初期タッチはホバージェスチャーであり、前記仮想カメラの高さは、前記ホバージェスチャーの高さに基づいて求められる。

幾つかの態様では、前記インターフェースはタッチスクリーンであり、前記仮想カメラの高さは、前記初期タッチの間に前記タッチスクリーンに印加される圧力を用いて求められる。

幾つかの態様では、前記第2の動きが、前記第1の動きの軌道に沿ってトレースバックする場合、前記仮想カメラは、前記第2の動きの前記求められた長さに基づく被写界深度を有するように構成される。

幾つかの態様では、前記方法は、前記競技フィールド上の前記位置における更なるタッチジェスチャーを前記インターフェースにおいて検出することと、前記初期タッチジェスチャーを示すもの、前記第1の動き及び前記第2の動きを表示することと、前記第1の動き及び前記第2の動きのうちの一方を更新するジェスチャーを受信して前記仮想カメラを更新することとを更に含む。

幾つかの態様では、前記初期タッチが、前記競技フィールド内の物体の位置におけるものであり、前記第2の動きが、前記第1の動きに対して、2つの所定の閾値の間の角度にある場合、前記仮想カメラは、前記物体を周回するように生成される。

幾つかの態様では、前記第1の動きジェスチャーの長さは、前記物体に対する前記仮想カメラの軌道経路の半径を求めるのに用いられる。

本開示の別の態様は、仮想カメラを構成するコンピュータプログラムが記憶された非一時的コンピュータ可読媒体であって、前記プログラムは、電子デバイスによって表示される競技フィールドの描写における位置での初期タッチを、前記電子デバイスのインターフェースにおいて受信するコードと、前記初期タッチの前記位置から遠ざかる、前記初期タッチからの連続した動きである第1の動きの方向を、前記インターフェースを介して特定するコードと、前記第1の動きからの連続した動きである、前記第1の動きの前記受信された方向から遠ざかる第2の動きの長さを、前記インターフェースを介して特定するコードと、前記第1の動きの前記特定された方向に基づく向きと、前記第2の動きの前記特定された長さに基づく視野とを有する前記仮想カメラを、前記競技フィールドにおける前記初期タッチの前記位置に生成するコードとを含む、非一時的コンピュータ可読媒体を提供する。

本開示の別の態様は、インターフェースと、ディスプレイと、メモリと、プロセッサとを備えるシステムであって、前記プロセッサは、仮想カメラを構成する方法を実施する、前記メモリに記憶されたコードを実行するように構成され、前記方法は、ディスプレイ上に表示される競技フィールドの描写における位置での初期プレスタッチを、前記インターフェースにおいて受信することと、前記初期タッチの前記位置から遠ざかる、前記初期タッチからの連続した動きである第1の動きの方向を、前記インターフェースを介して特定することと、前記第1の動きからの連続した動きである、前記第1の動きの前記受信された方向から遠ざかる第2の動きの長さを、前記インターフェースを介して特定することと、前記第1の動きの前記特定されて受信された方向に基づく向きと、前記第2の動きの前記特定されて受信された長さに基づく視野とを有する前記競技フィールド内の前記仮想カメラを、前記競技フィールドにおける前記初期タッチの前記位置に生成することとを含む、システムを提供する。

本開示の別の態様は、仮想カメラを構成するように適合されるタブレットデバイスであって、タッチスクリーンと、メモリと、プロセッサであって、競技フィールドのビデオ描写を前記タッチスクリーン上に表示することと、前記競技フィールドの前記描写における位置での初期タッチを前記タッチスクリーンにおいて受信することと、前記初期タッチからの連続した動きである、前記初期タッチの前記位置から遠ざかる第1の動きの方向を、前記タッチスクリーンを介して特定することと、前記第1の動きからの連続した動きである、前記第1の動きの前記受信された方向から遠ざかる第2の動きの長さを、前記タッチスクリーンを介して特定することと、前記第1の動きの前記特定された方向に基づく向きと、前記第2の動きの前記特定された長さに基づく視野とを有する仮想カメラを、前記競技フィールドにおける前記初期タッチの前記位置に生成することとを行う、前記メモリに記憶されたコードを実行するように構成されたプロセッサとを備える、タブレットデバイスを提供する。

次に、本発明の1つ以上の例示の実施形態を以下の図面を参照して説明する。

上述したように、仮想カメラビューを生成及び制御する既知の方法は、ライブスポーツ放送等の相対的に高速の仮想カメラ構成を必要とする用途には適していないことが多い。

本明細書に記載のシステムでは、仮想カメラの特性の定義は、ユーザがタッチスクリーン等のインターフェースを用いてジェスチャーを行うことによって実現される。ジェスチャーの属性が、仮想カメラの複数の特性を定義する。ジェスチャーによって、応答型仮想スポーツ放送システムによって必要とされるタイムフレーム内で仮想カメラを構成することが可能になる。

本明細書に記載の方法は、図1に示すようなスポーツフィールド又は同様のパフォーマンスフィールドであるパフォーマンス競技場の状況において用いられることを意図している。システム100は、ほぼ長方形、長円形又は円形の実際の物理的な競技フィールドが中心にあると仮定される競技場110を含む。フィールド110のこの形状によって、1つ以上の環状に並んだ物理カメラ120A〜120Xによってフィールド110を取り囲むことが可能になる。例示の構成100では、競技場110はフィールドである。ただし、他の構成では、競技場110は、音楽ステージ、シアター、一般の会場若しくは私有の会場、又は物理カメラ及び既知の空間レイアウトの同様の構成を有する任意の会場とすることができる。例えば、本明細書に記載の構成は、鉄道駅プラットフォーム等の競技場における監視に用いることもできる。

フィールド110は、図1の例では、物体140を含む。物体140のそれぞれは、フィールド110上の人、ボール、車両又は任意の構造物とすることができる。カメラ120A〜120Xは、同時刻にフレームを取得するように同期され、フィールド110上の全ての地点が多数の視点から同時にキャプチャーされるようになっている。幾つかの変形形態では、環状に並んだカメラ全てが用いられるわけではなく、逆に、全周の幾つかのサブセットが用いられる。全周のサブセットを用いる構成は、幾つかの特定の視点が事前に不要であると分かっているときに有利であり得る。

カメラ120A〜120Xによってキャプチャーされたビデオフレームは、ネットワーク接続921を介してビデオ処理ユニット905に利用可能にされる前に、カメラ120A-120Xの近くで処理されて一時的に記憶される。ビデオ処理ユニット905は、仮想カメラ150の位置、向き、ズーム及び場合によっては他のシミュレーションされたカメラ特徴を指定する制御入力をコントローラ180のインターフェースから受信する。仮想カメラ150は、カメラ120A〜120Xから受信されたビデオデータから生成された位置、方向及び視野を表す。コントローラ180は、ユーザからの入力(スクリーンタッチ又はマウスクリック等)を認識する。ユーザからのタッチ入力の認識は、容量検出、抵抗検出、コンダクタンス検出、ビジョン検出等の幾つかの異なる技術を通じて行うことができる。ビデオ処理ユニット905は、当該ユニット905に利用可能なビデオストリームに基づいて、指定された仮想カメラ透視ビュー190を合成し、合成透視画をディスプレイ端末914上に表示するように構成されている。仮想カメラ透視ビュー190は、仮想カメラ150がキャプチャーするビデオビューに関するものである。ディスプレイ端末914は、様々な構成体、例えば、タッチスクリーンディスプレイ、LEDモニター、投影ディスプレイ又は仮想現実ヘッドセットのうちの1つとすることができる。ディスプレイ端末914がタッチスクリーンである場合、ディスプレイ端末914は、コントローラ180のインターフェースも提供することができる。仮想カメラ透視ビュー190は、仮想カメラ150の生成から得られるビデオデータのフレームを表す。

「仮想カメラ」は、仮想カメラの機能が、カメラの間の補間等の方法によって、又は、単に任意の単一の物理カメラの出力ではなく、シーン(フィールド110等)を取り囲む多くのカメラ(カメラ120A〜120X等)からのデータを用いて構築された仮想モデル化された3Dシーンからのレンダリングによって計算的に導出されるものであることから仮想と呼ばれる。

仮想カメラ位置の入力は、人間の仮想カメラオペレーターが既知の構成において生成することができ、ジョイスティック、マウス、又は複数の入力構成要素を備える専用コントローラを含む同様のコントローラ等のユーザインターフェースデバイスからの入力に基づくことができる。代替的に、仮想カメラ位置は、ゲームプレーの解析に基づいて完全自動で生成することができる。カメラの位置決めの幾つかの態様が人間のオペレーターによって指示され、それ以外が自動化アルゴリズムによって指示されるハイブリッド制御構成も可能である。後者の例は、粗い位置決めが人間のオペレーターによって行われ、安定化及び経路平滑化を含む微細な位置決めが自動化アルゴリズムによって行われる場合を含む。

ビデオ処理ユニット905は、当該技術において知られている画像ベースレンダリング方法を用いてフレーム合成を実現する。これらのレンダリング方法は、既知の幾何学的配置の一組のカメラ120A〜120Xからのピクセルデータをサンプリングすることに基づいている。レンダリング方法は、サンプリングされたピクセルデータ情報を合成フレームに組み合わせる。要求されたフレームのサンプルベースレンダリングに加えて、ビデオ処理ユニット905は、必要に応じて、サンプリング欠陥をカバーして高品質の視覚的外観のフレームを作成する領域の合成、3Dモデリング、インペインティング又は補間も行うことができる。カメラ位置制御信号を生成するデバイスが、処理システムの実用的限界を認識することができるように、プロセッサ905は、フレーム品質又は要求された視点のカメラカバレッジの完全性の形でフィードバックも提供することができる。ビデオ処理ユニット905によって作成された一例示のビデオビュー190は、その後、カメラ120A〜120Xから受信されたビデオストリームを合わせて編集して放送ビデオを形成することができる制作デスク(図示せず)に提供することができる。代替的に、仮想カメラ透視ビュー190は、未編集のまま放送することもできるし、後の編纂に備えて記憶することもできる。

プロセッサ905は、通常、カメラ120A〜120Xによってキャプチャされたビデオデータに対して物体検出及び物体追跡を含む画像解析を行うようにも構成されている。特に、ビデオ処理ユニット905は、仮想カメラ視野内の物体を検出及び追跡するのに用いることができる。代替の構成では、フィールド110内の物体140は、物体に取り付けられたセンサ、例えば、プレーヤー又はボールに取り付けられたセンサを用いて追跡することができる。

上述の図1のコンピュータを用いたビデオキャプチャーシステムによって与えられる柔軟性は、物理カメラを用いるライブビデオカバレッジにおいて事前に予想されていなかった副次的な一組の問題を提示する。特に、上述したように、スポーツフィールド上のどの場所においてもフィールド上のアクションに応答していつでも仮想カメラを生成する方法における問題が特定されている。

図9A及び図9Bは、説明される方法が望ましく実施される、組み込み構成要素を備える汎用電子デバイス901の集約的な形式での概略ブロック図を示している。本明細書に記載の構成では、図1のコントローラ180は、タブレットデバイスである電子デバイス901と一体化している。他の構成では、コントローラ180は、ビデオ処理ユニット905(例えば、クラウドサーバ)に対する別個のデバイス(例えば、タブレット)の一部を形成することができ、これらの別個のデバイスは、インターネット等のネットワークを介して通信する。

電子デバイス901は、例えば、処理リソースが限られているモバイルフォン又はタブレットとすることができる。それにもかかわらず、説明される方法は、デスクトップコンピュータ、サーバコンピュータ、及び非常に大きな処理リソースを有する他のそのようなデバイス等のより高レベルのデバイス上でも実行することができる。

図9Aに見られるように、電子デバイス901は、組み込みコントローラ902を備える。したがって、電子デバイス901は、「組み込みデバイス」と呼ばれる場合がある。本例では、コントローラ902は、内部記憶モジュール909に双方向結合された処理ユニット(又はプロセッサ)905を有する。内部記憶モジュール909は、図9Bに見られるように、不揮発性半導体リードオンリーメモリ(ROM)960及び半導体ランダムアクセスメモリ(RAM)970から形成することができる。RAM970は、揮発性メモリ、不揮発性メモリ又は揮発性メモリ及び不揮発性メモリの組み合わせとすることができる。

電子デバイス901は、液晶ディスプレイ(LCD)パネル等のビデオディスプレイ914に接続されたディスプレイコントローラ907を備える。ディスプレイコントローラ907は、ディスプレイコントローラ907が接続された組み込みコントローラ902から受信された命令に従ってグラフィカル画像をビデオディスプレイ914上に表示するように構成されている。

電子デバイス901は、通常はキー、キーパッド又は同様の制御手段によって形成されるユーザ入力デバイス913も備える。好ましい実施態様では、ユーザ入力デバイス913は、ディスプレイ914に物理的に関連付けられて、全体としてタッチスクリーンを形成するタッチ検知パネルを含む。このタッチスクリーンは、したがって、通常はキーパッドディスプレイの組み合わせとともに用いられるプロンプト駆動型GUI又はメニュー駆動型GUIとは対照的なグラフィカルユーザインターフェース(GUI)の1つの形態として動作することができる。音声コマンド用のマイクロフォン(図示せず)又はメニューについてのナビゲーションを容易にするためのジョイスティック/サムホイール(図示せず)等の他の形態のユーザ入力デバイスも用いることができる。本明細書に記載の構成では、タッチスクリーン914は、仮想カメラ150を生成するためにジェスチャーが受信される際に経由するコントローラ180のインターフェースを形成する。一方、幾つかの実施態様では、ジェスチャーは、マウス等のデバイス913の異なる入力を用いてグラフィカルユーザインターフェースを介して受信することができる。

図9Aに見られるように、電子デバイス901は、接続919を介してプロセッサ905に結合されたポータブルメモリインターフェース906も備える。ポータブルメモリインターフェース906は、データのソース若しくはデスティネーションとして動作するために又は内部記憶モジュール909を補助するために、補完ポータブルメモリデバイス925を電子デバイス901に結合することを可能にする。そのようなインターフェースの例は、ユニバーサルシリアルバス(USB)メモリデバイス、セキュアデジタル(SD)カード、パーソナルコンピュータメモリカード国際協会(PCMIA)カード、光ディスク及び磁気ディスク等のポータブルメモリデバイスとの結合を可能にする。

電子デバイス901は、デバイス901を、接続921を介してコンピュータ又は通信ネットワーク920に結合することを可能にする通信インターフェース908も有する。接続921は、有線又は無線とすることができる。例えば、接続921は、無線周波数又は光とすることができる。有線接続の一例はイーサネット(登録商標)を含む。さらに、無線接続の一例は、Bluetooth(登録商標)タイプのローカル相互接続、Wi−Fi(IEEE802.11ファミリーの規格に基づくプロトコルを含む)、赤外線データ協会(IrDa)等を含む。物理カメラ120A〜120Xは、通常、接続921を介して電子デバイス901と通信する。

通常、電子デバイス901は、或る特殊機能を実行するように構成されている。組み込みコントローラ902は、場合によっては更なる特殊機能構成要素910とともに、その特殊機能を実行するために提供される。例えば、デバイス901がタブレットである場合、構成要素910は、タブレットのホバーセンサ又はタッチスクリーンを表すことができる。特殊機能構成要素910は、組み込みコントローラ902に接続されている。別の例として、デバイス901は、モバイル電話ハンドセットとすることができる。この場合、構成要素910は、セルラー電話環境において通信に必要とされる構成要素を表すことができる。デバイス901がポータブルデバイスである場合、特殊機能構成要素910は、ジョイントフォトグラフィックエキスパートグループ(JPEG)、ムービングピクチャエキスパートグループ(MPEG)、MPEG−1オーディオレイヤー3(MP3)等を含むタイプの幾つかのエンコーダー及びデコーダーを表すことができる。

以下に記載の方法は、組み込みコントローラ902を用いて実施することができ、この場合、図2〜図8のプロセスは、組み込みコントローラ902内で実行可能な1つ以上のソフトウェアアプリケーションプログラム933として実施することができる。図9Aの電子デバイス901は、本明細書に記載の方法を実施する。特に、図9Bに関して、本明細書に記載の方法のステップは、コントローラ902内で実行されるソフトウェア933における命令によって行われる。ソフトウェア命令は、1つ以上の特定のタスクをそれぞれ実行する1つ以上のコードモジュールとして形成することができる。このソフトウェアは、2つの個別の部分に分割することもでき、第1の部分及び対応するコードモジュールは、記載の方法を実行し、第2の部分及び対応するコードモジュールは、第1の部分とユーザとの間のユーザインターフェースを管理する。

組み込みコントローラ902のソフトウェア933は、通常、内部記憶モジュール909の不揮発性ROM960に記憶される。ROM960に記憶されたソフトウェア933は、必要なときにコンピュータ可読媒体から更新することができる。ソフトウェア933は、プロセッサ905内にロードされてプロセッサ905によって実行することができる。幾つかの場合には、プロセッサ905は、RAM970に配置されたソフトウェア命令を実行することができる。ソフトウェア命令は、プロセッサ905がROM960からRAM970内への1つ以上のコードモジュールのコピーを開始することによって、RAM970内にロードすることができる。或いは、1つ以上のコードモジュールのソフトウェア命令は、製造業者によってRAM970の不揮発性領域にプレインストールすることができる。1つ以上のコードモジュールがRAM970に配置された後、プロセッサ905は、1つ以上のコードモジュールのソフトウェア命令を実行することができる。

アプリケーションプログラム933は、通常、電子デバイス901の配布前に、製造業者によってプレインストールされ、ROM960に記憶される。ただし、幾つかの場合には、アプリケーションプログラム933は、1つ以上のCD−ROM(図示せず)上にコード化されてユーザに供給することができ、内部記憶モジュール909又はポータブルメモリ925に記憶する前に、図9Aのポータブルメモリインターフェース906を介して読み取ることができる。別の代替形態では、ソフトウェアアプリケーションプログラム933は、プロセッサ905によってネットワーク920から読み取ることもできるし、他のコンピュータ可読媒体からコントローラ902又はポータブル記憶媒体925内にロードすることもできる。コンピュータ可読記憶媒体は、命令及び/又はデータを実行及び/又は処理のためにコントローラ902に提供することに関与する任意の非一時的有形記憶媒体を指す。そのような記憶媒体の例は、フロッピーディスク、磁気テープ、CD−ROM、ハードディスクドライブ、ROM若しくは集積回路、USBメモリ、光磁気ディスク、フラッシュメモリ、又はPCMCIAカード等のコンピュータ可読カードを含み、そのようなデバイスがデバイス901の内部にあるのか又は外部にあるのかを問わない。ソフトウェア、アプリケーションプログラム、命令及び/又はデータをデバイス901に提供することに同様に関与することができる一時的コンピュータ可読伝送媒体又は非有形コンピュータ可読伝送媒体の例には、無線伝送チャネル又は赤外線伝送チャネル、並びに別のコンピュータ又はネットワーク化デバイスへのネットワーク接続、及び電子メール送信及びウェブサイト等に記録された情報を含むインターネット又はイントラネットが含まれる。そのようなソフトウェア又はコンピュータプログラムが記録されたコンピュータ可読媒体が、コンピュータプログラム製品である。

アプリケーションプログラム933の第2の部分及び上述した対応するコードモジュールは、図9Aのディスプレイ914上にレンダリング又は別の方法で表示される1つ以上のグラフィカルユーザインターフェース(GUI)を実施するのに実行することができる。ユーザ入力デバイス913(例えば、キーパッド)の操作を通じて、デバイス901及びアプリケーションプログラム933のユーザは、機能的に適応可能な方法でインターフェースを操作して、GUI(複数の場合もある)に関連したアプリケーションに制御コマンド及び/又は制御入力を提供することができる。ラウドスピーカー(図示せず)を介して出力される発話プロンプトと、マイクロフォン(図示せず)を介して入力されるユーザ音声コマンドとを利用するオーディオインターフェース等の他の形態の機能的適応可能ユーザインターフェースも実装することができる。

図9Bは、アプリケーションプログラム933を実行するプロセッサ905及び内部記憶装置909を有する組み込みコントローラ902を詳細に示している。内部記憶装置909は、リードオンリーメモリ(ROM)960及びランダムアクセスメモリ(RAM)970を備える。プロセッサ905は、接続されたメモリ960及び970の一方又は双方に記憶されたアプリケーションプログラム933を実行することができる。電子デバイス901が最初に電源投入されると、ROM960に常駐するシステムプログラムが実行される。ROM960に永続的に記憶されたアプリケーションプログラム933は、「ファームウェア」と呼ばれることがある。プロセッサ905によるファームウェアの実行は、プロセッサ管理、メモリ管理、デバイス管理、記憶管理及びユーザインターフェースを含む様々な機能を遂行することができる。

プロセッサ905は、通常、制御ユニット(CU)951と、算術論理ユニット(ALU)952と、デジタル信号プロセッサ(DSP)953と、通常は原子データ要素956、957を含む一組のレジスタ954を備えるローカルメモリ又は内部メモリとを含む幾つかの機能モジュールを、内部バッファ又はキャッシュメモリ955とともに備える。1つ以上の内部バス959は、これらの機能モジュールを相互接続する。プロセッサ905は、通常、接続961を用いてシステムバス981を介して外部デバイスと通信する1つ以上のインターフェース958も有する。

アプリケーションプログラム933は、条件付き分岐命令及びループ命令を含むことができる命令962〜963のシーケンスを含む。プログラム933は、プログラム933の実行中に用いられるデータも含むことができる。このデータは、命令の一部として記憶することもできるし、ROM960内の別個の位置964又はRAM970に記憶することもできる。

一般に、プロセッサ905には、当該プロセッサにおいて実行される命令のセットが与えられる。この命令のセットは、特定のタスクを実行するブロック又は電子デバイス901内で発生する特定のイベントをハンドリングするブロックに編成することができる。通常、アプリケーションプログラム933は、イベントを待機し、その後、そのイベントに関連したコードのブロックを実行する。イベントは、図9Aのユーザ入力デバイス913を介したユーザからの入力がプロセッサ905によって検出されると、この入力に応答してトリガーすることができる。イベントは、電子デバイス901における他のセンサ及びインターフェースに応答してトリガーすることもできる。

命令のセットの実行は、数値変数の読み出し及び変更を必要とする場合がある。そのような数値変数は、RAM970に記憶される。開示された方法は、メモリ970内の既知の位置972、973に記憶された入力変数971を用いる。入力変数971は処理されて、出力変数977が生成され、メモリ970内の既知の位置978、979に記憶される。中間変数974は、メモリ970の位置975、976における追加のメモリ位置に記憶することができる。代替的に、幾つかの中間変数は、プロセッサ905のレジスタ954にのみ存在することができる。

命令シーケンスの実行は、プロセッサ905においてフェッチ−実行サイクルを繰り返し適用することによって実現される。プロセッサ905の制御ユニット951は、実行される次の命令のROM960又はRAM970におけるアドレスを含むプログラムカウンタと呼ばれるレジスタを保持する。フェッチ実行サイクルの開始時に、プログラムカウンタによって指し示されたメモリアドレスの内容が、制御ユニット951内にロードされる。このようにロードされた命令は、プロセッサ905のその後の動作を制御し、例えば、ROMメモリ960からプロセッサレジスタ954内へのデータのロード、或るレジスタの内容と別のレジスタの内容との算術的結合、或るレジスタの内容の別のレジスタに記憶された位置への書き込み等をプロセッサに行わせる。フェッチ実行サイクルの終了時、プログラムカウンタは、システムプログラムコードにおける次の命令を指し示すように更新される。実行されたばかりの命令に応じて、これは、プログラムカウンタに含まれるアドレスをインクリメントすること、又は、分岐動作を実現するために新たなアドレスを有するプログラムカウンタをロードすることを伴う場合がある。

以下に記載の方法のプロセスにおける各ステップ又は各サブプロセスは、アプリケーションプログラム933の1つ以上のセグメントに関連付けられ、プロセッサ905におけるフェッチ−実行サイクルの繰り返し実行又は電子デバイス901内の他の独立したプロセッサブロックの同様のプログラム動作によって実行される。

本明細書に記載の構成では、コントローラ180は、タブレットデバイス901のタッチスクリーン914に関係している。タッチスクリーン914は、ユーザがフィールド110の表示された描写とインターラクトすることができるとともに、フィールド110に関連したビデオフッテージを視聴することができるインターフェースを提供する。

本開示は、構成部分又は構成操作からなるジェスチャーを用いて仮想カメラを構成する方法に関する。各構成部分は、仮想カメラビューの属性を規定する。これらの構成部分を含むジェスチャーは、単一の連続したジェスチャーである。

図2は、インターフェース914を介して受信されたジェスチャーを用いて仮想カメラ150を構成する方法200を示している。方法200は、メモリ909に記憶され、プロセッサ905の実行にわたって制御されるソフトウェアアプリケーション933の1つ以上のモジュールとして実施することができる。

方法200は、表示ステップ210から開始する。ステップ210において、ビデオ処理ユニット170は、ビデオビュー190によって表される合成仮想カメラビューと、仮想モデル化された3Dスポーツフィールド110の合成インタラクションビュー191との生成を実行する。インタラクションビュー191は、ユーザが仮想カメラ150の配置を制御するためにインターラクトすることができる競技フィールド110等のシーンの描写を提供する。この描写は、競技フィールド110又は競技フィールド110のキャプチャーされたシーンのマップに関するものとすることができる。ステップ210は、ビュー190及び191をディスプレイ端末914上に表示することを実行する。図1に示すように、ビュー190及び191は、通常、ディスプレイ914の異なる領域に表示される。本開示の1つの構成では、ビュー191は第1の表示領域である一方、ビュー190は第2の表示領域であり、第1の表示領域及び第2の表示領域の双方は、ディスプレイ914の一部を形成する。代替的に、第1の表示領域及び第2の表示領域は、それぞれ異なるディスプレイデバイスにおけるものとすることができる。これらの異なるディスプレイデバイスは、ディスプレイコントローラ907と接続することができる。合成インタラクションビュー191は、フィールド110全体をカバーするトップダウンビューであってもよいし、或いは、仮想カメラ150によって生成されたビュー等のフィールド110にわたる水平透視ビューを含むフィールド110の他の任意の全ビュー又は部分的ビューとすることもできる。ディスプレイ端末914及びコントローラ180は、タッチスクリーンディスプレイ等における1つのデバイスの構成要素とすることもできるし、投影ディスプレイ並びにジェスチャー認識用のカメラセンサ及びビジョン検出システム等の別個のデバイスとすることもできる。初期合成ビュー190の初期位置は、以前のユーザインタラクションによって設定された所定のデフォルトとすることもできるし、フィールドのアクションに基づいて自動的に決定することもできる。

方法200は、プロセッサ905の実行の下でステップ210から受信ステップ220に続く。ステップ220において、コントローラ180は、合成インタラクションビュー191においてユーザからポインティング操作、本明細書に記載の例ではタッチジェスチャー入力を受信する。例えば、ユーザは、指を用いてタッチスクリーン914をタッチする。或いは、ジェスチャーは、ユーザが入力デバイスを操作すること、例えば、マウスをクリックすることに関するものとすることができる。タッチスクリーンインターフェース914表現において受信されたジェスチャーは、全体的な連続ジェスチャーの初期操作である。方法200は、プロセッサ905の制御下で第1の認識ステップ230に進む。ステップ230において、タッチジェスチャーの第1の部分が、ビデオ処理ユニット905によって認識される。一例示の初期タッチ310入力が、図3Aにおける構成300に示されている。方法200は、認識されたタッチをフィールド110の合成インタラクションビュー191上の位置に関連付けるように動作する。この位置は、デバイス901における例えばメモリ909に記憶することができる。幾つかの構成では、ステップ230は、位置を求めると、動的な仮想カメラプレビューを生成し、タッチスクリーンディスプレイ914の一部分に表示することを実行する。この仮想カメラプレビューは、上記位置において任意の方向又はデフォルト方向における仮想カメラからのビューに関するものである。デフォルト方向の一例は、最も近いゴールポストに向いた方向である。

方法200は、プロセッサ905の制御下で、ステップ230から第2の認識又は特定ステップ240に続く。ステップ240において、コントローラ180は、タッチジェスチャーの第2の操作又は更なる操作を受信する。このジェスチャーの第2の操作又は更なる操作は、図3Aにおける矢印320によって示される、タッチスクリーン914に印加される第1のスワイプ入力を含む。スワイプジェスチャーは、初期タッチ(ポインティング)入力310の位置から遠ざかる連続した動きである。このジェスチャーが、入力デバイスの操作に関するものである場合、マウスのホールドアンドドラッグ操作等の対応する連続した動きを特定することができる。ビデオ処理ユニット905は、スワイプジェスチャーを特定し、特定されたジェスチャーを第1のスワイプ入力又は第1の動きとして記録する。ビデオ処理ユニット905は、第1のスワイプ入力320の属性(例えば、方向又は長さ)を求めるようにも動作する。初期タッチ(ポインティング)入力310及び第1のスワイプ入力320は、単一の連続ジェスチャーを形成する。プロセッサ905は、第1のスワイプ入力又は第1の動き320の識別情報及び方向を、例えばメモリ909に記憶するように動作する。

幾つかの構成では、ステップ240は、特定された第1の動き(スワイプ)に基づいて仮想カメラの動的なプレビューを生成し、ビデオディスプレイ914を用いて表示するように動作する。この仮想カメラプレビューは、第1のスワイプ入力320の方向に沿った第1の入力310の位置に関するものであるので、この仮想カメラプレビューは、ステップ230の仮想カメラプレビューと異なる。この動的なプレビューは、第1の動きが受信されると、ビュー190における仮想カメラに関連したリアルタイム画像を提供するように効果的に機能する。

方法200は、プロセッサ905の実行の下で、ステップ240から第3の認識ステップ250に進む。ステップ250において、コントローラ180は、第1のスワイプに対して或る角度で入力された、第1のスワイプ320から遠ざかる連続した動きを有する、タッチスクリーン914に適用されるタッチジェスチャーの第3の部分を受信する。この第1の動き又は第1のスワイプ320から遠ざかる連続した動きは、第2の動き330を表す。この第2の操作又は更なる操作は、ステップ240の第1の動き及びステップ250の第2の動きの双方を含むとみなすことができる。アプリケーション933は、この角度(視野)と、この角度に基づく仮想カメラ150の範囲とを求める。この角度は、好ましくは、所定の閾値、例えば50度よりも大きい。この閾値は、通常、第1のスワイプ入力320における通常の変動(不安定性)を許容するために、10度と170度との間又は190度と350度との間にある。認識されたタッチジェスチャーの第3の部分は、実際上、第2のスワイプジェスチャー又は第2の動きである。図3Aに330として示された第2のスワイプ入力又はジェスチャーは、仮想カメラ150の視野を決定する。したがって、妥当な前提として、第2のスワイプ入力300は、170度〜190度の範囲外に含まれるべきでもある。この前提は、180度に過度に近いスワイプが第1のスワイプ入力320から十分にずれていないという理由からなされる。

ビデオ処理ユニット905は、閾値要件を満たす第2のスワイプ入力330を認識する。初期タッチ入力310、第1のスワイプ入力320及び第2のスワイプ入力330は、単一の連続ジェスチャーを形成する。コンピュータモジュール901は、基本仮想カメラ150を構成するように動作可能である。基本仮想カメラ150を構成するために、ビデオ処理ユニット905は、ステップ250において、第1のスワイプ入力320の端部から遠ざかる第2のスワイプ入力330の長さを求める。図3Aに示す視野線340は、競技フィールド110の描写に対して初期(ポインティング)タッチ310の位置と第2のスワイプ330の端部との間に引かれる。視野線340は、第1のスワイプ入力320についてミラーリングされると、仮想カメラ150の視野の水平範囲を画定する。その結果得られる仮想カメラ150の視野370は、図3Bにおける構成300bに示されている。幾つかの構成では、更新された動的な仮想カメラプレビューが、ステップ250の実行中に生成される。動的なプレビューは、視野370に関するものである。

方法200は、プロセッサ905の実行の下で、ステップ250から生成ステップ260に続く。ステップ260において、アプリケーション933は、基本仮想カメラ150の生成を実行する。仮想カメラ150の向きは、第1の動きの特定された方向に基づいており、仮想カメラ150の視野は、第2の動きの特定された長さに基づいている。仮想カメラ150は、初期タッチ入力310の位置に位置決めされ、視線が第1のスワイプ入力320の方向に従うような向きであって、視野370が、第1のスワイプ入力320に対する第2のスワイプ入力330の角度を決定する第2のスワイプ入力330の長さから求められた視野線340に従って延在するように設定された向きを有する。アプリケーション933は、位置、方向、視野等の仮想カメラビュー150を規定する設定の保存を実行する。別の実施態様では、複数の既定の仮想カメラをシーン(フィールド110)に関連付けることができる。これらの既定の仮想カメラは、例えば、ゲームの開始前にコントローラ180のユーザによってカメラ120A〜120Xから構成することができる。ステップ260は、この実施態様では、既定のカメラのうちの1つを選択するように動作する。例えば、最も類似した方向及び/又は視野、又は、所定の方向閾値及び/又は視野閾値内の方向及び/又は視野を有する既定のカメラを選択することができる。

幾つかの実施態様は、上述したようなステップ240及び260において動的なプレビューを生成することに関するものである。他の実施態様は、仮想カメラが生成又は構成された後に、ステップ260においてビュー190の画像データ又はビデオデータを生成することに関するものである。

ユーザが、タッチジェスチャー310、320及び330を入力すると、仮想カメラビュー190の構成を示す仮想カメラプレビュー350(図3A)をビデオディスプレイ914上に提示することができる。仮想カメラプレビュー350は動的であり、ユーザがジェスチャーを終了するか、又は、コントローラ180のタッチスクリーンとの接触を終了すると、表示を中止する。対照的に、ステップ260において生成された仮想カメラは、メモリ(メモリ309等)に保存され、ユーザがジェスチャーを終了した後であっても動作される。

アプリケーション933は、ステップ260において、仮想カメラ150のビュー領域内でカメラ120A〜120Xによってキャプチャーされた画像上での物体検出に画像解析技法も用いることができる。仮想カメラ150の視野に存在するものとして検出された、すなわち仮想カメラビュー190においてキャプチャーされた物体380は、図3Aに示すように強調表示される。仮想カメラビュー190に含まれない物体390等の検出物体は、いずれも強調表示されない。強調表示する視覚プロンプト及び強調表示しない視覚プロンプトによって、ユーザは、入力中に全体的なジェスチャーを変更して、仮想カメラ150の最終構成を改良することが可能になる。

ジェスチャーの完了後、強調表示された物体380のうちの1つが、視野370の範囲又は区域の外に移動した場合、ステップ260の実行中に、視野370の範囲を変更して、強調表示された物体が仮想カメラビュー190内に確実に留まるようにすることができる。例えば、図3Bに示す視野370の角度の範囲が、アプリケーション933の実行によって、強調表示された物体380が移動した角度の変化だけ変更される。強調表示された物体の角度の変化は、視野の角度と同じ軸を用いてアプリケーション933によって求められる。向き及び視野の一方又は双方を変更することができる。

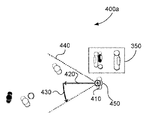

図4Aは、仮想カメラビュー190を生成するように仮想カメラ150を構成する方法の代替の構成400aを示している。図4Aの構成では、仮想カメラビュー190は、プレーヤー又は審判等のフィールド110上の物体の視点を反映している。仮想カメラ150及び結果として得られるビュー190は、図2に関して説明した3つの部分ジェスチャーを用いて求められる。実際上、図4Aに関して説明する構成は、「Ref−cam」(審判カメラ)等の「物体ビュー」カメラを提供する。構成400aは、基本「物体ビュー」仮想カメラを構成又はセットアップするのに必要とされるインタラクションを示している。図4Bにおける構成400bは、フィールド110上で選択された別の物体470を追跡する視線を有する「物体ビュー」仮想カメラをセットアップするのに必要とされるインタラクションを示している。

図4Aの例では、タッチジェスチャーの第1の部分は、ビデオ処理ユニット905によって、合成インタラクションビュー191上においてフィールド110上の物体450と同じ位置に入力された初期タッチ410として認識される。ステップ260において作成された仮想カメラ150は、タッチされた物体450に応じて有効な方法で位置決めされる。例えば、物体がボールである場合、仮想カメラ150は、ボールの中心に位置決めされる。物体が人、例えば審判である場合、仮想カメラ150は、人の頭部に位置決めされる。物体ビューカメラの重要な属性は、物体の位置が変化すると仮想カメラ150が位置を変化させることである。例えば、仮想カメラ150の位置は、フィールド110に対する人の移動を追跡するように更新される。仮想カメラ150は、物体に有効にテザリングされ、物体がフィールドを動き回っても、物体に対する位置又は位置を維持する。

ステップ240において、コントローラ180は、連続タッチジェスチャー入力の第2の部分420(すなわち、更なる操作の第1の動き)を受信する。第2のジェスチャー420は、初期タッチ入力410の位置から遠ざかる連続した動きを有する。ビデオ処理ユニット905は、入力420をスワイプジェスチャーとして認識し、ジェスチャー420を第1のスワイプ入力として記録する。ステップ260において作成され、410に位置決めされた仮想カメラ150は、第1のスワイプ入力420の方向に従った視線を有するように向きが定められる。タッチされた物体450が人である場合、仮想カメラ150の視線角度は、人の頭部の前方方向を基準として固定される。人の頭部の方向は、通常、カメラ120A〜120Xのうちの該当するカメラによってキャプチャーされたビデオデータに対して顔認識処理技法を用いて求められる。人がその頭部を回転させた場合、アプリケーション933は、ステップ240〜260において、ビデオストリームに対して顔認識技法を用いてその回転を特定することを実行し、仮想カメラ150を同じ方向に同じ量だけ回転させる。したがって、仮想カメラ150は、人の視点を追跡及びシミュレーションする。

ステップ250において、コントローラ180は、所定の閾値よりも大きな角度で入力された、第1のスワイプ420から遠ざかる連続した動きを有するタッチジェスチャーの第3の部分430を受信する。ビデオ処理ユニット905は、第3の部分430を第2のスワイプ入力(すなわち、更なる操作の第2の動き)として認識する。ビデオ処理ユニット905は、第1のスワイプ入力420の端部から遠ざかる第2のスワイプ入力430の長さを求める。視野線440が、初期タッチ位置410と第2のスワイプ430の端部との間に描かれる。視野線430は、第1のスワイプ入力420についてミラーリングされ、ステップ260の実行中に作成された仮想カメラ150の視野の水平範囲が画定される。

図4Bの構成400bに示すように、第1のスワイプジェスチャー420は、第2の物体470に向けて延び、第2の物体470上で終了することができる。物体の存在は、上述したように検出される。仮想カメラ150の視線は、タッチされた物体450の頭部に対して固定されない。逆に、第1のスワイプジェスチャーがこのイベントにおいて第2の物体上で終了した場合、物体470が仮想カメラビュー190の中心近くに保たれるように、仮想カメラ150の視線は、第2の物体470の位置を追跡する。第1のタッチジェスチャーの位置が物体に対するものでなかったが、第1のスワイプジェスチャーが或る物体上で終了した場合、仮想カメラ150は、その場合も、通常は、第1のスワイプジェスチャー420の終端にあるその物体を追跡するように構成される。

図5A及び図5Bは、3つの部分ジェスチャーを用いてフィールド110の上方の様々な高さに仮想カメラ150を構成する方法の別の実施態様を示している。上述の構成では、仮想カメラ150は、デフォルトの高さ、例えば1.5mに作成される。このデフォルトの高さは、ユーザが設定することができ、通常、実験を通じて求められる。この高さは、好ましくは、仮想カメラビュー190を、フィールド110上のプレーヤーの頭部の高さ、例えば、年齢層及び/又は性別に基づくプレーヤーの平均の高さ近くにすることを可能にする妥当なデフォルトである。

図5Aは、電子デバイス901のタッチスクリーンを用いて仮想カメラの高さを設定するのに必要とされるインタラクションを説明する構成500aを示している。図5Bに示す構成500bは、仮想カメラの高さを設定するのに必要とされるインタラクションを示している。この構成では、電子デバイス901は、例えば、赤外線カメラセンサを用いて、近接ジェスチャー又はホバージェスチャーを検知するように構成されている。

コントローラ180が図5Aに示すようなタッチスクリーンに関するものである構成では、コントローラ180は、ステップ230において、合成インタラクションビュー191に対して入力された初期タッチ570を受信する。仮想カメラ150の高さは、初期タッチの持続時間に基づいて求められる。この高さは、初期タッチの持続時間が、閾値、例えば500msよりも長い場合に求められる。閾値は、通常、特定のスポーツ及び/又は競技場についての実験を通じて事前に決定される。閾値を越える長期のホールドによって、ユーザに意図があることが推測される。相対的に短い閾値が用いられた場合、ユーザは、高さ調整を不注意でトリガーする可能性がある。入力された初期タッチ570の持続時間が500msの閾値を越えている場合、フィールド110の地面からの仮想カメラ150の高さが求められる。ユーザが初期タッチ入力570を長くするほど、カメラの高さ設定値は増加し、ビデオディスプレイ914上の高さインジケータ510aに示される。高さは、限界、例えば20メートルまで増加させることができる。高さの限界は、環状に並んだカメラ120A〜120Xの位置によって決まる。高さの限界に達した後、長期のタッチを更に連続して印加すると、仮想カメラ150の高さは減少する。高さインジケータ510aは、グラフィックとすることもできるし、テキストとすることもできる。

別の実施態様では、タッチスクリーン914は、タッチスクリーンに印加された圧力を測定するように構成されたタッチスクリーンである。そのような構成では、仮想カメラ150の高さは、初期タッチの間にタッチスクリーンに印加された圧力を用いて求められる。ステップ220において、圧力閾値を越える初期タッチが特定され、第2のジェスチャー(第1のスワイプ又は第1の動き)の前に印加された最大圧力が、仮想カメラ150の高さを求めるのに用いられる。ユーザは、タッチスクリーン914にタッチして圧力を印加することによって初期タッチを印加する。高さを変えるのに用いられる圧力閾値及び圧力スケールは、通常、タッチスクリーンの製造業者の仕様に従って決定される。ユーザが圧力を高めると、仮想カメラ150の高さ設定値は増加し、高さインジケータ510aに示される。高さ限界に達した後、圧力を更に連続して印加すると、仮想カメラ150の高さは減少する。

デバイス901が、ホバージェスチャーセンサを備える場合、ニアエア(near air)ジェスチャーを用いて、仮想カメラ150の高さを規定することができ、ジェスチャーの第2の構成要素及び第3の構成要素を特定することができる。図5Bでは、ホバー検出ゾーン550が、ホバージェスチャー対応デバイス540b(コントローラ180)上に存在する。ユーザの指520がホバー検出ゾーン550に入ると、指520のホバージェスチャーの存在が、ステップ230の実行中に初期タッチ入力として認識される。仮想カメラ150の高さは、ホバージェスチャーの高さに基づいて求められる。ディスプレイスクリーン914上には、初期タッチ入力アイコン560が表示されるとともに、デフォルト値に設定された仮想カメラの高さを有する高さインジケータ510bが表示される。ユーザは、指520の移動を継続して下部閾値530を通過し、モジュール901をトリガーして新たな仮想カメラの高さを設定することができる。ユーザの指520は、その後、逆に移動して閾値レイヤー530及び550を通過することができる。仮想カメラ150の高さを設定するために、高さの変化が高さインジケータ510bに示される。図5Bに関して説明したインタラクションは、垂直ホバージェスチャーを用いてカメラの高さを設定することができる方法を示している。代替的に、ユーザは、500msの閾値よりも長い持続時間の間、指520をホバー検出ゾーン550内にホールドすることができ、アプリケーション900は、指の位置を長期タッチ入力として認識して登録する。この長期タッチ入力によって、高さインジケータ510b及び初期タッチ入力アイコン560が表示され、仮想カメラ150の高さが設定される。

ユーザの指520が、初期タッチ入力位置(例えば、570)から遠ざかる連続した動きで水平方向に移動すると、アプリケーション933は、この指の動きをタッチジェスチャー入力の第2の部分、すなわち、第1のスワイプ入力、例えば入力575として認識する。第1のスワイプ575及び第2のスワイプ580の入力は、タッチジェスチャー又はホバージェスチャーとして行うこともできるし、マウスによってドラッグして行うこともできる。仮想カメラ150の区域の範囲は、図3Aと同様の方法で決定される。したがって、第1のジェスチャー、第2のジェスチャー及び第3のジェスチャーが単一の連続ジェスチャーを形成する場合、ステップ240及び250において特定された第2の動き及び第3の動きは、ホバースワイプジェスチャーに関係することができる。

図6は、仮想カメラ150を構成する代替の構成600を示している。構成600において用いられる方法は、3つの部分ジェスチャーを用いて仮想カメラ150の焦点距離及び被写界深度を設定する。焦点距離は、物体に焦点が合っているときの仮想カメラ150からの距離に関するものである。被写界深度は、物体に焦点が合っているときの焦点距離の両側の範囲に関するものである。被写界深度の外部の物体は、焦点が合っておらず、物体が焦点距離から更に遠くなるほど、ますます焦点が合わなくなる。

方法200のステップ220において、コントローラ180は、合成インタラクションビュー191上でタッチジェスチャー入力を受信する。ステップ230において、このタッチジェスチャーの第1の部分が、ビデオ処理ユニット905によって初期タッチ入力610として認識される。ビデオ処理ユニット905は、初期タッチ入力610を合成インタラクションビュー191上の位置に関連付ける。仮想カメラ150は、初期タッチ入力610のこの位置に位置決めされる。

方法200のステップ230において、コントローラ180は、初期タッチ入力601の位置から遠ざかる連続した動きであるタッチジェスチャー入力の第2の部分を受信する。ビデオ処理ユニット905は、この第2のタッチジェスチャーをスワイプジェスチャーとして認識し、このジェスチャーを第1のスワイプ入力620として記録する。仮想カメラ150は、610における位置を用いてステップ260において作成され、仮想カメラ150の視線が第1のスワイプ入力620の方向に従うように向きが定められる。図6の構成では、第1のスワイプジェスチャー620が第2の物体670に向かって延び、第2の物体670上で終了すると、アプリケーション933は、第2の物体670の位置に仮想カメラ150の焦点距離(焦点)を設定する。焦点距離は、幾つかの構成では、第2の物体670がフィールド110を動き回ると、物体670を追跡するように調整される。他の構成では、仮想カメラ150の決定された焦点距離は、物体670のその後の動きにかかわらず、静的な焦点距離である。

図6に関する構成では、ステップ250において、コントローラ180は、第1のスワイプ入力620の端部から遠ざかる連続した動きを有するタッチジェスチャー入力の第3の部分を受信する。この連続タッチ入力は、第1のスワイプ入力620の軌道に沿って、又は、例えば10度未満の閾値角度でトレースバックしているものと認識される。ビデオ処理ユニット905は、この連続タッチ入力を、被写界深度を設定する第2のスワイプ入力630として認識し、被写界深度ガイド680を表示する。被写界深度ガイド680は、初期タッチ入力630の位置を通過して延在する。第2のスワイプ入力630も、初期タッチ入力610の位置を通過して延在することができる。第2のスワイプ入力630は、ガイド680のうちの最も近い個別のガイドにスナップするように行うことができる。ステップ250において、ビデオ処理ユニット905は、第2のスワイプ入力630の長さを求める。この求められた長さは、仮想カメラ150の被写界深度を求めるのに用いられる。実際上、第2のスワイプジェスチャーが、第1のスワイプジェスチャーの軌道に沿ってトレースバックする場合、仮想カメラ150は、第2のスワイプ入力の長さに基づく被写界深度を有するように構成される。

物体660、640及び650は、第2の物体670に位置する焦点距離から様々な距離にある。したがって、物体660、640及び650は全て、仮想カメラ150について生成されたビューにおいて焦点から僅かにずれている。物体660、640及び650は、第2の物体670及び焦点距離から遠くなるほど、物体660、640及び650は、仮想カメラ150について生成されたビューにおいて焦点から更にずれる(ぼける)。

図7A及び図7Bは、存在する仮想カメラ150を再構成又は編集する構成を示している。図7Aにおける構成700aは、仮想カメラの位置、視線、又は視野を再構成するのに必要とされるインタラクションを示している。このインタラクションでは、ユーザは、コントローラ180のタッチスクリーンとインターラクトする。図7Bにおける構成700bは、タッチスクリーンを用いて仮想カメラの高さを再構成するのに必要とされるインタラクションを示している。

図7Aに示すように、方法200のステップ220において、コントローラ180は、合成インタラクションビュー191上で、存在する仮想カメラ150と同じ位置に入力されたタッチジェスチャーを受信する。方法220は、仮想カメラ150を構成するのに用いられた元のジェスチャー入力を表すガイド710、720及び730を表示することを実行する。ユーザは、3部分ジェスチャーを再トレースし、ジェスチャー部分のうちの任意のものを変更して仮想カメラ150を再構成することができる。或いは、ユーザは、第1のスワイプガイド、すなわち第1の動き720、又は、第2のスワイプガイド、すなわち第2の動き730のそれぞれのエンドポイント760又は761のいずれかにタッチして、仮想カメラ150の特性を変更することができる。幾つかの構成では、ユーザがエンドポイントを容易に認識、選択及び変更することができるように、エンドポイント760及び761は、合成インタラクションビュー131において強調表示される。例えば、ユーザは、第1のスワイプガイド720の端部におけるエンドポイント760にタッチし、ドラッグ又はスワイプジェスチャーを実施して、第1のスワイプ入力の角度を変更することができる。ドラッグ又はスワイプジェスチャーによって、仮想カメラ150の視線が変更される。第2のスワイプガイド730のエンドポイント760を移動させると、仮想カメラ150の元の視野740が変更される。初期タッチガイド710を移動させると、仮想カメラ150の位置が移動する。いずれの変更も、仮想カメラプレビュー795aに表される。

図7Bに示すように、合成インタラクションビュー191は、フィールド110の側面図を表す。コントローラ180が、合成インタラクションビュー191上で、存在する仮想カメラ150と同じ位置にタッチジェスチャー入力を受信すると、元のジェスチャー入力を表すインタラクション平面とも呼ばれるガイド780、790及び791が、アプリケーション933の実行によって表示される。合成インタラクションビュー191が、図7Bに示すように、フィールド110にわたる水平ビュー又は透視ビューであるとき、ガイド780、790及び791の表示は変化する。ユーザが初期タッチガイド780を上下に移動させると、アプリケーション933は、インタラクション平面が現在の合成インタラクションビュー191に垂直であると解釈するので、仮想カメラ150の高さが変更される。他のガイド790、791及びエンドポイント792のインタラクション平面は変化していない。他のガイド790、791及びエンドポイント792のインタラクション平面は、図7Aにおけるようなグラウンド平面770に平行に移動する。更新された仮想カメラビュー795bが示されている。実際上、コントローラ180は、第1のスワイプジェスチャー及び第2のスワイプジェスチャーのうちの一方を更新するジェスチャーを受信し、アプリケーション933は、それに応じて仮想カメラ150を再構成するように動作する。

図8A及び図8Bは、仮想カメラ150が、周回又は別の制約された動きの経路を有するフィールド110上のプレーヤー等の物体にテザリングされるように仮想カメラ150を構成する方法の動作を示す一組の図800a及び図800bを示している。図8の例では、仮想カメラ150は、物体が位置を変化させると、物体とともに移動するが、物体から仮想カメラ150までの距離は制約されている。

図8Aでは、タッチジェスチャーの第1の部分は、ビデオ処理ユニット905によって、合成インタラクションビュー191上の初期タッチ入力(初期操作又はポインティング操作)810として認識される。この初期タッチ入力810は、物体860、この場合にはプレーヤー、と同じ位置にある。

ステップ240において、コントローラ180は、初期タッチ入力810の位置から遠ざかる連続した動きを有するタッチジェスチャー入力の第2の部分を受信する。ビデオ処理ユニット905は、このタッチジェスチャーの第2の部分をスワイプジェスチャーとして認識し、タッチジェスチャーの第2の部分を第1のスワイプ入力(更なる操作の第1の動き)820として記録する。

ステップ250において、コントローラ180は、2つの閾値の間にある角度で第1のスワイプ入力820の端部から遠ざかる連続した動きを有するタッチジェスチャーの第3の部分(更なる操作の第2の動き)を受信する。例えば、閾値は、第1のスワイプ入力820から10度〜45度の角度に関するものとすることができる。45度の最大閾値は、超広角レンズを近似したものである。10度の最小閾値は、超望遠レンズを近似したものである。

初期タッチ入力810は、物体の位置にあり、第2のスワイプの動きは、第1のスワイプに対して2つの所定の閾値の間の角度にあるので、仮想カメラは、物体を周回するように生成される。アプリケーション933は、3つの部分ジェスチャーが、テザリングされた仮想カメラを規定すると認識し、テザリングされた仮想カメラ870が、第1のスワイプ入力820の端部に配置され、初期タッチ入力810を用いて選択された物体860を中心とする視線を有するように構成する。第1のスワイプジェスチャー又は第1の動き820の長さは、図8Bに示すような軌道経路880の半径を求めるのに用いられる。軌道経路880は、テザリングされた仮想カメラ870の移動を物体860の周囲に制約する。テザリングされた仮想カメラ870は、物体860の周囲を自動的に又は手動ナビゲーションによって移動することができる。テザリングされた仮想カメラは、物体860に対して接離して移動することができるが、通常位置は軌道経路880上にある。物体880がフィールド110を動き回るとき、テザリングされた仮想カメラ870は、同じ方向に同じ量だけ移動する。

本明細書に記載の構成は、コンピュータ産業及びデータ処理産業に適用可能であり、特に、ビデオ放送産業に適用可能である。本明細書に記載の構成は、スポーツ又は警備等のライブ放送アプリケーションに特に適している。

3つの構成要素の連続ジェスチャーの使用において、本明細書に記載の構成は、アクションが進行すると、ユーザが準リアルタイムで仮想カメラを生成することを可能にするという利点を提供する。ユーザは、片手のみを用いて容易に仮想カメラを構成し、仮想カメラの少なくとも3つのパラメーター、すなわち、位置、方向及び視野を制御することができる。さらに、本明細書に記載の構成は、専用コントローラを備えることなく実施することができる。対照的に、タブレット等のデバイスは、仮想カメラをその場で構成するのに用いることができる。

1つの例示の用途では、制作者は、サッカーの試合のライブフッテージを観察しながら、ボールが特定のプレーヤーにパスされることを予測する。制作者は、3つの構成要素ジェスチャーを用いて、プレーヤーを含む視野を有する仮想カメラを構成することができる。

上記内容は、本発明の幾つかの実施形態しか説明しておらず、本発明の範囲及び趣旨から逸脱することなく、それらの実施形態に対して変更及び/又は変形を行うことができる。実施形態は例示であって、限定ではない。

本明細書の文脈において、文言「〜を備える(comprising)」は、「主として〜を含むが、必ずしもそれのみではない」又は「〜を有する」又は「〜を含む」を意味するものであり、「〜のみからなる(consisting only of)」を意味するものではない。「〜を備えている("comprise" and "comprises")」等の、文言「〜を備える(comprising)」の変形形態は、それに対応して、様々な意味を有する。

Claims (23)

- 仮想カメラを構成する、コンピュータによって実行される方法であって、

第1の表示領域に表示されるシーンの描写における位置を特定するポインティング操作を、電子デバイスのインターフェースにおいて受信することと、

前記ポインティング操作の前記位置から遠ざかる連続した動きを含む、前記第1の表示領域における更なる操作を、前記インターフェースにおいて受信することと、

前記ポインティング操作の前記位置及び少なくとも前記更なる操作の方向に基づいて前記仮想カメラを構成することと、

を含み、

前記構成された仮想カメラに対応する画像は、前記第1の表示領域と異なる第2の表示領域に表示される、方法。 - 前記位置を特定する操作は、前記第1の表示領域において、前記仮想カメラが配めされる位置を選択することを含む、請求項1に記載の方法。

- 前記インターフェースはタッチスクリーンであり、前記ポインティング操作はタッチジェスチャーであり、前記更なる操作はスワイプ操作である、請求項1に記載の方法。

- 前記インターフェースはマウスであり、前記ポインティング操作はクリックであり、前記更なる操作はドラッグ操作である、請求項1に記載の方法。

- 前記仮想カメラの向きは、前記連続した動きの前記方向に基づいて構成される、請求項1に記載の方法。

- 前記ポインティング操作の前記位置から遠ざかる前記連続した動きは第1の動きであり、

前記更なる操作は、前記第1の動きからの連続した動きである第2の動きを更に含み、

前記仮想カメラの視野は、前記第2の動きの長さに基づいて構成される、請求項5に記載の方法。 - 前記シーンは、複数の既定の仮想カメラに関連付けられ、前記仮想カメラを構成することは、前記複数の既定の仮想カメラのうちの1つを選択することを含む、請求項1に記載の方法。

- 前記仮想カメラの構成は、前記仮想カメラの初期位置、初期の向き及び初期視野を決定する、請求項1に記載の方法。

- 前記更なる操作が受信されたときに、前記仮想カメラは構成され、前記画像は、リアルタイムで前記第2の表示領域に表示される、請求項1に記載の方法。

- 前記仮想カメラの前記視野は、前記第1の動きに対する前記第2の動きの角度に基づいて求められ、前記角度は所定の閾値内にある、請求項6に記載の方法。

- 前記タッチジェスチャーの持続時間又は前記タッチジェスチャー中に前記タッチスクリーンに印加される圧力のうちの少なくとも一方に基づいて、前記仮想カメラの高さを求めることを更に含む、請求項3に記載の方法。

- 前記ポインティング操作は、前記シーンにおける物体の位置を選択することを含み、前記仮想カメラは、前記物体の視点を表示するように構成される、請求項1に記載の方法。

- 前記第1の動きが物体上で終了したとき、前記仮想カメラは、該物体を追跡するように構成される、請求項6に記載の方法。

- 前記第1の表示領域に表示される前記シーンの前記描写は、前記仮想カメラが構成される競技フィールドのマップを表す、請求項1に記載の方法。

- 前記第2の動きが、前記第1の動きの軌道に沿ってトレースバックする場合、前記仮想カメラは、前記第2の動きの求められた長さに基づく被写界深度を有するように構成される、請求項6に記載の方法。

- 前記シーン内の前記位置における更なる選択を前記インターフェースにおいて検出することと、前記選択を示すもの、前記第1の動き及び前記第2の動きを表示することと、前記第1の動き及び前記第2の動きのうちの一方を更新して前記仮想カメラを再構成する選択を受信することとを更に含む、請求項6に記載の方法。

- 前記ポインティング操作が、前記シーン内の物体の位置にあり、前記第2の動きが、前記第1の動きに対して2つの所定の閾値の間の角度にある場合、前記仮想カメラは、前記物体を周回するように構成される、請求項6に記載の方法。

- 前記第1の動きの長さは、前記物体に対する前記仮想カメラの軌道経路の半径を求めるのに用いられる、請求項17に記載の方法。

- 前記第1の表示領域及び前記第2の表示領域は、前記電子デバイスの異なる部分である、請求項1に記載の方法。

- 前記第1の表示領域及び前記第2の表示領域は、それぞれ異なるディスプレイデバイスに存在し、該異なるディスプレイデバイスは、前記電子デバイスと接続されている、請求項1に記載の方法。

- 仮想カメラを構成するコンピュータプログラムが記憶された非一時的コンピュータ可読媒体であって、前記プログラムは、

第1の表示領域に表示されるシーンの描写における位置を特定するポインティング操作を、電子デバイスのインターフェースにおいて受信するコードと、

前記ポインティング操作の前記位置から遠ざかる連続した動きを含む、前記第1の表示領域における更なる操作を、前記インターフェースにおいて受信するコードと、

前記ポインティング操作の前記位置及び少なくとも前記更なる操作の方向に基づいて仮想カメラを構成し、該構成された仮想カメラに対応する画像を前記第1の表示領域と異なる第2の表示領域に表示するコードと、

を含む、非一時的コンピュータ可読媒体。 - インターフェースと、

ディスプレイと、

メモリと、

仮想カメラを構成する方法を実施する、前記メモリに記憶されたコードを実行するように構成されたプロセッサと、

を備えるシステムであって、

前記方法は、

第1の表示領域に表示されるシーンの描写における位置を特定するポインティング操作を、前記インターフェースにおいて受信することと、

前記ポインティング操作の前記位置から遠ざかる連続した動きを含む、前記第1の表示領域における更なる操作を、前記インターフェースにおいて受信することと、

前記ポインティング操作の前記位置及び少なくとも前記更なる操作の方向に基づいて前記仮想カメラを構成することと、

を含み、

前記構成された仮想カメラに対応する画像は、前記第1の表示領域と異なる第2の表示領域に表示される、システム。 - 仮想カメラを構成するように適合されるタブレットデバイスであって、

タッチスクリーンと、

メモリと、

プロセッサであって、

前記タッチスクリーンの第1の領域にシーンのビデオ描写を表示することと、

前記第1の領域内の前記シーンにおける位置を特定するポインティング操作を、前記タッチスクリーンにおいて受信することと、

前記位置から遠ざかる連続した動きを含む、前記第1の領域における更なる操作を、前記タッチスクリーンにおいて受信することと、

前記ポインティング操作の前記位置及び少なくとも前記更なる操作の方向に基づいて前記仮想カメラを構成することと、

前記構成された仮想カメラに対応する画像を、前記第1の領域と異なる前記タッチスクリーンの第2の領域に表示することと、

を行う、前記メモリに記憶されたコードを実行するように構成されたプロセッサと、

を備える、タブレットデバイス。

Applications Claiming Priority (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| AU2017204099A AU2017204099A1 (en) | 2017-06-16 | 2017-06-16 | System and method of configuring a virtual camera |

| AU2017204099 | 2017-06-16 | ||

| PCT/AU2018/000084 WO2018227230A1 (en) | 2017-06-16 | 2018-05-31 | System and method of configuring a virtual camera |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2020523668A true JP2020523668A (ja) | 2020-08-06 |

| JP2020523668A5 JP2020523668A5 (ja) | 2021-07-26 |

Family

ID=64658750

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2019565904A Withdrawn JP2020523668A (ja) | 2017-06-16 | 2018-05-31 | 仮想カメラを構成するシステム及び方法 |

Country Status (4)

| Country | Link |

|---|---|

| US (1) | US20200106967A1 (ja) |

| JP (1) | JP2020523668A (ja) |

| AU (1) | AU2017204099A1 (ja) |

| WO (1) | WO2018227230A1 (ja) |

Families Citing this family (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| EP3654294A4 (en) * | 2017-07-14 | 2020-06-03 | Sony Corporation | IMAGE PROCESSING DEVICE, IMAGE PROCESSING METHOD FOR IMAGE PROCESSING DEVICE, AND PROGRAM |

| CN109568956B (zh) * | 2019-01-10 | 2020-03-10 | 网易(杭州)网络有限公司 | 游戏中的显示控制方法、装置、存储介质、处理器及终端 |

| JP7358078B2 (ja) * | 2019-06-07 | 2023-10-10 | キヤノン株式会社 | 情報処理装置、情報処理装置の制御方法、及び、プログラム |

| WO2020262392A1 (ja) * | 2019-06-28 | 2020-12-30 | 富士フイルム株式会社 | 情報処理装置、情報処理方法、及びプログラム |

Family Cites Families (6)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2004005272A (ja) * | 2002-05-31 | 2004-01-08 | Cad Center:Kk | 仮想空間移動制御装置及び制御方法並びに制御プログラム |

| JP4115188B2 (ja) * | 2002-07-19 | 2008-07-09 | キヤノン株式会社 | 仮想空間描画表示装置 |

| US8277316B2 (en) * | 2006-09-14 | 2012-10-02 | Nintendo Co., Ltd. | Method and apparatus for using a common pointing input to control 3D viewpoint and object targeting |

| JP4662495B2 (ja) * | 2007-11-30 | 2011-03-30 | 株式会社スクウェア・エニックス | 画像生成装置、画像生成プログラム、画像生成プログラム記録媒体及び画像生成方法 |

| CN103324386A (zh) * | 2008-08-22 | 2013-09-25 | 谷歌公司 | 移动设备上的三维环境中的导航 |

| US9626786B1 (en) * | 2010-07-19 | 2017-04-18 | Lucasfilm Entertainment Company Ltd. | Virtual-scene control device |

-

2017

- 2017-06-16 AU AU2017204099A patent/AU2017204099A1/en not_active Abandoned

-

2018

- 2018-05-31 US US16/621,529 patent/US20200106967A1/en not_active Abandoned

- 2018-05-31 JP JP2019565904A patent/JP2020523668A/ja not_active Withdrawn

- 2018-05-31 WO PCT/AU2018/000084 patent/WO2018227230A1/en active Application Filing

Also Published As

| Publication number | Publication date |

|---|---|

| WO2018227230A1 (en) | 2018-12-20 |

| US20200106967A1 (en) | 2020-04-02 |

| AU2017204099A1 (en) | 2019-01-17 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| CN110944727B (zh) | 控制虚拟照相机的系统和方法 | |

| US11663785B2 (en) | Augmented and virtual reality | |

| JP6770061B2 (ja) | いつでもどこからでもビデオコンテンツを再生するための方法および装置 | |

| US20150185825A1 (en) | Assigning a virtual user interface to a physical object | |

| US20180173393A1 (en) | Apparatus and method for video zooming by selecting and tracking an image area | |

| JP2020523668A (ja) | 仮想カメラを構成するシステム及び方法 | |

| US20150187137A1 (en) | Physical object discovery | |

| CN114727022A (zh) | 在全向视频中的跟踪感兴趣对象 | |

| JP2019160318A (ja) | 情報処理装置、情報処理方法、及びプログラム | |

| CN109189302B (zh) | Ar虚拟模型的控制方法及装置 | |

| US20240078703A1 (en) | Personalized scene image processing method, apparatus and storage medium | |

| KR20150012274A (ko) | 이미지 내 원형 객체 검출에 의한 계산장치 동작 | |

| CN108377361B (zh) | 一种监控视频的显示控制方法及装置 | |

| CN104360729A (zh) | 基于Kinect和Unity3D的多交互方法与装置 | |

| EP2753094B1 (en) | Method and apparatus for controlling contents in electronic device | |

| JP2022510658A (ja) | 仮想カメラパスを決定するシステム及び方法 | |

| KR101743888B1 (ko) | 터치 유저 인터페이스를 이용한 카메라의 이동경로와 이동시간의 동기화를 위한 사용자 단말장치 및 컴퓨터 구현 방법 | |

| KR20180045668A (ko) | 터치 유저 인터페이스를 이용한 카메라의 이동경로와 이동시간의 동기화를 위한 사용자 단말장치 및 컴퓨터 구현 방법 | |

| CN109472873B (zh) | 三维模型的生成方法、装置、硬件装置 | |

| US11765333B1 (en) | Systems and methods for improved transitions in immersive media | |

| CN117806491A (zh) | 弹幕信息显示方法、装置、计算机设备和存储介质 | |

| AU2015264917A1 (en) | Methods for video annotation |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20210531 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20210531 |

|

| RD01 | Notification of change of attorney |

Free format text: JAPANESE INTERMEDIATE CODE: A7421 Effective date: 20220630 |

|

| A761 | Written withdrawal of application |

Free format text: JAPANESE INTERMEDIATE CODE: A761 Effective date: 20220707 |