JP2013532441A - Method and apparatus for encapsulating encoded multi-component video - Google Patents

Method and apparatus for encapsulating encoded multi-component video Download PDFInfo

- Publication number

- JP2013532441A JP2013532441A JP2013515413A JP2013515413A JP2013532441A JP 2013532441 A JP2013532441 A JP 2013532441A JP 2013515413 A JP2013515413 A JP 2013515413A JP 2013515413 A JP2013515413 A JP 2013515413A JP 2013532441 A JP2013532441 A JP 2013532441A

- Authority

- JP

- Japan

- Prior art keywords

- file

- media data

- media

- component

- extracted

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Pending

Links

Images

Classifications

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/40—Client devices specifically adapted for the reception of or interaction with content, e.g. set-top-box [STB]; Operations thereof

- H04N21/43—Processing of content or additional data, e.g. demultiplexing additional data from a digital video stream; Elementary client operations, e.g. monitoring of home network or synchronising decoder's clock; Client middleware

- H04N21/435—Processing of additional data, e.g. decrypting of additional data, reconstructing software from modules extracted from the transport stream

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/80—Generation or processing of content or additional data by content creator independently of the distribution process; Content per se

- H04N21/83—Generation or processing of protective or descriptive data associated with content; Content structuring

- H04N21/84—Generation or processing of descriptive data, e.g. content descriptors

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/20—Servers specifically adapted for the distribution of content, e.g. VOD servers; Operations thereof

- H04N21/23—Processing of content or additional data; Elementary server operations; Server middleware

- H04N21/234—Processing of video elementary streams, e.g. splicing of video streams, manipulating MPEG-4 scene graphs

- H04N21/2343—Processing of video elementary streams, e.g. splicing of video streams, manipulating MPEG-4 scene graphs involving reformatting operations of video signals for distribution or compliance with end-user requests or end-user device requirements

- H04N21/234327—Processing of video elementary streams, e.g. splicing of video streams, manipulating MPEG-4 scene graphs involving reformatting operations of video signals for distribution or compliance with end-user requests or end-user device requirements by decomposing into layers, e.g. base layer and one or more enhancement layers

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/20—Servers specifically adapted for the distribution of content, e.g. VOD servers; Operations thereof

- H04N21/23—Processing of content or additional data; Elementary server operations; Server middleware

- H04N21/235—Processing of additional data, e.g. scrambling of additional data or processing content descriptors

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/60—Network structure or processes for video distribution between server and client or between remote clients; Control signalling between clients, server and network components; Transmission of management data between server and client, e.g. sending from server to client commands for recording incoming content stream; Communication details between server and client

- H04N21/63—Control signaling related to video distribution between client, server and network components; Network processes for video distribution between server and clients or between remote clients, e.g. transmitting basic layer and enhancement layers over different transmission paths, setting up a peer-to-peer communication via Internet between remote STB's; Communication protocols; Addressing

- H04N21/647—Control signaling between network components and server or clients; Network processes for video distribution between server and clients, e.g. controlling the quality of the video stream, by dropping packets, protecting content from unauthorised alteration within the network, monitoring of network load, bridging between two different networks, e.g. between IP and wireless

- H04N21/64784—Data processing by the network

- H04N21/64792—Controlling the complexity of the content stream, e.g. by dropping packets

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/80—Generation or processing of content or additional data by content creator independently of the distribution process; Content per se

- H04N21/83—Generation or processing of protective or descriptive data associated with content; Content structuring

- H04N21/845—Structuring of content, e.g. decomposing content into time segments

- H04N21/8451—Structuring of content, e.g. decomposing content into time segments using Advanced Video Coding [AVC]

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/80—Generation or processing of content or additional data by content creator independently of the distribution process; Content per se

- H04N21/85—Assembly of content; Generation of multimedia applications

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/80—Generation or processing of content or additional data by content creator independently of the distribution process; Content per se

- H04N21/85—Assembly of content; Generation of multimedia applications

- H04N21/854—Content authoring

- H04N21/85406—Content authoring involving a specific file format, e.g. MP4 format

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N7/00—Television systems

- H04N7/24—Systems for the transmission of television signals using pulse code modulation

Landscapes

- Engineering & Computer Science (AREA)

- Multimedia (AREA)

- Signal Processing (AREA)

- Computer Networks & Wireless Communication (AREA)

- Computer Security & Cryptography (AREA)

- Two-Way Televisions, Distribution Of Moving Picture Or The Like (AREA)

- Compression Or Coding Systems Of Tv Signals (AREA)

Abstract

複数のレイヤを含むメディア・エンティティを複数のコンポーネント・ファイルにカプセル化する(レイヤごとに1つのコンポーネント・ファイルにカプセル化する)方法および装置について、それに対応するコンポーネント・ファイルを読み取る方法および装置とともに説明する。ISO BMFFの新たなボックス、およびSVC/MVCファイル・フォーマットの抽出器データ構造の拡張を、提案する。この新たなボックスにより、参照したコンポーネント・ファイルに対するアクセスを、現在のコンポーネント・ファイルの処理と並行して行うことが可能になる。本発明の抽出器の拡張により、異なるコンポーネント・ファイルにまたがるNALユニットの参照が可能になる。本発明は、メディア・ファイルの適応型HTTPストリーミングを可能にする。 Describes a method and apparatus for encapsulating a media entity including multiple layers into multiple component files (encapsulating into one component file per layer) along with a method and apparatus for reading the corresponding component file To do. A new box of ISO BMFF and an extension of the extractor data structure of the SVC / MVC file format are proposed. This new box allows access to the referenced component file in parallel with the processing of the current component file. The extractor extension of the present invention allows for referencing NAL units across different component files. The present invention enables adaptive HTTP streaming of media files.

Description

(関連出願の相互参照)

本特許出願は、2010年6月14日出願の「Extension to the Extractor data structure of SVC/MVC file formats」と題する米国仮特許出願第61/354,422号、および2010年6月14日出願の「Some extensions for ISO Base Media File Format for HTTP streaming」と題する米国仮特許出願第61/354,424号の優先権の利益を主張するものである。

(Cross-reference of related applications)

This patent application is filed on June 14, 2010, entitled “Extension to the Extractor data structure of SVC / MVC file formats” and US Provisional Patent Application No. 61 / 354,422, filed June 14, 2010. It claims the benefit of the priority of US Provisional Patent Application No. 61 / 354,424 entitled “Some extensions for ISO Base Media File Format for HTTP Streaming”.

本願は、本願と同時に出願された「Method and Apparatus for Encapsulating Coded Multi−component Video」と題する、同時係属の所有者が共通の米国特許出願第_/_号(代理人番号PU100140)に関連するものである。 This application is related to United States Patent Application No. __ / _ (Attorney No. PU100140), co-owned owner, entitled “Method and Apparatus for Encapsulating Coded Multi-component Video” filed concurrently with this application. It is.

本発明は、一般に、HTTPストリーミングに関する。さらに詳細には、本発明は、HTTPストリーミングのスケーラブル・ビデオ符号化(SVC)ストリームやマルチビュー符号化(MVC)ストリームなどの符号化マルチコンポーネント・ビデオ・ストリームのメディア・エンティティのカプセル化に関する。 The present invention generally relates to HTTP streaming. More particularly, the invention relates to the encapsulation of media entities of encoded multi-component video streams, such as scalable video coding (SVC) streams and multi-view coding (MVC) streams of HTTP streaming.

HTTPストリーミングの分野では、サーバ側で、MP4ファイルなどのBMFFに準拠したファイルとして、符号化ビデオをカプセル化して記憶することが多い。さらに、適応型HTTPストリーミングを実現するために、通常は、ファイルは、複数の動画フラグメントに分割され、これらのフラグメントが、さらに、クライアントURL要求によってアドレス可能な複数のセグメントにグループ化される。実際には、これらのセグメントには、ビデオ・コンテンツの様々な符号化表現が記憶され、クライアントが、所望の表現を動的に選択して、セッション中にダウンロードして再生することができるようになっている。 In the field of HTTP streaming, on the server side, encoded video is often encapsulated and stored as a BMFF-compliant file such as an MP4 file. In addition, to achieve adaptive HTTP streaming, a file is typically divided into a plurality of video fragments that are further grouped into segments that can be addressed by a client URL request. In practice, these segments store various encoded representations of the video content so that the client can dynamically select the desired representation to download and play during the session. It has become.

SVCやMVCのビットストリームなど、符号化された階層型ビデオは、ビットストリームの様々なサブセットを復号することによって、時間的/空間的解像度、画質、ビューなどに関して様々な動作点すなわち表現を可能にすることにより、このようなビットレート適応の自然なサポートを実現する。しかし、MP4ファイル・フォーマットなど、既存のISO Base Media File Format(BMFF)規格は、各レイヤまたは表現への個別アクセスに対応していないので、HTTPストリーミング分野に適用することができない。図1に示すように、MP4ファイル・フォーマットでは、1つのメディア・ファイルの全てのレイヤまたは表現のメタデータは、moov動画ボックスに記憶され、一方、全てのレイヤまたは表現のメディア・コンテンツ・データは、mdat動画ボックスに記憶される。HTTPストリーミングでは、クライアントが1つのレイヤを要求したとき、全てのレイヤまたは表現が混ざった状態であり、所要のレイヤまたは表現がどこで見つかるのかクライアントには分からないので、ファイル全体を送信しなければならない。 Encoded hierarchical video, such as SVC and MVC bitstreams, allows different operating points or representations in terms of temporal / spatial resolution, image quality, views, etc. by decoding different subsets of the bitstream By doing so, natural support for such bit rate adaptation is realized. However, the existing ISO Base Media File Format (BMFF) standard, such as the MP4 file format, does not support individual access to each layer or expression, and therefore cannot be applied to the HTTP streaming field. As shown in FIG. 1, in the MP4 file format, the metadata for all layers or representations of one media file is stored in the moov video box, while the media content data for all layers or representations is , Mdat video box. In HTTP streaming, when a client requests one layer, all layers or representations are mixed and the client does not know where to find the required layer or representation, so the entire file must be sent .

後述のように、適応型HTTPストリーミングの分野では、ネットワーク抽象化レイヤ(NAL)ユニットなどのメディア・データ・サンプルを、動画フラグメントまたはコンポーネント・ファイルの境界をまたいで参照することができることが望ましい。SVC/MVCの状況では、このような参照は、「抽出器」などの機構を用いることによって実現することができる。「抽出器」は、以下のBMFFのAVCファイル・フォーマット拡張に対するSVC/MVC補正に定義される、内部ファイル・データ構造である。Information Technology − coding of audio−visual objects − Part 15:Advanced Video Coding (AVC) File format, Amendment 2:File format support for Scalable Video Coding,2008,15〜17ページ。抽出器は、コピーを行わずに、参照によってその他のトラックからNALユニットを抽出することを可能にするように設計されている。ここで、トラックとは、ISOベース・メディア・ファイル中の関連するサンプルの時限シーケンスである。メディア・データでは、トラックは、画像またはサンプリングした音声のシーケンスに対応する。抽出器のシンタックスを、以下に示す。

class aligned(8) Extractor () {

NALUnitHeader( );

unsigned int(8) track_ref_index;

signed int(8) sample_offset;

unsigned int ((lengthSizeMinusOne + 1) * 8)

data_offset;

unsigned int ((lengthSizeMinusOne + 1) * 8)

data_length;

}

As described below, in the field of adaptive HTTP streaming, it is desirable to be able to reference media data samples, such as network abstraction layer (NAL) units, across video fragment or component file boundaries. In the SVC / MVC context, such a reference can be achieved by using a mechanism such as an “extractor”. "Extractor" is an internal file data structure defined in SVC / MVC correction for the following BMFF AVC file format extension. Information Technology-coding of audio-visual objects-Part 15: Advanced Video Coding (AVC) File format, Amendment 2: File format superV. The extractor is designed to allow NAL units to be extracted from other tracks by reference without copying. Here, a track is a timed sequence of related samples in an ISO base media file. In media data, a track corresponds to a sequence of images or sampled audio. The syntax of the extractor is shown below.

class aligned (8) Extractor () {

NALUnitHeader ();

unsigned int (8) track_ref_index;

signed int (8) sample_offset;

unsigned int ((lengthSizeMinusOne + 1) * 8)

data_offset;

unsigned int ((lengthSizeMinusOne + 1) * 8)

data_length;

}

抽出器データ構造のセマンティクスは、以下の通りである。

NALUnitHeader:タイプ20のNALユニットのISO/IEC 14496−10 Annex Gに指定されるNALユニット構造:

nal_unit_typeは、抽出器NALユニット・タイプ(タイプ31)に設定されるものとする。

forbidden_zero_bit、reserved_one_bitおよびreserved_three_2bitsは、ISO/IEC 14496−10 Annex Gに指定されるように設定されるものとする。

その他のフィールド(nal_ref_idc、idr_flag、priority_id、no_inter_layer_pred_flag、dependency_id、quality_id、temporal_id、use_ref_base_pic_flag、discardable_flagおよびoutput_flag)は、B.4 of Information technology − Coding of audio−visual objects − part 15:Advanced Video Coding (AVC) file format,Amendment 2:File format support for Scalable Video Coding,ISO/IEC 14496−15:2004/Amd.2:2008,17ページに指定されるように設定されるものとする。

The semantics of the extractor data structure are as follows:

NALunitHeader: NAL unit structure specified in ISO / IEC 14496-10 Annex G of type 20 NAL unit:

nal_unit_type shall be set to extractor NAL unit type (type 31).

Forbidden_zero_bit, reserved_one_bit, and reserved_three_2 bits shall be set as specified in ISO / IEC 14496-10 Annex G.

Other fields (nal_ref_idc, idr_flag, priority_id, no_inter_layer_pred_flag, dependency_id, quality_id, temporal_id, use_ref_base_pic_flag, discardpable_bladtable_bladg. 4 of Information technology-Coding of audio-visual objects-part 15: Advanced Video Coding (AVC) file format, Amendment 2: File format, Amendment 2: File format 2: 2008, page 17 is set as specified.

track_ref_indexは、データを抽出するトラックを発見するために使用するタイプ「scal」のトラック参照の指標を指定する。データが抽出されるトラック中のサンプルは、メディア復号タイムライン中で、すなわち時間/サンプル・テーブルのみを使用して、抽出器を含むサンプルと時間的に整列される、またはそれより先行する最も近い位置に位置し、sample_offsetによって指定されるオフセットだけ調節される。第1のトラック参照は、指標値1を有する。値0は予約される。 track_ref_index specifies an index of a track reference of type “scal” used to find the track from which data is extracted. The sample in the track from which the data is extracted is closest in time before or ahead of the sample containing the extractor in the media decoding timeline, i.e., using only the time / sample table. Located in position and adjusted by the offset specified by sample_offset. The first track reference has an index value of 1. The value 0 is reserved.

sample_offsetは、情報源として使用すべきリンクされたトラック中のサンプルの相対指標を与える。サンプル0(ゼロ)は、抽出器を含むサンプルの復号時間と比較して、同じ復号時間またはそれより先行する最も近い復号時間を有するサンプルである。サンプル1(イチ)は、次のサンプルであり、サンプル−1(マイナス1)は、前のサンプルである。以下同様に続く。 sample_offset gives a relative indication of the samples in the linked track to be used as an information source. Sample 0 (zero) is the sample that has the same decoding time or the closest preceding decoding time as compared to the decoding time of the sample containing the extractor. Sample 1 (one) is the next sample, and sample-1 (minus 1) is the previous sample. The same goes for the following.

data_offset:コピーする参照サンプル内の最初のバイトのオフセットである。サンプル中のデータの最初のバイトから抽出が開始される場合には、オフセットは、値0をとる。オフセットは、NALユニット長さフィールドの冒頭を参照するものとする。 data_offset: the offset of the first byte in the reference sample to be copied. If the extraction starts from the first byte of data in the sample, the offset takes the value 0. The offset shall refer to the beginning of the NAL unit length field.

data_length:コピーするバイト数である。このフィールドが値0をとる場合には、参照した1つのNALユニットの全体がコピーされる(すなわち、コピーする長さは、データ・オフセットによって参照した長さフィールドからとり、Aggregatorの場合にはadditional_bytesフィールドで増補する)。 data_length: the number of bytes to be copied. If this field takes the value 0, the entire referenced NAL unit is copied (ie, the length to be copied is taken from the length field referenced by the data offset, and in the case of an aggregator, additional_bytes. Augment in the field).

さらなる詳細は、Information technology − Coding of audio−visual objects − part 15:Advanced Video Coding (AVC) file format,Amendment 2:File format support for Scalable Video Coding,ISO/IEC 14496−15:2004/Amd.2:2008に見ることができる。 Further details are: Information technology-Coding of audio-visual objects-part 15: Advanced Video Coding (AVC) file format, Amendment 2: File format, Amendment 2: File format. 2: 2008 can be seen.

現在のところ、抽出器は、参照によってNALユニットを他のトラックから抽出することはできるが、同じ動画ボックス/フラグメント内から抽出することしかできない。換言すれば、抽出器を使用しても、別のセグメントまたはファイルからNALユニットを抽出することはできない。この制約により、抽出器の使用は上記の使用事例に制限されている。 Currently, the extractor can extract NAL units from other tracks by reference, but only from within the same video box / fragment. In other words, using an extractor cannot extract NAL units from another segment or file. This restriction limits the use of the extractor to the use case described above.

クライアントがサーバから1つのメディア・コンテンツの1つまたは複数のコンテンツ・コンポーネントを既にダウンロードしており、別のコンテンツ・コンポーネントをダウンロードするプロセスに入っている場合、クライアントは、必要に応じて完全なコンポーネント・セットをダウンロードするその他の要求を行うことができるように、以前にダウンロードしたコンテンツ・コンポーネントが、新たなコンテンツ・コンポーネントの依存性コンポーネントのセットの中に含まれるかどうかを知る必要がある。この使用事例でも、外部依存性コンテンツ・コンポーネントおよびその位置情報を信号通信する機構が必要である。 If the client has already downloaded one or more content components of one media content from the server and is in the process of downloading another content component, the client can complete the component as needed It needs to know if the previously downloaded content component is included in the set of dependent components of the new content component so that other requests to download the set can be made. This use case also requires a mechanism for signaling externally dependent content components and their location information.

BMFFでは、提示中の含んでいるトラックから別のトラックへの参照を実現するために使用される、「tref」と呼ばれるボックス・タイプがある。このボックスを使用して、トラック間の依存性を記述することができるが、その依存性は、同じメディア・ファイル内のトラックに限定される。 In BMFF there is a box type called “tref” that is used to realize a reference from the containing track being presented to another track. This box can be used to describe dependencies between tracks, but the dependencies are limited to tracks within the same media file.

1つの手法は、何らかの帯域外機構を用いてこの情報を信号通信するものである。例えば、HTTPストリーミングの分野では、サーバは、セッションの開始前に、クライアントにマニフェスト・ファイルを送信することができる。マニフェスト・ファイルは、要求されたメディア・コンテンツの各コンテンツ・コンポーネントの依存性および位置情報を含むファイルである。この場合、クライアントは、必要な全てのコンポーネント・ファイルを要求することができる。ただし、この帯域外手法は、マニフェスト・ファイルが利用できないローカルなファイル再生には適用することができない。 One approach is to signal this information using some out-of-band mechanism. For example, in the field of HTTP streaming, the server can send a manifest file to the client before the session starts. The manifest file is a file that includes dependency and location information for each content component of the requested media content. In this case, the client can request all necessary component files. However, this out-of-band technique cannot be applied to local file playback where a manifest file is not available.

上述の問題に対する従来の解決策は、当技術分野ではまだ十分に確立されていない。速度およびトランスポート効率を犠牲にすることなく、複数のレイヤを構文解析してカプセル化することができるようになれば、望ましいであろう。このような成果は、当技術分野では、これまでのところまだ達成されていない。 Conventional solutions to the above problems are not yet well established in the art. It would be desirable if multiple layers could be parsed and encapsulated without sacrificing speed and transport efficiency. Such results have not been achieved so far in the art.

本発明は、複数のレイヤを含むメディア・エンティティからコンポーネント・ファイルをカプセル化し、コンポーネント・ファイルを読み取る、方法および装置に関する。 The present invention relates to a method and apparatus for encapsulating and reading a component file from a media entity that includes multiple layers.

本発明の1つの態様によれば、複数のレイヤを含むメディア・エンティティからコンポーネント・ファイルをカプセル化して作成する方法が提供される。この方法では、メディア・エンティティから、各レイヤに、メタデータを抽出し、その抽出したメタデータに対応するメディア・データを抽出する。抽出したメディア・データとメタデータとを関連付けて、抽出したメタデータおよび抽出したメディア・データを含むコンポーネント・ファイルを各レイヤに作成することを可能にする。 According to one aspect of the invention, a method is provided for encapsulating and creating a component file from a media entity that includes multiple layers. In this method, metadata is extracted from the media entity to each layer, and media data corresponding to the extracted metadata is extracted. The extracted media data and the metadata are associated with each other, and a component file including the extracted metadata and the extracted media data can be created in each layer.

本発明の別の態様によれば、ファイル・カプセル化装置が提供される。このファイル・カプセル化装置は、メディア・エンティティから各レイヤにメタデータを抽出し、且つ抽出したメタデータに対応するメディア・データを抽出する抽出器と、抽出したメディア・データを抽出したメタデータと関連付けて、各レイヤにコンポーネント・ファイルを作成することを可能にする相関器とを含む。 According to another aspect of the invention, a file encapsulation device is provided. The file encapsulating apparatus extracts metadata from a media entity to each layer and extracts media data corresponding to the extracted metadata; and metadata obtained by extracting the extracted media data; And a correlator that makes it possible to create a component file for each layer.

本発明の上記の特徴は、添付の図面を参照しながらその例示的な実施例について詳細に説明することにより、さらに明らかになるであろう。 The above features of the present invention will become more apparent from the detailed description of exemplary embodiments thereof with reference to the accompanying drawings.

本発明では、メディア・ファイルもしくはメディア・ファイル・セットまたはストリーミング・メディアなどのメディア・エンティティを、クライアントURL要求によってアドレス可能な複数の動画コンポーネント・ファイルに分割またはカプセル化する。ここでは、コンポーネント・ファイルは、フラグメント、セグメント、ファイル、およびその他のそれらと等価な用語を表す広い意味で用いられる。 In the present invention, a media entity, such as a media file or media file set or streaming media, is divided or encapsulated into a plurality of video component files that are addressable by a client URL request. Here, component files are used in a broad sense to represent fragments, segments, files, and other equivalent terms.

本発明の一実施例では、複数の表現またはコンポーネントを含むメディア・エンティティを構文解析して、各表現/コンポーネントのメタデータおよびメディア・データを抽出する。この表現/コンポーネントの例としては、様々な時間的/空間的解像度を有するレイヤなどのレイヤ、SVCの画質レイヤなどのレイヤ、およびMVCのビューなどがある。以下では、レイヤも、表現/コンポーネントを指すために使用され、これらの用語は、入れ替え可能である。メタデータは、例えば、各表現のメディア・エンティティに何が含まれているか、またそこに含まれるメディア・データをどのように使用するかを記述している。メディア・データは、例えばコンテンツの復号など、メディア・データの目的を実施するのに必要なメディア・データ・サンプル、または所要のデータ・サンプルを取得する方法に関する任意の必要な情報を含む。各表現またはレイヤの抽出されたメタデータおよびメディア・データは、関連付け/相関付けされ、ユーザのアクセスに備えて一緒に記憶される。記憶動作は、ハード・ドライブまたはその他の記憶媒体上で物理的に行ってもよいし、あるいは、メタデータおよびメディア・データが実際には記憶媒体上の異なる場所に位置しているときでも、その他のアプリケーションまたはモジュールとのインタフェースをとったときに、それらが一緒に記憶されているように見えるように、関係管理機構を介して仮想的に実行してもよい。図2は、この実施例の例を示す。図2では、メディア・エンティティは、ベース・レイヤ、エンハンスメント・レイヤ1、およびエンハンスメント・レイヤ2の3つのレイヤを含む。メディア・エンティティを構文解析して、3つのレイヤそれぞれのメタデータおよびメディア・データを抽出し、これらのデータを、関連付けられたメタデータと対応するメディア・データとを備えるコンポーネント・ファイルとして、別々に記憶する。 In one embodiment of the invention, a media entity that includes multiple representations or components is parsed to extract metadata and media data for each representation / component. Examples of this representation / component include layers such as layers with various temporal / spatial resolutions, layers such as SVC image quality layers, and MVC views. In the following, layers are also used to refer to representations / components, and these terms are interchangeable. The metadata describes, for example, what is contained in the media entity of each representation and how to use the media data contained therein. The media data includes any necessary information regarding the media data samples necessary to perform the purpose of the media data, such as decryption of the content, or how to obtain the required data samples. The extracted metadata and media data for each representation or layer is correlated / correlated and stored together for user access. Storage operations may be performed physically on a hard drive or other storage medium, or other, even when metadata and media data are actually located at different locations on the storage medium When interfacing with other applications or modules, they may be executed virtually via a relationship management mechanism so that they appear to be stored together. FIG. 2 shows an example of this embodiment. In FIG. 2, the media entity includes three layers: a base layer, an enhancement layer 1 and an enhancement layer 2. Parse the media entity to extract metadata and media data for each of the three layers, and separate these data as component files with associated metadata and corresponding media data Remember.

図3は、SVC符号化ビデオなど、複数のレイヤを含むメディア・エンティティからコンポーネント・ファイルをカプセル化して作成するために使用される好ましいカプセル化装置300の構造を示す。入力メディア・エンティティ310は、メタデータ抽出器320およびメディア・データ抽出器340に渡される。メタデータ抽出器320は、各レイヤのメタデータ330を抽出する。メディア・データ抽出器340は、メタデータ330を取り込み、対応するメディア・データ350を抽出する。なお、別の実施例では、メタデータ抽出器320およびメディア・データ抽出器340は、1つの抽出器として実施されることに留意されたい。メタデータ330およびメディア・データ350の両データは、これら2つのタイプのデータを関連付けて出力コンポーネント・ファイル390を作成する相関器380に送られる。コンポーネント・ファイルは、各レイヤに1つ作成される。

FIG. 3 shows the structure of a

SVCまたはMVCのAVC拡張によって符号化されたビデオなど、階層型ビデオは、複数のメディア・コンポーネント(スケーラブルなレイヤまたはビュー)を含む。このような符号化ビットストリームは、ビットストリームの様々なサブセットを復号することによって、時間的/空間的解像度、画質、ビューなどに関して様々な動作点すなわち表現またはレイヤを提供することができる。さらに、ビットストリームのレイヤ間には、符号化依存性がある、すなわち、1つのレイヤの復号が、他のレイヤに依存する場合がある。従って、このようなビットストリームの表現のうちの1つを要求する際には、カプセル化ビデオ・ファイルから1つまたは複数のコンポーネントまたはメディア・データを取り出して復号する必要がある場合がある。様々な表現の抽出プロセスを容易にするために、符号化階層型ビデオは、各レイヤが異なるセグメントまたはコンポーネント・ファイルに別々に記憶されるような方法でMP4ファイルにカプセル化されることが多い。この場合には、上述の復号依存性またはアプリケーションによるその他の依存性によって、NALユニットなど、ビットストリームの特定のメディア・データ・サンプルが、複数のセグメントまたはコンポーネント・ファイルによって必要とされる、またはそれらと関係付けられることを考慮する必要がある。 Hierarchical video, such as video encoded with an SVC or MVC AVC extension, includes multiple media components (scalable layers or views). Such an encoded bitstream can provide different operating points or representations or layers with respect to temporal / spatial resolution, image quality, view, etc. by decoding different subsets of the bitstream. Furthermore, there is an encoding dependency between the layers of the bitstream, that is, decoding of one layer may depend on other layers. Thus, when requesting one of such bitstream representations, it may be necessary to retrieve and decode one or more components or media data from the encapsulated video file. To facilitate the various representation extraction processes, encoded hierarchical video is often encapsulated in MP4 files in such a way that each layer is stored separately in a different segment or component file. In this case, due to the decoding dependencies described above or other dependencies by the application, a particular media data sample of the bitstream, such as a NAL unit, is required by multiple segments or component files, or Need to be taken into account.

本発明の別の実施例では、セグメントまたはコンポーネント・ファイルによって必要とされる追加メディア・データを抽出して、当該セグメントまたはコンポーネント・ファイルと関連付ける。図4は、この実施例の例を示す。この図では、SVCビットストリームは、3つの空間レイヤ、HD1080p、SDおよびQVGAを有する。3つの動画フラグメントまたはコンポーネント・ファイルは、これら3つの動作点に対応して形成され、それぞれが異なるURLによってアドレス可能である。各動画フラグメントまたはコンポーネント・ファイル内で、復号に必要な全てのメディア・データ・サンプル(この例ではNALユニット)がコピーされ、「mdat」ボックスに収納されるメディア・サンプルとして記憶される。そのため、クライアントが適切なURLを用いて特定の動作点または表現を要求したとき、サーバは、対応する動画フラグメントまたはコンポーネント・ファイルを取り出して、クライアントに転送することができる。この実施例では、図3のメディア・データ抽出器340は、さらに各レイヤに、入力メディア・エンティティ310から、各レイヤに抽出したメディア・データに関係する追加メディア・データを抽出する。相関器380は、さらに、この各レイヤの追加の抽出メディア・データを関連付けて、対応するコンポーネント・ファイルを作成する。

In another embodiment of the invention, additional media data required by the segment or component file is extracted and associated with the segment or component file. FIG. 4 shows an example of this embodiment. In this figure, the SVC bitstream has three spatial layers, HD 1080p, SD and QVGA. Three video fragments or component files are formed corresponding to these three operating points, each addressable by a different URL. Within each video fragment or component file, all media data samples (NAL units in this example) required for decoding are copied and stored as media samples stored in the “mdat” box. Thus, when a client requests a specific operating point or representation using an appropriate URL, the server can retrieve the corresponding video fragment or component file and transfer it to the client. In this embodiment, the

記憶スペースを節約するために、各コンポーネント・ファイル内の同じデータを実際に複製することなく、複数の動画フラグメントまたはコンポーネント・ファイルの境界をまたいで、NALユニットなどのメディア・データ・サンプルを参照することができることが望ましい。しかし、ISO Base Media File Format(BMFF)およびその拡張では、現在のところこの機能に対応していない。この問題を解決するために、本発明のさらに別の実施例では、動画フラグメントまたはコンポーネント・ファイルのメディア・データと関係付けられる、またはこれによって必要とされる追加メディア・データについて、参照を識別して構築する。これらの追加メディア・データではなく、この参照を、そのメタデータおよびメディア・データとともにコンポーネント・ファイルと関連付ける。参照は、各レイヤの抽出メディア・データに埋め込むことができ、その後、各レイヤの抽出メタデータおよび抽出メディア・データを関連付けて、対応するコンポーネント・ファイルを作成することができる。 To save storage space, reference media data samples such as NAL units across multiple video fragment or component file boundaries without actually duplicating the same data in each component file It is desirable to be able to. However, the ISO Base Media File Format (BMFF) and its extensions do not currently support this function. To solve this problem, yet another embodiment of the present invention identifies references for additional media data related to or required by the media data of a video fragment or component file. And build. Instead of these additional media data, this reference is associated with the component file along with its metadata and media data. The reference can be embedded in each layer of extracted media data, and each layer's extracted metadata and extracted media data can then be associated to create a corresponding component file.

この実施例では、カプセル化装置300の構造に参照識別器360が追加される。参照識別器360は、入力メディア・エンティティ310から、各レイヤの抽出メディア・データ350に関係するそれらの追加メディア・データに対する参照370を識別する。次いで、相関器380により、例えば参照370を抽出メディア・データ350に埋め込むことによって、参照370を各レイヤの抽出メタデータ330および抽出メディア・データ350と関連付けて、対応するコンポーネント・ファイル390を作成する。

In this embodiment, a

上述のように、SVC/MVCの状況では、このような参照は、「抽出器」などの機構を用いることによって構築することができる。現在のところ、抽出器は、参照によってNALユニットを他のトラックから抽出することはできるが、同じ動画ボックス/フラグメント内から抽出することしかできない。換言すれば、抽出器を使用しても、別のセグメントまたはファイルからNALユニットを抽出することはできない。この制約により、他のケースの抽出器の使用は制限されている。以下、抽出器データ構造の拡張を開示するが、この拡張は、上述したSVC/MVCタイプの階層型ビデオ・コンテンツから複数のコンポーネント・ファイルへの効率的なカプセル化をサポートすることを目的とするものである。 As mentioned above, in the SVC / MVC context, such a reference can be constructed by using a mechanism such as an “extractor”. Currently, the extractor can extract NAL units from other tracks by reference, but only from within the same video box / fragment. In other words, using an extractor cannot extract NAL units from another segment or file. This restriction limits the use of extractors in other cases. In the following, an extension of the extractor data structure is disclosed, which is intended to support efficient encapsulation of the above-mentioned SVC / MVC type hierarchical video content into multiple component files. Is.

この拡張は、抽出器が存在する動画ボックス/フラグメントまたはコンポーネント・ファイルとは異なる動画ボックス/フラグメントまたはコンポーネント・ファイルに存在するNALユニットを参照する追加機能を有する抽出器データ構造を提供するために追加されるものである。 This extension was added to provide an extractor data structure with additional functionality to reference NAL units residing in a video box / fragment or component file that is different from the video box / fragment or component file in which the extractor resides It is what is done.

拡張された抽出器は、以下のように定義される。 The extended extractor is defined as follows:

シンタックス:

aligned (8) class DataEntryUrlBox (bit (24) flags)

extends FullBox ('url', version = 0, flags) {

string location;

}

aligned (8) class DataEntryUrnBox (bit (24) flags)

extends FullBox ('urn', version = 0, flags) {

string name;

string location;

}

class aligned (8) Extractor () {

NALUnitHeader ( );

DataEntryBox (entry_version, entry_flags) data_entry;// added extension

unsigned int(8) track_ref_index;

signed int(8) sample_offset;

unsigned int ((lengthSizeMinusOne + 1) * 8)

data_offset;

unsigned int ((lengthSizeMinusOne + 1) * 8)

data_length;

}

Syntax:

aligned (8) class DataEntryUrlBox (bit (24) flags)

extends FullBox ('url', version = 0, flags) {

string location;

}

aligned (8) class DataEntryUrnBox (bit (24) flags)

extends FullBox ('urn', version = 0, flags) {

string name;

string location;

}

class aligned (8) Extractor () {

NALUnitHeader ();

DataEntryBox (entry_version, entry_flags) data_entry; // added extension

unsigned int (8) track_ref_index;

signed int (8) sample_offset;

unsigned int ((lengthSizeMinusOne + 1) * 8)

data_offset;

unsigned int ((lengthSizeMinusOne + 1) * 8)

data_length;

}

セマンティクス:

data_entryは、統一資源ロケータ(URL)または統一資源名(URN)エントリである。名称はURNであり、URNエントリで必要である。位置はURLであり、URLエントリで必要であるが、URNエントリでは任意選択であり、所与の名称を有する資源が見つかる位置を与える。それぞれはUTF−8文字を用いたナル終了文字列である。自立フラグがセットされた場合には、URLフォームを使用し、文字列は存在せず、ボックスはエントリ・フラグ・フィールドで終了する。URLタイプは、ファイルを配信するサービスのものとする。相対URLは許容されるが、抽出器が属するトラックを含む動画ボックス/フラグメントを含むファイルに関するものである。

Semantics:

data_entry is a unified resource locator (URL) or unified resource name (URN) entry. The name is URN and is required in the URN entry. The location is a URL and is required in the URL entry, but is optional in the URN entry, giving the location where a resource with a given name is found. Each is a null-terminated character string using UTF-8 characters. If the independence flag is set, the URL form is used, there is no character string, and the box ends with the entry flag field. The URL type is a service for distributing files. Relative URLs are allowed, but relate to files containing video boxes / fragments containing the track to which the extractor belongs.

その他のフィールドは、前述の元の抽出器と同じセマンティクスを有する。 The other fields have the same semantics as the original extractor described above.

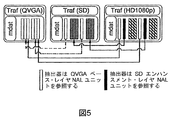

拡張された抽出器では、参照によって、抽出器が存在する動画ボックス/フラグメントとは異なる動画ボックス/フラグメントから、NALユニットを抽出することができる。図5は、このような例を示し、SVCビットストリームは図4と同じであるが、新たな拡張された抽出器データ構造を用いている。この図から分かるように、SDの動画フラグメントは、QVGAの動画フラグメントのNALユニットを参照することができる。同様に、HD1080pの動画フラグメントは、抽出器を使用して、QVGAおよびSDの両方の動画フラグメントのNALユニットを参照することができる。図4と比較すると、これらの動画フラグメントをまたいで複製されるNALユニットは存在せず、従って、記憶スペースが節約される。 In the extended extractor, by reference, the NAL unit can be extracted from a moving image box / fragment different from the moving image box / fragment in which the extractor exists. FIG. 5 shows such an example, where the SVC bitstream is the same as in FIG. 4 but uses a new extended extractor data structure. As can be seen from this figure, the NAL unit of the QVGA video fragment can be referred to for the SD video fragment. Similarly, HD 1080p video fragments can use an extractor to reference the NAL units of both QVGA and SD video fragments. Compared to FIG. 4, there are no NAL units replicated across these video fragments, thus saving storage space.

図6は、本発明の新しい抽出器データ構造を用いた、SVC/MVCタイプのビデオ・ビットストリームから複数の動画フラグメントまたはコンポーネント・ファイルへの関連するカプセル化動作を示す。このプロセスは、ステップ601で開始される。ステップ610で、各NALユニットを1つ1つ読み込む。ステップ620で、ビットストリームの末尾に到達した場合には、プロセスは、690で停止し、そうでない場合には、プロセスは、次のステップ630に進む。判断ステップ630では、現在のNALユニットが復号に際して他のトラックのNALユニットに依存するかどうかを判定する。この判定の結果が、現在のNALユニットが復号に際して他のトラックのNALユニットに依存しない場合には、制御はステップ640に移り、現在のNALユニットを用いてサンプルが形成され、現在のトラック中に配置される。ステップ630の判定の結果、現在のNALユニットと他のトラックのNALユニットの間に依存性がある場合には、プロセスは、ステップ650に進む。判断ステップ650では、現在のNALユニットによって必要とされるNALユニットのトラックが同じ動画フラグメント内に存在するかどうかをさらに判定する。この判定の結果、トラックが同じ動画フラグメント内に存在する場合には、ステップ670を利用して、拡張された抽出器に記入(fill in)して、当該他のトラックのNALユニットを参照する。判定の結果、トラックが別の動画フラグメント内に存在する場合には、ステップ660で、この動画フラグメントのURLまたはURNを識別し、この識別したURLおよびURNを拡張された抽出器に記入するものとして、プロセスは、ステップ670に進む。この拡張された抽出器は、記入後に、ステップ680で現在のトラックに埋め込まれる。その後、ステップ610で、次のNALユニットのプロセスが開始される。

FIG. 6 illustrates the associated encapsulation operation from a SVC / MVC type video bitstream to multiple video fragments or component files using the new extractor data structure of the present invention. The process begins at

別の実施例では、相関器380によって、参照370が抽出メタデータ330に埋め込まれ、参照370の指標が抽出メディア・データ350に付加される。相関器380は、さらに、各レイヤのメタデータとメディア・データを関連付けて、対応するコンポーネント・ファイル390を作成する。ISO Media Base File Formatの状況では、HTTPストリーミング情報ボックスと呼ばれるボックスが開示されている。このボックスは、ISOファイルのHTTPストリーミングを補助することができる情報を含む。HTTPストリーミング情報ボックスは、例えばファイルの冒頭など、できる限り早い段階でコンポーネント・ファイル中に配置されることが好ましい。このボックスは、サーバがクライアントに対するマニフェスト・ファイルを形成するときのソースとして機能することもできる。HTTPストリーミング情報ボックスに含まれる、メディア参照ボックスと呼ばれる別のタイプのボックスも、開示されている。このボックスは、外部依存ファイルに関する情報を含む。抽出器構造は、さらに、異なるコンポーネント・ファイルをまたいで複数のメディア・サンプルを参照することができるように拡張される。メディア参照ボックスに含まれる情報は、抽出器が信号通信のオーバヘッドを節約するために利用することができる。

In another embodiment,

提案したHTTPストリーミング情報ボックス、メディア参照ボックスおよびさらに改良された抽出器の詳細な定義は、以下の通りである。 Detailed definitions of the proposed HTTP streaming information box, media reference box and further improved extractor are as follows.

HTTPストリーミング情報ボックス

定義:

ボックス・タイプ:'hsin'

コンテナ:ファイル

必須:いいえ

量:0または1

HTTP streaming information box Definition:

Box type: 'hsin'

Container: File Required: No Quantity: 0 or 1

HTTPストリーミング情報ボックスは、ISOメディア・ファイルのHTTPストリーミング動作を補助する。HTTPストリーミング情報ボックスは、考えられる他のタイプのボックスの中でも特に、以下に定義するメディア参照ボックスを含む、ファイルのHTTPストリーミング配信に関する関連情報を含む。HTTPストリーミング情報ボックスは、可用性を最大限に高めるために、できる限り早い段階でファイル中に配置することが好ましい。 The HTTP streaming information box assists the HTTP streaming operation of the ISO media file. The HTTP streaming information box contains relevant information regarding HTTP streaming delivery of files, including the media reference box defined below, among other possible types of boxes. The HTTP streaming information box is preferably placed in the file as early as possible in order to maximize availability.

シンタックス:

aligned(8) class HTTPStreamingInfoBox extends Box ('hsin') {

}

Syntax:

aligned (8) class HTTPStreamingInfoBox extends Box ('hsin') {

}

メディア参照ボックス

定義:

ボックス・タイプ:'mref'

コンテナ:'hsin'

必須:いいえ

量:0または1

Media reference box Definition:

Box type: 'mref'

Container: 'hsin'

Required: No Quantity: 0 or 1

メディア参照ボックスは、HTTPストリーミング情報ボックスに含まれ、当該ボックス内に含まれる各トラックが依存する外部ファイルの位置を宣言するURLの形態をしたデータ参照のテーブルを含む。このボックスを読み取ることにより、ファイル読取り装置は、外部コンポーネント・ファイルなど、ファイル中のトラックの外部依存ファイル・ソースと、それらを取り出すための手段とを識別することができる。 The media reference box is included in the HTTP streaming information box and includes a data reference table in the form of a URL that declares the location of an external file on which each track included in the box depends. By reading this box, the file reader can identify the external dependent file sources of the tracks in the file, such as external component files, and the means for retrieving them.

シンタックス:

aligned(8) class DataEntryUrlBox ( bit(24) flags ) extends Box ( 'url') {

string location;

}

aligned(8) class MediaReferenceBox extends Box ('mref' ) {

unsigned int(16) entry_count;

for ( i = 1;i <= entry_count;i++) {

unsigned int(32) track_ID;

unsigned int(16) dependent_source_count;

for ( j = 1;j <= dependent_source_count;j++){

DataEntryUrlBox data_entry;

}

}

}

Syntax:

aligned (8) class DataEntryUrlBox (bit (24) flags) extends Box ('url') {

string location;

}

aligned (8) class MediaReferenceBox extends Box ('mref') {

unsigned int (16) entry_count;

for (i = 1; i <= entry_count; i ++) {

unsigned int (32) track_ID;

unsigned int (16) dependent_source_count;

for (j = 1; j <= dependent_source_count; j ++) {

DataEntryUrlBox data_entry;

}

}

}

セマンティクス:

entry_countは、実際のエントリをカウントした整数である。

track_IDは、ボックスが適用されるファイル中のトラックを一意に識別する整数である。

dependent_source_countは、track_IDを有するファイル中のトラックが依存する外部メディア・ソースをカウントした整数である。

data_entryは、指定されたトラックが依存する1つの外部メディア・ソースを指すURLエントリである。それぞれは、UTF−8文字を用いたナル終了文字列である。URLタイプは、ファイルを配信するサービスのものとする。相対URLは許容されるが、このメディア参照ボックスを含むファイルに関するものである。

Semantics:

entry_count is an integer obtained by counting actual entries.

track_ID is an integer that uniquely identifies the track in the file to which the box is applied.

The dependent_source_count is an integer that counts the external media source on which the track in the file with track_ID depends.

data_entry is a URL entry that points to one external media source on which the specified track depends. Each is a null-terminated character string using UTF-8 characters. The URL type is a service for distributing files. Relative URLs are allowed, but relate to the file containing this media reference box.

上記で定義したメディア参照ボックスは、複数のレイヤを含むメディア・エンティティのHTTPストリーミングをいくつかの方法で容易にするように設計される。 The media reference box defined above is designed to facilitate HTTP streaming of media entities containing multiple layers in several ways.

第1に、メディア参照ボックスは、参照テーブルによってコンポーネント・ファイルの冒頭でコンポーネント・ファイル間の依存関係を明示的に信号通信することができる。従って、クライアントは、コンポーネント・ファイルのわずかな部分を一度ダウンロードした後は、その1つまたは複数のトラックの関連する外部コンポーネント・ファイルを全て知ることができ、必要に応じて、テーブルに含まれる参照により、対応する要求を行って、1つまたは複数の完全なセットを再生のために取得することができる。 First, the media reference box can explicitly signal dependencies between component files at the beginning of the component file by means of a lookup table. Thus, once a client has downloaded a small portion of a component file, it can know all the associated external component files for that track or tracks, and if necessary, references included in the table Can make a corresponding request to obtain one or more complete sets for playback.

第2に、このボックスのファイル内情報は、容易に抽出して、マニフェスト・ファイルに含めることができる。この情報をマニフェスト中に含めることで、クライアントが実際のHTTPストリーミングより前に、関連サービス情報を発見し、例えば全ての関連コンポーネント・ファイルの要求や必要なバッファ資源の割当てなど対応するサービス初期化を実行するのを助けることができる。 Secondly, the in-file information in this box can be easily extracted and included in the manifest file. By including this information in the manifest, the client discovers the relevant service information prior to the actual HTTP streaming and performs the corresponding service initialization, eg requesting all relevant component files and allocating necessary buffer resources. Can help to perform.

第3に、クライアントは、コンポーネント・ファイルとして既に配信されている別の表現を有する、表現の異なる何らかのマルチコンポーネント・メディア・コンテンツを要求するときに、ファイル中の対応するメディア参照ボックスを確認して、そのファイルが再利用可能な新たな表現の任意の依存性コンポーネントを含むかどうかを調べることができる。 Third, when a client requests some multi-component media content with a different representation that has another representation already delivered as a component file, it checks the corresponding media reference box in the file. , Whether the file contains any dependency components of the new representation that can be reused.

最後に、このボックスは、以下のように定義された拡張された抽出器構造の信号通信のオーバヘッドを低減するのに役立つ。 Finally, this box helps to reduce the signaling overhead of the extended extractor structure defined as follows.

抽出器

抽出器は、さらに、外部メディア・ファイルのトラックのデータを参照する機能を拡張することが提案されている。

Extractor The extractor has also been proposed to extend the ability to refer to track data in external media files.

拡張シンタックス:

class aligned(8) Extractor ( ) {

NALUnitHeader ( );

unsigned int(16) media_reference_index;

unsigned int(8) track_ref_index;

signed int(8) sample_offset;

unsigned int ((lengthSizeMinusOne + 1) * 8)

data_offset;

unsigned int ((lengthSizeMinusOne + 1) * 8)

data_length;

}

Extended syntax:

class aligned (8) Extractor () {

NALUnitHeader ();

unsigned int (16) media_reference_index;

unsigned int (8) track_ref_index;

signed int (8) sample_offset;

unsigned int ((lengthSizeMinusOne + 1) * 8)

data_offset;

unsigned int ((lengthSizeMinusOne + 1) * 8)

data_length;

}

セマンティクス:

media_reference_index:抽出器を含むトラックと同じ関連するtrack_IDの値を有するメディア参照ボックスに含まれる参照テーブルのエントリの指標を指定する。media_reference_indexが0に等しい場合には、抽出器は、別のトラックのデータではあるが、抽出器と同じファイル内のデータを参照する。この場合には、このトラックと同じtrack_IDの値を有するメディア参照ボックス内の参照テーブルは存在しないものとする。media_reference_indexが、1から、メディア参照ボックスのトラックと関連付けられた参照テーブルのdependent_source_countの値までの間である場合には、参照テーブルのmedia_reference_indexによって参照されるURLが外部ファイルを指し、この外部ファイルが、抽出器がデータを抽出するトラックを含む。

Semantics:

media_reference_index: specifies the index of the reference table entry contained in the media reference box with the same associated track_ID value as the track containing the extractor. If media_reference_index is equal to 0, the extractor refers to data in the same file as the extractor, although it is data of another track. In this case, it is assumed that there is no reference table in the media reference box having the same track_ID value as this track. If media_reference_index is between 1 and the value of dependent_source_count in the reference table associated with the track in the media reference box, the URL referenced by the media_reference_index in the reference table points to the external file, and this external file is The extractor includes a track from which data is extracted.

他のフィールドのセマンティクスは、元の抽出器の定義と同じままである。 The semantics of the other fields remain the same as in the original extractor definition.

このさらに拡張された抽出器構造では、抽出器を使用して、外部コンポーネント・ファイルに属するトラックのデータにリンクしてこれを抽出することができる。これは、SVCやMVCで符号化されたものなど、1つの符号化されたマルチコンポーネント・メディア・コンテンツからのコンテンツ・コンポーネントを異なるコンポーネント・ファイルにカプセル化するときに、特に有用である。この拡張された抽出器では、ファイルの境界をまたいで抽出を行うことができる。これにより、異なるコンポーネント・ファイル中の同じデータを複製しなくても済む。 In this further expanded extractor structure, an extractor can be used to link and extract data for tracks belonging to an external component file. This is particularly useful when encapsulating content components from one encoded multi-component media content, such as those encoded with SVC or MVC, into different component files. This extended extractor can perform extraction across file boundaries. This eliminates the need to duplicate the same data in different component files.

図9は、開示したHTTPストリーミング情報ボックスおよびメディア参照ボックスならびに上記のさらに拡張された抽出器データ構造を用いた、SVC/MVCタイプのビデオ・ビットストリームから複数の動画フラグメントまたはコンポーネント・ファイルへの関連するカプセル化動作を示す。このプロセスは、上述のボックスおよび抽出器のさらなる拡張によるいくつかの修正点を除けば、図6に示すプロセスと同様である。ステップ660で位置情報URL/URNが識別された後で、ステップ965で、この位置情報を使用して、mrefボックス(メディア参照ボックス)中の参照テーブルに記入を行う。ステップ970で、さらに、参照テーブルの位置情報の指標を抽出器に記入する。次いで、抽出器を現在のトラックに埋め込む。ステップ620でビットストリームの末尾に到達している場合には、mrefボックスおよびそのコンテナhsinボックス(HTTPストリーミング情報ボックス)を、コンポーネント・ファイルのメタデータに埋め込む。

FIG. 9 shows the association of a SVC / MVC type video bitstream to multiple video fragments or component files using the disclosed HTTP streaming information box and media reference box and the above-extended extractor data structure described above. The encapsulating operation is shown. This process is similar to the process shown in FIG. 6 except for some modifications due to further expansion of the box and extractor described above. After the location information URL / URN is identified in

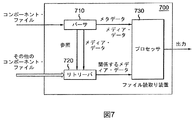

コンポーネント・ファイルを読み取るために、図7に示すファイル読取り装置700を利用する。パーサ710が、最初に、コンポーネント・ファイルを構文解析して、メタデータおよびメディア・データを取得し、入手可能であれば参照を取得する。復号した参照から、メディア・データが復号依存性などによって他のコンポーネント・ファイルのメディア・データに関係していることが分かった場合には、リトリーバ(retriever)720が、この関連するメディア・データを、参照に示されている他のコンポーネント・ファイルから取り出す。さらに、プロセッサ730は、コンポーネント・ファイルから取得したメタデータおよびメディア・データを処理し、入手可能であれば追加メディア・データも処理する。パーサ710による構文解析動作は、プロセッサ730のために用意されたメタデータおよびメディア・データ、ならびにリトリーバ720のために用意された参照を取得するために必要な様々な動作を含む。この構文解析動作は、必要に応じて、メタデータおよび/またはメディア・データをさらに構文解析することを含む。一実施例では、参照は、メディア・データに埋め込まれるので、メディア・データを構文解析することによって取得される。参照が入手可能である場合には、構文解析ステップは、参照のシンタックスを分析すること、および参照を復号することをさらに含む。プロセッサ730は、コンポーネント・ファイルがビデオ・コンテンツを含む場合には、ビデオ・デコーダを含むことができる。別の実施例では、パーサおよびリトリーバをプロセッサに組み込むこともできる。

In order to read the component file, a

図8は、本発明を含むビデオ・デコーダのSVC/MVCタイプ・ビデオ・ビットストリームを読み取るプロセスを示す。ステップ801で、コンポーネント・ビデオ・ファイルにアクセスし、ステップ805で、当該コンポーネント・ビデオ・ファイルの各レイヤのメタデータおよびメディア・データを識別する。ステップ810で、識別したメタデータおよびメディア・データを構文解析し、ステップ815で、メディア・データの各NALユニットを1つ1つ読み込む。現在のNALユニットについて、ステップ820で最初に判断を行い、ビットストリームの末尾に到達しているかどうかを判定し、その結果が「はい」である場合には、プロセスは、ステップ825で終了する。そうでない場合には、プロセスは、判断ステップ830に進み、現在のNALユニットが抽出器であるかどうかを判定する。現在のNALユニットが抽出器ではない場合には、それは現在のNALユニットが復号用データを含む通常のNALユニットであることを意味するので、ステップ835で、このNALユニットをデコーダに送信する。現在のNALユニットが抽出器である場合には、ステップ840で、現在のNALユニットが同じコンポーネント・ファイル外のNALユニットに依存するかどうかを判定する。必要とされるNALユニットが同じコンポーネント・ファイル内にある場合には、ステップ845で、そのNALユニットを現在のファイルから取り出し、ステップ835で、デコーダに送信する。必要とされるNALユニットが別のコンポーネント・ファイルのものである場合には、ステップ850で、抽出器中の参照情報Data_entryを用いてそのNALユニットを突き止め、ステップ855で遠隔ファイルから取り出し、その後、ステップ835でデコーダに送信する。

FIG. 8 illustrates the process of reading the SVC / MVC type video bitstream of the video decoder including the present invention. Step 801 accesses the component video file, and step 805 identifies the metadata and media data for each layer of the component video file. At

別の実施例では、パーサ710がメディア・データを構文解析することによって参照を識別して、埋め込まれた参照指標を得、これらの参照指標に従って対応する参照を取得する。ビデオ・デコーダのSVC/MVCタイプ・ビデオ・ビットストリームを読み取る対応するプロセスを、図10に示す。これは、図8のプロセスと同様である。好ましい実施例ではコンポーネント・ファイルの冒頭に参照が配置されるので、ステップ810のメタデータの構文解析により、その中に含まれる参照の分析をメディア・データの構文解析と並行して行うことが可能になる。参照を分析するときには、ステップ1014で、参照されたその他のコンポーネント・ファイルを識別する。これらのその他のコンポーネント・ファイルの取出しは、ステップ1012で、このプロセスの残りのステップと並行して開始される。ステップ850で、現在のNALユニットが依存するコンポーネント・ファイルの位置情報にアクセスした後で、このコンポーネント・ファイルを入手することができるかどうか、メディア・バッファなどのローカル記憶装置を確認する。必要なコンポーネント・ファイルがローカルで入手できる場合には、そのローカル・コピーのNALユニットを取り出し、そうでない場合には、遠隔ファイルのNALユニットを取り出す。なお、このコンポーネント・ファイルのローカル・コピーは、ステップ1012で並行取出しによって取得してもよいし、このコンポーネント・ファイルの以前の要求から取得してもよいことに留意されたい。

In another embodiment,

本明細書では、本発明の好ましい実施例について詳細に説明したが、本発明はこれらの実施例に限定されるわけではないこと、および当業者なら、添付の特許請求の範囲に定義する本発明の範囲を逸脱することなく、その他の修正形態および変形形態を実施することができることを理解されたい。 Although the present invention has been described in detail with reference to preferred embodiments thereof, it is to be understood that the invention is not limited to these embodiments and that those skilled in the art will recognize the invention as defined in the appended claims. It should be understood that other modifications and variations can be made without departing from the scope thereof.

Claims (37)

前記メディア・エンティティから各レイヤのメタデータを抽出するステップと、

前記メディア・エンティティから、前記メディア・エンティティの各レイヤの前記抽出したメタデータに対応するメディア・データを抽出するステップと、

前記抽出したメディア・データを前記抽出したメタデータと関連付けて、前記抽出したメタデータおよび前記抽出したメディア・データを含むコンポーネント・ファイルを前記各レイヤに作成することを可能にするステップと、を含む、前記方法。 A method of creating a component file from a media entity containing multiple layers,

Extracting metadata for each layer from the media entity;

Extracting from the media entity media data corresponding to the extracted metadata of each layer of the media entity;

Associating the extracted media data with the extracted metadata to enable creation of component files including the extracted metadata and the extracted media data in each of the layers. , Said method.

対応するコンポーネント・ファイルの作成のため、各レイヤの前記抽出したメディア・データと前記追加メディア・データとを関連付けるステップと、をさらに含む、請求項1に記載の方法。 Extracting additional media data related to the extracted media data of each layer from the media entity to each layer;

The method of claim 1, further comprising associating the extracted media data and the additional media data for each layer for creation of a corresponding component file.

対応するコンポーネント・ファイルの作成のため、前記参照を、各レイヤの前記抽出したメタデータおよび前記抽出したメディア・データと関連付けるステップと、をさらに含む、請求項1に記載の方法。 Identifying additional media data references related to the extracted media data for each layer;

The method of claim 1, further comprising associating the reference with the extracted metadata and the extracted media data for each layer to create a corresponding component file.

前記参照の指標を前記抽出したメディア・データに付加するステップと、をさらに含む、請求項4に記載の方法。 Embedding the reference in the extracted metadata of each layer;

The method of claim 4, further comprising: adding the reference indication to the extracted media data.

前記メディア・エンティティから各レイヤのメタデータを抽出し、前記メディア・エンティティから前記メディア・エンティティの各レイヤの前記抽出したメタデータに対応するメディア・データを抽出する抽出器と、

前記抽出したメディア・データを前記抽出したメタデータと関連付けて、前記抽出したメタデータおよび前記抽出したメディア・データを含むコンポーネント・ファイルを前記各レイヤに作成することを可能にする相関器とを含む、前記ファイル・カプセル化装置。 A file encapsulation device that creates a component file from a media entity containing multiple layers,

An extractor that extracts metadata of each layer from the media entity and extracts media data corresponding to the extracted metadata of each layer of the media entity from the media entity;

A correlator that associates the extracted media data with the extracted metadata and that enables creation of component files including the extracted metadata and the extracted media data in each of the layers. The file encapsulation device.

前記相関器が、さらに、各レイヤの前記抽出したメディア・データと前記追加メディア・データとを関連付けて、対応するコンポーネント・ファイルを作成する、請求項11に記載のファイル・カプセル化装置。 The extractor further extracts, for each layer, additional media data related to the extracted media data of each layer from the media entity;

12. The file encapsulation device according to claim 11, wherein the correlator further associates the extracted media data and the additional media data of each layer to create a corresponding component file.

前記コンポーネント・ファイルを構文解析して、メタデータ、メディア・データおよび参照を取得するステップと、

前記参照によれば、前記コンポーネント・ファイルの前記メディア・データがその他のコンポーネント・ファイルのメディア・データに関係している場合に、前記参照を用いて前記その他のコンポーネント・ファイルから前記関係するメディア・データを取り出すステップと、を含む、方法。 A method of reading a component file,

Parsing the component file to obtain metadata, media data and references;

According to the reference, when the media data of the component file is related to media data of another component file, the related media Retrieving the data.

前記参照指標に従って対応する参照を取得するステップと、をさらに含む、請求項25に記載の方法。 Parsing the media data to obtain a reference index embedded therein;

26. The method of claim 25, further comprising: obtaining a corresponding reference according to the reference index.

前記参照に従って、前記その他のコンポーネント・ファイルを並列に取り出すステップを含む、請求項25に記載の方法。 Said removing step comprises:

26. The method of claim 25, comprising retrieving the other component file in parallel according to the reference.

ローカルなファイル記憶装置を確認するステップと、

前記ローカルなファイル記憶装置が前記その他のコンポーネント・ファイルを含む場合に、前記ローカルな記憶装置から前記その他のコンポーネント・ファイルを取り出すステップと、をさらに含む、請求項27に記載の方法。 Said removing step comprises:

Checking the local file storage;

28. The method of claim 27, further comprising retrieving the other component file from the local storage device if the local file storage device includes the other component file.

前記参照に従って、その他のコンポーネント・ファイルから前記メディア・データに関係するメディア・データを取り出すリトリーバと、

前記メタデータ、前記メディア・データ、および前記その他のコンポーネント・ファイルから取り出したメディア・データを処理するプロセッサと、を含む、ファイル読取り装置。 A parser that parses component files to obtain metadata, media data, and references;

A retriever for retrieving media data related to the media data from other component files according to the reference;

A processor for processing media data retrieved from the metadata, the media data, and the other component files.

Applications Claiming Priority (5)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| US35442210P | 2010-06-14 | 2010-06-14 | |

| US35442410P | 2010-06-14 | 2010-06-14 | |

| US61/354,424 | 2010-06-14 | ||

| US61/354,422 | 2010-06-14 | ||

| PCT/US2011/040168 WO2011159605A1 (en) | 2010-06-14 | 2011-06-13 | Method and apparatus for encapsulating coded multi-component video |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2013532441A true JP2013532441A (en) | 2013-08-15 |

| JP2013532441A5 JP2013532441A5 (en) | 2014-07-24 |

Family

ID=44454826

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2013515413A Pending JP2013532441A (en) | 2010-06-14 | 2011-06-13 | Method and apparatus for encapsulating encoded multi-component video |

Country Status (6)

| Country | Link |

|---|---|

| EP (1) | EP2580920A1 (en) |

| JP (1) | JP2013532441A (en) |

| KR (1) | KR20130088035A (en) |

| CN (1) | CN103098484A (en) |

| BR (1) | BR112012031874A2 (en) |

| WO (1) | WO2011159605A1 (en) |

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2017515336A (en) * | 2014-03-25 | 2017-06-08 | キヤノン株式会社 | Method, device, and computer program for improving streaming of segmented timed media data |

Families Citing this family (10)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US9432433B2 (en) | 2006-06-09 | 2016-08-30 | Qualcomm Incorporated | Enhanced block-request streaming system using signaling or block creation |

| US9917874B2 (en) | 2009-09-22 | 2018-03-13 | Qualcomm Incorporated | Enhanced block-request streaming using block partitioning or request controls for improved client-side handling |

| WO2012010928A1 (en) | 2010-07-20 | 2012-01-26 | Nokia Corporation | A media streaming apparatus |

| EP2680527A1 (en) * | 2012-06-28 | 2014-01-01 | Alcatel-Lucent | Adaptive streaming aware node, encoder and client enabling smooth quality transition |

| US9202350B2 (en) | 2012-12-19 | 2015-12-01 | Nokia Technologies Oy | User interfaces and associated methods |

| JP2014230055A (en) * | 2013-05-22 | 2014-12-08 | ソニー株式会社 | Content supply device, content supply method, program, and content supply system |

| GB2527786B (en) | 2014-07-01 | 2016-10-26 | Canon Kk | Method, device, and computer program for encapsulating HEVC layered media data |

| GB2538998A (en) * | 2015-06-03 | 2016-12-07 | Nokia Technologies Oy | A method, an apparatus, a computer program for video coding |

| GB2538997A (en) | 2015-06-03 | 2016-12-07 | Nokia Technologies Oy | A method, an apparatus, a computer program for video coding |

| GB2579389B (en) * | 2018-11-29 | 2022-07-27 | Canon Kk | Method, device and computer program for encapsulating media data into a media file |

Citations (5)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| WO2004008759A1 (en) * | 2002-07-12 | 2004-01-22 | Matsushita Electric Industrial Co., Ltd. | Data processing device |

| JP2009502055A (en) * | 2005-07-15 | 2009-01-22 | ソニー株式会社 | Change file format, file server, data processing system, and data extraction method |

| JP2009503950A (en) * | 2005-07-19 | 2009-01-29 | アップル インコーポレイテッド | Media data transmission method and apparatus |

| JP2009506475A (en) * | 2005-08-31 | 2009-02-12 | リサーチ・アンド・インダストリアル・コーオペレイション・グループ | Integrated multimedia file format structure and multimedia service system and method based on the integrated multimedia file format structure |

| JP2009522984A (en) * | 2006-01-09 | 2009-06-11 | 韓國電子通信研究院 | SVC file data sharing method and file |

Family Cites Families (3)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| AU2003213555B2 (en) * | 2002-02-25 | 2008-04-10 | Sony Electronics, Inc. | Method and apparatus for supporting AVC in MP4 |

| KR101198583B1 (en) * | 2005-10-12 | 2012-11-06 | 한국과학기술원 | Apparatus of multimedia middle ware using metadata and management method and storing medium thereof |

| JP2013534101A (en) * | 2010-06-14 | 2013-08-29 | トムソン ライセンシング | Method and apparatus for encapsulating encoded multi-component video |

-

2011

- 2011-06-13 KR KR1020127032653A patent/KR20130088035A/en not_active Application Discontinuation

- 2011-06-13 BR BR112012031874A patent/BR112012031874A2/en not_active IP Right Cessation

- 2011-06-13 EP EP11727605.5A patent/EP2580920A1/en not_active Withdrawn

- 2011-06-13 WO PCT/US2011/040168 patent/WO2011159605A1/en active Application Filing

- 2011-06-13 JP JP2013515413A patent/JP2013532441A/en active Pending

- 2011-06-13 CN CN2011800293844A patent/CN103098484A/en active Pending

Patent Citations (5)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| WO2004008759A1 (en) * | 2002-07-12 | 2004-01-22 | Matsushita Electric Industrial Co., Ltd. | Data processing device |

| JP2009502055A (en) * | 2005-07-15 | 2009-01-22 | ソニー株式会社 | Change file format, file server, data processing system, and data extraction method |

| JP2009503950A (en) * | 2005-07-19 | 2009-01-29 | アップル インコーポレイテッド | Media data transmission method and apparatus |

| JP2009506475A (en) * | 2005-08-31 | 2009-02-12 | リサーチ・アンド・インダストリアル・コーオペレイション・グループ | Integrated multimedia file format structure and multimedia service system and method based on the integrated multimedia file format structure |

| JP2009522984A (en) * | 2006-01-09 | 2009-06-11 | 韓國電子通信研究院 | SVC file data sharing method and file |

Non-Patent Citations (1)

| Title |

|---|

| GRUENEBERG K ET AL., DELIVERABLE D3.2 MVC/SVC STORAGE FORMAT, JPN5013010627, 29 January 2009 (2009-01-29), pages 1 - 34, ISSN: 0003039522 * |

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2017515336A (en) * | 2014-03-25 | 2017-06-08 | キヤノン株式会社 | Method, device, and computer program for improving streaming of segmented timed media data |

Also Published As

| Publication number | Publication date |

|---|---|

| WO2011159605A1 (en) | 2011-12-22 |

| BR112012031874A2 (en) | 2017-11-28 |

| KR20130088035A (en) | 2013-08-07 |

| CN103098484A (en) | 2013-05-08 |

| EP2580920A1 (en) | 2013-04-17 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP2013532441A (en) | Method and apparatus for encapsulating encoded multi-component video | |

| KR102125162B1 (en) | Media encapsulation and decapsulation techniques | |

| CN113170239B (en) | Method, apparatus and storage medium for encapsulating media data into media files | |

| KR20180018662A (en) | A method, device, and computer program product for obtaining media data and metadata from an encapsulated bit-stream from which an operating point descriptor may be dynamically set | |

| US20130097334A1 (en) | Method and apparatus for encapsulating coded multi-component video | |

| WO2012032502A1 (en) | A method and apparatus for adaptive streaming | |

| JP7249413B2 (en) | Method, apparatus and computer program for optimizing transmission of portions of encapsulated media content | |

| US20130091154A1 (en) | Method And Apparatus For Encapsulating Coded Multi-Component Video | |

| GB2593897A (en) | Method, device, and computer program for improving random picture access in video streaming | |

| US11403804B2 (en) | Method for real time texture adaptation | |

| JP7241874B2 (en) | Method, apparatus, and computer program for signaling available portions of encapsulated media content | |

| GB2599170A (en) | Method, device, and computer program for optimizing indexing of portions of encapsulated media content data | |

| JP2013534101A (en) | Method and apparatus for encapsulating encoded multi-component video | |

| WO2020012070A1 (en) | An apparatus, a method and a computer program for video coding and decoding | |

| EP4068781A1 (en) | File format with identified media data box mapping with track fragment box | |

| US20230336602A1 (en) | Addressable resource index events for cmaf and dash multimedia streaming | |

| GB2620582A (en) | Method, device, and computer program for improving indexing of portions of encapsulated media data | |

| JP2022546894A (en) | Method, apparatus, and computer program for encapsulating media data into media files |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20140604 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20140604 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20150212 |

|

| RD04 | Notification of resignation of power of attorney |

Free format text: JAPANESE INTERMEDIATE CODE: A7424 Effective date: 20150226 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20150401 |

|

| A02 | Decision of refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A02 Effective date: 20150902 |