JP2005234337A - 音声合成装置、音声合成方法、及び音声合成プログラム - Google Patents

音声合成装置、音声合成方法、及び音声合成プログラム Download PDFInfo

- Publication number

- JP2005234337A JP2005234337A JP2004044852A JP2004044852A JP2005234337A JP 2005234337 A JP2005234337 A JP 2005234337A JP 2004044852 A JP2004044852 A JP 2004044852A JP 2004044852 A JP2004044852 A JP 2004044852A JP 2005234337 A JP2005234337 A JP 2005234337A

- Authority

- JP

- Japan

- Prior art keywords

- phoneme

- information

- voice quality

- formant

- speech

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Pending

Links

Images

Classifications

-

- E—FIXED CONSTRUCTIONS

- E02—HYDRAULIC ENGINEERING; FOUNDATIONS; SOIL SHIFTING

- E02D—FOUNDATIONS; EXCAVATIONS; EMBANKMENTS; UNDERGROUND OR UNDERWATER STRUCTURES

- E02D29/00—Independent underground or underwater structures; Retaining walls

- E02D29/02—Retaining or protecting walls

- E02D29/025—Retaining or protecting walls made up of similar modular elements stacked without mortar

-

- E—FIXED CONSTRUCTIONS

- E02—HYDRAULIC ENGINEERING; FOUNDATIONS; SOIL SHIFTING

- E02D—FOUNDATIONS; EXCAVATIONS; EMBANKMENTS; UNDERGROUND OR UNDERWATER STRUCTURES

- E02D29/00—Independent underground or underwater structures; Retaining walls

- E02D29/02—Retaining or protecting walls

- E02D29/0258—Retaining or protecting walls characterised by constructional features

- E02D29/0266—Retaining or protecting walls characterised by constructional features made up of preformed elements

-

- A—HUMAN NECESSITIES

- A01—AGRICULTURE; FORESTRY; ANIMAL HUSBANDRY; HUNTING; TRAPPING; FISHING

- A01G—HORTICULTURE; CULTIVATION OF VEGETABLES, FLOWERS, RICE, FRUIT, VINES, HOPS OR SEAWEED; FORESTRY; WATERING

- A01G9/00—Cultivation in receptacles, forcing-frames or greenhouses; Edging for beds, lawn or the like

- A01G9/02—Receptacles, e.g. flower-pots or boxes; Glasses for cultivating flowers

- A01G9/022—Pots for vertical horticulture

- A01G9/025—Containers and elements for greening walls

-

- E—FIXED CONSTRUCTIONS

- E02—HYDRAULIC ENGINEERING; FOUNDATIONS; SOIL SHIFTING

- E02D—FOUNDATIONS; EXCAVATIONS; EMBANKMENTS; UNDERGROUND OR UNDERWATER STRUCTURES

- E02D2600/00—Miscellaneous

- E02D2600/20—Miscellaneous comprising details of connection between elements

Abstract

【課題】 ハードウェア資源に大きな制約が課されている環境下においても、様々な種類の声質の合成音声を生成することができる音声合成装置等を提供する。

【解決手段】 1種類の音韻データを備えた音声合成装置100に声質変更部250及び声質データベース260を設ける。声質変更部250は、テキスト解析部220から供給される声質データ番号を検索キーとして声質データベース260を検索し、声質パラメータを取得する。声質変更部250は、取得した声質パラメータに基づいて、音韻データ取得部230によって取得される音韻データに示される各音韻の声質を変更する。

【選択図】 図1

Description

本発明は、入力されるテキスト情報から合成音声を生成する音声合成装置、音声合成方法、及び音声合成プログラムに関する。

図17は、入力されるテキスト情報から合成音声を生成する従来の音声合成装置100の構成を示す図である。

入力部110は、図示せぬ操作部等から「こんにちわ」等のテキスト情報を受け取ると、このテキスト情報をテキスト解析部120に供給する。テキスト解析部120は、受け取ったテキスト情報について、単語辞書等を用いて単語解析、構文解析等を行い、「こ」、「ん」、「に」、「ち」、「わ」といったモーラ単位の各音韻をあらわす音韻情報、及び各音韻の長さ、高さ、強さをあらわす韻律情報を生成し、音声合成部130に供給する。音声合成部130は、テキスト解析部120から供給される各音韻情報に基づいて、モーラ単位の音声データ(以下、音韻データ)を音韻データベース140から取得する。そして、音声合成部130は、取得した各音韻データを韻律情報に従って適宜加工・接続等して合成音声信号を生成し、スピーカ等から合成音声として出力する。ユーザは、音声合成装置から出力される合成音声を聴取することで、入力されたテキスト情報の内容を確認することができる。

入力部110は、図示せぬ操作部等から「こんにちわ」等のテキスト情報を受け取ると、このテキスト情報をテキスト解析部120に供給する。テキスト解析部120は、受け取ったテキスト情報について、単語辞書等を用いて単語解析、構文解析等を行い、「こ」、「ん」、「に」、「ち」、「わ」といったモーラ単位の各音韻をあらわす音韻情報、及び各音韻の長さ、高さ、強さをあらわす韻律情報を生成し、音声合成部130に供給する。音声合成部130は、テキスト解析部120から供給される各音韻情報に基づいて、モーラ単位の音声データ(以下、音韻データ)を音韻データベース140から取得する。そして、音声合成部130は、取得した各音韻データを韻律情報に従って適宜加工・接続等して合成音声信号を生成し、スピーカ等から合成音声として出力する。ユーザは、音声合成装置から出力される合成音声を聴取することで、入力されたテキスト情報の内容を確認することができる。

ところが、上記音韻データベースには、特定話者(例えば、男性話者)による1種類の音韻データしか登録されていない。このため、例えば若い女性等が好んで使用するであろうテキスト情報(「ちょう・・・的」や「・・・みたいなぁ」等のテキスト情報)を、上記特定話者の声質を有する合成音声で出力した場合には、ユーザは声質と音声内容との間に違和感を感じてしまう等の問題があった。

かかる問題を解消するべく、複数種類の音韻データ(例えば、男性、女性、子供、老人のそれぞれの音韻データ)を音韻データベースに予め登録し、入力されるテキスト情報の内容等に応じて最適な音韻データを選択し、選択した音韻データを用いて合成音声を生成する技術が提案されている(例えば、特許文献1参照)。

特許文献1に開示された技術によれば、確かに適切な合成音声を得ることができるが、これを実現するためには複数種類の音韻データを音韻データベースに登録しなければならない。しかしながら、メモリやCPU等のハードウェア資源に大きな制約が課されている携帯端末等にこのような複数種類の音韻データを実装することはできず、結局、携帯端末等においては様々な声質の合成音声を生成することができないという問題があった。

本発明は、以上説明した事情を鑑みてなされたものであり、ハードウェア資源に大きな制約が課されている環境下においても、様々な種類の声質の合成音声を生成することができる音声合成装置、音声合成方法、及び音声合成プログラムを提供することを目的とする。

上述した問題を解決するため、本発明に係る音声合成装置は、入力されるテキスト情報から、合成音声の音韻を指定する音韻指定情報及び該合成音声の声質を指定する声質指定情報を取得する取得手段と、特定話者の各音韻をあらわす一連の音韻データを記憶する第1記憶手段と、前記各音韻の声質を変更するために必要な情報であって、音韻データの加工内容をあらわす音韻データ加工情報を複数種類記憶する第2記憶手段と、前記第1記憶手段から、前記音韻指定情報に示される音韻に対応する音韻データを抽出する第1抽出手段と、前記第2記憶手段から、前記声質指定情報に示される声質に対応する音韻データ加工情報を抽出する第2抽出手段と、前記抽出された音韻データを、前記抽出された音韻データ加工情報に基づいて加工し、前記合成音声を生成する生成手段とを具備することを特徴とする。

かかる構成によれば、第1抽出手段によって抽出された音韻データが第2抽出手段によって抽出された音韻データ加工情報に基づいて加工され、これにより、合成音声が生成される。この音韻データ加工情報に様々な加工条件(例えば、音韻のフォルマントの変更内容等)を設定することで、1種類の音韻データ(例えば、男性話者の音韻データ)から様々な音質の合成音声を得ることが可能となる。

ここで、上記構成にあっては、前記各音韻データは、それぞれ対応する音韻のフォルマントを複数備え、前記音韻データ加工情報には、前記フォルマントの変更内容をあらわすフォルマント変更情報が含まれ、前記生成手段は、前記音韻データに示される音韻の各フォルマントを、前記フォルマント変更情報に基づいて変更し、変更後の各フォルマントを加算した後の信号波形に基づいて前記合成音声を生成する態様が好ましい。

これに加え、前記フォルマントは、フォルマント周波数とフォルマントレベルとの対によって構成され、前記フォルマント変更情報には、前記フォルマント周波数の変更内容をあらわすフォルマント周波数変更情報と前記フォルマントレベルの変更内容をあらわすフォルマントレベル変更情報が含まれ、前記生成手段は、前記音韻データに示される音韻の各フォルマント周波数と各フォルマントレベルのそれぞれを、前記フォルマント周波数変更情報及び前記フォルマントレベル変更情報に基づいて変更することにより、前記変更後の各フォルマントを得る態様がより好ましい。

これに加え、前記フォルマントは、フォルマント周波数とフォルマントレベルとの対によって構成され、前記フォルマント変更情報には、前記フォルマント周波数の変更内容をあらわすフォルマント周波数変更情報と前記フォルマントレベルの変更内容をあらわすフォルマントレベル変更情報が含まれ、前記生成手段は、前記音韻データに示される音韻の各フォルマント周波数と各フォルマントレベルのそれぞれを、前記フォルマント周波数変更情報及び前記フォルマントレベル変更情報に基づいて変更することにより、前記変更後の各フォルマントを得る態様がより好ましい。

また、前記取得手段は、前記テキスト情報から前記音韻指定情報及び前記声質指定情報を取得するほか、前記合成音声のピッチを指定するピッチ指定情報を取得し、前記生成手段は、前記変更後の各フォルマントを加算した後の信号波形に対して前記ピッチ指定情報に示されるピッチを与えることにより、前記合成音声を得る態様も好ましい。

以上説明したように、本発明によれば、ハードウェア資源に大きな制約が課されている環境下においても、様々な種類の声質の合成音声を生成することが可能となる。

以下、本発明に係る実施の形態について図面を参照しながら説明する。

A.本実施形態

図1は、本実施形態に係る音声合成装置100の機能構成を示す図である。なお、本実施形態では、携帯電話やPHS(Personal Handyphone System)、PDA(Personal Digital Assistance)などハードウェア資源に大きな制約が課される携帯端末に実装される場合を想定するが、これに限らず様々な電子機器に適用可能である。

A.本実施形態

図1は、本実施形態に係る音声合成装置100の機能構成を示す図である。なお、本実施形態では、携帯電話やPHS(Personal Handyphone System)、PDA(Personal Digital Assistance)などハードウェア資源に大きな制約が課される携帯端末に実装される場合を想定するが、これに限らず様々な電子機器に適用可能である。

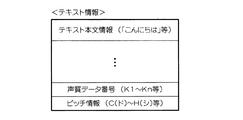

入力部210は、図示せぬ操作部等を介して入力されるテキスト情報をテキスト解析部220に供給する。図2は、テキスト情報を例示した図である。

テキスト本文情報は、合成音声として出力すべきテキストの内容(例えば「こんにちわ」)をあらわす情報である。なお、図2ではひらがなのみによって表されたテキスト本文情報を示しているが、ひらがなのみならず、漢字、ローマ字、カタカナ等の各種文字や各種記号によって表されたものであっても良い。

テキスト本文情報は、合成音声として出力すべきテキストの内容(例えば「こんにちわ」)をあらわす情報である。なお、図2ではひらがなのみによって表されたテキスト本文情報を示しているが、ひらがなのみならず、漢字、ローマ字、カタカナ等の各種文字や各種記号によって表されたものであっても良い。

声質データ番号(声質指定情報)は、後述する複数の声質パラメータ(音韻データ加工情報)をそれぞれ識別するためのユニークな番号(図2では、K1〜Kn)である。本実施形態では、この声質パラメータを適宜選択・利用することで、特定話者(本実施形態では、「男性話者」を想定)による1種類の音韻データから、様々な声質の合成音声を得ることが可能となる(詳細は後述)。

ピッチ情報(ピッチ指定情報)は、合成音声にピッチを与える(いいかえれば、合成音声のピッチを指定する)ための情報であり、「C(ド)」〜「H(シ)」等の音階を指定する情報によって構成されている(図2参照)。

テキスト解析部220は、入力部210から供給されるテキスト情報を解析し、解析結果を音韻データ取得部230、声質変更部250、音声信号生成部270にそれぞれ供給する。具体的には、図2に示すようなテキスト情報が供給されると、テキスト解析部220は、まず、「こんにちわ」といったテキスト本文情報を「こ」、「ん」、「に」、「ち」、「わ」といったモーラ単位の音韻に分解する。なお、モーラとは、読みの単位をあらわし、基本的には1つの子音と1つの母音から構成されるものをいう。

テキスト解析部(取得手段)220は、このようにしてテキスト本文情報をモーラ単位の音韻に分解すると、これら合成音声の各音韻を指定する音韻情報(音韻指定情報)を生成し、音韻データ取得部230に順次供給する。さらに、テキスト解析部220は、声質データ番号(例えばK3)、ピッチ情報(例えばC(ド))をテキスト情報からそれぞれ取得し、取得した声質データ番号を声質変更部250に供給する一方、取得したピッチ情報を音声信号生成部270に供給する。

音韻データ取得部(第1抽出手段)230は、テキスト解析部220から供給される音韻情報を検索キーとして音韻データベース240を検索することにより、音韻情報に示される音韻に対応する音韻データを取得する。図3は、音韻データベース240の登録内容を例示した図である。図3に示すように、音韻データベース(第1記憶手段)240には、1人の男性話者のモーラ単位の各音韻(「あ」、「い」、・・・「ん」等)をあらわす一連の音韻データ1〜mが登録されるほか、該一連の音韻データの数(以下、登録音韻データ数)等が登録されている。

図4は、ある音韻(例えば「こ」等)をあらわす音韻データの構成を例示した図であり、図5は、音韻データに含まれる各フレーム情報を説明するための図である。なお、図5のAは、上記男性話者がある音韻(例えば「こ」等)を発声したときの音声波形vwと各フレームFRとの関係を示しており、図5のB、図5のC、図5のDは、それぞれ第1フレームFR1、第2フレームFR2、第nフレームFRnに係るフォルマント分析結果を示している。

図4に示すように、音韻データは、第1フレーム情報〜第nフレーム情報によって構成されている。各フレーム情報は、対応する各フレームFR(図5参照)をフォルマント分析することにより得られる第1フォルマント情報〜第kフォルマント情報と、各フレームFRの音声が有声であるか無声であるかをあらわす有声/無声判別フラグ(例えば、“1”=有声、“0”=無声)とを備えている。

各フレーム情報を構成する第1フォルマント情報〜第kフォルマント情報は、対応するフォルマントをあらわすフォルマント周波数FとフォルマントレベルAとの対によって構成されている(図5のB〜図5のD参照)。例えば、第1フレーム情報を構成する第1フォルマント情報〜第kフォルマント情報は、それぞれ(F11、A11)、(F12、A12)、・・・(F1k、A1k)といったフォルマント周波数とフォルマントレベルとの対によって構成され(図5のB参照)、・・・第nフレーム情報を構成する第1フォルマント情報〜第kフォルマント情報は、それぞれ(Fn1、An1)、(Fn2、An2)、・・・(Fnk、Ank)といったフォルマント周波数とフォルマントレベルとの対によって構成される(図5のD参照)。

音韻データ取得部230は、テキスト解析部220から供給される各音韻情報(「こ」、「ん」、「に」、「ち」、「わ」等をあらわす各音韻情報)に基づいて対応する各音韻データを取得すると、これらを声質変更部250に供給する。

声質変更部250は、音韻データ取得部230によって取得された各音韻データに示される音韻の声質を変更する。詳述すると、声質変更部(第2抽出手段)250は、まず、テキスト解析部220から供給される声質データ番号を検索キーとして声質データベース(第2記憶手段)260を検索し、対応する声質パラメータを取得する。そして、声質変更部250は、取得した声質パラメータに基づいて、上記各音韻の声質の変更を行う。

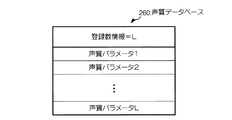

図6は、声質データベース260の登録内容を例示した図である。

図6に示すように、声質データベース(第2記憶手段)260には、上記各音韻の声質を変更するために必要な情報であって、音韻データの加工内容をあらわす複数種類の声質パラメータ1〜Lと、該声質パラメータの数をあらわす登録数情報とが格納されている。

図6に示すように、声質データベース(第2記憶手段)260には、上記各音韻の声質を変更するために必要な情報であって、音韻データの加工内容をあらわす複数種類の声質パラメータ1〜Lと、該声質パラメータの数をあらわす登録数情報とが格納されている。

図7は、声質パラメータの構成の一例を示す図である。

図7に示すように、声質パラメータ(音韻データ加工情報)は、当該パラメータを特定するための声質データ番号と、合成音声の性別を変更するか否かをあらわす性別変更フラグと、第1〜第kフォルマントの変更内容をあらわす第1〜第kフォルマント変更情報とを備えている。ここで、例えば上記性別変更フラグが“1”に設定されている場合には、声質変更部250によって合成音声の性別を変更するための処理(以下、性別変更処理)が行われる一方、上記性別変更フラグが“0”に設定されている場合には、上記性別変更処理は行われない(詳細は後述)。なお、本実施形態では、男性話者による1種類の音韻データを想定しているため、この性別変更フラグが“1”に設定されている場合には、合成音声の特徴は男性的なものから女性的なものに変更される。一方、性別変更フラグが“0”に設定されている場合には、合成音声の特徴は男性的なもののまま変更されない。

図7に示すように、声質パラメータ(音韻データ加工情報)は、当該パラメータを特定するための声質データ番号と、合成音声の性別を変更するか否かをあらわす性別変更フラグと、第1〜第kフォルマントの変更内容をあらわす第1〜第kフォルマント変更情報とを備えている。ここで、例えば上記性別変更フラグが“1”に設定されている場合には、声質変更部250によって合成音声の性別を変更するための処理(以下、性別変更処理)が行われる一方、上記性別変更フラグが“0”に設定されている場合には、上記性別変更処理は行われない(詳細は後述)。なお、本実施形態では、男性話者による1種類の音韻データを想定しているため、この性別変更フラグが“1”に設定されている場合には、合成音声の特徴は男性的なものから女性的なものに変更される。一方、性別変更フラグが“0”に設定されている場合には、合成音声の特徴は男性的なもののまま変更されない。

一方、各フォルマント変更情報は、後述する各フォルマントの基本波形(正弦波等)を選択するための基本波形選択情報と、各フォルマント周波数の変更内容をあらわすフォルマント周波数変更情報と、フォルマント周波数の各レベルの変更内容をあわすフォルマントレベル変更情報とを備えている。

各フォルマント周波数変更情報及び各フォルマントレベル変更情報には、それぞれフォルマント周波数のシフト量、発振速度、発振レベルをあらわす情報及びフォルマントレベルのシフト量、発振速度、発振レベルをあらわす情報が含まれている。なお、フォルマント周波数及びフォルマントレベルのシフト量、発振速度、発振レベルに関する詳細は後述する。

図8は、声質変更部250によって実行される声質変更処理を示すフローチャートである。

声質変更部(生成手段)250は、テキスト解析部220から声質データ番号を受け取ると、該声質データ番号を検索キーとして声質データベース260を検索し、対応する声質パラメータを取得する(ステップS1)。そして、声質変更部250は、取得した声質パラメータに含まれる性別変更フラグを参照し、合成音声の性別を変更すべきか(すなわち、性別変更処理を実行すべきか)否かを判断する(ステップS2)。声質変更部250は、例えば性別変更フラグが“0”に設定され、性別変更すべきでないと判断すると、ステップS3をスキップしてステップS4に進む一方、例えば性別変更フラグが“1”に設定され、性別変更すべきと判断すると、ステップS3に進み、性別変更処理を実行する。

声質変更部(生成手段)250は、テキスト解析部220から声質データ番号を受け取ると、該声質データ番号を検索キーとして声質データベース260を検索し、対応する声質パラメータを取得する(ステップS1)。そして、声質変更部250は、取得した声質パラメータに含まれる性別変更フラグを参照し、合成音声の性別を変更すべきか(すなわち、性別変更処理を実行すべきか)否かを判断する(ステップS2)。声質変更部250は、例えば性別変更フラグが“0”に設定され、性別変更すべきでないと判断すると、ステップS3をスキップしてステップS4に進む一方、例えば性別変更フラグが“1”に設定され、性別変更すべきと判断すると、ステップS3に進み、性別変更処理を実行する。

図9は、記憶手段(図示略)に格納されている性別変更処理用のマッピング関数mfを例示した図であり、図10及び図11は、男性及び女性がそれぞれ同一の音韻(例えば、「あ」等)を発声したときの分析結果を示す図である。なお、図9に示すマッピング関数mfの横軸は入力周波数(声質変更部250に入力されるフォルマント周波数)、縦軸は出力周波数(声質変更部250から出力される周波数変更後のフォルマント周波数)をあらわし、fmaxは入力可能なフォルマント周波数の最大値をあらわす。また、図10及び図11に示す分析グラフg1、g2の横軸は周波数、縦軸はレベルをあらわす。

図10と図11に示す分析グラフg1、g2を比較して明らかなように、男性の音韻の第1フォルマント周波数fm1〜第4フォルマント周波数fm4は、女性の音韻の第1フォルマント周波数ff1〜第4フォルマント周波数ff4と比較して低い。そこで、本実施形態では、図9に示すように、直線nl(入力周波数=出力周波数;破線部分参照)よりも上側に位置するマッピング関数mf(実線部分参照)を用いることにより、男性的な特徴を有する音韻を女性的な特徴を有する音韻に変更する。

具体的には、声質変更部250は、入力される音韻データの各フォルマント周波数を、図9に示すマッピング関数mfを用いて周波数の高い方向にシフトする。これにより、入力される男性の音韻の各フォルマント周波数は、女性的な特徴を有するものに変更される。なお、女性の音韻のフォルマント周波数が入力される場合には、上記とは逆に、直線nlよりも下側に位置するマッピング関数mf’(図9に一点鎖線で示す部分参照)を利用すれば良い。

声質変更部250は、上記性別変更処理を実行し、ステップS4に進むと、各フォルマント周波数変更情報に示される各フォルマント周波数のシフト量に従って、各フォルマント周波数をシフトする。さらに、声質変更部250は、シフトした各フォルマント周波数を発振させるべく、周波数発振処理を実行する(ステップS5)。

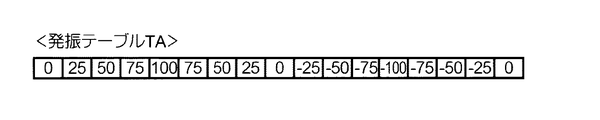

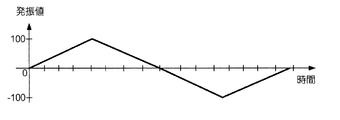

図12は、記憶手段(図示略)に格納されている周波数発振処理に用いられる発振テーブルTAを例示した図であり、図13は、該発振テーブルTAから読み出される発振値と時間の関係を例示した図である。なお、本実施形態では、便宜上、同一の発振テーブルTAを用いて上記各フォルマント周波数を発振させる場合を想定するが、各フォルマント周波数毎に発振値等が異なる発振テーブルを用いても良い。

発振テーブルTAは、発振値を時系列順に登録したテーブルである。声質変更部250は、各フォルマント周波数変更情報に示されるフォルマント周波数の発振速度に従って、発振テーブルTAに登録されている発振値の読み出し速度(あるいは発振値を読み飛ばす数)を制御する一方、読み出した各発振値に対して各フォルマント周波数変更情報に示されるフォルマント周波数の発振レベルを乗するといった周波数発振処理を実行する。これにより、図14に示すようなフォルマント周波数fmを発振速度sp、発振レベルlvで発振させた波形を得ることができる。なお、本実施形態では、フォルマント周波数の発振レベルの演算量を削減するために、上記発振テーブルTAを利用する態様を例示したが、発振テーブルTAを利用することなく所定の関数等を利用してフォルマント周波数の発振レベルを求めても良い。

声質変更部250は、周波数発振処理を実行すると、ステップ6に進み、各フォルマント周波数変更情報に示される各フォルマントレベルのシフト量に従って、各フォルマントレベルをシフトする。さらに、声質変更部250は、シフトした各フォルマントレベルを発振させるべく、レベル発振処理を実行し(ステップS7)、処理を終了する。なお、レベル発振処理に用いられる発振テーブルや該発振テーブルを用いて各フォルマントレベルを発振させる場合の動作については、上記各フォルマント周波数を発振させる場合とほぼ同様に説明することができるため割愛する。また、フォルマントレベルの発振について、フォルマント周波数の発振と同一の発振テーブルを用いて発振させても良いが、フォルマント周波数の発振とは異なる発振テーブルを用いて発振させても良い。

声質変更部(生成手段)250は、取得した声質パラメータ(音韻データ加工情報)に基づいて各音韻の声質を変更(すなわち、音韻データを加工)すると、各フォルマント毎の基本波形選択情報、各フォルマント周波数、及び各フォルマントレベルを音声信号生成部270に供給する。

音声信号生成部270は、声質変更部250から供給される基本波形選択情報を受け取ると、この基本波形選択情報に示される波形データを波形データベース280から取得する。なお、この基本波形選択情報に示される基本波形は、各フォルマント毎に異なっていても良く、例えば低い周波数のフォルマントの基本波形を正弦波とする一方、個性を表す高い周波数のフォルマントの基本波形を正弦波以外の波形(例えば、矩形波やのこぎり波など)等としても良い。もちろん、複数種類の基本波形を利用することなく、単一の基本波形(例えば、正弦波)のみを利用しても良い。

音声信号生成部270は、声質変更部250から供給される基本波形選択情報を受け取ると、この基本波形選択情報に示される波形データを波形データベース280から取得する。なお、この基本波形選択情報に示される基本波形は、各フォルマント毎に異なっていても良く、例えば低い周波数のフォルマントの基本波形を正弦波とする一方、個性を表す高い周波数のフォルマントの基本波形を正弦波以外の波形(例えば、矩形波やのこぎり波など)等としても良い。もちろん、複数種類の基本波形を利用することなく、単一の基本波形(例えば、正弦波)のみを利用しても良い。

音声信号生成部(生成手段)270は、このようにして各波形データを選択すると、選択した各波形データ、各フォルマント周波数、各フォルマントレベルを用いて各フォルマント毎のフォルマント波形を生成する。そして、音声信号生成部(生成手段)270は、各フォルマント波形を加算し、合成音声信号を生成する。さらに、音声信号生成部270は、生成した合成音声信号に、テキスト解析部220から供給されるピッチ情報(ピッチ指定情報)に示されるピッチを与える処理(以下、ピッチ付与処理)を施す。

図15は、ピッチ付与処理を説明するための図である。なお、図15では、説明の理解を容易にするために、正弦波の合成音声信号にピッチが付与される場合を例示している。

音声信号生成部270は、テキスト解析部220から供給されるピッチ情報に基づいて図15に示す時間エンベロープtpの周期を算出する。ここで、合成音声のピッチは、時間エンベロープtpの周期に依存し、時間エンベロープtpの周期が長くなればピッチは低くなる一方、時間エンベロープtpの周期が短くなればピッチは高くなる。音声信号生成部270は、このようにして時間エンベロープtpの周期を求めると、時間エンベロープtpと合成音声信号との乗算を、求めた時間エンベロープtpの周期で繰り返し行うことにより、所定のピッチが付与された合成音声信号を得る。

音声信号生成部270は、テキスト解析部220から供給されるピッチ情報に基づいて図15に示す時間エンベロープtpの周期を算出する。ここで、合成音声のピッチは、時間エンベロープtpの周期に依存し、時間エンベロープtpの周期が長くなればピッチは低くなる一方、時間エンベロープtpの周期が短くなればピッチは高くなる。音声信号生成部270は、このようにして時間エンベロープtpの周期を求めると、時間エンベロープtpと合成音声信号との乗算を、求めた時間エンベロープtpの周期で繰り返し行うことにより、所定のピッチが付与された合成音声信号を得る。

図16は、声質変更処理及びピッチ付与処理が施された特定フォルマントのフォルマント波形を例示した図である。図16に示すように、声質変更に関わる処理(例えば、フォルマント周波数やフォルマントレベルの発振処理等)は、フレーム周期(フレーム単位)で制御することが可能となっている。音声信号生成部(生成手段)270は、上記の如く所定のピッチが付与された合成音声信号を得ると、これを合成音声として外部へ出力する。これにより、ユーザは、音声合成装置100に入力したテキスト本文(「こんにちわ」等)の内容を、所望する声質の合成音声によって確認することが可能となる。

以上説明したように、本実施形態に係る音声合成装置によれば、声質変更部においてフォルマントを単位とする様々な声質変更処理が施されるため、記憶される音韻データが1種類(すなわち、特定話者の音韻データのみ)であっても、様々な声質の音声合成が可能となる。

B.その他

以上説明した本実施形態では、音声合成装置100に入力されるテキスト情報にピッチ情報が含まれている場合を例示したが(図2参照)、該テキスト情報にピッチ情報が含まれない場合もある。かかる場合を想定して音韻データベース240に予め代替ピッチ情報を登録し(図3の括弧書き参照)、テキスト情報にピッチ情報が含まれていない場合には、この代替ピッチ情報に示されるピッチ(例えば、C(ド)等)を合成音声のピッチとして利用するようにしても良い。また、代替ピッチ情報のほか、図4に示す各フレーム毎のフォルマント情報の数(フォルマント数情報;図3の括弧書き参照)を音韻データベース240に予め登録しておいても良い。

以上説明した本実施形態では、音声合成装置100に入力されるテキスト情報にピッチ情報が含まれている場合を例示したが(図2参照)、該テキスト情報にピッチ情報が含まれない場合もある。かかる場合を想定して音韻データベース240に予め代替ピッチ情報を登録し(図3の括弧書き参照)、テキスト情報にピッチ情報が含まれていない場合には、この代替ピッチ情報に示されるピッチ(例えば、C(ド)等)を合成音声のピッチとして利用するようにしても良い。また、代替ピッチ情報のほか、図4に示す各フレーム毎のフォルマント情報の数(フォルマント数情報;図3の括弧書き参照)を音韻データベース240に予め登録しておいても良い。

また、以上説明した音声合成装置100に係る諸機能は、CPU(或いはDSP)がROM等のメモリに格納されたプログラムを実行することによって実現されるため、かかるプログラムについてCD−ROM等の記録媒体に記録して頒布したり、インターネット等の通信ネットワークを介して頒布しても良い。

100・・・音声合成装置、210・・・入力部、220・・・テキスト解析部、230・・・音韻データ取得部、240・・・音韻データベース、250・・・声質変更部、260・・・声質データベース、270・・・音声信号生成部、280・・・波形データベース。

Claims (6)

- 入力されるテキスト情報から、合成音声の音韻を指定する音韻指定情報及び該合成音声の声質を指定する声質指定情報を取得する取得手段と、

特定話者の各音韻をあらわす一連の音韻データを記憶する第1記憶手段と、

前記各音韻の声質を変更するために必要な情報であって、音韻データの加工内容をあらわす音韻データ加工情報を複数種類記憶する第2記憶手段と、

前記第1記憶手段から、前記音韻指定情報に示される音韻に対応する音韻データを抽出する第1抽出手段と、

前記第2記憶手段から、前記声質指定情報に示される声質に対応する音韻データ加工情報を抽出する第2抽出手段と、

前記抽出された音韻データを、前記抽出された音韻データ加工情報に基づいて加工し、前記合成音声を生成する生成手段と

を具備することを特徴とする音声合成装置。 - 前記各音韻データは、それぞれ対応する音韻のフォルマントを複数備え、

前記音韻データ加工情報には、前記フォルマントの変更内容をあらわすフォルマント変更情報が含まれ、

前記生成手段は、前記音韻データに示される音韻の各フォルマントを、前記フォルマント変更情報に基づいて変更し、変更後の各フォルマントを加算した後の信号波形に基づいて前記合成音声を生成することを特徴とする請求項1に記載の音声合成装置。 - 前記フォルマントは、フォルマント周波数とフォルマントレベルとの対によって構成され、

前記フォルマント変更情報には、前記フォルマント周波数の変更内容をあらわすフォルマント周波数変更情報と前記フォルマントレベルの変更内容をあらわすフォルマントレベル変更情報が含まれ、

前記生成手段は、前記音韻データに示される音韻の各フォルマント周波数と各フォルマントレベルのそれぞれを、前記フォルマント周波数変更情報及び前記フォルマントレベル変更情報に基づいて変更することにより、前記変更後の各フォルマントを得ることを特徴とする請求項2に記載の音声合成装置。 - 前記取得手段は、前記テキスト情報から前記音韻指定情報及び前記声質指定情報を取得するほか、前記合成音声のピッチを指定するピッチ指定情報を取得し、

前記生成手段は、前記変更後の各フォルマントを加算した後の信号波形に対して前記ピッチ指定情報に示されるピッチを与えることにより、前記合成音声を得ることを特徴とする請求項2または3に記載の音声合成装置。 - 入力されるテキスト情報から、合成音声の音韻を指定する音韻指定情報及び該合成音声の声質を指定する声質指定情報を取得する取得過程と、

特定話者の各音韻をあらわす一連の音韻データを記憶する第1記憶手段から、前記音韻指定情報に示される音韻に対応する音韻データを抽出する第1抽出過程と、

前記各音韻の声質を変更するために必要な情報であって、音韻データの加工内容をあらわす音韻データ加工情報を複数種類記憶する第2記憶手段から、前記声質指定情報に示される声質に対応する音韻データ加工情報を抽出する第2抽出過程と、

前記抽出された音韻データを、前記抽出された音韻データ加工情報に基づいて加工し、前記合成音声を生成する生成過程と

を具備することを特徴とする音声合成方法。 - 特定話者の各音韻をあらわす一連の音韻データを記憶する第1記憶手段と、前記各音韻の声質を変更するために必要な情報であって、音韻データの加工内容をあらわす音韻データ加工情報を複数種類記憶する第2記憶手段とを備えたコンピュータを、

入力されるテキスト情報から、合成音声の音韻を指定する音韻指定情報及び該合成音声の声質を指定する声質指定情報を取得する取得手段と、

前記第1記憶手段から、前記音韻指定情報に示される音韻に対応する音韻データを抽出する第1抽出手段と、

前記第2記憶手段から、前記声質指定情報に示される声質に対応する音韻データ加工情報を抽出する第2抽出手段と、

前記抽出された音韻データを、前記抽出された音韻データ加工情報に基づいて加工し、前記合成音声を生成する生成手段として機能させるための音声合成プログラム。

Priority Applications (4)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2004044852A JP2005234337A (ja) | 2004-02-20 | 2004-02-20 | 音声合成装置、音声合成方法、及び音声合成プログラム |

| TW094104941A TW200535235A (en) | 2004-02-20 | 2005-02-18 | Voice operation device, method and recording medium for recording voice operation program |

| CNB2005100074542A CN100337104C (zh) | 2004-02-20 | 2005-02-21 | 语音合成装置、方法和记录语音合成程序的记录介质 |

| KR1020050014045A KR100759172B1 (ko) | 2004-02-20 | 2005-02-21 | 음성 합성 장치, 음성 합성 방법, 및 음성 합성 프로그램을기억한 기억 매체 |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2004044852A JP2005234337A (ja) | 2004-02-20 | 2004-02-20 | 音声合成装置、音声合成方法、及び音声合成プログラム |

Publications (1)

| Publication Number | Publication Date |

|---|---|

| JP2005234337A true JP2005234337A (ja) | 2005-09-02 |

Family

ID=35007713

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2004044852A Pending JP2005234337A (ja) | 2004-02-20 | 2004-02-20 | 音声合成装置、音声合成方法、及び音声合成プログラム |

Country Status (4)

| Country | Link |

|---|---|

| JP (1) | JP2005234337A (ja) |

| KR (1) | KR100759172B1 (ja) |

| CN (1) | CN100337104C (ja) |

| TW (1) | TW200535235A (ja) |

Cited By (2)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| WO2012011475A1 (ja) * | 2010-07-20 | 2012-01-26 | 独立行政法人産業技術総合研究所 | 声色変化反映歌声合成システム及び声色変化反映歌声合成方法 |

| WO2020145353A1 (ja) * | 2019-01-10 | 2020-07-16 | グリー株式会社 | コンピュータプログラム、サーバ装置、端末装置及び音声信号処理方法 |

Families Citing this family (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP6724932B2 (ja) * | 2018-01-11 | 2020-07-15 | ヤマハ株式会社 | 音声合成方法、音声合成システムおよびプログラム |

Family Cites Families (12)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP3633963B2 (ja) * | 1994-09-14 | 2005-03-30 | 株式会社河合楽器製作所 | 楽音生成装置及び楽音生成方法 |

| DE69617480T2 (de) * | 1995-01-13 | 2002-10-24 | Yamaha Corp | Vorrichtung zur Verarbeitung eines digitales Klangsignals |

| JPH1078952A (ja) * | 1996-07-29 | 1998-03-24 | Internatl Business Mach Corp <Ibm> | 音声合成方法、音声合成装置、ハイパーテキストの制御方法及び制御装置 |

| CN1113330C (zh) * | 1997-08-15 | 2003-07-02 | 英业达股份有限公司 | 语音合成中的语音规整方法 |

| EP1100072A4 (en) * | 1999-03-25 | 2005-08-03 | Matsushita Electric Ind Co Ltd | LANGUAGE SYNTHETIZATION SYSTEM AND METHOD |

| JP2000339137A (ja) * | 1999-05-31 | 2000-12-08 | Sanyo Electric Co Ltd | 電子メール受信システム |

| JP2002268699A (ja) * | 2001-03-09 | 2002-09-20 | Sony Corp | 音声合成装置及び音声合成方法、並びにプログラムおよび記録媒体 |

| JP3732793B2 (ja) * | 2001-03-26 | 2006-01-11 | 株式会社東芝 | 音声合成方法、音声合成装置及び記録媒体 |

| JP2003031936A (ja) * | 2001-07-19 | 2003-01-31 | Murata Mach Ltd | プリント基板 |

| JP2003295882A (ja) * | 2002-04-02 | 2003-10-15 | Canon Inc | 音声合成用テキスト構造、音声合成方法、音声合成装置及びそのコンピュータ・プログラム |

| US8214216B2 (en) * | 2003-06-05 | 2012-07-03 | Kabushiki Kaisha Kenwood | Speech synthesis for synthesizing missing parts |

| KR20050041749A (ko) * | 2003-10-31 | 2005-05-04 | 한국전자통신연구원 | 방송 음성 데이터를 이용한 영역 및 화자 의존 음성 합성장치, 음성 합성용 데이터베이스 구축방법 및 음성 합성서비스 시스템 |

-

2004

- 2004-02-20 JP JP2004044852A patent/JP2005234337A/ja active Pending

-

2005

- 2005-02-18 TW TW094104941A patent/TW200535235A/zh not_active IP Right Cessation

- 2005-02-21 CN CNB2005100074542A patent/CN100337104C/zh not_active Expired - Fee Related

- 2005-02-21 KR KR1020050014045A patent/KR100759172B1/ko not_active IP Right Cessation

Cited By (6)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| WO2012011475A1 (ja) * | 2010-07-20 | 2012-01-26 | 独立行政法人産業技術総合研究所 | 声色変化反映歌声合成システム及び声色変化反映歌声合成方法 |

| JP5510852B2 (ja) * | 2010-07-20 | 2014-06-04 | 独立行政法人産業技術総合研究所 | 声色変化反映歌声合成システム及び声色変化反映歌声合成方法 |

| US9009052B2 (en) | 2010-07-20 | 2015-04-14 | National Institute Of Advanced Industrial Science And Technology | System and method for singing synthesis capable of reflecting voice timbre changes |

| WO2020145353A1 (ja) * | 2019-01-10 | 2020-07-16 | グリー株式会社 | コンピュータプログラム、サーバ装置、端末装置及び音声信号処理方法 |

| JPWO2020145353A1 (ja) * | 2019-01-10 | 2021-12-23 | グリー株式会社 | コンピュータプログラム、サーバ装置、端末装置及び音声信号処理方法 |

| JP7309155B2 (ja) | 2019-01-10 | 2023-07-18 | グリー株式会社 | コンピュータプログラム、サーバ装置、端末装置及び音声信号処理方法 |

Also Published As

| Publication number | Publication date |

|---|---|

| CN100337104C (zh) | 2007-09-12 |

| TWI300551B (ja) | 2008-09-01 |

| KR20060043023A (ko) | 2006-05-15 |

| KR100759172B1 (ko) | 2007-09-14 |

| TW200535235A (en) | 2005-11-01 |

| CN1658281A (zh) | 2005-08-24 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| US7155390B2 (en) | Speech information processing method and apparatus and storage medium using a segment pitch pattern model | |

| JPH10116089A (ja) | 音声合成用の基本周波数テンプレートを収容する韻律データベース | |

| CN101156196A (zh) | 混合语音合成器、方法和使用 | |

| KR100759172B1 (ko) | 음성 합성 장치, 음성 합성 방법, 및 음성 합성 프로그램을기억한 기억 매체 | |

| JP2007086309A (ja) | 音声合成装置、音声合成方法および音声合成プログラム | |

| JP2001272991A (ja) | 音声対話方法及び音声対話装置 | |

| JP4829605B2 (ja) | 音声合成装置および音声合成プログラム | |

| JP4841339B2 (ja) | 韻律補正装置、音声合成装置、韻律補正方法、音声合成方法、韻律補正プログラム、および、音声合成プログラム | |

| JPH08335096A (ja) | テキスト音声合成装置 | |

| JPH09152884A (ja) | 音声合成装置 | |

| JP2004117662A (ja) | 音声合成システム | |

| JP2010175717A (ja) | 音声合成装置 | |

| JP2004226505A (ja) | ピッチパタン生成方法、音声合成方法とシステム及びプログラム | |

| JP2005242231A (ja) | 音声合成装置、音声合成方法、及び音声合成プログラム | |

| JP3344487B2 (ja) | 音声基本周波数パターン生成装置 | |

| JPH05281984A (ja) | 音声合成方法および装置 | |

| JP2703253B2 (ja) | 音声合成装置 | |

| Huang et al. | A Chinese text-to-speech synthesis system based on an initial-final model | |

| JP3883780B2 (ja) | 音声合成装置 | |

| JP2679623B2 (ja) | テキスト音声合成装置 | |

| JPH1185193A (ja) | 音声データベースにおける音素片情報最適化方法、及び音素片情報最適化装置 | |

| JP2755478B2 (ja) | テキスト音声合成装置 | |

| JP2956936B2 (ja) | 音声合成装置の発声速度制御回路 | |

| JPH06167989A (ja) | 音声合成装置 | |

| JP2003005774A (ja) | 音声合成装置 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20060223 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20090519 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20090717 |

|

| A02 | Decision of refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A02 Effective date: 20090818 |