ES2818622T3 - Entradas de muestra y acceso aleatorio - Google Patents

Entradas de muestra y acceso aleatorio Download PDFInfo

- Publication number

- ES2818622T3 ES2818622T3 ES17729604T ES17729604T ES2818622T3 ES 2818622 T3 ES2818622 T3 ES 2818622T3 ES 17729604 T ES17729604 T ES 17729604T ES 17729604 T ES17729604 T ES 17729604T ES 2818622 T3 ES2818622 T3 ES 2818622T3

- Authority

- ES

- Spain

- Prior art keywords

- sample

- video

- tracks

- video data

- hevc

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

- 238000000034 method Methods 0.000 claims abstract description 62

- 230000002123 temporal effect Effects 0.000 claims abstract description 17

- 230000004044 response Effects 0.000 claims abstract description 12

- 238000011084 recovery Methods 0.000 claims description 12

- 238000004891 communication Methods 0.000 claims description 6

- 230000001413 cellular effect Effects 0.000 claims description 2

- 230000010267 cellular communication Effects 0.000 claims 1

- 239000010410 layer Substances 0.000 description 65

- 238000005538 encapsulation Methods 0.000 description 43

- 238000012545 processing Methods 0.000 description 27

- 108091000069 Cystinyl Aminopeptidase Proteins 0.000 description 22

- 102100020872 Leucyl-cystinyl aminopeptidase Human genes 0.000 description 22

- 230000006978 adaptation Effects 0.000 description 22

- 238000002360 preparation method Methods 0.000 description 20

- 239000012634 fragment Substances 0.000 description 13

- 238000010586 diagram Methods 0.000 description 8

- 238000009877 rendering Methods 0.000 description 8

- 230000005540 biological transmission Effects 0.000 description 7

- 230000008569 process Effects 0.000 description 5

- 230000003287 optical effect Effects 0.000 description 4

- 238000003491 array Methods 0.000 description 3

- 230000006835 compression Effects 0.000 description 3

- 238000007906 compression Methods 0.000 description 3

- 238000004590 computer program Methods 0.000 description 3

- 238000013500 data storage Methods 0.000 description 3

- 239000002356 single layer Substances 0.000 description 3

- 238000012546 transfer Methods 0.000 description 3

- 230000001052 transient effect Effects 0.000 description 3

- 230000000007 visual effect Effects 0.000 description 3

- FMYKJLXRRQTBOR-UBFHEZILSA-N (2s)-2-acetamido-4-methyl-n-[4-methyl-1-oxo-1-[[(2s)-1-oxohexan-2-yl]amino]pentan-2-yl]pentanamide Chemical group CCCC[C@@H](C=O)NC(=O)C(CC(C)C)NC(=O)[C@H](CC(C)C)NC(C)=O FMYKJLXRRQTBOR-UBFHEZILSA-N 0.000 description 2

- 230000008901 benefit Effects 0.000 description 2

- 239000000470 constituent Substances 0.000 description 2

- 238000005516 engineering process Methods 0.000 description 2

- 239000000835 fiber Substances 0.000 description 2

- 230000006870 function Effects 0.000 description 2

- 230000007246 mechanism Effects 0.000 description 2

- 230000000750 progressive effect Effects 0.000 description 2

- 239000013598 vector Substances 0.000 description 2

- 238000012935 Averaging Methods 0.000 description 1

- 101100172874 Caenorhabditis elegans sec-3 gene Proteins 0.000 description 1

- 101100412093 Schizosaccharomyces pombe (strain 972 / ATCC 24843) rec16 gene Proteins 0.000 description 1

- 230000003044 adaptive effect Effects 0.000 description 1

- 150000001768 cations Chemical class 0.000 description 1

- 230000008859 change Effects 0.000 description 1

- 238000000605 extraction Methods 0.000 description 1

- 230000006872 improvement Effects 0.000 description 1

- 238000013507 mapping Methods 0.000 description 1

- 239000000463 material Substances 0.000 description 1

- AWSBQWZZLBPUQH-UHFFFAOYSA-N mdat Chemical compound C1=C2CC(N)CCC2=CC2=C1OCO2 AWSBQWZZLBPUQH-UHFFFAOYSA-N 0.000 description 1

- 230000008520 organization Effects 0.000 description 1

- 238000004806 packaging method and process Methods 0.000 description 1

- 230000000644 propagated effect Effects 0.000 description 1

- 230000002441 reversible effect Effects 0.000 description 1

- 230000003068 static effect Effects 0.000 description 1

- 230000008685 targeting Effects 0.000 description 1

Classifications

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/80—Generation or processing of content or additional data by content creator independently of the distribution process; Content per se

- H04N21/83—Generation or processing of protective or descriptive data associated with content; Content structuring

- H04N21/845—Structuring of content, e.g. decomposing content into time segments

- H04N21/8451—Structuring of content, e.g. decomposing content into time segments using Advanced Video Coding [AVC]

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04L—TRANSMISSION OF DIGITAL INFORMATION, e.g. TELEGRAPHIC COMMUNICATION

- H04L65/00—Network arrangements, protocols or services for supporting real-time applications in data packet communication

- H04L65/60—Network streaming of media packets

- H04L65/75—Media network packet handling

- H04L65/756—Media network packet handling adapting media to device capabilities

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/30—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using hierarchical techniques, e.g. scalability

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/70—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals characterised by syntax aspects related to video coding, e.g. related to compression standards

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/85—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using pre-processing or post-processing specially adapted for video compression

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/20—Servers specifically adapted for the distribution of content, e.g. VOD servers; Operations thereof

- H04N21/23—Processing of content or additional data; Elementary server operations; Server middleware

- H04N21/234—Processing of video elementary streams, e.g. splicing of video streams or manipulating encoded video stream scene graphs

- H04N21/2343—Processing of video elementary streams, e.g. splicing of video streams or manipulating encoded video stream scene graphs involving reformatting operations of video signals for distribution or compliance with end-user requests or end-user device requirements

- H04N21/23439—Processing of video elementary streams, e.g. splicing of video streams or manipulating encoded video stream scene graphs involving reformatting operations of video signals for distribution or compliance with end-user requests or end-user device requirements for generating different versions

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/40—Client devices specifically adapted for the reception of or interaction with content, e.g. set-top-box [STB]; Operations thereof

- H04N21/43—Processing of content or additional data, e.g. demultiplexing additional data from a digital video stream; Elementary client operations, e.g. monitoring of home network or synchronising decoder's clock; Client middleware

- H04N21/432—Content retrieval operation from a local storage medium, e.g. hard-disk

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/80—Generation or processing of content or additional data by content creator independently of the distribution process; Content per se

- H04N21/83—Generation or processing of protective or descriptive data associated with content; Content structuring

- H04N21/845—Structuring of content, e.g. decomposing content into time segments

- H04N21/8456—Structuring of content, e.g. decomposing content into time segments by decomposing the content in the time domain, e.g. in time segments

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/80—Generation or processing of content or additional data by content creator independently of the distribution process; Content per se

- H04N21/85—Assembly of content; Generation of multimedia applications

- H04N21/854—Content authoring

- H04N21/85406—Content authoring involving a specific file format, e.g. MP4 format

Landscapes

- Engineering & Computer Science (AREA)

- Multimedia (AREA)

- Signal Processing (AREA)

- Databases & Information Systems (AREA)

- Computer Networks & Wireless Communication (AREA)

- Computer Security & Cryptography (AREA)

- Compression Or Coding Systems Of Tv Signals (AREA)

- Two-Way Televisions, Distribution Of Moving Picture Or The Like (AREA)

Abstract

Un procedimiento de recuperación de datos de vídeo, comprendiendo el procedimiento: recibir datos que describen un tipo de entrada de muestra para una muestra de un flujo de bits de vídeo, siendo el tipo de entrada de muestra uno de 'hev1' o 'hev2', en el que la muestra comprende datos de vídeo codificados de acuerdo con una de codificación de vídeo de alta eficacia (HEVC) o HEVC en capas (L-HEVC), en el que una o más de otras muestras que incluyen datos de vídeo preceden a la muestra en el flujo de bits de vídeo en orden de descodificación, y en respuesta a que el tipo de entrada de muestra es 'hev1' o 'hev2' y que la muestra comprende los datos de vídeo codificados de acuerdo con uno de HEVC o L-HEVC, recuperar la muestra para realizar un acceso aleatorio usando la muestra, sin recuperar los datos de vídeo de cualquiera de las una o más de otras muestras que preceden a la muestra, y sin recuperar conjuntos de parámetros de ninguna muestra anterior del flujo de bits de vídeo en orden de descodificación, caracterizado por que los datos de vídeo de la muestra se incluyen en una pista de una pluralidad de pistas de un archivo, incluyendo la pluralidad de pistas un subconjunto de la pluralidad de pistas que incluye datos de vídeo de una o varias capas, comprendiendo además el procedimiento, en respuesta a determinar que el acceso aleatorio conveniente está habilitado para uno del subconjunto de la pluralidad de pistas que tiene una subcapa temporal más baja, determinar que el acceso aleatorio conveniente está habilitado para cada una de la pluralidad de pistas.

Description

DESCRIPCIÓN

Entradas de muestra y acceso aleatorio

[0001] Esta solicitud reivindica el beneficio de la solicitud provisional estadounidense número 62/340.886, presentada el 24 de mayo de 2016.

CAMPO TÉCNICO

[0002] Esta divulgación se refiere a formatos de archivo para el almacenamiento y transporte de flujos de bits de medios, como los flujos de bits de vídeo.

ANTECEDENTES

[0003] Las capacidades de vídeo digital se pueden incorporar a una amplia gama de dispositivos, incluyendo televisores digitales, sistemas de radiodifusión directa digital, sistemas de radiodifusión inalámbrica, asistentes personales digitales (PDA), ordenadores portátiles o de escritorio, cámaras digitales, dispositivos de grabación digitales, reproductores de medios digitales, dispositivos de videojuegos, consolas de videojuegos, teléfonos de radio celulares o por satélite, dispositivos de videoconferencia y similares. Los dispositivos de vídeo digitales implementan técnicas de compresión de vídeo, tales como las descritas en las normas definidas por MPEG-2, MPEG-4, ITU-T H.263 o ITU-T H.264/MPEG-4, parte 10, Codificación de Vídeo Avanzada (AVC) y ampliaciones de dichas normas, para transmitir y recibir información de vídeo digital de manera más eficaz.

[0004] Las técnicas de compresión de vídeo realizan predicción espacial y/o predicción temporal para reducir o eliminar la redundancia inherente a las secuencias de vídeo. Para la codificación de vídeo basada en bloques, una trama o un fragmento de vídeo se pueden dividir en macrobloques. Cada macrobloque se puede dividir aún más. Los macrobloques de una trama o un fragmento intracodificados (I) se codifican usando predicción espacial con respecto a macrobloques vecinos. Los macrobloques de una trama o un fragmento intercodificados (P o B) pueden usar predicción espacial con respecto a macrobloques vecinos de la misma trama o fragmento, o predicción temporal con respecto a otras tramas de referencia.

[0005] Después de que se hayan codificado los datos de vídeo, los datos de vídeo se pueden agrupar en paquetes para su transmisión o almacenamiento. Los datos de vídeo se pueden ensamblar en un archivo de vídeo que se ajusta a cualquiera de una variedad de normas, tales como el formato de archivo de medios de base de la Organización Internacional de Normalización (ISO) y ampliaciones del mismo, tal como el formato de archivo AVC.

BREVE EXPLICACIÓN

[0006] En general, esta divulgación describe técnicas para permitir operaciones de acceso aleatorio convenientes para archivos que almacenan un flujo de bits de una o varias capas en una o más pistas. Esta divulgación proporciona procedimientos, dispositivos y productos de programa informático en diseños de entrada de muestras que permiten operaciones de acceso aleatorio convenientes, para archivos que almacenan un flujo de bits de una o varias capas en una o más pistas.

[0007] Los detalles de uno o más ejemplos se exponen en los dibujos adjuntos y en la siguiente descripción. Otras características, objetivos y ventajas resultarán evidentes a partir de la descripción y de los dibujos, y a partir de las reivindicaciones.

BREVE DESCRIPCIÓN DE LOS DIBUJOS

[0008]

La FIG. 1 es un diagrama de bloques que ilustra un sistema de ejemplo que implementa técnicas para transmitir en continuo datos de medios a través de una red.

La FIG. 2 es un diagrama de bloques que ilustra un conjunto de componentes de ejemplo de una unidad de recuperación.

La FIG. 3 es un diagrama conceptual que ilustra elementos de contenido multimedia de ejemplo.

La FIG. 4 es un diagrama de bloques que ilustra elementos de un archivo de vídeo de ejemplo.

La FIG. 5 es un diagrama de flujo que ilustra una técnica de ejemplo para procesar datos.

La FIG. 6 es un diagrama de flujo que ilustra una técnica de ejemplo para procesar datos.

La FIG. 7 es un diagrama de flujo que ilustra una técnica de ejemplo para generar un archivo que incluye datos de vídeo.

DESCRIPCIÓN DETALLADA

[0009] En general, esta divulgación describe técnicas para permitir operaciones de acceso aleatorio convenientes para archivos que almacenan un flujo de bits de una o varias capas en una o más pistas. El acceso aleatorio conveniente puede definirse como el acceso aleatorio sin necesidad de buscar y/o recuperar conjuntos de parámetros de muestras anteriores. En otras palabras, se habilita el acceso aleatorio conveniente para una muestra de un flujo de bits de vídeo cuando un dispositivo cliente puede solicitar la muestra y muestras posteriores sin buscar y/o recuperar conjuntos de parámetros de muestras anteriores. Por lo tanto, todos los conjuntos de parámetros necesarios pueden incluirse en la propia muestra o en una entrada de muestra que corresponda a la muestra.

[0010] Esta divulgación describe procedimientos en diseños de entrada de muestra que permiten operaciones de acceso aleatorio convenientes, para archivos que almacenan un flujo de bits de una o varias capas en una o más pistas.

[0011] Las normas de codificación de vídeo incluyen ITU-T H.261, ISO/IEC MPEG-1 Visual, ITU-T H.262 o ISO/IEC MPEG-2 Visual, ITU-T H.263, ISO/IEC MPEG-4 Visual, ITU-T H.264 o ISO/IEC MPEG-4 AVC, incluyendo sus ampliaciones de codificación de vídeo escalable (SVC) y codificación de vídeo multivista (MVC), y codificación de vídeo de alta eficacia (HEVC), también conocida como ITU-T H.265 e ISO/IEC 23008-2, incluyendo su ampliación de codificación escalable (es decir, codificación de vídeo escalable de alta eficacia, SHVC), su ampliación multivista (es decir, codificación de vídeo multivista de alta eficacia, MV-HEVC) y su ampliación 3D (es decir, codificación de vídeo 3D de alta eficacia, 3D-HEVC).

[0012] Las normas de formato de archivo incluyen el formato de archivo de medios de base ISO (ISOBMFF, ISO/IEC 14496-12) y otros derivados del ISOBMFF, incluido el formato de archivo MPEG-4 (ISO/IEC 14496-15), el formato de archivo 3GPP (3GPP TS 26.244) e ISO/IEC 14496-15 que contiene los formatos de archivo para AVC y sus ampliaciones, así como los formatos de archivo para HEVC y sus ampliaciones. Los borradores de las nuevas ediciones recientes para ISO/IEC 14496-12 y 14496-15 están disponibles en http://phenix.intevry. fr/mpeg/doc_end_user/documents/111_Geneva/wg11/w15177-v6-w15177.zip y http:// wg11.sc29.org/doc_end_user/documents/114_San%20Diego/wg11/w15928-v2-w15928.zip, respectivamente.

[0013] Las técnicas de esta divulgación se pueden aplicar a los archivos de vídeo conformes a los datos de vídeo encapsulados de acuerdo con cualquiera de entre el formato de archivo de medios de base ISO, el formato de archivo de codificación de vídeo escalable (SVC), el formato de archivo de codificación de vídeo avanzada (AVC), el formato de archivo del Proyecto de colaboración de tercera generación (3GPP) y/o el formato de archivo de codificación de vídeo de múltiples vistas (MVC) u otros formatos similares de archivo de vídeo.

[0014] En la transmisión continua HTTP, las operaciones de uso frecuente incluyen HEAD, GET y GET parcial. La operación HEAD recupera una cabecera de un archivo asociado a un localizador de recursos uniforme (URL) o un nombre de recursos uniforme (URN) dado, sin recuperar una carga útil asociada al URL o al URN. La operación GET recupera un archivo entero asociado a un URL o URN dado. La operación GET parcial recibe un intervalo de bytes como parámetro de entrada y recupera un número continuo de bytes de un archivo, donde el número de bytes corresponde al intervalo de bytes recibido. Por tanto, se pueden proporcionar fragmentos de película para la transmisión continua del HTTP, porque una operación GET parcial puede obtener uno o más fragmentos de película individuales. En un fragmento de película, pueden existir varios fragmentos de pista de diferentes pistas. En la transmisión continua del HTTP, una presentación de medios puede ser una recopilación de datos estructurados que es accesible para el cliente. El cliente puede solicitar y descargar la información de datos de medios para presentar un servicio de transmisión continua a un usuario.

[0015] En el ejemplo de transmisión en continuo de datos 3GPP usando transmisión en continuo HTTP, pueden existir múltiples representaciones para datos de vídeo y/o audio de contenido multimedia. Como se describe a continuación, diferentes representaciones pueden corresponder a diferentes características de codificación (por ejemplo, diferentes perfiles o niveles de una norma de codificación de vídeo), diferentes normas de codificación o ampliaciones de normas de codificación (tales como ampliaciones multivista y/o escalables), o diferentes tasas de bits. El manifiesto de dichas representaciones se puede definir en una estructura de datos de descripción de presentación de medios (MPD). Una presentación de medios puede corresponder a un grupo de datos estructurado que es accesible para un dispositivo cliente de transmisión en continuo HTTP. El dispositivo cliente de transmisión en continuo HTTP puede solicitar y descargar información de datos de medios para presentar un servicio de transmisión en continuo a un usuario del dispositivo cliente. Una presentación de medios se puede describir en la estructura de datos MPD, que puede incluir actualizaciones de la MPD.

[0016] Una presentación de medios puede contener una secuencia de uno o más períodos. Cada período se puede extender hasta el inicio del siguiente período, o hasta el final de la presentación de medios en el caso del último período. Cada período puede contener una o más representaciones para el mismo contenido de medios. Una

representación puede ser una de varias versiones codificadas alternativas de audio, vídeo, texto temporizado u otros datos de ese tipo. Las representaciones pueden diferir según el tipo de codificación, por ejemplo, según la tasa de bits, la resolución y/o el códec para los datos de vídeo y la tasa de bits, el idioma y/o el códec para los datos de audio. El término representación se puede usar para referirse a una sección de datos de audio o vídeo codificados correspondientes a un período en particular del contenido multimedia y codificados de una forma en particular.

[0017] Las representaciones de un período en particular se pueden asignar a un grupo indicado en la MPD por un atributo indicativo de un conjunto de adaptación al que pertenecen las representaciones. Las representaciones en el mismo conjunto de adaptación en general se consideran alternativas entre sí, en la medida en que un dispositivo cliente puede conmutar entre estas representaciones de manera dinámica y sin interrupciones, por ejemplo, para realizar una adaptación de ancho de banda. Por ejemplo, cada representación de datos de vídeo para un período particular se puede asignar al mismo conjunto de adaptación, de modo que cualquiera de las representaciones se puede seleccionar para descodificar a fin de presentar datos de medios, tales como datos de vídeo o datos de audio, del contenido multimedia para el período correspondiente. El contenido de medios dentro de un período se puede representar mediante una representación cualquiera del grupo 0, si está presente, o bien la combinación de como máximo una representación de cada grupo no cero, en algunos ejemplos. Los datos de temporización para cada representación de un período se pueden expresar con respecto al tiempo de inicio del período.

[0018] Una representación puede incluir uno o más segmentos. Cada representación puede incluir un segmento de inicialización, o cada segmento de una representación puede ser autoinicializador. Cuando está presente, el segmento de inicialización puede contener información de inicialización para acceder a la representación. En general, el segmento de inicialización no contiene datos de medios. Un segmento se puede referenciar de forma única mediante un identificador, tal como un localizador de recursos uniforme (URL), un nombre de recursos uniforme (URN) o un identificador de recursos uniforme (URI). La MPD puede proporcionar los identificadores para cada segmento. En algunos ejemplos, la MPD también puede proporcionar intervalos de bytes en forma de un atributo de intervalo, que puede corresponder a los datos para un segmento dentro de un archivo accesible por el URL, el URN o el URI

[0019] Se pueden seleccionar diferentes representaciones para una recuperación sustancialmente simultánea para diferentes tipos de datos de medios. Por ejemplo, un dispositivo cliente puede seleccionar una representación de audio, una representación de vídeo y una representación de texto temporizado a partir de las cuales se pueden recuperar segmentos. En algunos ejemplos, el dispositivo cliente puede seleccionar conjuntos de adaptación particulares para realizar una adaptación de ancho de banda. Es decir, el dispositivo cliente puede seleccionar un conjunto de adaptación que incluye representaciones de vídeo, un conjunto de adaptación que incluye representaciones de audio y/o un conjunto de adaptación que incluye texto temporizado. De forma alternativa, el dispositivo cliente puede seleccionar conjuntos de adaptación para determinados tipos de medios (por ejemplo, vídeo) y seleccionar directamente representaciones para otros tipos de medios (por ejemplo, audio y/o texto temporizado).

[0020] La FIG. 1 es un diagrama de bloques que ilustra un sistema 10 de ejemplo que implementa técnicas para transmitir en continuo datos de medios a través de una red. En este ejemplo, el sistema 10 incluye un dispositivo de preparación de contenido 20, un dispositivo servidor 60 y un dispositivo cliente 40. El dispositivo cliente 40 y el dispositivo servidor 60 están acoplados de forma comunicativa por una red 74, que puede comprender Internet. En algunos ejemplos, el dispositivo de preparación de contenido 20 y el dispositivo servidor 60 también pueden estar acoplados por la red 74 u otra red, o pueden estar directamente acoplados de forma comunicativa. En algunos ejemplos, el dispositivo de preparación de contenido 20 y el dispositivo servidor 60 pueden comprender el mismo dispositivo.

[0021] El dispositivo de preparación de contenido 20, en el ejemplo de la FIG. 1, comprende una fuente de audio 22 y una fuente de vídeo 24. La fuente de audio 22 puede comprender, por ejemplo, un micrófono que produce señales eléctricas representativas de datos de audio captados que el codificador de audio 26 va a codificar. De forma alternativa, la fuente de audio 22 puede comprender un medio de almacenamiento que almacena datos de audio previamente registrados, un generador de datos de audio tal como un sintetizador informatizado, o cualquier otra fuente de datos de audio. La fuente de vídeo 24 puede comprender una cámara de vídeo que produce datos de vídeo que el codificador de vídeo 28 va a codificar, un medio de almacenamiento codificado con datos de vídeo previamente registrados, una unidad de generación de datos de vídeo, tal como una fuente de gráficos de ordenador, o cualquier otra fuente de datos de vídeo. El dispositivo de preparación de contenido 20 no está necesariamente acoplado de forma comunicativa al dispositivo servidor 60 en todos los ejemplos, pero puede almacenar contenido multimedia en un medio separado que el dispositivo servidor 60 lee.

[0022] Los datos de audio y vídeo no procesados pueden comprender datos analógicos o digitales. Los datos analógicos se pueden digitalizar antes de que el codificador de audio 26 y/o el codificador de vídeo 28 los codifiquen. La fuente de audio 22 puede obtener datos de audio a partir de un participante que habla mientras el participante que habla está hablando, y la fuente de vídeo 24 puede obtener simultáneamente datos de vídeo del participante que habla. En otros ejemplos, la fuente de audio 22 puede comprender un medio de almacenamiento legible por ordenador que comprende datos de audio almacenados, y la fuente de vídeo 24 puede comprender un medio de almacenamiento legible por ordenador que comprende datos de vídeo almacenados. De esta manera, las técnicas descritas en esta divulgación se pueden aplicar a la transmisión continua en directo y en tiempo real de datos de audio y vídeo, o de

datos de audio y vídeo archivados y preregistrados.

[0023] Las tramas de audio que corresponden a tramas de vídeo son en general tramas de audio que contienen datos de audio que la fuente de audio 22 ha captado (o generado) al mismo tiempo que unos datos de vídeo, que la fuente de vídeo 24 ha captado (o generado), que están contenidos dentro de las tramas de vídeo. Por ejemplo, mientras un participante que habla en general produce, al hablar, datos de audio, la fuente de audio 22 capta los datos de audio, y la fuente de vídeo 24 capta los datos de vídeo del participante que habla al mismo tiempo, es decir, mientras la fuente de audio 22 está captando los datos de audio. Así pues, una trama de audio puede corresponder temporalmente a una o más tramas de vídeo en particular. Por consiguiente, una trama de audio correspondiente a una trama de vídeo corresponde en general a una situación en la que se han captado datos de audio y datos de vídeo al mismo tiempo, y para la que una trama de audio y una trama de vídeo comprenden, respectivamente, los datos de audio y los datos de vídeo que se han captado al mismo tiempo.

[0024] En algunos ejemplos, el codificador de audio 26 puede codificar una marca de tiempo en cada trama de audio codificada, que representa un tiempo en el que se han registrado los datos de audio para la trama de audio codificada y, de forma similar, el codificador de vídeo 28 puede codificar una marca de tiempo en cada trama de vídeo codificada, que representa un tiempo en el que se han registrado los datos de vídeo para la trama de vídeo codificada. En dichos ejemplos, una trama de audio correspondiente a una trama de vídeo puede comprender una trama de audio que comprende una marca de tiempo y una trama de vídeo que comprende la misma marca de tiempo. El dispositivo de preparación de contenido 20 puede incluir un reloj interno a partir del cual el codificador de audio 26 y/o el codificador de vídeo 28 pueden generar las marcas de tiempo, o que la fuente de audio 22 y la fuente de vídeo 24 pueden usar para asociar datos de audio y vídeo, respectivamente, a una marca de tiempo.

[0025] En algunos ejemplos, la fuente de audio 22 puede enviar datos al codificador de audio 26, correspondientes a un tiempo en el que se han registrado los datos de audio, y la fuente de vídeo 24 puede enviar datos al codificador de vídeo 28, correspondientes a un tiempo en el que se han registrado los datos de vídeo. En algunos ejemplos, el codificador de audio 26 puede codificar un identificador de secuencia en unos datos de audio codificados para indicar un orden temporal relativo de los datos de audio codificados, pero sin indicar necesariamente un tiempo absoluto en el que se han registrado los datos de audio y, de forma similar, el codificador de vídeo 28 también puede usar identificadores de secuencia para indicar un orden temporal relativo de los datos de vídeo codificados. De forma similar, en algunos ejemplos, un identificador de secuencia se puede asignar a, o en cualquier caso correlacionar con, una marca de tiempo.

[0026] El codificador de audio 26, en general, produce un flujo de datos de audio codificados, mientras que el codificador de vídeo 28 produce un flujo de datos de vídeo codificados. Cada flujo de datos individual (ya sea de audio o vídeo) se puede denominar flujo elemental. Un flujo elemental es un componente único codificado digitalmente (y posiblemente comprimido) de una representación. Por ejemplo, la parte de vídeo o audio codificado de la representación puede ser un flujo elemental. Un flujo elemental se puede convertir en un flujo elemental paquetizado (PES) antes de encapsularse dentro de un archivo de vídeo. Dentro de la misma representación, se puede usar un ID de flujo para distinguir los paquetes PES que pertenecen a un flujo elemental de los otros. La unidad básica de datos de un flujo elemental es un paquete de flujo elemental paquetizado (PES). Por tanto, los datos de vídeo codificados corresponden en general a flujos de vídeo elementales. De forma similar, los datos de audio corresponden a uno o más flujos elementales respectivos.

[0027] Muchas normas de codificación de vídeo, tales como ITU-T H.264/AVC y la inminente norma de codificación de vídeo de alta eficacia (HEVC), definen la sintaxis, la semántica y el proceso de descodificación para flujos de bits sin errores, cualquiera de los cuales se ajusta a un determinado perfil o nivel. Las normas de codificación de vídeo típicamente no especifican el codificador, pero el codificador se ocupa de garantizar que los flujos de bits generados cumplan las normas para un descodificador. En el contexto de las normas de codificación de vídeo, un "perfil" corresponde a un subconjunto de algoritmos, rasgos característicos o herramientas y restricciones que se les aplican. Como se define en la norma H.264, por ejemplo, un "perfil" es un subconjunto de toda la sintaxis del flujo de bits especificada por la norma H.264. Un "nivel" corresponde a las limitaciones del consumo de recursos del descodificador, tales como, por ejemplo, memoria y cálculo del descodificador, que están relacionados con la resolución de las imágenes, la velocidad de bits y la velocidad de procesamiento de bloques. Un perfil se puede señalizar con un valor idc de perfil (indicador de perfil), mientras que un nivel se puede señalizar con un valor level_idc (indicador de nivel).

[0028] La norma H.264, por ejemplo, reconoce que, dentro de los límites impuestos por la sintaxis de un perfil dado, todavía es posible requerir una gran variación del rendimiento de los codificadores y descodificadores, dependiendo de los valores adoptados por los elementos de sintaxis en el flujo de bits, tales como el tamaño especificado de las imágenes descodificadas. La norma H.264 reconoce, además, que, en muchas aplicaciones, no es ni práctico ni económico implementar un descodificador capaz de tratar todos los usos hipotéticos de la sintaxis dentro de un perfil en particular. Por consiguiente, la norma H.264 define un "nivel" como un conjunto especificado de restricciones impuestas a los valores de los elementos de sintaxis en el flujo de bits. Estas restricciones pueden ser simples limitaciones de valores. De forma alternativa, estas restricciones pueden adoptar la forma de restricciones sobre combinaciones aritméticas de valores (por ejemplo, la anchura de la imagen multiplicada por la altura de la imagen

multiplicada por el número de imágenes descodificadas por segundo). La norma H.264 establece, además, que las implementaciones individuales pueden admitir un nivel diferente para cada perfil admitido.

[0029] Un descodificador que se ajusta a un perfil normalmente admite todos los rasgos característicos definidos en el perfil. Por ejemplo, como rasgo característico de codificación, la codificación de imágenes B no está admitida en el perfil de línea de base de H.264/AVC, pero está admitida en otros perfiles de H.264/AVC. Un descodificador que se ajusta a un nivel deberá ser capaz de descodificar cualquier flujo de bits que no requiere recursos fuera de las limitaciones definidas en el nivel. Las definiciones de perfiles y niveles pueden ser útiles para la interpretabilidad. Por ejemplo, durante la transmisión de vídeo, se pueden negociar y acordar un par de definiciones de perfil y nivel para una sesión de transmisión completa. Más específicamente, en H.264/AVC, un nivel puede definir limitaciones en el número de macrobloques que es necesario procesar, el tamaño de la memoria intermedia de imágenes descodificadas (DPB), el tamaño de la memoria intermedia de imágenes codificadas (CPB), el intervalo de vectores de movimiento vertical, el número máximo de vectores de movimiento para cada dos MB consecutivos y si un bloque B puede tener divisiones de submacrobloque inferiores a 8x8 píxeles. De esta manera, un descodificador puede determinar si el descodificador es capaz de descodificar apropiadamente el flujo de bits.

[0030] En el ejemplo de la FIG. 1, la unidad de encapsulación 30 del dispositivo de preparación de contenido 20 recibe flujos elementales que comprenden datos de vídeo codificados desde el codificador de vídeo 28 y flujos elementales que comprenden datos de audio codificados desde el codificador de audio 26. En algunos ejemplos, el codificador de vídeo 28 y el codificador de audio 26 pueden incluir, cada uno, paquetizadores para formar paquetes PES a partir de datos codificados. En otros ejemplos, el codificador de vídeo 28 y el codificador de audio 26 pueden interactuar, cada uno, con los paquetizadores respectivos para formar paquetes PES a partir de datos codificados. En otros ejemplos más, la unidad de encapsulación 30 puede incluir paquetizadores para formar paquetes PES a partir de datos de audio y de vídeo codificados.

[0031] El codificador de vídeo 28 puede codificar datos de vídeo de contenido multimedia en una variedad de formas, para producir diferentes representaciones del contenido multimedia a diversas tasas de bits y con diversas características, tales como resoluciones de píxeles, velocidades de tramas, conformidad con diversas normas de codificación, conformidad con diversos perfiles y/o niveles de perfiles para diversas normas de codificación, representaciones que tienen una o múltiples vistas (por ejemplo, para reproducción bidimensional o tridimensional), u otras características de ese tipo. Una representación, como se usa en esta divulgación, puede comprender uno de datos de audio, datos de vídeo, datos de texto (por ejemplo, para subtítulos cerrados) u otros datos de este tipo. La representación puede incluir un flujo elemental, tal como un flujo elemental de audio o un flujo elemental de vídeo. Cada paquete PES puede incluir un identificador stream_id que identifica el flujo elemental al que pertenece el paquete PES. La unidad de encapsulación 30 es responsable de ensamblar flujos elementales en archivos de vídeo (por ejemplo, segmentos) de diversas representaciones.

[0032] La unidad de encapsulación 30 recibe paquetes PES para flujos elementales de una representación desde el codificador de audio 26 y el codificador de vídeo 28 y forma las correspondientes unidades de capa de abstracción de red (NAL) a partir de los paquetes PES. En el ejemplo de la H.264/AVC (codificación de vídeo avanzada), los segmentos de vídeo codificados están organizados en unidades de NAL, que proporcionan una representación de vídeo "apta para redes" dirigida a aplicaciones tales como la videotelefonia, el almacenamiento, la radiodifusión o la transmisión continua. Las unidades NAL se pueden clasificar en unidades NAL de capa de codificación de vídeo (VCL) y unidades NAL no VCL. Las unidades VCL pueden contener el motor de compresión central y pueden incluir datos a nivel de bloque, macrobloque y/o fragmento. Otras unidades NAL pueden ser unidades NAL no VCL. En algunos ejemplos, una imagen codificada en una instancia de tiempo, normalmente presentada como una imagen codificada primaria, puede estar contenida en una unidad de acceso, que puede incluir una o más unidades NAL.

[0033] Las unidades NAL no VCL pueden incluir unidades NAL de conjunto de parámetros y unidades NAL SEI, entre otras. Los conjuntos de parámetros pueden contener información de cabecera a nivel de secuencia (en conjuntos de parámetros de secuencia (SPS)) y la información de cabecera a nivel de imagen que cambia ocasionalmente (en conjuntos de parámetros de imagen (PPS)). Con los conjuntos de parámetros (por ejemplo, PPS y SPS), la información que cambia ocasionalmente no necesita ser repetida para cada secuencia o imagen, de ahí que pueda mejorarse la eficacia de la codificación. Además, el uso de conjuntos de parámetros puede permitir la transmisión fuera de banda de la información de cabecera importante, evitando la necesidad de transmisiones redundantes para la resistencia a los errores. En los ejemplos de transmisión fuera de banda, las unidades NAL de conjunto de parámetros se pueden transmitir en un canal diferente al de otras unidades NAL, tales como las unidades NAL SEI.

[0034] La información de mejora complementaria (SEI) puede contener información que no es necesaria para descodificar las muestras de imágenes codificadas a partir de las unidades NAL VCL, pero puede ayudar en los procesos relacionados con la descodificación, visualización, resistencia a los errores y otros propósitos. Los mensajes de SEI pueden estar contenidos en unidades NAL no VCL. Los mensajes de SEI son la parte normativa de algunas memorias descriptivas habituales y, por tanto, no siempre son obligatorios para la implementación de descodificadores que cumplen las normas. Los mensajes de SEI pueden ser mensajes de SEI a nivel de secuencia o mensajes de SEI a nivel de imagen. Parte de la información a nivel de secuencia puede estar contenida en mensajes de SEI, tales como mensajes de SEI de información de adaptabilidad a escala en el ejemplo de SVC y mensajes de SEI de

información de adaptabilidad a escala de la vista en MVC. Estos ejemplos de mensajes de SEI pueden transmitir información, por ejemplo, sobre extracción de puntos de funcionamiento y características de los puntos de funcionamiento. Además, la unidad de encapsulación 30 puede formar un archivo de manifiesto, tal como una descripción de presentación de medios (MPD) que describe características de las representaciones. La unidad de encapsulación 30 puede formatear la MPD de acuerdo con un lenguaje de marcado extensible (XML).

[0035] La unidad de encapsulación 30 puede proporcionar datos para una o más representaciones de contenido multimedia, junto con el archivo de manifiesto (por ejemplo, la MPD), a la interfaz de salida 32. La interfaz de salida 32 puede comprender una interfaz de red o una interfaz para escribir en un medio de almacenamiento, tal como una interfaz de bus serie universal (USB), una grabadora o copiadora de CD o DVD, una interfaz para medios de almacenamiento magnéticos o flash, u otras interfaces para almacenar o transmitir datos de medios. La unidad de encapsulación 30 puede proporcionar datos de cada una de las representaciones de contenido multimedia a la interfaz de salida 32, que puede enviar los datos al dispositivo servidor 60 por medio de transmisión por red o medios de almacenamiento. En el ejemplo de la FIG. 1, el dispositivo servidor 60 incluye un medio de almacenamiento 62 que almacena diversos contenidos multimedia 64, incluyendo cada uno un respectivo archivo de manifiesto 66 y una o más representaciones 68A a 68N (representaciones 68). En algunos ejemplos, la interfaz de salida 32 también puede enviar datos directamente a la red 74.

[0036] En algunos ejemplos, las representaciones 68 se pueden separar en conjuntos de adaptación. Es decir, diversos subconjuntos de representaciones 68 pueden incluir respectivos conjuntos comunes de características, tales como códec, perfil y nivel, resolución, número de vistas, formato de archivo para segmentos, información de tipo de texto que puede identificar un idioma u otras características de un texto que se va a visualizar con la representación y/o datos de audio que se van a descodificar y presentar, por ejemplo, mediante altavoces, información de ángulo de cámara que puede describir un ángulo de cámara o una perspectiva de cámara real de una escena para representaciones del conjunto de adaptación, información de calificación que describe la idoneidad del contenido para audiencias en particular, o similares.

[0037] El archivo de manifiesto 66 puede incluir datos indicativos de los subconjuntos de representaciones 68 correspondientes a conjuntos de adaptación en particular, así como características comunes para los conjuntos de adaptación. El archivo de manifiesto 66 también puede incluir datos representativos de características individuales, tales como las tasas de bits, para representaciones individuales de conjuntos de adaptación. De esta manera, un conjunto de adaptación puede hacer posible una adaptación simplificada del ancho de banda de red. Las representaciones de un conjunto de adaptación se pueden indicar usando elementos hijo de un elemento del conjunto de adaptación del archivo de manifiesto 66.

[0038] El dispositivo servidor 60 incluye una unidad de procesamiento de peticiones 70 y una interfaz de red 72. En algunos ejemplos, el dispositivo servidor 60 puede incluir una pluralidad de interfaces de red. Además, uno cualquiera o todos los rasgos característicos del dispositivo servidor 60 se pueden implementar en otros dispositivos de una red de entrega de contenido, tales como encaminadores, puentes, dispositivos proxy, conmutadores u otros dispositivos. En algunos ejemplos, los dispositivos intermedios de una red de entrega de contenido pueden almacenar en memoria caché datos de contenido multimedia 64, e incluir componentes que se ajustan sustancialmente a los del dispositivo servidor 60. En general, la interfaz de red 72 está configurada para enviar y recibir datos por medio de la red 74.

[0039] La unidad de procesamiento de peticiones 70 está configurada para recibir peticiones de red desde dispositivos cliente, tales como el dispositivo cliente 40, para datos del medio de almacenamiento 62. Por ejemplo, la unidad de procesamiento de peticiones 70 puede implementar el protocolo de transferencia de hipertexto (HTTP) versión 1.1, como se describe en RFC 2616, "Hypertext Transfer Protocol - HTTP/1.1", de R. Fielding y otros, Grupo de Trabajo de la Red, IETF, junio de 1999. Es decir, la unidad de procesamiento de peticiones 70 puede estar configurada para recibir peticiones GET o GET parciales HTTP y proporcionar datos de contenido multimedia 64 como respuesta a las peticiones. Las peticiones pueden especificar un segmento de una de las representaciones 68, por ejemplo, usando un URL del segmento. En algunos ejemplos, las peticiones también pueden especificar uno o más intervalos de bytes del segmento, comprendiendo por tanto peticiones GET parciales. La unidad de procesamiento de peticiones 70 puede estar configurada, además, para atender peticiones HEAD HTTP para proporcionar datos de cabecera de un segmento de una de las representaciones 68. En cualquier caso, la unidad de procesamiento de peticiones 70 puede estar configurada para procesar las peticiones para proporcionar los datos solicitados a un dispositivo solicitante, tal como el dispositivo cliente 40.

[0040] De forma adicional o alternativa, la unidad de procesamiento de peticiones 70 puede estar configurada para entregar datos de medios por medio de un protocolo de radiodifusión o multidifusión, tal como el eMBMS. El dispositivo de preparación de contenido 20 puede crear segmentos y/o subsegmentos DASH, sustancialmente de la misma manera que se ha descrito, pero el dispositivo servidor 60 puede entregar estos segmentos o subsegmentos usando el eMBMS u otro protocolo de transporte de red de radiodifusión o multidifusión. Por ejemplo, la unidad de procesamiento de peticiones 70 puede estar configurada para recibir una petición para unirse a un grupo de multidifusión desde el dispositivo cliente 40. Es decir, el dispositivo servidor 60 puede comunicar una dirección de protocolo de Internet (IP), asociada a un grupo de multidifusión a unos dispositivos cliente, que incluyen el dispositivo cliente 40, asociados a un contenido de medios en particular (por ejemplo, radiodifusión de un acontecimiento en

directo). El dispositivo cliente 40, a su vez, puede presentar una petición para unirse al grupo de multidifusión. Esta petición se puede propagar por toda la red 74, por ejemplo, los encaminadores que componen la red 74, de modo que se hace que los encaminadores dirijan el tráfico destinado a la dirección IP asociada al grupo de multidifusión a los dispositivos cliente abonados, tales como el dispositivo cliente 40.

[0041] Como se ilustra en el ejemplo de la FIG. 1, el contenido multimedia 64 incluye el archivo de manifiesto 66, que puede corresponder a una descripción de presentación de medios (MPD). El archivo de manifiesto 66 puede contener descripciones de diferentes representaciones alternativas 68 (por ejemplo, servicios de vídeo con diferentes calidades) y la descripción puede incluir, por ejemplo, información de códec, un valor de perfil, un valor de nivel, una tasa de bits y otras características descriptivas de las representaciones 68. El dispositivo cliente 40 puede recuperar la MPD de una presentación de medios para determinar cómo acceder a segmentos de las representaciones 68.

[0042] En particular, la unidad de recuperación 52 puede recuperar datos de configuración (no mostrados) del dispositivo cliente 40 para determinar las capacidades de descodificación del descodificador de vídeo 48 y las capacidades de representación de la salida de vídeo 44. Los datos de configuración también pueden incluir cualquiera o todas las preferencias de idioma seleccionadas por un usuario del dispositivo cliente 40, una o más perspectivas de cámara correspondientes a las preferencias de profundidad establecidas por el usuario del dispositivo cliente 40 y/o una preferencia de calificación seleccionada por el usuario del dispositivo cliente 40. La unidad de recuperación 52 puede comprender, por ejemplo, un navegador web o un cliente de medios configurados para presentar peticiones GET y GET parcial HTTP. La unidad de recuperación 52 puede corresponder a unas instrucciones de software ejecutadas por uno o más procesadores o unidades de procesamiento (no mostrados) del dispositivo cliente 40. En algunos ejemplos, la totalidad o unas partes de la funcionalidad descrita con respecto a la unidad de recuperación 52 se pueden implementar en hardware, o una combinación de hardware, software y/o firmware, donde se puede proporcionar el hardware requerido para ejecutar instrucciones para software o firmware.

[0043] La unidad de recuperación 52 puede comparar las capacidades de descodificación y representación del dispositivo cliente 40 con las características de las representaciones 68 indicadas por la información del archivo de manifiesto 66. La unidad de recuperación 52 puede recuperar inicialmente al menos una parte del archivo de manifiesto 66 para determinar las características de las representaciones 68. Por ejemplo, la unidad de recuperación 52 puede solicitar una parte del archivo de manifiesto 66 que describe las características de uno o más conjuntos de adaptación. La unidad de recuperación 52 puede seleccionar un subconjunto de representaciones 68 (por ejemplo, un conjunto de adaptación) que tiene características que se pueden satisfacer mediante las capacidades de codificación y representación del dispositivo cliente 40. La unidad de recuperación 52 puede, a continuación, determinar las tasas de bits para las representaciones del conjunto de adaptación, determinar una cantidad actualmente disponible de ancho de banda de red y recuperar segmentos de una de las representaciones que tiene una tasa de bits que se puede satisfacer mediante el ancho de banda de red.

[0044] En general, las representaciones de tasas de bits mayores pueden producir una reproducción de vídeo de mayor calidad, mientras que las representaciones de tasas de bits más bajas pueden proporcionar una reproducción de vídeo de calidad suficiente cuando el ancho de banda de red disponible se reduce. En consecuencia, cuando el ancho de banda de red disponible es relativamente alto, la unidad de recuperación 52 puede recuperar datos de representaciones de tasas de bits relativamente altas, mientras que cuando el ancho de banda de red disponible es bajo, la unidad de recuperación 52 puede recuperar datos de representaciones de tasas de bits relativamente bajas. De esta manera, el dispositivo cliente 40 puede transmitir en continuo datos de medios a través de la red 74 mientras que también se adapta a la disponibilidad cambiante de ancho de banda de red de la red 74.

[0045] De forma adicional o alternativa, la unidad de recuperación 52 puede estar configurada para recibir datos de acuerdo con un protocolo de red de radiodifusión o multidifusión, tal como la multidifusión eMBMS o IP. En dichos ejemplos, la unidad de recuperación 52 puede presentar una petición para unirse a un grupo de red de multidifusión asociado a un contenido de medios en particular. Después de unirse al grupo de multidifusión, la unidad de recuperación 52 puede recibir datos del grupo de multidifusión sin peticiones adicionales emitidas al dispositivo servidor 60 o al dispositivo de preparación de contenido 20. La unidad de recuperación 52 puede presentar una petición para abandonar el grupo de multidifusión cuando ya no se necesitan datos del grupo de multidifusión, por ejemplo, para detener la reproducción o para cambiar canales a un grupo de multidifusión diferente.

[0046] La interfaz de red 54 puede recibir y proporcionar datos de segmentos de una representación seleccionada a la unidad de recuperación 52, que a su vez puede proporcionar los segmentos a la unidad de procesamiento del formato de archivo 50. La unidad de procesamiento del formato de archivo 50 puede desencapsular elementos de un archivo de vídeo en flujos PES constituyentes, desempaquetar los flujos PES para recuperar datos codificados y enviar los datos codificados al descodificador de audio 46 o bien al descodificador de vídeo 48, dependiendo de si los datos codificados forman parte de un flujo de audio o vídeo, por ejemplo, como lo indican las cabeceras de paquetes PES del flujo. El descodificador de audio 46 descodifica datos de audio codificados y envía los datos de audio descodificados a la salida de audio 42, mientras que el descodificador de vídeo 48 descodifica datos de vídeo codificados y envía los datos de vídeo descodificados, que pueden incluir una pluralidad de vistas de un flujo, a la salida de vídeo 44.

[0047] El codificador de vídeo 28, el descodificador de vídeo 48, el codificador de audio 26, el descodificador de audio 46, la unidad de encapsulación 30, la unidad de recuperación 52 y la unidad de procesamiento del formato de archivo 50 se pueden implementar cada uno como cualquiera de una variedad de circuitos de procesamiento adecuados, según corresponda, tales como uno o más microprocesadores, procesadores de señales digitales (DSP), circuitos integrados específicos de la aplicación (ASIC), matrices de puertas programables in situ (FPGA), circuitos lógicos discretos, software, hardware, firmware o cualquier combinación de los mismos. Tanto el codificador de vídeo 28 como el descodificador de vídeo 48 pueden estar incluidos en uno o más codificadores o descodificadores, ambos de los cuales pueden estar integrados como parte de un codificador/descodificador (CÓDEC) de vídeo combinado. Asimismo, tanto el codificador de audio 26 como el descodificador de audio 46 pueden estar incluidos en uno o más codificadores o descodificadores, ambos de los cuales pueden estar integrados como parte de un CÓDEC combinado. Un aparato que incluye un codificador de vídeo 28, un descodificador de vídeo 48, un codificador de audio 26, un descodificador de audio 46, una unidad de encapsulación 30, una unidad de recuperación 52 y/o una unidad de procesamiento del formato de archivo 50 puede comprender un circuito integrado, un microprocesador y/o un dispositivo de comunicación inalámbrica, tal como un teléfono móvil.

[0048] El dispositivo cliente 40, el dispositivo servidor 60 y/o el dispositivo de preparación de contenido 20 pueden estar configurados para funcionar de acuerdo con las técnicas de esta divulgación. Con propósitos de ejemplo, esta divulgación describe estas técnicas con respecto al dispositivo cliente 40 y al dispositivo servidor 60. Sin embargo, se deberá entender que el dispositivo de preparación de contenido 20 puede estar configurado para realizar estas técnicas, en lugar (o, además) del dispositivo servidor 60.

[0049] La unidad de encapsulación 30 puede formar unidades NAL que comprenden una cabecera que identifica un programa al cual pertenece la unidad NAL, así como una carga útil, por ejemplo, datos de audio, datos de vídeo o datos que describen el flujo de transporte o de programa al cual corresponde la unidad NAL. Por ejemplo, en H.264/AVC, una unidad NAL incluye una cabecera de 1 byte y una carga útil de tamaño variable. Una unidad NAL que incluye datos de vídeo en su carga útil puede comprender diversos niveles de granularidad de datos de vídeo. Por ejemplo, una unidad NAL puede comprender un bloque de datos de vídeo, una pluralidad de bloques, un fragmento de datos de vídeo o una imagen completa de datos de vídeo. La unidad de encapsulación 30 puede recibir datos de vídeo codificados desde el codificador de vídeo 28 en forma de paquetes PES de flujos elementales. La unidad de encapsulación 30 puede asociar cada flujo elemental a un programa correspondiente.

[0050] La unidad de encapsulación 30 también puede ensamblar unidades de acceso desde una pluralidad de unidades NAL. En general, una unidad de acceso puede comprender una o más unidades NAL para representar una trama de datos de vídeo, así como datos de audio correspondientes a la trama cuando dichos datos de audio están disponibles. Una unidad de acceso incluye en general todas las unidades NAL para una instancia de tiempo de salida, por ejemplo, todos los datos de audio y vídeo para una instancia de tiempo. Por ejemplo, si cada visualización tiene una frecuencia de tramas de 20 tramas por segundo (fps), cada instancia de tiempo puede corresponder a un intervalo de tiempo de 0,05 segundos. Durante este intervalo de tiempo, las tramas específicas para todas las vistas de la misma unidad de acceso (la misma instancia de tiempo) se pueden representar simultáneamente. En un ejemplo, una unidad de acceso puede comprender una imagen codificada en una instancia de tiempo, que se puede presentar como una imagen codificada primaria.

[0051] Por consiguiente, una unidad de acceso puede comprender todas las tramas de audio y vídeo de una instancia temporal común, por ejemplo, todas las vistas correspondientes al tiempo X. Esta divulgación también se refiere a una imagen codificada de una vista particular como un "componente de vista". Es decir, un componente de vista puede comprender una imagen (o trama) codificada para una vista en particular en un tiempo en particular. Por consiguiente, se puede definir una unidad de acceso que comprende todos los componentes de vista de una instancia temporal común. El orden de descodificación de las unidades de acceso no necesita ser el mismo que el orden de salida o de visualización.

[0052] Una presentación de medios puede incluir una descripción de presentación de medios (MPD), que puede contener descripciones de diferentes representaciones alternativas (por ejemplo, servicios de vídeo con diferentes calidades) y la descripción puede incluir, por ejemplo, información de códec, un valor de perfil y un valor de nivel. Una MPD es un ejemplo de archivo de manifiesto, tal como el archivo de manifiesto 66. El dispositivo cliente 40 puede recuperar la MPD de una presentación de medios para determinar cómo acceder a fragmentos de película de diversas presentaciones. Los fragmentos de película pueden estar situados en cuadros de fragmento de película (cuadros moof) de archivos de vídeo.

[0053] El archivo de manifiesto 66 (que puede comprender, por ejemplo, una MPD) puede comunicar la disponibilidad de segmentos de representaciones 68. Es decir, la MPD puede incluir información que indica el tiempo de hora de reloj en el cual un primer segmento de una de las representaciones 68 queda disponible, así como información que indica las duraciones de los segmentos dentro de las representaciones 68. De esta manera, la unidad de recuperación 52 del dispositivo cliente 40 puede determinar cuándo está disponible cada segmento, en base al tiempo de inicio, así como de las duraciones de los segmentos que preceden a un segmento en particular.

[0054] Después de que la unidad de encapsulación 30 haya ensamblado las unidades de NAL y/o las unidades de

acceso en un archivo de vídeo, en base a los datos recibidos, la unidad de encapsulación 30 pasa el archivo de vídeo a la interfaz de salida 32 para su salida. En algunos ejemplos, la unidad de encapsulación 30 puede almacenar el archivo de vídeo localmente o enviar el archivo de vídeo a un servidor remoto por medio de la interfaz de salida 32, en lugar de enviar el archivo de vídeo directamente al dispositivo cliente 40. La interfaz de salida 32 puede comprender, por ejemplo, un transmisor, un transceptor, un dispositivo para escribir datos en un medio legible por ordenador tal como, por ejemplo, una unidad óptica, una unidad de medios magnéticos (por ejemplo, una unidad de disquetes), un puerto de bus serie universal (USB), una interfaz de red u otra interfaz de salida. La interfaz de salida 32 emite el archivo de vídeo a un medio legible por ordenador, tal como, por ejemplo, una señal de transmisión, un medio magnético, un medio óptico, una memoria, una unidad flash u otro medio legible por ordenador.

[0055] La interfaz de red 54 puede recibir una unidad NAL o unidad de acceso por medio de la red 74 y proporcionar la unidad NAL o la unidad de acceso a la unidad de procesamiento del formato de archivo 50, por medio de la unidad de recuperación 52. La unidad de procesamiento del formato de archivo 50 puede desencapsular un elemento de un archivo de vídeo en flujos PES constituyentes, desempaquetar los flujos PES para recuperar los datos codificados y enviar los datos codificados al descodificador de audio 46 o al descodificador de vídeo 48, dependiendo de si los datos codificados forman parte de un flujo de audio o vídeo, por ejemplo, como se indica en las cabeceras de paquetes PES del flujo. El descodificador de audio 46 descodifica datos de audio codificados y envía los datos de audio descodificados a la salida de audio 42, mientras que el descodificador de vídeo 48 descodifica datos de vídeo codificados y envía los datos de vídeo descodificados, que pueden incluir una pluralidad de vistas de un flujo, a la salida de vídeo 44.

[0056] El dispositivo de preparación de contenido 20 (a través de, por ejemplo, la unidad de encapsulación 30) y el dispositivo cliente 40 (a través de, por ejemplo, la unidad de procesamiento del formato de archivo 50) pueden utilizar uno o varios de muchos formatos de archivo para encapsular y/o desencapsular contenido de vídeo. El ISOBMFF se usa como la base para muchos formatos de encapsulación de códec, tales como el formato de archivo AVC, así como para muchos formatos de contenedor multimedia, tales como el formato de archivo MPEG-4, el formato de archivo 3GPP (3GP) y el formato de archivo DVB.

[0057] Además de los medios continuos, tales como el audio y el vídeo, los medios estáticos, tales como las imágenes, así como los metadatos, se pueden almacenar en un archivo que se ajusta al ISOBMFF. Los archivos estructurados de acuerdo con el ISOBMFF se pueden usar para muchos propósitos, incluyendo la reproducción local de archivos de medios, la descarga progresiva de un archivo remoto, segmentos para la transmisión en continuo dinámica adaptativa a través de HTTP (DASH), contenedores para contenido que se va a transmitir en continuo y sus instrucciones de empaquetado y el registro de flujos de medios recibidos en tiempo real.

[0058] Una caja es la estructura sintáctica elemental en el ISOBMFF, que incluye un tipo de caja codificada de cuatro caracteres, un recuento de bytes de la caja y la carga útil. Un archivo ISOBMFF consiste en una secuencia de cajas, y las cajas pueden contener otras cajas. Una caja de película ("moov") contiene los metadatos para los flujos continuos de medios presentes en el archivo, cada uno representado en el archivo como una pista. Los metadatos para una pista están contenidos en una caja de pista ("trak"), mientras que el contenido de medios de una pista está contenido en una caja de datos de medios ("mdat") o directamente en un archivo separado. El contenido de medios para pistas consiste en una secuencia de muestras, tales como unas unidades de acceso de audio o vídeo.

[0059] El ISOBMFF especifica los siguientes tipos de pistas: una pista de medios, que contiene un flujo de medios elemental, una pista de indicaciones, que incluye instrucciones de transmisión de medios o representa un flujo de paquetes recibido, y una pista de metadatos temporizados, que comprende metadatos sincronizados en el tiempo.

[0060] Aunque originalmente se diseñó para el almacenamiento, el ISOBMFF ha demostrado ser muy valioso para la transmisión en continuo, por ejemplo, para una descarga progresiva o DASH. Para propósitos de transmisión en continuo, se pueden usar los fragmentos de película definidos en el ISOBMFF.

[0061] Los metadatos para cada pista incluyen una lista de entradas de descripción de muestra, cada una de las cuales proporciona el formato de codificación o encapsulación usado en la pista y los datos de inicialización necesarios para procesar ese formato. Cada muestra está asociada a una de las entradas de descripción de muestra de la pista.

[0062] El ISOBMFF permite especificar metadatos específicos de muestra con diversos mecanismos. Las cajas específicas dentro de la caja de tabla de muestras ("stbl") se han normalizado para responder a necesidades comunes. Por ejemplo, se usa una caja de muestras de sincronización ("stss") para enumerar las muestras de acceso aleatorio de la pista. El mecanismo de agrupación de muestras permite la correlación de muestras de acuerdo con un tipo de agrupación de cuatro caracteres en grupos de muestras que comparten la misma propiedad especificada como una entrada de descripción de grupo de muestras en el archivo. Se han especificado diversos tipos de agrupación en el ISOBMFF.

[0063] La especificación ISOBMFF especifica seis tipos de puntos de acceso de flujo (SAP) para usar con DASH. Los dos primeros tipos de SAP (tipos 1 y 2) corresponden a imágenes IDR en H.264/AVC y HEVC. El tercer tipo de SAP (tipo 3) corresponde a puntos de acceso aleatorio de GOP abierto, por consiguiente, a imágenes BLA o CRA en

HEVC. El cuarto tipo de SAP (tipo 4) corresponde a puntos de acceso aleatorio de GDR.

[0064] En ISO/IEC 14496-15, se especifican varios tipos de entrada de muestra (también denominados nombres de entrada de muestra).

[0065] En el formato de archivo HEVC (cláusula 8 de ISO/IEC 14496-15), se especifican los tipos de entrada de muestra 'hvc1' y 'hevl'. Una restricción para el tipo de entrada de muestra 'hevl' se especifica de la siguiente manera: Cuando el nombre de entrada de muestra es 'hev1', se aplica lo siguiente: Si la muestra es un punto de acceso aleatorio, todos los conjuntos de parámetros necesarios para descodificar esa muestra se incluirán en la entrada de la muestra o en la muestra misma.

[0066] De lo contrario (la muestra no es un punto de acceso aleatorio), todos los conjuntos de parámetros necesarios para descodificar la muestra se incluirán en la entrada de la muestra o en cualquiera de las muestras, desde el punto de acceso aleatorio anterior a esa propia muestra, inclusive.

[0067] El propósito de esta restricción también es permitir un acceso aleatorio conveniente, desde la muestra que es un punto de acceso aleatorio sin la necesidad de buscar y recuperar conjuntos de parámetros de muestras anteriores.

[0068] En el formato de archivo HEVC en capas (L-HEVC) (cláusula 9 de ISO/IEC 14496-15), se especifican los tipos de entrada de muestra 'hvc2', 'hev2', 'lhv1' y 'lhe1'. Una restricción para el tipo de entrada de muestra 'lhe1' se especifica de la siguiente manera:

[0069] Cuando el nombre de entrada de muestra es 'lhe1', se aplica lo siguiente:

Las restricciones a continuación imponen restricciones en la colocación de conjuntos de parámetros fuera de banda (en entradas de muestra) y conjuntos de parámetros dentro de banda (en muestras), para permitir un acceso aleatorio conveniente desde unidades de acceso que contienen imágenes IRAP al menos en algunas capas. Con estas restricciones, un lector de archivos que se inicializa con las entradas de muestra y avanza desde una unidad de acceso en la que todas las imágenes son imágenes IRAP tendrá todos los conjuntos de parámetros que necesita.

[0070] Para cualquier muestra particular en una pista particular, la muestra colocada temporalmente en otra pista se define como aquella con el mismo tiempo de descodificación que la de esta muestra particular.

[0071] Para una imagen IRAP de una muestra, pista y capa dados, cada conjunto de parámetros necesarios para descodificar la imagen IRAP se incluirá en uno de los siguientes:

a. la entrada de muestra que se aplica a la muestra dada en la pista dada

b. la entrada de muestra de la muestra inicial de una pista que lleva una capa de referencia de la capa dada, donde la muestra inicial es la muestra colocada temporalmente de la muestra dada, cuando la muestra colocada temporalmente contiene una imagen IRAP de la capa de referencia, o la muestra anterior que contiene una imagen IRAP de la capa de referencia

c. la muestra dada en sí, posiblemente mediante el uso de extractores

d. cuando está presente, cualquier muestra colocada temporalmente de las pistas que llevan capas de referencia de la capa dada, posiblemente mediante el uso de extractores

[0072] Para una imagen no IRAP de una muestra, pista y capa dados, cada conjunto de parámetros necesarios para descodificar esa imagen se incluirá en uno de los siguientes:

a. la entrada de muestra que se aplica a la muestra dada en la pista dada

b. la entrada de muestra de la muestra inicial de una pista que lleva una capa de referencia de la capa dada, donde la muestra inicial es la muestra colocada temporalmente de la muestra dada, cuando la muestra colocada temporalmente contiene una imagen IRAP de la capa de referencia, o la muestra anterior que contiene una imagen IRAP de la capa de referencia

c. cualquiera de las muestras en la pista dada desde la muestra anterior que contiene una imagen IRAP en la capa dada a la muestra dada en sí, inclusive, posiblemente mediante el uso de extractores

d. cuando está presente, cualquiera de las muestras en una pista que lleva una capa de referencia de la capa dada desde la muestra colocada temporalmente de la muestra anterior que contiene una imagen IRAP en la capa dada hasta la muestra colocada temporalmente de la muestra dada, inclusive, posiblemente usando

extractores

[0073] El propósito de esta restricción también es permitir un acceso aleatorio conveniente, pero para flujos de bits que contienen múltiples capas, como se describe en detalle anteriormente como parte de la descripción de la restricción.

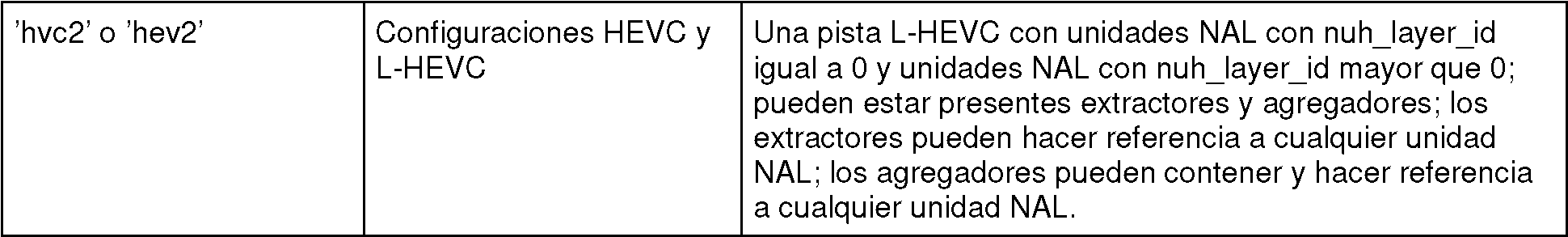

La Tabla 10 de ISO/IEC 14496-15 (copiada a continuación) muestra todos los usos posibles de entradas de muestra, configuraciones y las herramientas L-HEV C para pistas HEVC y L-HEVC:

[0074] Esta divulgación reconoce que los diseños actuales de tipos de entrada de muestra en los formatos de archivo para HEVC y L-HEVC (por ejemplo, en las cláusulas 8 y 9 de ISO/IEC 14496-15) pueden presentar varios problemas. Por ejemplo:

[0075] Para describir un primer problema potencial, se observa que la fila 2 de la Tabla 10 de ISO/IEC 14496-15 establece:

[0076] Mientras tanto, la fila 4 de la Tabla 10 de ISO/IEC 14496-15 establece:

[0077] Cuando el tipo de entrada de muestra es 'hvc1', 'hev1', 'hvc2' o 'hev2', y la misma entrada contiene configuraciones HEVC y LHEVC, la pista transporta datos tanto de la capa base como de una o más capas de mejora.

[0078] Sin embargo, la restricción que permite un acceso aleatorio conveniente pero, para flujos de bits que

contienen múltiples capas, solo se especifica para el tipo de entrada de muestra 'lhe1'. Esto significa que cuando se almacena un flujo de bits L-HEVC multicapa utilizando cualquiera de los tipos de entrada de muestra 'hvc1', 'hev1', 'hvc2' y 'hev2', no hay forma de garantizar e indicar que ese acceso aleatorio conveniente (sin necesidad de buscar y recuperar conjuntos de parámetros de muestras anteriores, etc.), está habilitado.

[0079] Las técnicas de esta divulgación pueden usarse para abordar el primer problema potencial analizado anteriormente. En particular, en un ejemplo, se especifica una restricción para permitir un acceso aleatorio conveniente, sin necesidad de buscar y recuperar conjuntos de parámetros de muestras anteriores para una pista que contiene datos de múltiples capas, para los tipos de entrada de muestra 'hev1' y 'hev2' cuando la entrada de muestra contiene ambas configuraciones HEVC y L-HEVC. Por lo tanto, el dispositivo de preparación de contenido 20 puede garantizar que los conjuntos de parámetros necesarios se proporcionen con entradas de muestra y/o muestras que tengan tipos de entrada de muestra de 'hevl' y 'hev2', de modo que no se requiera buscar ni recuperar conjuntos de parámetros de muestras anteriores. Del mismo modo, el dispositivo cliente 40 puede recuperar una entrada de muestra y una muestra que tiene un tipo de entrada de muestra de 'hevl' o 'hev2' y realizar un acceso aleatorio, sin recuperar conjuntos de parámetros de ninguna muestra previa en el orden de descodificación de vídeo. La Tabla 10 de ISO/IEC 14496-15 (copiada a continuación) muestra todos los usos posibles de entradas de muestra, configuraciones y las herramientas L-HEV C para pistas HEVC y L-HEVC:

[0080] Para describir un segundo problema potencial, se observa que la fila 3 de la Tabla 10 de ISO/IEC 14496-15 establece:

[0081] Cuando el tipo de entrada de muestra es 'hvc2' o 'hev2', y la misma entrada contiene solo la configuración HEVC, puede ocurrir cualquiera de los siguientes escenarios: (1) La pista transporta un flujo de bits HEVC de una sola capa completa en el que todas las unidades NAL VCL tienen un nuh layer id igual a 0, y hay algunos extractores y/o agregadores presentes; o (2) La pista transporta un subconjunto de un flujo de bits HEVC de una sola capa de este tipo y el subconjunto contiene unidades NAL VCL que tienen solo un TemporalId mayor que 0 (independientemente de si hay extractores y/o agregadores).

[0082] Sin embargo, ninguno de los tipos de entrada de muestra 'hvc2' y 'hev2' se ha limitado para permitir un acceso aleatorio conveniente de manera similar al tipo de entrada de muestra 'hev1'. Esto significa que, para los dos escenarios anteriores, no hay forma de garantizar e indicar que el acceso aleatorio conveniente (sin necesidad de buscar y recuperar conjuntos de parámetros de muestras anteriores) esté habilitado.

[0083] Esta divulgación también describe técnicas que pueden usarse para resolver el segundo problema potencial. En particular, se puede especificar una restricción para permitir un acceso aleatorio conveniente, sin necesidad de buscar y recuperar conjuntos de parámetros de muestras anteriores para una pista que contenga solo un flujo de bits HEVC de capa única completa o un subconjunto del mismo, que el tipo de entrada de muestra 'hev2' se debe utilizar cuando la entrada de muestra contiene solo la configuración HEVC. Por lo tanto, cuando la entrada de muestra contiene solo la configuración HEVC, el dispositivo de preparación de contenido 20 puede especificar un tipo de entrada de muestra de 'hev2'. Del mismo modo, el dispositivo cliente 40 puede determinar que el acceso aleatorio conveniente está habilitado para una muestra que tiene el tipo de entrada de muestra 'hev2' y, además, que la muestra incluye datos de vídeo codificados de acuerdo solo con la configuración HEVC, en lugar de la configuración L-HEVC.

[0084] Para describir un tercer problema potencial, se observa que, cuando cada capa completa de un flujo de bits L-HEVC multicapa se almacena en una pista separada, de acuerdo con la especificación actual, es posible que la pista base use el tipo de entrada de muestra 'hevl' solo con la configuración HEVC, y otras pistas usan el tipo de entrada de muestra 'lhv1' solo con la configuración L-HEVC, y también es posible que la pista base use el tipo de entrada de muestra 'hvc1' solo con la configuración HEVC, y otras pistas usen el tipo de entrada de muestra 'lhe1' solo con la configuración L-HEVC.

[0085] En el primer escenario, se indica un acceso aleatorio conveniente para la pista base, pero no para otras pistas. En el segundo escenario, el acceso aleatorio conveniente no está indicado para la pista base, pero está indicado para otras pistas. Puede haber una excusa plausible para el primer escenario, como que la pista base es lo suficientemente importante como para justificar la sobrecarga de permitir un acceso aleatorio conveniente, mientras que la concesión de renunciar a un acceso aleatorio conveniente para a una menor sobrecarga para las pistas que llevan capas de mejora se considera una buena compensación. Sin embargo, el segundo escenario no tiene sentido ya que habilitar el acceso aleatorio conveniente para las pistas que llevan capas de mejora requeriría efectivamente habilitar el acceso aleatorio conveniente para la pista base, y si está habilitado para la pista base, no hay razón para no indicarlo usando el tipo de entrada de muestra correcto, es decir, 'hevl'.

[0086] De manera similar, el tercer problema potencial también puede aplicarse cuando un flujo de bits HEVC de una sola capa que contiene múltiples subcapas temporales es transportado por múltiples pistas, donde la pista que transporta la subcapa más baja (las unidades NAL VCL que tienen TemporalId igual a 0) usa un tipo de entrada de muestra que indica que el acceso aleatorio conveniente está habilitado, mientras que otra pista usa un tipo de entrada de muestra que no indica que el acceso aleatorio conveniente está habilitado, o viceversa.