RU2476825C2 - Method of controlling moving object and apparatus for realising said method - Google Patents

Method of controlling moving object and apparatus for realising said method Download PDFInfo

- Publication number

- RU2476825C2 RU2476825C2 RU2011107969/28A RU2011107969A RU2476825C2 RU 2476825 C2 RU2476825 C2 RU 2476825C2 RU 2011107969/28 A RU2011107969/28 A RU 2011107969/28A RU 2011107969 A RU2011107969 A RU 2011107969A RU 2476825 C2 RU2476825 C2 RU 2476825C2

- Authority

- RU

- Russia

- Prior art keywords

- image

- cartographic

- images

- additional

- course

- Prior art date

Links

Images

Abstract

Description

Группа изобретений относится к способу управления движущимся объектом и устройству для его осуществления. Область применения охватывает автоматическое и автоматизированное управление движением различных объектов, например транспортных роботов, судов, летательных аппаратов и т.д.The group of inventions relates to a method for controlling a moving object and a device for its implementation. The scope covers automatic and automated control of the movement of various objects, such as transport robots, ships, aircraft, etc.

Известны и широко применяются различные способы и устройства определения координат объекта, например инерциальные, оптико-телевизионные или радиолокационные навигационные устройства [1, 2].Various methods and devices for determining the coordinates of an object are known and widely used, for example, inertial, optical-television or radar navigation devices [1, 2].

Существенным признаком этих способов и устройств является то, что производится анализ получаемой информации согласно определенным методикам, алгоритмам или теоретическим моделям, а затем делается вывод о координатах объекта. Так, например, вывод о местоположении объекта делается при анализе радиолокационного изображения местности [3].An essential feature of these methods and devices is that the analysis of the information obtained is carried out according to certain methods, algorithms or theoretical models, and then a conclusion is made about the coordinates of the object. So, for example, the conclusion about the location of the object is made when analyzing the radar image of the area [3].

Недостатки способов и устройств заключаются в низкой точности определения координат объекта и невозможности быстрой адаптации при изменении навигационной задачи. Кроме этого, указанные способы и устройства имеют низкие функциональные возможности, так как они воспринимают навигационную информацию с ограниченного количества датчиков (одного, двух и трех).The disadvantages of the methods and devices are the low accuracy of determining the coordinates of the object and the inability to quickly adapt when changing the navigation task. In addition, these methods and devices have low functionality, since they perceive navigation information from a limited number of sensors (one, two and three).

В качестве прототипа рассмотрим способ для определения координат объекта, в котором считывают (воспринимают) эталонное и текущее изображения, в результате чего получается пара сравниваемых изображений [4]. Устройство, реализующее этот способ, включает в себя картографический указатель истинного курса (КУИК), основной картографический указатель заданного курса (ОКУЗК), фильтры для фильтрации помех КУИК и ОКУЗК, блок корреляционно-экстремальной обработки информации (БКЭОИ) и блоки управления фильтрами. С помощью КУИК воспринимается текущее изображение, а с помощью ОКУЗК воспроизводится эталонное изображение, которые сравниваются в БКЭОИ и определяются координаты местоположения объекта.As a prototype, we consider a method for determining the coordinates of an object in which the reference and current images are read (perceived), resulting in a pair of compared images [4]. A device that implements this method includes a true course cartographic index (CICC), a basic cartographic index of a given course (CGC), filters for filtering interference CQC and CGC, a correlation-extreme information processing unit (CECI) and filter control units. With the help of the KUIK, the current image is perceived, and with the help of the CKPS, the reference image is reproduced, which are compared in the BKEOI and the coordinates of the object's location are determined.

Недостатки способа и устройства заключаются в низкой точности определения координат объекта из-за низкой помехоустойчивости и помехозащищенности (ограниченной возможностью фильтрации помех ТИ, ЭИ и ВКФ), невозможности быстрой адаптации при изменении навигационной задачи, низкой функциональной возможности вследствие использования одного датчика изображения (картографического указателя истинного курса), низком быстродействии из-за наличия электромеханических блоков фильтрации сравниваемых изображений и управления фильтрами.The disadvantages of the method and device are the low accuracy of determining the coordinates of the object due to the low noise immunity and noise immunity (limited by the ability to filter interference TI, EI and VKF), the inability to quickly adapt when changing the navigation task, low functionality due to the use of one image sensor (cartographic pointer true course), low speed due to the presence of electromechanical filtering units of the compared images and filter control.

Задачей является создание способа управления движущимся объектом и устройства с улучшенными функциональными возможностями за счет повышения точности, быстродействия определения координат движения объекта, помехоустойчивости и помехозащищенности, и как следствие, повышение оперативности выполнения навигационной задачи.The objective is to create a way to control a moving object and a device with improved functionality by increasing accuracy, speed of determining the coordinates of the movement of the object, noise immunity and noise immunity, and as a result, increasing the efficiency of the navigation task.

Поставленная задача достигается тем, что как и в известном способе в заявленном способе управления движущимся объектом получают картографические эталонные и текущие изображения территории, сравнивают параметры изменения текущего картографического изображения с эталонным картографическим изображением, фильтруют изображения от помехThe problem is achieved in that, as in the known method in the claimed method of controlling a moving object, get cartographic reference and current images of the territory, compare the change parameters of the current cartographic image with a reference cartographic image, filter the image from interference

Отличием предлагаемого способа от известного является то, что перед сравнением параметров изменения изображений определяют предварительные координаты объекта, распознают участок территории, формируют интегральное картографическое эталонное изображение и получают интегральные информативные параметры сравниваемых изображений, выделяя среди них многомерные и увеличивая последние на величину, определяемую требуемой точностью оценки координат объекта, определяют изменение геометрии, топологии и цвета участка территории, при этом дополнительно подавляют помехи нейросетевой фильтрацией, а после сравнения параметров изменения изображений оценивают местоположение объекта и производят коррекцию маршрута движения объекта.The difference between the proposed method and the known one is that before comparing the parameters for changing the images, preliminary coordinates of the object are determined, a site area is recognized, an integrated cartographic reference image is formed and integrated informative parameters of the compared images are obtained, highlighting the multidimensional ones and increasing the latter by an amount determined by the required estimation accuracy the coordinates of the object, determine the change in the geometry, topology and color of the area, while up to olnitelno suppress interference neural network filtering, and after comparing the image change parameter estimates the position of the object and produce corrected route of the object.

При этом формируют интегральное картографическое эталонное изображение путем монтажа локальных участков территории по реперным точкам с помощью нейросетевых технологий.At the same time, an integral cartographic reference image is formed by mounting local areas of the territory at reference points using neural network technologies.

Кроме того, получают интегральные информативные параметры сравниваемых изображений при формировании радиолокационных, телевизионных цветных или инфракрасных изображений подстилающей поверхности Земли или изображений карты звездного неба.In addition, receive integrated informative parameters of the compared images when forming radar, television color or infrared images of the underlying surface of the Earth or images of a map of the starry sky.

Формируют радиолокационные или телевизионные цветные изображения по топографическим картам Земли.Generate radar or television color images on topographic maps of the Earth.

Определяют изменение геометрии, топологии и цвета участка территории для сравниваемой пары изображений при устранении рассогласований изображений по углу их относительного разворота, масштабу, крену, тангажу и цвету.Determine the change in the geometry, topology and color of the area for the compared pair of images while eliminating the inconsistencies of the images according to the angle of their relative rotation, scale, roll, pitch and color.

Кроме того, определяют геометрические параметры локальных и интегральных участков территории в виде периметров, площадей, радиусов, длины, ширины, количества точек перегиба контура, геометрического центра элементов изображений, постоянно наблюдаемых участков, развертки контура, перевычисления в полярную систему координат, инвертирования изображения, формирования микроплана.In addition, the geometrical parameters of local and integral areas of the territory are determined in the form of perimeters, areas, radii, length, width, the number of inflection points of the contour, the geometric center of image elements, constantly observed areas, contour sweep, re-calculation in the polar coordinate system, image inversion, image formation microplan.

При этом переход к типу изображения осуществляют на основе вычисления адаптивного коэффициента путем сравнения текущих и предельных значений интегральных информативных геометрических, топологических и цветовых параметров изображений, а также амплитудных, спектральных, структурных и дифференциальных информативных параметров взаимно-корреляционной функции.In this case, the transition to the type of image is carried out on the basis of calculating the adaptive coefficient by comparing the current and limit values of the integral informative geometric, topological and color parameters of the images, as well as the amplitude, spectral, structural and differential informative parameters of the cross-correlation function.

Кроме того, корректируют маршрут движения объекта путем перенастройки работы устройства.In addition, they adjust the route of movement of the object by reconfiguring the operation of the device.

Кроме того, распознают участок территории с помощью нейросетевых технологий.In addition, they recognize a site using neural network technologies.

Целесообразно, многомерные интегральные информативные параметры сравниваемых изображений увеличивают до 1000 раз.It is advisable that multidimensional integrated informative parameters of the compared images are increased up to 1000 times.

При этом территорией может быть наземная, подводная, воздушная территория.In this case, the territory may be land, underwater, air territory.

Поставленная задача достигается также тем, что, как и известное заявленное устройство управления движущимся объектом, содержит последовательно соединенные синхронизатор, блок корреляционно-экстремальной обработки информации, основной картографический указатель заданного курса, блок дополнительных фильтров основного картографического заданного курса, выходом подключен ко второму входу блока корреляционно-экстремальной обработки информации, входом через блок управления фильтрами подключен к выходу блока корреляционно-экстремальной обработки информации, последний вторым входом подключен к блоку дополнительных фильтров картографического указателя истинного курса, а блок управления фильтрами вторым выходом подключен к блоку дополнительных фильтров картографического указателя истинного курса и объекту управления.The task is also achieved by the fact that, like the known claimed device for controlling a moving object, it contains a serially connected synchronizer, a block of correlation-extreme information processing, a main cartographic indicator of a given course, a block of additional filters of the main cartographic specified course, with an output connected to the second input of a correlation block -extreme information processing, the input through the filter control unit is connected to the output of the correlation-extreme block th information processing, the latter is connected to the second input of the additional filter unit COG pointer mapping, and filter control unit is connected to the second output of the additional filter unit COG mapping and pointer control object.

Новым является то, что оно дополнительно содержит, во-первых, последовательно соединенные блок подключения датчика изображения, адаптивный нейросетевой фильтр подавления помех и интеллектуальный блок обработки изображений, отдельным выходом подключен к входу блока подключения датчика изображения, которые введены между выходом радиолокационного картографического указателя истинного курса и отдельным входом блока корреляционно-экстремальной обработки информации, отдельным выходом подключен к интеллектуальному блоку обработки изображений, во-вторых, инфракрасный датчик изображений, блок астродатчиков, телевизионный датчик изображений, блок спутниковой навигационной системы, блок построения изображений по топографической карте подключены отдельными двунаправленными связями к блоку подключения датчика изображений, в-третьих, последовательно соединенные инерциальная навигационная система и структурно-перестраиваемый блок управления отдельными входами подключены к выходам блока корреляционно-экстремальной обработки информации, блока спутниковой навигационной системы, блока построения изображений по топографической карте и синхронизатора, а отдельными выходами подключены к объекту управления и блоку построения изображений по топографической карте, причем отдельный вход структурно-перестраиваемого блока управления подключен к выходу задатчика управления, в-четвертых, блок нейросетевого распознавания изображений отдельными входами подключен к отдельным выходам интеллектуального блока обработки изображений и синхронизатора, а отдельным выходом подключен к отдельным входам блока корреляционно-экстремальной обработки информации.What is new is that it additionally contains, firstly, a series-connected image sensor connection unit, an adaptive neural network interference suppression filter and an intelligent image processing unit, with a separate output connected to the input of the image sensor connection unit, which are inserted between the output of the radar cartographic indicator of the true course and a separate input of the correlation-extreme information processing unit, a separate output is connected to an intelligent processing unit of secondly, an infrared image sensor, an astro sensor unit, a television image sensor, a satellite navigation system unit, a topographic map image building unit are connected by separate bidirectional connections to the image sensor connection unit, thirdly, an inertial navigation system and structurally connected tunable control unit for individual inputs connected to the outputs of the correlation-extreme information processing unit, satellite navigation unit system, a block for constructing images from a topographic map and a synchronizer, and with separate outputs connected to a control object and a block for constructing images from a topographic map, with a separate input of a structurally tunable control unit connected to the output of a control unit, fourthly, a block of neural network image recognition by separate inputs connected to separate outputs of the intelligent image processing unit and synchronizer, and a separate output connected to separate inputs of the block relational-extreme information processing.

Кроме того, блок подключения датчика изображения выполнен в виде многоканального мультиплексора.In addition, the image sensor connection unit is made in the form of a multi-channel multiplexer.

Кроме того, блок астродатчиков содержит датчики, воспринимающие карту звездного неба и радиогалактики.In addition, the astro sensors block contains sensors that receive a map of the starry sky and radio galaxies.

Кроме того, блок спутниковой навигационной системы содержит ГЛОНАСС, GPS и/или ГАЛИЛЕО.In addition, the satellite navigation system unit contains GLONASS, GPS and / or GALILEO.

Кроме того, инерциальная навигационная система включает блоки гироскопов, акселерометров, управления, контроля и обработки информации.In addition, the inertial navigation system includes blocks of gyroscopes, accelerometers, control, monitoring and information processing.

Кроме того, блок построения изображений по топографической карте состоит из топографических и топологических карт земной поверхности, считывателя изображения с карт и автомата на перестраиваемых вычислительных средах.In addition, the block for constructing images on a topographic map consists of topographic and topological maps of the earth’s surface, an image reader from maps, and an automaton on tunable computing environments.

Кроме того, телевизионный датчик изображений выполнен в виде телевизионной камеры, функционирующей в инфракрасном оптическом диапазоне, и содержит инфракрасный прожектор.In addition, the television image sensor is made in the form of a television camera operating in the infrared optical range, and contains an infrared spotlight.

Кроме того, блок дополнительных фильтров картографического указателя истинного и заданного курсов и блок управления фильтрами выполнены на перестраиваемых вычислительных средах.In addition, the block of additional filters of the cartographic indicator of the true and given courses and the filter control block are made on tunable computing environments.

Кроме того, структурно-перестраиваемый блок управления реализован на перестраиваемых вычислительных средах.In addition, a structurally tunable control unit is implemented on tunable computing environments.

Предлагаемый способ и устройство иллюстрируется чертежами, представленными на фиг.1-21.The proposed method and device is illustrated by the drawings shown in figures 1-21.

На фиг.1 представлена структурная схема устройства.Figure 1 presents the structural diagram of the device.

На фиг.2 представлена структурная схема интеллектуального блока обработки изображений.Figure 2 presents the structural diagram of an intelligent image processing unit.

На фиг.3 представлена структурная схема блока корреляционно-экстремальной обработки информации.Figure 3 presents the structural diagram of the block correlation-extreme information processing.

На фиг.4 представлена структурная схема адаптивного нейросетевого фильтра подавления помех.Figure 4 presents the structural diagram of an adaptive neural network filter suppression interference.

На фиг.5 представлена схема формального нейрона.Figure 5 presents a diagram of a formal neuron.

На фиг.6 представлена нейронная сеть.Figure 6 presents the neural network.

На фиг.7 представлены используемые в способе шаблоны особенностей изображений (при применении нейросетей).7 shows the patterns of image features used in the method (when using neural networks).

На фиг.8 представлена структура многомерного запоминающего устройства основного картографического указателя заданного курса.On Fig presents the structure of a multidimensional storage device of the main cartographic indicator of a given course.

На фиг.9 представлено поле информативных параметров (ИП) основного радиолокационного картографического указателя заданного курса.Figure 9 presents the field of informative parameters (IP) of the main radar cartographic index of a given course.

На фиг.10 представлено поле ИП основного инфракрасного картографического указателя заданного курса.Figure 10 presents the IP field of the main infrared cartographic indicator of a given course.

На фиг.11 представлено поле ИП основного телевизионного картографического указателя заданного курса.Figure 11 presents the IP field of the main television cartographic index of a given course.

На фиг.12 представлено поле ИП основного астрономического картографического указателя заданного курса.On Fig presents the field IP of the main astronomical cartographic index of a given course.

На фиг.13 представлено поле ИП основного спутникового картографического указателя заданного курса.On Fig presents the IP field of the main satellite map of the specified course.

На фиг.14 представлено поле ИП основного топографического картографического указателя заданного курса.On Fig presents field IP of the main topographic cartographic index of a given course.

На фиг.15 представлена структурная схема основного картографического указателя заданного курса.On Fig presents a structural diagram of the main cartographic indicator of a given course.

На фиг.16 представлена структурная схема структурно-перестраиваемого блока управления.On Fig presents a structural diagram of a structurally tunable control unit.

На фиг.17 представлен вариант исполнения блока перестраиваемой вычислительной среды.On Fig presents an embodiment of a block tunable computing environment.

На фиг.18 представлена структурная схема блока подключения датчика изображения.On Fig presents a structural diagram of a unit for connecting an image sensor.

На фиг.19 представлен новый вид взаимно-корреляционной функции (ВКФ) при различных размерах элементов изображений и различных типах изображений.On Fig presents a new type of cross-correlation function (VKF) for various sizes of image elements and various types of images.

На фиг.20 представлены графики зависимостей точностных характеристик устройства от крутизны ВКФ или от геометрических характеристик изображений.On Fig presents graphs of the dependencies of the accuracy characteristics of the device from the steepness of the VKF or from the geometric characteristics of the images.

На фиг.21 представлен вид ВКФ при различных типах изображений.On Fig presents a view of the VKF with various types of images.

На фиг.1 даны следующие обозначения:Figure 1 gives the following notation:

1 - объект управления (ОУ);1 - control object (OS);

2 - дополнительный инфракрасный датчик изображений (ИДИ);2 - additional infrared image sensor (IDN);

3 - дополнительный блок астродатчиков (БА);3 - an additional block of astro sensors (BA);

4 - радиолокационный картографический указатель истинного курса (РКУИК);4 - radar cartographic indicator of the true course (RKUIK);

5 - дополнительный телевизионный картографический указатель истинного курса (ОТДИ);5 - additional television cartographic indicator of the true course (OTDI);

6 - дополнительный спутниковый картографический указатель истинного курса (БСНС);6 - additional satellite cartographic indicator of the true course (BSNS);

7 -инерциальная навигационная система (ИНС);7 - inertial navigation system (ANN);

8 - дополнительный формирователь картографического указателя истинного курса по топографической карте (блок построения изображений по топографической карте) (БПИТК);8 - additional shaper of the cartographic indicator of the true course on the topographic map (block for constructing images on the topographic map) (BPITK);

9 - блок подключения датчика изображений (БПДИ);9 - unit for connecting an image sensor (BPDI);

10 - интеллектуальный блок обработки изображений (ИБОИ);10 - intelligent image processing unit (OBOI);

11 - структурно-перестраиваемый блок управления (СПБУ);11 - structurally tunable control unit (SPBU);

12 - синхронизатор;12 - synchronizer;

13 - блок управления фильтрами (БУФ);13 - filter control unit (FUF);

14 - блок дополнительных фильтров картографического указателя истинного курса (БДФКУИК);14 - block additional filters cartographic pointer true course (BDFKUIK);

15 - блок дополнительных фильтров основного картографического указателя заданного курса (БДФОКУЗК);15 is a block of additional filters of the main cartographic index of a given course (BDFOKUZK);

16 - основной картографический указатель заданного курса (ОКУЗК);16 - the main cartographic index of a given course (OKUZK);

17 - блок корреляционно-экстремальной обработки информации (БКЭОИ);17 - block correlation-extreme information processing (BKEOI);

18 - адаптивный нейросетевой фильтр подавления помех (АНФПП);18 - adaptive neural network interference suppression filter (ANFPP);

19 - блок нейросетевого распознавания изображений (БНРИ).19 is a block neural network image recognition (BNRI).

Определение координат объекта с помощью предлагаемых способов и устройства осуществляется при сравнении изображений различных размерностей и цветностей на основе вычисления оценки:Determining the coordinates of an object using the proposed methods and devices is carried out when comparing images of various dimensions and chromaticities based on calculation estimates:

где R - мера близости текущего изображения (картографического указателя истинного курса) и эталонного изображения (картографического указателя заданного курса);where R is a measure of the proximity of the current image (cartographic indicator of the true course) and the reference image (cartographic indicator of the given course);

F1(λ), F2(λ,ν) - функции, описывающие картографические указатели истинного и заданного курсов соответственно;F 1 (λ), F 2 (λ, ν) - functions that describe the cartographic indicators of the true and given courses, respectively;

λ, ν - соответственно постоянная и переменная части параметров.λ, ν are respectively the constant and variable parts of the parameters.

Сначала рассмотрим алгоритмы, способные функционировать с произвольными изображениями (с произвольным расположением элементов ТИ и ЭИ).First, we consider algorithms that can function with arbitrary images (with an arbitrary arrangement of TI and EI elements).

Известно [5], что если угол разворота между ТИ и ЭИ равен нулю α=0), то координаты главного максимума ВКФ определяются следующими выражениями:It is known [5] that if the angle of rotation between TI and EI is zero α = 0), then the coordinates of the main maximum of the CCF are determined by the following expressions:

где , - координаты центров тяжести совпадающих элементов ТИ, ЭИ соответственно; a, b - относительные смещения коррелируемых изображений.Where , - coordinates of the centers of gravity of the coincident elements TI, EI, respectively; a, b are the relative displacements of the correlated images.

Если при угловом совмещении изображений системы координат, связанные с ТИ и плоскостью регистрации ВКФ, фиксированы, а ЭИ поворачивается вокруг оптической оси коррелятора, то координаты главного максимума ВКФ определяются приближенноIf during angular alignment of images, the coordinate systems associated with the TI and the registration plane of the VKF are fixed, and the EI rotates around the optical axis of the correlator, then the coordinates of the main maximum of the VKF are determined approximately

Для точного определения координат главного максимума следует произвести преобразование выражения (3) следующим образом:To accurately determine the coordinates of the main maximum, the expression (3) should be transformed as follows:

Выражения (4) означают перевычисления координат, связанных с ТИ, в координаты, связанные с ЭИ.Expressions (4) mean the re-calculation of coordinates associated with EI into coordinates associated with EI.

Очевидно, что при использовании алгоритма (3) возникает ошибка в вычислении линейных координатObviously, when using algorithm (3), an error occurs in the calculation of linear coordinates

Таким образом, еслиSo if

то, чтобы δ'ξ=δ'η=0, необходимо сначала определить приближенные значения ξ1, η1, а затем вычислить точные координаты по формулам (4).so that δ ' ξ = δ' η = 0, you must first determine the approximate values of ξ 1 , η 1 , and then calculate the exact coordinates using formulas (4).

Пользуясь (3) и методами геометрической оптики, можно также записатьUsing (3) and the methods of geometric optics, we can also write

Из (7) следует, что, еслиIt follows from (7) that if

то при угловом совмещении изображений линейные координаты не зависят от угла разворота ТИ и ЭИ относительно исходного положения и характеризуются только. выражениями (2).then with the angular alignment of the images, the linear coordinates do not depend on the rotation angle of the TI and EI relative to the initial position and are characterized only. expressions (2).

Таким образом, при совмещении сравниваемых изображений без изменения вращения ЭИ необходимо либо уточнять полученные приближенные значения координат, либо с целью упрощения процесса вычисления координат совмещать центр вращения ЭИ и центр тяжести изображения с оптической осью коррелятора.Thus, when combining the compared images without changing the EI rotation, it is necessary either to refine the obtained approximate coordinates, or to simplify the process of calculating the coordinates, combine the center of rotation of the EI and the center of gravity of the image with the optical axis of the correlator.

Рассмотрим теперь применение данного алгоритма в случае использования дифференцированного метода определения координат, при котором знаки координат вычисляются следующим образом:Let us now consider the application of this algorithm in the case of using a differentiated method for determining coordinates, in which the signs of coordinates are calculated as follows:

где Z1÷Z4 - сигналы, характеризующие освещенность соответствующего квадранта корреляционной плоскости.where Z 1 ÷ Z 4 - signals characterizing the illumination of the corresponding quadrant of the correlation plane.

В выражении (9) знак Δ1 соответствует координате η, а знак Δ2 - координате ξ.In expression (9), the sign Δ 1 corresponds to the coordinate η, and the sign Δ 2 corresponds to the coordinate ξ.

Выражение (9) справедливо в случае, если центр вращения ЭИ и центр тяжести изображения совмещены с оптической осью коррелятора, а разворот ЭИ не превышает угол π/2. При развороте ЭИ на угол больше, чем π/2, знаки уже будут:Expression (9) is valid if the center of rotation of the EI and the center of gravity of the image are aligned with the optical axis of the correlator, and the turn of the EI does not exceed the angle π / 2. When the EI is rotated by an angle greater than π / 2, the signs will already be:

Как видно из сопоставления выражений (9), (10) при развороте ЭИ на угол, превышающий π/2, в определении линейных координат возникают ошибкиAs can be seen from the comparison of expressions (9), (10) when the EI is rotated by an angle exceeding π / 2, errors arise in the determination of linear coordinates

Выражение (11) следует понимать так: величина ошибки по координате ξ соответствует значению смещения Δη по координате η, а величина ошибки по координате η - значению смещения Δξ по координате ξ.Expression (11) should be understood as follows: the magnitude of the error along the coordinate ξ corresponds to the offset Δη along the coordinate η, and the magnitude of the error along the coordinate η corresponds to the offset Δξ along the coordinate ξ.

Для устранения ошибок δξα; δηα. необходимо, используя априорную информацию о развороте ЭИ относительно корреляционной плоскости, подключать сигналы Z1÷Z4, снимаемые с выхода фотоприемника, к соответствующим входам блока оценки линейных координат.To eliminate errors δξ α ; δη α . it is necessary, using a priori information about the reversal of the EI with respect to the correlation plane, to connect the signals Z 1 ÷ Z 4 taken from the output of the photodetector to the corresponding inputs of the linear coordinate estimation block.

При распознавании цвета элементов территории определяется цвет зоны, «окрашенной» в какой-либо тон или спектр, на основе следующего правила:When recognizing the color of the elements of the territory, the color of the zone “colored” in any tone or spectrum is determined based on the following rule:

где Цк, Цз, Цс, Цп, Цж, Цг, Цб - соответственно уровни красного, зеленого, синего,where C to , C z , C s , C p , C W , C g , C b - respectively, the levels of red, green, blue,

пурпурного, желтого, голубого, белого цветов,purple, yellow, blue, white,

JR, JG, JB - соответственно ВКФ, характеризующие красный, зеленый и синий цвета. Таким образом, по сочетанию ВКФ JR, JG, JB можно определить любой цвет зоныJ R , J G , J B - respectively VKF, characterizing red, green and blue colors. Thus, by the combination of VKF J R , J G , J B , any color of the zone can be determined

исследуемой поверхности.the investigated surface.

Слагаемые ВКФ описываются следующими выражениями:The terms of the VKF are described by the following expressions:

где - функция описывающая цветное ТИ (в системе координат X1, O1, Y1);Where - a function describing the color TI (in the coordinate system X 1 , O 1 , Y 1 );

- функции, описывающие ЭИ (в системах координат , , ), пропускающие соответственно красную R, зеленную G и синюю В компоненту цвета; - functions that describe EI (in coordinate systems , , ), letting through respectively the red R, green G and blue B component of the color;

K - коэффициент пропорциональности.K is the coefficient of proportionality.

Геометрические характеристики зон исследуемой поверхности определяются следующими известными выражениями.The geometric characteristics of the zones of the investigated surface are determined by the following well-known expressions.

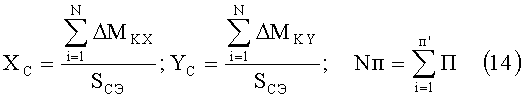

где XC, YC - координаты центра «тяжести» структурного элемента зоны изображения;where X C , Y C - coordinates of the center of gravity of the structural element of the image area;

ΔMKX, ΔMKY - элементарные моменты по направлению соответствующих осей;ΔM KX , ΔM KY - elementary moments in the direction of the corresponding axes;

Nк - число точек (пиксел) в контуре;N to - the number of points (pixel) in the circuit;

i - номер контура;i is the circuit number;

SСЭ - площадь структурного элемента зоны изображения, ограниченного контуром;S SE - the area of the structural element of the image area, limited by the contour;

KФ - коэффициент формы;K f - form factor;

P - периметр контура;P is the perimeter of the circuit;

Пi - перегиб контура;P i - inflection of the contour;

Nп - число перегибов контура;Nп - the number of inflections of the contour;

j - номер перегиба i-ого контура.j is the number of the inflection of the i-th circuit.

Площадь SСЭ и периметр Р структурного элемента определяются при обходе контура зоны. После получения необходимой информации происходит сопоставление текущей и эталонной информации (изображений) в соответствии с выражением (1):The area S of the solar cell and the perimeter P of the structural element are determined bypassing the zone contour. After obtaining the necessary information, the current and reference information (images) are compared in accordance with expression (1):

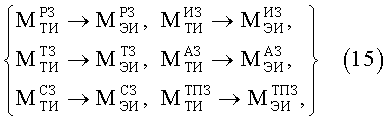

где , , , , , - матрицы информативных признаков (параметров) текущих изображений, формируемых в данный момент времени радиолокационным, инфракрасным, телевизионным, астрономическим, спутниковым и топографическим картографическим указателями истинного курса, соответственно;Where , , , , , - a matrix of informative features (parameters) of current images generated at a given time by radar, infrared, television, astronomical, satellite and topographic cartographic indicators of the true course, respectively;

- матрицы информативных признаков (параметров) эталонных изображений (запоминаемых заранее), формируемых радиолокационным, инфракрасным, телевизионным, астрономическим, спутниковым и топографическим картографическим указателями заданного курса, соответственно. - a matrix of informative features (parameters) of reference images (stored in advance) generated by radar, infrared, television, astronomical, satellite and topographic cartographic indicators of a given course, respectively.

Эти матрицы могут формироваться в виде снимков (фотографий) и математических моделей территорий.These matrices can be formed in the form of images (photographs) and mathematical models of territories.

Устройство работает в двух режимах: подготовка эталона и измерение (определение координат). В режиме подготовки эталона формируется эталонное изображение (ЭИ), характеризующее требуемое положение ОУ 1 и обеспечивающее заданное решение навигационной задачи. Для этого подключаются с помощью БПДИ 9 по сигналу от синхронизатора 12 все датчики изображений ИДИ 2, БА 3, РКУИК 4, ОТДИ 5, БСНС 6 и БПИТК 8, считываются изображения, обрабатываются изображения ИБОИ 10 и записываются в ОКУЗК 16, который является блоком записи (хранения) ЭИ. На этом режим работы устройства «подготовка эталона» заканчивается.The device operates in two modes: preparation of a standard and measurement (determination of coordinates). In the standard preparation mode, a reference image (EI) is formed that characterizes the required position of the

В режиме «измерение (определение координат)» устройство работает следующим образом. По сигналу от синхронизатора 12 включаются БКЭОИ 17, СПБУ 11, ИНС 7, ИБОИ 10 и БПДИ 9, который подключает датчики изображений ИДИ 2, БА 3, РКУИК 4, ОТДИ 5, БСНС 6 и БПИТК 8. Дополнительный инфракрасный датчик изображений ИДИ 2 воспринимает тепловое изображение поверхности Земли, а дополнительный телевизионный картографический указатель истинного курса ОТДИ 5 - цветные изображения поверхности Земли. Дополнительный блок астродатчиков БА 3 формирует оптико-телевизионное изображение карты Звездного неба или карты радиополя Звездного неба. РКУИК 4 считывает радиолокационное изображение (РЛИ) поверхности Земли. БСНС 6 воспринимает сигналы с навигационных спутников и определяет предварительные (грубые) координаты объекта управления ОУ 1, пропорциональные сигналы которых поступают в СПБУ 11. Кроме этого, сигналы с БСНС 6 направляются через БПДИ 9 в интеллектуальный блок обработки изображений ИБОИ 10. Блок БПИТК 8 синтезирует ТИ, используя предварительные навигационные координаты объекта управления ОУ 1, полученные с ИНС 7 и БСНС 6. Все сигналы, описывающие текущие изображения, полученные ИДИ 2, БА 3, РКУИК 4, ОТДИ 5, ДСНС 6 и БПИТК 8, поступают через БПДИ 9 и адаптивный нейросетевой фильтр подавления помех АНФПП 18 (вариант исполнения АНФПП 18 представлен на фиг.4) в интеллектуальный блок обработки изображений ИБОИ 10, который выполняет следующие операции: преобразование ТИ в контурные или точечные изображения, выделение электронным способом информативной части (частей) ТИ, преобразование ТИ по заданному закону, фильтрацию ТИ от несовпадающих частей (помех). Таким образом, ИБОИ 10 подает на БНРИ 19, БДФКУИК 14, БДФОКУЗК 15 или ОКУЗК 16 полное (не преобразованное) изображение (вариант исполнения ИБОИ 10 представлен на фиг.2). После этого включается блок нейросетевого распознавания изображений БНРИ 19, который сравнивает (распознает) изображения территории (вариант исполнения представлен на фиг.5, 6). После этого БУФ 13 включает БДФКУИК 14 и БДФОКУЗК 15, которые оптически устраняют дополнительные несовпадающие части изображений на ОКУЗК 16 и картографического указателя истинного курса, поступающего с ИБОИ 10. Далее БКЭОИ 17 определяет координаты (ξ, η) объекта следующим образом:In the "measurement (determination of coordinates)" mode, the device operates as follows. The signal from the

где , - фильтры, представляющие собой маску с прозрачной областью, равной размеру кадров КУИК и ОКУЗК;Where , - Filters, which are a mask with a transparent area equal to the size of the KUIK and OKUZK frames;

- фильтр, выполненный в виде маски, в которой изображения элементов прозрачны, по форме и расположению идентичны ЭИ, а границы элементов изображения на маске расширены по сравнению с ЭИ на величину, равную суммарной ошибке работы предлагаемого устройства; - a filter made in the form of a mask in which the image of the elements are transparent, identical in shape and arrangement to the EI, and the boundaries of the image elements on the mask are expanded compared to the EI by an amount equal to the total error of the proposed device;

Z3(ξ',η') - фильтр, представляет собой диафрагму.Z 3 (ξ ', η') - filter, represents a diaphragm.

Причем фильтры , обеспечивают фильтрацию помех основного картографического указателя заданного курса 16, а фильтр Z3(ξ',η') - фильтрацию побочных максимумов взаимно-корреляционной функции. Сигналы, пропорциональные величинам ξ', η', поступают от БКЭОИ 17 на структурно-перестраиваемый блок управления 11, который использует информацию с БСНС 6, ИНС 7 и БПИТК 8, управляет движением объекта управления 1. При изменении оперативной задачи на СПБУ 11 поступают соответствующие сигналы управления от задатчика управления. Информация с CПБУ 11 поступает также на БПИТК 8.Moreover, the filters , provide interference filtering of the main cartographic indicator of a given

На этом один цикл работы устройства заканчивается. Следующий цикл начинается снова по сигналу от синхронизатора 12.This completes one cycle of the device. The next cycle starts again at the signal from the

На фиг.2 представлена структурная схема интеллектуального блока обработки изображений 10. ИБОИ 10 состоит из следующих блоков:Figure 2 presents the structural diagram of an intelligent image processing unit 10. IBOI 10 consists of the following blocks:

20 - блок выделения контуров (БВК);20 - block selection contours (BVK);

21 - блок формирования точек (БФТ);21 - block forming points (BFT);

22 - блок инвертирования (БИ);22 - invert block (BI);

23 - блок перевычисления в другие системы координат (БПДСК);23 - block re-calculation in other coordinate systems (BPDSK);

24 - блок выделения постоянно наблюдаемых частей изображения (БВПНЧИ);24 is a block selection of constantly observed parts of the image (MNIS);

25 - блок фильтрации несовпадающих частей изображения (БФНЧИ);25 is a block filtering mismatched parts of the image (BFNCHI);

26 - блок формирования микроплана (БФМ);26 - microplan forming unit (BFM);

27 - блок формирования развертки контура (БФРК);27 - block forming a scan circuit (BFRK);

28 - блок вычисления координат центра «тяжести» изображения (БВКЦТИ);28 - block calculating the coordinates of the center of gravity of the image (BVKTSTI);

ИБОИ 10 работает следующим образом.OBOI 10 works as follows.

Во время функционирования ИБОБ 10 реализуются алгоритмы сегментации и кодирования изображения. Сегментацией называют процесс разбиения изображения рабочей сцены на составные части: объекты, их фрагменты или характерные особенности. Под кодированием понимают сжатие видеоинформации для хранения в памяти ИБОИ [3]. На этом этапе возможны следующие режимы работы ИБОИ:During the operation of IBC 10, image segmentation and coding algorithms are implemented. Segmentation is the process of dividing the image of the working scene into its component parts: objects, their fragments or characteristic features. Under coding is understood the compression of video information for storage in the memory of an OBOI [3]. At this stage, the following operating modes are possible:

1-й режим - без преобразования изображения - использование обычных (полных) изображений;1st mode - without image conversion - using ordinary (full) images;

2-й режим - преобразование полных изображений в контурные (формирование контуров элементов изображения или формирование развертки контуров изображений);2-nd mode - conversion of complete images to contour ones (forming contours of image elements or forming a scan of image contours);

3-й режим - преобразование полных изображений в точечные (например, путем формирования точек изображения в местах перегиба контура, путем вычисления координат центра тяжести части или всего изображения);3rd mode - conversion of full images to point-based ones (for example, by forming image points at the inflection points of the contour, by calculating the coordinates of the center of gravity of a part or the whole image);

4-й режим - выделение информативной части (частей) изображения (инвертирование, выделение постоянно-наблюдаемых частей - селекция элементов изображения);4th mode - selection of the informative part (s) of the image (invert, selection of constantly-observable parts - selection of image elements);

5-й режим - преобразование изображения по заданному закону (перевычисление в другие системы координат);5th mode - image conversion according to a given law (recalculation into other coordinate systems);

6-й режим - фильтрация изображений от несовпадающих частей (экстраполяция смещения изображения, использование режима микроплана изображения применение адаптивной нейросетевой фильтрации).6th mode - filtering images from mismatched parts (extrapolating image bias, using the microplan mode of the image, using adaptive neural network filtering).

Выбор режима работы ИБОИ основывается на некоторых характеристиках изображения и ВКФ. При этом используются геометрические характеристики элементов полных изображений (SGT - площадь объекта, l - длина (или ширина) объекта, Smu -изображение, характеризующее площадь объекта и помехи и кадра (экрана) датчика изображения (SЭ - площадь, lЭ - диаметр (ширина и высота)). Для изменения режима работы ИБОИ (то есть датчика изображения) используются следующие отношения:The choice of the operating mode of the OBI is based on some characteristics of the image and the VKF. In this case, the geometric characteristics of the elements of the complete images are used (S GT is the area of the object, l is the length (or width) of the object, S mu is the image characterizing the area of the object and the noise and frame (screen) of the image sensor (S E is the area, l E diameter (width and height)). To change the operating mode of the OBI (i.e. the image sensor), the following relationships are used:

Соотношения (17), легко реализуемые программно или аппаратно, следует использовать в качестве критериев для переключения некоторых режимов работы интеллектуального блока обработки изображений 10. При этом переход на другой режим необходимо осуществлять, если соблюдается одно (или несколько) из условий:Relations (17), easily implemented in software or hardware, should be used as criteria for switching some operating modes of the intelligent image processing unit 10. Moreover, the transition to another mode must be carried out if one (or several) of the following conditions is met:

где K*s, K*е, K*s, ΔS* - критические (предельные) значения соответствующих величин Ks, Ke, K's, ΔS, превышение которых обусловит сбой в работе БКЭОИ 17 (величины Ks, Ke, K*s, K*е получены экспериментально).wherein K * s, K * f, K * s, ΔS * - critical (limit) values the corresponding values K s, K e, K ' s, ΔS, above which will cause a malfunction SEAL 17 (value K s, K e , K * s , K * e obtained experimentally).

Ясно, что Ks, Ke следует использовать при отсутствии помех на ТИ, а K's, ΔS - при наличии помех на ТИ. Возможны также ситуации, когда режимами работы ИБОИ 10 нужно управлять, используя два критерия: один - при отсутствии помех, другой - при их наличии. Таким образом, по величинам Ks, Ke, K's, ΔS принимается решение о выборе какого-либо режима работы ИБОИ 10.It is clear that K s , K e should be used in the absence of interference on the transformer, and K ' s , ΔS - in the presence of interference on the transformer. Situations are also possible when the operating modes of IBOI 10 need to be controlled using two criteria: one - in the absence of interference, the other - if any. Thus, according to the values of K s , K e , K ' s , ΔS, a decision is made on the choice of any operating mode of OBOI 10.

Дадим схему выбора основных режимов (решающее правило РП) работы ИБОИ 10:We give a scheme for choosing the main modes (the decisive rule of the RP) of the operation of OBOI 10:

1-й режим используется при Ks≤K*s, Ke≤K*е, K's≤K'*s, ΔS≤ΔS*;1st mode is used for K s ≤K * s , K e ≤K * e , K ' s ≤K' * s , ΔS≤ΔS *;

2-й режим применяется при Ks>K*s, Ke>K*е, K's≤K'*s, ΔS≤ΔS*, при этом помехи не должны искажать контур объекта;2nd mode is applied when K s > K * s , K e > K * e , K ' s ≤K' * s , ΔS≤ΔS *, while the interference should not distort the contour of the object;

3-й режим используется при Ks>K*s, Ke>K*е, K's>K'*s, ΔS>ΔS*;3rd mode is used for K s > K * s , K e > K * e , K ' s >K' * s , ΔS> ΔS *;

4-й режим применяется в случае, когда использование предыдущих режимов не дает положительного эффекта, в частности, если элементы ТИ флуктуируют по яркости свечения и координатам, а информативная часть ТИ не воспринимается датчиком ТИ;The 4th mode is used when the use of the previous modes does not have a positive effect, in particular, if the elements of the TI fluctuate in brightness and coordinates, and the informative part of the TI is not perceived by the TI sensor;

5-й режим применяется в случае, если необходимо обеспечить оценку угловой координаты с высокой точностью, не используя при этом вращения ЭИ;5th mode is used if it is necessary to provide an estimate of the angular coordinate with high accuracy, without using the rotation of the EI;

6-й режим используется, если Ks>K*s, ΔS>ΔS*. Критические значения K*s, K*e, K*s, ΔS выбираются на основе предварительных исследований с учетом желаемых точностных характеристик предлагаемого устройства.6th mode is used if K s > K * s , ΔS> ΔS *. The critical values of K * s , K * e , K * s , ΔS are selected on the basis of preliminary studies, taking into account the desired accuracy characteristics of the proposed device.

Информация от ИБОИ 10 поступает на БПДИ 9, который определяет адаптивный коэффициент Ka, используя выражение (17), (18) и решающее правило РП. По этому коэффициенту Ka выбирается структура сравниваемых изображений и тип используемого датчика изображения.Information from IBOI 10 is fed to

На фиг.3 представлена структурная схема блока корреляционно-экстремальной обработки информации 17.Figure 3 presents the structural diagram of the block correlation-extreme processing of information 17.

БКЭОИ 17 состоит из следующих блоков:BKEOI 17 consists of the following blocks:

29 - формирователь корреляционной функции (КФ);29 - shaper correlation function (CF);

30 - анализатор КФ;30 - KF analyzer;

31 - классический корреляционный вычислитель (KB);31 - classical correlation calculator (KB);

32 - КВ с фильтрацией;32 - HF with filtration;

33 - КВ с совмещением ТИ и ЭИ по углу (КВСТИЭИУ);33 - HF with the combination of TI and EI in angle (KVSTIIU);

34 - КВ без совмещения ТИ и ЭИ по углу (КВБСТИЭИУ);34 - HF without combining TI and EI in angle (KVBSTIEIU);

35 - безэталонный (динамический) KB (БДКВ);35 - non-standard (dynamic) KB (BDKV);

36 - KB с заданным расположением слагаемых ВКФ (КВЗРСВКФ);36 - KB with a given arrangement of terms VKF (KVZRSVKF);

37 - KB с разложением цвета (КВРЦ);37 - KB with color decomposition (CMEC);

38 - классический корреляционный анализатор (КА);38 - classical correlation analyzer (KA);

39 - КА с коррекцией координат (КАКК);39 - spacecraft with coordinate correction (AS);

40 - дифференцированный КА (ДКА);40 - differentiated KA (DKA);

41 - разностный КА (РКА);41 - differential spacecraft (RCA);

42 - спектральный КА;42 - spectral KA;

43 - структурный КА;43 - structural spacecraft;

44 - квадратичный КА (ККА);44 - quadratic KA (KKA);

45 - стереоскопический КА;45 - stereoscopic spacecraft;

46 - линейный КА (ЛКА);46 - linear spacecraft (LCA);

47 - КА с экстраполяцией (КАЭ);47 - spacecraft with extrapolation (CAE);

48 - адаптивный КА;48 - adaptive spacecraft;

49 - амплитудный КА.49 - amplitude spacecraft.

БКЭОИ 17 работает следующим образом. Формирователь корреляционных функций (КФ) реализует следующие способы формирования КФ. Наиболее прост классический корреляционный анализатор (КА) 38, вычисляющий ВКФ или интеграл свертки. КА в классическом варианте требует значительных вычислительных мощностей для осуществления операций умножения и интегрирования при всех сдвигах и разворотах ТИ и эталонного изображения (ЭИ). КА с фильтрацией 32 обеспечивает фильтрацию (пространственную или иную) от помех ТИ, ЭИ и ВКФ. КА с совмещением ТИ и ЭИ по углу 33 по сравнению с КА без углового совмещения изображений 34 допускает разворот ТИ на любой угол и требует кругового вращения ЭИ по углу относительно ТИ. Безэталонный KB 35 синтезирует ВКФ с помощью последовательной перезаписи ТИ и ЭИ и основан на использовании динамического коррелятора [5]. КА, формирующий слагаемые ВКФ по заданному закону 36, характеризуется конструкцией коррелятора и определенным расположением элементов ТИ и ЭИ. KB с разложением на цвета 37 обеспечивает формирование ВКФ, соответствующих слагаемым цвета изображений. Применение конкретного формирователя КФ обуславливается задачей, выполняемой БКЭОИ и следовательно предлагаемым устройством. Анализатор КФ 30 работает следующим образом. Амплитудный КА 49 необходимую информацию извлекает на основе оценки амплитуды главного максимума ВКФ. Это самый простой КА. Более высокие точностные характеристики по сравнению с амплитудным КА 49 обеспечивает модифицированное амплитудное корреляционное вычисление, в котором необходимая информация извлекается на основе анализа параметров (ширина, крутизна) ВКФ. КА с коррекцией координат 39 допускает непрерывное вращение ЭИ при угловом совмещении изображений. При этом полученная грубая оценка координат уточняется. В дифференциальном КА 40 также осуществляется угловое вращение ЭИ и коррекция координат путем коммутации соответствующих квадрантов фотоприемника анализатора КФ 30. Разностный КА 41, основанный на поэлементном вьяислении разностей интенсивности ТИ и ЭИ, по объему вычислений имеет преимущество перед классическим КА 38, требующим проведения операции умножения. Спектральный КА 42, определяющий угловую координату, основан на Фурье-преобразовании и вычисляет различие спектров ТИ и дискретно развернутых ЭИ. Структурный (синтаксический или лингвистический) КА 43 базируется на трех процедурах: выделение контуров ТИ, выделение дескрипторов (линий определенной формы, сегментов) и описание их параметров, синтаксический анализ с использованием грамматики (классификация). При реализации алгоритма КА 43 производится сравнение признаков, а не полных изображений. Это значительно снижает необходимый объем памяти предлагаемого устройства и уменьшает объем вычислительных операций.BKEOI 17 works as follows. Shaper correlation functions (CF) implements the following methods of forming CF. The simplest classical correlation analyzer (KA) 38 calculates the VKF or convolution integral. The spacecraft in the classical version requires significant computing power to perform the operations of multiplication and integration for all shifts and turns of the TI and the reference image (EI). SC with filtering 32 provides filtering (spatial or otherwise) from interference TI, EI and VKF. A spacecraft with a combination of TI and EI at an angle of 33 in comparison with a spacecraft without an angular alignment of images 34 allows TI to be rotated to any angle and requires a circular rotation of the EI in angle relative to the TI. The standardless KB 35 synthesizes VKF using sequential rewriting of TI and EI and is based on the use of a dynamic correlator [5]. The spacecraft, which forms the terms of the VKF according to the given law 36, is characterized by the design of the correlator and a certain arrangement of the elements TI and EI. KB with color decomposition 37 provides the formation of VKF corresponding to the terms of the color of the images. The use of a specific shaper KF is determined by the task performed by the BKEOI and therefore the proposed device. The KF 30 analyzer operates as follows. Amplitude spacecraft 49 retrieves the necessary information based on an estimate of the amplitude of the main maximum of the VKF. This is the simplest spacecraft. A higher accuracy characteristics compared to the amplitude KA 49 provides a modified amplitude correlation calculation in which the necessary information is extracted based on the analysis of parameters (width, slope) VKF. Spacecraft with coordinate

Квадратичный КА 44 реализуется путем возведения в квадрат корреляционной функции, за счет чего увеличивается разница между главным и побочным (побочными) максимумами. Это значительно повышает помехоустойчивость предлагаемого устройства.Quadratic spacecraft 44 is implemented by squaring the correlation function, thereby increasing the difference between the main and secondary (secondary) maxima. This greatly increases the noise immunity of the proposed device.

Стереоскопический и линейный модифицированные КА 45, 46 предназначены для сравнения трехмерных изображений (т.е. анализа трехмерных сцен). При этом стереоскопический КА 45 основан на корреляционной оценке параллакса, а линейный модифицированный - на корреляционном сравнении совокупности плоских (двухмерных) изображений территории в рабочей зоне.Stereoscopic and linear modified KA 45, 46 are intended for comparing three-dimensional images (i.e. analysis of three-dimensional scenes). In this case, the stereoscopic spacecraft 45 is based on a correlation estimation of parallax, while the linear modified one is based on a correlation comparison of a combination of flat (two-dimensional) images of the territory in the working area.

КА с экстраполяцией 47 осуществляет фильтрацию ТИ и ЭИ путем прогнозирования смещения ТИ. Однако такой КА 47 требует априорной информации о смещении объекта в рабочей зоне.A spacecraft with extrapolation 47 filters TI and EI by predicting TI bias. However, such a spacecraft 47 requires a priori information about the displacement of the object in the working area.

Адаптивный КА 48 синтезирован на основе вышеописанных КА и осуществляет подстройку параметров предлагаемого устройства (например, выделение информативных признаков ТИ, регулирование чувствительности анализатора КФ, фильтрацию ТИ, ЭИ и ВКФ и др.) при наличии помех на сравниваемых изображениях и изменении ситуации в рабочей зоне. Выбор конкретного алгоритма определяется задачей, выполняемой устройством.Adaptive spacecraft 48 is synthesized based on the spacecraft described above and adjusts the parameters of the proposed device (for example, identifying informative features of TI, adjusting the sensitivity of the KF analyzer, filtering TI, EI and VKF, etc.) in the presence of interference in the compared images and changing the situation in the working area. The choice of a specific algorithm is determined by the task performed by the device.

На фиг.4 представлена структурная схема адаптивного нейросетевого фильтра подавления помех (АНФПП) 18.Figure 4 presents the structural diagram of an adaptive neural network interference suppression filter (ANFP) 18.

АНФПП решает задачу выделения полезного сигнала, искаженного широкополосной помехой, с помощью нейросети, которая выступает здесь фильтром, подавляющим широкополосную помеху (шум). Рассмотрим случай, когда полезный сигнал искажается широкополосной помехой, при этом не имеется внешнего эталонного сигнала, содержащего сам полезный сигнал. В общем случае для уменьшения или исключения такого вида помехи нельзя применять адаптивное устройство подавления помехи. Однако при получении эталонного сигнала непосредственно из входного сигнала через заданную задержку, как показано на фиг.4, можно подавить широкополосную помеху.ANFPP solves the problem of extracting a useful signal distorted by broadband interference using a neural network, which acts here as a filter that suppresses broadband interference (noise). Consider the case where the useful signal is distorted by broadband interference, while there is no external reference signal containing the useful signal itself. In general, an adaptive interference suppression device cannot be used to reduce or eliminate this type of interference. However, upon receipt of the reference signal directly from the input signal after a predetermined delay, as shown in FIG. 4, broadband interference can be suppressed.

АНФПП состоит из следующих элементов:ANFPP consists of the following elements:

50, 51-сумматоры;50, 51 adders;

52 - линия задержки;52 - delay line;

53 - фильтр.53 - filter.

На фиг.4 через m[k]=m(tk), tk=k*dt обозначен полезный гармонический сигнал. Через v[k]=v(tk) обозначена широкополосная помеха. Входной сигнал обозначен через x[k]=x(tk), (x[k]=m[k]+v[k]), а эталонный сигнал обозначен через x[k-dh]=x(tk-dh). Через y[k]=y(tk), обозначен сигнал на выходе фильтра, причем y[k]=M[k], где M[k] - оценка сигнала m[k] в момент времени tk. Через e[k]=e(tk) обозначена разность между x[k] и y[k], причем e[k]=x[k]-y[k]. Здесь через dt обозначен интервал дискретности измерений.In Fig. 4, m [k] = m (t k ), t k = k * dt denotes a useful harmonic signal. By v [k] = v (t k ) the broadband interference is indicated. The input signal is denoted by x [k] = x (t k ), (x [k] = m [k] + v [k]), and the reference signal is denoted by x [k-dh] = x (tk-dh) . By y [k] = y (t k ), the signal at the filter output is designated, and y [k] = M [k], where M [k] is the estimate of the signal m [k] at time t k . The difference between x [k] and y [k] is denoted by e [k] = e (t k ), and e [k] = x [k] -y [k]. Here, dt denotes the interval of measurement discreteness.

Нейросетевой блок распознавания изображений базируетсся на применении различных типов нейронных сетей [6, 7]. Нейронная сеть (НС) состоит из элементов, называемых формальными нейронами, которые имитируют работу нейронов коры головного мозга. Каждый нейрон преобразует набор сигналов, поступающих к нему на вход, в выходной сигнал. Пример формального нейрона показан на фиг.5. Структура нейронной сети приведена на фиг.6.The neural network image recognition unit is based on the use of various types of neural networks [6, 7]. A neural network (NS) consists of elements called formal neurons that mimic the functioning of neurons in the cerebral cortex. Each neuron converts a set of signals entering its input into an output signal. An example of a formal neuron is shown in FIG. The structure of the neural network is shown in Fig.6.

Между отдельными нейронами может существовать связь, и именно связи между нейронами, кодируемые весовыми коэффициентами, играют ключевую роль в функционировании НС. Связи между нейронами на фиг.6 обозначены латинской буквой W. Индекс в верхней части обозначает принадлежность весового коэффициента слою. Одним из преимуществ НС является возможность параллельного функционирования всех элементов, чем существенно повышается эффективность решения задачи в целом. Эта особенность НС успешно используется в системах распознавания образов. Нейронная сеть имеет входы Х и выходы Y, представляя собой систему, которая формирует выходное состояние в зависимости от входного. Наличие весовых коэффициентов, которые можно определять алгоритмически, позволяет придать НС важнейшее свойство - способности обучаться. На сегодняшний день существует огромное количество алгоритмов подстройки весов, которые успешно справляются с задачей обучений нейронной сети.A connection between individual neurons can exist, and it is communications between neurons, encoded by weight coefficients, that play a key role in the functioning of NS. The connections between the neurons in Fig.6 are indicated by the Latin letter W. The index in the upper part indicates the affiliation of the weight coefficient to the layer. One of the advantages of the NS is the possibility of parallel functioning of all elements, which significantly increases the efficiency of solving the problem as a whole. This feature of NS has been successfully used in pattern recognition systems. A neural network has inputs X and outputs Y, representing a system that generates an output state depending on the input. The presence of weighting coefficients that can be determined algorithmically allows us to give the NS the most important property - the ability to learn. Today, there are a huge number of weight adjustment algorithms that successfully cope with the task of training a neural network.

Рассмотрим алгоритм распознавания изображений территории с помощью нейронной сети. Допустим, что на фотографии (эталонном изображении) представлен образ изображения и система распознавания должна его идентифицировать. Для проведения правильной идентификации система должна быть этому обучена. Так как цифровая фотография представляет собой матрицу значений интенсивности, то, например, для черно-белой фотографии шкала градации серого цвета имеет протяженность от 0 (черный цвет) до 255 (белый цвет). Таким образом, на вход нейронной сети можно подать значение каждого пикселя цифровой фотографии в виде информационной матрицы векторов .Consider an algorithm for recognizing images of a territory using a neural network. Suppose that a photograph (reference image) presents an image of the image and the recognition system should identify it. For proper identification, the system must be trained in this. Since a digital photograph is a matrix of intensity values, for example, for a black-and-white photograph, the gray scale has a length from 0 (black) to 255 (white). Thus, the value of each pixel of a digital photograph can be fed to the input of a neural network in the form of an information matrix of vectors .

Предположим, что система обучена узнавать 10 изображений территории. Следовательно, выходной слой нейронной сети должен содержать 10 нейронов, каждый из которых «обучен узнавать» соответствующую территорию. Если на выходе какого-либо нейрона сигнал является максимальным по отношению к другим, то этот нейрон является «победителем» распознавания. Поскольку он связан с образом определенной территории из этой десятки, то идентифицированным будет та территория, которой соответствует данный нейрон.Suppose the system is trained to recognize 10 images of a territory. Therefore, the output layer of the neural network must contain 10 neurons, each of which is “trained to recognize” the corresponding territory. If at the output of a neuron the signal is maximum in relation to others, then this neuron is the “winner” of recognition. Since it is associated with the image of a certain territory from this ten, the territory to which this neuron corresponds will be identified.

Заметим, что при применении всех описанных методов для распознавания изображений трехмерных объектов возникают трудности, связанные с пространственными поворотами и изменением условий освещенности. Изображения для различных углов поворота объекта могут существенно различаться, а часть информации на изображении теряться. Существенными являются трудности, связанные с внутриклассовыми вариациями. Для территорий такими вариациями являются изменение цвета, освещенности и геометрических характеристик территории.Note that when applying all the described methods for image recognition of three-dimensional objects, difficulties arise associated with spatial rotations and changes in lighting conditions. Images for different angles of rotation of the object can vary significantly, and some of the information in the image is lost. The difficulties associated with intraclass variations are significant. For territories, such variations are changes in the color, lighting, and geometric characteristics of the territory.

Человек при распознавании образов неосознанно привлекает огромный запас контекстных знаний, который накапливает на протяжении всей своей жизни. Нейросетевой метод, реализованный в навигационной компьютерной программе «Нейрокибер» обучаемой нейронной сети, потенциально позволяет смоделировать происходящие при распознавании образов процессы в мозге человека, который в первом приближении можно представить в виде нейронной сети большой сложности.When recognizing images, a person unconsciously attracts a huge supply of contextual knowledge, which he accumulates throughout his life. The neural network method implemented in the Neurociber navigation computer program of the trained neural network, potentially allows you to simulate the processes occurring during pattern recognition in the human brain, which in a first approximation can be represented as a neural network of great complexity.

Рассмотрим результаты экспериментальных исследований программы «Нейрокибер». После получения текущего кадра изображения проводится его последующая загрузка в буфер модуля поиска аномального участка на изображении территории (или поиск другого изображения).Consider the results of experimental studies of the Neurociber program. After receiving the current image frame, it is subsequently loaded into the buffer of the search module of the anomalous area on the territory image (or search for another image).

Модуль поиска аномального участка на изображении территории предназначен для обнаружения на изображении областей, содержащих данные объекты или с подозрением на данные изменения, для последующей передачи содержимого этих областей модулю распознавания изменений на основе нейронных сетей. Модуль поиска аномального участка на изображении территории реализует алгоритм обнаружения объектов с использованием каскадов классификаторов, работающих с подобными особенностями.The module for searching for an abnormal area in the image of the territory is designed to detect areas containing these objects or with suspicion of these changes in the image, for subsequent transmission of the contents of these areas to the module for recognizing changes based on neural networks. The abnormal area search module on the territory image implements an algorithm for detecting objects using cascades of classifiers working with similar features.

Алгоритм использует сохраненный в памяти каскад классификаторов, созданный в результате «тренировки» каскада на массиве «положительных» изображений (содержащих данные изменения) и «отрицательных» изображений (изображения того же размера, не содержащие изменения участков территории).The algorithm uses a cascade of classifiers stored in memory, created as a result of “training” the cascade on an array of “positive” images (containing change data) and “negative” images (images of the same size that do not contain changes in areas of the territory).

После загрузки каскада он может быть применен к участку на изображении. Результатом операции является значение «1», если участок содержит похожий на аномальный участок на изображении территории, и значение «0» в ином случае. При анализе полного изображения каскад несколько раз масштабируется и «передвигается» по всему изображению для обнаружения аномальных участков на изображении территории, расположенных на разных участках изображения.After loading the cascade, it can be applied to the plot in the image. The result of the operation is the value "1" if the site contains a similar to an abnormal site in the image of the territory, and the value "0" otherwise. When analyzing the full image, the cascade is scaled several times and “moves” throughout the image to detect abnormal areas in the image of the territory located in different parts of the image.

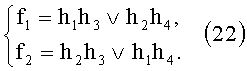

Слово «каскад классификаторов» в названии алгоритма означает, что объект под этим именем содержит несколько уровней классификаторов, которые последовательно, уровень за уровнем, применяются к исследуемому участку изображения, пока на одном из уровней участок изображения будет признан «отрицательным», либо все уровни будут пройдены и участок изображения будет признан «положительным». Хаар-подобные особенности являются входами отдельных классификаторов и рассчитываются следующим образом (см. фиг.7).The word “cascade of classifiers” in the name of the algorithm means that the object under this name contains several levels of classifiers, which are applied sequentially, level by level, to the studied image section, until at one of the levels the image section is recognized as “negative”, or all levels will be passed and the image section will be considered “positive”. Haar-like features are inputs of individual classifiers and are calculated as follows (see Fig. 7).

Особенность, используемая в конкретном классификаторе, задается ее положением внутри рассматриваемого участка изображения, масштабом и шаблоном (фиг.7).The feature used in a particular classifier is determined by its position inside the considered image area, scale and pattern (Fig. 7).

Например, в случае с третьей линейной особенностью (фиг.7, шаблон 2с) отклик вычисляется как разница между суммой пикселей изображения под прямоугольником, включающим всю особенность полностью (две белые полоски и черную полоску посередине) и суммой пикселей изображения под черной полоской, умноженной на 3, чтобы компенсировать разницу в размере площадей.For example, in the case of the third linear feature (Fig. 7, template 2c), the response is calculated as the difference between the sum of the pixels of the image under the rectangle that includes the entire feature (two white stripes and a black strip in the middle) and the sum of the pixels of the image under the black strip multiplied by 3 to compensate for the difference in the size of the areas.

По совокупности таких особенностей модуль поиска аномального участка на изображении территории обнаруживает на изображении все области, содержащие аномальные участки на изображении территории, вырезает их и передает для обработки модулю распознавания аномального участка на изображении территории на основе нейронных сетей.Based on the totality of these features, the search module for an anomalous area in the image of the territory detects all areas containing abnormal areas in the image of the area, cuts them out and passes it to the recognition module for recognizing the anomalous area in the image of the area based on neural networks.

Модуль распознавания аномального участка на изображении территории на основе нейронных сетей при загрузке осуществляет чтение базы данных нейронной сети, обученной распознавать данное изменение памяти компьютера.The module for recognizing an abnormal area in the image of a territory based on neural networks, when loading, reads a database of a neural network trained to recognize this change in computer memory.

Когда модуль поиска аномального участка на изображении территории передает область изображения, которая содержит аномальный участок, модуль распознавания на основе нейронных сетей подает пиксели данного изображения, представленные в диапазон [-1; +1], на вход обученной нейронной сети. В результате на ее выходе значение +1 появляется на нейроне, соответствующем одному из сохраненных в базе данных типу изменения изображения (или типу изображения). Остальные нейроны в этом случае должны иметь значение -1. В ином случае вследствие воздействия помех при распознавании (например, низкая или неравномерная освещенность, большой угол поворота транспортного средства и т.п.) значения отличаются от 1. Если отличие превышает заданный при компиляции порог, то объект считается нераспознанным и модуль распознавания аномального участка на изображении территории на основе нейронных сетей возвращает строку «неизвестный участок». В случае успешного распознавания модуль распознавания аномального участка на изображении территории на основе нейронных сетей выполняет поиск в базе данных, сопоставленной распознанному изменению строки (описание данного изменения) и возвращает ее как результат распознавания. Программа «Нейрокибер» выделяет идентифицированный аномальный участок на изображении территории.When the search module for the anomalous area in the territory image transmits an image area that contains the anomalous area, the neural network recognition module supplies the pixels of this image presented in the range [-1; +1], to the input of a trained neural network. As a result, at its output, the value +1 appears on the neuron corresponding to one of the type of image change (or type of image) stored in the database. The remaining neurons in this case should have a value of -1. Otherwise, due to the influence of interference during recognition (for example, low or uneven illumination, a large angle of rotation of the vehicle, etc.), the values differ from 1. If the difference exceeds the threshold set during compilation, the object is considered unrecognized and the recognition module of the anomalous section is the image of the territory based on neural networks returns the string "unknown section". In case of successful recognition, the recognition module of the anomalous area on the image of the territory based on neural networks searches the database associated with the recognized change in the line (description of this change) and returns it as the result of recognition. The Neurociber program identifies an identified abnormal area in the image of the territory.

Так как задача, решаемая нейронной сетью, классификация, то для решения данной задачи нейронной сети достаточно одного выхода. Выходное значение нейронной сети находится в интервале [-1; 1], что соответственно означает отсутствие или присутствие исследуемого объекта на классифицируемом изображении.Since the problem solved by the neural network is classification, then one output is enough to solve this problem of the neural network. The output value of the neural network is in the range [-1; 1], which accordingly means the absence or presence of the investigated object in the classified image.

Входной слой размером 28×32 нейронов служит для подачи входного образа в нейронную сеть. Следом за входным слоем находится сверточный слой С1, который состоит из 5 плоскостей и выполняет свертывание входного изображения с помощью синаптической маски размером 5×5.The input layer of 28 × 32 neurons serves to feed the input image into the neural network. Next to the input layer is a convolutional layer C1, which consists of 5 planes and coagulates the input image using a 5 × 5 synaptic mask.

Размер сверточной плоскости определяется в соответствии со следующим выражением:The size of the convolution plane is determined in accordance with the following expression:

. .

hc=hu-K+1,h c = h u -K + 1,

где wu, hu - ширина и высота сверточной плоскости соответственно;where w u , h u are the width and height of the convolution plane, respectively;

wc, hc - ширина и высота плоскости следующего слоя;w c , h c - width and height of the plane of the next layer;