JP2008257381A - Information analyzing system, information analyzing device, information analyzing method, information analyzing program, and recording medium - Google Patents

Information analyzing system, information analyzing device, information analyzing method, information analyzing program, and recording medium Download PDFInfo

- Publication number

- JP2008257381A JP2008257381A JP2007097294A JP2007097294A JP2008257381A JP 2008257381 A JP2008257381 A JP 2008257381A JP 2007097294 A JP2007097294 A JP 2007097294A JP 2007097294 A JP2007097294 A JP 2007097294A JP 2008257381 A JP2008257381 A JP 2008257381A

- Authority

- JP

- Japan

- Prior art keywords

- user

- information

- analysis

- image

- unit

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Pending

Links

Images

Landscapes

- Image Analysis (AREA)

- Processing Or Creating Images (AREA)

- Image Processing (AREA)

- Closed-Circuit Television Systems (AREA)

- Management, Administration, Business Operations System, And Electronic Commerce (AREA)

Abstract

Description

この発明は、ユーザに関して取得された情報を解析した結果に基づき、当該ユーザに対して情報を配信する情報解析システム、情報解析装置、情報解析方法および情報解析プログラム、ならびに、記録媒体に関する。 The present invention relates to an information analysis system, an information analysis apparatus, an information analysis method, an information analysis program, and a recording medium that distribute information to a user based on a result of analyzing information acquired about the user.

ユーザは自分の位置情報や時刻情報を記憶するようにされた利用者メディアを持ち歩き、所定のエリアや施設内にットワーク接続された撮影装置を複数台設置して常時撮影を行うようにしたシステムが本発明の出願人により提案され、特許文献1に記載されている。この特許文献1によるシステムでは、ユーザは、自分が撮影されている写真や映像の提供を受けたいと考えたときに、利用者メディアに記憶されている情報をシステムに読み取らせる。システム側では、利用者メディアから読み取った位置および時刻情報に基づき当該ユーザが撮影されている写真や映像を抽出し、例えばディスク、メモリカードといった可搬性の記録媒体に記録したり、ネットワークによる通信を利用してユーザに提供する。

この特許文献1に記載されるようなシステムにおいて、撮影装置により撮影された写真や映像を解析し、解析結果をユーザに提供できるシステムが望まれている。特に、解析結果に基づき特定の結論を導くことができ、その結論をユーザに提供できるようなシステムが望まれている。

In the system described in

したがって、この発明の目的は、センサ装置によりユーザに関する情報を取得し、取得された情報を解析して特定の結論を導き出してユーザに提供できるようにした情報解析システム、情報解析装置、情報解析方法および情報解析プログラム、ならびに、記録媒体を提供することにある。 Therefore, an object of the present invention is to provide an information analysis system, an information analysis apparatus, and an information analysis method that acquire information related to a user by a sensor device, analyze the acquired information, derive a specific conclusion, and provide the user with the information. And providing an information analysis program and a recording medium.

上述した課題を解決するために、第1の発明は、画像データを解析した結果に応じた情報を出力する情報解析装置において、画像データからユーザの身体に関連する画像を検出する画像検出部と、画像検出部で検出されたユーザの身体に関連する画像に基づき第1の所定の解析処理を行う第1の解析部と、第1の解析部による解析結果と閾値とを比較する比較部と、画像検出部で検出されたユーザの身体に関連する画像に基づき第2の所定の解析処理を行う第2の解析部とを有し、比較部による比較結果に基づき、第2の解析部による第2の所定の解析処理を行うか否かを決定することを特徴とする情報解析装置である。 In order to solve the above-described problems, a first invention is an information analysis apparatus that outputs information according to a result of analyzing image data. An image detection unit that detects an image related to a user's body from image data; A first analysis unit that performs a first predetermined analysis process based on an image related to the user's body detected by the image detection unit, and a comparison unit that compares an analysis result of the first analysis unit with a threshold value A second analysis unit that performs a second predetermined analysis process based on an image related to the user's body detected by the image detection unit, and based on a comparison result by the comparison unit, It is an information analysis apparatus characterized by determining whether or not to perform a second predetermined analysis process.

また、第2の発明は、画像データを解析した結果に応じた情報を出力する情報解析方法において、画像データからユーザの身体に関連する画像を検出する画像検出のステップと、画像検出のステップにより検出されたユーザの身体に関連する画像に基づき第1の所定の解析処理を行う第1の解析のステップと、第1の解析のステップによる解析結果と閾値とを比較する比較のステップと、画像検出のステップにより検出されたユーザの身体に関連する画像に基づき第2の所定の解析処理を行う第2の解析のステップとを有し、比較のステップによる比較結果に基づき、第2の解析のステップによる第2の所定の解析処理を行うか否かを決定することを特徴とする情報解析方法である。 According to a second aspect of the present invention, there is provided an information analysis method for outputting information according to a result of analyzing image data, the image detection step for detecting an image related to the user's body from the image data, and the image detection step. A first analysis step for performing a first predetermined analysis process based on the detected image relating to the user's body, a comparison step for comparing an analysis result of the first analysis step with a threshold value, and an image And a second analysis step for performing a second predetermined analysis process based on the image related to the user's body detected in the detection step, and based on the comparison result in the comparison step, It is an information analysis method characterized by determining whether or not to perform a second predetermined analysis process in steps.

また、第3の発明は、画像データを解析した結果に応じた情報を出力する情報解析方法をコンピュータに実行させる情報解析プログラムにおいて、情報解析方法は、画像データからユーザの身体に関連する画像を検出する画像検出のステップと、画像検出のステップにより検出されたユーザの身体に関連する画像に基づき第1の所定の解析処理を行う第1の解析のステップと、第1の解析のステップによる解析結果と閾値とを比較する比較のステップと、画像検出のステップにより検出されたユーザの身体に関連する画像に基づき第2の所定の解析処理を行う第2の解析のステップとを有し、比較のステップによる比較結果に基づき、第2の解析のステップによる第2の所定の解析処理を行うか否かを決定することを特徴とする情報解析プログラムである。 According to a third aspect of the present invention, there is provided an information analysis program for causing a computer to execute an information analysis method for outputting information corresponding to a result of analyzing image data. The information analysis method includes: An image detection step to detect, a first analysis step for performing a first predetermined analysis process based on an image related to the user's body detected by the image detection step, and an analysis by the first analysis step A comparison step for comparing the result with a threshold value, and a second analysis step for performing a second predetermined analysis process based on an image related to the user's body detected by the image detection step. And determining whether or not to perform the second predetermined analysis process in the second analysis step based on the comparison result in the step of It is a lamb.

また、第4の発明は、画像データを解析した結果に応じた情報を出力する情報解析方法をコンピュータに実行させる情報解析プログラムが記録されるコンピュータに読み取り可能な記録媒体において、画像データからユーザの身体に関連する画像を検出する画像検出のステップと、画像検出のステップにより検出されたユーザの身体に関連する画像と、ユーザの身体に関連する画像に対応する参照画像に基づく値との差分に基づき第1の所定の解析処理を行う第1の解析のステップと、第1の解析のステップによる解析結果と閾値とを比較する比較のステップと、画像検出のステップにより検出されたユーザの身体に関連する画像に基づき第2の所定の解析処理を行う第2の解析のステップとを有し、比較のステップによる比較結果に基づき、第2の解析のステップによる第2の所定の解析処理を行うか否かを決定するようにした情報解析方法をコンピュータに実行させる情報解析プログラムと、参照画像および/または参照画像に基づく値とが記録されることを特徴とするコンピュータに読み取り可能な記録媒体である。 According to a fourth aspect of the present invention, there is provided a computer-readable recording medium on which an information analysis program for causing a computer to execute an information analysis method for outputting information corresponding to a result of analyzing image data is recorded. A difference between an image detection step for detecting an image related to the body, an image related to the user's body detected by the image detection step, and a value based on a reference image corresponding to the image related to the user's body; A first analysis step for performing a first predetermined analysis process, a comparison step for comparing the analysis result of the first analysis step with a threshold value, and a user's body detected by the image detection step. A second analysis step for performing a second predetermined analysis process based on the related image, and based on the comparison result of the comparison step An information analysis program for causing a computer to execute an information analysis method for determining whether or not to perform the second predetermined analysis process in the second analysis step, and a reference image and / or a value based on the reference image A computer-readable recording medium characterized by being recorded.

また、第5の発明は、画像データを解析した結果に応じた情報を出力する情報解析システムにおいて、被写体を撮像して画像データを出力する撮像装置と、画像データからユーザの身体に関連する画像を検出する画像検出部と、画像検出部で検出されたユーザの身体に関連する画像に基づき第1の所定の解析処理を行う第1の解析部と、第1の解析部による解析結果と閾値とを比較する比較部と、画像検出部で検出されたユーザの身体に関連する画像に基づき第2の所定の解析処理を行う第2の解析部とを有し、比較部による比較結果に基づき、第2の解析部による第2の所定の解析処理を行うか否かを決定するようにした情報解析装置とを備え、撮像装置から出力された画像データは、ネットワークを介して情報解析装置に対して送信され、画像検出部は、ネットワークを介して送信された画像データからユーザの身体に関連する画像を検出するようにしたことを特徴とする情報解析システムである。 According to a fifth aspect of the present invention, there is provided an information analysis system that outputs information according to a result of analyzing image data, an imaging device that images a subject and outputs image data, and an image related to a user's body from the image data. An image detection unit that detects the image, a first analysis unit that performs a first predetermined analysis process based on an image related to the user's body detected by the image detection unit, an analysis result and a threshold value by the first analysis unit And a second analysis unit that performs a second predetermined analysis process based on an image related to the user's body detected by the image detection unit, and based on a comparison result by the comparison unit And an information analysis device configured to determine whether or not to perform the second predetermined analysis processing by the second analysis unit, and image data output from the imaging device is transmitted to the information analysis device via the network Sent to Image detection unit is an information analysis system being characterized in that to detect the images associated from the image data transmitted via the network to the user's body.

上述したように、第1、第2および第3の発明は、画像データからユーザの身体に関連する画像を検出し、検出されたユーザの身体に関連する画像に基づき第1の所定の解析処理を行い、第1の解析処理結果と閾値とを比較した結果に基づき、ユーザの身体に関連する画像に基づく第2の所定の解析処理を行うか否かを決定するようにしているため、画像データからユーザに身体に関する特定の結論を導き出すことができる。 As described above, the first, second, and third inventions detect an image related to the user's body from the image data, and the first predetermined analysis process based on the detected image related to the user's body. And determining whether or not to perform the second predetermined analysis process based on the image related to the user's body based on the result of comparing the first analysis process result and the threshold value. Specific conclusions about the body can be drawn from the data to the user.

また、第4の発明による記録媒体は、画像データからユーザの身体に関連する画像を検出し、検出されたユーザの身体に関連する画像と、ユーザの身体に関連する画像に対応する参照画像に基づく値との差分に基づき第1の所定の解析処理を行い、第1の解析処理による解析結果と閾値とを比較した結果に基づき、ユーザの身体に関連する画像に基づく第2の所定の解析処理を行うか否かを決定する情報解析プログラムと、参照画像および/または参照画像に基づく値とが記録されるため、記録媒体に記録された情報解析プログラムと、参照画像および/または参照画像に基づく値とをコンピュータで読み出してプログラムを実行させることで、ユーザに身体に関連する、参照画像と画像データを対比させた場合の特定の結論を導き出すことができる。 The recording medium according to the fourth aspect of the invention detects an image related to the user's body from the image data, and detects an image related to the detected user's body and a reference image corresponding to the image related to the user's body. A first predetermined analysis process is performed based on the difference from the value based on the result, and a second predetermined analysis based on an image related to the user's body is performed based on a result of comparing the analysis result of the first analysis process with a threshold value. Since an information analysis program for determining whether to perform processing and a reference image and / or a value based on the reference image are recorded, the information analysis program recorded on the recording medium, the reference image and / or the reference image are recorded. By reading the value based on the computer and executing the program, the user can draw a specific conclusion when comparing the reference image with the image data related to the body. It can be.

また、第5の発明は、被写体を撮像して画像データを出力する撮像装置と、画像データからユーザの身体に関連する画像を検出し、検出されたユーザの身体に関連する画像に基づき第1の所定の解析処理を行い、第1の解析処理結果と閾値とを比較した結果に基づき、ユーザの身体に関連する画像に基づく第2の所定の解析処理を行うか否かを決定するようにした情報解析装置とを備え、情報化伊勢装置は、撮像装置から出力されネットワークを介して送信された画像データに基づきユーザの身体に関連する画像を検出するようにしているため、ユーザは、情報解析装置とネットワークを介して接続される撮像装置が設置された場所であれば何処からでも、情報解析装置に対し、撮像装置で撮影された画像データからユーザに身体に関する特定の結論を導き出させることができる。 According to a fifth aspect of the present invention, there is provided an imaging device that captures an image of a subject and outputs image data, an image related to the user's body is detected from the image data, and the first is based on the detected image related to the user's body. To determine whether or not to perform the second predetermined analysis processing based on the image related to the user's body based on the result of comparing the first analysis processing result and the threshold value. The information analysis device is configured to detect an image related to the user's body based on the image data output from the imaging device and transmitted via the network. Any location where an imaging device connected to the analysis device via a network is installed, the information analysis device is instructed by the user from the image data captured by the imaging device to the user. It is possible to derive a conclusion.

第1、第2および第3の発明は、上述したように、画像データからユーザの身体に関連する画像を検出し、検出されたユーザの身体に関連する画像に基づき第1の所定の解析処理を行い、第1の解析処理結果と閾値とを比較した結果に基づき、ユーザの身体に関連する画像に基づく第2の所定の解析処理を行うか否かを決定するようにしているため、画像データからユーザに身体に関する特定の結論を導き出すことができる効果がある。 As described above, the first, second, and third inventions detect an image related to the user's body from the image data, and the first predetermined analysis process based on the detected image related to the user's body And determining whether or not to perform the second predetermined analysis process based on the image related to the user's body based on the result of comparing the first analysis process result and the threshold value. This has the effect of allowing the user to draw specific conclusions about the body from the data.

また、第4の発明は、上述したように、画像データからユーザの身体に関連する画像を検出し、検出されたユーザの身体に関連する画像と、ユーザの身体に関連する画像に対応する参照画像に基づく値との差分に基づき第1の所定の解析処理を行い、第1の解析処理による解析結果と閾値とを比較した結果に基づき、ユーザの身体に関連する画像に基づく第2の所定の解析処理を行うか否かを決定する情報解析プログラムと、参照画像および/または参照画像に基づく値とが記録されるため、記録媒体に記録された情報解析プログラムと、参照画像および/または参照画像に基づく値とをコンピュータで読み出してプログラムを実行させることで、ユーザに身体に関連する、参照画像と画像データを対比させた場合の特定の結論を導き出すことができる効果がある。 In addition, as described above, the fourth invention detects an image related to the user's body from the image data, and a reference corresponding to the detected image related to the user's body and the image related to the user's body. A first predetermined analysis process is performed based on a difference from a value based on the image, and a second predetermined process based on an image related to the user's body is performed based on a result of comparing the analysis result of the first analysis process with a threshold value. An information analysis program for determining whether or not to perform the analysis process and a reference image and / or a value based on the reference image are recorded, so that the information analysis program recorded on the recording medium, the reference image and / or the reference By reading the values based on the image on the computer and executing the program, the user can draw a specific conclusion when comparing the reference image with the image data related to the body. There is an effect that can.

また、第5の発明は、上述したように、被写体を撮像して画像データを出力する撮像装置と、画像データからユーザの身体に関連する画像を検出し、検出されたユーザの身体に関連する画像に基づき第1の所定の解析処理を行い、第1の解析処理結果と閾値とを比較した結果に基づき、ユーザの身体に関連する画像に基づく第2の所定の解析処理を行うか否かを決定するようにした情報解析装置とを備え、情報化伊勢装置は、撮像装置から出力されネットワークを介して送信された画像データに基づきユーザの身体に関連する画像を検出するようにしているため、ユーザは、情報解析装置とネットワークを介して接続される撮像装置が設置された場所であれば何処からでも、情報解析装置に対し、撮像装置で撮影された画像データからユーザに身体に関する特定の結論を導き出させることができる効果がある。 In addition, as described above, the fifth aspect of the invention relates to an imaging device that images a subject and outputs image data, and detects an image related to the user's body from the image data, and relates to the detected user's body. Whether to perform the first predetermined analysis process based on the image, and to perform the second predetermined analysis process based on the image related to the user's body based on the result of comparing the first analysis process result and the threshold value The information analysis device is configured to detect an image related to the user's body based on image data output from the imaging device and transmitted via the network. The user can obtain information from the image data captured by the imaging device from any location where the imaging device connected to the information analysis device via the network is installed. There is an effect that can be derived the specific conclusions about the body.

以下、この発明の実施の形態について、下記の順序に従って説明する。

1.発明の概念

2.発明の実施の第1の形態

2−1−1.システムについて

2−1−2.実施の第1の形態による概略的な処理の流れについて

2−1−3.補足

2−2.実施の第1の形態の第1の応用例について

2−2−1.システムの概要

2−2−2.第1の応用例に適用可能なシステムについて

2−2−3.第1の応用例による解析処理の例について

2−2−4.補足

2−3.実施の第1の形態の第2の応用例について

2−3−1.システムの概要

2−3−2.第2の応用例に適用可能なシステムについて

2−3−3.第2の応用例による解析処理の例について

2−3−4.補足

2−4.実施の第1の形態の第3の応用例について

2−4−1.システムの概要

2−4−2.第3の応用例に適用可能なシステムについて

2−4−3.第3の応用例による解析処理の例について

3.発明の実施の第1の形態の第1の変形例

3−1−1.システムについて

3−1−2.ユーザの識別方法の例について

3−1−3.概略的な処理の流れについて

3−2.実施の第1の形態の第1の変形例に対する応用例について

3−3−1.応用例に適用可能なシステムについて

3−3−2.概略的な処理の流れについて

3−3−3.実施の第1の形態の第2および第3の応用例に対する適用について

4.実施の第1の形態の第2の変形例について

4−1−1.システムについて

4−1−2.履歴情報に基づくデータの特定について

4−1−3.概略的な処理の流れについて

4−2.実施の第1の形態の第2の変形例に対する応用例について

4−2−1.応用例に適用可能なシステムについて

4−2−2.概略的な処理の流れについて

4−2−3.実施の第1の形態の第2および第3の応用例に対する適用について

5.発明の実施の第2の形態

5−1.システムの概要

5−2.概略的な処理の流れについて

5−3.実施の第2の形態の適用例

5−3−1.第1の適用例(化粧サポートシステムに適用した例)

5−3−2.第2の適用例(スポーツ向けのラーニングシステムに適用した例)

5−3−3.第3の適用例(外国語会話のラーニングシステムに適用した例)

6.発明の実施の第3の形態

6−1.概略

6−2.適用可能なシステムについて

6−3.概略的な処理の流れについて

Hereinafter, embodiments of the present invention will be described in the following order.

1.

5-3-2. Second application example (example applied to a sports learning system)

5-3-3. Third application example (example applied to a learning system for foreign language conversation)

6). Third Embodiment of the Invention 6-1. Outline 6-2. Applicable system 6-3. Schematic processing flow

なお、以下の記載は、この発明を実施可能な程度に開示するものであり、この発明は、下記の各実施形態および各応用例に限定されるものではなく、この発明の主旨を逸脱しない限り、様々な変形、応用が可能である。 It should be noted that the following description is disclosed to the extent that the present invention can be implemented, and the present invention is not limited to the following embodiments and application examples, as long as they do not depart from the gist of the present invention. Various modifications and applications are possible.

1.発明の概念

先ず、この発明の概念について説明する。この発明では、所定に配置されたセンサ装置により対象ユーザの情報を取得し、取得された情報を解析(以下、1次解析と呼ぶ)する。解析結果に基づき閾値判断を行い、判断結果に応じて当該情報に対して2次的な解析(以下、2次解析と呼ぶ)をさらに行うか否かを決定する。2次解析を行うと決定された場合、2次解析結果に基づく通知が登録された通知先に送信される。センサ装置により情報を取得された時点における当該ユーザの状態に応じて2次解析処理を行うことが可能とされ、ユーザは、2次解析処理の結果を自動的に受け取ることができる。

1. Concept of the Invention First, the concept of the present invention will be described. In this invention, the information of the target user is acquired by a sensor device arranged in a predetermined manner, and the acquired information is analyzed (hereinafter referred to as primary analysis). A threshold is determined based on the analysis result, and it is determined whether or not to further perform secondary analysis (hereinafter referred to as secondary analysis) on the information according to the determination result. When it is determined to perform the secondary analysis, a notification based on the secondary analysis result is transmitted to the registered notification destination. The secondary analysis process can be performed according to the state of the user at the time when information is acquired by the sensor device, and the user can automatically receive the result of the secondary analysis process.

2.発明の実施の第1の形態

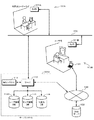

2−1−1.システムについて

この発明の実施の第1の形態について説明する。図1は、この発明の第1の形態による一例のシステム構成を概略的に示す。このシステムによりサービスの対象となる、例えば所定の施設10A、10B、10C、・・・に対して、センサ装置11A、11B、11C、・・・がそれぞれ配置される。同様に、これらセンサ装置11A、11B、11C、・・・にそれぞれ対応してリーダ12A、12B、12C、・・・が配置される。これらセンサ装置11A、11B、11C、・・・、ならびに、リーダ12A、12B、12C、・・・は、ネットワーク13にそれぞれ接続される。ネットワーク13に対して、サーバシステム14がさらに接続される。

2. First Embodiment of the Invention 2-1-1. About System A first embodiment of the present invention will be described. FIG. 1 schematically shows an example of a system configuration according to the first embodiment of the present invention.

センサ装置11A、11B、11C、・・・は、例えば、撮像素子を有し静止画および/または動画を撮影するようにされたカメラ装置である。センサ装置11A、11B、11C、・・・は、被写体を撮影して得られた静止画データおよび/または動画データを、センサ装置11A、11B、11C、・・・をそれぞれ識別するための識別情報であるセンサIDと、画像データが撮影された時刻を示す時刻情報とに対応付けて出力する。センサ装置11A、11B、11C、・・・から出力された静止画データおよび/または動画データ、ならびに、センサIDは、ネットワーク13を介してサーバシステム14に対して送信される。

The

なお、以下では、静止画データと動画データとを特に区別する必要がある場合を除き、これらを適宜、画像データとして統一的に記述する。 In the following description, unless otherwise required to distinguish between still image data and moving image data, they are described uniformly as image data as appropriate.

リーダ12A、12B、12C、・・・は、所定の記憶媒体からなるユーザ媒体15に記憶された、ユーザを識別するための識別情報であるユーザIDを読み出す。読み出されたユーザIDは、ネットワーク13を介してサーバシステム14に対して送信される。

The

ネットワーク13は、このシステムで閉じたネットワークとしてもよいし、インターネットのようなオープンなネットワークであってもよい。ネットワーク13としてオープンなネットワークを用いる場合には、各センサ装置11A、11B、11C、・・・、各リーダ12A、12B、12C、・・・、ならびに、サーバシステム14との間でやりとりされるデータは、所定の暗号化方式で以て暗号化することが望ましい。

The

サーバシステム14は、例えば、サーバ部20、解析システム部21、センサ情報データベース22およびユーザ情報データベース23を有する。サーバ部20は、このシステムの全体の制御や管理を行う。例えばサーバ部20は、ネットワーク13を介して各センサ装置11A、11B、11C、・・・や各リーダ12A、12B、12C、・・・と通信を行い、各センサ装置11A、11B、11C、・・・や、各リーダ12A、12B、12C、・・・から送信されたデータを受信する。受信されたデータは、センサ情報データベース22やユーザ情報データベース23に所定に格納される。例えば、詳細は後述するが、受信されたデータのうち画像データは、所定の識別情報に関連付けられてセンサ情報データベース22に格納される。

The

解析システム部21は、センサ装置11A、11B、11C、・・・で取得されセンサ情報データベース22に格納された画像データに対して、所定の解析処理(1次解析)を行い、1次解析結果に基づき必要であると判断されれば、当該画像データに対してさらに2次解析処理を行う。

The

サーバシステム14は、サーバ部20によりインターネット30に接続される。インターネット30には、例えば登録ユーザのユーザ端末31A、31B、31C、・・・が接続される。ユーザ端末31A、31B、31C、・・・は、インターネット30による通信が可能であれば特に種類を問わないが、例えばパーソナルコンピュータや、電波を用いてインターネット30との通信が可能とされた携帯端末装置などであって、電子メールの送受信を行うメーラや、ウェブサイトのウェブページを閲覧するためのブラウザなどの、インターネット30を利用するために必要なソフトウェアが搭載されている。サーバ部20は、インターネット30に接続される、登録ユーザのユーザ端末31A、31B、31C、・・・のそれぞれと、インターネット30を介して通信を行うことができる。

The

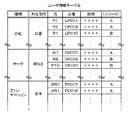

サーバシステム14が有するセンサ情報データベース22およびユーザ情報データベース23について、概略的に説明する。センサ情報データベース22は、各センサ装置11A、11B、11C、・・・からの画像データを、所定の識別情報と対応付けて格納する。図2は、センサ情報データベース22に格納されるセンサ情報テーブルの一例の構成を示す。この図2の例は、各センサ装置11A、11B、11C、・・・毎に、センサ情報テーブルが設けられる例である。各センサ情報テーブルは、各センサ装置11A、11B、11C、・・・にそれぞれ対応するセンサIDにより識別される。

The

センサ情報テーブルにおいて、画像データは、例えばユニークなデータIDにより識別され、時刻情報およびユーザIDと対応付けられて蓄積的に登録される。画像データは、例えば、実際にはサーバ部20が有する所定のストレージ装置(図示しない)に格納され、センサ情報テーブルには、画像データの格納場所を示すポインタが登録される。時刻情報は、例えば画像データがセンサ装置(例えばセンサ装置11A)で撮影された時刻を示す。また、ユーザIDは、例えば、当該センサ装置に対応するリーダ(例えばリーダ12A)によりユーザ媒体15から読み取られ、サーバシステム14に送信される。

In the sensor information table, image data is identified by, for example, a unique data ID, and is registered in association with time information and a user ID. For example, the image data is actually stored in a predetermined storage device (not shown) included in the

画像データと、時刻情報およびユーザIDとを対応付ける一例の方法として、互いに対応するセンサ装置11A、11B、11C、・・・とリーダ12A、12B、12C、・・・とを連動させる方法が考えられる。すなわち、例えば互いに対応するセンサ装置11Aおよびリーダ12Aにおいて、リーダ12Aによりユーザ媒体15から読み出されたユーザIDを所定に保持する。そして、センサ装置11Aから画像データが出力される際に、保持されているユーザIDを当該画像データに対して対応付けて、サーバシステム14に対して送信する。

As an example of a method for associating image data with time information and a user ID, a method of interlocking

これに限らず、各センサ装置11A、11B、11C、・・・において、画像データの撮影を行った時刻を示す時刻情報を画像データに対応付けて送信すると共に、リーダ12A、12B、12C、・・・においても、ユーザ媒体15から読み出したユーザIDを送信する際に、ユーザ媒体15からの読み出しを行った時刻を示す時刻情報を、当該ユーザIDに対応付けて送信することも考えられる。サーバシステム14において、サーバ部20は、これらの時刻情報に基づき画像データとユーザIDとを対応付けることができる。

In addition to this, in each of the

ユーザ情報データベース23は、例えばユーザ情報テーブルおよび参照情報テーブルを有し、登録されたユーザに関する情報が格納される。図3は、ユーザ情報テーブルの一例の構成を示す。ユーザ情報テーブルにおいて、ユーザIDに対して、当該ユーザの属性情報が関連付けられる。属性情報は、例えば当該ユーザの名前、連絡先などからなる。ユーザの連絡先を示す連絡先情報は、このシステムがインターネットを介してデータを配信するようにされている場合、電子メールアドレスが含まれる。それぞれのユーザ情報は、ユーザIDによって互いに識別可能とされる。ユーザ情報テーブルの情報は、例えばユーザのシステムへの登録などの際に、予め登録される。

The

図4は、参照情報テーブルの一例の構成を示す。参照情報テーブルは、センサ装置11A、11B、11C、・・・により取得されサーバシステム14に送信された画像データに対して2次解析処理を行うか否かを判断するための基準となる参照情報が、登録ユーザのそれぞれについて、ユーザIDに対応付けられて登録される。詳細は後述するが、1次解析処理において、参照情報は、画像データが解析システム部21で所定に処理された処理結果と比較されるので、この処理結果と同じ形式のデータとして形成される。参照情報テーブルの情報は、例えばユーザのシステムへの登録などの際に予め登録される。これに限らず、システムの目的や構成によっては、所定のタイミングで参照情報テーブルに登録するようにもできる。

FIG. 4 shows an example of the configuration of the reference information table. The reference information table serves as a reference for determining whether or not to perform secondary analysis processing on image data acquired by the

参照情報としてどのような種類の情報を用いるかは、システムの目的などに応じて異なる。センサ装置11A、11B、11C、・・・がカメラ装置であって、撮影された静止画および/または動画データが処理対象とされるこの例では、ユーザIDに対応するユーザにおけるある特定の状態の顔を撮影した画像データに基づく情報を参照情報として用いることができる。すなわち、ユーザのある特定の状態の顔を撮影した画像データから顔部分を検出し、検出された顔画像の特徴情報を抽出して数値化する。この顔の特徴情報が数値化された値を、参照情報として用いることができる。

What kind of information is used as the reference information varies depending on the purpose of the system. In this example in which the

2−1−2.実施の第1の形態による概略的な処理の流れについて

図5は、上述のようなシステムによる、この実施の第1の形態による一例の処理を示すフローチャートである。なお、ユーザ情報データベース23内のユーザ情報テーブルおよび参照情報テーブルに対するデータの登録は、この図5のフローチャートの処理に先立って予めなされており、ユーザは、ユーザIDの記憶されたユーザ媒体15を予め保有しているものとする。

2-1-2. About Schematic Process Flow According to First Embodiment FIG. 5 is a flowchart showing an example of a process according to the first embodiment by the system as described above. Registration of data for the user information table and the reference information table in the

最初のステップS10で、例えば施設10Aにおいて、ユーザによりユーザ媒体15に記憶されたユーザIDをリーダ12Aに読み出させる処理がなされ、また、センサ装置11Aによりユーザを被写体として撮影が行われる。撮影により得られた画像データに対して撮影時刻を示す時刻情報と、センサ装置11Aに対応するセンサIDとが付加されて、リーダ12Aにより読み込まれたユーザIDと共に、ネットワーク13を介してサーバシステム14に受信される。なお、ここでは、センサ装置11Aが出力する画像データは、静止画像データであるものとする。

In the first step S10, for example, in the

サーバシステム14は、受信されたユーザID、画像データおよび時刻情報をセンサ情報データベース22に所定に格納し、画像データについて、解析システム部21に供給して所定の処理を行う(ステップS11)。そして、次のステップS12において、この画像データが所定に処理された結果に基づく1次解析が行われる。例えば、受信されたユーザIDに基づきユーザ情報データベース23内の参照情報テーブルから対応する参照情報が抽出され、抽出された参照情報と、ステップS11による処理結果とが比較される。

The

ステップS12による比較の結果に基づき、ステップS13で閾値判断がなされる。例えば、ステップS12において、参照情報とステップS11による処理結果との差分が所定に算出され、この差分が閾値を超えたか否かがステップS13で判断される。 Based on the result of the comparison in step S12, a threshold value is determined in step S13. For example, in step S12, a difference between the reference information and the processing result in step S11 is calculated in advance, and it is determined in step S13 whether or not this difference has exceeded a threshold value.

若し、ステップS13で差分が閾値を超えたと判断されれば、処理はステップS14に移行される。すなわち、差分が閾値を超えた場合、現在のユーザにおける所定の状態が参照情報で示される状態に対して大きく異なると考えることができ、ステップS14以降で対応する処理がなされる。 If it is determined in step S13 that the difference has exceeded the threshold, the process proceeds to step S14. That is, when the difference exceeds the threshold, it can be considered that the predetermined state of the current user is significantly different from the state indicated by the reference information, and corresponding processing is performed in step S14 and subsequent steps.

ステップS14では、解析システム部21によりさらに解析処理(2次解析処理)が施される。例えば、ステップS14では、現在のユーザにおける所定の状態と参照情報で示される状態とが大きく異なる原因や要因を抽出可能なような解析が、2次解析として行われる。一例として、2次解析として、ステップS11で行った解析をさらに詳細に行うことが考えられる。また、2次解析として、ステップS11で行った解析の解析結果に基づき、他の解析方法を選択することも考えられる。

In step S14, the

次のステップS15では、ステップS14の2次解析処理の結果に基づく通知が、対応するユーザなどに送信される。すなわち、サーバシステム14において、受信されたユーザIDに基づきユーザ情報データベース23内のユーザ情報テーブルが参照され、当該ユーザIDの属性情報から連絡先情報が抽出され、この連絡先情報に示される連絡先に、通知が送信される。連絡先が電子メールアドレスであれば、当該ユーザIDに対応するユーザは、例えばユーザ端末31Aを用いてこの通知にアクセスすることができる。

In the next step S15, a notification based on the result of the secondary analysis process in step S14 is transmitted to the corresponding user or the like. That is, in the

なお、ステップS15でユーザに対して送信される通知の内容は、システムの目的や構成により異なる。例えば、現在のユーザにおける所定の状態と参照情報で示される状態とが大きく異なる原因や要因を示す情報の通知や、当該原因や要因を修正するための情報の通知、警告通知などが考えられる。 Note that the content of the notification transmitted to the user in step S15 varies depending on the purpose and configuration of the system. For example, a notification of information indicating a cause or a factor that greatly differs between a predetermined state of the current user and a state indicated by reference information, a notification of information for correcting the cause or the factor, a warning notification, or the like can be considered.

一方、ステップS13で、差分が閾値を超えていないと判断されれば、処理はステップS16に移行される。この場合には、現在のユーザにおける所定の状態と参照情報で示される状態とが、問題になるほど大きく異ならないと考えることができる。そのため、ステップS16では、特に何も処理を行わないことが考えられる。ステップS16で、対応するユーザなどに対して問題が無い旨を通知することも考えられる。 On the other hand, if it is determined in step S13 that the difference does not exceed the threshold value, the process proceeds to step S16. In this case, it can be considered that the predetermined state of the current user and the state indicated by the reference information are not so different as to cause a problem. Therefore, in step S16, it can be considered that no particular processing is performed. In step S16, it may be possible to notify the corresponding user or the like that there is no problem.

なお、ユーザ情報データベース23内において、ユーザIDに対して他のユーザのユーザIDを関連付けることで、ステップS15やステップS16による通知を対象とされるユーザに送信するのみならず、当該対象ユーザのユーザIDに関連付けられた他のユーザIDに対応するユーザにも送信するようにできる。

In the

2−1−3.補足

上述では、センサ装置11A、11B、11C、・・・が静止画データおよび/または動画データを出力するカメラ装置であるとして説明したが、センサ装置11A、11B、11C、・・・は、ユーザの所定の状態を検出可能な情報が取得できれば、様々な種類の装置を適用することができる。例えば、センサ装置11A、11B、11C、・・・としてカメラ装置を適用した場合であっても、可視光領域の光を撮影対象とするものに限られず、赤外線領域や紫外線領域、X線領域の光を撮影対象とするような装置でもよい。

2-1-3. Supplement: In the above description, the

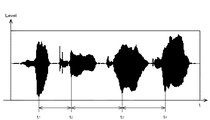

センサ装置11A、11B、11C、・・・は、カメラ装置やビデオカメラ装置のような画像を出力する装置に限られない。例えば、マイクロフォンを用いて収音された音声を出力するようなオーディオ装置をセンサ装置11A、11B、11C、・・・として用いることも可能である。

The

さらに例えば、所定のコードを含むディジタル信号が変調された電波を受信して復調するようにした受信装置を、センサ装置11A、11B、11C、・・・として用いることも考えられる。この場合、サービスを受けるユーザに対して、ユーザ毎にユニークなコードを変調して送信する送信機を所持させるようにする。

Further, for example, it is conceivable to use, as the

ユーザ媒体15として適用可能な記憶媒体は、様々に考えられる。例えば、合成樹脂製のカード内にIC(Integrated Circuit)チップ、不揮発性メモリおよびアンテナを内蔵させ、リーダ14から発せられる電波により自己発電を行い作動するようにされたカード型記憶媒体を、ユーザ媒体15として適用することができる。また、ユーザが所持する携帯およびデータの送受信が可能な情報機器を、ユーザ媒体15として適用することができる。このような情報機器としては、データの送受信が可能とされた携帯電話端末やPDA(Personal Digital Assistant)などが考えられる。

Various storage media can be used as the

さらに、近年では、携帯電話端末に対して、電話通信機能とは別途にICチップやアンテナ機構、不揮発性メモリを内蔵させ、カード型記憶媒体と同等の機能を持たせた製品も出現している。このような携帯電話端末の、カード型記憶媒体対応機能部分をユーザ媒体15として用いることも可能である。

Furthermore, in recent years, products that have an IC chip, an antenna mechanism, and a non-volatile memory, in addition to the telephone communication function, and a function equivalent to that of a card-type storage medium have appeared. . It is also possible to use the functional part corresponding to the card type storage medium of such a mobile phone terminal as the

さらに、リーダ12A、12B、12C、・・・とユーザ媒体15との間のデータ通信は、無線によるものに限られず、有線、例えばコネクタを介した電気的接触を用いて行うようにしてもよい。この場合、ユーザ媒体15は、不揮発性メモリとインターフェイスとで構成することができ、所謂USB(Universal Serial Bus)メモリ、コンパクトフラッシュメモリ(コンパクトフラッシュは登録商標)、スマートメディアなどを適用することができる。

Further, the data communication between the

さらにまた、ユーザ媒体15は、磁気ディスクや磁気カード、光磁気ディスク、光ディスクといった、書き換え可能な記録媒体としてもよい。この場合、リーダ12A、12B、12C、・・・は、対応するドライブ装置を備える。

Furthermore, the

さらに、ユーザ媒体15は、物理的な変形を以てデータを記録するようなものでもよい。例えば、紙やプラスチック板などに穴を穿ち、データを記録することが考えられる。ユーザIDや日時の情報を記録するのみであれば、このような記録方法でも十分対応可能である。この場合、リーダ12A、12B、12C、・・・は、光学的手法や、電気的な接触を以てデータの読み取りを行う。

Further, the

また、ユーザ媒体15として、印刷媒体を用いることができる。例えば、データをバーコードやQRコード(Quick Response Code)といった所定のコードに変換し、紙やその他の所定の印刷媒体に印刷することで、データの記録を行う。リーダ12A、12B、12C、・・・は、例えば印刷された情報を光を用いて読み取る読み取り装置を備える。

A print medium can be used as the

2−2.実施の第1の形態の第1の応用例について

次に、この発明の実施の第1の形態の第1の応用例について説明する。第1の応用例は、この実施の第1の形態を、化粧方法をアドバイスするような化粧サポートシステムに適用する例である。

2-2. First Application Example of First Embodiment Next, a first application example of the first embodiment of the present invention will be described. The first application example is an example in which the first embodiment is applied to a makeup support system that advises a makeup method.

2−2−1.システムの概要

この化粧サポートシステムについて概略的に説明する。図6は、この化粧サポートシステムの概要を説明するための一例の流れを示すフローチャートである。先ず、ユーザに対して、メイクアップアーティストなどの手により最適と考えられるメイクアップ(理想メイクと呼ぶ)を施す(ステップS20)。そして、この理想メイクが施された顔を所定に撮影し、撮影により得られた画像データをサーバシステムに送信する(ステップS21)。サーバシステム側では、送信されたこの理想メイクによる画像データに基づき、化粧の状態を判断するのに適切な特徴に特化させて顔の特徴情報を抽出し、抽出された顔の特徴情報を、ユーザの参照情報としてユーザ情報データベースに登録する(ステップS22)。このとき、理想メイクを施すのに用いた化粧品を示す情報を、当該参照情報に対応付けて所定にデータベースに登録するとよい。

2-2-1. Outline of system The makeup support system will be schematically described. FIG. 6 is a flowchart showing an exemplary flow for explaining the outline of the makeup support system. First, makeup (referred to as ideal makeup) considered to be optimal is applied to the user by the hands of a makeup artist or the like (step S20). Then, the face with the ideal makeup is photographed in a predetermined manner, and image data obtained by photographing is transmitted to the server system (step S21). On the server system side, based on the transmitted image data of the ideal makeup, the facial feature information is extracted by specializing in features suitable for judging the makeup state, and the extracted facial feature information is It is registered in the user information database as user reference information (step S22). At this time, information indicating the cosmetic used for applying the ideal makeup may be registered in a predetermined database in association with the reference information.

一方、ユーザは、後に、例えば自宅において自分でメイクアップ(自己メイクと呼ぶ)を施し(ステップS23)、自己メイクが施された顔を撮影する。そして、撮影により得られたこの自己メイクによる画像データをサーバシステムに送信する(ステップS24)。サーバシステム側では、ユーザから送信された画像データに所定の処理を施して、顔の、化粧の状態を示す特徴に特化した特徴情報を抽出し、この抽出されたこの特徴情報に対する1次解析処理を行う。1次解析処理は、例えば、当該ユーザの参照情報として登録されている特徴情報とを比較することで行う(ステップS25)。1次解析による比較の結果、両者の差が所定以上であるとされれば(ステップS26)、ユーザの化粧方法に何らかの問題があると考えることができる。そこで、サーバシステム側では、ユーザから送信された画像データおよび/または当該画像データを解析した解析結果に対して、問題部分を抽出可能なように2次解析処理を施す(ステップS27)。 On the other hand, the user later performs makeup (referred to as self-makeup) himself at home, for example (step S23), and photographs the face on which self-makeup has been performed. Then, this self-makeup image data obtained by photographing is transmitted to the server system (step S24). On the server system side, the image data transmitted from the user is subjected to predetermined processing to extract feature information specialized for the facial feature indicating the makeup state, and a primary analysis is performed on the extracted feature information. Process. The primary analysis process is performed, for example, by comparing with feature information registered as reference information of the user (step S25). As a result of the comparison by the primary analysis, if the difference between the two is determined to be greater than or equal to a predetermined value (step S26), it can be considered that there is some problem in the user's makeup method. Therefore, the server system side performs secondary analysis processing on the image data transmitted from the user and / or the analysis result obtained by analyzing the image data so that the problem part can be extracted (step S27).

サーバシステム側は、2次解析処理の結果に基づき、化粧方法に対してアドバイスを行うアドバイス情報を作成する。作成されたアドバイス情報は、当該ユーザに対して送信される(ステップS28)。このとき、アドバイス情報に対応して、お勧めの化粧品などを示す情報を当該アドバイス情報に付加して送信することができる。ユーザは、自宅に居ながらにして、自己のメイクアップを理想メイクに近付ける方法を取得することができると共に、必要な化粧品などの情報を得ることができる。 The server system side creates advice information for giving advice to the makeup method based on the result of the secondary analysis processing. The created advice information is transmitted to the user (step S28). At this time, corresponding to the advice information, information indicating recommended cosmetics or the like can be added to the advice information and transmitted. While staying at home, the user can obtain a method for bringing his / her make-up closer to the ideal make-up, and can obtain information such as necessary cosmetics.

なお、ステップS26で、差が所定未満であるとされた場合には、サーバシステム側からユーザに対して、現在のメイクアップ方法に問題が無い旨を示す通知が送信される(ステップS29)。このとき、参照情報に対応付けられて所定にデータベースに登録された、理想メイクを施す際に用いた化粧品の購入情報などを、当該通知に付加して送信することが考えられる。 If it is determined in step S26 that the difference is less than the predetermined value, a notification indicating that there is no problem in the current makeup method is transmitted from the server system side to the user (step S29). At this time, it is conceivable that the purchase information of cosmetics used when applying the ideal makeup, which is registered in the database in association with the reference information, is added to the notification and transmitted.

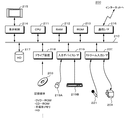

2−2−2.第1の応用例に適用可能なシステムについて

図7は、この実施の第1の形態の第1の応用例に適用可能な一例のシステムを概略的に示す。図7に例示する第1の応用例に適用可能なシステムは、基本的には、図1を用いて上述した、実施の第1の形態に適用可能なシステムと同様な構成を有する。カメラ装置101Aおよびリーダ102Aが施設100Aに配置され、ネットワーク103に接続される。施設100Aは、例えばデパートの化粧品コーナや化粧品メーカなどが主催するメイクアップ教室といった、メイクアップアーティストといったメイクアップのプロフェッショナルがユーザに対してメイクアップを施すようにされた場所である。同様に、カメラ装置101Bおよびリーダ102Bが、例えばユーザの自宅100Bに配置され、ネットワーク103に接続される。

2-2-2. About System Applicable to First Application Example FIG. 7 schematically illustrates an example system applicable to the first application example of the first embodiment. The system applicable to the first application example illustrated in FIG. 7 basically has the same configuration as the system applicable to the first embodiment described above with reference to FIG. A

カメラ装置101Aおよびカメラ装置101Bは、被写体を撮影し、静止画像データを出力する。また、カメラ装置101Aおよび101Bは、静止画像データと共に、当該静止画像データを撮影した時刻を示す時刻情報と、カメラ装置101Aおよび101Bのそれぞれを識別するためのセンサIDとを、当該静止画像データに対応付けて出力する。なお、施設100Aに対して、動画像データを出力するビデオカメラ装置をさらに設けるとよい。カメラ装置101Aにおいて動画像データ出力し、この動画像データから静止画像データを所定に取り出しても良い。

The

リーダ102Aおよび102Bは、図示されないユーザ媒体15に記憶されたユーザIDを読み出す。ユーザ媒体15は、既に述べたように様々な種類のものを適用可能であるが、この第1の応用例では、ユーザ媒体15は、上述した、合成樹脂製のカード内に不揮発性メモリ、送受信部および発電部を有するカード型記憶媒体であるものとする。ユーザ媒体15は、予めユーザIDが記憶され対応するユーザに渡されているものとする。

The readers 102A and 102B read the user ID stored in the user medium 15 (not shown). As described above, various types of

ここでは、カメラ装置101Aから出力される画像データと、リーダ102Aで読み出されたユーザIDとが所定に対応付けられて、ネットワーク103に対して送信されるものとする。例えば、ユーザ媒体15から読み出されたユーザIDを、次にリーダ102Aにユーザ媒体15が読み込まれるか、リーダ102Aに対して保持されるユーザIDの消去操作がなされるまで、リーダ102Aに保持することが考えられる。カメラ装置101Aから出力される画像データに対して、リーダ102Aに保持されるユーザIDを所定に対応付ける。これは、カメラ装置101Bおよびリーダ102Bについても同様とする。

Here, it is assumed that the image data output from the

なお、この第1の応用例において、ユーザIDは、ユーザ媒体15からリーダ102Aにより読み出されるのに限らない。例えば、リーダ102Aをキーボードなど所定の入力手段を設けた入力装置とし、ユーザがマニュアルでユーザIDを入力するようにしてもよい。

In the first application example, the user ID is not limited to being read from the

ネットワーク103は、このシステムで閉じたネットワークとしてもよいし、インターネットのようなオープンなネットワークであってもよい。ネットワーク103としてオープンなネットワークを用いる場合には、各カメラ装置101Aおよび101B、各リーダ102Aおよび102B、ならびに、サーバシステム104との間でやりとりされるデータは、所定の暗号化方式で以て暗号化することが望ましい。

The

なお、図7では、ネットワーク103に対して接続されるカメラ装置およびリーダが配置される施設などが、施設100Aおよびユーザの自宅100Bのみとなっているが、実際には、さらに多数の施設等に設けられたカメラ装置やリーダが、ネットワーク103に対して識別可能に接続される。

In FIG. 7, the facility where the camera device and the reader connected to the

サーバシステム104は、図1を用いて説明したサーバシステム14に対応するもので、例えばサーバ部110、解析システム部111、センサ情報データベース112およびユーザ情報データベース113を有し、この第1の応用例では、さらに、化粧品データベース114を有する。サーバ部110は、このシステムの全体の制御や管理を行う。例えば、サーバ部110は、ネットワーク103を介してカメラ装置101Aおよびリーダ102Aと通信を行い、カメラ装置101Aおよびリーダ102Aから互いに対応付けられて送信された画像データおよびユーザIDを受信し、センサ情報データベース112に所定に格納する。カメラ装置101Bおよびリーダ102Bから出力されるデータに関しても、同様である。

The

解析システム部111は、カメラ装置101Aおよび101Bで取得されセンサ情報データベース112に格納された画像データに対して、一例を後述するような1次解析処理を行う。さらに、1次解析の解析結果に基づき閾値判断を行い、判断結果に応じて一例を後述するような2次解析を行う。

The

サーバシステム104は、サーバ部110によりインターネット130に接続される。インターネット130には、例えばユーザが自宅100Bなどで利用可能な、パーソナルコンピュータなどによるユーザ端末131が接続される。なお、この図7では、インターネット130に接続されるユーザ端末がユーザ端末131のみとなっているが、実際には、さらに多数のユーザ端末の接続が可能である。

The

インターネット130には、さらに、インターネット130に向けてウェブページ公開などウェブサービスを提供するサーバであるウェブサーバ132が接続される。サーバシステム104は、インターネット130を介してウェブサーバ132と通信を行い、ウェブサーバ132に対してファイルのアップロードなどを行うことができる。

Further connected to the

なお、上述では、ユーザの自宅100Bに配置されるカメラ装置101Bがネットワーク103に接続されているように説明したが、これはこの例に限定されない。例えば、カメラ装置101Bがパーソナルコンピュータであるユーザ端末131に接続されるものとし、カメラ装置101Bによる撮影の制御をユーザ端末131にて行い、カメラ装置101Bから出力されたビデオデータをユーザ端末131からインターネット130を介してサーバシステム104に送信するようにしてもよい。

In the above description, the camera device 101B disposed in the user's home 100B has been described as being connected to the

センサ情報データベース112およびユーザ情報データベース113の構成について、概略的に説明する。センサ情報データベース112の構成は、基本的には、図2を用いて説明したセンサ情報データベース22と同一である。なお、施設100Aにおいてビデオカメラ装置が設けられ、動画像を撮影するようにしている場合、ビデオカメラ装置は、動画像データを所定に圧縮符号化してネットワーク103に対して送信し、サーバ部110は、圧縮符号化され供給されたこのビデオデータを所定に格納する。そして、データを識別するデータIDと、圧縮符号化されたビデオデータの実データの格納場所を示す情報とを対応付けて、センサ情報データベース112内のセンサ情報テーブルに登録する。

The configurations of the

ユーザ情報データベース113は、ユーザ情報が登録されるユーザ情報テーブルと、参照情報テーブルとを有する。図8は、ユーザ情報データベース113内のユーザ情報テーブルの一例の構成を示す。ユーザ情報テーブルは、ユーザを識別するユーザID毎に、ユーザIDが対応するユーザの属性情報と、当該ユーザの化粧に関する情報とが登録される。ユーザの属性情報は、例えば、そのユーザの名前、年齢、連絡先(電子メールアドレス)といった、ユーザを表す情報からなる。化粧情報は、そのユーザの化粧に関連する情報であって、肌のタイプ(乾燥肌か脂性か、きめが細かいか粗いか、地肌の色など)、化粧の好み(全体的に白っぽく、全体的に浅黒く、など)、普段使用している化粧品の品番などの情報からなる。これらの情報は、例えば、ユーザがこのシステムの利用を開始する際に設定される。参照情報テーブルの構成については、後述する。

The

このような構成のシステムにおいて、図6を用いて説明した流れに従い、先ずユーザは、施設100Aでメイクアップアーティストなどに、最適と思われるメイクアップ(理想メイク)を施してもらう(ステップS20)。また、ユーザは、リーダ102Aにユーザ媒体15に記憶されるユーザIDを読み取らせると共に、理想メイクが施された顔をカメラ装置101Aにより撮影させる。顔の撮影は、例えば、立体画像を構成可能なように、顔の正面、側面、上方といったように、複数の方向からなされる。メイクアップの様子をビデオカメラで撮影し、動画像データとして出力することもできる。また、後に画像補正が可能なように、色、濃淡、明るさなどの基準となる被写体が、ユーザの顔と同一の画像データ中に含まれるように撮影される。撮影で得られた複数の画像データは、それぞれ撮影された時刻を示す時刻情報と、カメラ装置101Aを識別するセンサIDと、ユーザIDとが付加されて、ネットワーク103を介してサーバシステム104に送信される(ステップS21)。

In the system configured as described above, according to the flow described with reference to FIG. 6, first, the user asks a makeup artist or the like to make up makeup (ideal makeup) at the facility 100A (step S20). Further, the user causes the reader 102A to read the user ID stored in the

サーバシステム104は、これら画像データと、当該画像データに付加された時刻情報、センサIDおよびユーザIDとをサーバ部110に供給する。サーバ部110は、センサ情報データベース112のセンサIDが対応するセンサ情報テーブルに対し、画像データ、時刻情報およびユーザIDを所定に対応付けて格納する。センサ情報データベース112に格納された画像データは、ユーザIDなどに基づきサーバ部20に読み出され、解析システム部111に供給される。解析システム部111は、供給された画像データに対して所定の処理を施し、処理結果に基づき当該画像データに対応する参照情報を生成する。参照情報は、参照情報を識別するための参照情報IDを付加され、関連する他の情報と対応付けられて、ユーザ情報データベース113内の参照情報テーブルに所定に登録される(ステップS22)。

The

ユーザは、後に、例えばユーザの自宅100Bで、理想メイクに倣って自分でメイクアップ(自己メイク)を行う(ステップS23)。また、ユーザは、リーダ102Bにユーザ媒体15に記憶されるユーザIDを読み出させる。そして、ユーザは、自己メイクが施された顔をカメラ装置101Bで撮影する。ユーザ側では、立体画像を構成可能に撮影を行う必要はなく、例えば顔の正面からのみの撮影が行われる。このときにも、後に画像補正が可能なように、色、濃淡、明るさなどの基準となる被写体が、ユーザの顔と同一の画像データ中に含まれるように撮影される。撮影で得られた複数の画像データは、それぞれ撮影された時刻を示す時刻情報と、カメラ装置101Aを識別するセンサIDと、ユーザIDとが付加されて、ネットワーク103を介してサーバシステム104に送信される(ステップS24)。

The user later performs makeup (self-makeup) himself following the ideal makeup, for example, at the user's home 100B (step S23). In addition, the user causes the reader 102B to read the user ID stored in the

サーバシステム104は、これら自己メイクによる画像データと、当該画像データに付加された時刻情報、センサIDおよびユーザIDとをサーバ部110に供給する。サーバ部110は、センサ情報データベース112のセンサIDが対応するセンサ情報テーブルに対し、画像データ、時刻情報およびユーザIDを所定に対応付けて格納する。センサ情報データベース112に格納された画像データは、ユーザIDなどに基づきサーバ部20に読み出され、解析システム部111に供給される。解析システム部111は、供給された画像データに対して所定の処理を施す。サーバ部110は、供給されたユーザIDに基づきユーザ情報データベース113内の参照情報テーブルから対応する参照情報を抽出し、参照情報と、自己メイクによる画像データに基づく処理結果とを比較し、1次解析を行う(ステップS25)。

The

1次解析の結果、参照情報と自己メイクによる画像データに基づく処理結果との差が所定以上あれば(ステップS26)、サーバ部110は、自己メイクによる画像データに基づき2次解析処理を行う(ステップS27)。そして、2次解析結果に基づきアドバイス情報を作成し、ユーザに対して送信する。例えば、サーバ部110は、ユーザIDに基づきユーザ情報データベース113内のユーザ情報テーブルを検索し、当該ユーザIDに対応付けられた電子メールアドレスを取得し、取得された電子メールアドレスに対して、アドバイス情報が記述または添付された電子メールを送信する。

As a result of the primary analysis, if the difference between the reference information and the processing result based on the self-make image data is greater than or equal to a predetermined value (step S26), the

ユーザは、サーバ部110から送信された、アドバイス情報が添付された電子メールを、例えばユーザの自宅100Bにおいてユーザ端末131を用いて受信することで、アドバイス情報に基づきより理想メイクに近い自己メイクを行うことが可能となる。

The user receives the e-mail attached with the advice information transmitted from the

ここで、アドバイス情報と共に、当該ユーザの参照情報に対応する画像データをユーザに対して送信することが考えられる。すなわち、アドバイス情報と当該画像データとを一纏めにパッケージングし、このパッケージデータを電子メールに添付して送信する。ユーザは、この電子メールをユーザ端末131で受信して、画像データを表示させながらアドバイス情報を参照することで、理想メイクによる画像を見ながらアドバイス情報に従いメイクアップを行うことができ、より容易に、理想メイクに近い自己メイクを行うことができる。

Here, it is conceivable to transmit image data corresponding to the reference information of the user together with the advice information to the user. That is, the advice information and the image data are packaged together, and the package data is attached to an electronic mail and transmitted. The user receives this e-mail at the

さらに、サーバ部110は、アドバイス情報に応じた広告を、アドバイス情報および理想メイクによる画像データとパッケージングしてユーザに送信することができる。例えば、サーバ部110は、2次解析結果に基づき、1次解析の結果として得られる差分を所定以下とすると思われる化粧品を、化粧品データベース114から検索することが考えられる。これに限らず、ステップS20による理想メイク時に用いた化粧品の情報を化粧品データベース114から検索してもよい。サーバ部110は、化粧品データベース114から検索された化粧品の情報に基づく広告と、アドバイス情報と、理想メイクによる画像データとを一纏めにしてパッケージングし、パッケージデータとしてユーザに送信する。これによれば、ユーザは、自分に合った化粧品の情報を即座に入手することができる。

Further, the

図9は、パッケージデータの一例の構成を示す。パッケージデータ140は、例えば、互いに対応するメタデータ141、個別データ142、142、・・・および付加情報143が一纏めにされたもので、一例として、これらのデータそれぞれをファイルとして構成し、アーカイブして1のファイルとすることが考えられる。1のフォルダ内にこれらのファイルを纏めて格納し、フォルダ自体をパッケージデータ140と見做すことも考えられる。

FIG. 9 shows an exemplary configuration of package data. The

メタデータ141は、パッケージングされたパッケージデータ140自体の属性であって、パッケージされたデータの内容を統括的に示す情報からなる。例えば、ユーザが理想メイクを行った施設100Aなどを識別するためのID情報をメタデータ141として格納することが考えられる。個別データ142、142、・・・は、例えば、参照情報に対応する画像データ、アドバイス情報、広告情報がそれぞれ格納される。付加情報143は、所定の付加情報を格納することができ、例えばユーザが理想メイクを行った日時、メイクアップを担当したメイクアップアーティスト名、メイクアップを行った施設100Aの名前などを付加情報143として格納することが考えられる。

The

上述では、パッケージデータ140に対してアドバイス情報、理想メイクによる画像データおよび広告情報を格納したが、これはこの例に限定されない。施設100Aにおいてメイクアップの様子を動画像データとして撮影している場合には、この動画像データをさらにパッケージデータ140に格納することができる。サーバ部110は、センサ情報データベース112から所定に動画像データを取り出して、パッケージデータ140に個別データとしてパッケージングして格納する。

In the above description, advice information, image data by ideal makeup, and advertisement information are stored in the

なお、パッケージデータ140に個別データとして含まれる動画像データは、所謂ストリーミング配信を行うと、配信先における閲覧時の負担が減り、好ましい。ストリーミング配信は、圧縮された動画像データおよび音声データを所定単位毎に配信し、受信側でバッファに溜め込み伸長しながら続きのデータを受信してバッファに蓄えるようにして、動画像データや音声データなどのストリームデータをダウンロードしながら再生できるようにしたものである。

Note that moving image data included as individual data in the

2−2−3.第1の応用例による解析処理の例について

次に、この実施の第1の形態の第1の応用例に適用可能な1次解析処理および2次解析処理の例について説明する。先ず、1次解析処理の例について説明する。1次解析処理は、例えば、顔における複数の所定ポイントを計測ポイントとして設定し、理想メイクを施した顔と自己メイクを施した顔とに対し、各々の計測ポイントで所定の計測を行い、理想メイクを施した顔について計測された値と、自己メイクを施した顔について計測された値とを比較し、差分を計算する。そして、この差分を、所定の閾値と比較することが考えられる。

2-2-3. Example of Analysis Processing According to First Application Example Next, examples of primary analysis processing and secondary analysis processing applicable to the first application example of the first embodiment will be described. First, an example of the primary analysis process will be described. In the primary analysis process, for example, a plurality of predetermined points on the face are set as measurement points, and predetermined measurement is performed at each measurement point on a face subjected to ideal makeup and a face subjected to self-makeup. A difference is calculated by comparing the value measured for the face with makeup and the value measured for the face with self-makeup. It is conceivable to compare this difference with a predetermined threshold.

図10を用いて、計測ポイントの例について説明する。例えば、サーバシステム104は、ユーザが施設100Aにおいて理想メイクを施された際に撮影された画像データに基づき、計測ポイントを設定する。先ず、顔150を正面から撮影した画像データに基づき、顔の輪郭152を特定すると共に、頭髪の輪郭151を特定する。特定された顔の輪郭152に基づき、顔150の内部の計測ポイントの位置を特定する。

An example of measurement points will be described with reference to FIG. For example, the

顔150の内部の計測ポイントとして、左右の眉153Aおよび153B、左右の目154Aおよび154B、ならびに、口唇155が考えられる。これら眉153Aおよび153B、目154Aおよび154B、ならびに、口唇155について、位置および形状が計測される。口唇155の形状に関しては、色を計測し色の変化に基づき判断することが考えられる。立体画像に基づき口唇155の形状を判断することもできる。眉153Aおよび153Bについては、色も計測される。目154Aおよび154Bについては、さらに詳細に、アイライン、睫などの色および形状が計測される。

As measurement points inside the

顔150の内部の計測ポイントとして、さらに、化粧の際に注目される所定の位置156A〜156Jを特定することが考えられる。一例として、額の中央の位置156A、鼻筋に相当する位置156Dおよび位置156G、左右の瞼の位置156Bおよび156C、左右の頬骨の位置156Eおよび156F、左右の頬の位置156Hおよび156I、ならびに、顎の位置156Jが考えられる。これらの位置156A〜156Jについて、位置および色が計測される。

As measurement points inside the

なお、これら位置156A〜156Jのうち、特に頬骨の位置156Eおよび156Fや、鼻の頂点の位置156G、顎の位置156Jなどは、理想メイク後に複数の方向から撮影された画像データに基づき構成される、顔の立体画像を用いることで特定できると考えられる。

Of these positions 156A to 156J,

また、図示しないが、顔150の内部の計測ポイントとして、例えば所定の2点を結ぶ線を特定することが考えられる。この所定の2点を結ぶ線により、色のグラデーションが計測される。この後羅デーションを計測するための所定の2点は、例えば目の近辺や、頬骨や頬の近辺に設定することが考えられる。

Further, although not shown, as a measurement point inside the

理想メイクによる画像データについて、これらの計測ポイントの計測値に基づきそれぞれ評価値を求める。眉、目、口唇などの形状データに関しては、これら眉、目、口唇に関して様々な形状が数値化されて登録された形状辞書を用意し、顔から計測された計測値と形状辞書に登録された値とを比較して差分を求め、差分に基づき評価値を求めることが考えられる。色に関しては、画像データから得られる3原色の値そのものを評価値として用いることが考えられる。これに限らず、3原色の値をCIE(commission internationale de l'eclairage)により規定される色度座標(x,y,Y)などに変換して、評価値として用いることも考えられる。グラデーションに関しては、所定の2点を結ぶ線上の複数点の色を計測することが考えられる。 Evaluation values are obtained for the image data based on the ideal makeup based on the measurement values at these measurement points. For shape data of eyebrows, eyes, lips, etc., a shape dictionary in which various shapes for these eyebrows, eyes, and lips are digitized and registered is prepared, and the measured values measured from the face and registered in the shape dictionary It can be considered that a difference is obtained by comparing the value and an evaluation value is obtained based on the difference. Regarding colors, it is conceivable to use the values of the three primary colors themselves obtained from the image data as evaluation values. Not limited to this, the values of the three primary colors may be converted into chromaticity coordinates (x, y, Y) defined by CIE (commission internationale de l'eclairage) and used as evaluation values. Regarding gradation, it is conceivable to measure the colors of a plurality of points on a line connecting two predetermined points.

このようにして、理想メイクによる画像データから求められた各計測ポイントの位置情報と、評価値とが参照情報として、参照情報テーブルに登録される。図11は、参照情報テーブルの構成例を示す。ここでは、図11A〜図11Dに例示されるように、参照情報テーブルを複数のテーブルから構成している。参照情報テーブルの構成はこれに限らず、複数のテーブルを1つに纏めてもよいし、さらに分割することも考えられる。 In this way, the position information of each measurement point obtained from the image data by ideal makeup and the evaluation value are registered in the reference information table as reference information. FIG. 11 shows a configuration example of the reference information table. Here, as illustrated in FIGS. 11A to 11D, the reference information table is composed of a plurality of tables. The configuration of the reference information table is not limited to this, and a plurality of tables may be combined into one, or further divided.

図11Aは、各計測ポイントを定義する定義テーブルの一例の構成を示す。この定義テーブルは、例えば参照情報毎に設けられ、計測ポイントを識別する識別情報PoIDに対して、位置情報と計測ポイントの種類が対応付けられて格納される。計測ポイントが複数の位置情報を用いて定義される場合、当該複数の位置情報を列挙することが考えられる。種類は、色、形状など、当該計測ポイントで計測されるデータの種類を示す。 FIG. 11A shows an example of a definition table that defines each measurement point. This definition table is provided for each reference information, for example, and stores the position information and the types of measurement points in association with the identification information PoID for identifying the measurement points. When a measurement point is defined using a plurality of position information, it is conceivable to list the plurality of position information. The type indicates the type of data measured at the measurement point, such as color and shape.

図11Bは、各計測ポイントにおける評価値が、参照情報毎に格納される評価値テーブルの一例の構成を示す。評価値の代わりに各計測ポイントにおける計測値を格納してもよい。評価値は、解析処理の際に計測値から求めるようにする。 FIG. 11B shows a configuration of an example of an evaluation value table in which evaluation values at each measurement point are stored for each reference information. The measurement value at each measurement point may be stored instead of the evaluation value. The evaluation value is obtained from the measured value during the analysis process.

図11Cは、各参照情報における画像データが格納される画像データテーブルの一例の構成を示す。各参照情報毎に、ユーザを複数の方向から撮影した画像のそれぞれと、これら複数の画像から形成された立体画像とが格納される。なお、実際には、画像データそのものは、サーバ部110が有する所定のストレージ装置(図示しない)に格納され、画像データテーブルに対してこれらの画像データの格納場所を示すポインタが登録される。

FIG. 11C shows a configuration of an example of an image data table in which image data in each reference information is stored. For each reference information, each of images obtained by photographing the user from a plurality of directions and a stereoscopic image formed from the plurality of images are stored. Actually, the image data itself is stored in a predetermined storage device (not shown) included in the

図11Dは、参照情報毎に、属性情報が格納される属性情報テーブルの一例の構成を示す。例えば、参照情報毎に、対応するユーザID、取得された日付、任意の説明、施設100Aの名称や施設100Aにおけるユーザの担当者などを登録することが考えられる。 FIG. 11D shows a configuration of an example of an attribute information table in which attribute information is stored for each reference information. For example, for each reference information, it may be possible to register a corresponding user ID, an acquired date, an arbitrary description, a name of the facility 100A, a person in charge of the user at the facility 100A, and the like.

1次解析は、一例として次のようにして行うことが考えられる。自己メイクによる画像データに対して、参照情報に基づき各計測ポイントの位置を求め、求められた各計測ポイントの位置において、参照情報を求める際に行ったのと同様の計測を行い、各計測結果に基づき評価値を求める。そして、参照情報について求められた各評価値と、自己メイクによる画像データに基づき求められた各評価値とに対し、計測ポイント毎に、計測ポイントに応じた重み付けをそれぞれ所定に行い、重み付けされた評価値に関し、対応する評価値の組それぞれについて差分の絶対値を計算する。評価値の組それぞれについて計算された差分の絶対値を加算して、加算結果を所定の閾値と比較する。加算結果が閾値よりも大きいと判断されれば(図6のステップS26)、2次解析を行う。 The primary analysis may be performed as follows as an example. For the image data by self-make, the position of each measurement point is obtained based on the reference information, and at the position of each obtained measurement point, the same measurement as that performed when obtaining the reference information is performed. The evaluation value is obtained based on Then, for each measurement point, each evaluation value obtained for the reference information and each evaluation value obtained based on the image data by self-make is weighted according to the measurement point, and weighted. For the evaluation value, the absolute value of the difference is calculated for each corresponding set of evaluation values. The absolute values of the differences calculated for each set of evaluation values are added, and the addition result is compared with a predetermined threshold value. If it is determined that the addition result is larger than the threshold value (step S26 in FIG. 6), secondary analysis is performed.

2次解析は、一例として次のようにして行うことが考えられる。先ず、1次解析の際に計算された、各評価値の組毎の差分について、計測ポイント単位で所定にソートし、差分が所定以上の計測ポイントについて、差分が大きい順に、差分の内容を解析する。解析は、計測ポイントの種類および計測内容に応じてなされる。例えば、形状の計測値、すなわち眉、目(睫、アイライン)、口唇(口紅の境界)などの場合は、理想メイクと自己メイクとで輪郭の位置になどにずれが生じていると考えられるので、ずれの大きさや方向が解析される。色の計測値、すなわち口唇や、顔150の内部の所定位置156A〜156J、2点間のグラデーションなどの場合は、色差の解析や、色度座標上でどの方向にずれているかなどが解析される。

The secondary analysis may be performed as follows as an example. First, the difference for each set of evaluation values calculated at the time of the primary analysis is sorted in units of measurement points, and the contents of the differences are analyzed in descending order for the measurement points having a difference greater than or equal to a predetermined value. To do. The analysis is performed according to the type of measurement point and the measurement content. For example, in the case of a shape measurement value, that is, eyebrows, eyes (eyelids, eyelines), lips (boundary of lipstick), it is considered that there is a deviation in the position of the contour between ideal makeup and self makeup. Therefore, the magnitude and direction of the deviation are analyzed. In the case of a color measurement value, that is, a lip or a gradation between two predetermined positions 156A to 156J inside the

2次解析結果に基づき、ユーザに対して化粧のアドバイスを行うアドバイス情報を生成し、ユーザに提示するとよい。サーバシステム104において、例えば2次解析を行った計測ポイント毎、評価値の差分情報の予測される解析結果毎に、アドバイス用のテキストデータを予め用意する。そして、実際の2次解析の結果に基づき、このアドバイス用のテキストデータを所定に組み合わせて1のテキストデータとし、これを、ユーザに対する全体的な化粧のアドバイス情報として提示する。アドバイス情報は、例えばパッケージデータ140に含めてユーザに提供される。

Based on the secondary analysis result, advice information for giving makeup advice to the user may be generated and presented to the user. In the

上述では、アドバイス情報などを電子メールに添付して送信するように説明したが、これはこの例に限定されない。例えば、アドバイス情報、理想メイクによる画像データおよび広告情報を、ウェブサイト上のウェブページとして、インターネット130上で閲覧可能としてユーザに提示することが考えられる。

In the above description, the advice information and the like are described as being attached to the e-mail, but this is not limited to this example. For example, it is conceivable that advice information, image data based on ideal makeup, and advertisement information are presented to a user as a web page on a website so as to be viewable on the

一例として、サーバ部110に対し、インターネット130上のURL(Uniform Resource Locator)を定義可能なストレージ装置を設け、アドバイス情報、理想メイクによる画像データおよび広告情報を一纏めにしたパッケージデータ140をこのストレージ装置に格納する。この場合には、パッケージデータ140は、例えばアドバイス情報、理想メイクによる画像データが格納されるフォルダである。パッケージデータ140に格納される画像データには、所定のURLが定義される。

As an example, a storage device capable of defining a URL (Uniform Resource Locator) on the

サーバ部110は、HTML(Hyper Text Markup Language)やXML(Extensible Markup Language)など、インターネット130上のウェブページとして提示可能な書式を用いて、ストレージ装置に保持されたパッケージデータ140に含まれる画像データのリンク情報やレイアウト情報、アドバイス情報に基づくテキストデータ、広告情報に基づくリンク情報などを記述したファイル(以降、ウェブファイルと呼ぶ)を作成する。広告情報に基づくリンク情報は、例えば広告情報に示される化粧品を販売するウェブページへのリンク情報である。このウェブファイルを、インターネット130上のウェブサーバ132に転送する。

The

ウェブサーバ132は、このウェブファイルに対してURLを定義し、インターネット130上で閲覧可能とする。ユーザは、インターネット130に接続されたユーザ端末131を用いて当該URLにアクセスすることで、パッケージデータ140に含まれる画像データや、アドバイス情報、広告情報を閲覧可能とされる。

The

一例として、サーバ部110は、ウェブサーバ132に対してウェブファイルを転送すると共に、ユーザに対して、当該ウェブファイルがインターネット130に対して閲覧可能とされていることを通知する。より具体的には、サーバ部110は、ユーザ情報データベース113内のユーザ情報テーブルを検索し、ユーザの電子メールアドレスを取得する。そして、サーバ部110は、当該ウェブファイルのURLを所定に記述した電子メールを作成し、取得された電子メールアドレスに宛てて送信する。この電子メールを受信したユーザは、電子メールの記述に基づき当該URLにアクセスする。

As an example, the

図12は、パッケージデータ140に含まれる画像データ、アドバイス情報、広告情報を閲覧させるウェブページの一例の画面構成を示す。ウェブページは、一般的には、ユーザ端末131に搭載されるブラウザと呼ばれるソフトウェアで表示などがなされる。ブラウザは、例えば入力されたURLに従いインターネット130の上のファイルにアクセスする。アクセスしたファイルが例えばHTML形式といった所定の形式で記述されていれば、ファイルの記述に従い、テキストデータの表示、画像データへのリンクや、各表示のレイアウトなどを行う。また、ブラウザは、読み込んだファイルに指定された手段で、ウェブサーバ132に対してデータを送信することができる。

FIG. 12 shows a screen configuration of an example of a web page for browsing image data, advice information, and advertisement information included in the

このようなブラウザソフトウェアは、パーソナルコンピュータなどの他に、インターネット接続が可能な携帯電話端末や家庭用ゲーム機器などにも搭載されるのが一般的となってきている。以下では、ブラウザがパーソナルコンピュータに搭載されているものとして説明する。ブラウザの各機能は、マウスといったポインティングデバイスと、キーボードなどのキャラクタ入力デバイスとにより制御するできるようにされている。 In addition to personal computers and the like, such browser software has been generally installed in mobile phone terminals and home game devices that can be connected to the Internet. In the following description, it is assumed that the browser is mounted on the personal computer. Each function of the browser can be controlled by a pointing device such as a mouse and a character input device such as a keyboard.

図12を参照し、ブラウザ画面300において、ブラウザ自身のコントロールやOS(Operating System)によるコントロールを行うための表示部301の下部に、ウェブページの表示を行うためのウェブページ表示部302が設けられる。ウェブページ表示部302に対し、パッケージデータ140に含まれる、理想メイクによる画像データ、アドバイス情報であるテキストデータおよび広告情報が所定に配置され表示される。図12の例では、ウェブページ表示部302内の表示領域310に理想メイクによる画像データが表示され、表示領域311にテキストデータが表示され、表示領域312に広告情報が表示されている。また、表示領域311および312には、それぞれ右端にスクロールバーが設けられ、領域内にデータが表示しきれない場合に、このスクロールバーを所定に操作することで、領域311や領域312において隠れていたデータを、当該領域内に表示させることができる。

Referring to FIG. 12, a web

図13は、ウェブページによる表示の別の例を示す。この図13の例では、ブラウザ画面320において、理想メイクによる画像データが表示される領域330内に、図中に点線で例示されるように、各計測ポイントに応じてそれぞれ所定に範囲340A〜340Gが設定される。例えば、このブラウザ画面320が表示されているユーザ端末131において、マウスといったポインティングデバイスを所定に操作し、画面上のカーソル341を範囲340A〜340Gのうち所望の範囲に位置させることで、領域331に対し、当該範囲に対応するアドバイス情報が選択的に表示される。また、当該範囲に対応する化粧品の広告情報が領域332に選択的に表示される。

FIG. 13 shows another example of display by a web page. In the example of FIG. 13, a range 340 </ b> A to 340 </ b> G is predetermined in accordance with each measurement point in a region 330 where image data by ideal makeup is displayed on the

さらに、この実施の第1の形態の第1の応用例では、2次解析の結果に基づき、ユーザに対して化粧品の紹介を行うことができるようにされている。例えば、2次解析で解析対象となった計測ポイントについて、位置および計測種類に応じて化粧品データベース114を参照し、2次解析の結果に基づき適当と判断される化粧品を選択する。この化粧品の情報をパッケージデータ140に含め、ユーザに対して提供する。化粧品データベース114は、例えば、化粧品を種類や主に用いられる顔内の部位で分類し、色情報、価格情報、化粧品の品番などを登録することが考えられる。

Furthermore, in the first application example of the first embodiment, cosmetics can be introduced to the user based on the result of the secondary analysis. For example, for a measurement point that is an analysis target in the secondary analysis, the

図14は、化粧品データベース114の一例の構成を示す。種類は、例えば化粧品を用途に応じて大まかに分類したもので、それぞれ顔内の部位と対応付けられる。対応部位は、図14では具体名となっているが、実際的には、計測ポイントで示す方が好ましいと考えられ、例えば、図11Aを用いて説明した計測ポイントの識別情報PoIDを用いることができる。各種類または対応部位毎に色別、品番別にデータが登録され、それぞれ価格情報が対応付けられる。この図14の例では、色情報が化粧品メーカによる命名法に基づき格納されている。この場合、別途、化粧品メーカの命名法に基づく色名と、色度図上の座標とを対応付けるテーブルを用意すると、好ましい。シリーズは、例えば化粧品メーカによる商品の分類である。

FIG. 14 shows an exemplary configuration of the

化粧品情報の検索方法の一例として、2次解析結果に基づき、自己メイクによる口唇(図10の例では、口唇155)の色が理想メイクによる色に比べて濃すぎると判定されたとする。なお、「色がある色に対して濃い」という場合、実際には、例えば色度図上の方向を示す必要がある。ここでは、繁雑さを避けるため、単に「濃い、薄い」と表現する。

As an example of a cosmetic information search method, it is assumed that the color of the lip by self-makeup (

このような場合、例えば、化粧品データベース114を参照して、部位が対応する化粧品(この場合は口紅)の中から、参照情報における口唇155の色に対応するの化粧品を抽出し、この化粧品の情報をパッケージデータ140に含ませてユーザに提供することが考えられる。このとき、この化粧品の購入方法を示す情報も、化粧品情報と共にユーザに提供すると、より好ましい。例えば、この化粧品をインターネット130を介して購入可能なウェブサイトのURLを、化粧品情報と共にユーザに提供する。ユーザは、2次解析結果を受け取ったその場で化粧品の注文を行うことができる。

In such a case, for example, referring to the

なお、上述では、図6のフローチャートにおけるステップS26で自己メイクによる特徴情報と理想メイクによる特徴情報との差が所定以上の場合に、化粧品の紹介を行うように説明したが、これはこの例に限定されない。すなわち、ステップS26においてこれらの差が所定未満であるとされた場合にも、化粧品の紹介を行うようにできる。この場合は、例えば、ユーザ情報データベース113内のユーザ情報テーブルにおける使用化粧品情報に基づき、ユーザが使用している化粧品と同等以上の効果を持つ他の化粧品や、同等の効果を持ちより低価格の化粧品を紹介することが考えられる。

In the above description, the cosmetic product is introduced when the difference between the feature information based on self-makeup and the feature information based on ideal makeup is greater than or equal to a predetermined value in step S26 in the flowchart of FIG. It is not limited. That is, even when it is determined in step S26 that these differences are less than a predetermined value, cosmetics can be introduced. In this case, for example, based on the used cosmetic information in the user information table in the

2−2−4.補足

なお、化粧では、微妙な色合いを用いることが多いため、1次解析や2次解析において正確な解析を行うためには、理想メイクによる顔を撮影した画像データと、自己メイクによる顔を撮影した画像データとで、色の見え方が等しくなるようにする必要がある。それと共に、画像データを計測して得られた色情報と、例えば化粧品データベース114に登録される各化粧品の色情報とを共通の表示系で比較可能とする必要がある。

2-2-4. Supplement Since makeup often uses subtle shades, in order to perform an accurate analysis in the primary and secondary analysis, the image data obtained by photographing the face with ideal makeup and the face by self-makeup are photographed. It is necessary to make the color appearance the same with the processed image data. At the same time, it is necessary to be able to compare the color information obtained by measuring the image data and the color information of each cosmetic registered in the

一例として、既に説明したように、理想メイクによる顔の撮影時および自己メイクによる顔の撮影時に、色、濃淡、明るさなどの基準となる被写体を、ユーザの顔と同一の画像データ中に含まれるように撮影を行う。この基準となる被写体は、例えば、ホワイトバランスに基づく補正を行うための白色の部分と、各色毎に色補正を行うための色見本部分とで構成する。この基準となる被写体を、画面内の所定位置に配置して、撮影を行う。 As an example, as described above, when photographing a face with ideal makeup and photographing a face with self-makeup, the reference object such as color, lightness and brightness is included in the same image data as the user's face Take a photo as shown. The reference subject includes, for example, a white portion for performing correction based on white balance and a color sample portion for performing color correction for each color. The reference subject is placed at a predetermined position in the screen and photographing is performed.

画像データに基づき1次解析を行う際や、カメラ装置101Aおよび101Bで撮影され得られた画像データがセンサ情報データベース112に格納される際などに、先ず、画像データによる画面内の所定位置に配置される、上述した基準となる被写体を所定に計測し、計測結果に基づき、白色部分の色情報と色見本部分の色情報とを取得する。そして、これらの色情報と、基準となる被写体の標準光源下における色情報とに基づき、カメラ装置101Aおよび101Bから得られた画像データを正規化することが考えられる。

When performing a primary analysis based on image data, or when image data obtained by the

また、顔の立体形状における凹凸と、撮影時の光源の方向により、画像データ中の顔の所定部分に影部が生じることがあり、この影部は、色の計測に影響する。この影響は、例えば、参照情報として登録される顔の立体画像に対して光源のシミュレートを行い、影部の発生を予測することで、回避可能であると考えられる。例えば、自己メイクによる画像データに対して、鼻周辺など影部の発生が予測される部分について計測を行って影らしき部分を抽出し、この抽出された影部分情報に基づき光源シミュレートを行い、光源の方向を予測する。この予測された光源方向に基づき、他の影部の発生を予測する。 In addition, a shadow portion may occur in a predetermined portion of the face in the image data depending on the unevenness in the three-dimensional shape of the face and the direction of the light source at the time of shooting, and this shadow portion affects the color measurement. This effect can be avoided by, for example, simulating a light source on a stereoscopic face image registered as reference information and predicting the occurrence of shadows. For example, for the image data by self-make, measure the part where shadows are predicted to occur such as around the nose, extract the part that appears to be shadowed, perform light source simulation based on this extracted shadow part information, Predict the direction of the light source. Based on the predicted light source direction, the occurrence of another shadow portion is predicted.

このように、この実施の第1の形態の第1の応用例によれば、ユーザは、自宅にいながらにして理想メイクにより近いメイクアップを簡単に行うことができ、また、必要な化粧品の情報の入手や購入も、その場で行うことができる。 As described above, according to the first application example of the first embodiment, the user can easily perform makeup that is closer to the ideal makeup while at home, and obtain necessary cosmetic information. And purchases can also be made on the spot.

2−3.実施の第1の形態の第2の応用例について

次に、この発明の実施の第1の形態の第2の応用例について説明する。第2の応用例は、実施の第1の形態を、スポーツなどの身体フォームに対するアドバイスを行うスポーツ向けのラーニングシステムに適用する例である。

2-3. Second Application Example of the First Embodiment Next, a second application example of the first embodiment of the present invention will be described. The second application example is an example in which the first embodiment is applied to a sports learning system that provides advice on body forms such as sports.

2−3−1.システムの概要

この第2の応用例によるスポーツ向けラーニングシステムについて概略的に説明する。図15は、このスポーツ向けラーニングシステムの概要を説明するための一例の流れを示すフローチャートである。先ず、ユーザにとって理想的なフォームの撮影がなされる(ステップS30)。例えば、トレーナやインストラクタ(以下、指導員)によりユーザに対して正しいフォームで動作するように指示がなされ、ユーザがこの指示に従い動作する様子を、動画として撮影する。ここで撮影されたフォームを、理想フォームと呼ぶ。理想フォーム撮影の際のユーザの動作は、実際のフォームに基づく動作に対して遅い動きであってもよいものとする。

2-3-1. System Overview A sports learning system according to the second application example will be schematically described. FIG. 15 is a flowchart showing an exemplary flow for explaining the outline of this sports learning system. First, a form ideal for the user is photographed (step S30). For example, a trainer or an instructor (hereinafter referred to as an instructor) gives an instruction to the user to operate in the correct form, and a picture of the user operating according to the instruction is taken as a moving image. The form photographed here is called an ideal form. It is assumed that the user's operation at the time of ideal form shooting may be slower than the operation based on the actual form.

理想フォームが撮影されたビデオデータは、サーバシステムに送信される(ステップS31)。サーバシステム側では、送信されたこのビデオデータに基づきフォームの特徴を示す特徴情報を抽出し、抽出されたフォームの特徴情報を、ユーザの参照情報としてユーザ情報データベースに登録する(ステップS32)。 The video data in which the ideal form is photographed is transmitted to the server system (step S31). On the server system side, feature information indicating the feature of the form is extracted based on the transmitted video data, and the extracted feature information of the form is registered in the user information database as user reference information (step S32).

一方、ユーザは、後に、トレーニング施設や自宅などでフォームの再現動作を行い、その様子を動画として撮影する(ステップS33)。ここで撮影されたフォームを、自己フォームと呼ぶ。そして、自己フォームを撮影したビデオデータをサーバシステムに送信する(ステップS34)。サーバシステム側では、ユーザから送信されたビデオデータを解析して、フォームの特徴を示す特徴情報を抽出し、抽出されたこの特徴情報と、当該ユーザの参照情報として登録されている特徴情報とを比較する(ステップS35)。比較の結果、両者の差が所定以上であるとされれば(ステップS36)、ユーザのフォームに何らかの問題があると考えることができる。そこで、サーバシステム側では、ユーザから送信されたビデオデータおよび/または当該ビデオデータを解析した解析結果に対して、問題部分を抽出可能なように2次解析処理を施す(ステップS37)。 On the other hand, the user later performs a form reproduction operation at a training facility or at home, and shoots the state as a moving image (step S33). The form photographed here is called a self-form. And the video data which image | photographed the self-form is transmitted to a server system (step S34). On the server system side, the video data transmitted from the user is analyzed, the feature information indicating the feature of the form is extracted, and the extracted feature information and the feature information registered as the reference information of the user are included. Compare (step S35). As a result of the comparison, if the difference between the two is greater than or equal to a predetermined value (step S36), it can be considered that there is some problem in the user's form. Therefore, the server system performs secondary analysis processing on the video data transmitted from the user and / or the analysis result obtained by analyzing the video data so that the problem part can be extracted (step S37).

サーバシステム側は、2次解析処理の結果に基づき、ユーザに対してフォームのアドバイスを行うアドバイス情報を作成する。作成されたアドバイス情報は、当該ユーザに対して送信される(ステップS38)。このとき、アドバイス情報に対応して、お勧めのスポーツウェアやスポーツ用品を示す情報を当該アドバイス情報に付加して送信することができる。ユーザは、自己トレーニングや自己レッスンにより自己のフォームを理想フォームに近付けることができると共に、必要などの情報を得ることができる。 The server system side creates advice information for giving advice of the form to the user based on the result of the secondary analysis processing. The created advice information is transmitted to the user (step S38). At this time, corresponding to the advice information, information indicating recommended sportswear and sports equipment can be added to the advice information and transmitted. The user can bring his / her own form closer to the ideal form through self-training and self-learning, and obtain necessary information.

なお、ステップS36で、差が所定未満であるとされた場合には、サーバシステム側からユーザに対して、現在のフォームで問題が無い旨を示す通知が送信される(ステップS39)。このとき、ユーザ情報データベースに登録された当該ユーザの情報などに基づき、関連商品の購入情報などを、当該通知に付加して送信することが考えられる。 If it is determined in step S36 that the difference is less than the predetermined value, a notification indicating that there is no problem in the current form is transmitted from the server system side to the user (step S39). At this time, based on the information of the user registered in the user information database and the like, it is conceivable that purchase information of related products is added to the notification and transmitted.

2−3−2.第2の応用例に適用可能なシステムについて

図16は、この実施の第1の形態の第2の応用例に適用可能な一例のシステムを概略的に示す。なお、以下では、この第2の応用例を、実施の第1の形態をゴルフのスウィングのフォームをユーザに対してアドバイスする、ゴルフ教習システムに適用したものとして説明する。

2-3-2. System applicable to second application example FIG. 16 schematically shows an example system applicable to the second application example of the first embodiment. In the following description, the second application example will be described assuming that the first embodiment is applied to a golf learning system that advises a user of a golf swing form.

図16に例示する第2の応用例に適用可能なシステムは、基本的には、図1を用いて上述した実施の第1の形態に適用可能なシステムや、図7を用いて上述した実施の第1の形態の第1の応用例に適用可能なシステムと同様の構成を有する。なお、図16において、上述した図7と共通する部分には同一の符号を付し、詳細な説明を省略する。 The system applicable to the second application example illustrated in FIG. 16 is basically the system applicable to the first embodiment described above with reference to FIG. 1 and the implementation described above with reference to FIG. It has the same configuration as the system applicable to the first application example of the first form. In FIG. 16, the same reference numerals are given to the same parts as those in FIG. 7 described above, and detailed description thereof is omitted.

施設160は、例えば指導員がユーザに対してフォームの指導などを行うようにされた場所である。この図16の例では、2台のビデオカメラ装置161Aおよび162A、ならびに、リーダ163Aが施設160に配置され、それぞれオープンまたはこのシステムでクローズされたネットワーク103に接続される。2台のビデオカメラ装置161Aおよび162Aのうち一方(ビデオカメラ装置161Aとする)は、ユーザのスウィングの様子を全体的に撮影するためのもので、他方(ビデオカメラ装置162A)は、ゴルフクラブのヘッドにおけるインパクトの様子を撮影するためのものである。リーダ163Aは、図示されないユーザ媒体15から例えばユーザIDを読み取る。

The

一方、ユーザの自宅164や図示されないゴルフ練習場のレーンといった、ユーザが自分自身でフォームのトレーニングを行うような場所に、2台のビデオカメラ装置161Bおよび162B、ならびに、リーダ163Bが配置され、それぞれネットワーク103に接続される。この場合も、施設160と同様に、2台のビデオカメラ装置161Bおよび162Bは、それぞれスウィング全体およびインパクトの様子を撮影するためのものである。

On the other hand, two

ビデオカメラ装置161A、162A、161Bおよび162Bは、それぞれ被写体を撮影し、得られたビデオデータを所定に圧縮符号化して出力すると共に、ビデオデータを撮影した時刻を示す時刻情報と、ビデオカメラ装置161A、162A、161Bおよび162Bそれぞれを識別するセンサIDとを、当該ビデオデータに対応付けて出力する。時刻情報は、ビデオカメラ装置161A、162A、161Bおよび162Bのそれぞれにおいて発生され、フレーム単位で時刻指定が可能とされたタイムコードを用いることができる。

Each of the

なお、ビデオカメラ装置161A、162A、161Bおよび162Bは、高速な動きを撮影する必要があるので、通常のビデオカメラと比べてフレームレートがより高速なものであると好ましい。さらに、ビデオカメラ装置161A、162A、162Aおよび162Bは、フラッシュライトシステムと連動したものであると、より好ましい。システムの構成などによっては、インパクトの様子を撮影するビデオカメラ装置162Aおよび162Bは、省略可能である。

Note that the

リーダ163Aおよび163Bは、図示されないユーザ媒体15に記憶されたユーザIDを読み出す。ユーザ媒体15は、既に述べたように様々な種類のものを適用可能であるが、この第2の応用例では、ユーザ媒体15は、上述した、合成樹脂製のカード内に不揮発性メモリ、送受信部および発電部を有するカード型記憶媒体であるものとする。ユーザ媒体15は、予めユーザIDが記憶され対応するユーザに渡されているものとする。

The

上述の第1の応用例と同様に、ビデオカメラ装置161Aおよび162Aから出力されるビデオデータと、リーダ163Aで読み出されたユーザIDとが所定に対応付けられて、ネットワーク103に対して送信されるものとする。これは、ビデオカメラ装置161Bおよび162B、ならびに、リーダ163Bについても同様とする。また、この第2の応用例においても上述の第1の応用例と同様に、ユーザIDは、ユーザ媒体15からリーダ163Aにより読み出されるのに限らない。例えば、リーダ163Aをキーボードなど所定の入力手段を設けた入力装置とし、ユーザがマニュアルでユーザIDを入力するようにしてもよい。

Similar to the first application example described above, the video data output from the

なお、図16では、ネットワーク103に対して接続されるビデオカメラ装置およびリーダが配置される施設などが、施設160およびユーザの自宅164のみとなっているが、実際には、さらに多数の施設等に設けられた ビデオカメラ装置やリーダが、ネットワーク103に対して識別可能に接続される。

In FIG. 16, the facility where the video camera device and the reader connected to the

サーバシステム104’は、図7を用いて説明したサーバシステム104に対応するもので、例えばサーバ部110’、解析システム部111’、センサ情報データベース112’、ユーザ情報データベース113’およびゴルフ情報データベース166を有する。ゴルフ情報データベース166は、ゴルフ用品の情報や、ゴルフ練習場の情報など、ゴルフに関する情報が登録される。サーバ部110’は、このシステムの全体の制御や管理を行い、ビデオカメラ装置161A、162A、161Bおよび162Bから送信されたビデオデータ、ユーザIDおよび時刻情報を、センサ情報データベース112’に所定に格納する。

The

解析システム部111’は、ビデオカメラ装置161A、162A、161Bおよび162Bで取得されセンサ情報データベース112’に格納されたビデオデータに対して、一例を後述するような1次解析処理を行う。さらに、1次解析の解析結果に基づき閾値判断を行い、判断結果に応じて一例を後述するような2次解析を行う。

The

サーバシステム104’は、サーバ部110’によりインターネット130に接続される。インターネット130には、例えばユーザが自宅164などで利用可能な、パーソナルコンピュータなどによるユーザ端末165が接続される。なお、図16の例では、インターネット130に接続されるユーザ端末がユーザ端末165のみとなっているが、実際には、さらに多数のユーザ端末の接続が可能である。また、インターネット130には、インターネット130に向けてウェブページ公開などウェブサービスを提供するサーバであるウェブサーバ132が接続される。

The server system 104 'is connected to the

なお、上述では、ユーザの自宅164に配置されるビデオカメラ装置161Bおよび162Bがネットワーク103に接続されているように説明したが、これはこの例に限定されない。例えば、ビデオカメラ装置161Bおよび162Bがパーソナルコンピュータであるユーザ端末165に接続されるものとし、ビデオカメラ装置161Bおよび162Bによる撮影の制御をユーザ端末165にて行い、ビデオカメラ装置161Bおよび162Bから出力されたビデオデータをユーザ端末165からインターネット130を介してサーバシステム104’に送信するようにしてもよい。

In the above description, the

センサ情報データベース112’およびユーザ情報データベース113’の構成について、概略的に説明する。センサ情報データベース112’の構成は、図2を用いて説明したセンサ情報データベース112と同様とされ、ビデオデータを識別するデータIDに対し、当該ビデオデータの格納場所を示すポインタ情報と、ユーザIDと、時刻情報とが対応付けられて、センサ情報テーブルに登録される。この場合、時刻情報は、例えば当該ビデオデータの撮影が開始された時刻とされる。

The configurations of the sensor information database 112 'and the user information database 113' will be schematically described. The configuration of the

ユーザ情報データベース113’は、ユーザ情報が登録されるユーザ情報テーブルと、参照情報テーブルとを有する。図17は、ユーザ情報データベース113’内のユーザ情報テーブルの一例の構成を示す。ユーザ情報テーブルは、ユーザを識別するユーザID毎に、ユーザIDが対応するユーザの属性情報と、当該ユーザのゴルフに関する情報とが登録される。ユーザの属性情報は、例えば、そのユーザの名前、連絡先(電子メールアドレス)といったユーザを識別する情報と、年齢、身長、体重といったユーザの身体的特徴を示す情報とからなる。ゴルフ関連情報は、そのユーザのゴルフに関連する情報であって、例えば、ハンデ、ドライバでの飛距離といったユーザのゴルフの技術に関する情報や、ユーザが使用しているゴルフクラブなど、ゴルフ用品に関する情報からなる。これらの情報は、例えば、ユーザがこのシステムの利用を開始する際に設定される。参照情報テーブルの構成については、後述する。 The user information database 113 'includes a user information table in which user information is registered and a reference information table. FIG. 17 shows an example of the configuration of the user information table in the user information database 113 '. In the user information table, for each user ID for identifying a user, user attribute information corresponding to the user ID and information regarding the user's golf are registered. The user attribute information includes, for example, information for identifying the user such as the user's name and contact information (e-mail address), and information indicating the physical characteristics of the user such as age, height, and weight. The golf-related information is information related to the user's golf, for example, information related to the user's golf technology such as a handicap and a driver's flight distance, and information related to golf equipment such as a golf club used by the user. Consists of. These pieces of information are set when the user starts using the system, for example. The configuration of the reference information table will be described later.

このような構成のシステムにおいて、図15を用いて説明した流れに従い、先ずユーザは、施設160で指導員の指導の下、理想フォームによるスウィング動作を行い、例えばビデオカメラ装置161Aを用いてそのフォームを撮影する(ステップS30)。また、ユーザは、リーダ163Aにユーザ媒体15に記憶されるユーザIDを読み取らせる。フォームが撮影されたビデオデータは、撮影された時刻を示す時刻情報と、ビデオカメラ装置161Aを識別するセンサIDと、ユーザIDとが付加されて、ネットワーク103を介してサーバシステム104’に送信される(ステップS31)。

In the system configured as described above, according to the flow described with reference to FIG. 15, the user first performs a swing operation using an ideal form under the guidance of an instructor at the

サーバシステム104’は、これらビデオデータと、当該ビデオデータに付加された時刻情報、センサID、ユーザIDとをサーバ部110’に供給する。ビデオデータは、例えばサーバ部110’が有するストレージ装置に所定に格納される。サーバ部110’は、センサ情報データベース112’のセンサIDが対応するセンサ情報テーブルに対し、ビデオデータの格納場所を示すポインタ情報、時刻情報およびユーザIDを所定に対応付けて格納する。

The

ビデオデータは、ポインタ情報やユーザIDなどに基づきサーバ部110’に読み出され、解析システム部111’に供給される。解析システム部111’は、供給されたビデオデータに対して所定の処理を施し、当該ビデオデータに対する参照情報を生成する。参照情報は、参照情報を識別するための参照情報IDを付加され、関連する他の情報と対応付けられて、ユーザ情報データベース113’内の参照情報テーブルに所定に登録される(ステップS32)。

The video data is read to the server unit 110 'based on the pointer information, the user ID, etc., and supplied to the analysis system unit 111'. The

ユーザは、後に、例えばユーザの自宅164で、自分自身でスウィング動作を行い、ビデオカメラ装置161Bを用いてフォームを撮影する(ステップS33)。また、ユーザは、リーダ163Bにユーザ媒体15に記憶されるユーザIDを読み出させる。自己フォームが撮影されたビデオデータは、撮影された時刻を示す時刻情報と、ビデオカメラ装置161Bを識別するセンサIDと、ユーザIDとが付加されて、ネットワーク103を介してサーバシステム104’に送信される(ステップS34)。

The user later performs a swing operation by himself / herself, for example, at the user's

サーバシステム104’は、これら自己フォームによるビデオデータと、当該ビデオデータに付加された時刻情報、センサIDおよびユーザIDとをサーバ部110’に供給する。ビデオデータは、例えばサーバ部110’が有するストレージ装置に所定に格納される。ビデオデータは、ポインタ情報やユーザIDなどに基づきサーバ部110’に読み出され、解析システム部111’に供給される。解析システム部111’は、供給されたビデオデータに対して所定の処理を施す。そして、サーバ部110’は、供給されたユーザIDに基づきユーザ情報データベース113’内の参照情報テーブルから対応する参照情報を抽出し、参照情報と、自己フォームによるビデオデータに基づく処理結果とを比較し、1次解析を行う(ステップS35)。

The server system 104 'supplies the video data in the self-form and the time information, sensor ID, and user ID added to the video data to the server unit 110'. For example, the video data is stored in a predetermined storage device in the

1次解析による比較の結果、参照情報と自己フォームによるビデオデータに基づく処理結果の差分が所定以上あれば(ステップS36)、サーバ部110’は、自己フォームによるビデオデータ、或いは、自己フォームによるビデオデータに基づく処理結果に対して、2次解析処理を行う(ステップS37)。そして、2次解析結果に基づきアドバイス情報を生成し、例えば電子メールなどを用いてユーザに対して送信する。 As a result of the comparison by the primary analysis, if the difference between the reference information and the processing result based on the video data based on the self-form is greater than or equal to a predetermined value (step S36), the server unit 110 ' A secondary analysis process is performed on the processing result based on the data (step S37). Then, advice information is generated based on the secondary analysis result, and transmitted to the user using e-mail, for example.

ユーザは、サーバ部110’から送信された、アドバイス情報が添付された電子メールを、例えばユーザの自宅164においてユーザ端末165を用いて受信することで、アドバイス情報に基づきより理想フォームに近いフォームのスウィングを学習することが可能となる。

The user receives the e-mail attached with the advice information transmitted from the

ここで、アドバイス情報と共に、当該ユーザの参照情報に対応するビデオデータをユーザに対して送信することが考えられる。すなわち、アドバイス情報と当該ビデオデータとを一纏めにパッケージングし、このパッケージデータを電子メールに添付して送信する。パッケージデータの構成は、図9を用いて説明したのと同様であるので、ここでの説明は省略する。ユーザは、この電子メールをユーザ端末165で受信して、ビデオデータを再生させながらアドバイス情報を参照することで、より効果的にスウィングの学習を行うことができる。