JP2005295004A - 立体画像処理方法および立体画像処理装置 - Google Patents

立体画像処理方法および立体画像処理装置 Download PDFInfo

- Publication number

- JP2005295004A JP2005295004A JP2004104148A JP2004104148A JP2005295004A JP 2005295004 A JP2005295004 A JP 2005295004A JP 2004104148 A JP2004104148 A JP 2004104148A JP 2004104148 A JP2004104148 A JP 2004104148A JP 2005295004 A JP2005295004 A JP 2005295004A

- Authority

- JP

- Japan

- Prior art keywords

- unit

- viewpoint

- value

- parallax

- camera

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Pending

Links

Images

Classifications

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/10—Processing, recording or transmission of stereoscopic or multi-view image signals

- H04N13/106—Processing image signals

- H04N13/128—Adjusting depth or disparity

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/10—Processing, recording or transmission of stereoscopic or multi-view image signals

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/20—Image signal generators

- H04N13/275—Image signal generators from 3D object models, e.g. computer-generated stereoscopic image signals

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/10—Processing, recording or transmission of stereoscopic or multi-view image signals

- H04N13/106—Processing image signals

- H04N13/122—Improving the 3D impression of stereoscopic images by modifying image signal contents, e.g. by filtering or adding monoscopic depth cues

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/10—Processing, recording or transmission of stereoscopic or multi-view image signals

- H04N13/106—Processing image signals

- H04N13/139—Format conversion, e.g. of frame-rate or size

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/20—Image signal generators

- H04N13/286—Image signal generators having separate monoscopic and stereoscopic modes

- H04N13/289—Switching between monoscopic and stereoscopic modes

Abstract

【解決手段】 カメラ配置決定部136は、現フレームにおいて、直前のフレームで取得したZ値およびユーザの適正視差をもとに、オブジェクト空間における本カメラの配置場所を決定する。投影処理を行った後、視差画像生成部142は、視点画像をもとに視差画像を生成する。上述のZ値は、直前のフレームにおいてカメラ配置決定部136により配置された少なくとも1つの本カメラにより取得されたものであり、現フレームでそれを利用することで立体画像処理全体の高速化を実現できる。

【選択図】 図19

Description

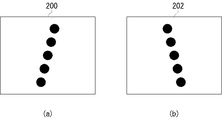

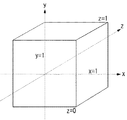

ここで、実施の形態1の概要を述べる。実施の形態1では、オブジェクト空間内に1つのカメラなどの視点を暫定的に配置する。こうして暫定的に配置されたカメラ(以下、単に「仮カメラ」という)により、立体表示すべきオブジェクトの奥行き方向の演算領域の範囲を取得する。この奥行き方向の演算領域の範囲を取得するとき、この装置は、Zバッファ法という既知の陰面消去アルゴリズムを用いる。ここでZバッファ法とは、オブジェクトのZ値を画素ごとに記憶させるとき、Z軸上で視点から近いZ値があれば、そのZ値をすでに記憶されたZ値に上書きする手法をいう。こうして画素ごとに記憶されたZ値の中で最大のZ値(以下、単に「最大Z値」という)および最小のZ値(以下、単に「最小Z値」という)を求めることで、奥行き方向の演算領域の範囲を特定する。実施の形態では、X軸方向の線分およびY軸方向の線分で区切られた画素に対応する位置でのオブジェクトのZ値を取得するものとする。

1)本カメラごとの視点画像の解像度よりも低い解像度でZ値を取得する。

2)立体表示すべきオブジェクトに対応し、かつ少ないデータ量からなるオブジェクトを用いて、Z値を取得する。この場合、Z値取得用の別のオブジェクト空間を準備し、そのオブジェクト空間内にそのオブジェクトを配置して、Z値を取得してもよい。

tan(φ/2)=Mtan(θ/2)/L

tan(ψ/2)=Ntan(θ/2)/L

このようにして、ユーザから与えられた限界視差をもとに、近置最大見込み角φおよび遠置最大見込み角ψが決まる。

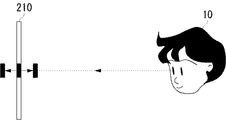

E:S=P:A

E:S+T=Q:T−A

が成立する。Eは本カメラのカメラ間距離である。いま、視差の付けられていない画素である点Gは両カメラからの光軸K2が光軸交差面上212で交差する位置にあり、光軸交差面212がスクリーン面の位置となる。近置最大視差Pを生む光線K1は前方投影面34上で交差し、遠置最大視差Qを生む光線K3は後方投影面36上で交差する。

P=2(S+A)tan(φ/2)

Q=2(S+A)tan(ψ/2)

で表され、結果として、

E=2(S+A)tan(θ/2)・(SM+SN+TN)/(LT)

A=STM/(SM+SN+TN)

が得られる。上述のごとく、基本表現空間Tと視点距離Sは、最大Z値および最小Z値に基づいて算出され既知であるため、こうしてA及びEが自動的に決まり、したがって光軸交差距離Dとカメラ間距離Eが自動的に決まり、カメラパラメータが確定する。カメラ配置決定部136はこれらのパラメータにしたがって本カメラの配置を決定すれば、以降、投影処理部140および視点画像生成部141の処理を各カメラからの画像に対して独立してなすことにより、視差画像生成部142により適正視差をもった視差画像が生成および出力できる。以上のごとく、EとAはハードウエアの情報を含んでおらず、ハードウエアに依存しない表現形式が実現される。

ここで、実施の形態2の概要を述べる。実施の形態1では、オブジェクト空間内に仮カメラを暫定的に配置してZ値を取得したが、実施の形態2では、本カメラにより取得されるZ値を利用する。図19は、実施の形態2に係る立体画像処理装置100の構成を示す。以下、実施の形態1と同等の構成には同じ符号を与え適宜説明を略す。実施の形態2に係る立体画像処理装置100には、図4に示した実施の形態1に係る立体画像処理装置100と異なる構成要素であるZ値読み出し部144、Z値書き込み部146、Z値保持部150が設けられている。Z値保持部150には、Z値取得部134により取得されたZ値が格納される。そうして格納されたZ値は、少なくとも最大Z値および最小Z値が含まれる。

ここで、実施の形態3の概要を述べる。実施の形態2では、静的なオブジェクトに対してとくに効果的であったが、例えば、オブジェクトが突然、カメラの視野範囲にフレームインしたときやこの立体画像処理装置がシーンチェンジを検出したとき、演算領域の範囲に急激な変化が生じているため、直前のフレームにおいて取得したZ値を現フレームのZ値として用いることが不適切なことがある。このような場合、この立体画像処理装置は、直前のZ値を用いてカメラパラメータを設定するのではなく、直前のフレームにおいて生成した視差画像よりも弱い視差を持たせた視差画像を生成するようなカメラパラメータを本カメラに適用することで対応する。

実施の形態1において、仮カメラを設けた理由は、上述するごとく、本カメラの配置場所を決定づけるZ値を取得するためであり、視点画像を生成するためではない。一方、第1変形例における仮カメラは、Z値を取得するとともに視差画像のもとになる1つの視点画像を生成することができる。

図24は、第2変形例に係る立体画像処理装置100の構成を示す図である。第2変形例は、実施の形態1に係る立体画像処理装置100に新たに演算選択情報取得部160が設けられる。演算選択情報取得部160は、オブジェクト毎に関連づけられている演算領域の範囲に含めるか否かの演算選択情報を取得し、その演算選択情報を読み取る。演算領域の範囲に含めないとする演算選択情報を有するオブジェクトを取得したとき、Z値取得部134に、そのオブジェクトを無視して、他のオブジェクトからZ値を取得するよう指示する。これにより、故意に基本表現空間を飛び出すような効果的なオブジェクトの立体表示を実現できる。また、立体画像処理装置100内の図示しないCPUが、所定のオブジェクトを演算領域の範囲に含めないようZ値取得部134に指示してもよいし、ユーザが図示しないGUIを用いて、指示してもよい。Z値取得部134は、演算選択情報取得部160により含めないとされたオブジェクトを無視して、Z値を取得する。また、演算選択情報取得部160は、実施の形態2または3に係る立体画像処理装置100にも設けても良い。

実施の形態3では、Z値使用判定部190により、Z値の使用不可が指示されたとき、カメラ配置決定部136は、直前のフレームにおいて生成された視差画像よりも弱い視差を持たせた視差画像を生成するよう本カメラを配置した。第3変形例では、このような指示があったとき、視差画像生成部142は、視差を持たない二次元画像を生成してもよい。既述のごとく、ユーザが不快感を訴える多くの原因は視差の強すぎが問題であり、それを回避するべく、現フレームでは立体表示でなく平面表示を実現することで、ユーザの立体視への影響を軽減することができる。第3変形例に係る立体画像処理装置100の構成は、実施の形態3に係る立体画像処理装置100の構成と同様である。第3変形例における仮カメラは、第1変形例の場合と同様に、Z値を取得するとともに視差画像のもとになる1つの視点画像を生成することができる。

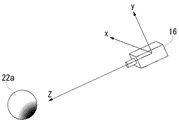

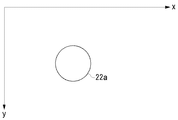

図26は、角度を用いて奥行き方向の演算領域の範囲を取得する様子を模式的に示す。実施の形態では、X軸方向の線分およびY軸方向の線分で区切られた画素に対応する位置でのオブジェクトのZ値を取得したが、第4変形例では、図示のごとく、第1オブジェクト22aおよび第2オブジェクト22bにおける第1角度θと第2角度φが同じ点の座標に対応するオブジェクトのZ値を取得し、最大Z値および最小Z値を求めてもよい。このとき、Z値取得用の別の仮想空間を準備して、最大Z値および最小Z値を求めてもよい。

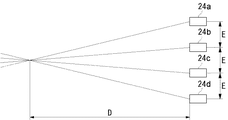

実施の形態では、カメラ配置決定部136は仮カメラを中心とし2台の本カメラを配置したが、第5変形例では、2つの異なる本カメラの両外側方向に、カメラ間の距離が2つの本カメラの距離間隔となるように、複数台、例えば4台の本カメラを配置する。図27は4台の第1〜第4本カメラ24a〜24dによる4眼式のカメラ配置を示す。より中央に近い第2本カメラ24bと第3本カメラ24cの間で決めた前述のAおよびEを他のカメラ間隔に流用してもよい。これにより、本カメラの配置場所を決めるためのカメラパラメータを算出する時間を短縮することができ、立体画像処理全体の高速化を実現することができる。

実施の形態では、カメラ仮配置部130は、仮想空間内における仮カメラの配置場所をフレームごとに決めていったが、第6変形例では、カメラ仮配置部130は、直前のフレームにおいて、カメラ配置決定部136により配置された本カメラの視野範囲を含む視野範囲を有するよう、仮カメラを配置してもよい。図28は、仮カメラ16と4台の第1〜第4本カメラ24a〜24dとの位置関係を示す。図示のごとく、直前のフレームにて配置された4台の第1〜第4本カメラ24a〜24dの視野範囲を含む視野範囲を実現するよう、仮カメラ16が配置されている。

図29は、第7変形例に係る立体画像処理装置100の構成を示す図である。第7変形例では、実施の形態2に係る立体画像処理装置100に新たに動作予測部170および変位量予測部172が設けられる。動作予測部170は、各オブジェクトの前後方向への動きおよび動作速度などを検出し、その検出結果をもとにそれらオブジェクトの将来の動きの状態を予測する。変位量予測部172は、動作予測部170による予測結果をもとに、それら立体表示すべきオブジェクトが包含される所定の領域の変位量を予測する。例えば、変位量予測部172は、この変位量を直前のフレームにおける奥行き方向の演算領域の範囲に加算することで、現フレームにおける奥行き方向の演算領域の範囲を予測することができる。このとき、奥行き方向の演算領域の範囲をもとにZ値を取得して、現フレームにおけるZ値の予測値としてもよい。また、変位量予測部172は、この変位量に応じたカメラの配置を実現するようなカメラ間隔や光軸交差位置などのカメラパラメータを予測することができる。

実施の形態3では、Z値使用判定部190によりZ値を使用しないと判定されたとき、直前のフレームにおいて生成された視差画像よりも弱い視差を持たせた視差画像を現フレームにて生成した。第8変形例では、Z値使用判定部190によりZ値を使用しないと判定されたとき、Z値取得部134は、直前のフレームにおいて取得されたZ値を用いず、上述の投影処理のクリッピング時において仮設定される前方投影面34と後方投影面36を用いて、奥行き方向の演算領域の範囲を取得してもよい。上述のごとく、前方投影面34と後方投影面36は、そもそも可視オブジェクトがすべて含まれるように決定されるため、立体表示すべきオブジェクトが含まれる演算領域として、前方投影面34と後方投影面36間に囲まれた領域を用いるのは、効果的である。

実施の形態3では、Z値使用判定部190によりZ値を使用しないと判定されたとき、直前のフレームにおいて生成された視差画像よりも弱い視差を持たせた視差画像を現フレームにて生成した。本カメラにより視点画像を生成するとともにZ値を取得する場合、立体画像処理に関する時間的な問題は少ないが、その視点画像の生成とは別の契機でZ値の取得処理が必要な場合には、簡易な取得方法で処理の高速化を図る必要がある。このとき、第9変形例として、Z値取得部134は視点画像の解像度よりも低い解像度でZ値を取得してもよい。既述のごとく、取得するZ値というのはオブジェクトの奥行き方向の演算領域の範囲を特定するためのものであり、視差画像を生成するほどの解像度は必要ない。したがって、ここでは解像度を視点画像よりも低下させることによって、Z値取得のためのデータ処理量を低減し、立体表示処理全体の高速化を実現することができる。また、Z値取得部134によるZ値取得処理がシーンチェンジまでに完了できないときは、その取得処理が完了するまで、シーンチェンジを遅延させてもよい。

実施の形態ではスクリーン面に対して水平方向にカメラを配置したが、垂直方向に配置してもよく、水平方向の場合と同様の効果を享受できる。

実施の形態では、Zバッファ法によりオブジェクトのZ値を取得したが、本変形例として、デプスマップを取得して奥行き方向の演算領域の範囲を特定してもよい。本変形例でも実施の形態と同様の効果を享受できる。

実施の形態1から実施の形態3を任意に組み合わせた形態も有効である。本変形例によれば、実施の形態1から実施の形態3を任意に組み合わせた効果が得られる。

Claims (16)

- 異なる視点に対応する複数の視点画像をもとにオブジェクトを立体表示する立体画像処理装置であって、

前記立体表示すべきオブジェクトが含まれる仮想空間内の奥行き方向の演算領域の範囲を取得する奥行き値取得部と、

前記取得された奥行き方向の演算領域の範囲をもとに、複数の異なる視点を前記仮想空間内に配置する視点配置部と、

前記複数の異なる視点からの視点画像をもとに、視差画像を生成する視差画像生成部とを、

備えることを特徴とする立体画像処理装置。 - 前記仮想空間内に暫定的に視点を配置する視点仮配置部をさらに備え、前記奥行き値取得部は、前記暫定的に配置された視点に基づき、前記奥行き方向の演算領域の範囲を取得することを特徴とする請求項1に記載の立体画像処理装置。

- 前記視点仮配置部は、前記仮想空間内に1つの視点を暫定的に配置することを特徴とする請求項2に記載の立体画像処理装置。

- 前記視点仮配置部は、前記視点配置部により配置された複数の視点の視野範囲を含む視野範囲を有するよう、視点を前記仮想空間内に配置することを特徴とする請求項2または3に記載の立体画像処理装置。

- 前記視点配置部は、前記奥行き値取得部により取得された前記奥行き方向の演算領域の範囲をもとに、前記視点仮配置部により暫定的に配置された視点に加え、当該視点が中心にくるよう、2つの異なる視点を前記仮想空間内に配置することを特徴とする請求項2から4のいずれかに記載の立体画像処理装置。

- 前記視点配置部は、前記2つの異なる視点の両外側方向に、視点間の距離が前記2つの視点の距離間隔となるように、複数の視点を配置することを特徴とする請求項5に記載の立体画像処理装置。

- 前記奥行き値取得部は、前記視点画像の解像度よりも低い解像度で前記奥行き方向の演算領域の範囲を取得することを特徴とする請求項1から6のいずれかに記載の立体画像処理装置。

- 前記奥行き値取得部は、前記立体表示すべきオブジェクトに対応し、かつ少ないデータ量からなるオブジェクトを用いて、前記奥行き方向の演算領域の範囲を取得することを特徴とする請求項1から7のいずれかに記載の立体画像処理装置。

- 前記奥行き値取得部は、前記視点配置部により配置された前記複数の異なる視点のうち、少なくとも1つの視点による前記奥行き方向の演算領域の範囲を取得することを特徴とする請求項1に記載の立体画像処理装置。

- 前記奥行き値取得部は、前記視点配置部により配置された前記複数の異なる視点のうち、2以上の視点による前記奥行き方向の演算領域の範囲を取得し、それぞれの奥行き方向の演算領域の範囲を統合して、1つの奥行き方向の演算領域の範囲を生成することを特徴とする請求項1に記載の立体画像処理装置。

- 前記奥行き値取得部により取得された前記奥行き方向の演算領域の範囲を使用可能かどうかを判定する奥行き値使用判定部をさらに備え、前記奥行き値使用判定部により使用できないとされたとき、前記視差画像生成部は、視差画像を生成せず視差を持たない二次元画像を生成することを特徴とする請求項9または10に記載の立体画像処理装置。

- 前記奥行き値取得部により取得された前記奥行き方向の演算領域の範囲を使用可能かどうかを判定する奥行き値使用判定部をさらに備え、前記奥行き値使用判定部により使用できないとされたとき、前記視点配置部は、前回生成された視差画像よりも弱い視差を持たせた視差画像を生成するよう前記複数の異なる視点を配置することを特徴とする請求項9または10に記載の立体画像処理装置。

- 前記奥行き値取得部により取得された前記奥行き方向の演算領域の範囲を使用可能かどうかを判定する奥行き値使用判定部をさらに備え、前記奥行き値使用判定部により使用できないとされたとき、前記奥行き値取得部は、前方投影面および後方投影面を用いて、前記奥行き方向の演算領域の範囲を取得することを特徴とする請求項9または10に記載の立体画像処理装置。

- 前記オブジェクトの動きの状態を検出し、その検出結果をもとに前記オブジェクトの将来の動きの状態を予測する動作予測部と、

前記動作予測部により予測されたオブジェクトの将来の動きの状態をもとに、前記オブジェクトが包含される所定の領域の変位量を予測する変位量予測部と、

をさらに備え、前記視点配置部は、前記変位量予測部により予測された所定の領域の変位量に基づいて、前記複数の異なる視点を前記仮想空間内に配置することを特徴とする請求項9から13のいずれかに記載の立体画像処理装置。 - 前記演算領域の範囲に含めるか否かの演算選択情報を前記オブジェクトごとに取得する演算選択情報取得部をさらに備え、前記演算選択情報取得部により前記演算領域の範囲に含めないとする演算選択情報を取得したとき、前記奥行き値取得部は、含めないとしたオブジェクトを無視して、他のオブジェクトから前記奥行き方向の演算領域の範囲を取得することを特徴とする請求項1から14のいずれかに記載の立体画像処理装置。

- 立体表示を目的とするオブジェクトが含まれる仮想空間内の奥行き方向の演算領域の範囲を取得するステップと、

前記取得された奥行き方向の演算領域の範囲をもとに、複数の異なる視点を前記仮想空間内に配置するステップと、

前記複数の異なる視点からの視点画像をもとに、視差画像を生成するステップと、

を有することを特徴とする立体画像処理方法。

Priority Applications (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2004104148A JP2005295004A (ja) | 2004-03-31 | 2004-03-31 | 立体画像処理方法および立体画像処理装置 |

| CNA200510055045XA CN1678085A (zh) | 2004-03-31 | 2005-03-15 | 立体图像处理方法以及立体图像处理装置 |

| US11/086,493 US20050219239A1 (en) | 2004-03-31 | 2005-03-23 | Method and apparatus for processing three-dimensional images |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2004104148A JP2005295004A (ja) | 2004-03-31 | 2004-03-31 | 立体画像処理方法および立体画像処理装置 |

Publications (1)

| Publication Number | Publication Date |

|---|---|

| JP2005295004A true JP2005295004A (ja) | 2005-10-20 |

Family

ID=35050344

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2004104148A Pending JP2005295004A (ja) | 2004-03-31 | 2004-03-31 | 立体画像処理方法および立体画像処理装置 |

Country Status (3)

| Country | Link |

|---|---|

| US (1) | US20050219239A1 (ja) |

| JP (1) | JP2005295004A (ja) |

| CN (1) | CN1678085A (ja) |

Cited By (11)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2010263542A (ja) * | 2009-05-11 | 2010-11-18 | National Institute Of Information & Communication Technology | 遠隔コミュニケーションシステム、制御装置、およびプログラム |

| CN102143371A (zh) * | 2010-01-28 | 2011-08-03 | 株式会社东芝 | 图像处理装置、三维显示装置和图像处理方法 |

| JP2011160302A (ja) * | 2010-02-02 | 2011-08-18 | Waseda Univ | 立体映像制作装置およびプログラム |

| JP2011176823A (ja) * | 2010-01-28 | 2011-09-08 | Toshiba Corp | 画像処理装置、立体表示装置及び画像処理方法 |

| CN102193705A (zh) * | 2010-03-02 | 2011-09-21 | 鸿富锦精密工业(深圳)有限公司 | 三维多媒体影像互动控制系统及方法 |

| JP2012129710A (ja) * | 2010-12-14 | 2012-07-05 | Canon Inc | 表示制御装置、表示制御方法及びプログラム |

| JP2012141819A (ja) * | 2010-12-29 | 2012-07-26 | Nintendo Co Ltd | 画像処理システム、画像処理プログラム、画像処理方法及び画像処理装置 |

| JP2012191366A (ja) * | 2011-03-09 | 2012-10-04 | Fujitsu Ltd | 生成装置および生成方法 |

| JP2012203755A (ja) * | 2011-03-28 | 2012-10-22 | Toshiba Corp | 画像処理装置及び画像処理方法 |

| JP2012252583A (ja) * | 2011-06-03 | 2012-12-20 | Nintendo Co Ltd | 表示制御プログラム、表示装置、表示システム、および、表示制御方法 |

| JP2012252566A (ja) * | 2011-06-03 | 2012-12-20 | Nintendo Co Ltd | 情報処理プログラム、情報処理装置、情報処理システム、及び、情報処理方法 |

Families Citing this family (45)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US7298370B1 (en) * | 2005-04-16 | 2007-11-20 | Apple Inc. | Depth ordering of planes and displaying interconnects having an appearance indicating data characteristics |

| US8698844B1 (en) * | 2005-04-16 | 2014-04-15 | Apple Inc. | Processing cursor movements in a graphical user interface of a multimedia application |

| JP4508049B2 (ja) * | 2005-09-05 | 2010-07-21 | 株式会社日立製作所 | 360°画像撮影装置 |

| KR100762670B1 (ko) * | 2006-06-07 | 2007-10-01 | 삼성전자주식회사 | 스테레오 이미지로부터 디스패리티 맵을 생성하는 방법 및장치와 그를 위한 스테레오 매칭 방법 및 장치 |

| US9098647B2 (en) | 2008-03-10 | 2015-08-04 | Apple Inc. | Dynamic viewing of a three dimensional space |

| US8089479B2 (en) | 2008-04-11 | 2012-01-03 | Apple Inc. | Directing camera behavior in 3-D imaging system |

| BRPI0911016B1 (pt) | 2008-07-24 | 2021-01-05 | Koninklijke Philips N.V. | método de provisão de um sinal de imagem tridimensional, sistema de provisão de sinal de imagem tridimensional, sinal que contém uma imagem tridimensional, mídia de armazenamento, método de renderização de uma imagem tridimensional, sistema de renderização de imagem tridimensional para renderizar uma imagem tridimensional |

| JP4637942B2 (ja) * | 2008-09-30 | 2011-02-23 | 富士フイルム株式会社 | 3次元表示装置および方法並びにプログラム |

| US9619917B2 (en) | 2008-10-03 | 2017-04-11 | Apple Inc. | Depth of field for a camera in a media-editing application |

| WO2010095081A1 (en) | 2009-02-18 | 2010-08-26 | Koninklijke Philips Electronics N.V. | Transferring of 3d viewer metadata |

| CN102349304B (zh) * | 2009-03-30 | 2015-05-06 | 日本电气株式会社 | 图像显示装置、图像生成装置、图像显示方法、图像生成方法和存储程序的非暂时计算机可读介质 |

| KR20100135032A (ko) * | 2009-06-16 | 2010-12-24 | 삼성전자주식회사 | 2차원 영상의 3차원 영상 변환 장치 및 방법 |

| JP5415170B2 (ja) * | 2009-07-21 | 2014-02-12 | 富士フイルム株式会社 | 複眼撮像装置 |

| CN102165516A (zh) * | 2009-08-31 | 2011-08-24 | 松下电器产业株式会社 | 图像显示控制装置、图像显示控制方法及集成电路 |

| JP2011082919A (ja) * | 2009-10-09 | 2011-04-21 | Sony Corp | 画像処理装置および方法、並びにプログラム |

| JP2011139281A (ja) * | 2009-12-28 | 2011-07-14 | Sony Corp | 三次元画像生成装置、三次元画像表示装置、三次元画像生成方法およびプログラム |

| JP5227993B2 (ja) * | 2010-03-31 | 2013-07-03 | 株式会社東芝 | 視差画像生成装置、及びその方法 |

| JP5573379B2 (ja) * | 2010-06-07 | 2014-08-20 | ソニー株式会社 | 情報表示装置および表示画像制御方法 |

| CN102986231B (zh) * | 2010-06-11 | 2015-06-24 | 富士胶片株式会社 | 立体图像显示装置、立体成像装置及方法 |

| US8631047B2 (en) | 2010-06-15 | 2014-01-14 | Apple Inc. | Editing 3D video |

| JP4937390B2 (ja) * | 2010-08-24 | 2012-05-23 | 株式会社東芝 | 立体映像表示装置及び立体映像用眼鏡 |

| US8907983B2 (en) | 2010-10-07 | 2014-12-09 | Aria Glassworks, Inc. | System and method for transitioning between interface modes in virtual and augmented reality applications |

| JP2012090094A (ja) * | 2010-10-20 | 2012-05-10 | Sony Corp | 画像処理装置、画像処理方法、およびプログラム |

| JP5066244B2 (ja) * | 2010-10-29 | 2012-11-07 | 株式会社東芝 | 映像再生装置及び映像再生方法 |

| JP5594067B2 (ja) * | 2010-11-02 | 2014-09-24 | ソニー株式会社 | 画像処理装置および画像処理方法 |

| WO2012071466A2 (en) | 2010-11-24 | 2012-05-31 | Aria Glassworks, Inc. | System and method for acquiring virtual and augmented reality scenes by a user |

| WO2012071463A2 (en) | 2010-11-24 | 2012-05-31 | Aria Glassworks, Inc. | System and method for presenting virtual and augmented reality scenes to a user |

| US9041743B2 (en) * | 2010-11-24 | 2015-05-26 | Aria Glassworks, Inc. | System and method for presenting virtual and augmented reality scenes to a user |

| JP5050094B2 (ja) * | 2010-12-21 | 2012-10-17 | 株式会社東芝 | 映像処理装置及び映像処理方法 |

| US8953022B2 (en) | 2011-01-10 | 2015-02-10 | Aria Glassworks, Inc. | System and method for sharing virtual and augmented reality scenes between users and viewers |

| US9983685B2 (en) * | 2011-01-17 | 2018-05-29 | Mediatek Inc. | Electronic apparatuses and methods for providing a man-machine interface (MMI) |

| US9118970B2 (en) | 2011-03-02 | 2015-08-25 | Aria Glassworks, Inc. | System and method for embedding and viewing media files within a virtual and augmented reality scene |

| US9022864B2 (en) | 2011-06-03 | 2015-05-05 | Nintendo Co., Ltd. | Apparatus and method for controlling objects on a stereoscopic display |

| JP2012253690A (ja) * | 2011-06-06 | 2012-12-20 | Namco Bandai Games Inc | プログラム、情報記憶媒体及び画像生成システム |

| US9392251B2 (en) * | 2011-12-29 | 2016-07-12 | Samsung Electronics Co., Ltd. | Display apparatus, glasses apparatus and method for controlling depth |

| KR102131745B1 (ko) * | 2012-01-04 | 2020-07-08 | 인터디지탈 매디슨 페이튼트 홀딩스 | 3d 이미지 시퀀스의 처리 |

| US9286723B2 (en) * | 2012-04-04 | 2016-03-15 | Parag Tope | Method and system of discretizing three-dimensional space and objects for two-dimensional representation of space and objects |

| JP6099892B2 (ja) * | 2012-07-09 | 2017-03-22 | パナソニック インテレクチュアル プロパティ コーポレーション オブ アメリカPanasonic Intellectual Property Corporation of America | 映像表示装置 |

| US9626799B2 (en) | 2012-10-02 | 2017-04-18 | Aria Glassworks, Inc. | System and method for dynamically displaying multiple virtual and augmented reality scenes on a single display |

| JP6143469B2 (ja) * | 2013-01-17 | 2017-06-07 | キヤノン株式会社 | 情報処理装置、情報処理方法及びプログラム |

| US10769852B2 (en) | 2013-03-14 | 2020-09-08 | Aria Glassworks, Inc. | Method for simulating natural perception in virtual and augmented reality scenes |

| US9836879B2 (en) * | 2013-04-16 | 2017-12-05 | Autodesk, Inc. | Mesh skinning technique |

| US10977864B2 (en) | 2014-02-21 | 2021-04-13 | Dropbox, Inc. | Techniques for capturing and displaying partial motion in virtual or augmented reality scenes |

| JP7102173B2 (ja) * | 2018-03-09 | 2022-07-19 | キヤノン株式会社 | 情報処理装置、情報処理方法、及びプログラム |

| JP7341674B2 (ja) * | 2019-02-27 | 2023-09-11 | キヤノン株式会社 | 情報処理装置、情報処理方法及びプログラム |

Citations (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH0974573A (ja) * | 1995-06-29 | 1997-03-18 | Matsushita Electric Ind Co Ltd | 立体cg画像生成装置 |

| JP2001128195A (ja) * | 1999-10-29 | 2001-05-11 | Atr Ningen Joho Tsushin Kenkyusho:Kk | 立体画像補正装置、立体画像表示装置および立体画像補正処理プログラムを記録した記録媒体 |

| JP2002008040A (ja) * | 2000-06-16 | 2002-01-11 | Matsushita Electric Ind Co Ltd | 三次元情報検出装置及び三次元情報検出方法 |

| JP2004007396A (ja) * | 2002-03-27 | 2004-01-08 | Sanyo Electric Co Ltd | 立体画像処理方法および装置 |

Family Cites Families (24)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US5764231A (en) * | 1992-05-15 | 1998-06-09 | Eastman Kodak Company | Method and apparatus for creating geometric depth images using computer graphics |

| US5850352A (en) * | 1995-03-31 | 1998-12-15 | The Regents Of The University Of California | Immersive video, including video hypermosaicing to generate from multiple video views of a scene a three-dimensional video mosaic from which diverse virtual video scene images are synthesized, including panoramic, scene interactive and stereoscopic images |

| US6005607A (en) * | 1995-06-29 | 1999-12-21 | Matsushita Electric Industrial Co., Ltd. | Stereoscopic computer graphics image generating apparatus and stereoscopic TV apparatus |

| JPH11119303A (ja) * | 1997-10-20 | 1999-04-30 | Fujitsu Ltd | 監視システム及び監視方法 |

| US6710903B2 (en) * | 1998-07-29 | 2004-03-23 | Sony Corporation | Method and apparatus for formulating image data, method and apparatus for converting image data, method and apparatus for formulating holographic stereogram, recording medium and data transmitting method |

| US6366370B1 (en) * | 1998-12-30 | 2002-04-02 | Zebra Imaging, Inc. | Rendering methods for full parallax autostereoscopic displays |

| JP3634677B2 (ja) * | 1999-02-19 | 2005-03-30 | キヤノン株式会社 | 画像の補間方法、画像処理方法、画像表示方法、画像処理装置、画像表示装置、及びコンピュータプログラム記憶媒体 |

| US6771809B1 (en) * | 2000-04-28 | 2004-08-03 | Orametrix, Inc. | Method and system for registering data |

| GB2354389A (en) * | 1999-09-15 | 2001-03-21 | Sharp Kk | Stereo images with comfortable perceived depth |

| AU2001247302A1 (en) * | 2000-03-10 | 2001-09-24 | Sensormatic Electronics Corporation | Method and apparatus for object surveillance with a movable camera |

| US7085409B2 (en) * | 2000-10-18 | 2006-08-01 | Sarnoff Corporation | Method and apparatus for synthesizing new video and/or still imagery from a collection of real video and/or still imagery |

| US20020054211A1 (en) * | 2000-11-06 | 2002-05-09 | Edelson Steven D. | Surveillance video camera enhancement system |

| US6573912B1 (en) * | 2000-11-07 | 2003-06-03 | Zaxel Systems, Inc. | Internet system for virtual telepresence |

| WO2002065761A2 (en) * | 2001-02-12 | 2002-08-22 | Carnegie Mellon University | System and method for stabilizing rotational images |

| JP4075418B2 (ja) * | 2002-03-15 | 2008-04-16 | ソニー株式会社 | 画像処理装置及び画像処理方法、印刷物製造装置及び印刷物製造方法、並びに印刷物製造システム |

| US6853398B2 (en) * | 2002-06-21 | 2005-02-08 | Hewlett-Packard Development Company, L.P. | Method and system for real-time video communication within a virtual environment |

| US7466336B2 (en) * | 2002-09-05 | 2008-12-16 | Eastman Kodak Company | Camera and method for composing multi-perspective images |

| JP4228646B2 (ja) * | 2002-10-02 | 2009-02-25 | 株式会社セガ | 立体視画像生成方法および立体視画像生成装置 |

| US7251346B2 (en) * | 2002-11-19 | 2007-07-31 | Honda Motor Co., Ltd. | Moving object detection device, moving object detection method, and moving object detection program |

| AU2003298681A1 (en) * | 2002-11-21 | 2004-06-18 | Vision Iii Imaging, Inc. | Critical alignment of parallax images for autostereoscopic display |

| GB2413720B (en) * | 2003-03-14 | 2006-08-02 | British Broadcasting Corp | Video processing |

| EP1646006B1 (en) * | 2003-07-11 | 2010-03-10 | Toyota Jidosha Kabushiki Kaisha | Image processing device, image processing method, image processing program, and recording medium |

| US7643025B2 (en) * | 2003-09-30 | 2010-01-05 | Eric Belk Lange | Method and apparatus for applying stereoscopic imagery to three-dimensionally defined substrates |

| US7376250B2 (en) * | 2004-01-05 | 2008-05-20 | Honda Motor Co., Ltd. | Apparatus, method and program for moving object detection |

-

2004

- 2004-03-31 JP JP2004104148A patent/JP2005295004A/ja active Pending

-

2005

- 2005-03-15 CN CNA200510055045XA patent/CN1678085A/zh active Pending

- 2005-03-23 US US11/086,493 patent/US20050219239A1/en not_active Abandoned

Patent Citations (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH0974573A (ja) * | 1995-06-29 | 1997-03-18 | Matsushita Electric Ind Co Ltd | 立体cg画像生成装置 |

| JP2001128195A (ja) * | 1999-10-29 | 2001-05-11 | Atr Ningen Joho Tsushin Kenkyusho:Kk | 立体画像補正装置、立体画像表示装置および立体画像補正処理プログラムを記録した記録媒体 |

| JP2002008040A (ja) * | 2000-06-16 | 2002-01-11 | Matsushita Electric Ind Co Ltd | 三次元情報検出装置及び三次元情報検出方法 |

| JP2004007396A (ja) * | 2002-03-27 | 2004-01-08 | Sanyo Electric Co Ltd | 立体画像処理方法および装置 |

Cited By (13)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2010263542A (ja) * | 2009-05-11 | 2010-11-18 | National Institute Of Information & Communication Technology | 遠隔コミュニケーションシステム、制御装置、およびプログラム |

| CN102143371A (zh) * | 2010-01-28 | 2011-08-03 | 株式会社东芝 | 图像处理装置、三维显示装置和图像处理方法 |

| JP2011176823A (ja) * | 2010-01-28 | 2011-09-08 | Toshiba Corp | 画像処理装置、立体表示装置及び画像処理方法 |

| JP2011160302A (ja) * | 2010-02-02 | 2011-08-18 | Waseda Univ | 立体映像制作装置およびプログラム |

| CN102193705A (zh) * | 2010-03-02 | 2011-09-21 | 鸿富锦精密工业(深圳)有限公司 | 三维多媒体影像互动控制系统及方法 |

| JP2012129710A (ja) * | 2010-12-14 | 2012-07-05 | Canon Inc | 表示制御装置、表示制御方法及びプログラム |

| JP2012141819A (ja) * | 2010-12-29 | 2012-07-26 | Nintendo Co Ltd | 画像処理システム、画像処理プログラム、画像処理方法及び画像処理装置 |

| JP2012191366A (ja) * | 2011-03-09 | 2012-10-04 | Fujitsu Ltd | 生成装置および生成方法 |

| US9288473B2 (en) | 2011-03-09 | 2016-03-15 | Fujitsu Limited | Creating apparatus and creating method |

| JP2012203755A (ja) * | 2011-03-28 | 2012-10-22 | Toshiba Corp | 画像処理装置及び画像処理方法 |

| JP2012252583A (ja) * | 2011-06-03 | 2012-12-20 | Nintendo Co Ltd | 表示制御プログラム、表示装置、表示システム、および、表示制御方法 |

| JP2012252566A (ja) * | 2011-06-03 | 2012-12-20 | Nintendo Co Ltd | 情報処理プログラム、情報処理装置、情報処理システム、及び、情報処理方法 |

| US9049424B2 (en) | 2011-06-03 | 2015-06-02 | Nintendo Co., Ltd. | Recording medium storing display control program for controlling display capable of providing stereoscopic display, display system, display control method, and display |

Also Published As

| Publication number | Publication date |

|---|---|

| CN1678085A (zh) | 2005-10-05 |

| US20050219239A1 (en) | 2005-10-06 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP2005295004A (ja) | 立体画像処理方法および立体画像処理装置 | |

| US8577127B2 (en) | Method and apparatus for processing three-dimensional images | |

| EP2381691B1 (en) | Method and apparatus for processing three-dimensional images | |

| JP4903888B2 (ja) | 画像表示装置、画像表示方法、および画像補正方法 | |

| JP3802630B2 (ja) | 立体画像生成装置および立体画像生成方法 | |

| JP6407460B1 (ja) | 画像処理装置、画像処理方法およびプログラム | |

| US9106906B2 (en) | Image generation system, image generation method, and information storage medium | |

| JP3857988B2 (ja) | 立体画像処理方法および装置 | |

| JP2003284093A (ja) | 立体画像処理方法および装置 | |

| JP4270347B2 (ja) | 距離演算装置 | |

| WO2020166376A1 (ja) | 画像処理装置、画像処理方法、及び、プログラム | |

| WO2017062730A1 (en) | Presentation of a virtual reality scene from a series of images | |

| JP2003284095A (ja) | 立体画像処理方法および装置 | |

| JP5222407B2 (ja) | 画像表示装置、画像表示方法、および画像補正方法 | |

| JPH10172004A (ja) | 立体画像表示方法 | |

| GB2602841A (en) | Image generation system and method |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20070709 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20070731 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20070928 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20080304 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20080422 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20081028 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20081226 |

|

| A02 | Decision of refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A02 Effective date: 20090127 |