JP7073640B2 - 電子機器、感情情報取得システム、プログラム及び感情情報取得方法 - Google Patents

電子機器、感情情報取得システム、プログラム及び感情情報取得方法 Download PDFInfo

- Publication number

- JP7073640B2 JP7073640B2 JP2017123200A JP2017123200A JP7073640B2 JP 7073640 B2 JP7073640 B2 JP 7073640B2 JP 2017123200 A JP2017123200 A JP 2017123200A JP 2017123200 A JP2017123200 A JP 2017123200A JP 7073640 B2 JP7073640 B2 JP 7073640B2

- Authority

- JP

- Japan

- Prior art keywords

- information

- user

- voice

- acquired

- acquisition

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

Images

Classifications

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS OR SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING; SPEECH OR AUDIO CODING OR DECODING

- G10L25/00—Speech or voice analysis techniques not restricted to a single one of groups G10L15/00 - G10L21/00

- G10L25/48—Speech or voice analysis techniques not restricted to a single one of groups G10L15/00 - G10L21/00 specially adapted for particular use

- G10L25/51—Speech or voice analysis techniques not restricted to a single one of groups G10L15/00 - G10L21/00 specially adapted for particular use for comparison or discrimination

- G10L25/63—Speech or voice analysis techniques not restricted to a single one of groups G10L15/00 - G10L21/00 specially adapted for particular use for comparison or discrimination for estimating an emotional state

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/16—Sound input; Sound output

- G06F3/167—Audio in a user interface, e.g. using voice commands for navigating, audio feedback

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04M—TELEPHONIC COMMUNICATION

- H04M1/00—Substation equipment, e.g. for use by subscribers

- H04M1/72—Mobile telephones; Cordless telephones, i.e. devices for establishing wireless links to base stations without route selection

- H04M1/724—User interfaces specially adapted for cordless or mobile telephones

- H04M1/72403—User interfaces specially adapted for cordless or mobile telephones with means for local support of applications that increase the functionality

- H04M1/7243—User interfaces specially adapted for cordless or mobile telephones with means for local support of applications that increase the functionality with interactive means for internal management of messages

- H04M1/72433—User interfaces specially adapted for cordless or mobile telephones with means for local support of applications that increase the functionality with interactive means for internal management of messages for voice messaging, e.g. dictaphones

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04M—TELEPHONIC COMMUNICATION

- H04M1/00—Substation equipment, e.g. for use by subscribers

- H04M1/72—Mobile telephones; Cordless telephones, i.e. devices for establishing wireless links to base stations without route selection

- H04M1/724—User interfaces specially adapted for cordless or mobile telephones

- H04M1/72448—User interfaces specially adapted for cordless or mobile telephones with means for adapting the functionality of the device according to specific conditions

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04M—TELEPHONIC COMMUNICATION

- H04M1/00—Substation equipment, e.g. for use by subscribers

- H04M1/72—Mobile telephones; Cordless telephones, i.e. devices for establishing wireless links to base stations without route selection

- H04M1/724—User interfaces specially adapted for cordless or mobile telephones

- H04M1/72448—User interfaces specially adapted for cordless or mobile telephones with means for adapting the functionality of the device according to specific conditions

- H04M1/72451—User interfaces specially adapted for cordless or mobile telephones with means for adapting the functionality of the device according to specific conditions according to schedules, e.g. using calendar applications

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04M—TELEPHONIC COMMUNICATION

- H04M1/00—Substation equipment, e.g. for use by subscribers

- H04M1/72—Mobile telephones; Cordless telephones, i.e. devices for establishing wireless links to base stations without route selection

- H04M1/724—User interfaces specially adapted for cordless or mobile telephones

- H04M1/72448—User interfaces specially adapted for cordless or mobile telephones with means for adapting the functionality of the device according to specific conditions

- H04M1/72454—User interfaces specially adapted for cordless or mobile telephones with means for adapting the functionality of the device according to specific conditions according to context-related or environment-related conditions

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04R—LOUDSPEAKERS, MICROPHONES, GRAMOPHONE PICK-UPS OR LIKE ACOUSTIC ELECTROMECHANICAL TRANSDUCERS; DEAF-AID SETS; PUBLIC ADDRESS SYSTEMS

- H04R3/00—Circuits for transducers, loudspeakers or microphones

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04R—LOUDSPEAKERS, MICROPHONES, GRAMOPHONE PICK-UPS OR LIKE ACOUSTIC ELECTROMECHANICAL TRANSDUCERS; DEAF-AID SETS; PUBLIC ADDRESS SYSTEMS

- H04R2420/00—Details of connection covered by H04R, not provided for in its groups

- H04R2420/07—Applications of wireless loudspeakers or wireless microphones

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04R—LOUDSPEAKERS, MICROPHONES, GRAMOPHONE PICK-UPS OR LIKE ACOUSTIC ELECTROMECHANICAL TRANSDUCERS; DEAF-AID SETS; PUBLIC ADDRESS SYSTEMS

- H04R2499/00—Aspects covered by H04R or H04S not otherwise provided for in their subgroups

- H04R2499/10—General applications

- H04R2499/11—Transducers incorporated or for use in hand-held devices, e.g. mobile phones, PDA's, camera's

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04R—LOUDSPEAKERS, MICROPHONES, GRAMOPHONE PICK-UPS OR LIKE ACOUSTIC ELECTROMECHANICAL TRANSDUCERS; DEAF-AID SETS; PUBLIC ADDRESS SYSTEMS

- H04R2499/00—Aspects covered by H04R or H04S not otherwise provided for in their subgroups

- H04R2499/10—General applications

- H04R2499/15—Transducers incorporated in visual displaying devices, e.g. televisions, computer displays, laptops

Description

請求項4に記載の発明の電子機器は、ユーザの音声を入力して音声情報に変換する音声入力手段と、前記音声入力手段により変換された音声情報に基づき感情情報を取得する第1取得手段と、ユーザに関する情報又は環境情報を取得する第2取得手段と、を備え、前記第1取得手段は、前記第2取得手段により取得されたユーザに関する情報又は環境情報に基づき決定される所定のタイミング、当該タイミングよりも所定時間前、及び当該タイミングよりも所定時間後の各音声情報からそれぞれ感情情報を取得し、取得された各感情情報に基づき総合的な感情情報を取得することを特徴とする。

まず、図1を参照して、本実施形態の構成を説明する。図1は、本実施形態の感情情報取得システム100の概略構成図である。

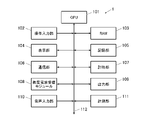

次いで、スマートウォッチ1の内部構成を説明する。図2に、スマートウォッチ1の内部構成を示す。

これらのプログラムは、コンピュータ読み取り可能なプログラムコードの形態で記憶部105に格納されている。CPU101は、当該プログラムコードに従った動作を逐次実行する。

次いで、スマートフォン2の内部構成を説明する。図3に、スマートフォン2の内部構成を示す。

本実施形態のスマートウォッチ1により行われる感情情報取得処理について、図4を参照して説明する。図4は、本実施形態に係る感情情報取得処理の一例を示すフローチャートである。

以上のようにして、感情情報取得処理を行う。

また、同様に、上記ステップS105の処理にて判定する時間の長さを、環境情報が満たした条件やユーザに関する情報が達成した目標に応じて、変化させるものとしても良い。

本実施形態によれば、スマートウォッチ1が、ユーザの音声を入力して音声情報に変換する音声入力部110と、音声入力部110により変換された音声情報に基づき感情情報を取得し、ユーザに関する情報又は環境情報を取得するCPU101とを備え、CPU101が、取得されたユーザに関する情報又は環境情報に基づき決定される所定のタイミングの音声情報から感情情報を取得するので、ユーザの感情が変化する可能性の高いタイミングで感情情報を取得できるため、より正確な感情情報を取得することができる。

上記した実施形態の感情情報取得システム100の変形例について説明する。以下に説明する以外の点は、上記実施形態の感情情報取得システム100と同様に構成されているものとする。

以上のようにして感情情報取得処理を行う。

以上、変形例によれば、CPU101が、あらかじめ音声情報の取得を開始しておき、ユーザに関する情報又は環境情報が所定の条件を満たしたと判定された時の音声情報から感情情報を取得するので、上記実施形態において得られる技術的効果のみならず、感情情報の取得に適した音声情報をより確実に取得することができる。

さらに、変形例によれば、ユーザに対する報知を行うことなく感情情報を取得した場合には、当該報知がなされることによってユーザの感情が僅かに変化してしまうことを防止でき、より正確な感情情報を取得することができる。

なお、上記実施形態及び変形例における記述は、本発明に係る好適な感情情報取得システムの一例であり、これに限定されるものではない。

また、自動車等の移動手段に搭載される電子機器が上記感情情報取得処理を行うものとしても良い。この場合には、例えば、取得された感情情報に基づいて、ユーザに対して安全運転を促す通知等を行うものとしても良い。

以下に、この出願の願書に最初に添付した特許請求の範囲に記載した発明を付記する。付記に記載した請求項の項番は、この出願の願書に最初に添付した特許請求の範囲の通りである。

〔付記〕

<請求項1>

ユーザの音声を入力して音声情報に変換する音声入力手段と、

前記音声入力手段により変換された音声情報に基づき感情情報を取得する第1取得手段と、

ユーザに関する情報又は環境情報を取得する第2取得手段と、

を備え、

前記第1取得手段は、前記第2取得手段により取得されたユーザに関する情報又は環境情報に基づき決定される所定のタイミングの音声情報から感情情報を取得することを特徴とする電子機器。

<請求項2>

前記第2取得手段により取得されたユーザに関する情報又は環境情報に基づき前記音声入力手段をオン又はオフに設定する音声入力制御手段を備えることを特徴とする請求項1に記載の電子機器。

<請求項3>

前記第1取得手段は、前記第2取得手段により取得されたユーザに関する情報又は環境情報に基づき、あらかじめ設定された条件を満たしたと判定されたタイミングに応じて音声情報から感情情報を取得することを特徴とする請求項1又は2に記載の電子機器。

<請求項4>

前記第2取得手段は、所定期間ごとにユーザに関する情報を取得し、

前記第1取得手段は、前記第2取得手段により取得されたユーザに関する情報が、過去に取得されたユーザに関する情報と異なると判定されたタイミングに応じて音声情報から感情情報を取得することを特徴とする請求項1から3のいずれか一項に記載の電子機器。

<請求項5>

前記第2取得手段により取得されたユーザに関する情報又は環境情報に基づき、ユーザに対して前記音声入力手段への音声入力を促す報知を行う報知手段を備え、

前記第1取得手段は、前記報知手段により報知が行われたタイミングに応じて音声情報から感情情報を取得することを特徴とする請求項1から3のいずれか一項に記載の電子機器。

<請求項6>

前記第1取得手段は、前記第2取得手段により取得されたユーザに関する情報又は環境情報に基づき決定される所定のタイミング、当該タイミングよりも所定時間前、及び当該タイミングよりも所定時間後の各音声情報からそれぞれ感情情報を取得し、取得された各感情情報に基づき総合的な感情情報を取得することを特徴とする請求項1から5のいずれか一項に記載の電子機器。

<請求項7>

端末装置とネットワークを介して前記端末装置と接続されるサーバ装置からなる感情情報取得システムであって、

ユーザの音声を入力して音声情報に変換する音声入力手段と、

前記音声入力手段により変換された音声情報に基づき感情情報を取得する第1取得手段と、

ユーザに関する情報又は環境情報を取得する第2取得手段と、

を備え、

前記第1取得手段は、前記第2取得手段により取得されたユーザに関する情報又は環境情報に基づき決定される所定のタイミングの音声情報から感情情報を取得することを特徴とする感情情報取得システム。

<請求項8>

コンピュータを、

ユーザの音声を入力して音声情報に変換する音声入力手段、

前記音声入力手段により変換された音声情報に基づき感情情報を取得する第1取得手段、

ユーザに関する情報又は環境情報を取得する第2取得手段、

として機能させるためのプログラムであって、

前記第1取得手段は、前記第2取得手段により取得されたユーザに関する情報又は環境情報に基づき決定される所定のタイミングの音声情報から感情情報を取得することを特徴とするプログラム。

<請求項9>

ユーザの音声を入力して音声情報に変換する音声入力工程と、

変換された音声情報に基づき感情情報を取得する第1取得工程と、

ユーザに関する情報又は環境情報を取得する第2取得工程と、

を有し、

前記第1取得工程において、前記第2取得工程で取得されたユーザに関する情報又は環境情報に基づき決定される所定のタイミングの音声情報から感情情報を取得することを特徴とする感情情報取得方法。

100 感情情報取得システム

101 CPU(第1取得手段、第2取得手段、音声入力制御手段、報知手段)

108 音声入力部(音声入力手段)

Claims (16)

- ユーザの音声を入力して音声情報に変換する音声入力手段と、

前記音声入力手段により変換された音声情報に基づき感情情報を取得する第1取得手段と、

所定期間ごとにユーザに関する情報を取得する第2取得手段と、

を備え、

前記第1取得手段は、前記第2取得手段により取得されたユーザに関する情報が、過去に取得されたユーザに関する情報と異なると判定された場合に、前記感情情報を新たに取得することを特徴とする電子機器。 - 前記第1取得手段は、前記第2取得手段により取得されたユーザに関する情報が、過去に取得されたユーザに関する情報と異なると判定された場合に、前記音声情報を新たに取得し、取得された音声情報から前記感情情報を取得することを特徴とする請求項1に記載の電子機器。

- 前記第2取得手段により取得されたユーザに関する情報に基づき前記音声入力手段をオン又はオフに設定する音声入力制御手段を備えることを特徴とする請求項1又は2に記載の電子機器。

- ユーザの音声を入力して音声情報に変換する音声入力手段と、

前記音声入力手段により変換された音声情報に基づき感情情報を取得する第1取得手段と、

ユーザに関する情報又は環境情報を取得する第2取得手段と、

を備え、

前記第1取得手段は、前記第2取得手段により取得されたユーザに関する情報又は環境情報に基づき、決定される所定のタイミング、当該タイミングよりも所定時間前、及び当該タイミングよりも所定時間後の各音声情報からそれぞれ感情情報を取得し、取得された各感情情報に基づき総合的な感情情報を取得することを特徴とする電子機器。 - 前記第2取得手段により取得されたユーザに関する情報又は環境情報に基づき、決定される所定のタイミング、当該タイミングよりも所定時間前、及び当該タイミングよりも所定時間後の各音声情報からそれぞれ感情情報を取得する場合は、あらかじめ前記音声入力手段をオンに設定し、終了操作が入力された場合に前記音声入力手段をオフに設定する音声入力制御手段を備えることを特徴とする請求項4に記載の電子機器。

- 前記第1取得手段は、前記第2取得手段により取得されたユーザに関する情報又は環境情報に基づき、あらかじめ設定された条件を満たしたと判定されたタイミングに応じて音声情報から感情情報を取得することを特徴とする請求項5に記載の電子機器。

- 前記第2取得手段は、所定期間ごとにユーザに関する情報を取得し、

前記第1取得手段は、前記第2取得手段により取得されたユーザに関する情報が、過去に取得されたユーザに関する情報と異なると判定されたタイミングに応じて音声情報から感情情報を取得することを特徴とする請求項5又は6に記載の電子機器。 - 前記第2取得手段により取得されたユーザに関する情報又は環境情報に基づき、ユーザに対して前記音声入力手段への音声入力を促す報知を行う報知手段を備え、

前記第1取得手段は、前記報知手段により報知が行われたタイミングに応じて音声情報から感情情報を取得することを特徴とする請求項5から7のいずれか一項に記載の電子機器。 - 前記ユーザに関する情報は、ユーザごとに異なる情報であり、移動距離、移動速度などの情報を含み、

前記第2取得手段は、外部環境に基づく情報である環境情報を更に取得し、

前記環境情報は、現在時刻、気温、湿度、気圧、高度、方位、潮汐、これらに基づき導出される各種情報の何れかを含むことを特徴とする請求項1から8のいずれか一項に記載の電子機器。 - 前記第2取得手段は、ユーザに関する情報及び環境情報を取得することを特徴とする請求項1又は4に記載の電子機器。

- 端末装置とネットワークを介して前記端末装置と接続されるサーバ装置からなる感情情報取得システムであって、

ユーザの音声を入力して音声情報に変換する音声入力手段と、

前記音声入力手段により変換された音声情報に基づき感情情報を取得する第1取得手段と、

所定期間ごとにユーザに関する情報を取得する第2取得手段と、

を備え、

前記第1取得手段は、前記第2取得手段により取得されたユーザに関する情報が、過去に取得されたユーザに関する情報と異なると判定された場合に、前記感情情報を新たに取得することを特徴とする感情情報取得システム。 - 端末装置とネットワークを介して前記端末装置と接続されるサーバ装置からなる感情情報取得システムであって、

ユーザの音声を入力して音声情報に変換する音声入力手段と、

前記音声入力手段により変換された音声情報に基づき感情情報を取得する第1取得手段と、

ユーザに関する情報又は環境情報を取得する第2取得手段と、

を備え、

前記第1取得手段は、前記第2取得手段により取得されたユーザに関する情報又は環境情報に基づき決定される所定のタイミング、当該タイミングよりも所定時間前、及び当該タイミングよりも所定時間後の各音声情報からそれぞれ感情情報を取得し、取得された各感情情報に基づき総合的な感情情報を取得することを特徴とする感情情報取得システム。 - コンピュータを、

ユーザの音声を入力して音声情報に変換する音声入力手段、

前記音声入力手段により変換された音声情報に基づき感情情報を取得する第1取得手段、

所定期間ごとにユーザに関する情報を取得する第2取得手段、

として機能させるためのプログラムであって、

前記第1取得手段は、前記第2取得手段により取得されたユーザに関する情報が、過去に取得されたユーザに関する情報と異なると判定された場合に、前記感情情報を新たに取得することを特徴とするプログラム。 - コンピュータを、

ユーザの音声を入力して音声情報に変換する音声入力手段、

前記音声入力手段により変換された音声情報に基づき感情情報を取得する第1取得手段

、

ユーザに関する情報又は環境情報を取得する第2取得手段、

として機能させるためのプログラムであって、

前記第1取得手段は、前記第1取得手段は、前記第2取得手段により取得されたユーザに関する情報又は環境情報に基づき決定される所定のタイミング、当該タイミングよりも所定時間前、及び当該タイミングよりも所定時間後の各音声情報からそれぞれ感情情報を取得し、取得された各感情情報に基づき総合的な感情情報を取得することを特徴とするプログラム。 - ユーザの音声を入力して音声情報に変換する音声入力工程と、

変換された音声情報に基づき感情情報を取得する第1取得工程と、

所定期間ごとにユーザに関する情報を取得する第2取得工程と、

を有し、

前記第1取得工程は、前記第2取得工程により取得されたユーザに関する情報が、過去に取得されたユーザに関する情報と異なると判定された場合に、前記感情情報を新たに取得することを特徴とする感情情報取得方法。 - ユーザの音声を入力して音声情報に変換する音声入力工程と、

変換された音声情報に基づき感情情報を取得する第1取得工程と、

ユーザに関する情報又は環境情報を取得する第2取得工程と、

を有し、

前記第1取得工程において、前記第2取得工程により取得されたユーザに関する情報又は環境情報に基づき決定される所定のタイミング、当該タイミングよりも所定時間前、及び当該タイミングよりも所定時間後の各音声情報からそれぞれ感情情報を取得し、取得された各感情情報に基づき総合的な感情情報を取得することを特徴とする感情情報取得方法。

Priority Applications (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2017123200A JP7073640B2 (ja) | 2017-06-23 | 2017-06-23 | 電子機器、感情情報取得システム、プログラム及び感情情報取得方法 |

| US16/015,016 US10580433B2 (en) | 2017-06-23 | 2018-06-21 | Electronic device, emotion information obtaining system, storage medium, and emotion information obtaining method |

| CN201810649657.9A CN109147824A (zh) | 2017-06-23 | 2018-06-22 | 电子设备、情绪信息取得系统及取得方法、以及存储介质 |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2017123200A JP7073640B2 (ja) | 2017-06-23 | 2017-06-23 | 電子機器、感情情報取得システム、プログラム及び感情情報取得方法 |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2019008113A JP2019008113A (ja) | 2019-01-17 |

| JP2019008113A5 JP2019008113A5 (ja) | 2020-07-02 |

| JP7073640B2 true JP7073640B2 (ja) | 2022-05-24 |

Family

ID=64692733

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2017123200A Active JP7073640B2 (ja) | 2017-06-23 | 2017-06-23 | 電子機器、感情情報取得システム、プログラム及び感情情報取得方法 |

Country Status (3)

| Country | Link |

|---|---|

| US (1) | US10580433B2 (ja) |

| JP (1) | JP7073640B2 (ja) |

| CN (1) | CN109147824A (ja) |

Families Citing this family (3)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP7073640B2 (ja) * | 2017-06-23 | 2022-05-24 | カシオ計算機株式会社 | 電子機器、感情情報取得システム、プログラム及び感情情報取得方法 |

| KR102348693B1 (ko) * | 2017-10-24 | 2022-01-10 | 삼성전자주식회사 | 어플리케이션 프로그램을 제어하는 전자 장치 및 그 제어 방법 |

| US10839201B2 (en) | 2018-11-09 | 2020-11-17 | Akili Interactive Labs, Inc. | Facial expression detection for screening and treatment of affective disorders |

Citations (7)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2005185630A (ja) | 2003-12-26 | 2005-07-14 | Casio Comput Co Ltd | 養育補助装置、感情緩和制御装置及びプログラム |

| JP2007525897A (ja) | 2004-02-17 | 2007-09-06 | ボイス シグナル テクノロジーズ インコーポレイテッド | マルチモーダル埋め込み型インタフェースの交換可能なカスタマイズ用の方法及び装置 |

| JP2009042671A (ja) | 2007-08-10 | 2009-02-26 | Kao Corp | 感情を判定するための方法 |

| JP2014123239A (ja) | 2012-12-21 | 2014-07-03 | Hitachi Ltd | 渋滞情報配信システム、サーバ、車載端末、及びプログラム |

| JP2014219594A (ja) | 2013-05-09 | 2014-11-20 | ソフトバンクモバイル株式会社 | 会話処理システム及びプログラム |

| JP2016012341A (ja) | 2014-06-05 | 2016-01-21 | ソフトバンク株式会社 | 行動制御システム、システム及びプログラム |

| JP2018147452A (ja) | 2017-03-09 | 2018-09-20 | 岩崎通信機株式会社 | ドアシステム、およびドアシステムを用いた監視方法 |

Family Cites Families (67)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US5765134A (en) * | 1995-02-15 | 1998-06-09 | Kehoe; Thomas David | Method to electronically alter a speaker's emotional state and improve the performance of public speaking |

| JPH09292964A (ja) | 1996-04-24 | 1997-11-11 | Sanyo Electric Co Ltd | オンライン情報システム |

| JP2003110703A (ja) | 2001-10-02 | 2003-04-11 | Sony Corp | 情報通信システム、および情報通信方法、並びにコンピュータ・プログラム |

| EP1300831B1 (en) * | 2001-10-05 | 2005-12-07 | Sony Deutschland GmbH | Method for detecting emotions involving subspace specialists |

| US6959080B2 (en) * | 2002-09-27 | 2005-10-25 | Rockwell Electronic Commerce Technologies, Llc | Method selecting actions or phases for an agent by analyzing conversation content and emotional inflection |

| JP3984207B2 (ja) * | 2003-09-04 | 2007-10-03 | 株式会社東芝 | 音声認識評価装置、音声認識評価方法、及び音声認識評価プログラム |

| US8214214B2 (en) * | 2004-12-03 | 2012-07-03 | Phoenix Solutions, Inc. | Emotion detection device and method for use in distributed systems |

| US7912720B1 (en) * | 2005-07-20 | 2011-03-22 | At&T Intellectual Property Ii, L.P. | System and method for building emotional machines |

| JP2007041988A (ja) * | 2005-08-05 | 2007-02-15 | Sony Corp | 情報処理装置および方法、並びにプログラム |

| US8150692B2 (en) * | 2006-05-18 | 2012-04-03 | Nuance Communications, Inc. | Method and apparatus for recognizing a user personality trait based on a number of compound words used by the user |

| US7893342B2 (en) * | 2006-09-08 | 2011-02-22 | Panasonic Corporation | Information processing terminal and music information generating program |

| US8571853B2 (en) * | 2007-02-11 | 2013-10-29 | Nice Systems Ltd. | Method and system for laughter detection |

| US8965762B2 (en) * | 2007-02-16 | 2015-02-24 | Industrial Technology Research Institute | Bimodal emotion recognition method and system utilizing a support vector machine |

| SG151123A1 (en) * | 2007-09-13 | 2009-04-30 | St Electronics Training & Simu | A decision analysis system |

| JP2009265852A (ja) | 2008-04-23 | 2009-11-12 | Sharp Corp | 回答記憶携帯端末及び回答記憶方法 |

| US20100041958A1 (en) * | 2008-04-24 | 2010-02-18 | Searete Llc | Computational system and method for memory modification |

| US8259992B2 (en) * | 2008-06-13 | 2012-09-04 | International Business Machines Corporation | Multiple audio/video data stream simulation method and system |

| JP4900739B2 (ja) * | 2009-09-04 | 2012-03-21 | カシオ計算機株式会社 | 電子写真立て、その制御方法及びプログラム |

| US8417524B2 (en) * | 2010-02-11 | 2013-04-09 | International Business Machines Corporation | Analysis of the temporal evolution of emotions in an audio interaction in a service delivery environment |

| US20110282662A1 (en) * | 2010-05-11 | 2011-11-17 | Seiko Epson Corporation | Customer Service Data Recording Device, Customer Service Data Recording Method, and Recording Medium |

| WO2012003523A1 (en) * | 2010-07-06 | 2012-01-12 | Rmit University | Emotional and/or psychiatric state detection |

| WO2012089906A1 (en) * | 2010-12-30 | 2012-07-05 | Nokia Corporation | Method, apparatus and computer program product for emotion detection |

| US20120209606A1 (en) * | 2011-02-14 | 2012-08-16 | Nice Systems Ltd. | Method and apparatus for information extraction from interactions |

| WO2012120656A1 (ja) * | 2011-03-08 | 2012-09-13 | 富士通株式会社 | 通話支援装置、通話支援方法 |

| US9728189B2 (en) * | 2011-04-26 | 2017-08-08 | Nec Corporation | Input auxiliary apparatus, input auxiliary method, and program |

| US9418661B2 (en) * | 2011-05-12 | 2016-08-16 | Johnson Controls Technology Company | Vehicle voice recognition systems and methods |

| CN102332263B (zh) * | 2011-09-23 | 2012-11-07 | 浙江大学 | 一种基于近邻原则合成情感模型的说话人识别方法 |

| JP5772448B2 (ja) * | 2011-09-27 | 2015-09-02 | 富士ゼロックス株式会社 | 音声解析システムおよび音声解析装置 |

| KR101850026B1 (ko) * | 2011-11-07 | 2018-04-24 | 한국전자통신연구원 | 음성 인식 단문 메시지 서비스 기반의 사용자 맞춤 광고 장치, 및 음성 인식 단문 메시지 서비스 기반의 사용자 맞춤 광고 노출 방법 |

| CN103543979A (zh) * | 2012-07-17 | 2014-01-29 | 联想(北京)有限公司 | 一种输出语音的方法、语音交互的方法及电子设备 |

| US9031293B2 (en) * | 2012-10-19 | 2015-05-12 | Sony Computer Entertainment Inc. | Multi-modal sensor based emotion recognition and emotional interface |

| US9020822B2 (en) * | 2012-10-19 | 2015-04-28 | Sony Computer Entertainment Inc. | Emotion recognition using auditory attention cues extracted from users voice |

| TWI489451B (zh) * | 2012-12-13 | 2015-06-21 | Univ Nat Chiao Tung | 基於語音情感辨識之音樂播放系統及其方法 |

| KR102050897B1 (ko) * | 2013-02-07 | 2019-12-02 | 삼성전자주식회사 | 음성 대화 기능을 구비한 휴대 단말기 및 이의 음성 대화 방법 |

| US9472207B2 (en) * | 2013-06-20 | 2016-10-18 | Suhas Gondi | Portable assistive device for combating autism spectrum disorders |

| US20150154002A1 (en) * | 2013-12-04 | 2015-06-04 | Google Inc. | User interface customization based on speaker characteristics |

| US20150287403A1 (en) * | 2014-04-07 | 2015-10-08 | Neta Holzer Zaslansky | Device, system, and method of automatically generating an animated content-item |

| US9412393B2 (en) * | 2014-04-24 | 2016-08-09 | International Business Machines Corporation | Speech effectiveness rating |

| US9685174B2 (en) * | 2014-05-02 | 2017-06-20 | The Regents Of The University Of Michigan | Mood monitoring of bipolar disorder using speech analysis |

| EP3147798A4 (en) * | 2014-05-22 | 2018-01-17 | Sony Corporation | Information processing device, information processing method, and program |

| US9652678B2 (en) * | 2014-05-23 | 2017-05-16 | Samsung Electronics Co., Ltd. | Method and device for reproducing content |

| CN105615902A (zh) * | 2014-11-06 | 2016-06-01 | 北京三星通信技术研究有限公司 | 情绪监控方法和装置 |

| US9533687B2 (en) * | 2014-12-30 | 2017-01-03 | Tk Holdings Inc. | Occupant monitoring systems and methods |

| US9916846B2 (en) * | 2015-02-10 | 2018-03-13 | Nice Ltd. | Method and system for speech detection |

| EP3259754B1 (en) * | 2015-02-16 | 2022-06-15 | Samsung Electronics Co., Ltd. | Method and device for providing information |

| CN106161990B (zh) * | 2015-04-28 | 2019-11-12 | 腾讯科技(北京)有限公司 | 一种图像处理方法和装置 |

| WO2016195474A1 (en) * | 2015-05-29 | 2016-12-08 | Charles Vincent Albert | Method for analysing comprehensive state of a subject |

| KR102344063B1 (ko) * | 2015-06-29 | 2021-12-28 | 엘지전자 주식회사 | 이동 단말기 |

| KR20170027999A (ko) * | 2015-09-03 | 2017-03-13 | 삼성전자주식회사 | 사용자 단말 장치, 시스템 및 그 제어 방법 |

| WO2017064891A1 (ja) * | 2015-10-13 | 2017-04-20 | ソニー株式会社 | 情報処理システム、情報処理方法、および記憶媒体 |

| KR102453603B1 (ko) * | 2015-11-10 | 2022-10-12 | 삼성전자주식회사 | 전자 장치 및 그 제어 방법 |

| US10755704B2 (en) * | 2015-11-17 | 2020-08-25 | Sony Interactive Entertainment Inc. | Information processing apparatus |

| CN105334743B (zh) * | 2015-11-18 | 2018-10-26 | 深圳创维-Rgb电子有限公司 | 一种基于情感识别的智能家居控制方法及其系统 |

| CN105726045A (zh) * | 2016-01-28 | 2016-07-06 | 惠州Tcl移动通信有限公司 | 一种情绪监控方法及其移动终端 |

| US9711056B1 (en) * | 2016-03-14 | 2017-07-18 | Fuvi Cognitive Network Corp. | Apparatus, method, and system of building and processing personal emotion-based computer readable cognitive sensory memory and cognitive insights for enhancing memorization and decision making skills |

| US9836055B1 (en) * | 2016-06-03 | 2017-12-05 | Internaitonal Business Machines Corporation | Mobile audio input device controller |

| US20170351330A1 (en) * | 2016-06-06 | 2017-12-07 | John C. Gordon | Communicating Information Via A Computer-Implemented Agent |

| US10726836B2 (en) * | 2016-08-12 | 2020-07-28 | Kt Corporation | Providing audio and video feedback with character based on voice command |

| US10074368B2 (en) * | 2016-08-17 | 2018-09-11 | International Business Machines Corporation | Personalized situation awareness using human emotions and incident properties |

| CN106528859A (zh) * | 2016-11-30 | 2017-03-22 | 英华达(南京)科技有限公司 | 一种数据推送系统及方法 |

| US11086391B2 (en) * | 2016-11-30 | 2021-08-10 | At&T Intellectual Property I, L.P. | Methods, and devices for generating a user experience based on the stored user information |

| CN106843458B (zh) * | 2016-12-12 | 2021-05-25 | 北京光年无限科技有限公司 | 一种用于智能机器人的人机交互方法及装置 |

| US11291796B2 (en) * | 2016-12-29 | 2022-04-05 | Huawei Technologies Co., Ltd | Method and apparatus for adjusting user emotion |

| CN107053191B (zh) * | 2016-12-31 | 2020-05-08 | 华为技术有限公司 | 一种机器人,服务器及人机互动方法 |

| JP6922284B2 (ja) * | 2017-03-15 | 2021-08-18 | 富士フイルムビジネスイノベーション株式会社 | 情報処理装置及びプログラム |

| KR102363794B1 (ko) * | 2017-03-31 | 2022-02-16 | 삼성전자주식회사 | 정보 제공 방법 및 이를 지원하는 전자 장치 |

| JP7073640B2 (ja) * | 2017-06-23 | 2022-05-24 | カシオ計算機株式会社 | 電子機器、感情情報取得システム、プログラム及び感情情報取得方法 |

-

2017

- 2017-06-23 JP JP2017123200A patent/JP7073640B2/ja active Active

-

2018

- 2018-06-21 US US16/015,016 patent/US10580433B2/en active Active

- 2018-06-22 CN CN201810649657.9A patent/CN109147824A/zh active Pending

Patent Citations (7)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2005185630A (ja) | 2003-12-26 | 2005-07-14 | Casio Comput Co Ltd | 養育補助装置、感情緩和制御装置及びプログラム |

| JP2007525897A (ja) | 2004-02-17 | 2007-09-06 | ボイス シグナル テクノロジーズ インコーポレイテッド | マルチモーダル埋め込み型インタフェースの交換可能なカスタマイズ用の方法及び装置 |

| JP2009042671A (ja) | 2007-08-10 | 2009-02-26 | Kao Corp | 感情を判定するための方法 |

| JP2014123239A (ja) | 2012-12-21 | 2014-07-03 | Hitachi Ltd | 渋滞情報配信システム、サーバ、車載端末、及びプログラム |

| JP2014219594A (ja) | 2013-05-09 | 2014-11-20 | ソフトバンクモバイル株式会社 | 会話処理システム及びプログラム |

| JP2016012341A (ja) | 2014-06-05 | 2016-01-21 | ソフトバンク株式会社 | 行動制御システム、システム及びプログラム |

| JP2018147452A (ja) | 2017-03-09 | 2018-09-20 | 岩崎通信機株式会社 | ドアシステム、およびドアシステムを用いた監視方法 |

Also Published As

| Publication number | Publication date |

|---|---|

| US20180374498A1 (en) | 2018-12-27 |

| CN109147824A (zh) | 2019-01-04 |

| US10580433B2 (en) | 2020-03-03 |

| JP2019008113A (ja) | 2019-01-17 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| CN108595275B (zh) | 一种提示信息推送的方法及终端 | |

| JP7073640B2 (ja) | 電子機器、感情情報取得システム、プログラム及び感情情報取得方法 | |

| US8949745B2 (en) | Device and method for selection of options by motion gestures | |

| US20160321901A1 (en) | Wristband and application to allow one person to monitor another | |

| US10408629B2 (en) | Navigation system, client terminal device, control method, and storage medium | |

| US20170097816A1 (en) | Context-based applications for mobile devices | |

| US9445230B1 (en) | Automated arrival notifications | |

| CN107846518B (zh) | 一种导航状态切换方法、移动终端及计算机可读存储介质 | |

| CN107608855B (zh) | 提醒方法及移动终端 | |

| CN108051010B (zh) | 确定到达目的地的时间的方法及移动终端 | |

| CN105336107A (zh) | 震动报警方法及装置 | |

| US20160011662A1 (en) | Electronic device, method, and computer program product | |

| EP3382343B1 (en) | Electronic apparatus, position specifying system, position specifying method, and program | |

| JP5915803B2 (ja) | 情報処理装置、混雑度マップ生成装置、情報処理方法、プログラム、及び記録媒体 | |

| JP2015122609A (ja) | 電子機器 | |

| US20210182781A1 (en) | Information processing apparatus, information processing method, and program | |

| JP5853088B2 (ja) | 情報処理装置、プログラム及び方法 | |

| EP3163928A1 (en) | Communication apparatus, communication method and program | |

| JP2009230250A (ja) | 監視装置、監視方法及びコンピュータプログラム | |

| KR101564347B1 (ko) | 긴급 구조 요청 단말 및 긴급 구조 요청 방법 | |

| US9143893B2 (en) | Communication apparatus and control method therefor | |

| CN109086448B (zh) | 一种基于性别特征信息的语音搜题方法及家教设备 | |

| JP6565132B2 (ja) | 情報処理装置、情報処理方法及びプログラム | |

| EP2999298B1 (en) | Mobile information processing device, information processing system, and information processing method | |

| CN112435441B (zh) | 睡眠检测方法和可穿戴电子设备 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20200520 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20200520 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20210317 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20210330 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20210506 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20210803 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20210913 |

|

| A02 | Decision of refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A02 Effective date: 20220104 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20220207 |

|

| C60 | Trial request (containing other claim documents, opposition documents) |

Free format text: JAPANESE INTERMEDIATE CODE: C60 Effective date: 20220207 |

|

| A911 | Transfer to examiner for re-examination before appeal (zenchi) |

Free format text: JAPANESE INTERMEDIATE CODE: A911 Effective date: 20220216 |

|

| C21 | Notice of transfer of a case for reconsideration by examiners before appeal proceedings |

Free format text: JAPANESE INTERMEDIATE CODE: C21 Effective date: 20220222 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20220412 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20220425 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 7073640 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 |