JP6201615B2 - 音響装置、音響システム、音響処理方法及び音響処理プログラム - Google Patents

音響装置、音響システム、音響処理方法及び音響処理プログラム Download PDFInfo

- Publication number

- JP6201615B2 JP6201615B2 JP2013215111A JP2013215111A JP6201615B2 JP 6201615 B2 JP6201615 B2 JP 6201615B2 JP 2013215111 A JP2013215111 A JP 2013215111A JP 2013215111 A JP2013215111 A JP 2013215111A JP 6201615 B2 JP6201615 B2 JP 6201615B2

- Authority

- JP

- Japan

- Prior art keywords

- user

- gaze

- time

- target object

- sound source

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Expired - Fee Related

Links

Images

Classifications

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04S—STEREOPHONIC SYSTEMS

- H04S7/00—Indicating arrangements; Control arrangements, e.g. balance control

- H04S7/30—Control circuits for electronic adaptation of the sound field

- H04S7/302—Electronic adaptation of stereophonic sound system to listener position or orientation

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F1/00—Details not covered by groups G06F3/00 - G06F13/00 and G06F21/00

- G06F1/16—Constructional details or arrangements

- G06F1/1613—Constructional details or arrangements for portable computers

- G06F1/1633—Constructional details or arrangements of portable computers not specific to the type of enclosures covered by groups G06F1/1615 - G06F1/1626

- G06F1/1684—Constructional details or arrangements related to integrated I/O peripherals not covered by groups G06F1/1635 - G06F1/1675

- G06F1/1694—Constructional details or arrangements related to integrated I/O peripherals not covered by groups G06F1/1635 - G06F1/1675 the I/O peripheral being a single or a set of motion sensors for pointer control or gesture input obtained by sensing movements of the portable computer

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/011—Arrangements for interaction with the human body, e.g. for user immersion in virtual reality

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/011—Arrangements for interaction with the human body, e.g. for user immersion in virtual reality

- G06F3/012—Head tracking input arrangements

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/017—Gesture based interaction, e.g. based on a set of recognized hand gestures

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F2200/00—Indexing scheme relating to G06F1/04 - G06F1/32

- G06F2200/16—Indexing scheme relating to G06F1/16 - G06F1/18

- G06F2200/163—Indexing scheme relating to constructional details of the computer

- G06F2200/1637—Sensing arrangement for detection of housing movement or orientation, e.g. for controlling scrolling or cursor movement on the display of an handheld computer

Landscapes

- Engineering & Computer Science (AREA)

- Theoretical Computer Science (AREA)

- General Engineering & Computer Science (AREA)

- Physics & Mathematics (AREA)

- Human Computer Interaction (AREA)

- General Physics & Mathematics (AREA)

- Computer Hardware Design (AREA)

- Acoustics & Sound (AREA)

- Signal Processing (AREA)

- Stereophonic System (AREA)

- User Interface Of Digital Computer (AREA)

Description

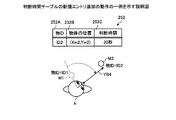

Xs’=Xs−(Xs−Xh)*(tf/t)

Ys’=Ys−(Ys−Yh)*(tf/t) …(1)

前記注視先の物体と判断されたタイミングから所定の判断時間を経過した場合に、当該注視先の物体を対象物と判断する第2の判断部と、

前記注視先の物体が前記対象物と判断された場合に、前記対象物に対応した音源の音声を前記対象物の位置に関連付けて出力する音響信号を生成する生成部と、

前記利用者の進行方向と前記利用者の身体の向きとの違いに基づき、前記所定の判断時間が経過するまでの残り時間を減少方向に調整する調整部と

を有することを特徴とする音響装置。

所定周期毎に前記残り時間を減少方向に調整し、当該調整した残り時間を新たな判断時間として設定し、

前記第2の判断部は、

前記調整部で設定された新たな判断時間を経過した場合に、前記注視先の物体を前記対象物と判断することを特徴とする付記1に記載の音響装置。

前記第1の判断部にて前記進行方向以外の方向に位置する物体を前記利用者の注視先の物体と判断された場合に、前記利用者の進行方向と前記利用者の身体の向きとの違いに基づき、前記残り時間を減少させることを特徴とする付記3に記載の音響装置。

前記利用者の進行方向と前記利用者の身体の向きとが成す角度に基づき、前記残り時間を減少させることを特徴とする付記4に記載の音響装置。

を有し、

前記設定部が、前記残り時間に合わせて注視先の物体に対応した音源が利用者に近づくように音源の位置座標を設定することを特徴とする付記1〜5の何れか一つに記載の音響装置。

前記利用者の注視行動が検出されると、前記進行方向以外の方向に位置する物体を前記利用者の注視先の物体と判断し、

前記調整部は、

前記第1の判断部にて前記利用者の注視行動による前記進行方向以外の方向に位置する物体を前記利用者の注視先の物体と判断された場合に、前記残り時間を更に減少させることを特徴とする付記1〜5の何れか一つに記載の音響装置。

前記利用者の前記進行方向への移動状態から停止状態になる行動を前記利用者の注視行動として検出することを特徴とする付記7に記載の音響装置。

前記利用者の手と当該利用者の耳との間の距離を所定距離よりも短くする行動を前記利用者の注視行動として検出することを特徴とする付記7に記載の音響装置。

前記注視先の物体と判断されたタイミングから所定の判断時間を経過した場合に、当該注視先の物体を対象物と判断する第2の判断部と、

前記注視先の物体が前記対象物と判断された場合に、前記対象物の位置から当該対象物に対応した音源の音声を出力する音響信号を生成する生成部と、

前記利用者の進行方向と前記利用者の身体の向きとの違いに基づき、前記所定の判断時間が経過するまでの残り時間を減少方向に調整する調整部と

を有することを特徴とする拡張現実音響装置。

前記端末装置は、

前記利用者の状態を検出する検出部と、

前記音響信号を音響出力する音響出力部と

を有し、

前記音響装置は、

前記利用者の状態に基づき、前記利用者の周囲の物体の内、任意の物体を前記利用者の注視先の物体と判断する第1の判断部と、

前記注視先の物体と判断されたタイミングから所定の判断時間を経過した場合に、当該注視先の物体を対象物と判断する第2の判断部と、

前記注視先の物体が前記対象物と判断された場合に、前記対象物に対応した音源の音声を前記対象物の位置に関連付けて出力する音響信号を生成する生成部と、

前記利用者の進行方向と前記利用者の身体の向きとの違いに基づき、前記所定の判断時間が経過するまでの残り時間を減少方向に調整する調整部と

を有することを特徴とする音響システム。

利用者の状態に基づき、前記利用者の周囲の物体の内、任意の物体を前記利用者の注視先の物体と判断し、

前記注視先の物体と判断されたタイミングから所定の判断時間を経過した場合に、当該注視先の物体を対象物と判断し、

前記注視先の物体が前記対象物と判断された場合に、前記対象物に対応した音源の音声を前記対象物の位置に関連付けて出力する音響信号を生成し、

前記利用者の進行方向と前記利用者の身体の向きとの違いに基づき、前記所定の判断時間が経過するまでの残り時間を減少方向に調整する

処理を実行することを特徴とする音響処理方法。

利用者の状態に基づき、前記利用者の周囲の物体の内、任意の物体を前記利用者の注視先の物体と判断し、

前記注視先の物体と判断されたタイミングから所定の判断時間を経過した場合に、当該注視先の物体を対象物と判断し、

前記注視先の物体が前記対象物と判断された場合に、前記対象物に対応した音源の音声を前記対象物の位置に関連付けて出力する音響信号を生成し、

前記利用者の進行方向と前記利用者の身体の向きとの違いに基づき、前記所定の判断時間が経過するまでの残り時間を減少方向に調整する

処理を実行させることを特徴とする音響処理プログラム。

10、10A 端末装置

11 位置検出部

12 向き検出部

13 進行方向検出部

14 ヘッドホン

16 行動検出部

20、20A、20B 音声AR装置

21 第1の判断部

22 第2の判断部

23 音声制御部

24 調整部

25 記憶部

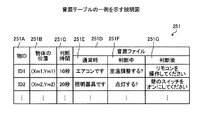

251 音源テーブル

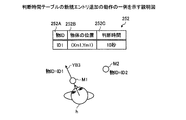

252 判断時間テーブル

253 音源位置テーブル

Claims (10)

- 利用者の状態に基づき、前記利用者の周囲の物体の内、任意の物体を前記利用者の注視先の物体と判断する第1の判断部と、

前記注視先の物体と判断されたタイミングから所定の判断時間を経過した場合に、当該注視先の物体を対象物と判断する第2の判断部と、

前記注視先の物体が前記対象物と判断された場合に、前記対象物に対応した音源の音声を前記対象物の位置に関連付けて出力する音響信号を生成する生成部と、

前記利用者の進行方向と前記利用者の身体の向きとの違いに基づき、前記所定の判断時間が経過するまでの残り時間を減少方向に調整する調整部と

を有することを特徴とする音響装置。 - 前記調整部は、

所定周期毎に前記残り時間を減少方向に調整し、当該調整した残り時間を新たな判断時間として設定し、

前記第2の判断部は、

前記調整部で設定された新たな判断時間を経過した場合に、前記注視先の物体を前記対象物と判断することを特徴とする請求項1に記載の音響装置。 - 前記第1の判断部が、前記利用者の進行方向と前記利用者の身体の向きとに基づき、前記任意の物体を前記利用者の注視先の物体と判断することを特徴とする請求項1又は2に記載の音響装置。

- 前記調整部は、

前記第1の判断部にて前記進行方向以外の方向に位置する物体を前記利用者の注視先の物体と判断された場合に、前記利用者の進行方向と前記利用者の身体の向きとの違いに基づき、前記残り時間を減少させることを特徴とする請求項3に記載の音響装置。 - 前記調整部は、

前記利用者の進行方向と前記利用者の身体の向きとが成す角度に基づき、前記残り時間を減少させることを特徴とする請求項4に記載の音響装置。 - 前記利用者の注視先の物体に対応した音源を仮想的に定位させる位置座標を設定する設定部

を有し、

前記設定部が、前記残り時間に合わせて注視先の物体に対応した音源が利用者に近づくように音源の位置座標を設定することを特徴とする請求項1〜5の何れか一つに記載の音響装置。 - 前記第1の判断部は、

前記利用者の注視行動が検出されると、前記進行方向以外の方向に位置する物体を前記利用者の注視先の物体と判断し、

前記調整部は、

前記第1の判断部にて前記利用者の注視行動による前記進行方向以外の方向に位置する物体を前記利用者の注視先の物体と判断された場合に、前記残り時間を更に減少させることを特徴とする請求項1〜5の何れか一つに記載の音響装置。 - 利用者が携帯する端末装置と、前記利用者の周囲の物体に対応した音源からの音声を含む音響信号を前記端末装置に提供する音響装置とを有し、

前記端末装置は、

前記利用者の状態を検出する検出部と、

前記音響信号を音響出力する音響出力部と

を有し、

前記音響装置は、

前記利用者の状態に基づき、前記利用者の周囲の物体の内、任意の物体を前記利用者の注視先の物体と判断する第1の判断部と、

前記注視先の物体と判断されたタイミングから所定の判断時間を経過した場合に、当該注視先の物体を対象物と判断する第2の判断部と、

前記注視先の物体が前記対象物と判断された場合に、前記対象物に対応した音源の音声を前記対象物の位置に関連付けて出力する音響信号を生成する生成部と、

前記利用者の進行方向と前記利用者の身体の向きとの違いに基づき、前記所定の判断時間が経過するまでの残り時間を減少方向に調整する調整部と

を有することを特徴とする音響システム。 - 情報処理装置が、

利用者の状態に基づき、前記利用者の周囲の物体の内、任意の物体を前記利用者の注視先の物体と判断し、

前記注視先の物体と判断されたタイミングから所定の判断時間を経過した場合に、当該注視先の物体を対象物と判断し、

前記注視先の物体が前記対象物と判断された場合に、前記対象物に対応した音源の音声を前記対象物の位置に関連付けて出力する音響信号を生成し、

前記利用者の進行方向と前記利用者の身体の向きとの違いに基づき、前記所定の判断時間が経過するまでの残り時間を減少方向に調整する

処理を実行することを特徴とする音響処理方法。 - 情報処理装置に、

利用者の状態に基づき、前記利用者の周囲の物体の内、任意の物体を前記利用者の注視先の物体と判断し、

前記注視先の物体と判断されたタイミングから所定の判断時間を経過した場合に、当該注視先の物体を対象物と判断し、

前記注視先の物体が前記対象物と判断された場合に、前記対象物に対応した音源の音声を前記対象物の位置に関連付けて出力する音響信号を生成し、

前記利用者の進行方向と前記利用者の身体の向きとの違いに基づき、前記所定の判断時間が経過するまでの残り時間を減少方向に調整する

処理を実行させることを特徴とする音響処理プログラム。

Priority Applications (2)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2013215111A JP6201615B2 (ja) | 2013-10-15 | 2013-10-15 | 音響装置、音響システム、音響処理方法及び音響処理プログラム |

| US14/479,756 US9294863B2 (en) | 2013-10-15 | 2014-09-08 | Acoustic device, augmented reality acoustic device, acoustic system, acoustic processing method, and recording medium |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2013215111A JP6201615B2 (ja) | 2013-10-15 | 2013-10-15 | 音響装置、音響システム、音響処理方法及び音響処理プログラム |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2015079310A JP2015079310A (ja) | 2015-04-23 |

| JP6201615B2 true JP6201615B2 (ja) | 2017-09-27 |

Family

ID=52809705

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2013215111A Expired - Fee Related JP6201615B2 (ja) | 2013-10-15 | 2013-10-15 | 音響装置、音響システム、音響処理方法及び音響処理プログラム |

Country Status (2)

| Country | Link |

|---|---|

| US (1) | US9294863B2 (ja) |

| JP (1) | JP6201615B2 (ja) |

Families Citing this family (10)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US9663031B2 (en) * | 2013-10-21 | 2017-05-30 | Harman International Industries, Inc. | Modifying an audio panorama to indicate the presence of danger or other events of interest |

| JP6263098B2 (ja) * | 2014-07-15 | 2018-01-17 | Kddi株式会社 | 仮想音源を提供情報位置に配置する携帯端末、音声提示プログラム及び音声提示方法 |

| US10575117B2 (en) | 2014-12-08 | 2020-02-25 | Harman International Industries, Incorporated | Directional sound modification |

| WO2017106281A1 (en) * | 2015-12-18 | 2017-06-22 | Dolby Laboratories Licensing Corporation | Nuisance notification |

| KR102892155B1 (ko) * | 2016-08-12 | 2025-12-01 | 매직 립, 인코포레이티드 | 단어 흐름 주석 |

| JP2018082308A (ja) * | 2016-11-16 | 2018-05-24 | ソニー株式会社 | 情報処理装置、方法及びプログラム |

| US20190200154A1 (en) * | 2017-12-21 | 2019-06-27 | Facebook, Inc. | Systems and methods for audio-based augmented reality |

| US10783766B2 (en) * | 2018-08-27 | 2020-09-22 | Avaya Inc. | Method and system for warning users of offensive behavior |

| JP7451235B2 (ja) * | 2020-03-06 | 2024-03-18 | キヤノン株式会社 | 撮像装置、制御方法、およびプログラム |

| JP7703181B2 (ja) * | 2021-08-11 | 2025-07-07 | 株式会社ジェイテクト | 情報提供システム、方法、及びプログラム |

Family Cites Families (11)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH11288341A (ja) * | 1998-04-01 | 1999-10-19 | Canon Inc | ナビゲーション装置及び方法 |

| WO2000022823A1 (en) | 1998-10-09 | 2000-04-20 | Sony Corporation | Communication apparatus and method |

| JP2003521202A (ja) * | 2000-01-28 | 2003-07-08 | レイク テクノロジー リミティド | 地理的な環境で使用される空間オーディオシステム。 |

| JP2005309948A (ja) * | 2004-04-23 | 2005-11-04 | Yamaha Corp | 情報提供装置 |

| JP2005316704A (ja) | 2004-04-28 | 2005-11-10 | Sony Corp | 周囲状況通知装置、周囲状況通知方法 |

| JP2006277192A (ja) | 2005-03-29 | 2006-10-12 | Advanced Telecommunication Research Institute International | 映像表示システム |

| JP6016322B2 (ja) * | 2010-03-19 | 2016-10-26 | ソニー株式会社 | 情報処理装置、情報処理方法、およびプログラム |

| JP5821307B2 (ja) * | 2011-06-13 | 2015-11-24 | ソニー株式会社 | 情報処理装置、情報処理方法及びプログラム |

| JP5800602B2 (ja) * | 2011-06-29 | 2015-10-28 | オリンパス株式会社 | 情報処理システム、携帯電子機器、プログラム及び情報記憶媒体 |

| US9554229B2 (en) * | 2011-10-31 | 2017-01-24 | Sony Corporation | Amplifying audio-visual data based on user's head orientation |

| US9129430B2 (en) * | 2013-06-25 | 2015-09-08 | Microsoft Technology Licensing, Llc | Indicating out-of-view augmented reality images |

-

2013

- 2013-10-15 JP JP2013215111A patent/JP6201615B2/ja not_active Expired - Fee Related

-

2014

- 2014-09-08 US US14/479,756 patent/US9294863B2/en not_active Expired - Fee Related

Also Published As

| Publication number | Publication date |

|---|---|

| US20150104049A1 (en) | 2015-04-16 |

| US9294863B2 (en) | 2016-03-22 |

| JP2015079310A (ja) | 2015-04-23 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP6201615B2 (ja) | 音響装置、音響システム、音響処理方法及び音響処理プログラム | |

| US11805382B2 (en) | Coordinated tracking for binaural audio rendering | |

| US11586280B2 (en) | Head motion prediction for spatial audio applications | |

| US11589183B2 (en) | Inertially stable virtual auditory space for spatial audio applications | |

| US10880670B2 (en) | Systems and methods for determining estimated head orientation and position with ear pieces | |

| US20210400418A1 (en) | Head to headset rotation transform estimation for head pose tracking in spatial audio applications | |

| RU2678481C2 (ru) | Устройство обработки информации, способ обработки информации и программа | |

| CN107211216B (zh) | 用于提供虚拟音频再现的方法和装置 | |

| US20250133363A1 (en) | Head tracking correlated motion detection for spatial audio applications | |

| US9622013B2 (en) | Directional sound modification | |

| KR102192361B1 (ko) | 머리 움직임을 이용한 사용자 인터페이스 방법 및 장치 | |

| US20180048950A1 (en) | Accessory Device that Provides Sensor Input to a Media Device | |

| US12219344B2 (en) | Adaptive audio centering for head tracking in spatial audio applications | |

| CN104205880A (zh) | 基于取向的音频控制 | |

| US20130055103A1 (en) | Apparatus and method for controlling three-dimensional graphical user interface (3d gui) | |

| US10499164B2 (en) | Presentation of audio based on source | |

| JP2015076797A (ja) | 空間情報提示装置、空間情報提示方法及び空間情報提示用コンピュータプログラム | |

| JP2017138277A (ja) | 音声ナビゲーションシステム | |

| US20220082688A1 (en) | Methods and systems for determining position and orientation of a device using acoustic beacons | |

| US20240430636A1 (en) | Audio augmented reality object playback device and audio augmented reality object playback method | |

| US20170064485A1 (en) | Method and device for playing 3d sound | |

| CN105282642A (zh) | 耳机及其声道控制方法 | |

| WO2021125081A1 (ja) | 情報処理装置、制御方法及び非一時的なコンピュータ可読媒体 | |

| CN117897687A (zh) | 基于用户电信号的音频调整 | |

| US20250126431A1 (en) | Information processing apparatus, information processing method, and program |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20160705 |

|

| TRDD | Decision of grant or rejection written | ||

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20170726 |

|

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20170801 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20170814 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 6201615 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 |

|

| LAPS | Cancellation because of no payment of annual fees |