JP2015524977A - Automatic gesture recognition for sensor systems - Google Patents

Automatic gesture recognition for sensor systems Download PDFInfo

- Publication number

- JP2015524977A JP2015524977A JP2015526994A JP2015526994A JP2015524977A JP 2015524977 A JP2015524977 A JP 2015524977A JP 2015526994 A JP2015526994 A JP 2015526994A JP 2015526994 A JP2015526994 A JP 2015526994A JP 2015524977 A JP2015524977 A JP 2015524977A

- Authority

- JP

- Japan

- Prior art keywords

- gesture

- sensor

- distance

- hidden markov

- readable medium

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Pending

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V40/00—Recognition of biometric, human-related or animal-related patterns in image or video data

- G06V40/20—Movements or behaviour, e.g. gesture recognition

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/017—Gesture based interaction, e.g. based on a set of recognized hand gestures

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/048—Interaction techniques based on graphical user interfaces [GUI]

- G06F3/0487—Interaction techniques based on graphical user interfaces [GUI] using specific features provided by the input device, e.g. functions controlled by the rotation of a mouse with dual sensing arrangements, or of the nature of the input device, e.g. tap gestures based on pressure sensed by a digitiser

- G06F3/0488—Interaction techniques based on graphical user interfaces [GUI] using specific features provided by the input device, e.g. functions controlled by the rotation of a mouse with dual sensing arrangements, or of the nature of the input device, e.g. tap gestures based on pressure sensed by a digitiser using a touch-screen or digitiser, e.g. input of commands through traced gestures

- G06F3/04883—Interaction techniques based on graphical user interfaces [GUI] using specific features provided by the input device, e.g. functions controlled by the rotation of a mouse with dual sensing arrangements, or of the nature of the input device, e.g. tap gestures based on pressure sensed by a digitiser using a touch-screen or digitiser, e.g. input of commands through traced gestures for inputting data by handwriting, e.g. gesture or text

Abstract

関連付けられている複数の検出センサを使用して、1つ以上のジェスチャ関連信号を検出することと、ジェスチャが所定の組のジェスチャのうちの1つに対応するかどうかを決定するために、自動認識技法を使用して、1つ以上のジェスチャ関連信号から検出されるジェスチャを評価することとを含む、ジェスチャ認識のための方法。一実施形態において、ジェスチャを評価することは、ジェスチャの開始および停止を決定することを含む。一実施形態において、各ジェスチャは、1つ以上の隠れマルコフモデル(HMM)によって表される。Automatic detection to detect one or more gesture related signals using a plurality of associated detection sensors and to determine whether the gesture corresponds to one of a predetermined set of gestures. Evaluating a gesture detected from one or more gesture-related signals using a recognition technique. In one embodiment, evaluating the gesture includes determining the start and stop of the gesture. In one embodiment, each gesture is represented by one or more hidden Markov models (HMMs).

Description

(関連出願の引用)

本願は、米国仮特許出願第61/684,039号(2012年8月16日出願)からの優先権を主張する。該出願は、本明細書において完全に記載されたかのように、その全体が参照により引用される。

(Citation of related application)

This application claims priority from US Provisional Patent Application No. 61 / 684,039 (filed Aug. 16, 2012). The application is incorporated by reference in its entirety as if fully set forth herein.

(技術分野)

本開示は、センサシステムのための方法およびシステムに関し、具体的には、そのようなシステムのための自動ジェスチャ認識に関する。より具体的には、本開示は、ジェスチャの変換および/または拡大縮小に対して不変であり、手/指とセンサシステムとの間の比較的大きい距離のためのジェスチャ認識システムに関する。

(Technical field)

The present disclosure relates to methods and systems for sensor systems, and in particular, to automatic gesture recognition for such systems. More specifically, the present disclosure relates to a gesture recognition system that is invariant to gesture transformation and / or scaling and for a relatively large distance between a hand / finger and a sensor system.

ジェスチャの非接触検出および認識のためのシステムが知られている。そのようなシステムは、容量性(例えば、表面容量性、投影容量性、相互容量性、または自己容量性)、赤外線、光学撮像、分散信号、超音波、または音響のパルス認識センサ技術に基づき得る。 Systems for non-contact detection and recognition of gestures are known. Such systems may be based on capacitive (eg, surface capacitive, projected capacitive, mutual capacitive, or self-capacitive), infrared, optical imaging, distributed signal, ultrasound, or acoustic pulse recognition sensor technology. .

容量センサシステムは、例えば、交流電場を生成し、電場内のセンサ電極において得られる電位差(すなわち、電圧)を測定することによって、実現されることができる。実装に応じて、単一の電極が使用され得、または伝送電極および1つ以上の受信電極が使用され得る。センサ電極における電圧は、センサ電極とその電気的環境との間の静電容量の評価尺度である。つまり、これは、具体的には電極配列によって提供される検出空間内でジェスチャを行い得る、人間の指または手のような物体による影響を受ける。さらに、この電圧から、例えば、指の距離またはジェスチャが推測され得る。この情報は、ヒューマン・マシンインタフェースに使用されることができる。 A capacitive sensor system can be realized, for example, by generating an alternating electric field and measuring the potential difference (ie, voltage) obtained at the sensor electrodes in the electric field. Depending on the implementation, a single electrode can be used, or a transmission electrode and one or more receiving electrodes can be used. The voltage at the sensor electrode is a measure of the capacitance between the sensor electrode and its electrical environment. That is, it is affected by an object such as a human finger or hand that can specifically make a gesture within the detection space provided by the electrode array. Furthermore, from this voltage, for example, finger distance or gesture can be inferred. This information can be used for a human-machine interface.

3次元位置付けシステムを考慮すると、ジェスチャ検出のための率直かつ最高レベルのアプローチは、自動ジェスチャ認識システムへの入力としてx/y位置推定値を得て、開始/停止基準のためにz距離を使用することである。位置推定値は、センサデータが処理される1つ以上の段階の結果(較正、較正されたセンサ値および距離の非線形関係、距離の三角関数である位置)であり、各段階が余分な不確実性を導入するので、x/y/z推定値を使用することは、より早い処理段階からのデータを使用することよりもエラーを生じやすいであろう。 Considering a 3D positioning system, a straightforward and highest level approach for gesture detection takes an x / y position estimate as input to an automatic gesture recognition system and uses z-distance for start / stop criteria It is to be. The position estimate is the result of one or more stages in which the sensor data is processed (calibration, non-linear relationship between calibrated sensor values and distance, position that is a trigonometric function of distance), each stage with extra uncertainty Using x / y / z estimates would be more error-prone than using data from earlier processing stages.

本開示のこれらおよび他の側面は、以下の説明および付随の図面と併せて検討されることによって、さらに認識および理解されるであろう。しかしながら、以下の説明は、本開示の種々の実施形態およびその多数の具体的詳細を示すが、限定ではなく、例証として与えられることを理解されたい。多くの代用、修正、追加、および/または再配列が、その精神から逸脱することなく、本開示の範囲内で行われてもよく、本開示は、全てのそのような代用、修正、追加、および/または再配列を含む。 These and other aspects of the present disclosure will be further appreciated and understood when considered in conjunction with the following description and the accompanying drawings. However, it is to be understood that the following description illustrates various embodiments of the present disclosure and numerous specific details thereof, but is provided by way of illustration and not limitation. Many substitutions, modifications, additions, and / or rearrangements may be made within the scope of the present disclosure without departing from the spirit thereof, and the disclosure includes all such substitutions, modifications, additions, And / or including rearrangement.

実施形態によるジェスチャ認識のための方法は、関連付けられている複数の検出センサを使用して、1つ以上のジェスチャ関連信号を検出することと、ジェスチャが所定の組のジェスチャのうちの1つに対応するかどうかを決定するために、自動認識技法を使用して、1つ以上のジェスチャ関連信号から検出されるジェスチャを評価することとを含む。いくつかの実施形態では、ジェスチャの開始は、標的物体と少なくとも1つのセンサとの間の距離が減少し、標的物体と少なくとも1つのセンサとの間の距離が増加し、かつ、所定の複数の信号サンプルにわたる短期間変動または同等の評価尺度が閾値より小さい場合に、決定される。いくつかの実施形態では、ジェスチャの停止は、所与の時点において、標的物体と全てのセンサとの間の距離が減少し、および/または所定の複数の信号サンプルにわたる短期間変動または同等の評価尺度が閾値より小さく、および/または信号変化は、所与の時点後の所定の複数の信号サンプルにわたり所定の閾値より小さい場合に、決定される。 A method for gesture recognition according to an embodiment uses a plurality of associated detection sensors to detect one or more gesture related signals, and the gesture is one of a predetermined set of gestures. Evaluating a gesture detected from one or more gesture-related signals using an automatic recognition technique to determine whether it corresponds. In some embodiments, the initiation of the gesture decreases the distance between the target object and the at least one sensor, increases the distance between the target object and the at least one sensor, and the predetermined plurality of Determined when short-term variation over signal samples or equivalent rating measure is less than threshold. In some embodiments, cessation of a gesture reduces the distance between the target object and all sensors at a given point in time and / or short-term variation or equivalent assessment across a given plurality of signal samples. A measure is determined if it is less than a threshold and / or the signal change is less than a predetermined threshold over a predetermined number of signal samples after a given time point.

いくつかの実施形態では、各ジェスチャは、1つ以上の隠れマルコフモデル(HMM)によって表される。いくつかの実施形態では、ジェスチャを評価することは、1つ以上のHMMに対する確率評価尺度を評価することを含む。いくつかの実施形態では、HMMの観察行列が関連付けられている特徴は、非量子化または量子化センサ信号レベル、x/y/z位置、距離、方向、配向、角度、および/またはこれらの時間に関する一次、二次、またはさらに高次の導関数、あるいはそれらの任意の組み合わせである。いくつかの実施形態では、特徴は、2つの量子化レベルに量子化される、センサ信号レベルの一次導関数である。 In some embodiments, each gesture is represented by one or more hidden Markov models (HMMs). In some embodiments, evaluating the gesture includes evaluating a probability rating measure for one or more HMMs. In some embodiments, the features with which the HMM observation matrix is associated are unquantized or quantized sensor signal levels, x / y / z position, distance, direction, orientation, angle, and / or their time. Is a first, second, or higher order derivative, or any combination thereof. In some embodiments, the feature is the first derivative of the sensor signal level that is quantized to two quantization levels.

実施形態によるジェスチャ認識のためのシステムは、関連付けられている複数の検出センサを使用して、1つ以上のジェスチャ関連信号を検出するためのセンサ配列と、ジェスチャが所定の組のジェスチャのうちの1つに対応するかどうかを決定するために、自動認識技法を使用して、1つ以上のジェスチャ関連信号から検出されるジェスチャを評価するためのモジュールとを含む。 A system for gesture recognition according to an embodiment includes a sensor array for detecting one or more gesture-related signals using a plurality of associated detection sensors, and a gesture of a predetermined set of gestures. A module for evaluating gestures detected from one or more gesture-related signals using automatic recognition techniques to determine whether one is supported.

いくつかの実施形態では、ジェスチャの開始は、標的物体と少なくとも1つのセンサとの間の距離が減少し、標的物体と少なくとも1つのセンサとの間の距離が増加し、かつ、所定の複数の信号サンプルにわたる短期間変動または同等の評価尺度が閾値より小さい場合に、決定される。いくつかの実施形態では、ジェスチャの停止は、所与の時点において、標的物体と全てのセンサとの間の距離が減少し、および/または所定の複数の信号サンプルにわたる短期間変動または同等の評価尺度が閾値より小さく、および/または信号変化が所与の時点後の所定の複数の信号サンプルにわたり所定の閾値より小さい場合に、決定される。 In some embodiments, the initiation of the gesture decreases the distance between the target object and the at least one sensor, increases the distance between the target object and the at least one sensor, and the predetermined plurality of Determined when short-term variation over signal samples or equivalent rating measure is less than threshold. In some embodiments, cessation of a gesture reduces the distance between the target object and all sensors at a given point in time and / or short-term variation or equivalent assessment across a given plurality of signal samples. Determined when the measure is less than a threshold and / or the signal change is less than a predetermined threshold over a predetermined number of signal samples after a given time point.

実施形態によるコンピュータ読み取り可能な媒体は、複数の検出センサを使用して、1つ以上のジェスチャ関連信号を受信するため、およびジェスチャが所定の組のジェスチャのうちの1つに対応するかどうかを決定するために、自動認識技法を使用して、1つ以上のジェスチャ関連信号から検出されるジェスチャを評価するための1つ以上の非一過性機械読み取り可能なプログラム命令を含む。 A computer-readable medium according to an embodiment uses a plurality of detection sensors to receive one or more gesture-related signals and whether the gesture corresponds to one of a predetermined set of gestures. To determine, includes one or more non-transitory machine readable program instructions for evaluating gestures detected from one or more gesture related signals using automatic recognition techniques.

いくつかの実施形態では、ジェスチャの開始は、標的物体と少なくとも1つのセンサとの間の距離が減少し、標的物体と少なくとも1つのセンサとの間の距離が増加し、かつ、所定の複数の信号サンプルにわたる短期間変動または同等の評価尺度が閾値より小さい場合に、決定される。いくつかの実施形態では、ジェスチャの停止は、所与の時点において、標的物体と全てのセンサとの間の距離が減少し、および/または所定の複数の信号サンプルにわたる短期間変動または同等の評価尺度が閾値より小さく、および/または信号変化が所与の時点後の所定の複数の信号サンプルにわたり所定の閾値より小さい場合に決定される。 In some embodiments, the initiation of the gesture decreases the distance between the target object and the at least one sensor, increases the distance between the target object and the at least one sensor, and the predetermined plurality of Determined when short-term variation over signal samples or equivalent rating measure is less than threshold. In some embodiments, cessation of a gesture reduces the distance between the target object and all sensors at a given point in time and / or short-term variation or equivalent assessment across a given plurality of signal samples. Determined when the measure is less than a threshold and / or the signal change is less than a predetermined threshold over a predetermined number of signal samples after a given time point.

付随の本明細書の一部を形成する図面は、本開示のある側面を描写するために含まれる。図面に図示される特徴は、必ずしも、正確な縮尺で描かれていないことに留意されたい。本開示およびその利点のより完全な理解は、類似参照番号が類似特徴を示す、付随の図面と関連して検討される、以下の説明を参照することによって得られ得る。

本開示およびその種々の特徴および有利な詳細が、付随の図面に図示され、以下の説明に詳述される、例示的であり、したがって、非限定的な実施形態を参照して、より完全に説明される。しかしながら、発明を実施するための形態および具体的実施例は、好ましい実施形態を示すが、限定ではなく、単なる例証として与えられることを理解されたい。既知のプログラミング技法、コンピュータソフトウェア、ハードウェア、オペレーティングプラットフォームおよびプロトコルの説明は、本開示の詳細を不必要に曖昧にしないよう省略され得る。本発明の根本概念の精神および/または範囲内の種々の置き換え、修正、追加、および/または並べ替えは、本開示から当業者に明白となるであろう。 The present disclosure and its various features and advantageous details are illustrated in the accompanying drawings and detailed in the following description, and are therefore more fully described with reference to non-limiting embodiments. Explained. However, it should be understood that the detailed description and specific examples, while indicating the preferred embodiment, are given by way of illustration only and not limitation. Descriptions of known programming techniques, computer software, hardware, operating platforms, and protocols may be omitted so as not to unnecessarily obscure the details of the present disclosure. Various substitutions, modifications, additions, and / or rearrangements within the spirit and / or scope of the underlying concepts of the present invention will be apparent to those skilled in the art from this disclosure.

実施形態によると、システムは、測定データを提供する2つ以上のセンサ電極を伴うセンサシステムの前で行われる、事前定義された手のジェスチャの確実な自動認識を伴って提供される。実施形態によると、認識は、ジェスチャの変換および/または拡大縮小に対して不変であり、手/指とそれぞれのセンサシステムとの間の広範囲のz軸距離のためのものである。種々の実施形態によると、手のジェスチャ認識のための改良された特徴抽出およびジェスチャ検出を伴う隠れマルコフ認識装置が提供されることができる。 According to an embodiment, the system is provided with reliable automatic recognition of predefined hand gestures performed in front of a sensor system with two or more sensor electrodes providing measurement data. According to embodiments, recognition is invariant to gesture transformation and / or scaling and is for a wide range of z-axis distances between the hand / finger and the respective sensor system. According to various embodiments, a hidden Markov recognizer with improved feature extraction and gesture detection for hand gesture recognition can be provided.

便宜上、実施形態は、容量センサシステムとの関連で説明されるが、距離または深度情報を提供することができる、任意の好適なセンサシステムが採用され得る。さらに、実施形態は、3次元(x/y/z)センサシステムとの関連で説明されるが、ジェスチャ認識のための提案された方法はまた、2次元センサシステム(z=0)にも適用可能である。好適なセンサシステムの例は、容量性(例えば、表面容量性、投影容量性、相互容量性、または自己容量性)、表面音響波、赤外線、光学またはビデオ撮像、1つ以上のフォトダイオード、分散信号、超音波、または音響のパルス認識センサ技術に基づくものを含むが、それらに限定されない。したがって、図は例示にすぎない。 For convenience, embodiments are described in the context of a capacitive sensor system, but any suitable sensor system that can provide distance or depth information may be employed. Furthermore, although the embodiments are described in the context of a three-dimensional (x / y / z) sensor system, the proposed method for gesture recognition also applies to a two-dimensional sensor system (z = 0). Is possible. Examples of suitable sensor systems are capacitive (eg, surface capacitive, projected capacitive, mutual capacitive, or self-capacitive), surface acoustic waves, infrared, optical or video imaging, one or more photodiodes, distributed Including, but not limited to, those based on signal, ultrasound, or acoustic pulse recognition sensor technology. Accordingly, the figures are merely exemplary.

ここで図面を参照し、特に図1に注目すると、センサ構成が示され、概して、参照数字100によって識別される。より具体的には、図1は、容量センサシステム等の内蔵センサシステムを伴うPCキーボード103の上の人間の指102等のユーザ入力物体を図示する。領域104a−104dは、キーの下のセンサ電極の位置を識別する。指102と長方形の領域104a−104dとの間の線106は、指先からセンサ電極までの最短経路を示す。領域104a−104dによってx/y次元で制限される長方形の領域107は、「アクティブ領域」として表され、アクティブ領域の上方の立方体状の空間108は、「アクティブ空間」として表される。

Referring now to the drawings and with particular attention to FIG. 1, the sensor configuration is shown and generally identified by

独立型キーボードに組み込まれたセンサシステムとして図示されるが、実施形態は、携帯電話、MP3プレーヤ、PDA、タブレットコンピュータ、コンピュータ、リモートコントロール、ラジオ、コンピュータマウス、タッチセンサ式ディスプレイ、およびテレビ等の、それ自体がユーザインターフェースであるか、またはユーザインターフェースを備えている電子機器に関連付けられる、センサシステムとともに採用され得ることに留意されたい。ユーザ入力物体は、スタイラス(例えば、小型ペン形状器具)またはデジタルペンのようなものであり得る。ユーザ入力物体はまた、この意味では、ユーザの手または指であり得る。 Although illustrated as a sensor system incorporated into a stand-alone keyboard, embodiments include cell phones, MP3 players, PDAs, tablet computers, computers, remote controls, radios, computer mice, touch-sensitive displays, and televisions, etc. Note that it may be employed with a sensor system that is itself a user interface or associated with an electronic device that has a user interface. The user input object may be something like a stylus (eg, a small pen-shaped instrument) or a digital pen. The user input object can also be the user's hand or finger in this sense.

図2は、センサシステムをさらに詳細に示す、キーのうちのいくつかが除去されたキーボード103を図示する。具体的には、底部(EB)104a、左(EL)104d、上部(ET)104c、および右(ER)104b電極を伴うセンサシステムを保持する基礎的プリント回路基板が示されている。

FIG. 2 illustrates the

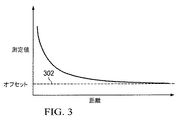

図3は、センサ電極と指先との間の距離(水平軸)の関数として、センサの測定値(垂直軸)の規模を定性的に示す。距離が大きくなるほど、測定値が小さくなる。本発明の同等の実施形態について、センサ値は、距離とともに増加する。無限に向かって増大する距離に対する漸近オフセット302は、概して、未知であり、また、経時的に変化し得る。 FIG. 3 qualitatively shows the magnitude of the sensor measurement (vertical axis) as a function of the distance between the sensor electrode and the fingertip (horizontal axis). As the distance increases, the measured value decreases. For equivalent embodiments of the invention, the sensor value increases with distance. The asymptotic offset 302 for distances increasing towards infinity is generally unknown and may change over time.

いくつかの実施形態では、センサシステムは、所定のサンプリングレートf_sで、各センサ電極に対する離散時間測定値を提供する。典型的には、前処理段階で、センサ信号は、用途に応じて、典型的には最大でf_max=<15Hz〜20Hzである、手のジェスチャの周波数範囲に合致するために、低域通過フィルタにかけられ、f_s>2*f_maxである。1つ以上の電極に対するこれらの信号を考慮すると、目標は、それぞれ、キーボードまたはアクティブ領域の上で行われる手のジェスチャの確実な自動認識を提供することである。 In some embodiments, the sensor system provides discrete time measurements for each sensor electrode at a predetermined sampling rate f_s. Typically, in the pre-processing stage, the sensor signal is a low-pass filter to match the hand gesture frequency range, which is typically up to f_max = <15 Hz to 20 Hz, depending on the application. And f_s> 2 * f_max. Considering these signals for one or more electrodes, the goal is to provide reliable automatic recognition of hand gestures made on the keyboard or active area, respectively.

図4では、実施形態によると、8つのジェスチャの具体的実施例が定義される。しかしながら、他の実施形態によると、他のジェスチャが定義され得る。図示される実施例では、ジェスチャは、4つの「フリック」、すなわち、4つの主要な方向(右402、左404、上406、下408)への速い線形の指の動き、時計回り410および反時計回り412の円、「確認」または「チェック」ジェスチャ414、および一連の連続的な短い左<−>右の動きであるキャンセルジェスチャ416である。

In FIG. 4, according to an embodiment, specific examples of eight gestures are defined. However, according to other embodiments, other gestures may be defined. In the illustrated embodiment, the gesture has four “flicks”: fast linear finger movements in four major directions (right 402, left 404, top 406, bottom 408), clockwise 410 and counterclockwise. A clockwise 412 circle, a “confirm” or “check”

自動音声認識および手書き文字認識等のパターン認識における一般的アプローチは、それぞれ、事前定義された一組の音素、言葉、または文字のうちの最も可能性が高いものを推定するために、隠れマルコフモデル(HMM)およびトレリス計算を使用することである。HMMλ:=(A,B,π)は、M個の出力記号または「特徴」を生成することができる、N個の状態を伴う有限確率的状態機械である。これは、3つのパラメータ、すなわち、サイズN×Nの状態遷移確率分布行列A、各状態特徴マップの確率を含む、N×M記号確率分布行列B、およびN×1初期状態分布ベクトルπによって表される。トレリスは、時間の次元を状態図に追加し、効率的な計算を可能にするグラフである。ここで議論される実施形態は、一次HMMに関するが、他の実施形態では、より高次のHMMが使用され得る。 Common approaches in pattern recognition, such as automatic speech recognition and handwritten character recognition, each use a hidden Markov model to estimate the most likely one of a predefined set of phonemes, words, or characters. (HMM) and trellis calculation. HMMλ: = (A, B, π) is a finite stochastic state machine with N states that can generate M output symbols or “features”. This is represented by three parameters: a state transition probability distribution matrix A of size N × N, an N × M symbol probability distribution matrix B containing the probability of each state feature map, and an N × 1 initial state distribution vector π. Is done. A trellis is a graph that adds the dimension of time to a state diagram and enables efficient computation. The embodiments discussed herein relate to primary HMMs, but in other embodiments higher order HMMs may be used.

ジェスチャ認識では、例えば、各HMMは、ジェスチャを表す。ジェスチャは、その特徴がその割り当てられたHMMにおける状態によって表されるジェスチャ断片に分割され得る。ジェスチャを行っている間に検出されるセンサ信号から、典型的には、等距離の離散時間インスタンスにおいて、特徴が抽出される。そのような特徴は、例えば、非量子化または量子化信号レベル、x/y/z位置、距離、方向、配向、角度、および/またはこれらの時間に関する一次、二次、またはさらに高次の導関数、あるいはそれらの任意の組み合わせを含む。例えば、利用される特徴が、時間に関するx/y位置の一次導関数、すなわち、x/y速度である場合には、ジェスチャを検出している間に得られる特徴シーケンスは、x/y速度ベクトルのシーケンスである。このシーケンスの長さは、ジェスチャの時間的継続に依存する。異なる人々が、センサシステムの前で、同一のジェスチャ、例えば、「チェック」ジェスチャを行うとき、ジェスチャの持続時間、動きの速度、および/またはジェスチャの形状は、わずかに異なり得る。したがって、対応する特徴シーケンスの変動もあろう。 In gesture recognition, for example, each HMM represents a gesture. A gesture can be divided into gesture fragments whose features are represented by states in their assigned HMM. Features are extracted from sensor signals detected during a gesture, typically in equidistant discrete time instances. Such features may include, for example, first, second, or higher order derivatives with respect to unquantized or quantized signal levels, x / y / z position, distance, direction, orientation, angle, and / or their time. Contains a function, or any combination thereof. For example, if the feature utilized is the first derivative of x / y position with respect to time, i.e., x / y velocity, then the feature sequence obtained while detecting the gesture is the x / y velocity vector This is the sequence. The length of this sequence depends on the time duration of the gesture. When different people make the same gesture, eg, a “check” gesture, in front of the sensor system, the duration of the gesture, the speed of movement, and / or the shape of the gesture may be slightly different. Therefore, there will also be variations in the corresponding feature sequence.

HMMは、各時間インスタンスにおいて、単一の特徴を表すだけでなく、全ての可能である特徴ベクトルにわたる確率分布も表すため、これらの変動を組み込むことができる。これらの確率分布行列B、ならびにその状態の間の遷移の確率を得るために、各HMMは、いわゆる訓練ジェスチャセットの特徴シーケンスを用いて訓練される必要がある。訓練中、HMM確率分布は、このHMMを考慮して訓練シーケンスの条件付き確率を最大限化するために最適化される。したがって、HMMは、それが訓練された全てのジェスチャの特徴シーケンスを表している。HMMに必要な状態の数Nは、とりわけ、対応するジェスチャの複雑性に依存する。各状態に関して、これは、単一の観察確率分布(行列Bの中の行)に属し、ジェスチャの特徴シーケンスの中により多くの異なる特徴があるほど、それを表すためにより多くの状態が必要とされる。ジェスチャ認識での隠れマルコフモデルの使用についての追加の詳細は、本明細書で完全に記載されるかのように、その全体で参照することにより本明細書に組み込まれる、「System and Method for Multidimensional Gesture Analysis」と題された同一出願人による米国特許第8,280,732号で見出され得る。 The HMM can incorporate these variations because it represents not only a single feature at each time instance, but also a probability distribution over all possible feature vectors. In order to obtain these probability distribution matrices B, as well as the probability of transitions between their states, each HMM needs to be trained using a feature sequence of a so-called training gesture set. During training, the HMM probability distribution is optimized to maximize the conditional probability of the training sequence taking this HMM into account. Thus, the HMM represents the feature sequence of all gestures for which it has been trained. The number N of states required for the HMM depends inter alia on the complexity of the corresponding gesture. For each state, it belongs to a single observation probability distribution (rows in matrix B), the more different features in the gesture feature sequence, the more states are needed to represent it. Is done. Additional details regarding the use of hidden Markov models in gesture recognition are incorporated herein by reference in their entirety as if fully set forth herein, “System and Method for Multidimensional”. No. 8,280,732 by the same applicant entitled “Gesture Analysis”.

用途に応じて、異なるHMMモデルトポロジー、例えば、線形モデル(多くの場合、音声認識で使用される、現在または次の状態のみへの状態遷移を伴う)、または図8に示されるような円形モデル(多くの場合、画像処理で使用され、最後の状態は第1の状態への非ゼロ遷移確率を有する)が可能である。 Depending on the application, different HMM model topologies, for example linear models (often with state transitions to the current or next state used in speech recognition) or circular models as shown in FIG. (Often used in image processing, the last state has a non-zero transition probability to the first state).

実施形態によると、フリック402、404、406、408、および確認ジェスチャ414(図4)のような明確な始点および終点を伴うジェスチャについては、線形モデルが好ましい。円410、412、およびキャンセルジェスチャ414のような明確ではない始点および終点を伴うジェスチャについては、円形モデルが好ましい。加えて、全ての状態の間の非ゼロ遷移確率を伴う完全接続モデルは、例えば、拒否されるべきジェスチャに対するいわゆる「ガーベッジ」HMMに使用されることができる。

According to embodiments, linear models are preferred for gestures with distinct start and end points, such as

訓練前に頻繁に使用されているHMM初期化が、図9に示され、同図は、状態遷移行列Aにおける線形および円形特性を明らかにする。HMM訓練中、AおよびB行列の非ゼロ入力が変化するであろう。しかしながら、ゼロ入力は、そのようなものとしてとどまり、したがって、モデルトポロジーもとどまるであろう。 A frequently used HMM initialization prior to training is shown in FIG. 9, which reveals linear and circular properties in state transition matrix A. During HMM training, the non-zero inputs of the A and B matrices will change. However, the zero input will remain as such and therefore the model topology will also remain.

各ジェスチャに対する行列AおよびBを最適化する訓練アルゴリズム、ならびに認識アルゴリズムの両方への入力は、特徴の時間的シーケンスであり、各シーケンスは、ジェスチャの1回の実行に対応する。 The inputs to both the training algorithm that optimizes the matrices A and B for each gesture, as well as the recognition algorithm, are temporal sequences of features, each sequence corresponding to one execution of the gesture.

ジェスチャの開始および停止時間の知識は、認識性能のために重要であり得る。そして、種々の実施形態は、(限定されないが)HMMとの使用のために、非常に単純であるが、拡大縮小および遷移に対して不変であり、したがって、非常にロバストである、開始/停止基準と信号特徴との組み合わせを使用する。 Knowledge of gesture start and stop times may be important for recognition performance. And various embodiments are very simple for use with (but not limited to) HMM, but are invariant to scaling and transitions, and therefore very robust, start / stop Use a combination of criteria and signal features.

図5Aおよび5Bは、「チェック」ジェスチャの特徴シーケンスおよび例示的なセンサEB、EL、ET、ERの実施例を示し、特徴ベクトルは、指先と4つのセンサ電極との間の距離の時間に関する一次導関数から成る。図5Aの特徴シーケンス行列の中の各列は、離散時間インスタンスに対応する。例えば、行列の位置(2,2)の中の値「−4.1」は、時間インスタンス2において電極E2から離れて比較的速く移動することを示し、同時に、行4の中の値「0.4」は、電極E4に向かって比較的ゆっくり移動することを示す。

FIGS. 5A and 5B show a feature sequence of a “check” gesture and examples of exemplary sensors EB, EL, ET, ER, where the feature vector is linear with respect to the time of distance between the fingertip and the four sensor electrodes. Consists of derivatives. Each column in the feature sequence matrix of FIG. 5A corresponds to a discrete time instance. For example, the value “−4.1” in matrix position (2, 2) indicates a relatively fast movement away from electrode E2 at

ジェスチャの開始および停止の検出については、以下の作業仮定を立てることができる。A)ジェスチャは、外側からアクティブ空間(またはz=0の場合はアクティブ領域)に進入するとき、またはアクティブ空間内の静止期間後の移動の開始時のいずれかで始まる(すなわち、指がジェスチャの間にアクティブ空間から退出する必要がない)。B)ジェスチャが、アクティブ空間内で静止するとき、またはそこから退出するとき、あるいは行われたジェスチャが所定の組のジェスチャのうちの1つであるための確率が閾値を超えるときに、終了する。 For gesture start and stop detection, the following working assumptions can be made: A) A gesture begins either when entering the active space from the outside (or the active region if z = 0) or at the start of movement after a rest period in the active space (ie, the finger is No need to leave the active space in between). B) Terminate when a gesture rests in or leaves the active space, or when the probability that the gesture made is one of a predetermined set of gestures exceeds a threshold .

上記のように、これらの仮定から、開始および停止検出のための基準が直接推測される。 As mentioned above, from these assumptions, the criteria for start and stop detection are inferred directly.

(開始検出:)

A1)指先と少なくとも1つのセンサとの間の距離が増加し、かつ、指先と少なくとも1つのセンサとの間の距離が減少する(または少なくとも1つの電極の信号レベルが増加し、かつ少なくとも1つの他の電極の信号レベルが減少する)。(一定のz高度でのアクティブ空間内の手の動きは、常に、少なくとも1つの電極までの距離の増加と、少なくとも1つの他の電極までの距離の減少とにつながる。)Z=0については、3D認識問題は、2Dタッチジェスチャ認識問題である。増加または減少を検出することは、閾値距離または信号レベル変化を検出することを含み得る。

(Start detection :)

A1) The distance between the fingertip and at least one sensor is increased and the distance between the fingertip and at least one sensor is decreased (or the signal level of at least one electrode is increased and at least one The signal level of the other electrode is reduced). (A hand movement in active space at a constant z-altitude always leads to an increase in distance to at least one electrode and a decrease in distance to at least one other electrode.) For Z = 0 The 3D recognition problem is a 2D touch gesture recognition problem. Detecting the increase or decrease can include detecting a threshold distance or signal level change.

A2)例えば、10個の信号サンプルにわたる信号レベルの短時間変動または同様の評価尺度が、閾値を超えなければならない(指が十分に速く動いている)。両方の基準が同時に満たされる場合、ジェスチャの開始が検出されると仮定される。検出されたジェスチャ開始の直後に、上記(または同様)の基準を再びチェックすることによって、開始検出の妥当性を検証することができる。妥当性検証が否定である場合、ジェスチャ認識が中断される。 A2) For example, a short-term variation in signal level over 10 signal samples or a similar evaluation measure must exceed a threshold (finger moving fast enough). If both criteria are met simultaneously, it is assumed that the start of the gesture is detected. Immediately after the detected gesture start, the validity of the start detection can be verified by checking the above (or similar) criteria again. If the validation is negative, gesture recognition is interrupted.

(停止検出:)

B1)手から電極までの距離が、例えば、nD=10個のサンプルにわたって、全ての電極に対して増加する(または全てのセンサの信号レベルが減少する)。(これは、一定のz距離におけるアクティブ空間内の移動には可能ではない。)

B2)例えば、nV=10個の信号サンプルにわたるセンサ信号の短時間変動または同様の評価尺度が、閾値を超えてはならない(指が十分に遅く動いている)。

(Stop detection :)

B1) The distance from the hand to the electrode increases for all electrodes (or decreases the signal level of all sensors), for example over nD = 10 samples. (This is not possible for movement in active space at a constant z distance.)

B2) For example, the short-time variation of the sensor signal over nV = 10 signal samples or a similar rating scale should not exceed the threshold (the finger is moving slowly enough).

B3)基準B1)またはB2)が離散時間インスタンスT_Eで満たされる場合には、ジェスチャ終了が、時間T_E−nDまたはT_E−nVであるようにそれぞれ検出される。 B3) If the criterion B1) or B2) is satisfied with a discrete time instance T_E, the end of the gesture is detected as being at time T_E-nD or T_E-nV, respectively.

ジェスチャの開始と停止との間の時間が、事前定義された時間間隔以内ではない場合、ジェスチャが、可能なジェスチャの組から除外されることができる。 If the time between the start and stop of a gesture is not within a predefined time interval, the gesture can be excluded from the set of possible gestures.

図6Aは、図6Bに示される時計回りの円ジェスチャの開始事象の決定を示し、以下の基準が適用される。A1)>=1個の電極の信号レベルが増加する、および>=1個の他の電極の信号レベルが減少する(アクティブ空間内で動く指に対応する)。A2)センサ信号の短時間変動または同様の評価尺度が閾値を超える(指が十分に速く動いている)。 FIG. 6A shows the determination of the start event of the clockwise circle gesture shown in FIG. 6B, with the following criteria applied: A1) The signal level of> = 1 electrode increases and the signal level of> = 1 other electrode decreases (corresponding to a finger moving in the active space). A2) Short-term fluctuations in sensor signal or similar rating scale exceeds threshold (finger moving fast enough).

図7は、基準B1)が適用されるようなジェスチャ停止検出を示す。全ての電極の信号レベルが減少する(これはアクティブ空間から退出する指に対応する)。 FIG. 7 shows gesture stop detection such that criterion B1) is applied. The signal level of all electrodes is reduced (this corresponds to a finger leaving the active space).

図10は、開始/停止検出を含む、全体的なジェスチャ認識プロセスを図示するフローチャート1000である。プロセスの開始1004に応じて、各入力信号サンプル(全ての電極からのセンサ値から成る)に対し、最初に、HMM確率の計算を伴うジェスチャ認識がすでに作動している(ACTIVE=true)か、作動していないか(ACTIVE=false)がチェックされる(ステップ1004)。後者の場合、開始基準が評価される(ステップ1008)。開始基準が満たされる場合(ステップ1022で決定される)、ACTIVEフラグが「真(true)」に設定され(ステップ1024)、実際のジェスチャ認識が始まる(ステップ1016)。閾値を超えることの確率が決定され(ステップ1020)、基準が満たされる場合、認識されたジェスチャが出力され(ステップ1014)、ACTIVEが偽(false)に設定される(ステップ1018)。そうでなければ、プロセスが終了する(ステップ1026)。

FIG. 10 is a

ACTIVEが入力サンプルについて真である(ステップ1004)場合には、停止基準が評価される(ステップ1006)。停止基準が満たされる(ステップ1010)場合、ジェスチャ認識が完了し、その結果が評価され(ステップ1012)、出力され(ステップ1014)、ACTIVEが偽に設定される(ステップ1018)。そうでなければ、ジェスチャ認識が続行する(ステップ1016)。 If ACTIVE is true for the input sample (step 1004), the stop criterion is evaluated (step 1006). If the stop criterion is met (step 1010), gesture recognition is complete, the result is evaluated (step 1012), output (step 1014), and ACTIVE is set to false (step 1018). Otherwise, gesture recognition continues (step 1016).

図11は、アクティブ領域の上方の一定のz距離で時計回りの円を描く指、および全ての電極に対する信号レベルの変化である、結果として生じる特徴ベクトルの例を示す。この時間ステップ1では、指は、電極ERおよびEBに向かって、かつ電極ELおよびETから離れて動く。

FIG. 11 shows an example of the resulting feature vector, which is a finger drawing a clockwise circle at a constant z distance above the active area, and the signal level change for all electrodes. In this

これは、電極ERおよびEBの信号レベルの増加、ならびに電極ELおよびETの信号レベルの減少につながる。時間ステップ3では、指は、依然としてETから離れ、かつELに向かって動くが、ここではERから離れ、かつELに向かって動く。これは、電極EBおよびELの信号レベルの増加、ならびに電極ETおよびERの信号の減少等につながる。

This leads to an increase in the signal level of the electrodes ER and EB and a decrease in the signal level of the electrodes EL and ET. At

いくつかの実施形態によると、性能評価のために、HMM(すなわち、各ジェスチャ)は、定義された回数で各ジェスチャを行った一組の人々からのデータを用いて訓練された。HMMの訓練については、L.R.Rabiner:”A tutorial on Hidden Markov Models und selected applications in speech recognition”.Proceedings of the IEEE,Vol.77 No.2,Feb.1989を参照されたい。 According to some embodiments, for performance evaluation, the HMM (ie, each gesture) was trained with data from a set of people who made each gesture a defined number of times. For HMM training, see L.C. R. Rabiner: “A tutu on Hidden Markov Models unselected applications in spec recognition”. Proceedings of the IEEE, Vol. 77 No. 2, Feb. See 1989.

客観的に認識率を評価するために、追加の試験ジェスチャデータベースが、別の明確に異なる組の人々から得られた。達成されたジェスチャ認識率(パーセント単位)が、図12に示されている。行列の行は、行われたジェスチャを示し、列は、認識されたジェスチャを示す。「拒否」という列は、拒否されたジェスチャを示す。ガーベッジモデルは、全ての非意図的な定義されていない手の動きを表す。これは、第1組の人々のうちの全ての人々の全ての訓練データ、すなわち、彼らの全てのジェスチャを用いて訓練される。「合計」という列は、全ての認識されたジェスチャの確率の合計を示し、したがって、100でなければならない。全ての定義されたジェスチャについては、少なくとも95%の認識率を達成することができる。認識されていないジェスチャの多くが拒否され、これは、異なるジェスチャの誤検出が拒否よりも不都合とみなされるため、有利である。 In order to objectively assess recognition rates, additional test gesture databases were obtained from another distinctly different set of people. The achieved gesture recognition rate (in percent) is shown in FIG. The rows of the matrix indicate the gestures made and the columns indicate the recognized gestures. The column “Reject” indicates a rejected gesture. The garbage model represents all unintentional undefined hand movements. This is trained using all training data of all people in the first set of people, ie all their gestures. The column “Sum” shows the sum of the probabilities of all recognized gestures and should therefore be 100. A recognition rate of at least 95% can be achieved for all defined gestures. Many of the unrecognized gestures are rejected, which is advantageous because false detection of different gestures is considered more inconvenient than rejection.

提案された方法は、正確に4つの電極/センサ、または図1あるいは2のような電極レイアウトを伴うセンサシステムのみに限定されない。これは、任意の多数、すなわち、2個から最大で無限のセンサを伴うシステムに適用される。例えば、これはまた、円形または別の形状である、2つだけの電極、すなわち、左電極ELおよび右電極ERを伴うシステムでもあり得る。 The proposed method is not limited to just a sensor system with exactly four electrodes / sensors or an electrode layout as in FIG. This applies to systems with any number, i.e. from 2 up to an infinite number of sensors. For example, it may also be a system with only two electrodes, a left electrode EL and a right electrode ER, which are circular or another shape.

センサ信号の短時間変動を各チャネルに対する閾値と比較する代わりに、これらの分散の加重合計を単一の閾値と比較すること、またはアクティブな移動を表す信号の任意の他の評価尺度を使用することも可能である。 Instead of comparing short-term variations in the sensor signal with the threshold for each channel, compare the weighted sum of these variances with a single threshold, or use any other measure of the signal that represents active movement It is also possible.

種々の実施形態は、センサが距離依存性測定データを提供する、任意のセンサシステムに適用可能である。そのようなシステムは、容量および抵抗タッチセンサ、超音波センサ、レーダ、表面音響センサを含む。開示された実施形態は、HMMを使用するジェスチャ認識に限定されないが、動的時間伸縮、ニューラルネットワーク、または他の自動認識技法とともに使用されることもできる。 Various embodiments are applicable to any sensor system in which the sensor provides distance dependent measurement data. Such systems include capacitive and resistive touch sensors, ultrasonic sensors, radar, surface acoustic sensors. The disclosed embodiments are not limited to gesture recognition using HMMs, but can also be used with dynamic time stretching, neural networks, or other automatic recognition techniques.

ここで図13を参照すると、ブロック図は、実施形態による、開始/停止検出を含むジェスチャ認識のためのセンサシステム1300の特定の実装を図示する。図13のシステムは、容量感知システムにおいて特に有用であり得る。システム1300は、感知コントローラ1301と、感知電極1302と、ホストシステム1303とを含む。感知電極1302は、図1に示されるような構成を実装し得る。ホスト3103は、携帯電話、ラップトップコンピュータ、入出力デバイス、光スイッチ、コーヒーメーカー、医療入力デバイス等の、タッチセンサ信号を利用することができる任意のシステムであり得る。

Referring now to FIG. 13, a block diagram illustrates a specific implementation of a

図示される実施例では、TX信号発生器1304は、伝送機信号VTXを伝送電極TXDに提供する。受信電極RX0−RX4は、フィルタリング等を実装するための信号調節モジュール1306で受信される。信号調節の出力は、ADC1307に提供され、バス1308を通して、信号処理ユニット1308に提供される。信号処理ユニット1308は、ジェスチャ認識の機能性を実装し得る。結果として生じる出力は、入出力ユニット1318を介してホスト1303に提供され得る。

In the illustrated embodiment, the

本システムはさらに、内部クロック1309、フラッシュメモリ1312等のメモリ、電圧基準1310、電力管理1314、低電力起動1316、リセット制御1322、および通信制御1320等の種々の追加のモジュールを含み得る。

The system may further include various additional modules such as an

以下の参考文献は、隠れマルコフモデルの使用についての追加の情報を提供する。

L.E.Baum、他、:”A maximization technique occurring in the statistical analysis of probabilistic functions of Markov chains”,Ann.Math.Statist..vol.41.no.1.pp.164−171,1970.

E.Behrends:Introduction to Markov Chains,Viehweg Verlag,2000.

L.R.Rabiner:A tutorial on Hidden Markov Models und selected applications in speech recognition”.Proceedings of the IEEE,Vol.77 No.2,Feb.1989.

A.J.Viterbi:’Error bounds for convolutional codes and an asymptotically optimum decoding algorithm”.IEEE Transactions on Information Theory,Vol.13,Apr.1967.

Welch:”Hidden Markov Models and the Baum−Welch Algorithm”.IEEE Information Theory Society Newsletter,Dec.2003.

本発明は、その具体的実施形態に関して説明されたが、これらの実施形態は、単に、例証であって、本発明の制限ではない。本発明の図示される実施形態の本明細書における説明は、要約および概要における説明を含め、包括的であること、または本発明を本明細書に開示される精密な形態に限定することを意図しない(および、特に、要約または概要内の任意の特定の実施形態、特徴、または機能の包含は、発明の範囲をそのような実施形態、特徴、または機能に限定することを意図しない)。むしろ、説明は、当業者に、要約または概要に説明される任意のそのような実施形態特徴または機能を含め、本発明を任意の特に説明される実施形態、特徴、または機能に限定せず、本発明を理解するための背景を提供するために、例証的実施形態、特徴、および機能を説明することを意図する。本発明の具体的実施形態およびその実施例は、例証目的のためだけに本明細書に説明されるが、種々の均等修正も、当業者が認識および理解するであろうように、本発明の精神および範囲内において可能である。示されるように、これらの修正は、本発明の図示される実施形態の前述の説明に照らして、本発明に行われてもよく、本発明の精神および範囲内に含まれるものとする。したがって、本発明は、その特定の実施形態を参照して、本明細書に説明されるが、様々な修正、種々の変更、および代用が、前述の開示内で意図され、いくつかの事例では、記載されるような本発明の範囲および精神から逸脱することなく、本発明の実施形態のいくつかの特徴が、他の特徴の対応する使用を伴わずに、採用されるであろうことを理解されるであろう。したがって、多くの修正は、特定の状況または材料を本発明の本質的範囲および精神に適合させるために行われ得る。

The following references provide additional information about the use of hidden Markov models.

L. E. Baum, et al .: “A maximization technique occurring in the statistic analysis of probabilistic functions of Markov chains”, Ann. Math. Statist. . vol. 41. no. 1. pp. 164-171, 1970.

E. Behrends: Introduction to Markov Chains, Viehweg Verlag, 2000.

L. R. Rabiner: A tutor on Hidden Markov Models unselected applications in specification recognition, Proceedings of the IEEE, Vol. 77 No. 2, Feb. 1989.

A. J. et al. Viterbi: 'Error bounds for convolutional codes and an asymptotically optimal decoding algorithm ", IEEE Transactions on Information Theory, Vol.

Welch: “Hidden Markov Models and the Baum-Welch Algorithm”. IEEE Information Theory Society Newsletter, Dec. 2003.

Although the invention has been described with reference to specific embodiments thereof, these embodiments are merely illustrative and not limiting of the invention. The description herein of the illustrated embodiments of the invention, including the summary and summary descriptions, is intended to be exhaustive or to limit the invention to the precise form disclosed herein. (And in particular, inclusion of any particular embodiment, feature, or function in the summary or summary is not intended to limit the scope of the invention to such embodiment, feature, or function). Rather, the description is not intended to limit the invention to any specifically described embodiments, features, or functions, including any such embodiment features or functions described in the Summary or Summary to those skilled in the art, In order to provide a background for understanding the present invention, it is intended to describe exemplary embodiments, features, and functions. While specific embodiments of the present invention and examples thereof are described herein for purposes of illustration only, various equivalent modifications will be recognized and understood by those skilled in the art. It is possible within the spirit and scope. As indicated, these modifications may be made to the invention in light of the foregoing description of illustrated embodiments of the invention and are intended to be within the spirit and scope of the invention. Thus, although the invention is described herein with reference to specific embodiments thereof, various modifications, various changes, and substitutions are contemplated within the foregoing disclosure, and in some cases Without departing from the scope and spirit of the invention as described, certain features of embodiments of the invention may be employed without the corresponding use of other features. Will be understood. Accordingly, many modifications may be made to adapt a particular situation or material to the essential scope and spirit of the present invention.

本明細書の全体を通した「one embodiment(一実施形態)」、「an embodiment(ある実施形態)」、または「a specific embodiment(具体的実施形態)」、あるいは同様の専門用語の参照は、実施形態に関連して説明される特定の特徴、構造、または特性が、少なくとも1つの実施形態に含まれ、必ずしも、全実施形態に存在しなくてもよいことを意味する。したがって、語句「in one embodiment(一実施形態では)」、「in an embodiment(ある実施形態では)」、または「in a specific embodiment(具体的実施形態では)」、あるいは本明細書の全体を通した種々の場所における同様の専門用語のそれぞれの表出は、必ずしも、同一の実施形態を参照するわけではない。さらに、任意の特定の実施形態の特定の特徴、構造、または特性は、任意の好適な様式において、1つ以上の他の実施形態と組み合わせられ得る。本明細書に説明および図示される実施形態の他の変形例および修正も、本明細書の教示に照らして可能であり、本発明の精神および範囲の一部として見なされるべきであることを理解されたい。 Throughout this specification "one embodiment", "an embodiment", or "a specific embodiment", or similar terminology reference, It means that a particular feature, structure, or characteristic described in connection with the embodiment is included in at least one embodiment and is not necessarily present in all embodiments. Accordingly, the phrases “in one embedment” (in one embodiment), “in an embodiment” (in one embodiment), or “in a specific embodiment” (in a specific embodiment), or throughout the specification. Each representation of a similar terminology in various places does not necessarily refer to the same embodiment. Furthermore, the particular features, structures, or characteristics of any particular embodiment may be combined with one or more other embodiments in any suitable manner. It is understood that other variations and modifications of the embodiments described and illustrated herein are possible in light of the teachings herein and should be considered as part of the spirit and scope of the present invention. I want to be.

本明細書の説明では、多数の具体的詳細が、構成要素および/または方法の実施例等、本発明の実施形態の完全理解を提供するために提供される。しかしながら、当業者は、実施形態が、具体的詳細のうちの1つ以上を伴わずに、あるいは他の装置、システム、アセンブリ、方法、構成要素、材料、部品、および/または同等物を伴って、実践可能であり得ることを認識するであろう。他の事例では、公知の構造、構成要素、システム、材料、または動作は、本発明の実施形態の側面を曖昧にすることを回避するために、具体的には、詳細に図示または説明されない。本発明は、特定の実施形態を使用することによって図示され得るが、これは、任意の特定の実施形態ではなく、本発明をそれに限定するわけでもなく、当業者は、付加的実施形態が、容易に理解可能であって、本発明の一部であることを認識するであろう。 In the description herein, numerous specific details are provided to provide a thorough understanding of embodiments of the invention, such as examples of components and / or methods. However, one of ordinary skill in the art appreciates that embodiments may be described without one or more of the specific details, or with other devices, systems, assemblies, methods, components, materials, parts, and / or the like. You will recognize that it can be practicable. In other instances, well-known structures, components, systems, materials, or operations are not specifically shown or described in detail to avoid obscuring aspects of embodiments of the present invention. Although the present invention may be illustrated by using specific embodiments, this is not any specific embodiment and is not intended to limit the present invention, and those skilled in the art will recognize additional embodiments, It will be appreciated that it is readily understandable and is part of the present invention.

本明細書に説明される本発明の実施形態のルーチン、方法、またはプログラムを実装するために、C、C++、Java(登録商標)、アセンブリ言語等を含む、任意の好適なプログラミング言語を使用することができる。手続き型またはオブジェクト指向等の異なるプログラミング技法を採用することができる。任意の特定のルーチンが、単一コンピュータ処理デバイスまたは複数のコンピュータ処理デバイス、単一コンピュータプロセッサまたは複数のコンピュータプロセッサ上で実行することができる。データは、単一記憶媒体内に記憶され、または複数の記憶媒体を通して分散され得、単一データベースまたは複数のデータベース(または、他のデータ記憶技法)内に常駐し得る。ステップ、動作、または算出は、具体的順番で提示され得るが、本順番は、異なる実施形態では、変更され得る。いくつかの実施形態では、複数のステップが本明細書に順次的として示される範囲において、代替実施形態におけるそのようなステップのいくつかの組み合わせは、同時に行われてもよい。本明細書に説明される動作のシーケンスは、オペレーティングシステム、カーネル等の別のプロセスによって中断、一時停止、または別様に制御することができる。ルーチンは、オペレーティングシステム環境内において、または独立ルーチンとして、動作することができる。本明細書に説明される機能、ルーチン、方法、ステップ、および動作は、ハードウェア、ソフトウェア、ファームウェア、または任意のそれらの組み合わせにおいて行うことができる。 Use any suitable programming language, including C, C ++, Java, assembly language, etc., to implement the routines, methods, or programs of the embodiments of the invention described herein. be able to. Different programming techniques such as procedural or object oriented can be employed. Any particular routine may be executed on a single computer processing device or multiple computer processing devices, a single computer processor or multiple computer processors. Data may be stored in a single storage medium or distributed across multiple storage media and may reside in a single database or multiple databases (or other data storage techniques). The steps, actions, or calculations may be presented in a specific order, but this order may be changed in different embodiments. In some embodiments, to the extent that multiple steps are shown sequentially herein, some combinations of such steps in alternative embodiments may be performed simultaneously. The sequence of operations described herein can be interrupted, suspended, or otherwise controlled by another process such as an operating system, kernel, or the like. The routine can operate within the operating system environment or as an independent routine. The functions, routines, methods, steps, and operations described herein may be performed in hardware, software, firmware, or any combination thereof.

本明細書に説明される実施形態は、ソフトウェア、またはハードウェア、または両方の組み合わせにおいて、制御論理の形態で実装することができる。制御論理は、情報処理デバイスに、種々の実施形態に開示される一組のステップを行うよう指示するように適合された複数の命令として、コンピュータ読み取り可能な媒体等の情報記憶媒体内に記憶され得る。本明細書に提供される本開示および教示に基づいて、当業者は、本発明を実装するための他の手法および/または方法を理解するであろう。 The embodiments described herein may be implemented in the form of control logic in software, hardware, or a combination of both. The control logic is stored in an information storage medium, such as a computer readable medium, as a plurality of instructions adapted to instruct the information processing device to perform a set of steps disclosed in various embodiments. obtain. Based on the disclosure and teachings provided herein, one of ordinary skill in the art will appreciate other techniques and / or methods for implementing the invention.

ソフトウェアプログラミングまたはコード内に、本明細書に説明されるステップ、動作、方法、ルーチン、またはその一部のいずれかを実装することもまた、本発明の精神および範囲内であって、そのようなソフトウェアプログラミングまたはコードは、コンピュータ読み取り可能な媒体内に記憶されることができ、プロセッサによって、コンピュータに、本明細書に説明されるステップ、動作、方法、ルーチン、またはその一部のいずれかを行わせるように操作することができる。本発明は、1つ以上の汎用デジタルコンピュータ内のソフトウェアプログラミングまたはコードを使用することによって、特定用途向け集積回路、プログラマブル論理デバイス、フィールドプログラマブルゲートアレイ等を使用することによって、実装され得る。光学的、化学的、生物学的、量子力学的、またはナノ加工システム、構成要素および機構が、使用され得る。一般に、本発明の機能は、当技術分野において公知のような任意の手段によって達成することができる。例えば、分散またはネットワーク化システム、構成要素、および回路を使用することができる。別の実施例では、データの通信または転送(または別様に、ある場所から別の場所に移動する)は、有線、無線、または任意の他の手段によるものであり得る。 It is also within the spirit and scope of the present invention to implement any of the steps, operations, methods, routines, or portions thereof described herein in software programming or code. Software programming or code can be stored in a computer-readable medium and causes a processor to perform any of the steps, operations, methods, routines, or portions thereof described herein. Can be operated. The present invention may be implemented by using application specific integrated circuits, programmable logic devices, field programmable gate arrays, etc., by using software programming or code in one or more general purpose digital computers. Optical, chemical, biological, quantum mechanical, or nanofabrication systems, components and mechanisms can be used. In general, the functions of the present invention can be achieved by any means as is known in the art. For example, distributed or networked systems, components, and circuits can be used. In another example, the communication or transfer of data (or otherwise moving from one location to another) may be by wire, wireless, or any other means.

「コンピュータ読み取り可能な媒体」は、命令実行システム、装置、システム、またはデバイスによって、あるいはそれと併せて使用するために、プログラムを含有、記憶、通信、伝搬、もしくはトランスポートすることができる、任意の媒体であり得る。コンピュータ読み取り可能な媒体は、限定ではなく、単なる一例として、電子、磁気、光学、電磁、赤外線、または半導体システム、装置、システム、デバイス、伝搬媒体、あるいはコンピュータメモリであり得る。そのようなコンピュータ読み取り可能な媒体は、概して、機械読み取り可能であり、人間読み取り可能(例えば、ソースコード)または機械読み取り可能(例えば、オブジェクトコード)であり得る、ソフトウェアプログラミングまたはコードを含むものとする。非一過性コンピュータ読み取り可能な媒体の実施例は、ランダムアクセスメモリ、読み取り専用メモリ、ハードドライブ、データカートリッジ、磁気テープ、フロッピー(登録商標)ディスケット、フラッシュメモリドライブ、光学データ記憶デバイス、コンパクトディスク読み取り専用メモリ、ならびに他の適切なコンピュータメモリおよびデータ記憶デバイスを含むことができる。例証的実施形態では、ソフトウェア構成要素の一部または全部は、単一サーバコンピュータまたは別個のサーバコンピュータの任意の組み合わせ上に常駐し得る。当業者が理解し得るように、本明細書に開示される実施形態を実装するコンピュータプログラム製品は、コンピューティング環境内の1つ以上のプロセッサによって翻訳可能であるコンピュータ命令を記憶する、1つ以上の非一過性コンピュータ読み取り可能な媒体を備え得る。 “Computer-readable medium” is any medium that can contain, store, communicate, propagate, or transport a program for use by or in conjunction with an instruction execution system, apparatus, system, or device. It can be a medium. The computer readable medium is not limiting and may be, by way of example only, an electronic, magnetic, optical, electromagnetic, infrared, or semiconductor system, apparatus, system, device, propagation medium, or computer memory. Such computer readable media is generally intended to include machine programming or code that may be machine readable and may be human readable (eg, source code) or machine readable (eg, object code). Examples of non-transitory computer readable media are random access memory, read only memory, hard drive, data cartridge, magnetic tape, floppy diskette, flash memory drive, optical data storage device, compact disk read Dedicated memory can be included, as well as other suitable computer memory and data storage devices. In the illustrative embodiment, some or all of the software components may reside on any combination of single server computers or separate server computers. As can be appreciated by one skilled in the art, a computer program product that implements the embodiments disclosed herein stores one or more computer instructions that are translatable by one or more processors in a computing environment. Non-transitory computer readable media.

「プロセッサ」は、データ、信号、または他の情報を処理する、任意のハードウェアシステム、機構、または構成要素を含む。プロセッサは、汎用中央処理ユニット、複数の処理ユニット、機能性を達成するための専用回路、または他のシステムを伴うシステムを含むことができる。処理は、地理的場所に限定される、または時間的制限を有する必要はない。例えば、プロセッサは、「リアルタイム」、「オフライン」、「バッチモード」等でその機能を行うことができる。処理の一部は、異なる時間および異なる場所で、異なる(または、同一の)処理システムによって行うことができる。 A “processor” includes any hardware system, mechanism, or component that processes data, signals, or other information. The processor can include a system with a general purpose central processing unit, multiple processing units, dedicated circuitry to achieve functionality, or other systems. Processing need not be limited to geographic locations or have time restrictions. For example, the processor can perform its functions in “real time”, “offline”, “batch mode”, and the like. Some of the processing can be performed by different (or the same) processing systems at different times and at different locations.

本明細書で使用される場合、用語「comprise(備えている)」、「comprising(備えている)」、「include(含む)」、「including(含む)」、「has(有する)」、「having(有する)」、またはその任意の他の変形例は、非排他的含有を網羅することが意図される。例えば、要素のリストを備えている、プロセス、製品、物品、または装置は、必ずしも、それらの要素のみに限定されず、明示的にリストされていない、あるいはそのようなプロセス、プロセス、物品、または装置に固有の他の要素を含み得る。 As used herein, the terms “comprise”, “comprising”, “include”, “including”, “has”, “ “having”, or any other variation thereof, is intended to cover non-exclusive inclusions. For example, a process, product, article, or device comprising a list of elements is not necessarily limited to only those elements, is not explicitly listed, or such process, process, article, or Other elements specific to the device may be included.

さらに、用語「or(または)」は、本明細書で使用される場合、別様に示されない限り、概して、「and/or(および/または)」を意味すると意図される。例えば、条件AまたはBは、いかのうちの任意の1つによって充足される:Aは、真(または、存在)であって、Bは、偽(または、不在)である、Aは、偽(または、不在)であって、Bは、真(または、存在)である、ならびにAおよびBの両方が、真(または、存在)である。本明細書で使用されるように、以下の請求項を含め、「a」または「an」(および、先行詞が「a」または「an」であるときは、「the」)によって先行される用語は、別様に請求項内で明確に示されない限り、そのような用語の単数形および複数形の両方を含む(すなわち、「a」または「an」の参照は、単数形のみまたは複数形のみを明確に示す)。また、本明細書の説明および以下の請求項全体を通して使用されるように、「in(の中に)」の意味は、文脈によって明確に別様に示されない限り、「in(の中に)」および「on(の上に)」を含む。 Further, the term “or” as used herein is generally intended to mean “and / or” unless otherwise indicated. For example, condition A or B is satisfied by any one of: A is true (or present), B is false (or absent), A is false (Or absent), B is true (or present), and both A and B are true (or present). As used herein, including the following claims, preceded by “a” or “an” (and “the” when the antecedent is “a” or “an”) Terms include both the singular and plural of such terms (ie, reference to “a” or “an” includes only the singular or the plural unless specifically stated otherwise in the claims.) Only clearly). Also, as used throughout the description and the following claims, the meaning of “in” means “in” unless the context clearly indicates otherwise. ”And“ on ”.

図面/図で描写される要素のうちの1つ以上はまた、特定の用途に従って有用であるように、さらに分離または統合した様式で実装し、またはさらにある場合において、除去するか、動作不可能にすることもできると理解されるであろう。加えて、図面/図中の任意の信号矢印は、別様に具体的に記述されない限り、限定的ではなく例示的にすぎないと見なされるべきである。 One or more of the elements depicted in the drawings / diagrams may also be implemented in a more separate or integrated manner, or in some cases removed or inoperable, as useful according to the particular application. It will be understood that In addition, any signal arrows in the drawings / drawings should be regarded as illustrative rather than restrictive unless specifically stated otherwise.

Claims (31)

関連付けられている複数の検出センサを使用して、1つ以上のジェスチャ関連信号を検出することと、

自動認識技法を使用して、前記1つ以上のジェスチャ関連信号から検出されるジェスチャを評価することにより、前記ジェスチャが、所定の組のジェスチャのうちの1つに対応するかどうかを決定することと

を含む、方法。 A method for gesture recognition,

Detecting one or more gesture related signals using a plurality of associated detection sensors;

Determining whether the gesture corresponds to one of a predetermined set of gestures by evaluating gestures detected from the one or more gesture-related signals using automatic recognition techniques; And a method comprising:

関連付けられている複数の検出センサを使用して、1つ以上のジェスチャ関連信号を検出するためのセンサ配列と、

ジェスチャが所定の組のジェスチャのうちの1つに対応するかどうかを決定するために、自動認識技法を使用して、前記1つ以上のジェスチャ関連信号から検出される前記ジェスチャを評価するためのモジュールと

を備えている、システム。 A system for gesture recognition,

A sensor array for detecting one or more gesture-related signals using a plurality of associated detection sensors;

For evaluating the gesture detected from the one or more gesture-related signals using an automatic recognition technique to determine whether a gesture corresponds to one of a predetermined set of gestures. A system comprising a module and

複数の検出センサを使用して、1つ以上のジェスチャ関連信号を受信することと、

ジェスチャが所定の組のジェスチャのうちの1つに対応するかどうかを決定するために、自動認識技法を使用して、前記1つ以上のジェスチャ関連信号から検出される前記ジェスチャを評価することと

を行うためのものである、コンピュータ読み取り可能な媒体。 A computer readable medium comprising one or more non-transitory machine readable program instructions, the program instructions comprising:

Using one or more detection sensors to receive one or more gesture related signals;

Evaluating the gesture detected from the one or more gesture-related signals using an automatic recognition technique to determine whether a gesture corresponds to one of a predetermined set of gestures; A computer-readable medium for performing

Applications Claiming Priority (5)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| US201261684039P | 2012-08-16 | 2012-08-16 | |

| US61/684,039 | 2012-08-16 | ||

| US13/967,314 | 2013-08-14 | ||

| US13/967,314 US9323985B2 (en) | 2012-08-16 | 2013-08-14 | Automatic gesture recognition for a sensor system |

| PCT/EP2013/067098 WO2014029691A1 (en) | 2012-08-16 | 2013-08-15 | Automatic gesture recognition for a sensor system |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2015524977A true JP2015524977A (en) | 2015-08-27 |

| JP2015524977A5 JP2015524977A5 (en) | 2016-10-06 |

Family

ID=50100052

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2015526994A Pending JP2015524977A (en) | 2012-08-16 | 2013-08-15 | Automatic gesture recognition for sensor systems |

Country Status (7)

| Country | Link |

|---|---|

| US (1) | US9323985B2 (en) |

| EP (1) | EP2885687B1 (en) |

| JP (1) | JP2015524977A (en) |

| KR (2) | KR102380885B1 (en) |

| CN (1) | CN104662491B (en) |

| TW (1) | TWI564785B (en) |

| WO (1) | WO2014029691A1 (en) |

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2021077104A (en) * | 2019-11-08 | 2021-05-20 | 横河電機株式会社 | Detection device, detection method and detection program |

Families Citing this family (36)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US9625997B2 (en) | 2013-07-19 | 2017-04-18 | Microchip Technology Incorporated | Human interface device and method |

| US9665204B2 (en) | 2013-10-04 | 2017-05-30 | Microchip Technology Incorporated | Continuous circle gesture detection for a sensor system |

| US9817521B2 (en) | 2013-11-02 | 2017-11-14 | At&T Intellectual Property I, L.P. | Gesture detection |

| US10025431B2 (en) * | 2013-11-13 | 2018-07-17 | At&T Intellectual Property I, L.P. | Gesture detection |

| US20150253860A1 (en) * | 2014-03-07 | 2015-09-10 | Fresenius Medical Care Holdings, Inc. | E-field sensing of non-contact gesture input for controlling a medical device |

| CN106575200A (en) * | 2014-05-28 | 2017-04-19 | 汤姆逊许可公司 | Methods and systems for touch input |

| US9575560B2 (en) | 2014-06-03 | 2017-02-21 | Google Inc. | Radar-based gesture-recognition through a wearable device |

| ES2773901T3 (en) * | 2014-07-01 | 2020-07-15 | Delonghi Appliances Srl | Coffee machine and corresponding method to control it |

| US9811164B2 (en) | 2014-08-07 | 2017-11-07 | Google Inc. | Radar-based gesture sensing and data transmission |

| US10268321B2 (en) | 2014-08-15 | 2019-04-23 | Google Llc | Interactive textiles within hard objects |

| US9778749B2 (en) | 2014-08-22 | 2017-10-03 | Google Inc. | Occluded gesture recognition |

| US11169988B2 (en) | 2014-08-22 | 2021-11-09 | Google Llc | Radar recognition-aided search |

| US9600080B2 (en) | 2014-10-02 | 2017-03-21 | Google Inc. | Non-line-of-sight radar-based gesture recognition |

| WO2016131013A1 (en) * | 2015-02-13 | 2016-08-18 | Swan Solutions Inc. | System and method for controlling a terminal device |

| KR102307055B1 (en) * | 2015-04-28 | 2021-10-01 | 삼성전자주식회사 | Method and apparatus for extracting static pattern based on output of event-based sensor |

| CN107430444B (en) | 2015-04-30 | 2020-03-03 | 谷歌有限责任公司 | RF-based micro-motion tracking for gesture tracking and recognition |

| KR102229658B1 (en) | 2015-04-30 | 2021-03-17 | 구글 엘엘씨 | Type-agnostic rf signal representations |

| CN107430443B (en) | 2015-04-30 | 2020-07-10 | 谷歌有限责任公司 | Gesture recognition based on wide field radar |

| US9693592B2 (en) | 2015-05-27 | 2017-07-04 | Google Inc. | Attaching electronic components to interactive textiles |

| US10088908B1 (en) | 2015-05-27 | 2018-10-02 | Google Llc | Gesture detection and interactions |

| US9507974B1 (en) * | 2015-06-10 | 2016-11-29 | Hand Held Products, Inc. | Indicia-reading systems having an interface with a user's nervous system |

| US10817065B1 (en) | 2015-10-06 | 2020-10-27 | Google Llc | Gesture recognition using multiple antenna |

| US10359929B2 (en) * | 2015-11-09 | 2019-07-23 | Analog Devices, Inc. | Slider and gesture recognition using capacitive sensing |

| US9857881B2 (en) | 2015-12-31 | 2018-01-02 | Microsoft Technology Licensing, Llc | Electrical device for hand gestures detection |

| CN105744434B (en) * | 2016-02-25 | 2019-01-11 | 深圳市广懋创新科技有限公司 | A kind of intelligent sound box control method and system based on gesture identification |

| US10492302B2 (en) | 2016-05-03 | 2019-11-26 | Google Llc | Connecting an electronic component to an interactive textile |

| US10175781B2 (en) | 2016-05-16 | 2019-01-08 | Google Llc | Interactive object with multiple electronics modules |

| US10285456B2 (en) | 2016-05-16 | 2019-05-14 | Google Llc | Interactive fabric |

| US10929767B2 (en) | 2016-05-25 | 2021-02-23 | International Business Machines Corporation | Method for complex events detection using hidden markov models |

| US10579150B2 (en) | 2016-12-05 | 2020-03-03 | Google Llc | Concurrent detection of absolute distance and relative movement for sensing action gestures |

| KR102635976B1 (en) * | 2016-12-30 | 2024-02-13 | 에스엘 주식회사 | The Apparatus For Recognizing Gesture |

| US20200026360A1 (en) * | 2018-07-19 | 2020-01-23 | Infineon Technologies Ag | Gesture Detection System and Method Using Radar Sensors |

| US11416077B2 (en) | 2018-07-19 | 2022-08-16 | Infineon Technologies Ag | Gesture detection system and method using a radar sensor |

| CN114515146B (en) * | 2020-11-17 | 2024-03-22 | 北京机械设备研究所 | Intelligent gesture recognition method and system based on electrical measurement |

| DE102020215252A1 (en) | 2020-12-03 | 2022-06-09 | Robert Bosch Gesellschaft mit beschränkter Haftung | Procedure for radar-based gesture classification and radar sensor |

| CN112883849A (en) * | 2021-02-02 | 2021-06-01 | 北京小米松果电子有限公司 | Gesture recognition method and device, storage medium and terminal equipment |

Citations (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| WO2011098496A1 (en) * | 2010-02-10 | 2011-08-18 | Ident Technology Ag | System and method for contactless detection and recognition of gestures in a three-dimensional space |

Family Cites Families (23)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US6028271A (en) * | 1992-06-08 | 2000-02-22 | Synaptics, Inc. | Object position detector with edge motion feature and gesture recognition |

| DE69626208T2 (en) * | 1996-12-20 | 2003-11-13 | Hitachi Europ Ltd | Method and system for recognizing hand gestures |

| TW200907764A (en) * | 2007-08-01 | 2009-02-16 | Unique Instr Co Ltd | Three-dimensional virtual input and simulation apparatus |

| US9261979B2 (en) * | 2007-08-20 | 2016-02-16 | Qualcomm Incorporated | Gesture-based mobile interaction |

| US8565535B2 (en) * | 2007-08-20 | 2013-10-22 | Qualcomm Incorporated | Rejecting out-of-vocabulary words |

| US8225343B2 (en) * | 2008-01-11 | 2012-07-17 | Sony Computer Entertainment America Llc | Gesture cataloging and recognition |

| US8280732B2 (en) | 2008-03-27 | 2012-10-02 | Wolfgang Richter | System and method for multidimensional gesture analysis |

| US20090322701A1 (en) * | 2008-06-30 | 2009-12-31 | Tyco Electronics Corporation | Method and apparatus for detecting two simultaneous touches and gestures on a resistive touchscreen |

| US20100071965A1 (en) | 2008-09-23 | 2010-03-25 | Panasonic Corporation | System and method for grab and drop gesture recognition |

| US9009053B2 (en) * | 2008-11-10 | 2015-04-14 | Google Inc. | Multisensory speech detection |

| US20100153890A1 (en) | 2008-12-11 | 2010-06-17 | Nokia Corporation | Method, Apparatus and Computer Program Product for Providing a Predictive Model for Drawing Using Touch Screen Devices |

| US7996793B2 (en) * | 2009-01-30 | 2011-08-09 | Microsoft Corporation | Gesture recognizer system architecture |

| FR2950713A1 (en) * | 2009-09-29 | 2011-04-01 | Movea Sa | SYSTEM AND METHOD FOR RECOGNIZING GESTURES |

| US8922485B1 (en) * | 2009-12-18 | 2014-12-30 | Google Inc. | Behavioral recognition on mobile devices |

| US20110283241A1 (en) * | 2010-05-14 | 2011-11-17 | Google Inc. | Touch Gesture Actions From A Device's Lock Screen |

| US8457353B2 (en) * | 2010-05-18 | 2013-06-04 | Microsoft Corporation | Gestures and gesture modifiers for manipulating a user-interface |

| KR101257303B1 (en) * | 2010-09-08 | 2013-05-02 | 인테니움 인코퍼레이션 | Method and apparatus of recognizing gesture with untouched way |

| KR101141936B1 (en) * | 2010-10-29 | 2012-05-07 | 동명대학교산학협력단 | Method of tracking the region of a hand based on the optical flow field and recognizing gesture by the tracking method |

| US8253684B1 (en) * | 2010-11-02 | 2012-08-28 | Google Inc. | Position and orientation determination for a mobile computing device |

| US20120226981A1 (en) * | 2011-03-02 | 2012-09-06 | Microsoft Corporation | Controlling electronic devices in a multimedia system through a natural user interface |

| US8760395B2 (en) * | 2011-05-31 | 2014-06-24 | Microsoft Corporation | Gesture recognition techniques |

| JP2013080015A (en) * | 2011-09-30 | 2013-05-02 | Toshiba Corp | Speech recognition device and speech recognition method |

| US8862104B2 (en) * | 2012-06-29 | 2014-10-14 | Intel Corporation | System and method for gesture-based management |

-

2013

- 2013-08-14 US US13/967,314 patent/US9323985B2/en active Active

- 2013-08-15 KR KR1020207029857A patent/KR102380885B1/en active IP Right Grant

- 2013-08-15 EP EP13750064.1A patent/EP2885687B1/en active Active

- 2013-08-15 CN CN201380049477.2A patent/CN104662491B/en active Active

- 2013-08-15 WO PCT/EP2013/067098 patent/WO2014029691A1/en active Application Filing

- 2013-08-15 KR KR20157006066A patent/KR20150043386A/en not_active IP Right Cessation

- 2013-08-15 JP JP2015526994A patent/JP2015524977A/en active Pending

- 2013-08-16 TW TW102129530A patent/TWI564785B/en active

Patent Citations (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| WO2011098496A1 (en) * | 2010-02-10 | 2011-08-18 | Ident Technology Ag | System and method for contactless detection and recognition of gestures in a three-dimensional space |

Non-Patent Citations (1)

| Title |

|---|

| 鶴田泰士他: "顔及び手領域による身振り認識システム", 第59回(平成11年後期)全国大会講演論文集(2), JPN6017019491, 28 September 1999 (1999-09-28), pages 2-191〜2-192 * |

Cited By (3)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2021077104A (en) * | 2019-11-08 | 2021-05-20 | 横河電機株式会社 | Detection device, detection method and detection program |

| US11455060B2 (en) | 2019-11-08 | 2022-09-27 | Yokogawa Electric Corporation | Detection apparatus, detection method, and non-transitory computer-readable medium |

| JP7298447B2 (en) | 2019-11-08 | 2023-06-27 | 横河電機株式会社 | Detection device, detection method and detection program |

Also Published As

| Publication number | Publication date |

|---|---|

| WO2014029691A1 (en) | 2014-02-27 |

| TWI564785B (en) | 2017-01-01 |

| EP2885687A1 (en) | 2015-06-24 |

| KR102380885B1 (en) | 2022-04-01 |

| US20140050354A1 (en) | 2014-02-20 |

| EP2885687B1 (en) | 2019-06-05 |

| CN104662491B (en) | 2018-01-19 |

| KR20150043386A (en) | 2015-04-22 |

| US9323985B2 (en) | 2016-04-26 |

| TW201413568A (en) | 2014-04-01 |

| CN104662491A (en) | 2015-05-27 |

| KR20200123262A (en) | 2020-10-28 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| EP2885687B1 (en) | Automatic gesture recognition for a sensor system | |

| CN107644642B (en) | Semantic recognition method and device, storage medium and electronic equipment | |

| US10353476B2 (en) | Efficient gesture processing | |

| JP6235681B2 (en) | Method, storage medium and system for mobile device state adjustment based on user intent and / or identification information | |

| EP3215981B1 (en) | Nonparametric model for detection of spatially diverse temporal patterns | |

| EP2895943B1 (en) | Noise detection and correction routines | |

| US20140201120A1 (en) | Generating notifications based on user behavior | |

| CN103971680A (en) | Method and device for recognizing voices | |

| US9746929B2 (en) | Gesture recognition using gesture elements | |

| EP3046009A1 (en) | Information processing device, input method, and program | |

| CN111121607B (en) | Method for training three-dimensional positioning model and three-dimensional positioning method and device | |

| Lin et al. | Tracking touched trajectory on capacitive touch panels using an adjustable weighted prediction covariance matrix | |

| CN111857369A (en) | Method, device, terminal and storage medium for calibrating proximity sensor of mobile terminal | |

| CN115291786A (en) | False touch judgment method and device based on machine learning and storage medium | |

| Li et al. | Adaptive real-time prediction model for short-term traffic flow uncertainty | |

| US11755149B1 (en) | Systems and methods for using statistical inference to enhance the precision of sparsified capacitive-touch and other human-interface devices | |

| Darbar et al. | Magitext: Around device magnetic interaction for 3d space text entry in smartphone | |

| JP2019057237A (en) | Pedometer measurement device, method for counting steps, and program | |

| CN111897936B (en) | Method, device and equipment for evaluating recall accuracy of question-answering system | |

| Wu et al. | Multi-touch points detection for capacitive touch panel |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A711 | Notification of change in applicant |

Free format text: JAPANESE INTERMEDIATE CODE: A711 Effective date: 20160729 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20160810 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20160810 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20170511 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20170531 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20170815 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20171219 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20180306 |

|

| A02 | Decision of refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A02 Effective date: 20180817 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20181213 |

|

| C60 | Trial request (containing other claim documents, opposition documents) |

Free format text: JAPANESE INTERMEDIATE CODE: C60 Effective date: 20181213 |

|

| A911 | Transfer to examiner for re-examination before appeal (zenchi) |

Free format text: JAPANESE INTERMEDIATE CODE: A911 Effective date: 20181220 |

|

| C21 | Notice of transfer of a case for reconsideration by examiners before appeal proceedings |

Free format text: JAPANESE INTERMEDIATE CODE: C21 Effective date: 20181221 |

|

| A912 | Re-examination (zenchi) completed and case transferred to appeal board |

Free format text: JAPANESE INTERMEDIATE CODE: A912 Effective date: 20190201 |

|

| C211 | Notice of termination of reconsideration by examiners before appeal proceedings |

Free format text: JAPANESE INTERMEDIATE CODE: C211 Effective date: 20190205 |

|

| C22 | Notice of designation (change) of administrative judge |

Free format text: JAPANESE INTERMEDIATE CODE: C22 Effective date: 20191211 |

|

| C22 | Notice of designation (change) of administrative judge |

Free format text: JAPANESE INTERMEDIATE CODE: C22 Effective date: 20200402 |

|

| C13 | Notice of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: C13 Effective date: 20200501 |

|

| C19 | Decision taken to dismiss amendment |

Free format text: JAPANESE INTERMEDIATE CODE: C19 Effective date: 20200513 |

|

| C30A | Notification sent |

Free format text: JAPANESE INTERMEDIATE CODE: C3012 Effective date: 20200513 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20200707 |

|

| C23 | Notice of termination of proceedings |

Free format text: JAPANESE INTERMEDIATE CODE: C23 Effective date: 20200805 |

|

| C03 | Trial/appeal decision taken |

Free format text: JAPANESE INTERMEDIATE CODE: C03 Effective date: 20200908 |

|

| C30A | Notification sent |

Free format text: JAPANESE INTERMEDIATE CODE: C3012 Effective date: 20200908 |